基于YOLOv5全局注意力和上下文增强的遥感图像目标检测方法

2024-06-01杨新秀徐黎明冯正勇

杨新秀 徐黎明 冯正勇

摘要:针对遥感图像目标密集排列,提出一种基于YOLOv5的全局注意力和上下文增强的遥感图像目标检测算法。首先,在主干网络CSPDarknet53的尾部将C3模块替换为Transformer Encoder模块,利用全局注意力捕获目标和周围环境信息;再引入上下文增强模块,利用不同的分支结构获得侧重于大、中、小目标的特征信息;后处理中将NMS替换为DIoU_NMS,有效去除密集排列目标的冗余框,改善检测效果。在RSOD数据集对网络进行测试,与原网络相比,精度提升了13.9%,在飞机数据集进行了消融试验,验证了模块的有效性。

关键词:遥感目标检测;YOLOv5算法;上下文增强;Transformer模块

中图分类号:TP751.1文献标志码:A文章编号:1673-5072(2024)03-032106

近年来,航天遥感技术不断发展,吉林一号、遥感三十四号03星等新一批遥感探测卫星相继成功发射,我国正在建立一个种类齐全、体系完整的遥感空间探测系统,遥感图像目标检测广泛应用在军用和民用两方面。

遥感图像目标检测算法大多是由自然图像目标检测算法改进而来。90年代前,传统目标检测算法是基于手动设计特征,通过对图像进行区域选取、特征提取和分类器分类三步骤处理图像,然而人工设计的特征较为单一,且基于滑窗的方法计算量巨大,适用于有明显特征、背景简单的环境。基于深度学习的目标检测算法往往能检测复杂多密集目标的环境,基于有无候选框的生成,该算法被分为单阶段目标检测算法和二阶段目标检测算法。

目前,根据遥感图像的自身特点,众多学者选择单阶段目标检测算法来攻克具有挑战性的难题,其中,针对遥感图像目标尺寸差异大的特点,Chalavadi等[1]提出在主干网络EfficientNet中引入不同采样率的空洞卷积,更好地提取上下文信息;Wang等[2]提出了具有上下文信息细化的单阶段检测算法。针对遥感图像背景噪声多,易受干扰的问题,Li等[3]提出TRD网络,聚合了卷积神经网络(CNN)和基于自注意力的网络(Transformer)。针对目标密集排列的特点,张云佐等[4]设计了RotateSoftNMS,通过抑制检测框的置信度去除相邻的重复检测框。肖振久等[5]采用PSRRMaxpoolNMS替换原非极大值抑制算法进行后处理。

为提高遥感图像目标检测的精度,本文在单阶段目标检測算法YOLOv5基础上提出了全局注意力和上下文增强网络(Globalaware and Context Enhancement,GCENet),主要创新点和贡献有:(1)针对遥感图像背景复杂,目标像素占比少的特点,提出上下文增强模块(Comtext Enhancement,CE),有效提取不同侧重点的特征信息;(2)针对目标排列密集的特点,在网络后处理中将NMS替换为DIOU_NMS,有效去除冗余检测框,改善检测效果。

1改进YOLOv5目标检测算法

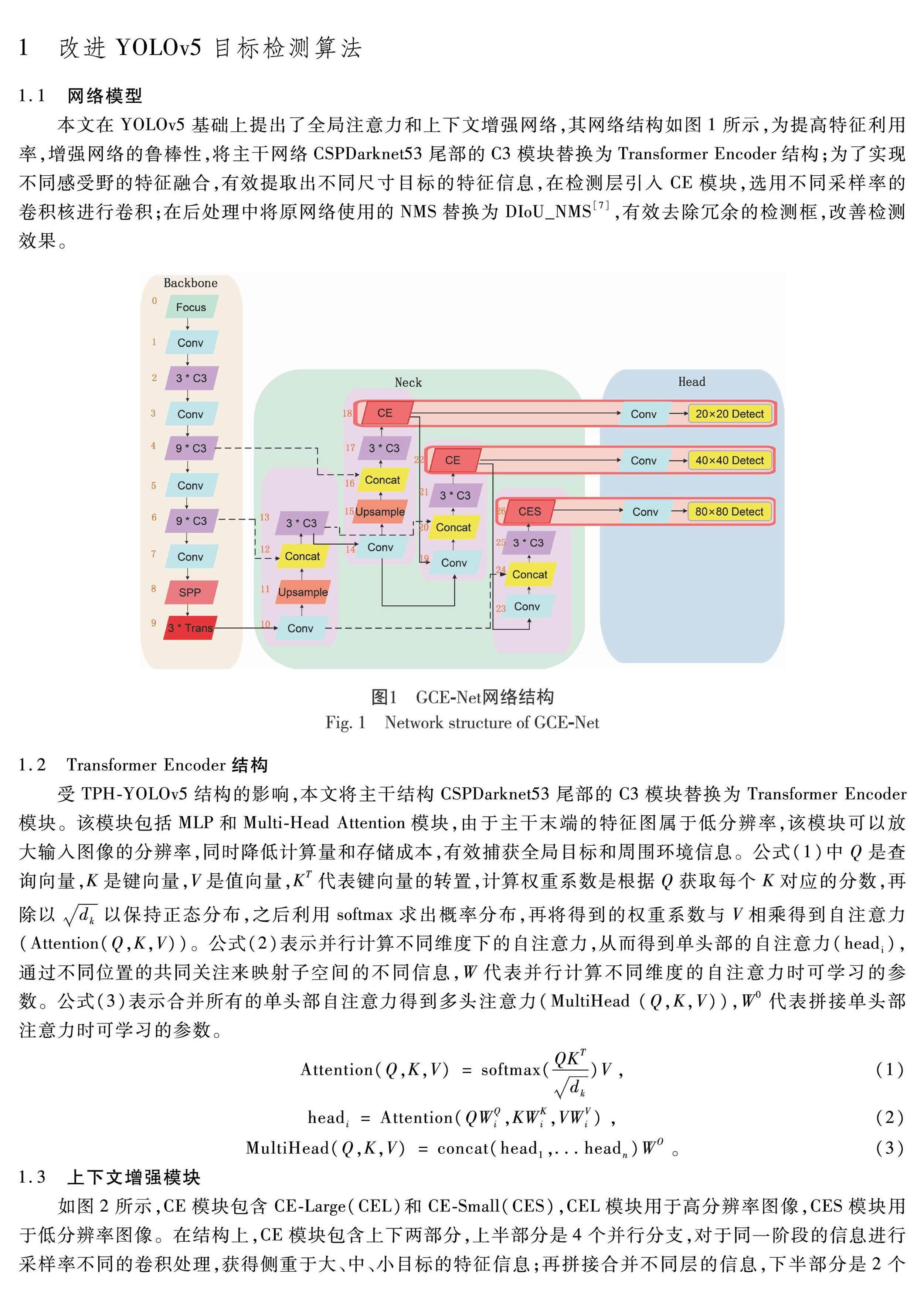

1.1网络模型本文在YOLOv5基础上提出了全局注意力和上下文增强网络,其网络结构如图1所示,为提高特征利用率,增强网络的鲁棒性,将主干网络CSPDarknet53尾部的C3模块替换为Transformer Encoder结构;为了实现不同感受野的特征融合,有效提取出不同尺寸目标的特征信息,在检测层引入CE模块,选用不同采样率的卷积核进行卷积;在后处理中将原网络使用的NMS替换为DIoU_NMS[7],有效去除冗余的检测框,改善检测效果。

1.2Transformer Encoder结构受TPHYOLOv5结构的影响,本文将主干结构CSPDarknet53尾部的C3模块替换为Transformer Encoder模块。该模块包括MLP和MultiHead Attention模块,由于主干末端的特征图属于低分辨率,该模块可以放大输入图像的分辨率,同时降低计算量和存储成本,有效捕获全局目标和周围环境信息。公式(1)中Q是查询向量,K是键向量,V是值向量,KT代表键向量的转置,计算权重系数是根据Q获取每个K对应的分数,再除以dk以保持正态分布,之后利用softmax求出概率分布,再将得到的权重系数与V相乘得到自注意力(Attention(Q,K,V))。公式(2)表示并行计算不同维度下的自注意力,从而得到单头部的自注意力(headi),通过不同位置的共同关注来映射子空间的不同信息,W代表并行计算不同维度的自注意力时可学习的参数。公式(3)表示合并所有的单头部自注意力得到多头注意力(MultiHead (Q,K,V)),W0代表拼接单头部注意力时可学习的参数。

1.3上下文增强模块如图2所示,CE模块包含CELarge(CEL)和CESmall(CES),CEL模块用于高分辨率图像,CES模块用于低分辨率图像。在结构上,CE模块包含上下两部分,上半部分是4个并行分支,对于同一阶段的信息进行采样率不同的卷积处理,获得侧重于大、中、小目标的特征信息;再拼接合并不同层的信息,下半部分是2个并行分支,通过不同的池化获得局部突出特征。

上半部分先压缩通道数为C/4,第一个分支是残差结构确保梯度持续存在,其余3个分支设置不同的采样率。对于CEL模块的后3个分支,采样率分别为2、4、6,设置较大的长宽比是为了在不引入较多参数量的情况下,用于较大目标特征信息的获取;对于CES模块的后3个分支,采样率分别为1、2、3,设置较小的长宽比是由于目标物狭小,但为了获取较多的细节信息,所以提取小范围内潜在小目标的语义信息。最后将拼接合并得到的特征信息,再通过一个1×1的卷积层扩张通道数为C。

下半部分先采用最大池化,减少过拟合现象,获得具有最大像素值的特征图;再采用平均池化去除冗余特征信息,获得全局特征,在输出端拼接起来;最后,再通过3×3的卷积层增强模型的非线性表达能力,有效去除背景噪声,更好地锁定和聚焦大、小目标。

CE模块充分考虑了SAR图像目标的离散特性,极大地抑制复杂背景中的噪声。

1.4DIoU_NMS将原网络后处理中的NMS替换为DIoU_NMS,抑制冗余预测框,能够有效缓解密集目标出现遮挡容易产生错误抑制的问题。在筛选真值框和预测框重叠达到50%以上的锚框时,不仅考虑重叠的影响,也考虑预测框和真值框中心点之间的距离,筛选找到最优框,改善检测效果。通过实验发现替换后,当模型对目标产生重叠的预测框时,逐一算出得分最高的检测框和其他检测框对应的DIoU的值,超过阈值就过滤掉,最终筛选出的最佳锚框能够改善网络对遥感图像密集排列目标的检测效果。

2试验

2.1试验参数

本文使用的硬件环境是64位Windows 10,GPU使用的是NVIDIA Tesla V100SXM2 32GB,CUDN是100版,CUDNN是10.1版,学习框架是Pytorch 1.2.0。

2.2数据集

本文所使用的数据集是飞机数据集和RSOD数据集。飞机数据集来源于DOTA数据集[8],其中包含400 000个目标实例,涵盖15个类别。先通过图像切割和增广等数据处理方法扩充DOTA数据集,再将数据集的原始标签文件的格式转换为YOLO格式,之后从DOTA数据集中识别并记录文件中飞机目标的索引“3”,将其对应的飞机图像和标签文件抽取出来,最终构建了飞机数据集作为消融试验的数据集,其中包含11 388张遥感图像和13 831个目标实例用于训练,并将结果与其他CE模块作对比。RSOD数据集包含4个类别共936张遥感图像,从中随机选取742张图片作为训练集,194张图片作为测试集,并将测试集结果作为对比试验的数据集。

2.3指标评估为了评估目标检测方法的有效性,本文采用5种衡量检测结果优劣的评价指标。

式中:TP是准确预测正样本的数量;FP是误检为正样本的负样本的数量;FN表示预测为负样本的正样本的数量;平均精度(AP)是PR曲线所围成的面积表示该类别的平均精度值;类平均准确率(mAP)是所有类别精度的平均值;F1是准确率和召回率的加权平均值;n代表样本量;N代表总量。

AP50表示交并比(IoU)为50%时AP的均值;AP50:95表示交并比(IoU)从50%到95%每间隔5%时AP的均值,下同。

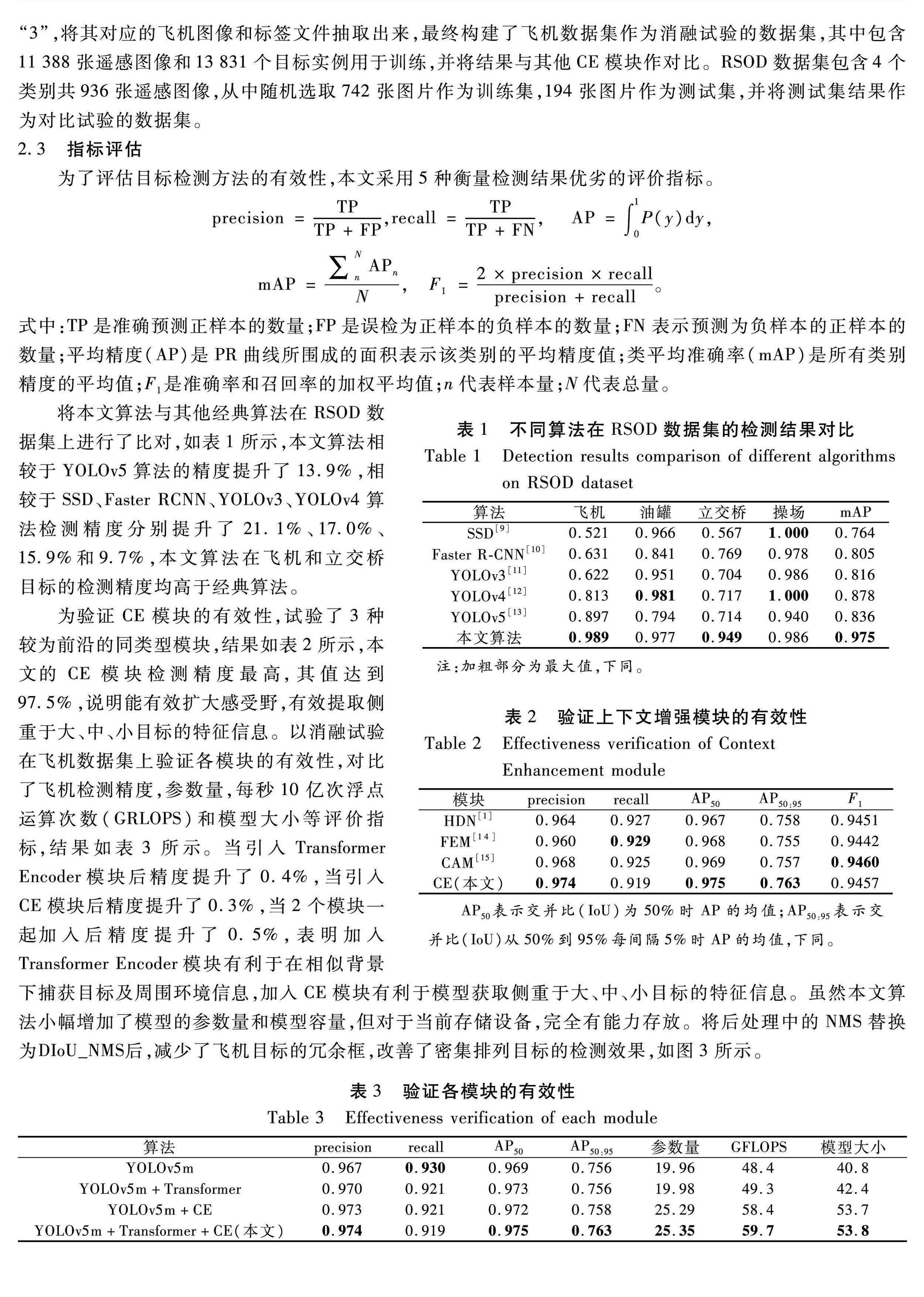

将本文算法与其他经典算法在RSOD数据集上进行了比对,如表1所示,本文算法相较于YOLOv5算法的精度提升了13.9%,相较于SSD、Faster RCNN、YOLOv3、YOLOv4算法检测精度分别提升了21.1%、170%、159%和97%,本文算法在飞机和立交桥目标的检测精度均高于经典算法。

为验证CE模块的有效性,试验了3种较为前沿的同类型模块,结果如表2所示,本文的CE模块检测精度最高,其值达到975%,说明能有效扩大感受野,有效提取侧重于大、中、小目标的特征信息。以消融试验在飞机数据集上验证各模块的有效性,对比了飞机检测精度,参数量,每秒10亿次浮点运算次数(GRLOPS)和模型大小等评价指标,结果如表3所示。当引入Transformer Encoder模块后精度提升了0.4%,当引入CE模块后精度提升了0.3%,当2个模块一起加入后精度提升了0.5%,表明加入Transformer Encoder模块有利于在相似背景下捕获目标及周围环境信息,加入CE模块有利于模型获取侧重于大、中、小目标的特征信息。虽然本文算法小幅增加了模型的参数量和模型容量,但对于当前存储设备,完全有能力存放。将后处理中的NMS替换为DIoU_NMS后,减少了飞机目标的冗余框,改善了密集排列目标的检测效果,如图3所示。

3结语

试验结果表明,在飞机数据集中、验证了CE模块的有效性;在RSOD数据集上,相较于基准算法YOLOv5的精度提升了13.9%,相较于SSD、Faster RCNN、YOLOv3、YOLOv4算法分别提升了21.1%、170%、15.9%和9.7%,将NMS替换为DIoU_NMS能有效去除冗余框,有效解决小目标密集排列漏检的问题,降低虚警率有利于更好地展现目标检测的性能。

因此,本文提出的算法提高了遥感图像目标检测算法的检测精度,为遥感图像目标检测的应用技术提供了可行的参考方案,但未来还有许多改进方向值得进一步尝试。因此,在未来,将针对轻量化方向进行网络优化,在嵌入式设备上进行部署,对网络的可移植性进行测评,得到适用于不同硬件的检测结果。

参考文献:

[1]CHALAVADI V,JERIPOTHULA P,DATLA R,et al.mSODANet:A network for multiscale object detection in aerial images using hierarchical dilated convolutions[J].Elsevier.2022,126:110.

[2]WANG Y,XU X F,LIU C W,et al.Context information refinement for fewshot object detection in remote Sensing images[J].Remote Sensing.2022,14(14):118.

[3]LI Q Y,CHEN Y S,ZENG Y.Transformer with transfer CNN for remotesensingimage object detection[J].Remote Sensing.2022,14(4):121.

[4]張云佐,郭威,李文博.遥感图像密集小目标全方位精准检测算法[J/OL].吉林大学学报(工学版),(20220905)[20221210]:http://doi.org/10.13229/j.cnki.jdxbgxb20220715.

[5]肖振久,楊玥莹,孔祥旭.基于改进YOLOv4的遥感图像目标检测方法[J].激光与光电子学进展,2023,60(6):407415.

[6]ZHU X K,LYU S C,WANG X,et al.TPHYOLOv5:improved YOLOv5 based on transformer prediction head for object detection on dronecaptured scenarios[C]// Proceedings of IEEE International Conference on Computer Vision Workshop.Piscataway:IEEE,2021:111.

[7]ZHENG Z H,WANG P,LIU W,et al.DistanceIoU loss:faster and better learning for bounding box regression[C]// Proceedings of AAAI Conference on Artificial Intelligence.Menlo Park:AAAI,2020:18.

[8]XIA G S,BAI X,DING J,et al.DOTA:A largescale dataset for object detection in aerial Images[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2018.

[9]LIU W,ANGUELOV D,ERHAN,D,et al.SSD:Single shot MultiBox detector[C]// Proceedings of European Conf erence on Computer Vision.Berlin:Springer,2016:2137.

[10]REN S Q,HE K M,GIRSHICK R,et al.Faster RCNN:towards realtime object detection with region proposal networks [C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2016:1-14.

[11]REDMON J,FARHADI A.YOLOv3:An incremental improvement[C]// Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2018:1-6.

[12]BOCHKOVSKIY A,WANG C Y,LIAO H Y M.YOLOv4:optimal speed and accuracy of object detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway:IEEE,2020:1-17.

[13]JOCHER G.YOLOv5[EB/OL].[20200610] [20231210].https://github.com/ultralytics/yolov5.

[14]ZHANG P,XU H,TIAN T,et al.SFRENet:scattering feature relation enhancement network for aircraft detection in SAR images[J].Remote Sensing.2022,14(9):1-18.

[15]肖进胜,赵陶,周剑,等.基于上下文增强和特征提纯的小目标检测网络[J].计算机研究与发展,2023,60(2):465-474.

Detection Method of Remote Sensing Image TargetsBased on YOLOv5 with Globalaware and Context Enhancement

YANG Xinxiuac, XU Limingb,FENG Zhengyongc

(a.School of Physics and Astronomy,b.School of Computer Science,c.School of Electronic Information Engineering,China West Normal University,Nanchong Sichuan 637009,China)

Abstract:On account of the dense arrangement of remote sensing image targets,a detection algorithm of remote sensing image targets is proposed on the basis of YOLOv5 with globalaware and Context Enhancement network.Firstly,the C3 module is replaced with the Transformer Encoder module at the tail of the backbone CSPDarknet53,and global attention is utilized to capture the targets and surrounding environment information;then,the Context Enhancement module is introduced to obtain the feature information focused on large,medium and small targets by employing different branching structures;after that,the NMS is replaced by DIoU_NMS in postprocessing to effectively remove the redundant boxes of densely arranged targets and improve the detection effect.The network is tested on the RSOD dataset,and the precision is improved by 13.9% when compared with that of the original network.Ablation experiments are conducted on the aircraft dataset to verify the effectiveness of the module.

Keywords:detection of remote sensing targets;YOLOv5 algorithm;Context Enhancement;Transformer module