基于深度学习的电影智能化摄制技术研究

2024-04-12胡堃解沛

胡 堃 解 沛

1.悉尼大学计算机科学学院,澳大利亚新南威尔士州 2006 2.中国电影科学技术研究所(中央宣传部电影技术质量检测所),北京 100086

1 引言

2023 年我国电影总票房为549.15 亿元,其中国产电影票房为460.05 亿元,占比83.77%[1],观影人次为12.99 亿。随着科技发展,电影拍摄与制作的工业化水平取得了极大提升,我国也正由电影大国向电影强国迈进。与此同时,深度学习(DL)作为机器学习(ML)的重要分支,近些年在计算机视觉(CV)、自然语言处理(NLP)、数据挖掘(DM)以及多模态内容理解等领域发挥了巨大作用。因部分环节工作的主观性与艺术性,电影摄制流程对于深度学习的结合与应用仍处于探索阶段。本文通过调研国内外现有技术与文章,针对摄制流程中的不同阶段,对深度学习技术在电影智能化摄制中的应用进行探讨与分析,以期提出电影工业化未来的发展趋势与方向。

2 深度学习技术与电影摄制流程的结合

电影摄制是一个涉及多个环节的复杂过程,通常根据时间线分为三大阶段:前期创意与筹备、中期拍摄以及后期制作。在前期创意阶段,首先是剧本创作环节,剧本作者会按照线性结构详细描绘故事情节、场景布局和对白。剧本完成之后,导演会要求分镜师根据剧本内容制作分镜头脚本,并详细规划每一镜头的编号、画面类型、拍摄手法和时长等信息。此外,对于包含计算机图形学(CG)元素的电影,还需对虚拟场景和角色进行建模和绘制;为了确保拍摄过程的顺畅,许多创作者还会对分镜头进行虚拟预演(PreViz)。拍摄阶段是电影制作中至关重要的一环,旨在捕捉分镜头脚本中所需的全部视频画面及部分现场声音素材,主要设备包括摄影机、麦克风和灯光系统等。在拍摄过程中,导演和摄影指导需紧密协作,确保每一镜头的构图与剧本或预演保持一致;灯光系统需提供符合镜头氛围的照明;尽可能多角度拍摄;要随时注意素材的安全保存与传输。此外,随着虚拟摄制技术的推广普及,运用动作捕捉和面部捕捉技术也日渐成为常态。后期制作指的是拍摄结束后进行的全部工作,包括素材的剪辑、声音设计、视觉效果(VFX)制作、色彩校正、混录以及母版制作等环节。

深度学习技术通过自动整合特征提取和建模过程,推动了多种任务的成功解决。与传统机器学习相比,深度学习依托于神经网络(Neural Network)架构,通过增加网络深度来形成对输入数据更强大的深层表示能力。目前,常用的深度学习架构主要包括多层感知机(MLP)、卷积神经网络(CNN)、循环神经网络(RNN)、图神经网络(GNN)[2]以及Transformer网络[3]等。其中,MLP 是深度神经网络的基础算法;CNN 擅长处理视觉和听觉方面的信息[4];RNN 能够有效处理和理解文章、视频或动作序列等连续的信息流;GNN 在动画仿真包括粒子特效领域、处理基于人体姿态识别[5][6]领域显示出强大能力;Transformer 网络具有理解复杂数据结构和模式的强大能力,同时通过引入跨模态注意力(Cross-Attention)机制,催生了如GPT[7]和Stable Diffusion[8]等模型。

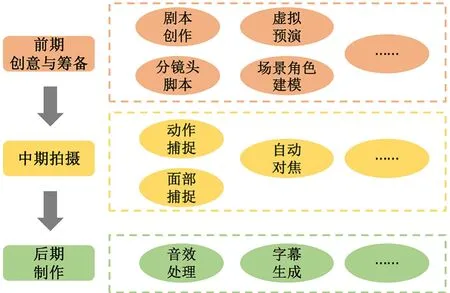

基于电影摄制的流程顺序,深度学习技术在不同阶段均有应用,主要应用场景如图1所示。

图1 电影摄制流程

3 深度学习在电影前期创意筹备阶段的应用

前期创意与筹备工作是整部电影的基石,既需要足够独特的剧本,也需要将创意落地的分镜头脚本,部分还需要为电影拍摄准备虚拟预演,此外,含虚拟场景的片段还应当为拍摄时使用的场景与角色进行建模。近年来,基于深度学习实现文本扩充、文生图以及文生视频等技术发展迅猛,在电影前期也得到了广泛应用。

3.1 剧本创作

剧本作为一部电影的基石,其创作显得尤为重要。随着数据集与模型的不断优化,现有技术所生成的剧本内容更加流畅也更符合人类阅读习惯。常见的剧本生成方式是利用已有文本对神经语言模型进行训练,输入简单的创意内容文本(通常是几句话),输出具有情节、人物等内容的长篇幅文本。Dharaniya 等[9]提出一种基于自然语言处理(NLP)的启发式算法的电影剧本生成模型。通过采集不同电影的文本数据(包括角色、场景和类型等)并进行数据预处理;再使用深度置信网络(Deep Belief Network, DBN)从代表性批归一化方法(Representative Batch Normalization, RBN)层中提取深度特征后获得相关特征;最后,将深度特征赋予基于集成学习的电影脚本生成(Ensemble-based Movie Script Generation,EMCG)系统,其中使用集成学习的脚本生成过程由双向长短期记忆网络(LSTM)、GPT-3 和GPT-NeoX模型执行。为了保证剧本内容既有相邻句子连贯性,又有段落之间的统一,相较于通过大量文本内容进行训练,Cho 等[10]尝试从连贯性和内聚性的角度对神经语言模型(NLM)进行升级,提出一种基于神经网络的跨句语言特征、连贯和衔接的长文本生成方法。作者在该方法中提供了两种鉴别器(Discriminator),其中连贯鉴别器帮助从宏观角度上构建段落,衔接鉴别器从微观上对相邻的句子进行连接。近年来,随着对话式人工智能的迅速发展,剧本生成也采用了类似模式,Zhu 等[11]提出一种基于所提供的叙述内容生成电影脚本的方法。该方法主要针对场景生成,通过更新机制跟踪叙述中提供的内容,每一次新生成的内容均是基于上下文、叙述和反馈之间的多重匹配。此外,他们还构建了一个大规模数据集,用于从电影脚本中生成叙事引导脚本。类似的,Eldhose 等[12]提出一种名为“Alyce Garner Peterson”的人工智能剧本微调模型,该模型能够根据给定的故事给出剧本内容。

3.2 图像生成

无论是创作用于拍摄的分镜头故事板,还是设计现场或虚拟场景的布景说明,将文字描述转换成相应的图像内容都是一个关键步骤。对于图像生成任务,主要的模型包括生成式对抗网络(GAN)[13][14][15]、扩散模型(Diffusion Model)[16][17]以及变分自编码器(Variational AutoEncoder, VAE)[18]三类(图2);每一类模型都可以进行有条件和无条件的图像生成。其中,有条件生成根据给定的条件或信息生成图像,而无条件生成则随机生成符合训练数据分布的图像。

图2 三类生成模型的特点

特别地,以文本作为条件,微软和京东共同开发了一种名为对象驱动的注意力生成式对抗网络(Object-driven Attentive Generative Adversarial Network,Obj-GAN)[19]。它允许以对象为中心的复杂场景的文本生成图像,并引入了一种基于快速R-CNN 的目标检测模型,以提供详细的对象信息来确保生成的对象与文本描述和预设的布局相匹配。作为近年来热门的深度学习模型,Stable Diffusion 是一个文本生成图像模型。该模型通过逐步迭代的方式,将原始图像的潜在表示扩散到高分辨率图像。

相较于单纯的文本到图像的转换,基于图像作为条件的场景也得到了广泛研究。例如,Zeng 等[20]提出用于从任何精度级别语义实现图像生成的框架SceneComposer,既实现了基于纯文本生成图像,也可以针对画布上的涂鸦进行图像生成。

3.3 虚拟预演

在电影准备阶段,为了保证开拍后的每一个镜头顺利完成拍摄,不仅需要绘制故事板,还需要完成部分镜头的虚拟预演(PreViz)。利用深度学习技术完成虚拟预演视频的生成,通常需要提供每一个分镜的场景描述,包括但不限于人物、置景、光线以及构图等内容,利用上述内容,我们期望生成一个合理、能够符合所提供文本内容的视频。基于上述需求,Zhang 等[21]提出一个处理复杂文本到动画的方法。基于现有的剧本创作动画生成系统,作者构建了一个自然语言处理(NLP)流程。首先将输入的剧本内容分割成不同的功能块,然后对描述性的句子进行简化,最后使用简化句子生成动画。作者还提出一组简化复杂句子的语言转换规则,以从简化句子中提取的信息用于生成描述文本的粗略故事板和视频。通过实验,68%的参与者认为该系统可以基于剧本生成合理的动画。虚拟预演除了根据文本生成相关视频画面外,通常还需要体现镜头、布景、人物位置甚至灯光等内容。针对这类需求,Zhu 等[22]提出MovieFactory,该方法可以根据自然语言所描述的需求生成包含画面的多模态电影内容。这是第一个完全自动化的电影生成模型,使用简单的文本输入创建连贯的电影内容。该方法第一步利用ChatGPT将提供的文本扩展为用于电影生成的详细顺序脚本;第二步通过视觉生成和音频检索,在视觉和听觉上进一步丰富脚本;第三步,采用空间微调弥合预训练图像模型和新视频数据集之间的差异;最后,引入时间学习来捕捉对象运动的特征。此外,在音频方面,该方法利用检索模型来选择和对齐与电影情节和视觉内容相对应的音频元素。对于声音效果,作者从原始文本内容或生成的视频内容中提取特征,并将它们与数据库中合适的音频剪辑进行匹配;对于背景音乐,则利用ChatGPT 来总结情节和音调,然后将推荐的音调类别与音乐信息检索技术相结合来识别合适的音乐曲目。MovieFactory 生成的样本可在 YouTube 或者bilibili上查阅。

近期,OpenAI 提出其第一个视频模型Sora[23]。在发布的技术报告中,研究人员表示其与GPT 模型同样采用Transformer 网络架构,这种架构可以处理视频和图片中时空片段的隐式空间表示。Sora 是一种扩散模型,它从看起来像静态噪声的视频开始生成视频,通过多个步骤消除噪声来逐渐还原视频。除了能够仅根据文本说明生成视频,该模型还能通过静止图像生成视频,从而提升准确性和对细节的关注。基于不同的输入(文本、图像甚至视频),Sora可以应用在不同的场景下,它可以将视频沿时间线向前或向后进行扩展;改变输入视频的风格和环境;实现视频间的拼接与平滑过渡;还可以对现有视频进行扩展或填充缺失帧。Sora 目前也存在无法精确模拟物理运动以及长视频逻辑不连贯等问题,但相比于其他视频生成模型,Sora 已经能够创造出更符合真实运镜效果的视频,也更加契合电影摄制的技术与艺术要求。

3.4 场景建模

在现代电影制作中,除了实地拍摄外,部分镜头常采用虚拟摄制技术,包括传统蓝幕/绿幕技术和采用LED 显示屏的新技术。无论选择蓝幕/绿幕还是LED 显示屏,构建逼真的虚拟场景都非常关键,这不仅包括整体环境的搭建,还涉及场景中的细节,比如纹理和气候所形成的地质特点。三维扫描实际场景后创建虚拟环境,是一种被广泛应用的整体环境构建方法。为了解决从实景点云数据输入到3D 建模场景输出的问题,Handa 等[24]提供了一个用于生成高质量室内环境3D 场景的框架——SceneNet。他们提出一种分层模型生成器,利用从现有室内场景数据集中学习到的对象关系先验,通过模拟退火算法(Simulated Annealing, SA)进行求解。扫描后的场景在转换成虚拟场景时,如需对不同物体进行识别和分割,过去通常需要耗费大量的人工进行识别。对于该问题,Chen 等[25]提出通过点云驱动的深度学习方法,该方法可以检测并分类点云场景中的建筑元素。在论文中,首先将点云转换为图形表示并通过基于边缘的分类器对来自不同对象的点的边缘进行识别;之后利用分类器识别到的边缘进行组件分割并确定建筑组件的类型;最后,将每个检测到的对象与特征空间中的建筑信息模型(Building Information Modeling, BIM)进行匹配。针对场景中每一个对象的动态纹理生成,Tesfaldet 等[26]提出用于动态纹理合成的基于卷积神经网络(CNN)的双流网络模型。Pajouheshgar 等[27]提出一种可以实时合成任意帧大小和无限长度动态纹理视频的模型。利用多尺度感知和位置编码,该模型中局部单元可以进行远距离建模并获取全局信息。通过定性和定量实验表明,与普通的近邻成分分析(Neighbourhood Components Analysis, NCA)模型相比,该模型在视觉质量和计算表达能力方面有更高的性能。

3.5 角色建模和设计

除了场景建模外,电影拍摄还常常会用到角色建模技术。通过角色建模,既可以实现对真人演员的数字化,也可以构建纯虚拟的数字人物。在真人建模的领域,相较于全身的数字化生成,仅针对面部或头部建模的研究与应用更为研究者所热衷。在角色建模和设计时,通常需要真实人物数据(一张图片或一段视频)来生成数字角色。Nagano 等[28]通过GAN 实现了仅使用一张2D 输入图像来驱动动态头像的构建。该网络根据生成的口腔内部和眼睛纹理来合成动态头像动画,这是第一个能够从单个图像生成具有口腔内部动态纹理的技术。Wei 等[29]提出一个利用面部特征制作与真人表情相似动画的系统,该系统使用消费级别的头戴式摄像头(Headset Mounted Camera, HMC)即可实现。该系统需要使用两套不同的HMC 设备——训练HMC 和追踪HMC,训练HMC 体积较大,配备9 个摄像头,旨在数据采集和模型构建;追踪HMC 内置3 个摄像头,用于精确制作动画。Galanakis 等[30]通过创建一个巨大的带有标签的面部渲染合成数据集并将其用于训练网络,使后者能够准确地建模和概括面部身份、姿势和外观。该模型可以准确地提取面部特征,拟合任意姿势和光照的面部图像,并用于在可控条件下重新渲染面部。除了角色建模外,如何实现生成角色与虚拟场景的交互也是目前热门研究内容,对于该问题,Starke 等[31]提出一种神经网络框架来合成涉及与环境密切交互的动作(坐下、站立、绕行以及开门等)。该系统通过输入目标位置以及需要实现的动作,计算完成目标动作过程中需要的动作,同时计算过程中需要避开或适应的障碍或家具,最终生成一段动画序列。

4 深度学习在电影拍摄中的应用

相较于电影制作前期,深度学习在电影拍摄过程中的应用并不普遍。这是因为实际拍摄环节涉及摄影师、灯光师和录音师等分属不同工种的众多专业人员,使基于深度学习的技术解决方案尚未能够在全环节广泛实施。目前深度学习技术主要应用于动作与面部捕捉、实时对焦等方面。

4.1 动作捕捉与面部捕捉

在电影拍摄当中,动作捕捉通常用于利用捕捉到的运动数据驱动已建模角色进行同样的运动。通过结合深度学习技术,可以对已经记录下的运动数据进行插帧以及修改。此外,目前还有技术可实现对视频内容中的人物进行动作捕捉,Tung 等[32]提出一种单相机输入的基于深度学习的运动捕捉模型。该模型不是直接优化网格和骨架参数,而是优化神经网络权重,在给定单目视频的情况下预测3D 形状和骨架配置。该模型使用强监督和自监督相结合的端到端方式进行训练,其中强监督数据使用合成数据,自监督数据使用骨骼关键点、密集3D 网格运动以及人类-背景分割三部分可微分渲染数据。在面部捕捉领域,研究方向更多是对拍摄视频内容进行识别与捕捉。Laine 等[33]提出一个基于视频的面部表演捕捉实时深度学习框架,在给定单目视频的情况下对人脸进行密集的3D 追踪。为了提升准确性,该框架的面部捕捉流程使用了多视角立体跟踪方法和艺术家手动修正关键区域(例如眼睛和嘴唇)的方式。Wang 等[34]针对面部表情动态捕捉,提出一种基于深度学习的面部特征提取和3D 动画生成方法,并利用支持向量机(Support Vector Machine, SVM)技术进行特征分类。作者通过C++和OpenGL 对3D 动画进行渲染模拟。实验结果表明,该方法的人脸检测算法在准确率和速度上均具有良好的性能,可以实现视频图像中人脸区域的实时检测。

4.2 对焦的实现

在电影拍摄中,确保焦点的准确性至关重要,而自动对焦技术则能进一步保障拍摄工作的顺利进行。目前,大多数技术专注于对已拍摄的视频或图像内容进行后期对焦处理。Wang 等[35]研究者提出一种基于图像的自动对焦新流程,能够迅速准确地找到焦点,速度比以往对比度增强方法快5~10 倍,通过建立图像与其焦点位置之间的直接映射来实现快速对焦,并设计了一种焦点控制策略,通过动态调整焦点位置,极大地提高了基于焦点堆栈估计的图像质量。Zhang 等[36]提出一种电影焦点追踪方法和系统,能够在智能手机拍摄的深景深视频中生成可重调焦的视频内容,并利用对未来视频帧的分析,为当前帧提供上下文感知的自动对焦功能。为了生成这种可重新对焦的视频,研究者们扩展了原本设计用于静态摄影的先进机器学习方法,提供了新的数据集、更适合电影焦点处理的渲染模型,以及保证时间连贯性的过滤方案。Nazir 等[37]提出一种利用深度神经网络实现对单张失焦图像的深度估计,并获得全焦(All-in-Focus, Aif)图像。该方法是由一个编码器和两个并行解码器组成的双头架构,每个解码器实现不同的任务,一个输出深度信息,另一个输出去模糊图像。

5 深度学习在电影后期制作中的应用

对于后期制作,深度学习主要应用于音视频处理与增强等方面。相较于其他两个阶段,深度学习在后期制作中已具备较为成熟的应用场景,也是应用效果较好的一个领域。

5.1 音乐处理和生成

除了拍摄期间录制的同期声外,音乐和音效的制作通常都在后期完成。目前,基于深度学习的音乐处理技术发展迅猛,尤其是在利用乐谱进行音乐合成方面已经取得较为成熟的进展。Mao 等[38]开发了一种名为DeepJ 的端到端生成模型,该模型能够模仿特定作曲家的风格来创作音乐,并能学习不同的音乐风格和音符的高低起伏。通过主观评价,证明了该模型相比于传统的长短期记忆网络(LSTM)方法有明显改进。Li 等[39]提出一种创新的旋律创作方法,该方法优化了基于单个小节的生成式对抗网络(GAN)模型,并引入了两个判别器来构建一个增强型的GAN 模型:一是LSTM 模型,确保乐段之间的连贯性;另一是CNN 模型,增强乐段间的一致性。另一项研究中,Li 等[40]还提出MRBERT 预训练模型,专注于多任务音乐生成,包括旋律和节奏的学习。该模型经过微调后,能够在多种音乐生成应用中使用,如网络音乐作曲家,实现旋律生成、编辑、补全及和弦匹配等功能。Li 等[41]还提出一种使用基于Transformer 网络的序列到序列模型生成旋律和弦的方法,该模型分为预训练的编码器和解码器。Lu 等[42]则提出一种从文本描述生成乐谱的系统,该系统通过音乐属性作为中介,将任务分解为从文本到属性的解析和从属性到音乐的生成两个阶段,特点是数据高效和能够精确控制生成结果。Parker 等[43]提出一种基于非自回归Transformer 的端到端音乐生成模型,该模型可以理解给定音乐并基于输入音乐生成新的音乐。

5.2 字幕生成

字幕生成通常是后期制作中耗费人工时间最长的几项工作之一,目前深度学习技术还无法完全代替手动添加字幕,但也有了不错的方法。Xu 等[44]提出一种深层框架,通过学习多模态注意力长短期记忆(Multimodal Attention Long-Short Term Memory, MA-LSTM)来增强视频字幕的网络。MA-LSTM 网络充分利用多模态流和时间注意力,在句子生成过程中有选择地关注特定元素。此外,MA-LSTM 中还设计了一种新颖的子和(Child-sum)融合单元,以将不同的编码模式有效组合到初始解码状态。Li 等[45]提出一个分层模块化网络,在生成字幕之前在实体、动词、谓词和句子4 个粒度上桥接视频表示和语言语义。每个级别由一个模块实现,以将相应的语义嵌入到视频表示中。此外,作者还提出一个基于字幕场景图的强化学习模块,以更好地测量句子相似度。实验结果表明,所提出的方法在三个广泛使用的基准数据集上的性能优于此前的模型。

6 挑战与前景

电影摄制是艺术创作与高新技术应用相结合的工作,既有需要大量创意与设计的剧本撰写、拍摄等工作,也有简单机械的字幕生成等工作。通过上述回顾我们可以看到,无论是艺术创作还是简单的重复性工作,都已经开始通过与深度学习技术相结合,进一步提升电影制作效率。未来,应做好以下工作。

(1)提升输出效率与输出内容专业性

在电影摄制过程中,Transformer 网络已然成为构建各种生成模型的首选。基于Transformer 网络的GPT 和Sora 能够很好地理解与分析自然语言,在剧本创作、分镜脚本生成、虚拟预演等工作上具有优秀的表现;基于扩散模型和Transformer 网络的Stable Diffusion 更擅长于文生图以及图生图等领域;基于Transformer 网络的SteamGen 等模型在音乐的生成与处理领域具有更多的研究进展。然而,目前各类算法仍然存在输出效率不高,输出内容不精细等问题。未来,研究人员可以继续在Transformer 网络上进行深入研究,升级或创新生成模型,提高生成效率,进一步提升输出的音视频内容精确性与专业性。

(2) 扩充完善电影级训练数据集

目前基于电影的专用深度学习算法与技术还处于发展阶段,这不仅需要硬件的升级与算法的创新,同样需要基于电影领域专用训练数据集的帮助。由于深度学习的主要算法是数据驱动,如果用于训练的数据由于人为选择标准或标签而分布不均或不具代表性,则学习后的结果同样可能存在偏差。未来,研究人员在提出新算法的同时,也应当建立和补充更加丰富多元也更为专业的训练数据集,同时考虑观众偏好以及时代特征,符合相关审查规范,进一步推动深度学习模型在训练时数据集的专业性与完备性。

(3)研究基于电影摄制全流程的深度学习技术

基于深度学习的电影摄制解决方案仍在持续涌现,然而目前深度学习技术在电影摄制方面的应用仍然处于割裂且分散的状态,无法实现对电影前后期全流程进行统一而全面的应用。在持续推进各阶段不同工作的新技术新应用的同时,还应当全局考虑电影摄制整体流程,尝试实现基于全流程的深度学习新应用;还可尝试将不同深度学习网络模型进行融合与集成,从而使深度学习技术不再单独完成单一任务,真正实现从剧本创作到成品电影的全流程智能化,进而创造出有价值、有意义的作品与内容。❖