基于Swin Transformer和图形推理的结直肠息肉分割方法

2024-04-12梁礼明何安军

梁礼明,何安军,阳 渊,吴 健

江西理工大学电气工程与自动化学院,赣州 341000

结直肠癌是一种常见危害人类健康的致命疾病,其发病率和死亡率均位居世界癌症发病率和死亡率的前三位[1-2]. 因此,通过筛查试验和准确诊断结直肠息肉对预防结直肠癌至关重要. 然而,结直肠息肉图像对比度低,病灶区域变化尺度大、病灶位置多变和边缘模糊等复杂特性,使得结直肠息肉分割仍面临着诸多挑战.

结直肠息肉分割方法主要分为传统分割方法[3-5]和基于深度学习的分割方法[6],传统分割方法依赖于人为参数的设定,对轮廓复杂、形态变化大和对比度低的结直肠息肉图像分割效果较差. 随着深度学习的普及,卷积神经网络(Convolutional neural network,CNN)以强大的特征提取能力在医学图像分割领域取得里程碑式的突破,Ronneberger等[7]提出对称的编码器–解码器网络架构U-Net,该网络在编码器–解码器之间采用跳跃连接方式,实现高低层次的特征融合. 然而,U-Net仅实现深层语义信息和浅层细粒度信息的简单融合,易引入背景噪声且难以建立像素间的远距离依赖关系,所以U-Net架构在一定程度上还有改进空间. Zhou等[8]在原U-Net的基础上将跳跃连接设计成密集跳跃连接,提出UNet++网络,密集跳跃连接能有效减少深层特征与浅层特征之间的语义鸿沟,但引入了极大的计算量和复杂度. Fan等[9]提出一种反向注意力网络(Parallel reverse attention network,PraNet),利用反向注意力机制来探索目标区域与边缘细节线索之间的高阶关系,基于区域与边界交互的思想,在结直肠息肉分割中获得较好的分割性能,但对小目标的精准定位还存在不足,产生误检现象较为严重. Lou等[10]利用通道金字塔模块来增大模型感受野,以适应不同尺度大小的分割目标,该策略提高了分割精度,但整体流程较为复杂.

Transformer[11]结构能够建模显性的全局上下文信息,不局限于局部运算,在自然语言处理任务中有着出色表现. Chen等[12]提出TransUnet架构,首次将Transformer结构应用于医学图像分割领域,超越基于卷积神经网络结构的分割精度,开辟了医学分割领域的新范式. Dong等[13]以金字塔视觉Transformer作为网络编码器,探索输入图像的上下文信息,设计相似性聚合模块挖掘局部信息与全局信息之间的依赖关系,在结直肠息肉分割中获得良好的分割精度,但该结构对病理性区域占比大的图像还存在误分割. Park和Lee[14]结合Swin Transformer[15]和Efficientnet[16]提出SwinE-Net,利用多扩张卷积对多层次特征进行细化,以提高多层次特征的可鉴别性,有效改善了结直肠息肉的分割精度,但在未知数据集上的泛化能力较差.

针对结直肠息肉分割当前面临的技术挑战,本文提出一种基于Swin Transformer和图形推理的自适应网络(Adaptive networks based on swin transformer and graph reasoning,GRFormer). 该网络在Transformer结构的基础上引入图卷积神经网络(Graph convolution neural networks,GCNNs)[17],不仅能有效缩短远距离特征间距建模全局上下文信息,还增强了各像素点之间的拓扑结构,处理图节点与图边的高阶关系,捕捉丰富的局部细节特征. 此外,本文提出全局与局部特征交互(Local global feature interaction,LGFI)模块,将多层次特征进行交互,以增强模型的微观表达能力. 利用区域引导图推理(Region-induced graph reasoning,RIGR)模块对高级语义信息和低级空间细节信息的依赖关系进行图形推理,高亮分割目标的位置信息. 最后通过边缘约束图推理(Edge-constricted graph reasoning,ECGR)模块来提高分割目标边缘细节信息的可见性.

1 方法

1.1 研究基础

卷积神经网络通过与局部像素进行点运算挖掘输入图像局部特征相似性,对平移、缩放、旋转等变换具有不变性,受到卷积核大小、网络结构以及计算资源的限制,卷积神经网络无法对图像上下文信息进行长期交互,难以消除多尺度特征之间的语义差异. 而Swin Transformer结构使用多头注意力机制来建模像素间的长期依赖关系,具有动态权值和全局接受阈,结直肠息肉图像病灶区域与正常组织相似度高、边缘模糊,有效处理全局上下文信息能有效减少病灶区域误分割,提高分割精度.

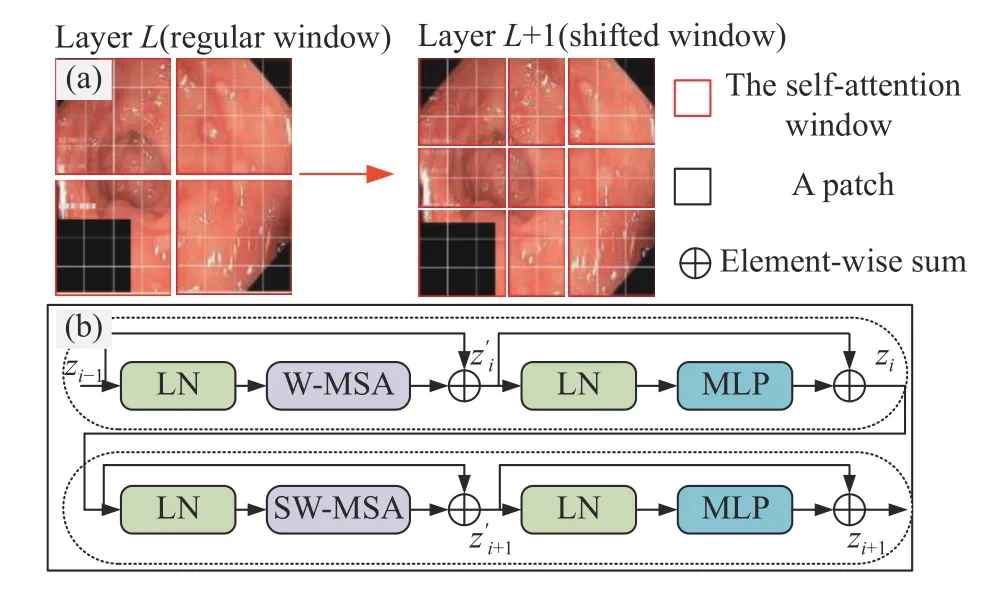

Swin Transformer结构将编码器分成四个阶段,每个阶段均由若干个Swin Transformer 核心模块和一个补丁融合组成. Swin Transformer编码器首先将输入尺寸为H×W×3图像进行补丁分区操作,对每个相邻4×4像素划分为一个补丁,并沿着高度轴和宽度轴进行展平使图像维度变成H/4×W/4×48,然后通过线性嵌入层进行通道数变换,图像维度重塑为H/4×W/4×96,最后输入Swin Transformer核心模块中对全局上下文信息进行建模. 每个Swin Transformer 核心模块均由两个连续的基于窗口多头注意力机制(Window based multi-head self attention,W-MSA)和基于滑动窗口多有注意力机制(SWMSA),层归一化(Layer normalization,LN),多层感知器(Multi-layer perceptron,MLP)以及残差结构组成. 其结构如图1所示. 图中:zi表示第i个模块经过LN,MLP和残差结构输出特征图;z′i表示第i个模块经过LN,W-MSA或者SW-MSA和残差结构输出特征图. 其整体计算流程如下:

图1 Swin Transformer结构. (a) 自注意移动窗口方法; (b) Swin Transformer核心模块Fig.1 Swin Transformer structure: (a) self-attention moving window method; (b) Swin Transformer block

计算W-MSA和SW-MSA中自注意机制时,每个head的计算表达式为:

其中,Q,K,V∈Rm2×d分别为查询矩阵、键矩阵和值矩阵;d为序列特征维度;m2为一个窗口的补丁数量;B∈Rm2×m2表示可学习的相对位置编码矩阵,其值在参数化的偏置矩阵∈R(2m-1)×(2m+1)中获取.

1.2 总体结构

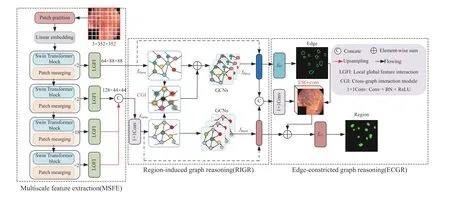

为增强网络对全局信息显式建模能力以及局部细节微观表达能力,针对结直肠息肉数据特点,本文提出一种基于Swin Transformer和图形推理的自适应分割网络,如图2所示. 其整体结构主要由多尺度特征提取(Multiscale feature extraction,MSFE)、区域引导图推理和边缘约束图推理三部分组成.多尺度特征提取首先利用图块分割层将输入图像划分多个4×4的块状序列图,并对每个块状序列图进行线性变换和位置编码信息嵌入,然后将图像输送到Swin Transformer block中进行特征提取和空间信息压缩,共包含四个阶段每个阶段Swin Transformer block数量分别为2,2,18,2,最终每个阶段得到分辨率为原图1/4,1/8,1/16和1/32的多尺度特征图,最后将每个阶段的多尺度特征图送入全局与局部特征交互模块中进行特征重构和特征自适应互补. 区域引导图推理利用图循环操作来充分挖掘待分割目标和分割目标边缘细节之间的高阶显性关系. 边缘约束图推理对区域引导图推理的结果进行进一步特征优化,以增强网络对小目标边缘像素点的识别能力.

图2 基于Swin Transformer和图形推理的自适应网络Fig.2 Adaptive networks based on the Swin Transformer and graph reasoning

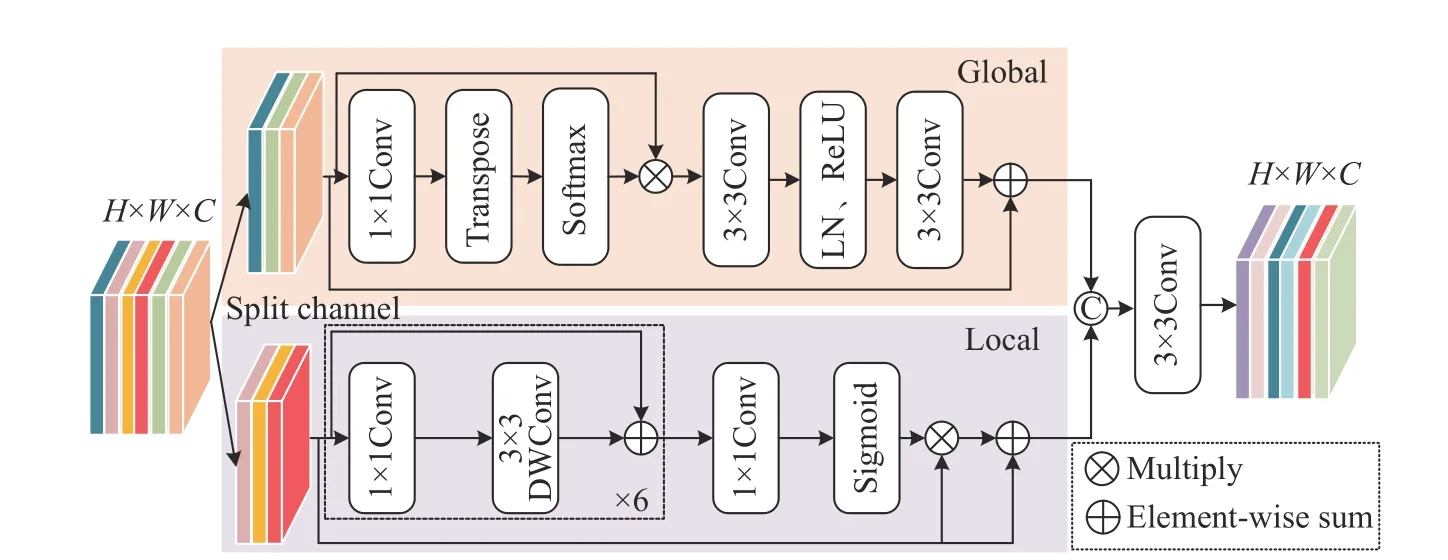

1.3 全局与局部特征交互模块

结直肠息肉图像病灶区域的局部特征具有相关性,即使网络编码部分能有效分析病灶区域的全局语义信息,但在捕捉局部细节特征能力受限,容易引入背景噪声和产生描述性差异. 为提高局部细节信息和全局语义信息之间的交互,文献[18]提出多尺度上下文感知模块以不同的感受野学习病灶区域的上下文信息,并为待分割目标区域提供合适的学习权重. 文献[19]设计多尺度特征交互模块来探索复杂的语义信息以聚合多个分割区域,并逐步融合离散的局部信息. 本文设计全局与局部特征交互模块来优化目标区域的相关性信息,同时解析全局特征与局部特征之间的内在联系. 其结构如图3所示,全局与局部特征交互模块主要包括全局信息嵌入和局部细节信息生成两条分支. 对于给定输入特征Fi,模块首先使用通道分离操作对输入特征进行均等划分,目的是为了平衡精度和计算资源,然后将划分后的特征图输入到全局信息嵌入和局部细节信息生成这两条分支进行特征优化,最后利用一个3×3的标准卷积融合两个分支的结果. 其具体计算过程如下:

图3 全局与局部特征交互模块Fig.3 Local–global feature interaction module

其中,Gsa(·)表示全局信息嵌入,Lsa(·)表示局部细节生成,Concat(·)表示拼接操作,C3×3(·)表示3×3卷积操作.

全局信息嵌入主要强调空间中每个像素点之间的远程依赖关系,填补局部细节信息生成分支的语义空白. 给定输入特征,首先对其使用1×1的卷积操作,目的是实现降维,随后采用空间池化操作以建立各像素点之间的依赖关系,然后利用Softmax函数高亮重要特征,最后经过两个3×3的卷积、一个层归一化和ReLU激活函数来优化更多的全局特征. 其具体计算过程如下:

其中,AttG(·)表示注意力操作,C1×1(·)表示1×1卷积操作,MLP(·)由两个3×3的卷积、一个层归一化和一个ReLU激活函数组成,⊗表示矩阵乘法.

局部细节信息生成分支主要是从给定特征图中挖掘感兴趣的局部细节特征. 其具体计算过程如下:

其中,Fc(·)表示级联6个1×1卷积和6个3×3深度可分离卷积,AttL(·)表示局部注意操作,σ(·)表示Sigmoid函数.

1.4 区域引导图推理模块

多尺度特征提取阶段任务主要是分析结直肠息肉图像的语义信息和空间细节,该阶段最终得到一个含有丰富语义信息的特征表示结果FC和一个含有边界明显且失真较少的特征表示结果FE. 受到文献[20]的启发,本文引入区域引导图推理模块,充分推理FC和FE之间的区域引导语义关系. 该模块由四个部分组成,即图投影(Graph projection,fGproj),交叉图交互(Cross-graph interaction,fCGI),图形推理(Graph reasoning,fGR)和图像重投影(Graph reprojection,fRproj). 该模块首先通过图投影操作将给定输入FC和FE转化为依赖于样本信息的语义图ΓC=(VC,QC)和ΓE=(VE,QE),然后利用交叉图交互模块来捕获ΓC和ΓE之间的高级依赖关系,并将VC语义信息转移到VE即VE′=fCGI(VC,VE),再后,利用图卷积进行图形推理得到图形表示结果OC和O′E,最后将图形表示结果OC和投影到原坐标空间即

1.4.1 图投影

对于给定输入FC∈Rh×w×c或FE∈Rh×w×c,首先使用1×1卷积降低输入特征图维度,然后使用图投影操作将降维后的特征表示结果FlC∈Rh×w×C′或∈Rh×w×C′转化为图节点嵌入即VC∈RC′×K或VE∈RC′×K,最后利用偏置矩阵W∈RK×C′和S∈RK×C′来参数化图投影操作. 其中wk为偏置矩阵W第k个可学习的聚类中心节点,其每个节点的具体推理过程如下:

其中,σk是偏置矩阵S的列向量,是特征向量fi和wk之间的残差加权平均值,vk表示第k个节点,并形成节点特征矩阵V的第k列,qik是特征向量fi到wk的软分配,其具体计算公式为:

通过测量节点内之间的亲和力来计算图的相邻矩阵,即Aint=fnorm(VT×V)∈RK×K,fnorm表示归一化操作.

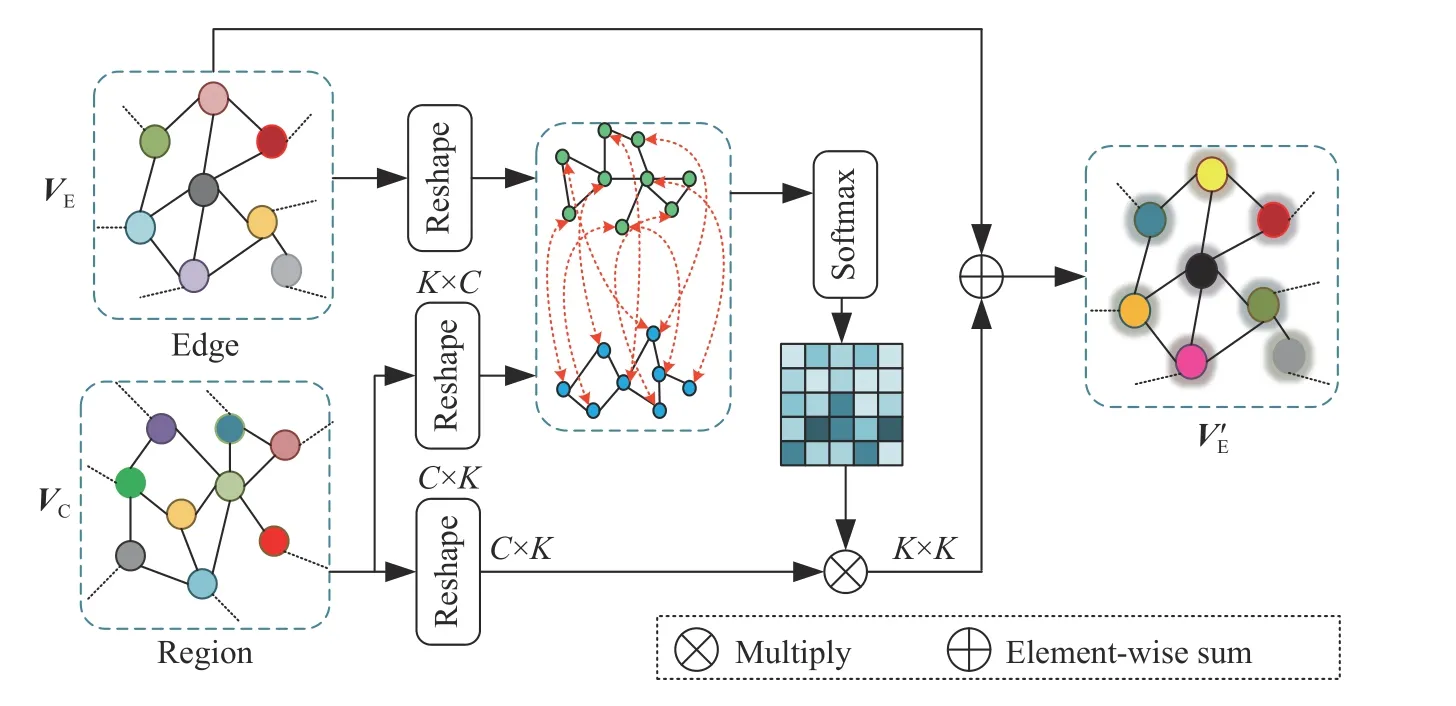

1.4.2 交叉图交互模块

交叉图交互模块对不同图进行建模交互,将图VC的拓扑信息传递到VE,并利用注意力机制来计算图之间的依赖关系,其结构如图4所示. 首先利用不同多层感知器(MLP)对图VC和图VE进行转化,得到关键图,值图和查询图,然后,通过矩阵乘法计算相邻矩阵. 其具体计算过程如下:

图4 交叉图交互模块Fig.4 Crossgraph interaction module

其中,χ表示加权参数.

1.4.3 图形推理

其中,g(·)表示非线性激活函数,WC和WE表示可学习参数,和表示和VC的图相邻矩阵.

1.4.4 图重投影

为了将图形推理部分得到的增强特征图表示映射到原始坐标空间上,本文重新访问图投影步骤中的软分配. 将含有丰富语义信息的特征图用赋值矩阵表示,其,将含有边界明显,失真较少的特征图用赋值矩阵表示,其. 图重投影操作具体计算过程为:

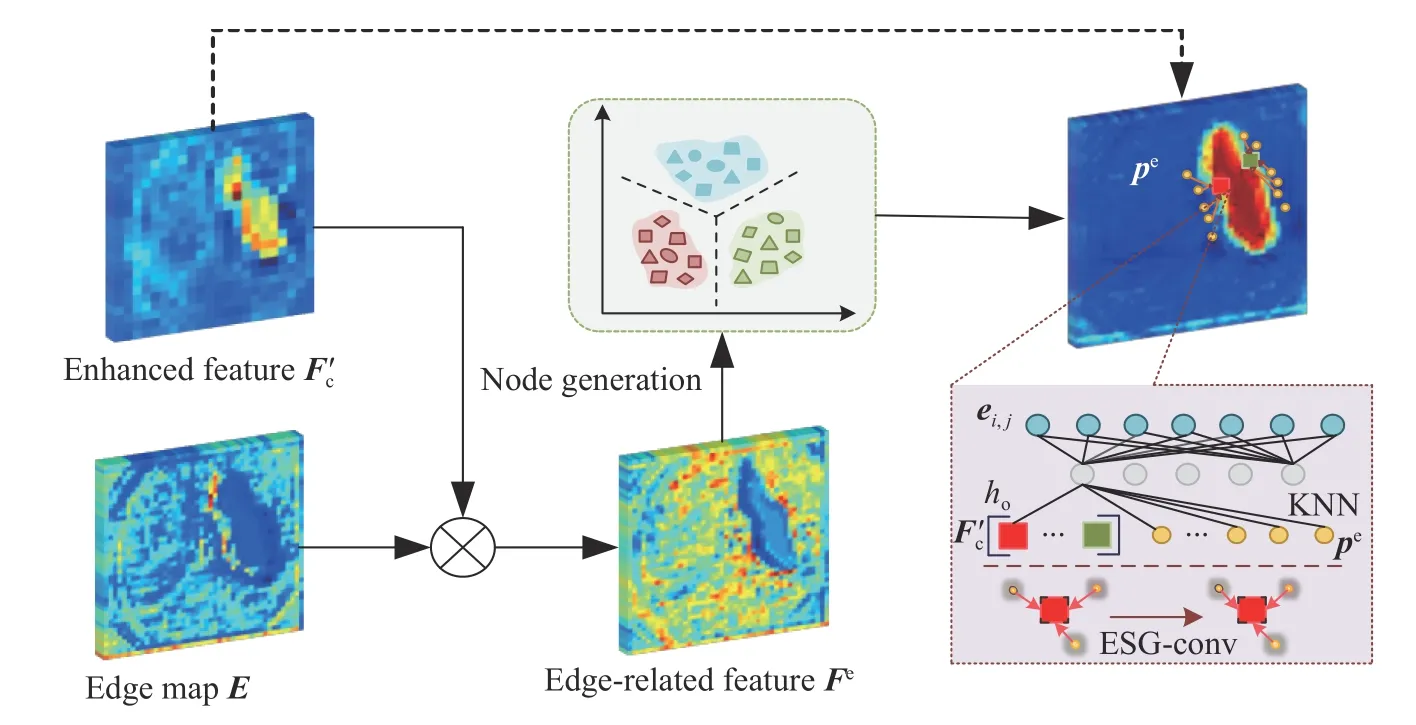

1.5 边缘约束图推理模块

为进一步改善区域特征与边界线索之间的关系,使模型具有显性边缘感知能力和精准定位待分割目标,本文在区域引导图推理模块后采用边缘收缩图推理模块[20]. 边缘收缩图推理模块主要由支持性节点生成(Supportive nod generation)和边缘支持图卷积(Edge supportive graph convolution,ESGconv)两个部分组成.

1.5.1 支持性节点生成

构建边缘支持图Γe(E)首要任务是生成基于边的节点嵌入,首先通过全连接层操作对特征图进行边缘感知空间映射得到映射结果E∈Rh×w×1,然后利用注意力机制获取网格中边缘像素的相关特性即,最后通过图投影操作将Fe转换为基于边z的节点嵌入且用来表示边的先验知识.

1.5.2 边缘支持图卷积

边缘支持图Γe(E)=(βE,ξE)作为k-NN[21]图将融合特征图与基于边的先验知识pe进行连接,其中βE和ξE分别表示边缘支持图Γe(E)的顶点和边. 具体来说,就是将每个特征向量视为边缘支持图的中心节点,作为边缘支持图的边缘支持节点. 边缘嵌入ei,j可以定义为:

其中,hϕ(·)表示可学习参数ϕ的非线性函数.

第i个特征向量的边缘支持图卷积输出结果为:

其中,hφ(·)表示可学习参数φ的学习节点嵌入.

边缘收缩图推理模块如图5所示,该模块首先将边界明显,失真较少的增强特征图输入到边缘分类器fEC中获得边缘感知特征图E,然后采用Concat操作融合区域引导图推理模块的输出结果和形成融合特征图,再后通过注意力机制以逐元素相乘的方式获取特征图的边缘相关特征即Fe=,最后设计一种新颖边缘支持图卷积来编码边缘信息和高效定位分割对象即ESGconv.

图5 边缘约束图推理模块Fig.5 Edge-constricted graph reasoning

2 实验与分析

2.1 数据集和实验设置

本文使用四个公开的结直肠息肉数据集来验证本文方法的分割性能,即CVC-ClinicDB[22]、Kvasir-SEG[23]、CVC-ColonDB[24]和ETIS[25]. 其中CVC-ClinicDB数据集包含612张分辨率大小为384×288的息肉图像与其对应标签;Kvasir-SEG数据集包含了1000张分辨率从332×487到1920×1072的息肉图像与其对应标签;CVC-ColonDB数据集包含了380张分辨率为574×500的结肠镜图像;ETIS数据集包含了196张分辨率为1226×996的结肠镜图像.随机抽取550张CVC-ClinicDB数据图像和900张Kvasir-SEG数据图像,共1450张图片作为实验训练集,其他数据均用作测试集. 为了方便模型训练和测试,将训练集图像统一分辨率352×352.

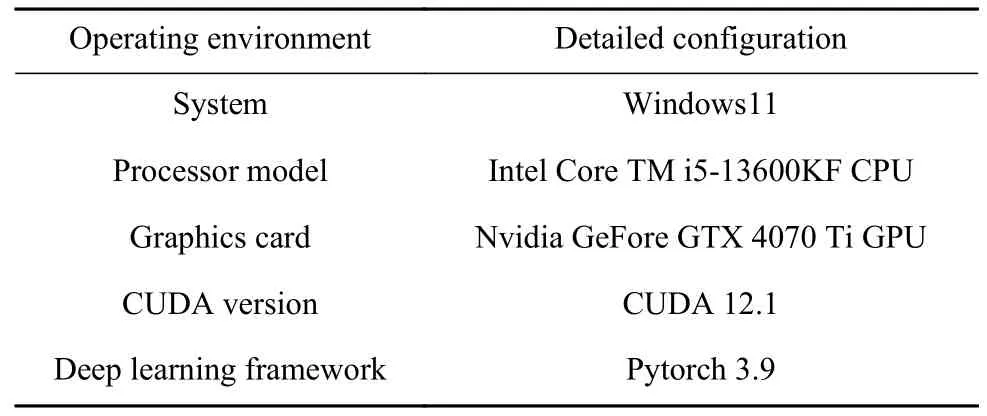

实验环境具体配置见表1,实验使用加权二进制交叉熵损失函数和加权交并比损失函数的组合,采用自适应矩估计优化器(Adam),实验迭代次数50,批量大小设置为6,初始学习率5×10–5,动量设置为0.9,并使用多尺度训练策略{0.75,1,1.25}.

表1 实验环境Table 1 Experimental environment configuration

2.2 评估指标

为了对结直肠息肉的分割结果进行定量评估,本文采用Dice相似性系数、平均交并比(Mean intersection over union,MIoU)、召回率(Sensitivity,SE)、精确率(Precision,PC)、F2得分和平均绝对误差(Mean absolute error,MAE),其具体计算式分别为:

其中,X为预测输出图像,Y专家标注的金标签图像,TP为预测结果中正确分类的前景像素数目,FN为预测结果中被错误分类为前景像素数目,FP为预测结果中被错误分类为背景像素数目,N为图像中的像素点数.

2.3 对比试验

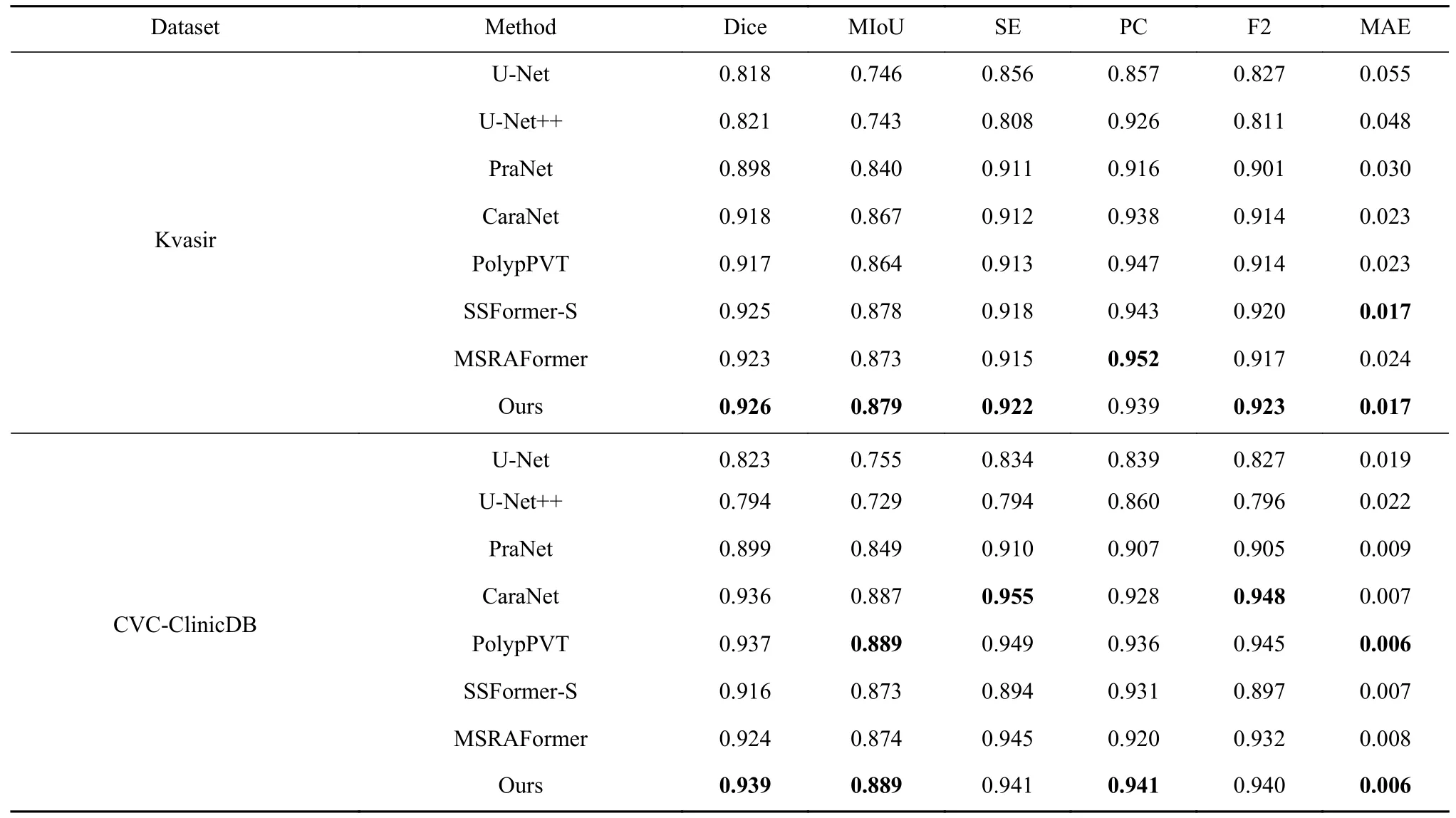

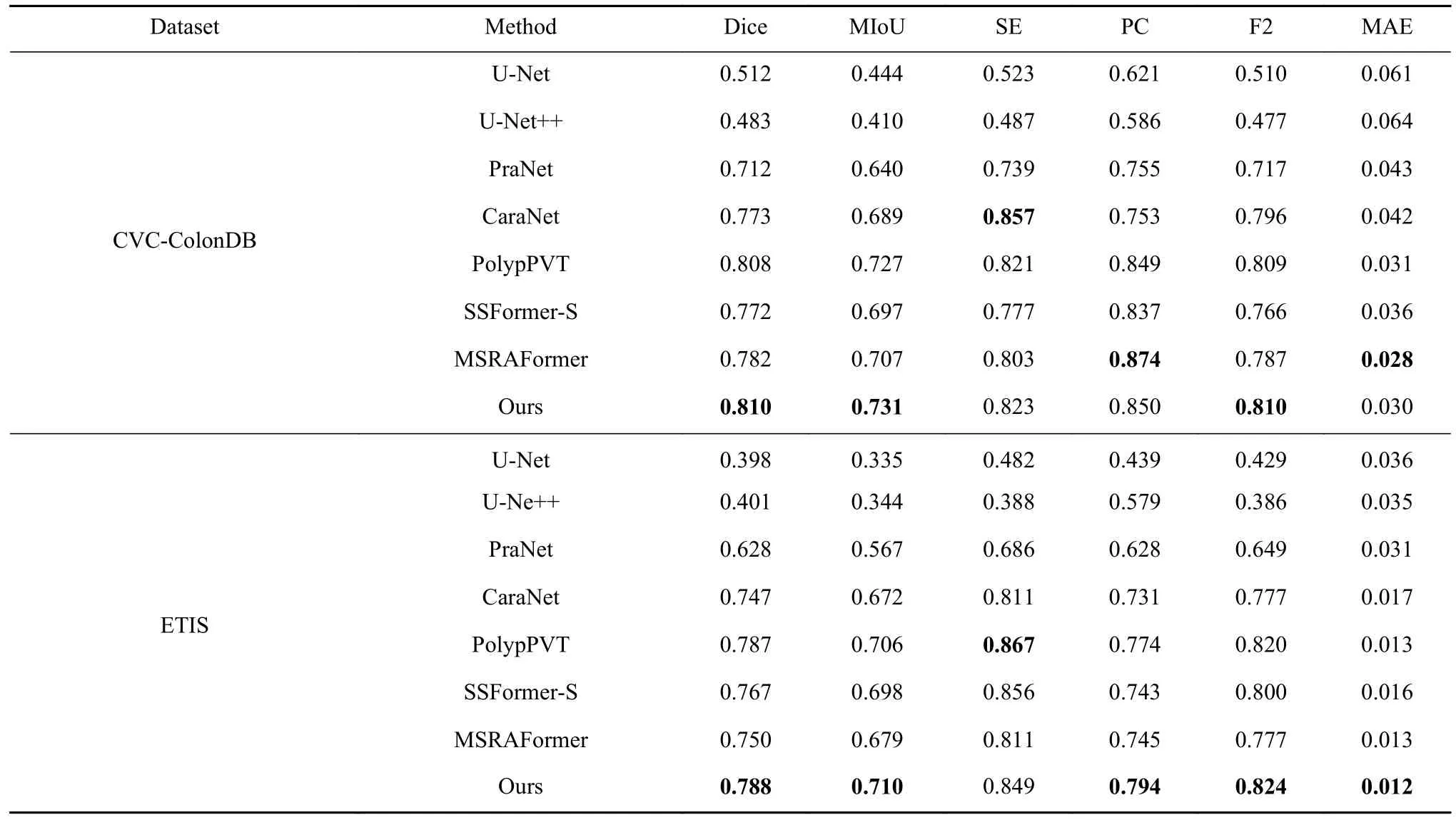

为了验证本文方法在结直肠息肉分割领域的优势,分别与基于卷积神经网络结构的U-Net、UNet++、PraNet和CaraNet以及最近提出Transformer结构的PolpyPVT、SSformer[26]和MSRAFormer[27]进行对比. 所有的预测结果均由原文献作者直接提供或是在相同的实验设备上通过复现开源代码得到.对比结果如表2和表3,其中最优指标加粗表示.

表2 本文方法和其他方法在Kvasir和CVC-ClinicDB数据集上的对比结果Table 2 Comparison results of this and other methods on the Kvasir and CVC-ClinicDB datasets

表3 本文方法和其他方法在CVC-ColonDB和ETIS数据集上的对比结果Table 3 Comparison results of this and other methods on the CVC-ColonDB and ETIS datasets

表2和表3给出了本文方法和其他7种方法在Kvasir、CVC-ClinicDB、CVC-ColonDB和ETIS数据集上的量化指标结果. 由表1和表2可知,本文方法在四个数据集上的分割结果,获得更高Dice系数和MIoU值,分别为0.926、0.939、0.810、0.788和0.879、0.889、0.731、0.710,说明本文方法对结直肠息肉病灶区域的划分能力最优,分割质量最好.相比于PraNet,本文方法F2得分分别提高了2.2%、3.9%、9.3%和17.5%,说明本文方法能有效划分背景像素和前景像素. MSRAFormer利用多尺度通道注意力机制聚合多尺度特征信息,在Kvasir和CVCColonDB数据集上获得最优的PC值,但在Dice系数、MIoU值、SE值和F2得分上均低于本文,这是因为MSRAFormer分割结果中出现较多的欠分割,即分割面积偏小. CaraNet设计残差轴反向注意力机制来挖掘边缘像素,使得该网络在CVC-ClinicDB获得最优的SE值和F2得分,这是因为CaraNet在分割结果上出现较多的过分割现象,即分割面积偏大. 综合对比分析,本文方法相比于其他网络更优,分割性能更好.

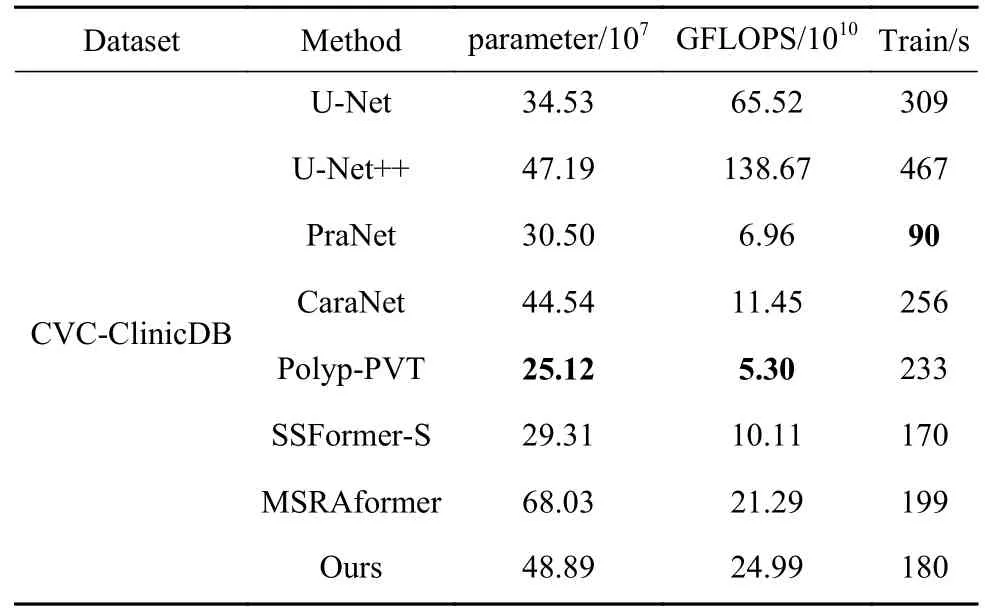

表4给出了本文方法和其他7种方法的性能对比,从表4可知,本文方法的参数量、浮点运算和单轮迭代时长都相对较少,说明本文方法能快速的完成训练和测试. 相比于基于卷积神经网络结构的U-Net++,浮点运算次数和单轮迭代时长均优于U-Net++网络. 相比于MSRAFomer,本文方法的参数量降低了28.1%,且单轮迭代时长优于MSRAFomer网络,表明设计的全局与局部特征交互模块在不增加参数量和计算复杂度的条件下提升算法的分割性能. 综合对比分析,本文方法在兼顾迭代时长和计算复杂度的同时,获得较优的分割结果.

表4 本文方法和其他方法的性能对比Table 4 Performance comparison between this and other methods

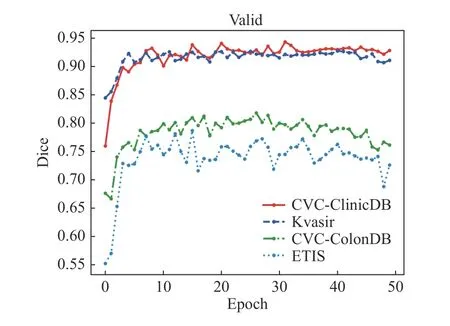

图6给出了本文方法在四个数据集上验证过程的Dice系数变化曲线. 由图6可见,本文方法的Dice系数提升很明显,迭代周期在16轮左右获得最优Dice系数.

图6 在四个数据集上验证过程的Dice系数变化曲线Fig.6 Variation curves of the Dice coefficient of the validation process on the four datasets

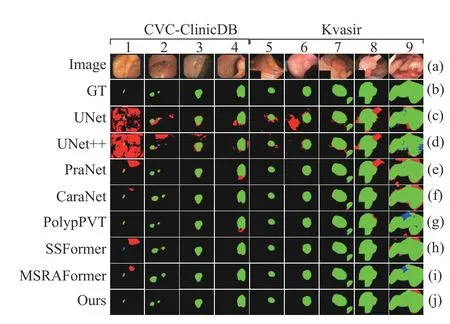

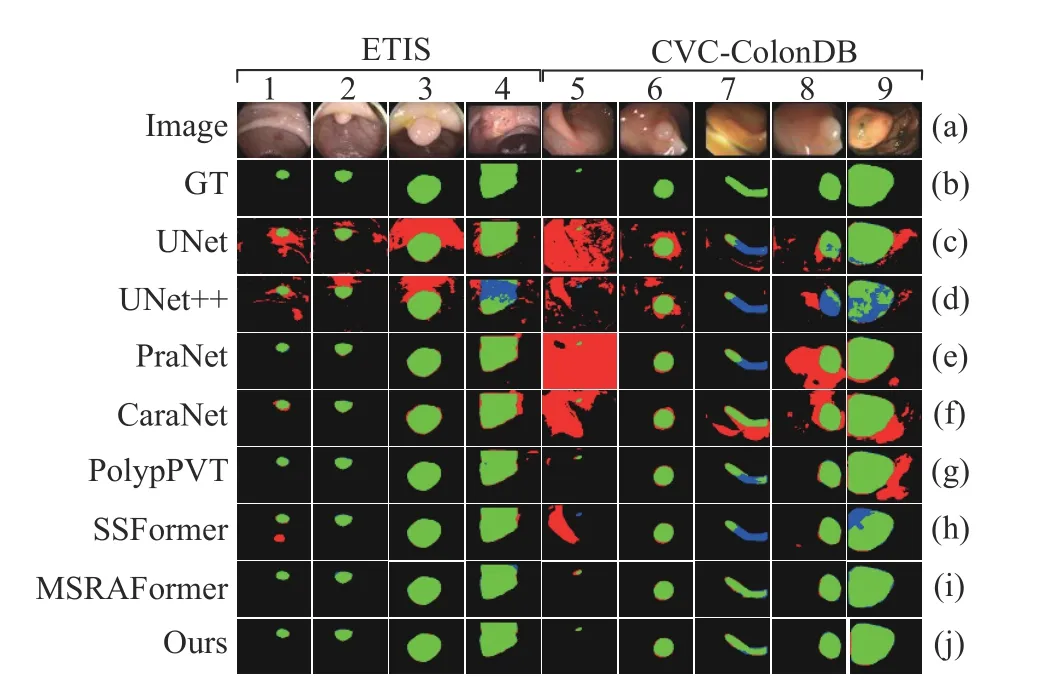

图7和图8给出了本文方法和其他7种方法在Kvasir、CVC-ClinicDB、CVC-ColonDB和ETIS数据集上的可视化对比结果,图中绿色表示真阳性像素,黑色表示真阴性像素,红色表示假阳性像素,蓝色表示假阴性像素,从上往下分别为原图、金标签、U-Net、U-Net++、PraNet、CaraNet、PolypPVT、SSFormer、MSRAformer和本文方法. 观察图7和图8的(c)行、(d)行可看出U-Net和U-Net++对不同尺度大小的病灶区域均存在严重的错分割,这是因为U-Net和U-Net++仅实现了高低层次信息的简单融合,对分割目标特征重构能力不足,易引入背景噪声和形成编码器和解码器之间的语义鸿沟,导致错分现象严重. 从图7和图8的(e)行,(f)行可看出PraNet和CaraNet对病灶区域占比较小的结直肠息肉图像易将背景像素错分为前景像素较为普遍,说明上述网络对小目标图像的细节和上下文信息提取不足,导致细节信息丢失较为严重,产生分割不完全情况. 观察图7和图8的(h)、(i)和(j)行可看出PolypPVT,SSFormer和MSRAFormer能有效分割病灶区域占比较小的结直肠息肉图像,但分割病灶区域占比较大的结直肠图像时,分割结果存在内部空洞和边缘轮廓线细节粗糙. 相比之下,本文方法结合Transformer和图卷积神经网络结构能有效处理全局上下文信息和局部空间细节信息,对不同尺度大小的结直肠息肉图像能准确分割. 通过区域引导图像推理模块和边缘约束图推理模块来精准定位病变区域以及使边缘轮廓细节跟金标签高度一致. 综合对比分析,本文方法的分割结果不管是在视觉效果上还是在量化性能指标上均更胜一筹.

图7 不同网络在Kvasir和CVC-ClinicDB数据集上的分割结果对比Fig.7 Comparison of segmentation results of different networks on the Kvasir and CVC-ClinicDB datasets

图8 不同网络在CVC-ColonDB和ETIS数据集上的分割结果对比Fig.8 Comparison of the segmentation results of different networks on the CVC-ColonDB and ETIS datasets

2.4 消融实验

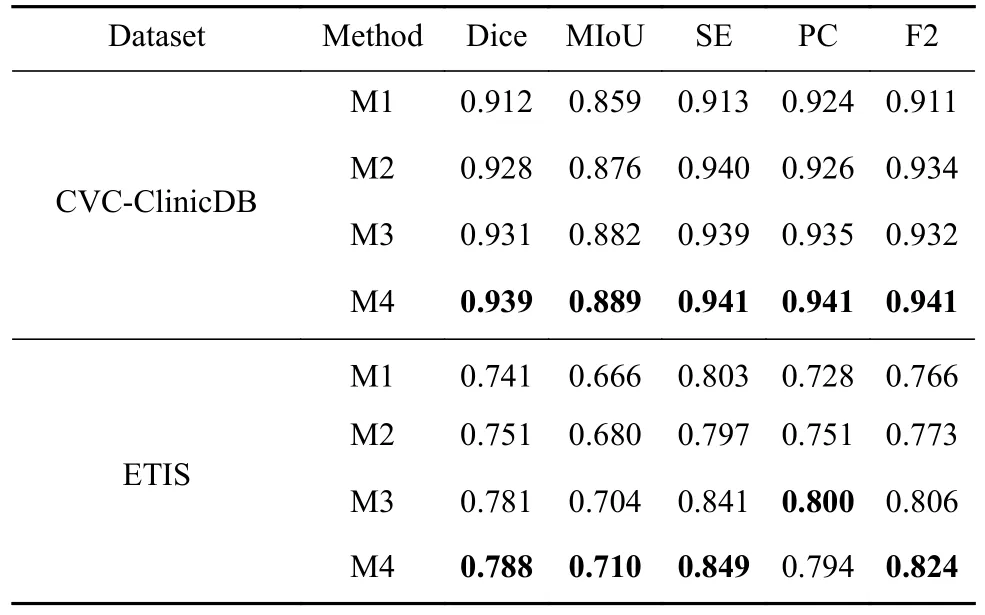

为了探究基于Swin Transformer和图形推理的自适应网络中各模块对整体性能的贡献程度,本文在CVC-ClinicDB和ETIS数据集上进行消融研究,消融结果如表5所示,表中最优指标加粗表示.表5中M1表示在Swin Transformer的基础上与U形网络结合,不添加任何模块. M2表示在M1的基础上添加全局与局部特征交互模块;M3表示在M2的基础上添加区域引导图推理模块;M4表示在M3的基础上添加边缘约束图推理模块,即本文所提方法.

表5 在CVC-ClinicDB和ETIS数据集上的消融实验实验Table 5 Ablation experiments on the CVC-ClinicDB and ETIS datasets

从表5可以看出,M1方法在这两个数据集上的Dice系数和MIoU值都较低,说明该方法对病灶区域的特征提取存在一定的局限性,主要原因是深层特征与浅层特征存在较大的语义鸿沟简单的融合易引入背景噪声,最终导致分割结果出现严重的误分割. M2在M1的基础上添加全局与局部特征交互模块,Dice系数和MIoU值都有了较大的提升,说明全局与局部特征交互模块能有效建立局部细节信息和全局语义信息的高阶关系,增强网络对病灶区域的定位能力,提高分割精度. M3相比于M2,MIoU分别提高了0.6%和2.4%说明区域引导图推理模块能有效解析病灶区域的显著性特征,减少分割结果内部空洞现象. 相比M4中的分割指标,M5中分割指标更为优异,因为边缘约束图推理模块通过约束区域与边界之间的关系,来纠正边缘预测错误分类,逐步锐化边缘细节特征,Dice系数和F2得分分别为0.939,0.788和0.94,0.824. 消融实验结果表明,本文所提方法的合理性和模块的有效性.

3 结束语

针对结直肠息肉图像病变区域分割精度低和分割边界存在伪影等问题,提出一种基于Swin Transformer和图形推理的自适应网络GRFormer. 首先使用分层Transformer编码器提取结直肠息肉图像的病灶特征,输出多尺度特征图;其次设计全局与局部特征交互模块来优化目标区域的相关性信息、同时抑制背景噪声和减少特征冗余;再次引入区域引导图推理模块使网络能有效挖掘深层语义信息浅层空间细节之间的高阶关系,减少特征信息丢失情况;最后利用边缘约束图推理模块激活边缘细节特征响应,解决目标结直肠息肉边缘模糊问题. 在CVC-ClinicDB、Kvasir、CVC-ColonDB和ETIS数据集上的F2得分分别为0.940,0.923,0.810和0.824. 相较于7种对比方法,GRFormer对于形态复杂、边缘模糊的情况均有较好的分割效果,对结直肠息肉的诊出具有一定的应用价值.