站在巨人肩膀上的初学者:社会科学研究中的生成式人工智能

2024-03-31胡安宁周森

胡安宁 周森

内容提要 如何利用生成式人工智能助力社会科学研究是近期社会科学研究者们共同关心的重要议题之一。在此背景下,从一般社会科学研究的实践需求出发,通过具体的实例考察生成式人工智能在社会科学研究的理论、方法和研究偏误三个方面的具体表现。生成式人工智能对于总结和复现现有资料具有很大的优势,以其强大算力来预处理海量在线资料,可以帮助研究者节省信息搜索的时间成本和精力成本。但是,生成式人工智能难以对既有理论进行“阅读”后的“理解”,同时亦不擅长进行方法层面的优劣对比和新分析工具的开发。此外,在生成内容上也表现出明显的偏见或者误差。背靠人類既有资料积累的生成式人工智能可谓站在巨人肩膀上,但由于其本身缺乏成熟的能动创新能力,生成式人工智能在学术研究的意义上仍然是一位“初学者”。如何引导和培养这位“初学者”,是社会科学研究者需要思考和完成的任务。

关键词 生成式人工智能 社会科学研究 偏差 代码

胡安宁,复旦大学社会学系教授

周森,浙江师范大学教师教育学院讲师

一、问题的提出

2022年底ChatGPT以及2023年初GPT-4的出现,让生成式人工智能(Generative AI)成为全社会关注的焦点[1]。作为一种通用式AI,生成式人工智能以惊人的算力学习数字世界的海量资料,生成具有高度可用性和似真性的文本、图像、音频、视频、软件代码等内容(AIGC,AI generated contents)。在此背景下,生成式人工智能与哲学社会科学研究之间的关系也日渐成为学界关注的重点。现有研究考察了生成式人工智能是否具有类似于人类的智能[1],是否能够成为社会科学研究的助力者乃至社会科学研究范式的改革者[2]等关键问题。

本文在既有哲学层面和范式层面讨论的基础上,希望能够基于社会科学研究实务的角度,通过一些具体的实例来反思生成式人工智能对于社会科学经验研究的工具性意义。所谓工具性,其基于的标准是,生成式人工智能产出的内容是否能够“助力”经验社会科学研究。因此,本文的讨论不同于哲学思辨和范式考察,而是把生成式人工智能嵌入一般社会科学的研究过程之中,讨论生成式人工智能所生成的内容是否能够突破现有研究限制以更好地满足研究人员的现实需求。为此,本文从三个角度评估生成式人工智能对于社会科学研究实务的价值:理论、方法和研究偏误。理论部分重在考察生成式人工智能是否可以帮助研究人员总结归纳现有文献,并挖掘其中的理论空白点。方法部分重在展示生成式人工智能是否可以起到“助研”的功能,帮助甚至“替代”研究人员完成一些重复性的工作。研究偏误分析则希望探究生成式人工智能产出的内容相较于研究人员人工设计的同类型内容,是否更能够克服潜在的偏误。在这些分析的基础上,本文进一步从人工智能技术可能的发展与社会科学研究者人为引导两个方面,讨论生成式人工智能如何克服既有局限以发挥更大的潜能。

需要说明的是,本文在经验层面所作的工具性分析具有时效性。一方面,随着生成式人工智能技术的进一步发展以及社会科学研究者更有针对性的介入,下文所列举和讨论的各种不足可能随着时间的推移得以克服。另一方面,社会科学的研究范式本身并非长久不变。过去几十年里,新的研究进路和范式不断涌现[3],因此,判断生成式人工智能的工具性功能达成与否的标准也在变化。鉴于此,本文讨论的立足点仍然是当下的技术发展水平和主流社会科学的研究路径。

二、理论层面:总结而非论辩

社会科学经验研究过程要求理论和经验之间的有机结合。由于生成式人工智能的重要功能之一是对各种文本资料进行总结并生成“新”的内容,因此当我们思考生成式人工智能和社会科学研究之间的关联时,一个很直接的思路便是,社会科学研究者是否能够利用生成式人工智能完成理论梳理方面的工作。换言之,当一个社会科学研究者围绕一个特定问题进行研究时,生成式人工智能可否帮助这位研究者更好地处理各种描述理论的文本信息[4]。

为了回答这一问题,我们首先要厘清的是,在社会科学经验研究中所谓的理论梳理需要具体做什么?简单而言,社会科学经验研究中我们需要围绕理论梳理做三点工作:其一,概念的辨析,即通过文献梳理,明晰经验研究中涉及的核心概念的具体意涵是什么。其二,理解概念之间的关系,即从理论文献的角度,帮助研究者理解为什么两个甚至多个概念之间存在某种实质性的关联,为什么这个关联不是虚假的。其三,在前面两点的基础上挖掘理论的空白点,由此提出创新性的理论论辩,也就是所谓的理论创新。

基于这三点理论层面的任务,我们为了衡量生成式人工智能的理论工具性价值,设定三个询问任务:概念总结、概念关联和理论空白点挖掘。具体而言,我们以社会学文化资本研究为例,利用OpenAI公司开发的ChatGPT以及Google公司开发的Bard这两个具有代表性的生成式人工智能平台,分别询问三个问题:第一,【概念总结】What is cultural capital?第二,【概念关联】How does cultural capital affect educational attainment?第三,【理论空白点挖掘】What are the research gaps in cultural capital studies?

由于篇幅所限,针对这些询问的详细输出结果不在文中直接展示,感兴趣的读者可以按照这里设置的提示词进行测试。通过上述提示词的试验,我们发现,无论是ChatGPT还是Bard,对于文化资本概念的总结都非常全面,涉及文化资本的核心意涵和可能的分类。Bard还呈现文化资本在形塑教育不平等过程中的角色。可以说,这些对于文化资本概念的总结是“教科书”似的,但是也有不足之处。例如,Bard生成的文本总结中对于文化资本类别的讨论使用了不同于布迪厄原初定义的三种类别术语[1],显然,这对于社会科学经验研究存在严重的误导性。此外,这一概念总结的“文风”偏向于维基百科,即重在向一般大众进行概念的介绍,几乎没有涉及文化资本概念的学术脉络以及发展过程中不同学者对于这一概念内涵的拓展。在此意义上,生成式人工智能形成的概念总结是“总括和介绍性”的。因此,这些生成的内容可以用于一般性的入门教学,但并不能够“直接”用于文化资本的“研究”。

在概念总结之后,我们转向概念之间的关联机制。关于文化资本如何影响个人的学业成就这一问题,ChatGPT给出了很有启发性的回答,内容涉及学业准备、与教育机构的沟通、资源获取、社会网络等多个中介因素。虽然在论及这些中介因素的时候生成的内容不是具体的研究,但是这些生成内容对于一般社会科学研究者具有很强的启发性。与之相比,Bard生成的内容则显得“顾左右而言他”,其虽然也讨论了文化资本和学业成就之间的相关关系,但是仔细阅读其生成的文本可以发现,有许多地方实际上并没有直接回应文化资本和教育成就之间的中间机制,而是在进行文本的同義反复(重复陈述所提出的问题,即二者“有”关系);且论述过程多以举例为主,缺乏ChatGPT生成内容的系统性。

最后,我们在提示词文本框中询问已有的文化资本研究可能存在的局限性,以探究理论的空白点。对于这一问题,无论是ChatGPT还是Bard的回答都不是非常令人满意。一个原因在于,两者列举的这些所谓尚未研究的议题实际上在现有研究中已经有所涉及。例如,跨越教育领域的文化资本[2]、不同社会环境下文化资本的作用(非西方的语境下)[3]、文化资本的代际传递[4]等。之所以出现这种情况,一个可能的原因是,在训练生成式人工智能的时候,很多输入资料会通过某些关键词来论及文化资本研究的局限,这些关键词进而被生成式人工智能总结并提炼出来。但是,熟悉社会科学研究的学者们都知道,之所以要提及某一问题的研究局限,恰恰是因为提及这些局限的文章或者专著本身就要填补这些空白。生成式人工智能并不能对这些填补空白的研究进行梳理。换句话说,这里呈现的所谓的研究空白点,是已有数据中学者们“提到”的空白点,并非在综合现有研究的基础上“提炼”出的真正的空白点,而学者们之所以提出这些空白点,恰恰是要填补这些空白点。这种“提到”而非“提炼”的资料呈现路径,或许正是生成式人工智能的局限所在。

综合上面的讨论,我们可以发现,采用生成式人工智能技术对社会科学研究的理论问题进行梳理的突出特点在于“总结而非论辩”。所谓总结,是基于既有资料进行一种内容的简化和聚焦。缺乏论辩的意思是,对于既有文献的背景以及不同研究之间的相互联系缺乏足够的把握。也就是说,生成式人工智能对于理论尚不能做到意义的理解和互相勾连。从这个角度来说,生成式人工智能产生的各种内容至少对于社会科学研究不能起到一个很好的“助研”的作用,因为其缺乏社会科学研究所需要的理论深度和广泛联系。

三、方法层面:旧方法代码呈现而非新方法创新

如果说理论层面的总结和凝练不能达到社会科学研究所需要的精细度和创新度,那么具体到研究方法层面呢?我们在面对已经构建好的研究问题时,是不是可以依赖生成式人工智能找到合适的方法并加以运用呢?这方面具有典型意义的一个案例就是代码撰写[1]。对于很多量化社科研究者而言,在具体研究中面对特定数据时,需要根据研究问题通过特定的软件平台撰写代码、进行数据分析,并以此获得具有理论价值的经验结论。由于特定软件平台下的统计模型语句都是“固定”的,且存在大量的在线资料,那么完全可以在确知所使用的方法的前提下,通过生成式人工智能生成相关的代码。这方面我们同样通过具体的方法来测试ChatGPT(由于篇幅所限,相关的输出结果不在文中呈现,感兴趣的读者可以自行按照本文设置的提示词进行测试)。

具体而言,我们设置的提示词是在STATA软件中撰写双重差分(difference-in-difference)方法的代码。相关的输出结果可用性很强,甚至每一句代码的具体解释都被直接标注出来。这一生成内容对于需要学习双重差分方法的学生而言非常友好。此外,我们还尝试通过生成式人工智能来解释特定的统计方法。例如,我们要求ChatGPT解释什么是结构嵌套均值模型(structural nested mean model)。相关输出的内容也比较全面,对于这一模型的功能和设定假设等都有总览性的展示。同样,对于这一高级方法的软件实现也没有问题。例如,我们希望ChatGPT提供关于结构嵌套模型的代码,ChatGPT也很好地完成了这一工作。同上面的例子一样,在代码语句的每一行,生成的内容都进行了解释性标注。

通过上面的几个实例,我们可以发现,生成式人工智能所产出的内容对于从事量化研究的人员非常友好。围绕特定的研究方法,生成式人工智能能够提供比较准确的方法解释以及在不同软件平台的实现代码。针对具体的研究问题,研究人员完全可以对生成式人工智能提供的一般性代码进行个性化修改,以完成自身的研究任务。

但是,需要指出的是,和前面一节关于理论总结的局限性类似,生成式人工智能撰写的代码往往也遵循“拿来主义”的逻辑。实际上,如果我们不采用ChatGPT而是使用微软Bing的生成式人工智能平台,这些生成内容的来源也会标注出来。不出意外,很多代码正是来源于网上的在线课程或者教程。在此意义上,生成式人工智能在研究方法上对我们帮助或许在于提供了更为高效的搜索结果。显然,这并无法帮助我们进一步修正和改进既有的研究方法。为了说明这一点,我们进一步询问ChatGPT是否可以对结构嵌套均值模型进行提升和修正。返回结果就像上文询问理论空白点时一样非常流于表面。虽然“貌似”指明了一些方法和革新的大方向,但是仍然缺乏足够的深度,仅仅是泛泛而谈。除了ChatGPT,我们还尝试了Bing的生成式人工智能平台,并在提示词文本框中询问了同样的问题。结果发现,Bing的这一平台自动把问题转化为是否存在结构嵌套均值模型的替代方法,其生成的内容也直接表示并没有特定的方法要优于结构嵌套均值模型。显然,这并不是我们希望获得的答案。从这个例子可以看出,生成式人工智能虽然可以帮助研究人员搜索并提供基本的代码,但是对于方法本身的创新却缺乏足够的关照。

四、偏误层面:答非所问

由于生成式人工智能是在对大量既有资料训练的基础上生成“新”的内容,因此在现有对生成式人工智能的反思中,一个被反复提及的问题是,一些存在于输入资料中的偏见和误差也可能会通过善于学习的人工智能转移到其生成的内容之中[1]。据此,我们在这一部分的讨论中通过具体的实例考察生成式人工智能的这种偏误问题。

进一步地,我们对偏误进一步细化。所谓研究偏误分为“偏”和“误”两个方面。“偏”的意思是,生成式人工智能产出的一系列资料和我们所希望获取的资料之间存在一定的偏差。而“误”的意思,则是指生成式人工智能产生的内容和我们所希望获取的内容相左。从这个意义上讲,“误”是比“偏”更为严重的情形。

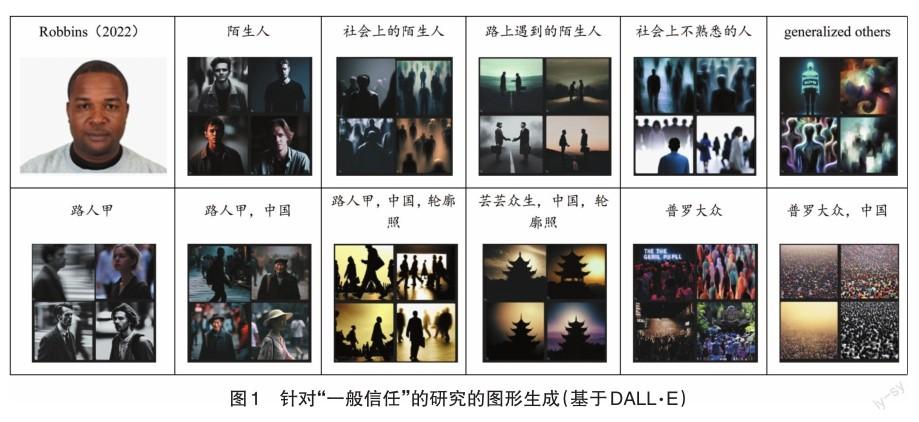

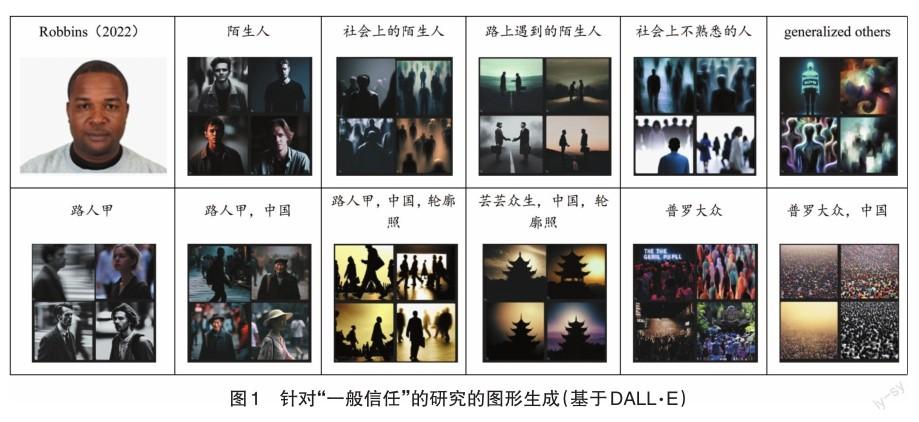

为了展示生成式人工智能潜在的研究偏误,我们选取一个具体的社会科学研究议题:一般信任。作为社会资本的一个非常具有代表性的测量变量,一般信任指的是对社会上的一般成员的信任程度[2]。“一般信任”的水平也常被用来衡量一个社会的团结程度和道德水平。在经验研究中,对“一般信任”通常采用的测量题器是对社会上大多数人的信任程度(中国综合社会调查也采用这一测量)。这个测量题器非常简单直接,但是与之伴随的一个潜在问题在于,人们对于社会上大多数人究竟指代谁可能有不同的理解。有的人偏向于指代那些社会上的陌生人,而有些人则偏向于指代身边熟识的信任对象[3]。面对此种局限,学界也在试图开发新的测量方法。2022年,学者Robbins提出了Stranger Face Trust问卷设计(陌生人面孔信任问卷设计)[4]。在这样一个问卷设计中,研究者通过出示陌生人头像的方式来展现一般社会成员,从而了解个体对于这些社会成员的信任度。例如,图1的第一幅图(第一行左一)便是Robbins文中所采用的陌生人面孔示例。

以陌生人的面孔来衡量个体对于社会成员的一般信任相较于文字的描述更加具体和直观。但是众所周知的是,即使是单纯的图片本身也包含了大量的信息或者认知线索(cue),而这些信息可能会左右被研究对象对于这张陌生面孔的信任水平[1]。以Robbins使用的这张面孔为例,一个直观的判断会认为这是一张黑人的面孔。那么,对于这个面孔的信任水平有可能掺杂个体对于黑人种族的固有偏见或者偏好。实际上,除了种族,人们从面孔中还能判断出很多信息(例如社会阶层地位等),这些都会成为影响信任水平的重要因素。

考虑到生成式人工智能在图片生成方面的优势,我们是否可以通过生成式人工智能构造更好的关于社会一般成员的图示?换句话说,生成式人工智能是否能够通过凸显信任对象的“社会”性来尽量削减上述的偏误?为了回答这一问题,我们使用了Bing平台提供的基于DALL·E的图片生成工具。这一生成式人工智能平台非常便捷,只需要提供提示词便可以生成相关的图片。在我们的实验中,首先使用的提示词是“陌生人”,产生的相关图片如图1所示。显然,基于这个提示词产生的这四个陌生人图片具有很明显的偏向:四幅面孔都是外国人且均为男性。鉴于这个局限,我们进一步修改提示词为“社会上的陌生人”。此时生成的图片不再是单个的个体,而是一系列抽象的群像。这个图片相较于前一个图片更加能够凸显“社会”的要素。除了“社会上的陌生人”,我们也尝试了另外一個提示词“路上遇到的陌生人”。这一次生成式人工智能没能达到我们的预期,因为其生成的图片更多地强调“路上遇到”,且这些图片给人的印象不是“陌生人”,而是熟人相遇。那么,这个图片并无法帮助我们探索一般信任的问题。如果把提示词设置为“社会上不熟悉的人”,此时生成的图片和提示词为“社会上的陌生人”时生成的图片非常相似,说明其并不关注特定的个体,而是提供了一个群像的描述。与这一提示词相似,我们也尝试了英文的“generalized others”,但是基于这一提示词生成的图片与我们理论预设的社会一般成员相差甚远,其中有些图片甚至无法辨识出是社会成员还是一般的抽象画作。

在尝试了上述各种提示词之后,我们发现,对于研究“一般信任”的学者而言,似乎只有“社会上的陌生人”和“社会上的不熟悉的人”两个提示词下生成的图片可以使用,但是这些图片更多的是一种集体群像,难以聚集于特定的社会上“一般成员”身上。

那么,如果尝试一下具有中国本土特色的提示词,会不会可以更加满足我们的需求呢?首先,我们使用了提示词“路人甲”。这是一个在中国社会语境下用于指涉陌生人的常用词。按照这个提示词,我们获取的生成图片仍然存在“陌生人”提示词下显现的偏差,即图片描述的均为外国人。此外,这些图片都强调“在路上行走”的特点,而不是我们所谓的“路人”的意义。为了生成具有本土特色的图片,我们在这个提示词之后增加了“中国”的标识,这一次所生成的图片确实具有本国特色,但是其中两个图片均为老人。那么,是否能够不呈现具体的面孔,而只把轮廓展现出来呢?为了做到这一点,继续增加提示词“轮廓照”。生成式人工智能生成的图片呈现了群像的属性,但是无一例外都凸显“路上行走”的人。显然,生成式人工智能所理解的“路人”更加偏向于其字面意思“路上的人”,而无法表现我们使用“路人甲”的时候所希望强调的人际陌生感。

除了“路人甲”,我们也尝试了其他中国语境下比较普遍的表示社会一般成员的词语,但是生成的结果并不能够很好地服务于“一般信任”研究。例如,如果使用“芸芸众生,中国,轮廓照”作为提示词,生成的图片为一系列的风景照,与所谓的社会成员没有任何关系。采用“普罗大众”作为提示词,生成式人工智能提供的图片主要偏向于“人多”这一特点,却没有呈现出我们在使用“普罗大众”一词的时候所希望强调的社会性大众。即使在后面增加提示词“中国”也并不能解决这个问题。例如,与以“普罗大众,中国”作为提示词所生成的图片更契合的词语或许是“人山人海”。

综合上面的各种尝试,我们可以发现,对“一般信任”的研究希望可以获得一种大家看上去就想到社会一般成员的人像图片,但是通过输入不同的提示词所生成的大多数图片因为存在各种偏误而难以很好地满足这一需求。在个别情况下甚至出现了南辕北辙或者不知所云的情况。生成式人工智能生成的图片之所以出现这种局限,或许因为这样一种悖论:一方面我们希望通过图片来反映某种现实意义,因此为了产生这种图片,需要在提示词文本框中非常明确地把这种意义详细描述出来。但是,另一方面如果我们可以做到这种意义的“完美”描述,完全可以直接采用语言的形式和被研究对象进行沟通,也就没有必要去生成图片来辅助研究了。

五、克服局限性:技术进步与人工引导

通过对生成式人工智能的各种“测试”,我们发现,对于社会科学研究,生成式人工智能在现有的技术能力下尚有不少局限,为了克服这些局限,至少需要在以下两个方向努力:技术进步和人工引导。

生成式人工智能的技术进步既涉及数据品质的提升也关系算法的优化。所谓数据品质,是指为了克服潜在的偏误,需要纳入更加“全面”而并不必然“更多”的资料。换言之,在训练生成式人工智能的时候,除了“投喂”大量数据,未来更需要考虑资料的“全面性”,以更为“逼真”且贴合现实的,对社会成员来说更具代表性的初始信息来达成对社会多样化现实的反映。此外,各种造成潜在偏误的“误解”或者“歧视”本身也可以作为一个单独的数据维度纳入算法,以对输出结果进行修正。实际上,以人工智能技术来“修正”研究过程的偏误对于社会科学研究而言并不罕见,其在克服人类注意力持续时间有限、反应偏差或习惯化方面表现得尤为突出,从而可以提供偏见较少的资料。此外,人工智能技术也有助于克服模型偏差和样本选择偏差问题[1]。这些既有的经验对于生成式人工智能技术可资借鉴。在算法提升方面,生成式人工智能技术需要将着力点放在探索理论与方法的增长点,而不仅仅是表面化的复现。这方面或许可以让算法在“做中学”,通过具体的研究过程来摸索社会科学的进路。此外,为了杜绝算法设计过程中的人为偏误(例如,引用含有某些人类注释者偏见的数据集或者无法捕获少数群体的相关特征等),算法设计者需要对研究设计过程保持一种反思性。

除了自身的技术进步,生成式人工智能应用于社会科学研究不可或缺的是人为的引导和“培育”。在这方面,一个很重要的努力方向是把生成式人工智能放入社会科学研究范式之中,让人工智能做“社会科学”的事而不是日常生活中的事。例如,研究人员可以结合各自的专业知识,使用生成式人工智能来模拟参与者特征,生成假设并在人群中进行验证[1]。此外,生成式人工智能的“黑匣子”性质阻碍了研究人员对其进行评估,也削弱了科研复制发现的能力。鉴于此,我们要倡导社会科学研究中使用的生成式人工智能像所有科学模型一样,以开源的形式展现。这意味着它们的算法和理想的数据可供所有人审查、测试和修改。只有保持透明度和可复制性,才能确保人工智能辅助的社会科学研究真正有助于我们理解人类经验。在对生成式人工智能进行人工引导的过程中,作为引导者的研究人员还需要恪守研究伦理,例如,如果研究者只寻求与他们预设的结论相一致的支持信息,这在无意中会进一步助长偏见。因此,当务之急是提升用于训练模型的数据的表征公平性。这种公平性只能通过透明度——也即披露有关人工智能模型训练数据的信息——来实现。但是,到目前为止,所有商业模式的此类信息都是一個谜[2]。关于这一点,我们还需要警惕陷入“聪明反被聪明误,努力反被努力误,公正反被公正误”的窘境。这是因为社会科学的研究目标正是研究特定群体的特定社会文化偏见,模拟具体人群的具体行为并追溯其文化演变。出于公正的要求,现在的伦理约束要求工程师保护人工智能免受这些偏见的影响。这反而让人工智能技术进入一种“平庸”的客观和全面,没有尊重我们苦苦寻觅的、客观存在的“偏见”,远离了充满偏见的真实世界,这种减轻训练偏见的努力又反过来破坏AI辅助社会科学研究的有效性[3]。最后,对生成式人工智能的人工引导还需要考虑外部有效性和内部有效性之间的权衡。生成式人工智能技术在不同的文化内容上进行训练,通过模拟类似人类的反应和泛化到现实世界的场景来提供更大的外部有效性。然而,它们的不透明性将限制其内部有效性;相反,建立在较小的受控数据集上的研究可以提供更强的内部有效性,但代价是可靠性和泛化性降低,因为有限的训练数据可能会阻碍它们在不同环境中一致和广泛的执行能力。因此,研究人员应根据自己的优先事项在这些方法之间仔细选择。

六、结语:站在巨人肩膀上的初学者

生成式人工智能技术方兴未艾,如何利用新兴技术助力社会科学研究成为过去一段时间以来社会科学研究者们关心的重要议题。本文在此背景下,从一般社会科学研究的实践需求出发,通过具体的实例考察了生成式人工智能在理论、方法和研究偏误三个方面的具体表现。综合上述的分析,笔者认为,生成式人工智能在总结和复现现有海量资料方面具有很大的优势。以大算力来预处理这些海量资料,本质上可以帮助研究者节省信息搜索的时间成本和精力成本。尤其是面对不熟悉的研究议题或者研究方法的时候,生成式人工智能确实可以起到很好的教育与“科普”功能,从而让一线研究人员迅速掌握特定概念的核心意义。在这个意义上,生成式人工智能真正站在了巨人的肩膀上,它提供给研究者的是前人研究的一种凝练。可以预见的是,生成式人工智能将进一步推动量化研究发展,推动社会科学中测量范式的转变,并用统计学意义上的相关性取代深层的逻辑因果关系,创生出一种新型的数据认识论。

但是,生成式人工智能对于社会科学研究者的这种辅助性作用更多地集中于“信息性”辅助,而不是“创新性”辅助。理论层面上,生成式人工智能难以对既有理论进行“阅读”后的“理解”,而是偏向于一种“机械性”的复述。因此,生成式人工智能进行的文献梳理并非传统意义上的文献梳理,也不是社会科学研究者想要的文献梳理。从这一点延展来看,在某些情况下,生成式人工智能会具有“欺骗性”。例如,娴熟地运用十分专业的各种学术术语和严密的逻辑论证,让错误的结论难以被发觉和识别,表现得权威性十足。随着技术的发展和资料库的丰富,未来的生成式人工智能能够给出远超个体研究者自己可以获得的更全面、丰富的例证,并以计算理性展现强大、坚实的表面逻辑,以无可辩驳的“科学权威”的姿态笼罩人类的智识世界。鉴于算法的复杂性,即使是最有经验的人也无法识别所有错误。理解和追溯决策能力的不足为充分地应用生成式人工智能埋下了重大隐患,也消解了我们对生成式人工智能的部分信任。为此,我们不得不谨慎地采用生成式人工智能算法,并努力完善问责制和提升透明度。

方法层面上,对于特定方法,生成式人工智能足以提供相关的背景知识和实现代码,甚至可对代码进行逐行解释,但是其却不擅长进行方法层面的优劣对比,故而并不能够直接帮助研究者开发新的分析技术。除了拙于创新,生成式人工智能依然保留了一些固有的偏误。例如,其所生成的内容默认以西方社会为蓝本,缺少中国本土特征;而对于文字提示词的理解也偏于字面意义,无法探究提示词背后的“深意”,从而带来某种对提示词的误读。从这个意义上来讲,生成式人工智能可以说是盲目的,它并不能够“读懂”和“体会”其所处理的资料,且在和研究人员通过提示词进行互动的时候,也不能真正成为一个可以与之“对话”的“助手”。在这方面,莱布尼茨最先洞察了逻辑(理性)真理与事实(意义)真理之间的分野,后来的维特根斯坦和卡尔纳普都对此进行了深度的阐述。我们的研究表明:当下的生成式人工智能的阅读能力还停留在字面阅读层面,能够便捷地领会逻辑理性方面的道理,但是对于人们在长期的文化传统和共同的社会生活中发展出的特殊的、难以言传的“意义”,领会不够,表现出对“语境”的迟钝。在本文第四部分关于图片的生成中,生成式人工智能显然只能照顾到明确的“字面”指令,没有能反映言语之外的、隐含的现实意义和文化语境中的要求。因此,虽然生成式人工智能对于海量数据的预处理造就了其站在巨人肩膀上的优势,但是由于其本身缺乏理解能力,因此更像是一个学术研究层面的“初学者”。如何引导这位“初学者”发挥出生成式人工智能站在巨人肩膀上的优势,则是社会科学研究者的任务了。

正如柏拉图洞穴寓言中的囚犯观察墙上的阴影并相信它们代表了现实一样,生成式人工智能主要还是依赖文化产品中描述的人类经验的“阴影”。这些阴影对它们所代表的现象的真实本质提供了有限的视角,因为在形形色色的各类文化产品中捕捉到的结论并不总是反映支配人类行为的真实机制——这是社会科学家必须承认的局限性。究其根本,人工智能既不是我们的敌人也不是我们的救世主,它只是一种工具,其价值取决于我们如何使用它。它可以丰富我们的集体智慧,但也会助长人类的愚蠢。只有在有效利用人工智能的潜力和管理它给我们带来的具体挑战之间取得平衡,人工智能才可以以一种负责任的、合乎道德的方式融入社会科学研究,并造福人类。

〔责任编辑:玉水〕

本文为国家社会科学基金项目“社会团结的文化基础研究”(22VRC140)的阶段性成果。感谢康奈尔大学社会学系博士研究生周志鹏为本文提供的分析资料支持。

[1]丁磊:《生成式人工智能:AIGC的逻辑与应用》,中信出版社2023年版,第41页;张彦坤、王雪梅、汪卫国:《生成式人工智能对经济社会的影响》,《通信世界》2023年第16期。

[1]徐英瑾:《胡塞尔的意向性理论与人工智能关系刍议》,《上海师范大学学报(哲学社会科学版)》2018年第5期;赵汀阳:《替人工智能着想》,《哲学动态》2023年第7期。

[2]唐兴华:《生成式人工智能的“危”与“机”》,《中国社会科学报》2023年8月21日;蓝江:《生成式人工智能与人文社会科学的历史使命——从ChatGPT智能革命谈起》,《思想理论教育》2023年第4期;C. A. Bail, "Can Generative AI Improve Social Science?", https://osf.io/preprints/socarxiv/rwtzs;C. S. Walker, R. V. Noorden, "The Promise and Peril of Generative AI", Nature, 2023, 614(1), pp.214-216。

[3]例如,在传统的演绎和归纳逻辑之外,溯因推论得到越来越多的重视,具体参见S. Timmermans, I. Tavory,"Theory Construction in Qualitative Research: From Grounded Theory to Abductive Analysis", Sociological Theory, 2012, 30(3), pp.167-86。在既有研究中,人工智能技术常被认为与归纳逻辑相一致,具体参见陈茁、陈云松:《计算扎根:定量研究的理论生产方法》,《社会学研究》2023年第4期。

[4]生成式人工智能在科学研究中的运用并非一帆风顺,一些实例表明,目前的生成式人工智能所产出的内容并不能够满足科研的需求,甚至会以一种貌似客观的方式传递错误的信息。相关的讨论可以参见C. A. Bail, "Can Generative AI Improve Social Science?", 2023年12月8日,https://osf.io/preprints/socarxiv/rwtzs。与之相关的一个现实案例为面向科研的生成式人工智能Galactica的下架。智能系统研究者麦克·布莱克(Michael Black)曾經使用Galactica处理学术问题,他发现,结果是错误且有偏的,但听起来正确且具有权威性(It was wrong or biased but sounded right and authoritative),具体参见https://twitter.com/Michael_J_Black/status/1593133722316189696,2023年12月8日。

[1]正确的表述分别是embodied、objectified和institutionalized文化资本。

[2]A. Thomas, "Cultural Capital in Health Promotion", in D. V. McQueen, I. Kickbusch, L. Potvin, et al, Health and Modernity: The Role of Theory in Health Promotion, New York: Springer, 2007.

[3]B. Soo-yong, E. Schofer, K. Kim, "Revisiting the Role of Cultural Capital in East Asian Educational Systems: The Case of South Korea", Sociology of Education, 2012, 85 (3): pp.219-239.

[4]G. Kraaykamp, K. V. Eijck, "The Intergenerational Reproduction of Cultural Capital: A Threefold Perspective", Social Forces, 2010, 89(1), pp.209-231.

[1]S. N. M. Shafiq, Y. M. Shakor, "Use ChatGPT to Solve Programming Bugs", International Journal of Information Technology& Computer Engineering, 2023, 3(1), pp.17-22; B. Som, "Role of ChatGPT in Computer Programming", Mesopotamian Journal of Computer Science, 2023, pp.8-16.

[1]丁磊:《生成式人工智能:AIGC的邏辑与应用》,中信出版社2023年版,第235—246页;C. A. Bail, "Can Generative AI Improve Social Science?",2023年12月9日,https://osf.io/preprints/socarxiv/rwtzs。

[2]胡安宁、周怡:《再议儒家文化对一般信任的负效应——一项基于2007年中国居民调查资料的考察》,《社会学研究》2013年第2期。

[3]T. Reeskens, M. Hooghe, "Cross-Cultural Measurement Equivalence of Generalized Trust: Evidence from the European Social Survey (2002 and 2004)", Social Indicators Research, 2008, 85, pp.515-532.

[4]B. G. Robbins, "Measuring Generalized Trust: Two New Approaches", Sociological Methods & Research, 2022, 51(1), pp.305-356.

[1]A. Todorov, Face Value: The Irresistible Influence of First Impressions, Boston: Princeton University Press, 2017.

[1]G. Igor, M. Feinberg, D. C. Parker, et al, "AI and the Transformation of Social Science Research", Science, 2023, 380(6650), pp.1108-1109.

[1]P. J. Sung, J. OBrien, C. J. Cai, et al, "Generative Agents: Interactive Simulacra of Human Behavior", Proceedings of the 36th Annual ACM Symposium on User Interface Software and Technology, 2023, pp.1-22.

[2]G. Igor, "Beyond the Hype: How AI Could Change the Game for Social Science Research", 2023年12月8日,https:// theconversation.com/beyond-the-hype-how-ai-could-change-the-game-for-social-science-research-208086#:~:text=AI% 20could%20act%20as%20a,as%20actors%20in%20social%20experiments.

[3]L. Weidinger, J. Uesato, M. Rauh, et al, "Taxonomy of Risks Posed by Language Models", Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency, Association for Computing Machinery, New York, NY, USA, 214-229.