基于旋转框表示的光学遥感图像目标检测

2024-03-27裴永涛粟长权

裴永涛,张 梅,粟长权

(贵州财经大学信息学院,贵阳 550025)

0 引言

遥感图像是指通过对地卫星以及航空飞机等对地拍摄得到的有关地球表面的图像,对于地表资源监测有着极大的利用价值。遥感图像目标检测技术是遥感图像智能解译任务中的基石,对遥感图像中感兴趣的目标如飞机、船舶、汽车等进行分类和定位识别,在自然资源监测、环境变化检测、智慧城市建设、智慧化农业发展等各个领域有着极为广泛的应用。

传统的遥感图像目标检测方法主要包括人工目视解译判读、模板匹配和机器学习方法等[1],人工目视解译需要专业人员凭借知识经验进行目视解译判读,主观性强且耗时较长,其中光学遥感图像中的目标由于受到云雾、天气变化和成像高度的影响,增大了专业人员对遥感目标检测和识别的难度。模板匹配方法主要通过预设模板,计算模板与图像之间的匹配相似度检测目标,该方法面对不同的尺度遥感目标需要设计不同的模板,泛化能力较弱。机器学习方法通过采用不同大小的矩形滑动窗口对遥感图像进行遍历,筛选出感兴趣的目标区域,然后通过分类器筛选得出最终的遥感目标检测结果,该方法面对不同尺度的目标检测有效,但检测精度较低。

近年来,随着人工智能技术以及深度学习的蓬勃发展,基于深度学习的通用目标检测算法逐渐兴起,该类方法由于检测精度较高、泛化能力好、鲁棒性强且应用场景广阔,被很多学者用于遥感图像目标检测,但遥感图像中目标密集分布、小目标较多,目标尺度跨度大等问题也给遥感目标检测任务带来了较大的挑战。

1 相关工作

当前,基于深度学习的目标检测方法在多个应用领域已取得了长足进步,但在遥感图像目标检测领域中,由于遥感图像目标分布密集、方向具有任意性等特点,通用的水平框遥感目标检测算法在表示目标时,存在目标框携带较多的背景、框选不准确、密集目标框混叠等问题[2],因此,使用带有角度的矩形旋转框对遥感目标进行检测逐渐成为研究热点。

随着高分遥感图像数据获取变得更加容易,基于卷积神经网络的遥感图像旋转目标检测算法发展迅速,这些算法大多都是从通用目标检测算法延伸而来,Jiang 等[3]在经典的Faster RCNN 算法基础上,提出斜框检测算法R2CNN(rotational region CNN),该算法对感兴趣区域(region of interest,ROI)采用多尺度的池化,提取任意方向目标的特征,并预测倾斜最小区域框,一定程度上能够实现倾斜目标预测,但该方法对于倾斜角度较大的目标预测效果并不准确。Ding 等[4]提出的RoI-Transformer 通过对RoI进行空间变形,并在有向边界框(oriented bounding box,OBB)标注监督下学习变形参数,模型较为灵活且对任意方向的遥感目标检测效果较好。Yang等[5]提出的R3Det在RetinaNet[6]的基础上进行改进,设计特征精细化模块(feature refinement module,FRM)重构特征,有效解决了旋转框表示目标时的特征错位问题。Xie 等[7]通过对经典的区域建议网络(region proposal network, RPN)进行改进,在对目标位置进行回归时,采用中点偏移法表示目标旋转框,预测中心点、宽、高以及两个偏移量,针对遥感目标旋转检测任务简单高效,但对于有向目标的表示较为复杂。Li 等[8]改进经典的一阶段无锚框检测算法FCOS[9],提出基于二维高斯分布的椭圆中心采样等方法,直接预测目标的中心点、宽、高和旋转角度,使网络模型更加简单且易于部署。Li 等[10]提出有向表示点(oriented representative points,oriented reppoints)对任意方向的遥感目标进行表示,并设计有效的质量评估和样本分配方案,能够很好地从相邻的遥感目标或背景噪声中捕获非轴对准特征。

上述方法采用不同的表征方式,对具有任意方向的遥感目标进行了很好的检测和识别,但遥感图像中存在目标密集、目标本身的极致长宽比、小目标较多等挑战,实现对遥感目标的精确检测还存在一定困难。为实现准确的遥感目标的旋转框检测,本文对经典的一阶段目标检测算法ATSS[11](adaptive threshold sample selection)进行改进,提出自适应阈值样本选择的显式旋转框检测算法ERDet(explicit rotation box detection based on adaptive threshold sample selection),ERDet 结合Quan 等[12]提出的显示视觉中心(explicit visual center,EVC),提取全局依赖关系与局部特征信息,在训练过程中,采用自适应阈值的样本选择策略,划分正负样本进行训练,并采用长边定义法Dle135表示目标,实现对遥感目标的旋转框预测,在DOTA-v1.0数据集上的实验结果表明,本文方法有效实现了对遥感图像目标的旋转检测,具有较高的精度。

2 研究方法

2.1 整体网络结构

ERDet 基于水平目标检测算法ATSS 进行改进,整体网络结构如图1 所示。首先,将大小为1024×1024 的图片输入到模型的主干网络Backbone,主干网络Backbone 采用经典的ResNet50 网络,产生不同大小的特征图C1~C5(为表达清晰,图1 中省略了C1 和C2 特征图)。其次,由于主干网络提取的高层特征图语义信息较为丰富,因此将主干网络提取到的最高层特征图C5(原图大小的1/32)送入显示视觉中心结构EVC,实现层内特征交互融合。再者,为了实现图像的全局信息与局部信息的有效融合,将特征图C3~C5 送入特征金字塔网络(feature pyramid network,FPN),进行层间特征交互融合。最后,特征金字塔产生的5 个特征图P3~P7送入检测头结构中,预测目标的类别和位置。

2.2 显示视觉中心EVC

遥感图像中的目标分布密集,尺度差异大,仅仅使用特征金字塔网络FPN 并不能很好地融合全部特征,FPN 仅仅实现了不同层之间(C3~C5)的特征交互融合,为了更好地应对遥感图像中的密集目标预测任务,本文结合Quan 等[12]提出的EVC 结构,对高层特征图C5 进行层间特征融合,EVC 的结构如图1 所示,由轻量化的多层感知器(lightweight multi-layer perceptron,lightweight MLP)架构和可学习的视觉中心(learnable visual center,LVC)组成,该结构具体构成如图2 所示,对于特征图C5,通过卷积核大小7 × 7 的卷积、批归一化和ReLu 函数,扩大感受野,对应图2 中的CBR(7 × 7)结构,计算如公式(1):

式(1)中,C5 代表骨干网络传入的最高级特征图,Conv7×7代表卷积核大小为7 × 7 的普通卷积,σ代表ReLU 激活函数,然后得到输出特征图F,将F通过并行的轻量化MLP 和LVC 结构,分别提取遥感图像的长距离依赖关系和局部特征,其中轻量化的MLP 结构能够很好地提取长距离依赖关系,检测到拥有极致长宽比特点的遥感目标。该结构主要包含两个残差模块,为使模型有更强的鲁棒性,两个模块均包含通道调整Channel Scaling 与多分支结构随机删除DropPath 操作,第一个模块和第二个模块的计算见式(2)和式(3):

图1 ERDet整体网络结构

上述公式中,DConv表示深度可分离的卷积,卷积核大小为1 × 1,GN为分组归一化,CMLP(channel multi-layer perceptron)表示通道级多层感知器,为表达清晰,未将通道调整Channel Scaling 和多分支随机删除DropPath 加入式(2)和式(3)中。

可学习的视觉中心LVC 通过内部字典编码与全连接层,可学习到遥感目标判别性的局部特征,固有字典codebook 主要包括两个部分,一是固有的k个码字,即:B={b1,b2,…,bk};二是一组比例因子,即:S={s1,s2,…,sk}。具体而言,将得到的特征图F,先经过1 × 1 的卷积,然后通过卷积核大小3 × 3 的卷积、批归一化和ReLU 函数进行编码,最后将编码后的特征输入到codebook 中,假设编码后的特征图大小为N,(N=H×W),H和W分别是特征图的高和宽。)通过比例因子S,第k个码字关于整个图像的信息可通过公式(4)计算:

式(4)中,是编码后特征图的第i个像素点,bk是第k个可学习的码字,sk是第k个缩放因子。后面采用带有ReLU 激活函数和平均层的批归一化层,即图2中的ϕ(∙),用于融合所有码字的信息。关于所有码字对整个图像的特征信息计算如公式(5):

式(5)中,ek是第k个码字关于整个图像的信息,在得到码本的输出e之后,将其送入到全连接层和1 × 1 的卷积层,预测突出类别的特征,并通过通道级乘法和通道级加法,得到LVC 的最终输出。

最后,将LVC 的输出与轻量化的MLP 输出进行拼接,采用1 × 1 的卷积调整特征图的通道数,得到P5,此时的P5 既包含了整个遥感图像的全局信息,提取了众多目标更多的长距离依赖关系,又保留更多的遥感图像局部信息,使得角落区域的目标更容易被检测到,进一步将P5 送入特征金字塔,使得每层的特征图能够融合图像的全局信息与局部信息。

图2 显示视觉中心EVC

2.3 旋转目标检测头

遥感图像中的目标具有任意方向,针对遥感图像的目标检测任务,使用旋转框表示目标,相对于水平框表示而言是更好的选择,为了更加准确地检测到遥感图像目标,在训练过程中,采用自适应阈值的正负样本选择策略划分正负样本,对真实目标进行回归、分类和预测旋转角度。自适应阈值的正负样本选择策略具体逻辑如下:

(1)对于遥感图像中的每个真实目标边框(ground truth bounding box,GT BBox),将特征金字塔输出的每一层中离GT BBox 的中心距离最近的K个预设锚框加入该GT BBox的候选样本集合,对于5 层金字塔而言,共计有5 ×K个候选样本。实验中默认K的取值为9。

(2)计算所有候选样本与GT BBox 的交并比(intersection over union,IoU),并统计这一组IoU 的均值m和方差v,自适应阈值为m和v的和,记为t,即t=m+v。

(3)对GT BBox 的候选样本集合进行筛选,对于IoU 值大于t的预设锚框,如果其中心点位于GT BBox 的内部,则分配为正样本,否则分配为负样本。通过该分配策略,能够保证真实的遥感目标框具有足够的正样本进行训练,能够更好地对真实遥感目标进行预测。

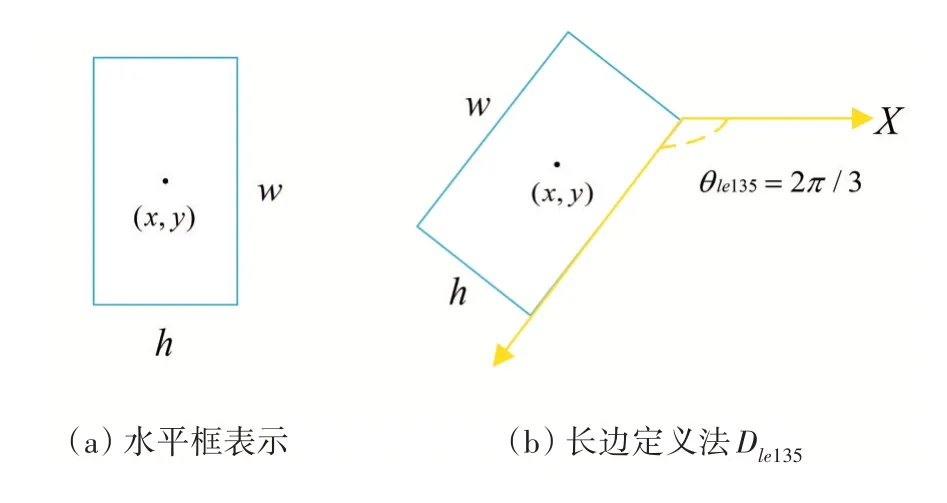

遥感图像目标的检测是否准确,目标框的表示方法十分重要,常规的水平框检测对目标表示主要由四个参数(x,y,w,h)构成,即目标框的中心点坐标(x,y)、宽w和高h,如图3(a)所示,该方式对于任意方向的遥感目标而言,容易引入大量背景,且造成较近的目标框之间形成大量重叠。为此,对于遥感图像目标,我们采用旋转框表示方法中的长边定义法Dle135对遥感目标进行框选,该表示方法主要由五个参数(x,y,w,h,θ)构成,如图3(b)所示,旋转框的最长边w与X轴的夹角为θ,,当长边在X轴上方时角度为负,在X轴下方时角度为正,采用该种表示方式,能够很好地对具有任意方向的遥感图像目标进行表示。

图3 目标检测框表示方法

3 实验

本文采用切分之后的DOTA-v1.0 数据集(https://captain-whu.github.io/DOTA/dataset.html)进行实验,输入模型的图片大小为1024 × 1024,切分后训练集图片共有15749张,验证集图片共有5297张,本文实验环境为Ubuntu 18.04,基于PyTorch平台开发的开源工具箱mmrotate,实验硬件配置为两块12 GB 显存的NVIDIA RTX3060 GPU、10th Gen Intel(R)Core(TM)i9-10900KF CPU 和64 GB 内存,DOTAv1.0 数据集中共标注了15 个遥感地物常见类别,如飞机、轮船、油罐、大型汽车等。实验中主干网络模型采用经典的ResNet50,损失函数为分类预测损失与回归预测损失相加,如公式(6):

式(6)中,λ1和λ2为可调节的超参数,实验中选取λ1= 1 和λ2= 1,Lcls为分类损失,采用Focal Loss,Lreg为回归损失,采用L1 Loss。实验中设置训练的迭代次数为12个epoch,采用的优化器算法为随机梯度下降算法,学习率初始设置为0.0025,在第8 个epoch 和第11 个epoch 分别下降10 倍,动量初始设置为0.9,衰减参数为0.0001。

实验评测结果指标选取平均精度mAP 和单类别精度AP,实验结果见表1(所示精度均为百分比制,均只保留一位小数,PL~HC 均为遥感目标单类别精度AP 的简写), 其中的Rotate-ATSS 表示仅使用长边定义法Dle135的自适应阈值样本选择目标检测算法,从表1可以看出,添加了显示视觉中心EVC的ERDet整体平均精度较之前的Rotate-ATSS提升了2个百分点,从其中单类别精度AP可以看出,针对大型汽车LV和轮船SH 等矩形目标提升较大,表明了EVC 能够更好地提取到图像的全局信息与局部信息。

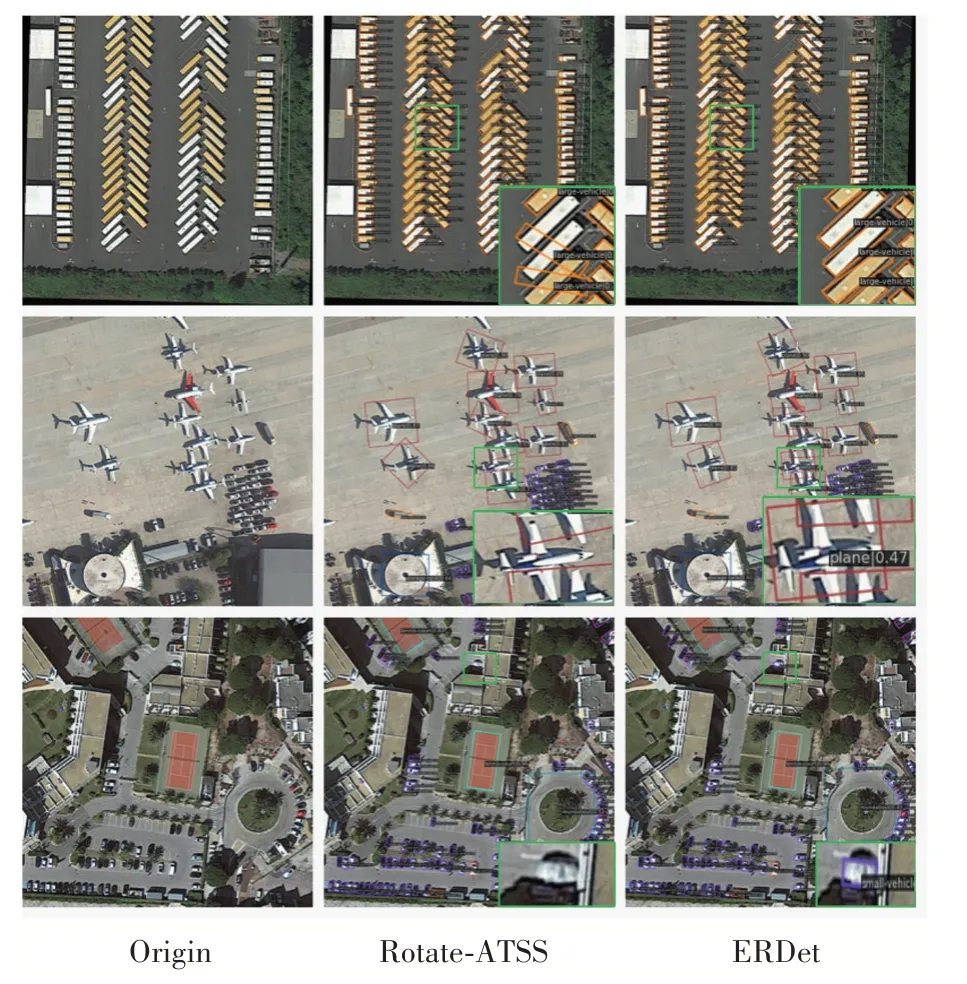

测试结果可视化如图4所示,其中绿色框表示错检或漏检区域,右下角为绿色框区域的放大图示,与Rotate-ATSS 算法相比,添加了显式视觉中心EVC 的ERDet,能够针对不同的物体,获取不同的局部特征和长距离依赖关系,如第一行所示,ERDet 能够正确对呈倾斜的长矩形大型汽车进行角度预测,而第二行和第三行则能比Rotate-ATSS 检测到朝向复杂的飞机和微小模糊的小型汽车。

图4 DOTA-v1.0旋转框可视化检测结果

表1 平均精度mAP和单类别精度AP检测结果(%)

4 结语

本文结合显示视觉中心EVC,提取复杂且尺度不同的目标的全局信息与局部信息,使用长边定义法Dle135表示目标,对自适应阈值正负样本采样策略的水平目标检测算法进行改进,提出了ERDet 对遥感目标进行旋转检测,在DOTA-v1.0 数据集上的实验表明,ERDet 能够很好地对不同尺度的感兴趣目标进行正确旋转检测,但ERDet 对于不同类别的目标检测精度有所差异,主要是由于复杂的背景以及训练样本不均衡所导致的,下一步将结合不同尺度的卷积核来提取目标更丰富的信息,完成更准确的遥感目标旋转检测。