多模态检索研究综述

2024-03-12侯腾达顾骁哲

金 涛,金 冉,侯腾达,袁 杰,2,顾骁哲

1.浙江万里学院大数据与软件工程学院,浙江 宁波 315100

2.江苏电力信息技术有限公司,南京 210003

随着互联网的不断发展以及大数据时代的到来,单模态检索的局限性在如今大数据时代逐渐明显,为了满足人们对于信息检索更加高效全面的需求,多模态学习已经逐渐受到了广大学者的关注。生活中各种模态的数据在身边被记录下来,如文本数据、图像数据、视频数据以及嗅觉数据等等。当各个模态的数据整合在一起时,多模态学习的研究也愈发重要。通过人工智能的学习来解决多模态问题,可以更好地度量不同模态间的相似性。

Shi等人[1]对多模态检索的相关技术进行分类总结,并制定了基准,为该领域发展奠定了良好基础。本文主要介绍多模态检索下以图像-文本检索为主的检索方法,同时总结并简述了一些其他模态间检索的方法。根据文献梳理将图文检索的方法技术归纳为如图1 所示。为便于多模态检索领域初学者能够了解到此领域最新研究进展,本文研究多模态检索领域由始以来发展的基本路线和近期研究现状,主要贡献如下:

(1)分析多模态检索主流方法的最新进展,总结现阶段多模态检索存在的挑战。

(2)与其他研究综述不同,本文探索了“细粒度+多模态”的检索方法并对除了图文检索外其他模态间检索方法进行了阐述。

(3)将一些代表性的方法进行测试比较,通过多模态数据集测试得出结果,分析方法之间准确性、效率、特点等方面的差异。最后对多模态检索的未来研究进行了展望。

1 实值表示学习方法

源于不同的模态数据间无法进行直接的比较,多模态检索的主要目的就是得到不同模态数据的相似性,而通过实值表示学习方法能使不同模态的数据具有统一的表示从而进行相似性对比[2]。本文主要将实值表示学习方法分为三类:全局特征学习方法、细粒度特征学习方法和混合特征学习方法。如表1所示,分别介绍近年来实值表示学习方法的热点模型。

1.1 全局特征学习方法

全局特征学习方法通过提取全局特征向量,映射到同一个子空间,通过余弦距离等方式来度量相似性,不同类别的相似度要低于相同类别的相似度,该方法在多模态检索中减少了语义鸿沟,提高了检索的准确度。

在经典的基于传统统计的分析中,Hardoon 等人[3]提出了典型相关分析(canonical correlation analysis,CCA)算法,CCA 算法作为最流行的子空间学习方法,其模型结构简单并能有效的解决线性关系问题。其主要思想为假设X=[x1,x2,…,xn],Y=[y1,y2,…,yn] 为两种不同模态特征矩阵,ωx、ωy是两投影向量,将特征矩阵转化为线性组合K和G:

构建集合内协方差矩阵ΣXX、ΣYY和集合间协方差矩阵ΣXY:

通过计算K和G两线性组合之间的相关系数ρ,体现两者间的相关性:

构建拉格朗日方程L,以为约束条件,找到最佳投影向量ωx、ωy,最大化线性组合K和G之间的相关性:

设λ和θ为系数变量,找到其特征值最大的特征向量:

该算法目标是通过学习两个线性映射,得到了不同模态之间最大化的特征相似性。但CCA算法仅能解决线性关系的问题,不能解决非线性关系的实际应用。

为了能够解决CCA算法非线性问题的缺陷,Zhang等人[4]提出了一种将核函数引入CCA 的无监督学习框架——核典型相关分析(kernel canonical correlation analysis,KCCA)。该方法通过非线性映射到公共子空间,将视觉和文本进行连接,为了有效地解决图像检索和自动标记的问题,利用用户提供关键字来传达信息[5]。KCCA在一定程度上弥补了CCA算法的不足,但KCCA方法是非参数的,因此它的可伸缩性不高。并且KCCA和CCA只适用于成对数据。

为了改进了CCA和KCCA只适用成对数据的问题。Rasiwasia等人[6]在原有的CCA算法上进行了新的扩展,提出了聚类相关性分析(cluster canonical correlation analysis,Cluster-CCA),该方法并非是类均值对应关系,而是通过两个集合中给定类中所有数据点之间的一一对应。Cluster-CCA 能够学习判别性的低维表示,最大化两个集合之间的相关性,同时在学习空间上隔离不同的类。由于它在计算协方差的时候对数据的数量呈平方的关系增长,所以在大型数据集的使用上计算量非常大。因此该方法并不适用于大型数据集上的使用。

随着需求的不断增加,仅仅只是单视图或者双视图已经无法满足多模态检索的需求,Gong等人[7]在原有的基础上提出了三视图CCA(3view canonical correlation analysis,3view-CCA)用于捕获高层次语义。经典的双视图CCA只考虑图像与相应文本特征向量之间的直接相关性。然而,通过考虑与前两个相关的第三个视图-图像的底层语义,可以获得显著的改进。

Ranjan 等人[8]在CCA 的基础上提出了多标签典型关联分析(multi-label canonical correlation analysis,ML-CCA),该方法通过多标签信息学习处理高级语义信息来学习共享子空间,与传统CCA 不同的是它不依赖于不同模式之间的显式配对。大多数现有的方法都将不同模式的数据投影到一个可以直接比较的公共空间中。

但是,由于忽略了特征和语义信息的保存,所以无法获得预期的满意结果。因此,Shu 等人[9]对ML-CCA做出了进一步改进,提出了(scalable multi-label canonical correlation analysis,SML-CCA),不仅能够像ML-CCA一样同时学习两种模态数据的共同语义空间,而且很好地解决了ML-CCA只关注语义相关性,忽略特征相关性的问题。在上述方法中,经过研究者对方法的改进一定程度上弥补了CCA 的缺点,证明了语义信息对提高多模态检索精准度的有效性。

为了研究多模态重构,通过多模态重构和单模态重构两组模型,Feng等人[10]提出了一种涉及对应自编码器(correspondence autoencoder,Corr-AE)的多模态检索新模型。将表示学习和相关学习两段式方法融合到一个过程中。受到深度网络学习的启发,一些人就希望能将深度神经网络与传统CCA 相结合,Andrew 等人[11]提出了深度典型相关分析(deep canonical correlation analysis,DCCA),这是一种学习两个数据视图的组合非线性变换的方法,使得得到的表示高度线性相关。两个变换的参数被共同学习,使总相关性最大化(正则化)。它可以被视为典型相关分析(CCA)的非线性扩展。但是DCCA仍然存在计算效率不高,内存占用过大等问题。

传统的特征提取技术限制了图像识别的性能。由于卷积神经网络(convolutional neural network,CNN)的发展,视觉识别任务取得了重大进展。为了提升多模态检索的效率,Wei 等人[12]提出了一种深度语义匹配方法(deep semantic matching,Deep-SM)来解决带有一个或多个标签注释的样本的多模态检索问题。通过实验与典型相关分析(CCA)相比较,证明了CNN 视觉特征在多模态检索中的优越性。

现有的基于深度神经网络的方法往往面临多模态训练数据不足的挑战,这限制了训练的有效性,容易导致过拟合。迁移学习通常用于缓解训练数据不足的问题。因此,Huang等人[13]提出了模态-对抗混合传输网络(modal-adversarial hybrid transfer network,MHTN),这是一个从单模态源域到多模态目标域的混合转移过程。与现有的单模态迁移方法不同,这种混合迁移结构可以将源域的大规模单模态数据集的知识联合迁移到目标域的所有模态中,提取模态无关的补充信息,缓解多模态训练数据不足的问题。如图2所示,展示了模态对抗性语义学习子网络的结构,其中以图像、文本和音频为例。

图2 模态对抗性语义学习子网络的结构Fig.2 Structure of modal adversarial semantic learning subnetwork

为了能完全保留数据中潜在的多模态语义结构。Wang 等人[14]提出了对抗式跨模态检索方法(adversarial cross-modal retrieval,ACMR),该模型在对抗机制下执行语义学习。进一步对特征提取施加三重约束,以最大限度地缩小来自具有相同语义标签的不同模态的所有项目的表示之间的差距,同时最大限度地扩大不同语义的图像和文本之间的距离。同样都是利用对抗学习,Peng 等人[15]提出了跨模态生成对抗网络(cross-modal generative adversarial network,CM-GAN),对不同模态的数据进行联合分布建模。模态间和模态内的相关性可以在生成模型和判别模型中同时探索。两者相互竞争以促进模态间相关学习。

1.2 细粒度特征学习方法

识别图像物体的大类比较容易,但若是需要判别更精细的物体则需要利用细粒度特征学习方法,细粒度特征学习方法目的是对属于同一基础类别的图像进行更加细致的子类划分。由于类别之间具有细微的类间差异以及较大的类内差异,所以需要捕获特定区域的细微差异进行分类。

Peng 等人[16]提出了一种基于分层网络的多粒度融合的多模态学习方法。该网络可以利用和整合粗粒度实例和细粒度补丁,使模态间关联更加精确。通过优化网络引入了对抗学习,Cheng 等人[17]提出了一种用于多模态检索的深度注意细粒度相似性网络(deep attentional fine-grained similarity network,DAFSN)。DAFSN模型由两个子网组成,用于对齐表示学习的注意细粒度相似性网络和模态判别网络。为了证明利用子空间学习方法来解决草图和照片之间的域间隙的可行性。Xu等人[18]介绍并比较了一系列先进的多模态子空间学习方法,并在两个最近发布的细粒度SBⅠR 数据集上对它们进行了基准测试。

尽管基于深度学习的视觉文本处理系统不断发展,但精确的多模态匹配仍然是一项具有挑战性的任务。Messina 等人[19]通过基于词-区域对齐的图像-句子匹配来解决模态间检索的任务。提出了一种新的方法,称为Transformer 编码器推理和对齐网络(Transformer encoder reasoning and alignment network,TERAN)。TERAN 强制在图像和句子的底层组件(即图像区域和单词)之间进行细粒度匹配,以保持两种模式的信息丰富性。

关于多模态检索任务中的多尺度稀缺性和目标冗余,Yuan等人[20]提出了一种新的非对称多模态特征匹配网络(asymmetric multimodal feature matching network,AMFMN)。该模型可适应多尺度特征输入,支持多源检索方法,并能动态过滤冗余特征。为了提高细粒度图像到文本多模态检索任务的训练,Wang等人[21]研究了生成文本-图像对的开放研究问题,并通过揭示StyleGAN2模型的隐藏语义信息,提出了一种新的配对数据增强框架。

为了保持多模态对齐中获得的多模态注意力之间的一致性。Zeng 等人[22]通过同时探索具有一致性约束的概念和句法多模态对齐来用于图像-文本匹配的概念和句法多模态对齐。引入概念级多模态对齐来探索细粒度对应关系。随后,Sheng 等人[23]提出了一个弱监督对齐模型。该模型利用注意机制并且侧重于视觉和文本片段的细粒度多模态对齐和检索。

如何充分挖掘和利用图像与句子之间的粗粒度关系或区域与单词之间的细粒度关系仍然是问题。Li 等人[24]提出了一种新的多尺度细粒度对齐网络(multiscale fine-grained alignments network,MFA),它可以有效地探索多尺度的视觉文本对应关系,以促进模态间差异的弥合。通过增强细粒度对象在不同模式下的信息交互,开发了一种通道混合方法,并对不同模式下的深度激活通道进行了处理。Shen 等人[25]提出了一种简单而有效的方法来实现多模态的从属类别之间的灵活检索。该方法采用了一种新颖的细粒度多模态中心损失,可以进一步提高多模态的类内可分性和类间紧密性。

考虑到细粒度语义相关学习提供互补提示的模态间关系,Peng等人[26]提出了一种关系聚合交叉图(relationaggregated cross-graph,RACG)模型,通过聚合模内和模态间关系来明确学习细粒度语义对应关系,可以很好地用于指导特征对应学习过程。细粒度对象检索旨在学习判别表示,以检索视觉上相似的对象。Wang 等人[27]开发了细粒度检索提示调整(fine-grained retrieval prompt tuning,FRPT),从样本提示和特征自适应的角度引导冻结的预训练模型执行细粒度检索任务。

1.3 混合特征学习方法

大多数现有的方法侧重于学习全局或局部对应关系,而不能探索细粒度的多级对齐。混合特征学习方法在图像-文本匹配在视觉和语言之间的桥梁中起着至关重要的作用,利用图像和句子之间的全局对齐或区域和单词之间的局部对齐来实现多级对齐。

近年来,探索图像区域与句子词局部对齐的细粒度匹配方法在通过聚合成对区域-单词相似性推断图像-文本对应关系方面取得了进展。然而,局部对齐很难实现,因为一些重要的图像区域可能被不准确地检测到甚至丢失。同时,一些具有高级语义的单词不能严格对应于单个图像区域。为了解决这些问题,Xu 等人[28]提出了一种新颖的混合匹配方法,称为具有语义一致性的跨模态注意力(cross-modal attention with semantic consistency,CASC),用于图像-文本匹配。拟议的CASC是一个联合框架,用于执行跨模态注意以进行局部对齐和多标签预测以实现全局语义一致性。

在之前的工作中,只是简单地利用预训练网络提取图像和文本特征并直接投射到一个共同的子空间中,或者在此基础上改变各种损失函数,或者利用注意力机制直接匹配图像区域和文本短语。这与图像和文本的语义不匹配。因此,Li等人[29]提出了一种基于全局表示和局部表示的跨媒体检索方法。构建了一个多媒体的两级网络,以探索图像和文本之间更好的语义匹配,其中包含处理全局和局部特征的子网。在此基础上,Li 等人[30]又提出了基于全局相似度和局部相似度的模型(global similarity and local similarity,GSLS)。对于全局图像特征,引入自关注网络来获得全局图像的宏观表示。对于全局文本特征,使用字符级卷积神经网络(character-level convolutional neural network,Char-CNN)来获得整个句子的宏观表示。对于局部图像特征,使用Faster R-CNN 获得图像的候选区域,并将其发送给卷积神经网络提取特征。随后,Zhang 等人[31]提出了一个统一的上下文感知注意力网络(context-aware attention network,CAAN),它通过聚合全局上下文有选择地关注关键的局部片段(区域和单词)。

现有的多模态检索方法只考虑全局或局部语义嵌入,缺乏对象之间的细粒度依赖关系。同时,人们往往忽略了模态之间的相互转换也有利于模态的嵌入。Zhu等人[32]提出了一种名为BiKA(bidirectional knowledgeassisted embedding and attention-based generation)的方法。该模型采用双向图卷积神经网络建立对象间的依赖关系。此外,它采用了双向的基于注意的生成网络来实现模态之间的相互转换。其中,利用知识图谱进行局部匹配,约束模态的局部表达;利用生成网络进行相互转换,约束模态的全局表达。

多模态检索不仅要考虑图像区域与文本词之间的低级语义对应关系,还要考虑不同模态内关系之间的更高语义相关性。因此,Zeng等人提出[33]了一个具有对象级、对象关系级和更高层次学习子网络的多层图卷积网络。通过局部和全局对齐来学习分层语义对应关系。

基于标量的分数不足以推断图像和文本之间的复杂关系。Zhang等人[34]提出了一种新的相似性对比胶囊变换(similarity contrastive capsule Transformation,SCCT)网络来推断胶囊聚类的图像-文本相似性。通过胶囊网络对词区域分数向量和短语区域分数向量之间的关系进行编码,然后用动态变化的胶囊数量获得更准确的预测。随着近年来研究的深入,Xie 等人[35]提出了一种基于多视角相似性建模(multi-perspective similarity modeling,MPSM)网络的多模态检索方法。具体来说,知识图谱迭代传播(knowledge graph iterative dissemination,KGⅠD)模块旨在迭代传播全局语义知识,实现领域信息的集成和相关节点的关联,从而获得细粒度的模态表示。

如何充分利用图像和句子之间的全局对齐或区域和单词之间的局部对齐来推断更准确地匹配分数仍然未被探索。Diao 等人[36]提出了一种用于图像文本匹配的新型相似图推理和注意力过滤(similarity graph reasoning and attention filtration,SGRAF)网络。引入依赖于一个图卷积神经网络的相似性图推理(similarity graph reasoning,SGR)模块,推断与局部和全局对齐的关系感知相似性。相似性注意力过滤(similarity attention filtration,SAF)模块经过进一步开发,通过选择性地关注重要和有代表性的对齐,同时抛弃无意义对齐的干扰,有效地整合这些对齐。

实值表示学习方法通过提高图像文本间的匹配准确度以及减少语义鸿沟来实现检索准确度的提高,随着多模态数据在生活中的应用,一些敏锐的学者也将多模态实值学习方法的检索技术应用到了实际社会生产场景中,Kou 等人[37]针对车联网中的模态数据,提出了一种基于对象注意和对抗学习(object attention and adversarial learning,OAAL)的通用语义表示方法。随着社交网络的快速发展,其中存在的语义缺口和稀疏性给多模态检索带来了挑战。为了减轻语义差距和稀疏性,Shi 等人[38]提出了一种基于互补注意和生成对抗网络(complementary attention and generative adversarial networks,CAGS)的搜索方法。细粒度特征学习方法也普遍应用于科学历史研究,因为类别之间具有高度的相似性,而特定类别由于不同的姿态和尺度而具有高度的不相似性。文化遗产图像[39]是一种细粒度图像,因为每个图像在大多数情况下具有相同的相似性。使用分类技术来区分文化遗产建筑可能会很困难。采用细粒度图像检索技术对数据库中的文物图像进行检索,可以解决类别之间高度相似和特定类别之间高度不相似的问题。

2 二值表示学习方法

多媒体数据的数量呈爆炸式增长,这使得快速高效地检索多模态数据成为迫切的要求。在众多检索方法中,哈希法以其存储成本低、快速有效的特点被广泛应用于多模态数据检索中[40]。哈希方法通过将原始特征映射到二进制编码汉明空间来节省存储空间并加快检索速度。

哈希函数学习分为两个阶段:(1)降维;(2)量化。降维意味着将信息从原始空间映射到低维空间表示。而量化是指将实际特征的线性或非线性转换为特征空间的二进制分段以获取哈希码。本文的哈希方法主要分为:传统哈希方法和基于深度哈希的方法。如表2所示,对二值表示学习方法进行了总结,汇总了传统哈希以及深度哈希方法的经典模型。

表2 二值表示学习方法总结Table 2 Summary of binary representation learning methods

2.1 传统哈希方法

传统哈希方法通过二进制编码的形式将不同模态的数据映射到同一个汉明空间中。计算查询项哈希码与数据哈希表关键值之间的汉明距离,并使用汉明距离较小的哈希表作为候选搜索范围,以提高检索的成功率。本节内容主要包含多模态检索工作中不包含深度学习方法的哈希方法。

在多语言和多模态信息访问中的许多应用程序中,数据库由具有多视图的数据对象组成,并且需要跨视图进行相似性搜索。因此,Kumar等人[41]提出了一种跨视图哈希(cross-view Hashing,CVH),CVH是一种无监督方法。通过一种新的松弛方法将其转化为可处理的特征值问题,证明了一般问题的一些特殊情况与局部敏感索引和典型相关分析等降维技术有关。但CVH并未充分考虑模态之间的联系和差异,未能满足用户同时接收多种类型数据的需求,为了弥补CVH的缺陷,实现大规模的多模态检索。Song等人[42]提出了跨媒体哈希(intermedia Hashing,ⅠMH)模型来探索来自不同数据源的多种媒体类型之间的相关性,并解决可扩展性问题。跨媒体哈希的基本思想与CVH 相似,但却充分考虑了模态之间的联系和差异,强调保持最近邻样本的模态间和模态内相似性。但是,该模型是以牺牲时间复杂度为代价保证检索效果,不适合应用于大规模数据集。

由于ⅠMH无法适用于大规模数据集的应用,为此,Zhu 等人[43]提出了一种新的哈希方法,称为线性交叉模态哈希(linear cross-modal Hashing,LCMH),以解决不使用任何先验知识的可扩展性问题。该模型采用了可扩展k-means算法计算数据点与中心点之间的距离,提升了大规模数据的检索效率。随着研究的深入,基于哈希的最近邻搜索方法在计算机视觉和信息检索界备受关注。Ding等人[44]提出了集体矩阵分解哈希(collective matrix factorization Hashing,CMFH)它假设所有模态数据的哈希码映射到公共汉明空间时是一致的。该方法不仅支持跨视图搜索,而且通过合并多视图信息提高了搜索精度。

现有的大多数哈希方法通常采用单一模态或简单地集成多个模态,而没有利用不同特征的影响。为了解决多模态紧凑哈希码的学习问题,Cheng 等人[45]提出多图哈希(multi-graph Hashing,MGH),MGH是一种半监督方法,该方法可以在多图学习方案中有效地将多种模态与优化权重集成在一起。通过这种方式,可以自适应地调节不同模态的效果。同为半监督学习,Xia 等人[46]提出了判别哈希学习方法(discriminative Hashing learning,DHLing),该方法主要包括两个模块,即领域特定优化和领域不变内存库。具体来说,第一个组件探索样本的结构知识,用伪标签预测未标记的图像,以实现哈希编码的一致性;第二种方法尝试构建域不变记忆库来指导特征生成,实现跨域对齐。

在许多重要的应用程序中,需要比较来自不同模态的数据,这些数据之间的相似性可能具有不同的结构和维度。Bronstein 等人[47]提出跨模态相似敏感哈希(cross-modal similarity-sensitive Hashing,CMSSH),几乎是近年来第一个有监督的多模态检索方法。但该方法只考虑了内部相似性。同样都是有监督学习方法,现有的大多数多模态哈希方法的训练时间复杂度过高,无法扩展到大规模数据集。Zhang等人[48]提出了语义相关最大化(semantic correlation maximization,SCM)。该方法根据标签信息学习公共空间的表示,使用语义标记向量计算数据样本之间的语义相似度。虽然该方法的训练复杂度不高,但却不适用于深度哈希中高维度的特征数据集。

为了放松离散约束,现有的方法通常忽略了哈希的固有离散性,这将导致检索性能的下降。为此,Wang等人[49]提出了语义主题多模态哈希(Semantic topic multimodal maximization,STMH),STMH 很好地维护了哈希码的离散性。通过保持哈希码的离散性,使其更适合哈希学习模式,也获得了更好的检索性能。

然而,Lin等人[50]有着了与上述不同的思想,他们提出了语义保留哈希(semantics-preserving Hashing,SePH)用于研究图像文本检索的问题。当给定训练数据的语义亲和力作为监督信息时,SePH 将其转换为一个概率分布,并在汉明空间中进行近似,方法是将待学习哈希码之间的所有成对汉明距离转换为另一个概率分布Q,并将散度最小化以提升多模态检索的性能。

通过对无监督学习的深入研究,Liu 等人[51]提出了一种新的无监督多模态检索方法,称为自监督相关学习(self-supervised correlation learning,SCL),该方法充分利用大量未标记的数据来学习判别性和模态不变表示,进一步提升了多模态哈希的检索效率。通过引入自适应方法,Luo 等人[52]提出了一种自适应边缘语义哈希(adaptive marginalized semantic Hashing,AMSH)方法,该方法不仅可以通过自适应边缘增强对潜在表示和哈希码的区分,而且可以用于成对和非成对的多模态哈希。

2.2 深度哈希方法

随着深度学习算法在计算机视觉领域的重大突破,图像识别、人脸识别等技术的准确度不断上升。深度哈希方法将深度学习与哈希图像检索相结合,同时拥有检索精度高,速度快的特点。

得益于深度学习,多模态检索取得了引人注目的成果。然而,深度多模态哈希方法要么依赖于标记信息的数量,要么无法学习不同模态之间的准确性和相关性。因此,Li等人[53]提出了无监督耦合循环生成对抗哈希网络(unsupervised coupled cycle generative adversarial Hashing,UCH)用于多模态检索。该方法通过所提出的耦合循环网络,实现公共表示和哈希码学习相互作用,并在网络收敛的同时达到最优。

由于多模态检索方法依赖于繁琐的人工标记过程,不仅引入了主观误差,而且耗费了大量的时间和人力成本。Duan等人[54]设计了一个基于Web知识驱动的多模态检索框架,称为无监督和鲁棒图卷积哈希(unsupervised and robust graph convolutional Hashing,URGCH)。针对人工标注过程繁琐、时间成本大的问题,提出了一种“二次语义自融合”方法,自动构建联合语义矩阵,用于弥合模态差距。随着对无监督多模态哈希的深入研究,Yang 等人[55]提出了一种新的深度语义对齐哈希(deep semantic-alignment Hashing,DSAH)用于无监督多模态检索,它充分利用了共同发生的图像-文本对。随后,Yu等人[56]设计了一种深度图邻相干保持网络(deep graphneighbor coherence preserving network,DGCPN),DGCPN 源于图模型,并通过整合数据及其邻居之间的信息来探索图邻居一致性。

由于传统多模态哈希的性能不能满足现有的需求,Jiang 等人[57]提出了深度跨模态哈希(deep cross-modal Hashing,DCMH),将哈希码学习以及特征学习集成到同一框架中。在DCMH 的基础上,为了提升模态检索的效率。Li等人[58]提出了一种自监督对抗哈希(selfsupervised adversarial Hashing,SSAH)方法,这是早期以自监督方式将对抗学习纳入多模态哈希的尝试之一。该方法仍然存局限性,忽略了许多多模态数据集在多标签中包含丰富的语义信息。因此,Zou 等人[59]提出了一种多标签模态增强的基于注意的自监督深度跨模态哈希(multi-label modality enhanced attention-based self-supervised deep cross-modal Hashing,MMACH)框架。该方法设计了一个多标签模态增强注意模块,将多模态数据中的重要特征集成到多标签特征表示中,以提高其完备性。

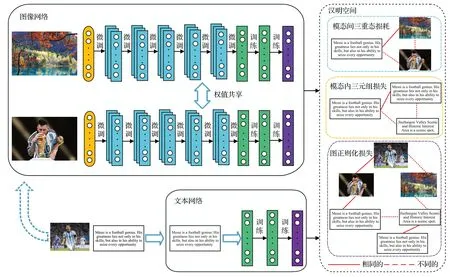

几乎所有采用多模态哈希的现有方法都忽略了异构数据之间的相对相似性,无法获得强大的哈希码,从而导致检索性能不理想。Deng 等人[60]提出了一种用于多模态检索的基于三重的深度哈希(tripletbased deep Hashing,TDH)网络。该方法使用三元组标签,描述了三个实例之间的相对关系,以便捕获跨模式实例之间的语义相关性。从模态间视图和模态内视图建立一个损失函数,以提高哈希码的鉴别能力。其结构如图3所示。

图3 拟议TDH的框架Fig.3 Framework of proposed TDH

为了缩小模态差距以进一步提高检索精度。Bai等人[61]提出了一种用于多模态检索的图卷积网络哈希(graph convolutional Hashing,GCH)算法,该算法由三个主要部分组成:语义编码器、两个特征编码网络和基于图卷积网络的融合模块。随着对细粒度的深入研究,Chen 等人[62]提出了一种具有双过滤机制和基于代理的损失函数的新型细粒度哈希方法(fine-grained hashing,FⅠSH)。具体来说,双过滤机制由空间过滤模块和特征过滤模块两个模块组成,分别解决了细粒度特征提取和特征细化问题。

二值表示学习方法通过哈希算法使其在大规模数据集上的检索效率有明显的优势,随着多媒体数据量的急剧增加,多模态检索已成为最普遍但最具挑战性的问题之一。哈希通过将高维数据嵌入到保持汉明空间的低维相似性空间中[63],为大规模多模态数据搜索提供了一种有前途的解决方案。

3 图文检索以外的多模态检索方法

3.1 视频-文本检索

随着YouTube、TikTok 等互联网视频的迅速兴起,给视频内容的准确检索带来了巨大的挑战。多模态视频-文本检索能够理解文字和视频的内容,从而实现视频与文本之间的匹配。视频-文本检索任务即给定一个文本查询,根据对文本的描述程度从数据库中检索和排序视频,反之亦然。

为了学习视频图和文本图之间的更好匹配,Jin 等人[64]提出了一种用于视频-文本检索任务的分层多模态图一致性学习网络(hierarchical cross-modal graph consistency learning network,HCGC),该网络考虑了视频-文本匹配的多级图一致性。设计了三种类型的图一致性:图间并行一致性、图间交叉一致性和图内交叉一致性。

Chen 等人[65]提出了一种用于细粒度视频文本检索的层次图推理(hierarchical graph reasoning,HGR)模型,该模型将视频文本匹配分解为全局到局部级别。它利用细节语义改进了全局匹配,利用全局事件结构改进了局部匹配。通过克服视频和文本之间的异构差距,Feng等人[66]提出了一种用于视频文本检索的具有全局-局部对齐(temporal multi-modal graph transformer with global-local alignment,TMMGT-GLA)的新型时间多模态图转换器。

为了将细粒度和交叉粒度的相似性矩阵聚合到实例级相似性,Ma 等人[67]提出一种用于视频文本检索的多粒度对比模型X-CLⅠP,模型专注于基本框架和单词之间的对比度,从而降低不必要的框架和单词对检索结果的影响。随后,Jin 等人[68]提出了粗细粒度并行注意力机制和特征融合模块(coarse-fine-grained parallel attention,CFPGA),使用粗-细粒度并行关注机制来处理多模态视频的全局和局部特征,从而增强了同一模态视频特征中特征点之间的关系。将多头注意机制整合到粗-细粒度并行注意中,增强了模型对特征的接受场,从多个角度处理相同的视频模态特征。

3.2 音频-文本检索

多模态音频-文本检索需要学习两种不同模态的综合特征表示,并将它们统一到一个共同的嵌入空间中。旨在以另一种方式从给定查询的候选池中检索目标音频剪辑或标题。

早期的工作只关注基于标签的音频检索,其中查询的是单词而不是句子。以早期的思想为基础,Mei 等人[69]针对基于自由形式语言的音频文本检索任务,提出了一种简单有效的声学语义嵌入学习模型,并在恒定训练环境下研究了基于该模型的度量学习目标的影响。

语言的相似性并不总是意味着声学上的相似性,对于临时的、用户生成的录音,这些录音在音频及其相关的文本标签中都是嘈杂的。为了克服这一限制,Elizalde等人[70]提出了一个框架,该框架从共享的词典声学空间中学习联合嵌入,其中来自任一模态的向量可以映射在一起并直接比较。通过引入注意力机制,Bai 等人[71]提出了一种端到端的非自回归语音识别模型,称为LASO(listen attentively,and spell once)。该模型将编码的语音特征聚合到与每个令牌对应的隐藏表示中。

音频-文本检索旨在检索与音频模态到文本模态的给定实例最匹配的实例,Chao 等人[72]提出了一个新颖的三阶段课程互学框架(three-stage curriculum-based mutual learning framework,3CMLF)来提高绩效。使用三个构建的训练集在三阶段多模态互学框架下训练文本和音频编码器。3CMLF 适用于大多数当前的音频-文本模型,因为它不需要更改模型架构。大多数现有的多模态音频-文本检索方法并未显式学习音频特征中的顺序表示。Song 等人[73]介绍了一种基于强化学习和特征融合的顺序特征增强框架,以增强多模态特征的顺序特征。采用强化学习来探索听觉和文本特征中的有效顺序特征。

生活中不仅只有图文检索的应用,Paddeu等人[74]讨论了基于Web 的自然语言问答系统的基本体系结构。提出了互动式影音文字指南,以方便参观博物馆。专注于制作有声文字指南,让残障人士也能无障碍地体验展览。此外,数据捕获、存储和通信技术的进步已经为消费者和企业应用程序提供了大量的视频数据。与多媒体数据,特别是视频进行交互,需要更好的文本形式来描述视频数据。

4 多模态数据集

4.1 常用数据集

随着多模态数据的普及,为了评价多模态检索算法的性能,研究人员收集多模态数据,建立多模态数据集。如表3 所示常用的数据集有Wikipedia[75]、Pascal Sentence[76]、Flickr30K[77]、NUS-WⅠDE[78]和MS-COCO[79]。

表3 多模态检索常用数据集Table 3 Multimodal retrieval of common datasets

Wikipedia:它由带有相关文本和图像对的文档语料库组成。维基百科将每篇文章分为29 个概念,并将这些概念分配到文章的图像和文本模块中。研究人员考虑了10 个最常见的概念,因为有些概念很罕见。最终语料库由2 866篇文献组成。

Pascal Sentence:该数据集是Pascal VOC的一个子集,它包含来自20个类别(每个类别50对)的1 000对图像和文本描述。每个图像文本对由一个图像和5 个相应的句子组成。

Flickr-30K:它是Flickr-8K的扩展,包含从不同Flickr组收集的31 783张图片,与158 915个字幕相关联,重点涉及人和动物的事件。每张图都会与由英语母语人士在Mechanical Turk网站独立撰写的句子相关联。

NUS-WⅠDE:这是一个真实世界的网络图像数据集,由新加坡国立大学的媒体搜索实验室组成。它包括:269 648 张图片和来自Flickr 的相关标签,其中有5 018个独特的标签;81个概念的Ground-truth。

MS-COCO:Microsoft Common Objects in COntext数据集由日常环境中的日常场景图片组成。该数据集由总共328 000 张图像和2 500 000 个标记实例组成。为数据集选择的对象来自91个不同的类别。

mAP 值指平均精准度,衡量检索到的模态与查询模态类别是否一致,常用于评估多模态检索算法性能。给出查询数据和n个检索结果,其检索精度可表示为:

其中,i表示检索文档中第i个样本,P(i)表示的是第i个检索样本的精度。另外,如果第i个样本检索返回的数据与其本身相关,则δ(i)=1,反之δ(i)=0,Q代表发起查询的数量,mAP 值越高意味着搜索性能越好,最终mAP值的公式如下:

R@k(Recall@k) 常在MS-COCO 和Flickr-30k等数据集中作为实值表示方法的评价指标,表示正确结果出现在前k个返回样例占总样例的比例。RELk代表Top-k结果中的相关项数,REL表示给定查询的相关项总数。这个指标回答了Top-k中是否找到了相关的结果,其计算公式如下:

4.2 实验结果对比与分析

本节选取了部分实值表示学习方法和二值表示学习方法中经典的方法模型进行实验比较。将mAP作为评价指标对方法的进行对比。

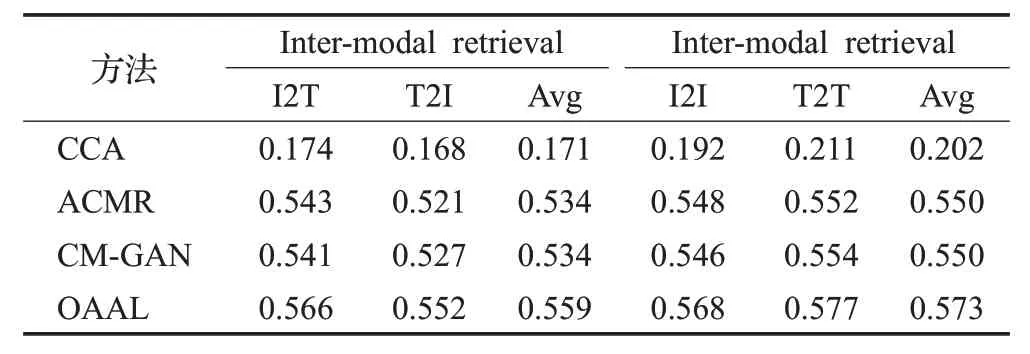

如表4所示,将实值表示方法中几个方法进行对比得出,ACMR、CM-GAN 和OAAL 方法在Pascal Sentence数据集上取得的效果远优于传统CCA方法,而ACMR、CM-GAN 和OAAL 三个方法都引入了对抗学习,体现出了对抗学习在多模态检索中的优势。OAAL 方法在几个方法中取得最优效果,证明了其方法将对象注意机制与生成对抗网络相结合的有效性。

表4 Pascal Sentence数据集上几种实值表示方法的mAPTable 4 mAP of several real-valued representations on Pascal Sentence datasets

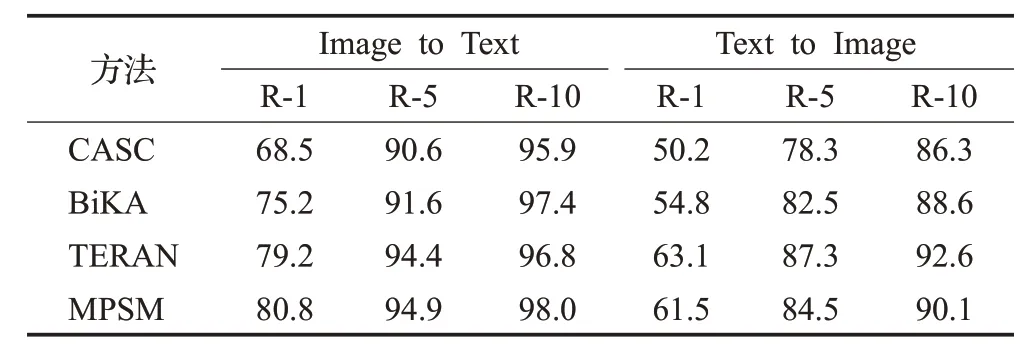

如表5 所示,在Flickr-30k数据集上对几个实值表示学习方法进行了比较,结果表明TERAN 模型在文本检索图像的任务中取得更优R@k值,证明通过在训练时执行这种细粒度的词区域对齐,可以在Flickr30K 数据集上获得先进的结果。MPSM 模型在图文检索的表现则更加地全面,表明了传播语义信息以学习细粒度的模态内相关性并将其纳入多模态相似性学习可显著提高匹配性能,并且从多个角度学习相似性有助于多模态对齐。

表5 Flickr-30k 上实值表示学习方法R@k 值比较Table 5 Real-values on Flickr-30k represent comparison of learning methods R@k values

如表6所示,将二值表示方法中几个方法进行对比得出,DCMH、DSAH、DGCPN 和TDH 四种深度哈希方法在NUS-WⅠDE 数据集中效果远优于传统CVH 方法,表明了深度哈希方法的优势。TDH方法更是取得最高的mAP,其性能的提高取决于其模态间视图和模态内视图建立了损失函数,以增强哈希码的判别能力。

表6 NUS-WⅠDE上不同哈希方法的mAPTable 6 mAP of different Hashing methods on NUS-WⅠDE

深度学习和哈希算法的结合具有优异的性能。单纯的深度学习技术可以帮助人们更好地理解多模态数据之间的关系,如今学者提出了多层网络组合形成的复杂模型结构,如对抗机制、注意力机制等被运用到模态检索中去,从而更好地进行多模态匹配,虽然在一定程度上提升了模态检索的精度,但却大大牺牲了检索效率以及需要耗费大量的训练时间。而哈希算法虽然在检索效率上有着突出的表现,但其却破坏了原有的数据结构使得检索的准确性受损。希望能在将来通过深度学习和哈希算法的结合带来同时兼顾检索效率与准确性的方法。

5 多模态检索未来展望

随着大量学者对于多模态检索方法的不断改进,检索方法的准确度以及效率都不断提升,但随着数据模态以及数量的不断扩展,人们的需求也不断增长。未来,仍需不断改进现有的模型方法,无论是从深度学习方面或是从哈希算法的改进方面,多模态检索仍将面临一系列挑战和机遇。以下是一些思考与展望:

(1)现有的方法通常是应用于文本与图像两个模态之间一对一地检索,现实生活中有着其他许多模态,音频和视频等模态间同样存在着非常大的研究价值,希望未来能将模态检索的方法扩展到以一种模态检索出多种模态,或者以多种模态来检索一种模态以提高多模态检索的准确性。

(2)多模态检索中实现更细粒度的检索,如人像类图片之中,全局信息或许包含了蓝天白云等信息,但图片之中的人物才应该是最值得关注的局部信息,关注全局语义容易被冗余的信息影响检索的效率,提取不同模态片段语义特征以及使其实现不同模态片段特征的关联是提升跨模态建模效果的途径,因此精细化模态细粒度将是未来提升检索效率的一个研究方向。

(3)高层语义理解和潜在语义挖掘可以帮助人们更好地理解多模态数据之间的语义关系,从而更好地进行跨模态匹配。随着对信息检索的要求不断提高,解决不同模态间的语义鸿沟仍是重大的挑战,通过提升多模态检索的精度来实现对多模态数据间高阶语义联系将会是未来多模态检索的一个重要发展方向。

(4)增强现实和虚拟现实将会为多模态检索带来新的机遇。例如,使用增强现实技术,可以将文本、图像和音频信息转化为现实世界中的虚拟实体,从而更好地展示和理解跨模态信息。

(5)现有的大多数社交媒体网站的数据集样本类别数量已经无法满足多模态的检索要求,对新颖多样的领域数据集的需求不断提升。随着模型的复杂度上升,对数据内容的多样性有着巨大的需求。如NUS-WⅠDE和维基百科对如今而言已经不够新颖了,需要引入更符合检索需求的多模态数据集。

总之,多模态检索是一个不断发展和变化的领域,它将会在未来成为人们从多媒体数据中获取信息的重要手段之一。

6 结束语

多模态检索是信息检索领域的一个重要研究方向,其目标是通过结合不同模态的数据,提高检索系统的效果和性能。该领域的研究涉及多个方面,包括跨语言、跨媒体、跨领域等。近年来,深度学习技术的发展为多模态检索提供了新的机会和挑战。在这一领域中,深度学习方法被广泛应用,包括深度神经网络、卷积神经网络、循环神经网络等。这些方法不仅能够提高检索效果,还能够降低特征提取的复杂度和计算成本。综上所述,多模态检索是一个充满挑战和机会的研究领域,其发展趋势将会受到深度学习技术和跨领域合作的影响。