多模态命名实体识别方法研究进展

2024-03-09王海荣荆博祥

王海荣, 徐 玺, 王 彤, 荆博祥

(1.北方民族大学 计算科学与工程学院,宁夏 银川 750021;2.北方民族大学 图像图形智能处理国家民委重点实验室,宁夏 银川 750021)

命名实体识别任务是从数据中识别出专有名词,最早在信息理解会议[1]上被提出。随后形成了基于规则[2]和词典[3]的方法、机器学习的方法、深度学习的方法等3类命名实体识别方法。基于规则和词典的方法通过字符匹配进行信息抽取,适用于数据更新较少的领域,但规则和词典制定成本较高。基于机器学习的方法将命名实体识别任务视为分类问题,并提出了如HMM-based[4]、CRF-based[5]的模型,该方法减少了人工成本,但选取特征的质量决定了算法的性能。基于深度学习的方法具有自动挖掘高质量上下文特征的能力,研究者相继提出了CNN-based[6]、BiLSTM-based[7]、Transformer-based[8-10]、GNN-based[11-13]等模型,但要求文本有充足的上下文特征,因此在长文本数据集中的性能表现更好,在短文本数据集中性能表现不佳。

传统的文本语义增强主要依赖字符特征[14]、词汇信息[15]、知识图谱[16-17]、检索[18]、标签信息[19]等外部文本数据,也结合了多任务学习来增强命名实体识别的能力。王蓬辉等[20]采用基于生成对抗的数据增强算法来解决标注数据不足的问题。余传明等[21]提出了实体和事件联合抽取模型,从而在2个任务中均取得了更好的效果。武国亮等[22]提出将命名实体识别任务的输出反馈到输入端,来解决多任务联合学习产生的损失不平衡问题。但随着社交媒体平台的广泛应用,以文本、图像为主要媒介的多模态数据快速增长,为了从这些多模态数据中挖掘语义,进而增强文本特征,人们提出了多模态命名实体识别(multimodal named entity recognition,MNER)方法。MNER研究难点是如何融合多模态特征中有益信息,并过滤有害信息。早期研究[23-25]关注使用视觉特征增强静态词表示的方法,取得了一些研究成果。范涛等[26]将MNER迁移到了地方志领域的实体识别研究。近年来,随着预训练语言模型的发展,MNER方法的研究重点逐步转向采用Transforme融合特征,取得了新的研究成果。现有的MNER方法可分为4类,如表1所示。

表1 多模态命名实体识别方法分类表

2018年,Moon等[27]首次在BiLSTM-CRF模型中融入了视觉特征,提出了多模态实体识别方法,提出MA[27]模型。VAM[28]、CWI[29]等模型也被提出。这些模型均使用注意力机制为文本表示和视觉特征分配权重,拼接得到多模态特征,再通过BiLSTM+CRF网络挖掘上下文特征并解码,将此类模型归纳为前融合模型。前融合模型中使用Glove表示单词,导致图像特征与文本特征间的语义存在巨大鸿沟。针对该问题,一些学者提出ACN[29]、GAN[30]、DCN[35]等模型,先使用BiLSTM挖掘文本中上下文特征以增强单词的实体语义,然后采用注意力机制作为多模态融合层,得到多模态特征,将此类模型归纳为后融合模型。

为了进一步缩小文本与图像特征的语义差距,2020年,基于Transformer的MNER方法首次被Yu等[33]提出,其中Chen等[36]使用BERT表示文本,并验证了提升单词语义的重要性,之后UMGF[31]、MAF[32]、ITJ[37]、HSN[38]等模型相继被提出,这些模型堆叠多个Transformer,对各模态特征进行编码、对齐或融合处理,得到多模态特征后,均只后接1个命名实体识别任务,本文将此类模型归纳为Transfor-mer单任务模型。为了解决多模态特征与目标语义间的偏差问题,一是在文本表示和多模态表示上构建联合实体识别任务,以解决视觉偏差的问题,如Yu等[33]的边界检测任务,Wang等[34]和Liu等[39]的文本视图命名实体识别任务。二是通过辅助任务联合训练多模态表示,增强特征的通用性。如李晓腾等[40]提出通过对比融合、实体聚类、边界检测等任务辅助学习多模态特征,Chen等[41]结合关系抽取任务训练多模态特征,本文将此类模型归纳为Transformer多任务模型。上面所提的4类模型尚没有关注单视觉特征中图像语义丢弃的问题。

此外,Sui等[42]构建文本和语音数据集并提出M3T模型,进一步验证多模态特征能帮助识别命名实体。Liu等[43]提出使用合成的声学特征而不是真实的人类语音,并采用多头注意力机制融合文本和语音2种模态的特征,稳定地提高了中文命名实体识别的性能。冯皓楠等[44]提出了一种图文注意力融合的主题标签推荐的方法,并表明相比单模态输入,多模态方法具有更显著的优势。郑建兴等[45]提出了基于评论文本情感注意力的推荐方法,使用注意力机制聚合用户特征和项目特征信息,以得到联合嵌入,进而提升了模型的有效性。

1 MNER方法框架

根据MNER各方法的特点,将MNER方法的框架划分为模态输入表示、上下文编码层、多模态融合层、标签解码和多任务融合层。多模态命名实体识别的基本框架如图1所示。

图1 多模态命名实体识别的基本框架

模态输入表示是将各模态数据表示为特征向量。上下文编码器旨在挖掘特征的上下文依赖关系,主要采用BiLSTM模型。多模态融合层旨在融合多模态特征,主要采用Attention、Co-Attention、Transformer、Transformer with Cross-Attention模型。多模态融合层和上下文编码器呈现3种结构,前融合模型将图像信息传递给每个单词,再挖掘单词间的上下文特征;后融合模型则相反;多模态表示使用Transformer作为联合编码模型,融合多模态特征。标签解码层将多模态表示作为输入特征来预测标签。此外,当MNER方法结合了如对抗学习、边界检测、关系抽取等辅助任务共同训练,将之归纳为多任务融合层。综上,可划分为4种模型结构:前融合模型、后融合模型、Transformer单任务模型及Transformer多任务模型。

1.1 模态输入表示

文本模态输入表示主要采用字符嵌入、词嵌入、混合嵌入表示文本特征。字符嵌入Xc通过CNN或RNN模型进行表示,缓解out-of-vocabulary的问题;词嵌入模型包括CBOW[46]、Word2Vec[47]、Glove[48]、FastText[49]、ELMo[50]、BERT等。对于输入的句子S,静态词向量可表示为

Xs=Glove(S)。

(1)

动态词向量可表示为

Xb=BERT(S)。

(2)

混合嵌入[51]可表示为X=[Xs;Xc]。

对于输入的图像特征I,视觉模态输入表示采用预训练数据模型进行特征表示,区域视觉特征使用ResNet[52]模型提取,可表示为

Vr=ResNet(I),Vr∈Rn×d。

(3)

式中:d为特征维度;n为特征的数量。

(4)

利用Mask RCNN[53]提取对象级视觉标签,可表示为

Vl=MaskRCNN(I)。

(5)

图像标题使用图像字幕[54](image captioning,IC)提取,可表示为

Vcap=IC(I)。

(6)

1.2 上下文编码层和多模态融合层

双向长短时记忆网络(bi-directional long-short term memory,BiLSTM)作为上下文编码器时,能提取单词上下文特征。自注意力机制能增强关键特征的权重。self-Attention(SA)、Multi Head self-Attention(MHSA),Cross-Attention(CA)、计算原理表示如下:

(7)

MHSA()=W′[SA0(),SA1(),…,SAm-1()];

(8)

(9)

式中:Q、K、V为输入特征的投影向量;d为Q的特征维度;m为多头注意力的头数;W′代表投影矩阵;Q1代表文本模态的输入特征的投影向量;K2、V2代表视觉模态的输入特征的投影向量。此外,multi head cross-attention(MHCA)是将MHSA()中的SA()替换为CA()。

Transformer能获取到长距离依赖关系,由多个编码器堆叠形成,每个编码器由多头自注意力机制、前馈层及规范化层组成。

Transformer作为多模态融合层时,其多模态特征融合技术主要为以下3种构建方式:①将文本表示和视觉表示投影到同一离散空间进行对齐;②使用视觉语言模型对文本和图像进行联合表示;③将视觉特征转化为自然语言描述,使用语言模型统一表示。

1.3 标签解码和多任务融合层

通常使用条件随机场(conditional random field, CRF)作为标签解码层,对多模态表示进行解码。设X={x0,x1,…,xn}为CRF的输入特征,y={y0,y1,…,yn},解码表示如下:

(10)

使用最大似然函数作为损失函数,计算如下:

(11)

yo为预测输出序列得分最高的序列,计算如下:

yo=argmaxyp(y|X),

(12)

多任务融合层中利用任务间的信息共享来训练模型参数,以全局最优的多模态特征或预测结果提升实体识别性能,增强模型的可用性,包括命名实体识别主任务和实现标签融合或优化多模态表征的辅助任务。

2 基于BiLSTM的MNER方法

基于BiLSTM的MNER方法以BiLSTM和CRF作为基础模块,并引入多模态融合层,实现文本和图像特征融合,以解决上下文特征匮乏的问题。根据多模态融合方法划分为前融合模型和后融合模型,并对各方法进行实验验证及对比分析。

2.1 前融合模型

前融合模型首先对各模态表示进行拼接或加权拼接,接着使用BiLSTM挖掘上下文特征,最后将融合表示输入CRF中预测标签。前融合模型框架如图2所示。

图2 前融合模型

Moon等[27]的多模态融合层是先拼接单词表示、字符表示及区域视觉特征,将其映射到统一特征空间X=σ([Xs;Xc;Xv]),Xv=Vr,σ为投影函数,使用注意力机制计算X中各模态权重[as;ac;av],得到融合表示M,以as为例,模态权重计算如下:

(13)

M=asXs+acXc+avXv。

(14)

Lu等[28]使用视觉注意力模型从图像中提取与文本最相关的图像特征,计算得到视觉上下文特征v,将v与词表示、字符表示拼接,得到融合表示M=[vs;Xs;Xc],计算如下:

A=softmax(W1([Xs;Xc]⊕Xv));

(15)

(16)

式中:W1为权值矩阵;⊕为向量的求和函数;A为视觉全局注意力权重。

Asgari-Chenaghlu等[55]分别挖掘出字符特征、单词特征和图像特征的上下文特征并拼接这些上下文特征作为多模态融合表示。

经分析发现上述模型存在以下限制:单词表示的实体语义微弱。当单词的拼写错误,只能通过随机初始化进行表示,文本的实体语义被降低。此外,实现处于不同特征空间的图文特征对齐是很困难的。

2.2 后融合模型

后融合模型利用BiLSTM挖掘上下文特征,增强单词表示的实体语义,使用多模态注意力融合图文特征,再使用CRF模型解码。框架如图3所示。

图3 后融合模型

Zhang等[29]提出了共注意力网络(CoAttention),对于输入的图文特征,先计算基于文本上下文的文本特征ht=BiLSTM([Xs;Xc]),再分别通过共注意力机制计算基于文本注意力的视觉特征Hcv和基于视觉注意力的文本特征Hct,通过门控机制gate(·)=softmax(ReLU(·))得到多模态表示M,计算如下:

[Hcv,Hct]=CoAttention(Xv,ht);

(17)

M=ht+Hct·gate(Hcv⊕Hct)。

(18)

但共注意力网络忽略了细粒度视觉对象和文本实体之间的关系,可能导致不同类型实体的错误预测。为此,Zheng等[30]利用对抗学习优化投影函数将图文特征映射为一个共享的表示,然后采用双线性注意力计算每个单词和对象标签的细粒度语义关系,以及共同表示G,通过门控机制生成融合表示M,计算如下:

(19)

G=Xv·AT;

(20)

M=σ([G;ht])∘G+ht。

(21)

式中:σ()为投影函数;one为向量;P为注意力得分的池化参数矩阵;W2、W3为参数矩阵;∘为哈达玛积。

Wu等[35]使用视觉标签表示图像语义,引入密集的共注意力机制建立单词和对象之间的关系,实现细粒度语义交互,得到多模态表示M。计算如下:

htsa=SA(ht,ht,ht);

(22)

hv=SA(Xv,Xv,Xv);

(23)

M=ht+CA(htsa,hv,hv)。

(24)

式中:Xv、ht代表视觉特征、文本特征;SA()和CA()分别代表自注意力机制和跨模态注意力机制。

2.3 方法分析

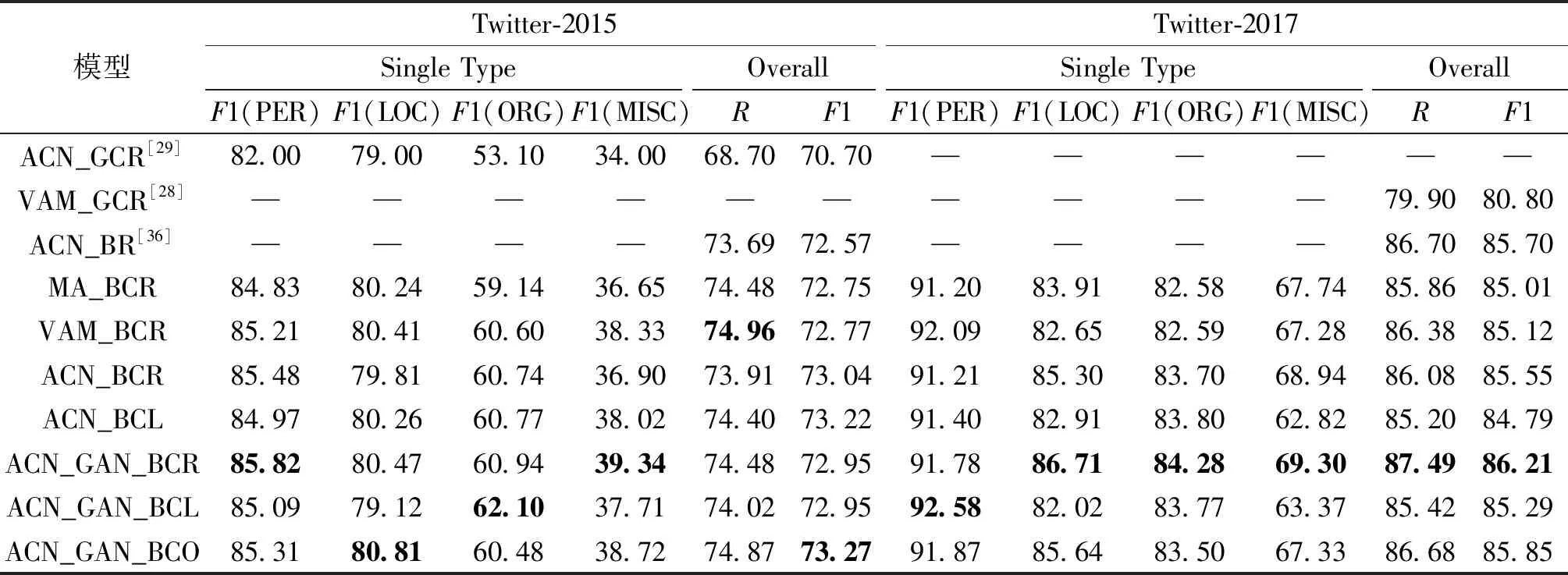

在Twitter 2015和Twitter 2017数据集上进行实验,使用评估指标[56]如召回率R和F1值对MNER方法的有效性进行对比分析。本文选择Lu等[28]、Zhang等[29]和Chen等[36]提出的基线模型,前融合模型选取MA和VAM模型,后融合模型选取增加字符表示的ACN模型,以及在ACN模型上融合其他方法的模型,即使用视觉区域特征的ACN_BCR和使用视觉对象标签的ACN_BCL模型,融入对抗学习[30]但分别使用区域特征、视觉对象特征、视觉对象标签的ACN_GAN_BCR、ACN_GAN_BCL、ACN_GAN_BCO等模型。实验结果如表2所示,表中PER、LOC、ORG、MISC分别代表数据集中的人名、地名、组织名和杂项等4类实体。

表2 基于BiLSTM的MNER方法对比分析

相比使用Glove的文本表示,使用BERT使文本表示具有更完备的实体语义表示,因为BERT具备语言模型的背景知识。如在表2中VAM_GCR[28]、ACN_GCR[29]与ACN_BCR、VAM_BCR的实验对比中,后两者明显取得显著的优势。在Twitter-2017数据集中,VAM_BCR方法较VAM_GCR[28]方法R、F1值分别高出6.48百分点、4.32百分点,ACN_BCR的5项指标均高于ACN_GCR[29]方法。

将字符表示和单词表示进行拼接,通过补全单词表示中缺失的语义,以增强单词表示,进而得到更加准确的预测标签。ACN_BCR与ACN_BR[36]相比,在Twitter-2015数据集中R和F1值分别高出0.22百分点和0.47百分点,结果表明,使用文本模态内多特征协同表达,可以解决现有的文本表征模型存在语义缺失的问题。

由前融合模型MA、VAM与后融合模型ACN_BCR的对比中可以发现,在2个数据集中,ACN_BCR的12个指标均高于MA方法,10个指标均高于VAM方法。这表明使用BiLSTM融合单词表示和字符表示,使得文本表示具有更高的实体语义,能得到更好的多模态表示。

使用对抗学习实现2个表征空间的统一是有效的。对比ACN_GAN方法和ACN方法,11个最先进的性能指标出现在ACN_GAN方法,2个数据集中最高的F1值分别为ACN_GAN_BCO和ACN_GAN_BCR方法。这是因为对抗学习能使得文本表示和区域视觉特征的语义分布相似,从而更准确地融合,得到更高质量的多模态表示。

3 基于Transformer的MNER方法

基于Transformer的MNER方法使用Transfor-mer模型和CRF作为基础模块,并使用BERT编码文本以缩小图文特征实体语义之间的差距。为解决视觉偏差的问题,利用多任务协同学习引导图像和文本特征深度融合,本文根据任务结构,划分为Transformer单任务模型和Transformer多任务模型,并对经典方法进行实验验证和方法分析。

3.1 Transformer单任务模型

Transformer单任务模型使用BERT进一步缩小文本与图像特征的语义差距,其处理流程是获得各模态的输入表示后采用多模态融合技术重新编码所有的模态输入表示,以获得多模态表示,最后通过CRF模型得到最终标签,具体框架如图4所示。Transformer单任务模型的核心是多模态融合技术,本小节将介绍所涉及的3种多模态融合技术路线。

图4 Transformer单任务模型

(1)图文联合编码。如Asgari-chenaghlu等[55]调用Transformer联合编码文本S和图像分类标签Vl,将输出特征的文本部分作为多模态表示M,可表示为

[M,V′]=BERT([S;Vl])。

(25)

(2)感知表示融合技术。如Zhang等[31]将文本单词特征Xb=BERT(S)和视觉对象Vr视作节点,分别使用模态内边连接模态内特征,使用模态间边连接模态间特征,构成无向图G。然后堆叠n个基于图的跨模态注意力模型对G进行编码,以实现特征融合,得到多模态表示M。

G=Graph(Xb,Vr);

(26)

[M,V″]=cross-attention(Xb,Vr)。

(27)

式中:Graph()为将单词特征和视觉对象构建为无向图的函数;cross-attention()为跨模态注意力机制,分别输出多模态表示M和多模态视觉表示V″。

钟维幸等[37]使用ALBERT分别对文本S和图像描述L进行编码,再使用由3个自注意力模型、4个跨模态注意力模型组成的多模态融合模块来计算多模态表示M。

(3)多模态语义对齐技术。如Xu等[32]通过跨模态注意力模型先将文本特征和视觉对象对齐,得到匹配表示,再使用多模态注意力模型融合文本特征和视觉对象得到多模态表示。Liu等[57]构建了多层次的对齐来捕获文本和图像之间由粗粒度到细粒度的交互,并通过计算文本和图像的相关性在不同语义层次上执行跨模态交互来增强文本表示,最终得到多模态表示。

3.2 Transformer多任务模型

在单任务MNER模型的基础上,扩展了文本模态任务或其他辅助任务,以解决视觉偏差问题。Transformer多任务模型的核心是多模态融合技术和多任务融合模块,框架如图5所示。

图5 Transformer多任务模型

多模态融合技术通常使用Transformer融合模态输入表示,得到多模态表示M。包含以下融合技术路线。

(1)感知表示融合技术。Yu等[33]提出由Transformer模型对文本进行处理,多头跨模态注意力机制(multi-head cross-modal attention,MHCA)融合图文特征,得到多模态表示M,计算如下:

M=MHCA(Transformer(BERT(S)),Vr)。

(28)

式中:S为输入文本;Vr为区域视觉特征。

Liu等[39]提出由2个Transformer模型分别对文本和视觉进行处理,然后使用多头跨模态注意力模型融合计算多模态表示M,计算如下:

M=MHCA(Transformer(BERT(S)),

Transformer(Vr))。

(29)

Zhang等[58]基于BERT文本token和SwinT视觉token构造了多模态图,使用对比学习实现文本节点和视觉节点之间的全局对齐和局部对齐,之后堆叠n个跨模态注意力模型进行特征融合,得到多模态表示。

(2)图文联合编码。如Wang等[34]提出将图像描述Vcap、视觉对象Vl和文本S进行拼接,使用BERT进行编码得到多模态文本表示M,计算如下:

[M,Vlcap]=BERT([S;Vl;Vcap])。

(30)

(31)

式中:i=1,2,…,12为Transformer编码层编号;Ti为第i层的编码输出,T1为输入的文本编码。Transformer编码层的自注意力机制(self-Attention,SA)计算原理表示为

(32)

式中:Qi、Ki、Vi均为Ti的投影向量。

多任务融合层通过联合优化模型参数,进而提升实体识别性能,主要包含多模态命名实体识别主任务结合文本模态任务或辅助任务的结构。多模态命名实体识别主任务是基于多模态表示的命名实体识别任务。文本模态任务是基于文本模态的解码任务,如Yu等[33]利用基于文本的实体跨度检测辅助预测;Wang等[34]对齐多模态视图和文本视图的输出分布预测;Liu等[39]通过不确定性判断使用文本候选标签或者多模态候选标签。

辅助任务能解决多模态表示过度融合视觉特征导致的偏差问题。如李晓腾等[40]所使用的对比学习、实体聚类辅助任务、边界检测任务;Chen等[41]的关系抽取任务能优化多模态表示;Zhang等[58]的多重对比学习任务能学习文本和图像表示的全局和局部一致性,从而过滤了语义不匹配或不相关的图文特征;Xu等[59]提出数据鉴别器任务,将数据分给文本模态命名实体识别任务或多模态命名实体识别任务,获得最优的预测序列;Zhang等[60]提出的硬样本挖掘策略,能优化文本和视觉特征对齐,缓减视觉对象的数量和类型所造成的偏差;Wang等[61]提出的聚合命名实体分类任务和命名实体分割任务聚合视觉特征中的实体语义。

3.3 方法分析

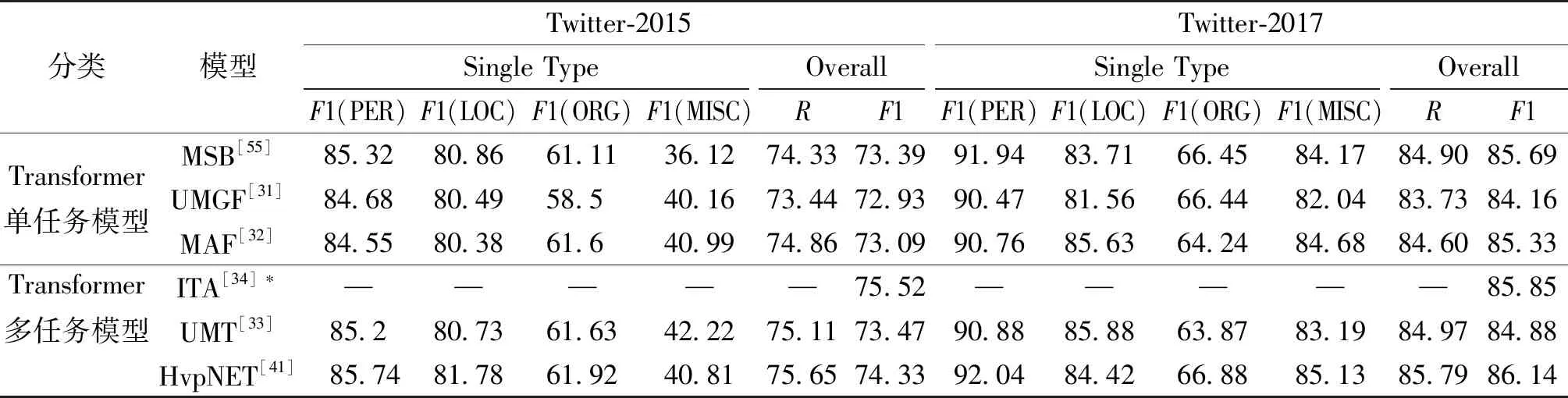

在Twitter-2015和Twitter-2017 2个多模态数据集上进行了实验,这2个数据集分别由Lu等[28]和Zhang等[29]提出,将每个数据集分割为训练数据集(Train)、验证数据集(Dev)、测试数据集(Test),分别统计数据集中的人名(PER)、地名(LOC)、组织名(ORG)、杂项(MISC)等4类实体的数量,统计数据如表3所示。

表3 2个Twitter的多模态数据集的统计数量

通过评价指标R和F1值对基于Transformer的MNER模型的有效性进行对比分析。选取Transformer单任务模型中MSB[55]、UMGF[31]和MAF[32]模型,Transformer多任务模型中UMT[33、ITA[34]和HvpNET[41]模型进行复现。在实验复现过程中,为了在同样的实验环境中运行,HvpNET批次大小降低为8,性能有所下降。具体实验结果如表4所示。

表4 基于Transformer的MNER方法对比分析

如表2和表4所示,在2个数据集中基于Transformer的方法整体优于基于BiLSTM的方法。这是因为Transformer的MNER方法使用BERT改进了文本表示,和Transformer融合模块具有同步挖掘上下文信息和融合多模态特征的能力,而基于BiLSTM的MNER方法是分阶段实现这2个功能的。如在Twitter-2015数据集中,基于BiLSTM方法的F1值最高值要低于基于Transformer方法的最低值,在Twitter-2017数据集中,相较VAM[28]、ACN[29]及ACN[36],基于Transformer方法的性能更好。

对ACN[36]进行改进,即通过融合字符表示或增加对抗学习任务,进一步补全文本语义以优化多模态表征后,ACN-GAN方法和MSB方法的性能相近。这表明使用BERT来表示文本语义仍然有缺失,而通过辅助任务可以促进多模态特征间的语义聚合,从而获得更好的多模态特征。

Transformer多任务模型通过任务间的共享学习和损失均衡,有效增强多模态表示通用性,同时也避免了多模态表示陷入局部最优值。由表4可以看出,在2个数据集上,Transformer多任务模型的各项指标均高于单任务模型,验证了多任务协同模型在多模态命名实体识别领域的优势。

视觉模态多特征协同对MNER具有重要作用。HvpNET协同使用层次视觉特征和对象级视觉特征作为文本的前缀特征,而UMT、UMGF、MAF仅使用区域视觉特征。在表4中可以发现,HvpNET方法的整体指标显著高于这3个方法。此外,使用视觉对象标签和图像标题的ITA方法,相比仅使用视觉对象标签的MSB方法,在2个数据集上的F1值分别高出2.13百分点、0.16百分点。这是因为2种视觉特征协同表示可以得到更全面的视觉语义。

进一步可以发现,相较于对象级视觉特征,使用自然语言对图像进行描述,图文语义能够更充分融合,如表4中,MSB的模型参数远小于UMT,却获得更好的性能。

3.4 模型的复杂度分析

模型参数量、单轮训练时间及单轮验证时间是衡量模型可用性的重要指标,对各模型进行统计,如表5所示。可以发现基于Transformer的MNER模型的参数量高于基于BiLSTM的MNER模型,综合F1值来看,模型参数量不是决定模型F1值的核心因素。Transformer多任务模型的训练时间与单任务模型的训练时间相当,但Transformer多任务模型的性能有较大提升。

表5 不同模型的参数量、训练时间和验证时间对比

4 结束语

本文先对MNER任务的定义、难点及方法进行了简要介绍,然后总结了MNER方法框架,分别介绍框架中各部分的常用技术及其优缺点。接着对近年来MNER的方法进行梳理和分类,将其总结为2类方法和4种模型结构。为了评估基于BiLSTM的MNER方法,将其总结为前融合模型和后融合模型结构,在Twitter-2015、Twitter-2017数据集对2种模型结构中7种方法进行实验,分析如下:前融合模型是最早的MNER模型结构,该类模型在命名实体识别模型中添加视觉模态,并以简单、直接的方式实现多模态融合,其性能优于命名实体识别模型。后融合模型是前融合模型的改进,它初步解决了文本语义和图像语义不匹配的问题。笔者在后融合模型ACN的基础上进行拓展,解决现有文本表示方法中存在语义缺失问题,使用多特征协同表达,补全文本语义,性能进一步提升。

为了评估Transformer的MNER方法,将其总结为Transformer单任务模型、Transformer多任务模型,在Twitter-2015、Twitter-2017数据集对Transformer单任务模型、Transformer多任务模型中6种典型方法进行实验,分析如下:单任务模型使用BERT作为文本表示,利用Transformer实现多模态特征的深度融合,但存在视觉偏差问题,为此,通过利用文本表示或优化多模态表示的方法,将单任务模型扩展为多任务模型,其中包含2种多任务结构,即联合命名实体识别任务解决视觉偏差问题或聚合辅助任务增强多模态表示的通用性。

5 展望

本文对4类模型进行分析后,从以下3个方面指出了MNER未来的发展方向。

(1)多特征协同表达的重要性。模态内多特征协同表达能解决特征语义的问题,从而获得更加准确和全面的模态信息描述。

(2)多模态表征空间统一的重要性。当多模态特征空间统一,能解决融合特征时实体语义不匹配的问题。其中可以采用调用Transformer层对多模态表示重新编码,实现表征空间的统一和使用辅助任务优化特征投影,在投影空间中实现语义对齐。

(3)多任务学习的重要性。多任务模型与命名实体识别任务的结合是必要的,具体可以尝试以下几种研究思路:第一,使用多任务优化模态特征以利于编码、融合或对齐;第二,通过多任务协同学习通用的多模态表征,进而提升MNER性能;第三,结合迁移学习解决中文数据标注困难的问题,将多模态命名实体模型引入中文文本命名实体识别研究。