基于多任务联合注意力的结肠息肉分割网络

2024-02-29郭祥振李思潼卢锐郭森崔学荣杨钢

郭祥振,李思潼,卢锐,郭森,崔学荣,杨钢

(1.东北大学信息科学与工程学院,辽宁 沈阳 110819;2.东北大学冶金学院,辽宁 沈阳 110819)

0 引言

结直肠癌(CRC)是消化系统中最常见的恶性肿瘤,位居城市居民肿瘤发病率的第2 位,病死率的第4 位,并且其发病率和死亡率逐年上升,甚至在最近几年内呈现年轻化的趋势。根据国家癌症中心统计数据显示,我国每年约有超过100 万的新增病例以及60 万的死亡病例,结直肠癌新发人数占所有新发恶性肿瘤的9.9%[1]。

绝大多数结直肠癌都由肠道息肉发展而来,而肠道息肉检查的最有效方法为肠镜检查,医生通过肠镜可以直观地看到肠道内部,寻找病变区域,并将其直接切除,使其不再进一步恶化癌变。许多研究结果表明,早期肠镜检查能使结直肠癌发病率下降30%[2]。然而,由于息肉自身特点以及各种人为主客观因素的存在,仍然会存在漏检、误检的现象[3],因此设计高性能的息肉分割系统作为辅助诊断工具具有重大意义。

基于传统算法的息肉检测依赖于手工提取息肉的纹理[4]、颜色和边界[5]等特征,并将这些特征组合后进行建模,用于训练生成分类器来辨别息肉和周围组织。但是手工设计的特征是借助视觉系统中的敏感区域来提取能够与肠壁区分的特征,其准确性在很大程度上取决于科学家的经验与专业水准。MAMONOV 等[5]提出一种二分类策略分离息肉与非息肉组织。该方法从肠镜每帧图像中提取息肉纹理和几何信息,并且借助中通滤波对图像进行几何分析,使用最佳拟合球形半径作为分类器的决策参数。BERNAL 等[6]提出使用分水岭算法对息肉进行检测,该算法利用矩阵分析法计算得到息肉区域基于梯度图像的特征值和特征向量,根据这些信息将图片中每个区域分成息肉类和非息肉类,进而将息肉分割出来。SASMAL 等[7]提出采用主成分追踪法(PCP)和活动轮廓(AC)模型对息肉进行检测分割。上述这些方法提取出的息肉特征无法有效将背景特征与息肉特征进行区分。因此,在分割结果上也存在较明显的局限,误检率、漏检率仍然较高。

近年来,利用深度学习方法进行的医学图像分割[8]和语义分割任务[9-10]取得了巨大突破,这些方法与传统方法相比能提取出更加丰富的息肉组织细节和语义特征,提高息肉检测效果。LONG 等[11]提出的全卷积网络(FCN)与RONNEBERGER 等[12]提出的U-Net 网络在息肉检测任务中有着较广泛的应用。文献[13]介绍基于FCN 思路的SegNet 网络的特点是在进行图片下采样时使用最大索引的方法,并且借助该索引在上采样过程中实现非线性特征,保留细节信息并与语义信息相结合以提升检测目标边缘细节分割的能力。ZHOU 等[14]借鉴DenseNet 的稠密连接方式将U-Net 各个层连接起来,使前后每个模块之间产生相互作用,并表现出良好的效果。JHA 等[15]提出ResUNet++网络,是一种结合残差连接和U-Net 的网络,不仅能更有效地解决梯度消失问题还能解决语义信息缺失问题,从而提高分割准确率。目前的针对性设计主要依赖于卷积神经网络,但卷积神经网络的感受野十分有限,不能从全局范围内探索特征关系,因此无法提供完整的对象区域预测。

此外,很多研究人员在骨干网络和相应模块中引入特征提取和聚合的方法。FAN 等[16]提出的PraNet 网络,通过多尺度融合模块将高级别特征相融合,根据这个组合特征生成全局引导图,作为下1 个部分的初始引导区域,然后利用反向注意力模块逐层向前挖掘边缘线索信息以细化息肉边界[17]。WEI等[18]提出SANet,针对息肉颜色分布差异大、尺寸小的特点进行网络设计,该方法选择高级特征进行融合,最高层的卷积特征经过卷积过滤噪声干扰,将生成的注意力逐像素相乘到上一层特征中,最终将不同层的特征拼接起来作为结果输出。DONG 等[19]提出Polyp-PVT 网络,充分利用卷积的局部感受野和平移不变性,以及Transformer[20]的全局注意力机制,对图像进行全局的语义建模和特征交互。这些方法存在2 个主要问 题:1)Transformer 的局部特征建模较差,Transformer 模型的不足之处是缺乏对模型输出特征中上下文信息的充分利用;2)基于Transformer 的解码器通常对具有显著性差异的特征感兴趣,从而忽略一些不易被发现有价值的特征。

针对上述方法的不足,本文提出一种基于多任务联合注意力的结肠息肉分割网络CPMJA-Net。设计级联融合模块(CFM)和联合注意力模块(JAM),能够有效解决局部区域内部信息交换缺乏的问题,构建一种多任务注意力模块(MAM),该模块采用渐进式的融合策略将3 个并行注意力模块的输出进行融合,充分学习图像中前景和背景之间的差异,进而准确预测息肉区域。

1 研究方法

1.1 方法概述

本文提出的CPMJA-Net 框架遵循编码器-解码器结构,在编码器阶段利用PVT 网络[21]获得具有全局依赖关系的多尺度特征,其中有4 层输出。CPMJA-Net 网络结构如图1 所示。本文将第1 层输出视为低级特征,第2 层输出视为中级特征,后2 层输出视为高级特征。通过将低级特征和中级特征送入级联融合模块,充分探索局部区域之间的关系,增强局部细节特征表示。中级特征和高级特征经过聚合送入多任务注意力模块,从多个方面探索息肉目标和背景之间的关系,使网络关注息肉目标。最后将两者的输出经过交互式融合得到输出结果。

使用PVT 网络作为backbone,提取输入息肉RGB 图片的多层次特征,? 视为低级特征,视为中级特征,与视为高级特征,将这些特征分别送入编码器中的不同模块中。

多任务注意力模块的设计与每层的输出相对应。首先高级特征与中级特征先进行特征融合,然后使每层对应的融合分支送入多任务注意力模块。在该模块中使用3 个注意力模块分别计算前景、背景和整体注意力,以有效提高对息肉区域的识别能力。

联合注意力模块的设计结合深度学习的交互式注意力和残差连接的思想。根据这种结合,JAM 模块可以同时接收低级细节特征和高级预测特征,从而能够更充分捕捉图像的全局和局部信息。在具体实现上,交互式注意力机制采用Self-Attention 的思想,通过计算注意力图来加权融合低级和高级特征,从而得到更具代表性的融合特征,然后采用卷积操作提取特征间的相关性,以便挖掘息肉区域的全局语义特征和线索,同时也能够捕捉局部像素之间的联系,最后通过残差连接输出结果。经过这些操作可以进一步挖掘息肉区域的全局语义和局部像素之间的联系。

1.2 级联融合模块

低级特征中包含的细节信息对网络分割精度的提升至关重要,全局上下文和局部特征在息肉检测任务中都发挥着重要的作用。然而大多数基于Transformer 的方法存在1 个共同的问题,即:缺乏机制来增强局部区域信息的交换。

中层输出特征有助于低层输出特征细节信息的提取,将中层输出特征与低层输出特征进行交互融合,使网络探索局部区域特征之间的关系。为实现2 个分支信息的传递和共享,有效促进不同尺度信息之间的互相协助,本文构建级联融合模块,使低级特征和中级特征的内部特征进行交互和探索,以及补偿Transformer 的局部建模能力。

级联融合模块由2 个并行分支组成,分别处理来自特征提取网络前2 层的输出,同时在输入阶段将这2 个分支进行交互融合,使特征中每个对应区域的局部像素进行融合,以增强局部特征表示,然后将这个融合特征分别在两者内部进行加权融合。具体而言,级联融合模块分别接收来自编码器前2 层的输出,记为f1和f2,调整尺寸使f1与f2相同,并将两者进行归一化,然后对每个输入分别使用2 个线性映射得 到2 个降维 后的特 征映射f(v,1),f(k,1)和f(v,2),f(k,2),如式(1)所示:

级联融合模块结构如图2 所示。

将2 层输出进行特征融合,经过卷积改变维度,再次经过线性映射得到继承2 个输出特征的向量fq,该向量后续分别与2 个输入特征交互,以达到局部特征增强的作用,其中对于2 个特征的操作为并行操作。对于每个分支首先将fq经过Softmax 函数生成权重矩阵,然后使用主元素相乘方法将与fq进行相乘,得到每个元素都被加权之后的特征向量,最后对特征向量进行平均池化操作,降低图像尺寸。其过程表达式如式(2)所示:

将加权之后的特征和fk进行矩阵相乘,探索2种特征之间的相关性,使用Softmax 函数生成注意力图Ta,此时的注意力图成为2 层特征的交互注意力。该步骤的计算式如式(3)所示:

之后将2 个并行分支中的Ta分别与fv进行交互相乘,使每个分支都能关注到对方的特征,实现特征互补,从而达到过滤冗余特征、关注细节特征的目的。使用残差连接将增强特征与原始特征相结合,以保留原始信息。该过程的表达式如式(4)所示:

最后将2 个并行分支进行Concat 拼接,再利用卷积操作调整尺寸,如式(5)所示:

1.3 多任务注意力模块

注意力机制通过对每个像素分配不同的注意力权重,使网络更加关注权重高的像素。由于息肉的自身特性和内窥镜头的拍摄角度使得其局部特征分布具有极强的随机性,因此要求网络对输入图像的不同区域分配不同的权重。在大多数的研究中注意力权重是通过掩码来形成的,主要思想是通过计算得出1 层拥有注意力权重的矩阵或者向量,再与输入图像的通道或者区域进行相乘来突出重要信息或者抑制干扰和无关信息。

将Self-Attention 机制引入网络中,增强像素的类内一致性,使关键信息得以凸显,干扰信息得以抑制。另外,受多头Self-Attention 机制[23]的启发,本文将注意力模块分为3 个部分,分别使用不同的掩码策略将息肉图像的前景和背景区域区分,并输入到3 个部分中完成不同的注意力任务。多任务注意力模块结构如图3 所示,

图3 多任务注意力模块结构Fig.3 Structure of multi-task attention module

1.3.1 前景注意力单元

该单元的任务是在输入特征图中挖掘前景区域的相关性,使网络学习前景内部之间的关系,避免内部噪声影响网络分割效果。该单元遵循Self-Attention的原理,如式(6)所示:

其中:AAT表示注意力机制;Q,K,V分别表示使用3 个不同的1×1 和3×3 卷积生成的query,key 和value向量;α是1 个可学习参数。

在前景注意力单元(FAT)中,将每个级别特征输出的息肉区域预测掩码图作为一部分输入引入到注意力AT 中,作为先验知识来调节生成的注意力矩阵,以更好地识别息肉区域。前景注意力单元结构如图4 所示。

图4 前景注意力单元结构Fig.4 Structure of foreground attention unit

其表达式如式(7)所示:

该单元接收来自某一层的语义特征图xinput∈RH×W×C和由该层特征图得到 的预测 掩码 图Mf∈RH×W×C,其中H、W为特征图的长和宽,C为通道数。首先通过对输入特征进行样本特征归一化,然后分别经过并行的3 个1×1 的卷积和3×3 的深度可分离卷积生成Q、K、V。此时将输入的掩码图Mf分别与Q和K进行逐像素相乘,用于提取预测的前景区域。将两者结果相乘再送入Softmax 生成基于前景的attention map。最后将其与V矩阵相乘得到基于前景注意力的加权特征图。

1.3.2 背景注意力单元

背景注意力单元(BAT)采用与前景注意力单元相同的结构,在该单元中同样接收某一层的语义特征图xinput∈RH×W×C和由该层特征图得到的预测掩码图Mb∈RH×W×C,与前景注意力单元不同的是掩码图换成了Mb,这是因为该单元的注意力机制在背景区域进行注意力建模,需要引入背景掩码图。因此,背景掩码图的获取采用1-Mf的形式以达到反转的效果,经过同样的处理,以得到基于背景注意力单元的加权特征图。BAT(计算中用BBAT)的表达式如式(8)所示:

此外,该注意力模块的第3 个单元为常规注意力机制,接收某一层的特征图,目的是从全局范围内计算出前景与背景间的关联性,如式(9)所示:

1.3.3 特征融合方法

在网络设计中,本文在每层输出特征之后都加入多任务注意力模块。为充分利用不同特征信息,采用渐进式融合的方式逐步将不同的特征图进行融合,以有效捕捉多个特征图中的不同特征,最后输出1 个息肉区域预测特征图。假设特征提取网络的后3 层输出为fi(i=2,3,4),首先将f2,f3,f4经过特征整合单元生成粗略的区域预测图D5,将该预测图经过尺寸调整和Sigmoid 函数生成掩码图P5,作为第1 个多任务注意力模块的掩码输入,然后将f4经过卷积调整维度,作为第1 个特征图输入。将这2 个输入经过第1 个多任务注意力模块生成1 个联合前景注意力、背景注意力和全局注意力的特征图D4,其过程如式(10)所示:

其中:MMTA(*)为多任务注意力模块。在该模块中掩码图P5输入到前景注意力单元中,将1-P5输入到背景注意力单元中。

将第1 个多任务注意力模块的输出D4经过上采样调节尺寸使其与f3相同,经过Sigmoid 函数生成掩码图P4,作为第2 部分的掩码图输入,同时将f4经过上采样调整尺寸、卷积提取特征后与f3进行逐像素相乘得到。将与f4拼接,经过卷积调整维度后与D4进行逐元素相乘,再与D4相加作为第2 部分的输入特征。这种融合方式可以增强局部特征的表示,其过程如式(11)所示:

其中:upsample(*)为上采样操作;⊙为哈达玛乘积,即矩阵逐元素相乘。

第3 部分以相同的方法处理D3,同时将f4与f3分别进行上采样并调整为与f2尺寸相同,再分别经过卷积与f2进行逐像素相乘得到,再将与上一部分Concat 后的特征相拼接,最后用同样的方法与D3进行融合作为多任务注意力模块最后部分的特征输入。该过程如式(12)所示:

1.4 联合注意力模块

为解决早期卷积神经网络(CNN)模型在目标检测任务中忽视了低层特征的问题,研究人员设计特征金字塔网络(FPN)[24]结构。该结构通过逐层融合低层特征,将顶层特征恢复到原图大小的过程中,补充细节信息,提高目标检测的预测效果。然而,FPN在进行不同层次特征融合时只采用简单的求和或者拼接策略,无法充分实现高低层信息互补,而且还有可能引入干扰噪声。

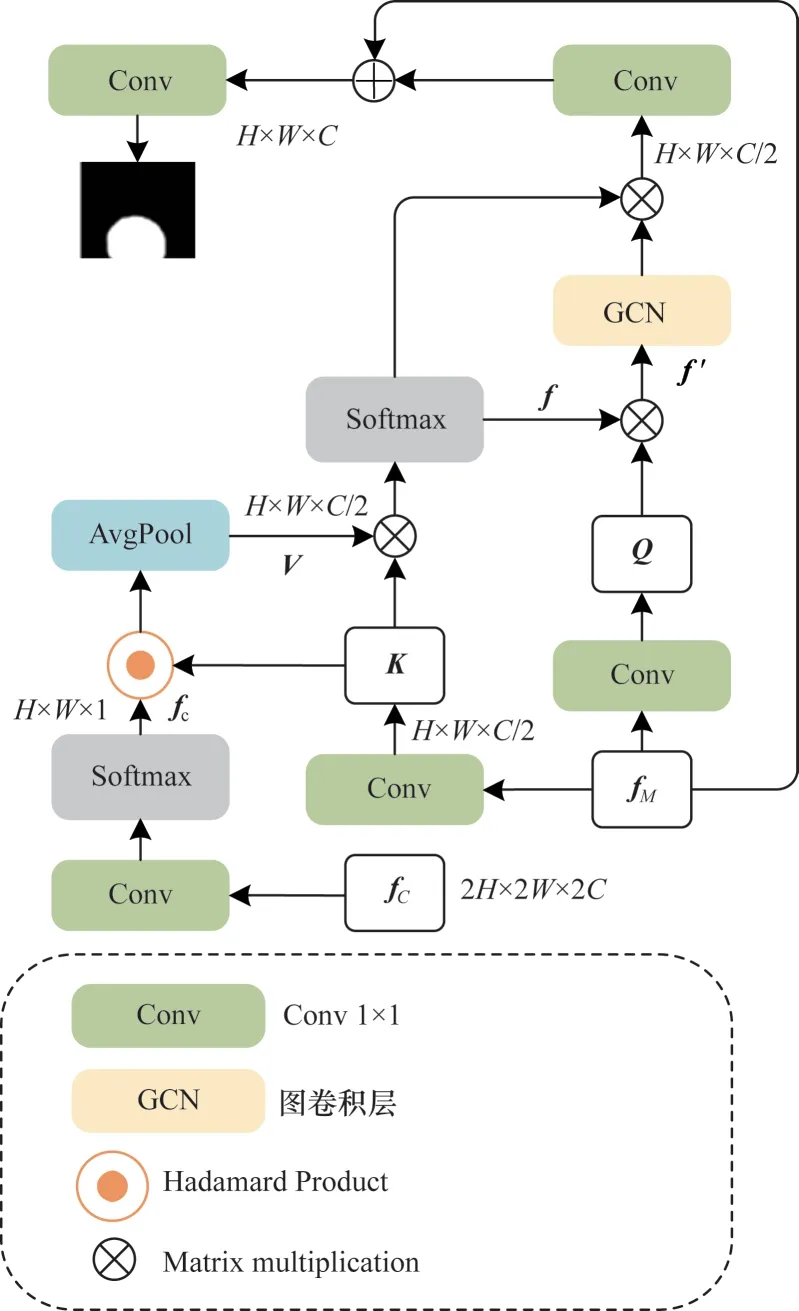

因此,本文提出一种联合注意力机制,该机制利用高级特征的轮廓信息在低级特征中筛选出有利于边缘分割的细节特征,并将其与息肉轮廓聚合起来,得到更加精确的边缘分割结果。联合注意力模块结构如图5 所示,分别将多任务注意力模块输出特征fM∈RH/8,W/8,C1和级联融合模块输出特征fC∈RH/4×W/4×C2作为输入。

图5 联合注意力模块结构Fig.5 Structure of joint attention module

首先将fC进行上采样操作,使其与fM尺寸相同,再将其经过1×1 的卷积来调整维度,使其与fM的通道数相等,同时减少网络计算量;然后将fC在通道维度上做Softmax,并且选择第1 个通道作为注意力的映射,此时∈RH/8×W/8×1。该过程如式(13)所示:

其中:interpolate 表示双线性插值法对图像进行上采样。

对于另外1 个输入特征fM具有更高级的语义特征,首先将fM经过2 个映射进行降维操作,分别得到映射特征Q∈R(H/8×W/8×16)和K∈R(H/8×W/8×16),其映射操作分别为2 个1×1 的卷积,如式(14)所示:

将K和进行对应元素相乘,然后对其使用平均池化操作提取特征的平移不变性,使模型对于输入图像的微小平移具有一定的容忍度,此时得到了特征映射V,V中具有突出的息肉边界信息。其过程如式(15)所示:

将K和V进行矩阵相乘,将相乘结果经过Softmax 建立K与V之间每个像素的相关性,从而获得相关性注意力图f。将f与Q相乘得到Q',此时Q'中每个元素与f之间建立相关性,给息肉边界区域分配更高的权重。将Q'经过图卷积层,从特征图中每个节点的状态和节点之间的关系中提取特征,并计算其关系矩阵,更新节点状态,以提高模型的表征能力。这部分的表达式如式(16)所示:

其中:⊗为矩阵相乘;GCN(*)为图卷积层。

再利用f和f'相乘,输出结果与该节点的原始特征相结合,以保留节点的原始特征信息。之后将其通过1×1 的卷积层将重构的特征图调整为原来的维度,再利用残差连接将重构特征与原始输入特征fM相加达到细化边缘分割结果的目的,最后再经过1×1的卷积调整为1 维,输出息肉检测结果。该过程的表达式如式(17)所示:

经过联合注意力模块可以有效地聚合高级特征和低级特征,将它们以交叉的方式将自己的特征加入到对方的Token 中,并计算注意力图。将每个注意力图与对方的特征序列相乘,使得两者特征中都包含对方的特征,从而建立两者之间的相关性,实现相邻2 层间的局部信息交换,丰富输出特征的局部表达。将网络的关注度聚焦到息肉边界上,同时利用低级特征中的详细信息来加强边缘的分割。

2 实验与结果分析

2.1 实验数据集与实验细节

本文在4 个开源数据集上对算法模型进行验证,包 括ETIS-LaribPolypDB[25]、CVC-ColonDB[26]、CVC-ClinicDB[27]和Kvasir[28]。数据集遵循PraNet 中的划分方法,其中训练集来自Kvasir 和CVCClinicDB,分别从中随机抽取900 张和550 张样本,共1 450 张样本。测试集选取ETIS-LaribPolypDB、CVC-ColonDB 中的全部样本、Kvasir 和CVCClinicDB 中剩下的样本,共有798 张样本。将图像尺寸调整为352×352 像素,并采用随机旋转和随机垂直翻转的方法扩充训练数据。

在PyTorch 深度学习框架下进行网络搭建、训练和测试,电脑显卡为一块NVIDIA GTX 1080Ti GPU。本文选用广泛用于Transformer 网络的AdamW 优化器来更新权重,设置初始学习率为1×10-4,学习率更新策略采用Poly 策略,总共训练100 个epoch,batch_size 设置为4。

2.2 损失函数

本文使用二元交叉熵(BCE)损失和交并比(IoU)损失相结合的方法来训练模型。其中,交叉熵损失反映像素级别的损失,它对预测图上的每个位置独立求取损失值,并将这些损失进行求和后取均值,如式(18)所示:

其中:H和W分别表示标签图的长度和宽度;S表示息肉预测图的概率分布;G表示息肉真实标签0或者1。

IoU 损失函数是在目标检测任务中常见的损失函数,通过计算预测框与实际标注框之间的重叠区域面积来评估预测框的准确性,可以度量2 个集合之间的相似性。IoU 损失函数是基于IoU 指标设计的,其表达式如式(19)所示:

其中:分子部分计算的是预测分割结果和真实分割结果的交集;分母部分计算的是预测分割结果和真实分割结果的并集。

为了使损失函数更适合本文任务,在设计损失函数时采用加权的方式,使整个模型计算的损失函数更加偏向于息肉边缘部分。加权方法是选取某个像素15 邻域的像素取平均值,然后再用这个平均值与该像素作差,计算该点像素与周围像素之间的差异。该权重表达式如式(20)所示:

其中:AvgPool(*)为31×31 的平均池化;mask 为息肉真实分割结果。

经过加权,最终的损失函数计算式如式(21)所示:

2.3 评价指标

本文采用在息肉检测领域中5 种最常见的评价指标对算法进行评估,包括mDice(计算中用mmDice)系数、平均交并比(mIoU,计算中用mmIoU)、平均绝对误 差(MAE,计算中 用MMAE)、F-measure 值[29]、S-measure 值[30],其计算式如下:

其中:X和Y表示2 个集合,分别代表息肉预测图和真实标签图;n表示数据点数量;Yi表示第i个数据点的实际值;Xi表示第i个数据点的预测值;参数β2的取值为0.5;参数α用于权衡2 种度量的比例;SO和Sr为平衡系数。

2.4 消融实验分析

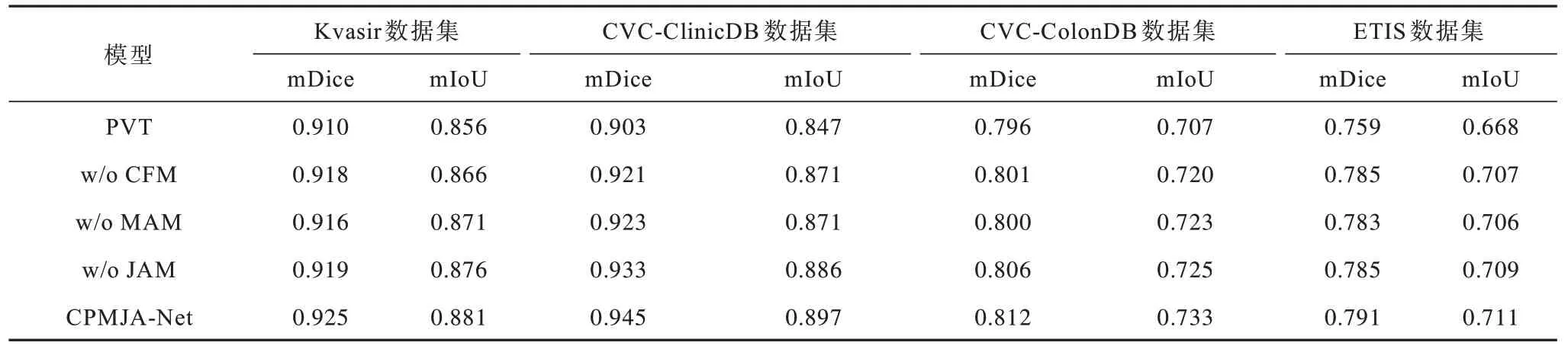

为验证级联融合模块(CFM)、多任务注意力模块(MAM)和联合注意力模块(JAM)的有效性,本文进行消融实验。本文实验以PVT 网络作为基线,在此基础上添加或减去各模块进行实验对比。每个模块的使用情况用w/o 来表示,即不加入某模块时模型的性能。各模块消融实验结果如表1所示。

表1 各模块消融实验结果 Table 1 Ablation experimental results of each module

从表1 可以看出各个模块对提升模型性能的贡献,PVT 在各个数据集中的指标较差,加入其他模块后性能有所提高,CPMJA-Net将所有模块都加入模型中,性能达到最优。当网络移除CFM 后,w/o CFM网络在4 个数据集中的表现都有所下降,相比CPMJA-Net,mDice 系数分 别下降0.7、2.4、1.1 和0.6 个百分点。移除MAM 模块后网络性能都出现下降情况,相比CPMJA-Net,在所有数据集中的mDice和mIoU 最多下降为2.2 和2.6 个百分点。去除JAM后网络的各项指标与CPMJA-Net 相比所有指标均有明显下降。

2.5 比较实验分析

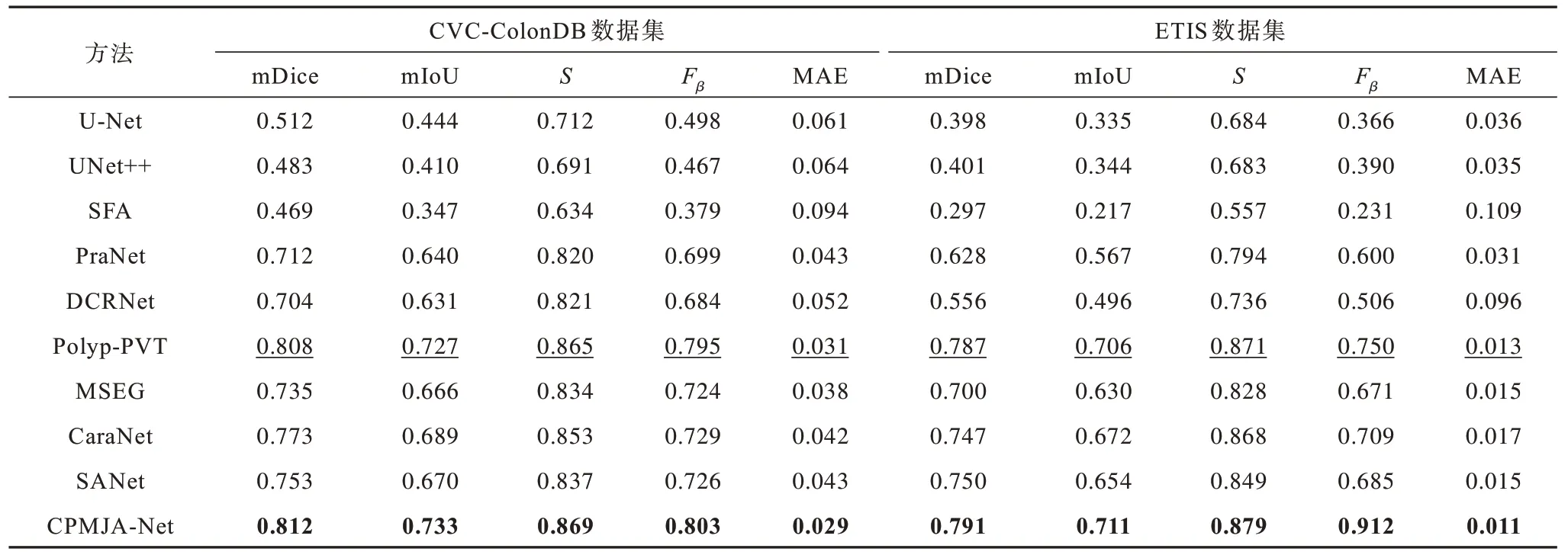

本文将CPMJA-Net 和U-Net[12]、UNet++[14]、SFA[31]、PraNet[16]、DCRNet[32]、MSEG[33]、CaraNet[34]、Polyp-PVT[19]和SANet[18]9 种肠道息肉检测算法进行对比。

2.5.1 定量比较

表2 和表3 所示为CPMJA-Net 模型与其他肠道息肉检测算法在4 个主流数据集上mDice 系数、mIoU、Fβ、S和MAE 等指标的对比,其中,加粗表示最优数据,下划线代表次优数据。从表2 和表3 可以看出,CPMJA-Net 在4 个数据集上性能都表现为最优,与每个数据及次优的算法相比,CPMJA-Net的mDice 系 数在Kvasir、CVC-ClinicDB、CVC-ColonDB和ETIS 数据集分别提升0.7、0.8、0.4、0.4 个百分点,mIoU 也分别提升1.6、1.2、0.6 和0.5 个百分点,MAE 值分别降低0.3、0、0.2 和0.2 个百分点。综合考虑所有数据集的上述5 个评价指标,本文算法性能优于其他算法。

表2 不同算法在Kvasir 和CVC-ClinicDB 数据集上的评价指标 Table 2 Evaluation indexes among different algorithms on Kvasir and CVC-ClinicDB datasets

表3 不同算法在CVC-ColonDB 和ETIS 数据集上的评价指标 Table 3 Evaluation indexes among different algorithms on CVC-ColonDB and ETIS datasets

2.5.2 定性比较

图6 所示为CPMJA-Net 与其他算法在不同场景肠道息肉下的分割结果。从图6 可以看出,CPMJA-Net 不仅可以准确识别息肉区域,而且能够保留相对细致的边缘轮廓。相比之下,其他算法的预测图像在前景和背景交界区域的像素存在模糊现象,无法显示出清晰的轮廓。在前景和背景比较相似的情况下,其他算法检测出的息肉区域不完整,而本文算法能将息肉完整地分割出来。此外,CPMJA-Net 也可以检测出小型息肉,说明对于小目标的检测也是适用的。综上所述,CPMJA-Net在肠道息肉分割方面具有较优的检测性能和鲁棒性,能够更准确地区分边界上的像素,并还原出更清晰的边缘。

图6 不同算法的预测结果图对比Fig.6 Comparison of prediction results images among different algorithms

通过上述比较可以看出,CPMJA-Net具有较优的分割性能,此前表现最好的Polyp-PVT,由于CAM 模块存在特征融合的局限性以及高阶特征和低阶特征明显的差异性,使得其仍然有提升的空间,而CPMJANet的CFM 和JAM 模块可以有效解决此问题。

3 结束语

本文提出一种新的息肉检测算法CPMJA-Net,解决过分割和注意力机制不足的问题,提升解码器的细节恢复能力,有助于获得边缘清晰的息肉检测结果。级联融合模块将低级特征和中级特征进行交互融合,探索两者特征之间的高阶关系,并通过残差连接保留丰富的细节信息和语义信息,增强基于Transformer 网络在对象分割任务中的局部特征表示能力。多任务注意力模块将注意力分为前景、背景和伪装区域,通过渐进式融合方式将不同特征图逐步进行融合,最后输出1 个息肉区域预测特征图,有效地捕捉多个特征图中的不同特征,降低模型复杂度,同时也可以减少噪音和冗余信息的干扰。联合注意力模块把高级特征和低级特征以交叉的方式进行融合,实现相邻2 层间的局部信息交换,丰富输出特征的局部表达。在4 个数据集上的实验结果表明,与U-Net、U-Net++、SFA 等网络相比,CPMJA-Net具有较优的鲁棒性和分割精度。下一步将对基于视频的息肉分割技术进行研究,以处理带有时间维度的动态医学影像,更准确地定位和描述息肉的形态、大小、位置等信息。