二阶逐层特征融合网络的图像超分辨重建

2024-01-30邓秋月郑丽颖吴昊宇

于 蕾, 邓秋月, 郑丽颖, 吴昊宇

(1. 哈尔滨工程大学信息与通信工程学院, 黑龙江 哈尔滨 150001;2. 哈尔滨工程大学计算机科学与技术学院, 黑龙江 哈尔滨 150001)

0 引 言

超分辨重建是一种重要的图像处理技术,旨在从低分辨率图像恢复出高分辨率图像[1-3],目前已被广泛应用于机器视觉的各个领域,例如视频监控[4]、遥感[5]、医学图像[6]等。由于退化方式的不同,从低分辨率图像能够重建出不同的高分辨率图像,这导致超分辨率重建是一个不确定的问题。为了解决这个问题,已有大量的方法被提出,大致分为:基于插值的方法、基于重构的方法和基于学习的方法。近年来,卷积神经网络(convolutional neural network, CNN)取得了显著的发展,其强大的特征学习能力非常适用于图像处理领域。大量的研究将CNN引入了超分辨领域,越来越多的超分辨网络被提出,并且取得了优异的表现[7-9]。

最初的超分辨模型往往由简单的CNN构建而成,表现为单一的线性结构,没有其他的连接结构以及多个分支。Dong等[10]提出的超分辨率卷积神经网络(super-resolution convolutional neural network, SRCNN),是第一个基于CNN的超分辨模型。SRCNN分为特征提取、非线性映射、重建3部分,其结构为超分辨网络提供了设计基线。SRCNN存在着一个缺陷,即模型需要将插值放大后的图像作为其输入,加大了网络的计算量,同时也放大了噪声。Dong等[11]又提出了快速SRCNN(fast SRCNN, FSRCNN)。与SRCNN不同的是,FSRCNN不需要对输入做任何处理,图像的放大过程通过反卷积层进行,实现了端到端的重建模式。FSRCNN不仅有效地降低了网络参数量,还提升了网络的训练速度。虽然FSRCNN利用反卷积层在网络的内部实现了图像的放大,但是反卷积层容易造成棋盘效应。后来,Shi等[12]提出了高效子像素CNN(efficient sub-pixel convolutional neural network, ESPCN)。ESPCN通过亚像素卷积实现图像的放大,亚像素卷积重建出的图像在视觉观感上更加贴近真实图像。亚像素卷积层也因此在超分辨重建网络中应用得更为广泛。

基于线性结构的超分辨模型,由于其简单的网络结构,不能实现复杂图像的重建。并且,网络层数的线性加深会导致网络难以收敛,从而阻碍了网络的表征能力。因此,非线性结构随即被提出。一系列基于跳跃连接、密集连接等结构的模型被提出,使得构建非常深的高性能的网络成为可能。Kim等[13]引入了残差学习的思想,提出了网络深度首次达到20层的极深超分辨网络(very deep super-resolution network, VDSR)。Ahn等[14]通过堆叠多个级联残差块,并建立跳跃连接以结合网络中学习到的全局信息和局部信息,提出了级联残差网络(cascading residual network, CARN)。为了防止梯度消失或爆炸,同时控制参数,将跳跃连接和递归学习结合,提出了深度递归残差网络[15](deep recursive residual network, DRRN)。文献[16]提出了一种非常深的持久存储网络(memory network, MemNet),它应用多个递归单元和门单元来提取和融合多级特征,以增强重建图像的视觉质量。程德强等[17]设计了一种多通道递归残差网络(multi-channel recursive residual network, MCSR)模型,将不同通道的特征信息进行融合。Qin等[18]利用多尺度上的特征融合提出了多尺度特征融合残差网络(multi-scale feature fusion residual network, MSFFRN)。

基于CNN的超分辨模型虽然有效地提升了重建性能,但是仍然存在着不足之处。首先,大多数超分辨模型没有重用网络不同层次的图像信息,使得网络的重建能力有限;其次,这些模型对网络各层次的特征没有进行进一步处理,阻碍了模型能力的充分挖掘,导致重建图像细节模糊、边缘不清晰。

为了解决上述问题,并进一步挖掘网络的表征能力,提出了二阶逐层特征融合超分辨网络(second-order progre-ssive feature fusion super-resolution network, SPFFSR)。本文的主要贡献如下:

(1) 提出了逐层特征融合方法,将每一层的特征与上一层的特征进行融合处理;

(2) 提出了二阶特征融合机制,在网络的局部和全局层面上采用逐层特征融合方法进行特征融合;

(3) 提出了SPFFSR,该网络可以学习更具代表性的特征,从而生成更准确的重建结果。

1 二阶逐层特征融合网络

1.1 网络框架

整体的网络框架如图1所示。所提出的二阶逐层特征融合网络分为了3部分:浅层特征提取部分、深层特征提取部分、重建部分。浅层特征提取部分用于提取图像的初始特征,即网络的浅层特征;深层特征提取部分用于进一步挖掘图像的高频特征,即网络的深层特征;重建部分利用网络提取到的特征构建最终的超分辨图像。

(1) 浅层特征提取部分。浅层特征提取部分用于提取图像的初始特征,即网络的浅层特征,其过程描述如下:

F0=fSFE(ILR)=Conv3(ILR)

(1)

式中:ILR表示输入的低分辨图像;Conv3(·)表示3×3的卷积函数;fSFE(·)用于对输入图像执行浅层特征提取操作;F0即为提取到的浅层特征。

(2) 深层特征提取部分。提取到浅层特征F0之后,再进入网络的深层特征提取部分。深层特征提取部分主要由主干分支、辅助分支和跳跃分支构成。主干分支是由g个级联的逐层特征融合模块组成,第i个模块在图1中表示为B-i(i=1,2,…,g),其特征提取过程可以表述为

Fg=fBg(Fg-1)=fBg(fBg-1(…fB1(F0)…))

(2)

式中:Fi表示第i个逐层特征融合模块的输出特征;fBi(·)表示第i个逐层特征融合模块的特征提取操作;Fg即为深层特征提取部分的主干分支提取到的特征。

图1 二阶逐层特征融合超分辨网络Fig.1 Second-order progressive feature fusion super-resolution network

辅助分支用来将每个逐层特征融合模块的输出特征按逐模块递进的方式进行先融合再卷积的操作,过程描述如下:

(3)

式中:Conv1(·)表示1×1的卷积函数;fresi表示辅助分支的输出。

在深层特征提取部分建立了一条跳跃分支,将浅层特征F0传送到网络深层,以弥补浅层特征在网络流动过程中的丢失。然后,将3条分支的输出进行融合得到如下的FM:

FM=Fg+F0+Fresg-1

(4)

最后,利用通道注意力机制赋予每条支路输出特征不同的重要性,数学表达式如下:

FG=fca(FM)

(5)

式中:fca(·)表示通道注意力机制函数;FG表示被赋予了不同权重的特征。整个深层特征提取部分描述如下:

FG=fDFE(FM)=fca(F0+Fg+Fresg-1)

(6)

式中:FDFE(·)表示深层特征提取函数。

(3) 重建部分。超分辨网络根据上采样操作的位置分为前端上采样网络,后端上采样网络,渐进式上采样网络,迭代上下采样网络。本文所采用的框架为后端上采样。上采样方法主要有双三次插值、转置卷积层和亚像素卷积层。本文所采用的方法为亚像素卷积层。网络重建部分FREC(·)由一个上采样模块FUM(·)构成,其结构如图2所示。

图2 上采样模块Fig.2 Upsampling module

当网络的放大因子为2时,上采样模块由3×3卷积层和Shuffle×2组成;当网络的放大因子为3时,上采样模块由3×3卷积层和Shuffle×3组成;当网络的放大因子为4时,上采样模块由2个3×3卷积层和Shuffle×2组成,即网络先实现放大图像2倍的操作,然后在此基础上再放大图像2倍,以实现最后放大4倍图像的任务。最终的超分辨图像ISR通过下式得到:

ISR=fREC(FG)=fUM(FG)

(7)

整个超分辨过程可以描述如下:

ISR=fSPFFSR(ILR)=fREC(fDFE(fSFE(ILR)))

(8)

式中:fSPFFSR(·)表示网络学习到的从低分辨图像到高分辨率图像的映射函数。

1.2 特征融合

特征融合是本文方法的重点。由于许多超分辨网络没有重用网络不同层次的特征,没有对网络各层次的特征进行进一步处理,阻碍了模型能力的充分挖掘。基于此,本文首先提出了逐层特征融合方法,再把提出的逐层特征融合方法应用到网络的全局层面和局部层面上,构成二阶特征融合机制,加强了网络各层之间的特征重用和信息流通。

1.2.1 特征融合方法

对于网络在不同层次提取特征的融合方式,本文主要参考了两种融合方法:层次特征融合(hierarchical feature fusion, HFF)[19]和二值化特征融合(binarized feature fusion, BFF)[20]。HFF如图3(a)所示,首先将所有层的特征进行对应像素相加,然后再进行卷积操作,以得到最终的特征。HFF只进行了一次特征融合处理,对各层次特征的重用率不高。BFF如图3(b)所示,将各相邻层的特征进行对应像素相加,再进行卷积操作,将处理后得到的特征再进行相同操作以得到最终的特征。BFF将相邻层的特征进行融合处理,而本文使用了异构模块,即相邻层的特征差异性较大,所以BFF在性能提升上效果不明显。

图3 4种特征融合方法Fig.3 Four feature fusion methods

为了探究更有效的特征融合方法,本文提出了两种新的特征融合方法:交叉特征融合(interlaced feature fusion, IFF)和逐层特征融合。IFF如图3(c)所示,将各奇数层的特征和各偶数层的特征,即交叉层的特征,分别进行对应像素相加,然后再进行卷积操作,将处理后得到的特征再进行一次相同的操作,以得到最终的特征。逐层特征融合如图3(d)所示,先将前两层的特征进行一次对应像素相加,然后再进行卷积操作,将得到的特征再与第3层的特征进行相同的处理,这样依次进行特征融合,以得到最终的特征。在相应实验部分对这4种特征融合方法的有效性进行了比较,实验结果表明逐层特征融合方法在整体上更加有效,所以本文选择了逐层特征融合方法。

1.2.2 二阶特征融合机制

如图4所示,二阶特征融合机制包含了全局特征融合和局部特征融合两个融合层次。网络主要由g个逐层特征融合模块构建而成。全局特征融合是指,利用逐层特征融合方法,将g个逐层特征融合模块提取出的全局特征进行融合,即二阶特征融合。局部特征融合是指,利用逐层特征融合方法,将由每个逐层特征融合模块内部提取出的局部特征进行融合,即一阶特征融合。

全局特征融合是g个逐层特征融合模块之间的特征融合。局部特征融合是每个逐层特征融合模块内部的特征融合。通过二阶特征融合机制,充分提取并处理网络各层次的特征,提高网络的学习能力,使得网络在重建时能够最大限度地挖掘其学习到的特征信息,进一步提高网络的重建性能。

(1) 全局特征融合。利用逐层特征融合方法,将g个逐层特征融合模块提取出的全局特征进行融合。如图4所示,将第一个逐层特征融合模块的输出特征F1和第二个逐层特征融合模块的输出特征F2的对应像素相加再卷积得到Fres1,然后Fres1再与第三个逐层特征融合模块的输出特征F3进行相同的操作得到Fres2,这样依次进行逐模块的特征融合,最终得到Fresg-1,其过程可以描述如下:

Fresg-1=Conv1(Fresg-2+Fg)=

Conv1(Conv1(…Conv1(F1+F2)…)+Fg)

(9)

式中:Conv1(·)表示1×1卷积函数,所用到的1×1卷积层的参数都不共享,F0,F1,F2,…,Fg分别表示网络的初始特征和每个逐层特征融合模块的输出特征。

图4 二阶特征融合机制Fig.4 Second-order feature fusion mechanism

(2) 局部特征融合。利用逐层特征融合方法,将每个逐层特征融合模块内部提取出的局部特征进行融合。如图4所示,以第三个逐层特征融合模块为例,将模块内部第一层的输出特征F2,1和第二层的输出特征F2,2的对应像素相加再卷积得到F2,res1,然后再与第三层的输出特征F2,3进行相同的操作得到F2,res2,这样依次进行逐层特征融合,最终得到F2,res3,特征提取和处理的过程可以描述如下:

F2,res3=Conv1(F2,res2+F2,4)=

Conv1(Conv1(…Conv1(F2,1+F2,2)…)+F2,4)

(10)

式中:Conv1(·)表示1×1卷积函数,所用到的1×1卷积层的参数都不共享,F2,i表示模块内第i层的输出特征。

1.2.3 逐层特征融合模块

针对基准残差模块(baseline residual block, BRB)结构单一、中间层特征无复用等不足,为了进一步提升模块的特征提取能力和学习能力,以获得更高质量的重建结果,提出了逐层特征融合模块(progressive feature fusion block,PFFB),其结构如图5所示。逐层特征融合模块也由主干分支、辅助分支和跳跃分支三条分支组成。

图5 逐层特征融合模块Fig.5 Progressive feature fusion block

主干分支由3×3大小的卷积层Conv(3)和1×1大小的卷积层Conv(1)交替连接构成,每个卷积层后面都接有激活层。卷积核大小相同的卷积层之间参数并不共享,即PFFB的第1层和第3层的参数不共享(第2层和第4层也同理)。这种利用异构结构提取特征的方式,不仅可以减少计算成本和内存消耗,还可以丰富PFFB的结构。以第g个PFFB为例,经过交替的卷积层的信息流动过程可以描述为

Fg-1,4=Conv1(Fg-1,3)=

Conv1(Conv3(Conv1(Conv3(Fg-1))))

(11)

式中:Fg-1,i(i=1,2,3,4)为PFFB,内部提取到的特征。

辅助分支主要用于处理PFFB中间层提取到的特征,通过逐层特征融合方法将PFFB内部提取到的局部特征有效地利用起来,实现局部特征融合,增强PFFB的特征学习能力。

跳跃分支用于将PFFB的输入Fg-1传送到PFFB的输出,以弥补特征在流动过程中的丢失。第g个PFFB最终的输出为

Fg=Fg-1+Fg-1,4+Fg-1,res3

(12)

式中:Fg-1,Fg-1,4和Fg-1,res3分别为3条分支提取到的特征。

2 实验结果与分析

2.1 实验设置

(1) 实验环境。实验所用的操作系统为Ubuntu 20.04 LTS,中央图形处理器为i7-8700k,运行环境为Anaconda 3和 PyCharm 2020.02。各超分辨网络模型在 PyTorch 框架下实现,并使用GeForce GTX 1080 Ti GPU加速模型的训练。

(2) 数据集。实验中使用的训练集为DIV2K。DIV2K包含1 000幅高清的自然图像,其中800张图像用于训练集,100张图像用于验证集,剩余的100张图像用于测试集。实验中使用的测试集为常用的公开测试集: Set5、Set14、BSD100、Urban100和Manga109。Set5和Set14都是非常经典的彩色数据集,其中Set5只由5个测试图像组成,与Set5相比,Set14有14个包含更多类别的测试图像。BSD100包含100幅不同场景的彩色图像,包括从自然图像到特定场景的图像。Urban100也由100幅彩色图像组成。它是一个相对较新的数据集,其焦点是城市场景、建筑结构等。Manga109是一个包含109幅漫画的数据集。

(3) 评价指标。峰值信噪比(peak signal to noise ratio, PSNR)和结构相似度(structural similarity SSIM)用于定量评估重建图像的质量。由于人类的视觉对亮度空间比对颜色空间更加敏感,所以测试结果都在YCbCr的Y通道进行计算。

(4) 训练设置。在训练过程中,相关参数设置如下。利用双三次下采样获得相应缩放因子(×2,×3,×4)的低分辨图像,进而获得用于训练的图像对。网络使用Adam优化器进行优化,其参数设置为β1=0.9,β2=0.999,ε=10-8。将批次大小设置为16。初始学习率设置为1×10-4,每2×105次迭代之后,学习率减半。为了降低训练成本,每个低分辨图像被裁剪为大小为48×48的补丁,这样可以提高训练的效率。通过水平翻转和旋转90°来增强训练数据。本文使用L1损失函数来训练网络。×2的网络是从头开始训练的,×3和×4的网络利用×2的网络作为预训练模型进行训练。

2.2 消融实验

(1) 特征融合方法的比较。为了比较这4种特征融合方法的有效性,分别对基于这4种特征融合方法的模型进行了训练,模型的放大因子均设置为2,并且在不影响实验结论的前提下,出于节约计算资源的考虑,将网络中的模块数量均设置为6,将训练好的4个模型在5个公开基准测试集上进行测试,得到的实验结果如表1所示。其中:加粗数值为每列最优值。从表1可以看出,在5个基准测试集上,基于逐层特征融合方法的模型比其他3个模型在整体上的重建性能要更优异。具体来说,在小数据集上,比如Set5和Set14,基于逐层特征融合方法的模型和基于层次特征融合方法的模型的重建性能比较相近,均取得了较优异的性能;在大数据集上,比如BSD100,Urban100和Manga109,基于逐层特征融合方法的模型的重建性能要比其他3种模型更加优异。总体而言,逐层特征融合方法有助于模型提取并利用特征,从而提高模型的重建性能。基于上述的实验结论,SPFFSR最终选定了逐层特征融合方法。

表1 不同特征融合方法下模型的性能比较

(2) 与BRB的比较。为了比较PFFB与BRB在重建性能上的有效性,进行了相关的实验研究,分别对PFFB和BRB的网络进行了训练,将放大因子均设置为2,并且在不影响实验结论的前提下,出于节约计算资源的考虑,将网络中的模块数量均设置为6,将训练好的这两个模型在5个公开基准测试集上进行了测试,表2给出了相应的实验结果。从实验结果可以看出,在5个基准测试集上,基于PFFB的网络比基于BRB的网络在整体上的重建性能要更优异。具体来说,在数据集Urban100和Manga109上,基于PFFB的网络比基于BRB的网络PSNR值均提升了0.13 dB;在数据集Set5和Set14上,基于PFFB的网络比基于BRB的网络PSNR值均提升了0.03 dB;在数据集BSD100上,基于PFFB的网络比基于BRB的网络PSNR值提升了0.02 dB。总结而言,逐层特征融合模块PFFB的性能更强。

表2 基于两种模块的网络性能比较

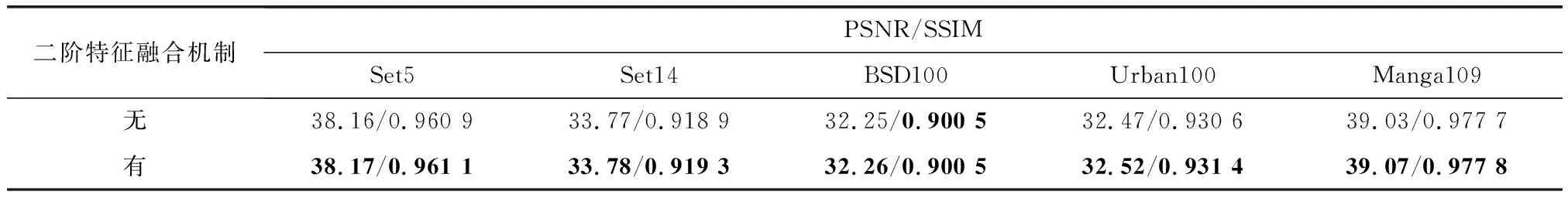

(3) 二阶特征融合机制。为了验证二阶特征融合机制的有效性,分别对引进了二阶特征融合机制(见图4)和没有引进二阶特征融合机制(见图6)的模型进行了训练。

图6 无二阶特征的融合机制Fig.6 Fusion mechanism without second-order feature

模型的放大因子均设置为2,并且在不影响实验结论的前提下,出于节约计算资源的考虑,将网络中的模块数量均设置为6,将训练好的两个模型在5个公开基准测试集上进行了测试,表3给出了相应的实验结果。其中,加粗数值表示每列最优值。从表3可以看出,引进了二阶特征融合机制的模型的性能整体上要优于没有引进二阶特征融合机制的模型的性能。具体而言,在Set14数据集上,引进二阶特征融合机制之后,PSNR值提升了0.01 dB,SSIM值提升了0.000 4;在Urban100数据集上,引进二阶特征融合机制之后,PSNR值提升了0.05 dB,SSIM值提升了0.000 8;在Manga109数据集上,引进二阶特征融合机制之后,PSNR值提升了0.04 dB,SSIM值提升了0.000 1;在Set5数据集和BSD100数据集上,两个模型的性能差异不是很明显。总体而言,二阶特征融合机制对于网络的性能具有显著的提升作用。

表3 有无二阶特征融合机制的模型性能比较

(4) 模块数量。在前面的特征融合结构的比较、二阶特征融合机制等实验讨论中,在不影响实验结论的前提下,出于节约计算资源的考虑,将网络的模块数量均设置为6。在本节,为了在模型性能和模型大小之间取得平衡,进行了相关的实验研究。定义n为网络中基于逐层特征融合结构的模块的数量,通过设置不同的n值,即不同的模型大小,观察模型取得的重建性能。将n的值依次设置为6、8、10,放大因子均设置为2,训练出3个不同大小的模型,在5个公开基准测试集上进行性能验证,得到的实验结果如表4所示。其中,↑表示数值增加,↓表示数值降低。从实验结果可以看出,当模块的数量从6增加到8,模型的性能也随之得到了提升,在5个基准测试集上均取得了优于n=6时的结果。当模块的数量从8增加到10时,在5个基准测试集上,模型的性能并没有完全得到提升,甚至还出现了部分下降的现象。具体而言,在数据集Set5和BSD100上,仅有PSNR指标值有提高,在数据集Urban100上,PSNR和SSIM两个指标值均有提高;但是在其他数据集上的指标有些基本保持不变,有些出现了下降。根据实验数据显示,n=10时的模型的性能并没有比n=8时的模型的性能有整体的提升。从模型性能与模型大小两个角度考虑,最终的SPFFSR将模块的数量设置为8。

表4 不同模块数量下模型的性能比较

2.3 与其他模型的比较

经过上述实验分析,SPFFSR最终的配置为:以逐层特征融合结构为基础,并引进二阶特征融合机制,模块个数设置为8。为了进一步验证所提SPFFSR的有效性,对其进行了定量和定性比较。

(1) 定量比较。定量比较是利用评估指标PSNR和SSIM进行的。在公开可用的基准数据集上,将SPFFSR与9种经典优秀的算法进行了比较,包括Bicubic[21]、SRCNN、FSRCNN、VDSR、DRCN[22]、LapSRN[23]、IDN[24]、CARN[25]、MCSR。表5~表7提供了在基准测试数据集,重建因子为×2、×3和×4的定量评估数据。这9种算法的结果均引用自本文给出的数据。其中,加粗字体表示每列最优性能,“-”表示此数据集在该方法下,原作者未进行相应实验。从表5~表7可以看到,与所有以前的方法相比,SPFFSR在所有缩放因子的所有数据集上表现最好。与近年来新提出的MCSR相比,SPFFSR仍然具有相当大的优势,这证明了所提出的网络的有效性。从表5~表7给出的实验数据来看,具体来说,在放大因子×2,数据集Set14、Urban100上,SPFFSR比MCSR分别高出0.23 dB、0.71 dB;在放大因子×3,数据集Set5、Urban100上,SPFFSR比MCSR分别高出0.21 dB、0.53 dB;在放大因子×4,数据集Set5、Urban100上,SPFFSR比MCSR分别高出0.25 dB、0.45 dB。

表5 在基准测试集下比较不同方法的 PSNR/SSIM 平均值(放大因子为×2)

表6 在基准测试集下比较不同方法的 PSNR/SSIM 平均值(放大因子为×3)

续表6

表7 在基准测试集下比较不同方法的 PSNR/SSIM 平均值(放大因子为×4)

(2) 定性比较。定性比较通过图像视觉效果质量来评估。图7~图10给出了一些模型的重建图像,这些重建图像都是随机选取的。为了更好地比较各方法的重建图像,将原始图像和各种网络重建图像的截取区域(图中的红色方框区域)放大展示。可以看出,SPFFSR重建出的超分辨率图像的放大区域在线条、轮廓上相比其他方法更加清晰,恢复图像细节的能力更强。综合定量评估和定性评估可以证明SPFFSR对超分辨重建的有效性。

图7 重建图像img004在放大4倍条件下的视觉比较Fig.7 Visual comparison for four-time enlargement on reconstructed image of img004

图8 重建图像PPT3在放大2倍条件下的视觉比较Fig.8 Visual comparison for two-times enlargement on reconstructed image of PPT3

图9 重建图像flower在放大3倍条件下的视觉比较Fig.9 Visual comparison for three-times enlargement on reconstructed image of flower

图10 重建图像img052在放大4倍条件下的视觉比较Fig.10 Visual comparison for four-times enlargement on reconstructed image of img052

2.4 模型复杂度分析

图11显示了每个网络的参数量与重建性能之间的比较。

图11 模型性能与参数量的比较Fig.11 Comparison of model performance and number of parameters

所选的数据集为Urban100,缩放因子为×4。从图11可以看出,SPFFSR的参数量要比其他几个模型的参数量大,但是SPFFSR所取得的重建性能要高于其他模型;相比EDSR模型,SPFFSR的参数量减少了很多,但是在重建性能上与EDSR模型相当。SPFFSR主要关注重建性能,所以参数量相对较大,适用于追求重建质量的场景。

2.5 执行时间

本节评估了这些模型的测试运行时间,如图12所示,图12显示了测试集Set5、2倍放大因子下模型的执行时间与重建性能之间的权衡。SPFFSR模型实现了相对高质量的重建性能,但是执行时间略长。SPFFSR模型适用于追求较高性能、不追求实时性的重建场景。

图12 模型性能与运行时间的比较Fig.12 Comparison of model performance and running time

3 结 论

在本文中,提出了一个二阶逐层特征融合网络,其核心部分是逐层特征融合模块。针对大多数网络没有重用网络各层次的特征,以及对各层次的特征没有进一步的处理等问题,提出了逐层特征融合方法和二阶特征融合机制,进而构建了二阶逐层特征融合网络,以最大限度地利用各层次特征。最后,在5个基准测试集上进行的评估结果显示,所提出的网络相比许多优秀的网络有较大的优势。从重建结果可以看到,由二阶逐层特征融合网络重建出来的图像纹理更清晰,边缘更明显。