基于深度学习与机器视觉的起重机吊装安全监测方法

2024-01-17薛志钢许晨旭闻东东

薛志钢,许晨旭,巫 波,闻东东

(1.江苏省特种设备安全监督检验研究院,南京 210036;2.徐州工程学院,江苏 徐州 221000)

随着我国基础建设的快速发展,在核电、风电、石油化工、公路、桥梁及大跨空间等领域涌现出一大批施工难度与技术均达到世界级的重大工程。这些重大工程均朝着大型化、复杂化和模块化发展,而起重机作为最主要的物料提升设备之一,能够有效地提高模块化建造的效率,减少对人力资源的需求,在各类施工现场均具有重要地位。大型工程对吊装作业急剧增加的强烈需求促进了起重机行业的大力发展。目前,起重机已经成为全球前三大工程机械品种之一。截至2018 年,全国吊装工程的营业总额达到400 亿元,拥有起重能力在650 t 以上的超大型起重机105 台,占全球保有量的20%。其中,全球仅有的2 台4 000 t 级履带型起重机、1 台2 000 t 级轮式全地面起重机、1 台6 400 t 级液压复式起重机均在我国[1]。

然而,随着起重机的提升高度和吨位不断加大,其安全管理的难度也随之提高,极易发生重大安全事故。例如,2001 年某船坞工地的龙门起重机发生倒塌事故,造成36 人死亡、3 人受伤,直接经济损失8 000 多万元;2001 年某钢铁氧气厂,汽车吊在吊装作业过程中车头翘起,吊物迅速下落砸中旋转半径内的工人,致其死亡;2002 年某工程现场,履带式起重机因操作失误导致倾覆,造成2 人死亡、1 人重伤、3 人轻伤;2005年某火电建设公司在吊装作业中,发生整体倾覆,造成3 人死亡,1 人受伤;2017 年某建筑工地,起重机在吊装过程中操作不慎,导致1 人死亡、1 人受伤。这些安全事故的发生促使起重机安全监测系统的发展。

为了充分保障起重机在吊装作业中的安全运行,减少安全事故和人员伤亡的发生。在起重机中安装了大量的传感器,搭建起重机运行参数监测系统[2-8]。例如,利用重量传感器测量起重量;采用角度传感器测量起重机的力臂幅度;通过绝对值编码器测量提升高度或下降深度;在臂杆顶端安装风速仪测量风速;在底盘上安装角度和水平度传感器测量起重机的主体状态;安装摄像机监控吊钩的运行状态。这类监测系统使起重机的吊装过程变得数字化、可控化,大大提高了吊装作业的安全系数。然而,这类系统中安装的摄像机仅起到了展示作用,无法深层次地理解监控图像中的信息。吊物状态只能依靠操作人员自行观察,受到光线等环境的影响,常常会发生误判。因此,吊物碰撞伤人事故的发生率依旧位居吊装安全事故总数的首位。

随着深度学习在图像处理领域不断取得了突破性成果,逐渐受到各领域广大科研人员的关注。例如,深度学习可以对监控图像中螺栓松弛损伤进行准确识别和定位,并与摄像机相连接实现损伤的实时监测[9-10]。深度学习算法可以对结构表面损伤比如裂缝、剥落、锈蚀等损伤进行识别和定位[11-15]。因而,深度学习能够深层次地理解图像中的信息,自主提取特征完成目标的精确识别与定位。鉴于此,本文将深度学习与机器视觉相结合对传统起重机监测系统中的监控图像进行目标识别与定位,根据定位信息获取工人与吊物之间的空间关系。第1 部分介绍了所提方法的整体流程;第2 部分介绍了基于工人与吊物的Faster R-CNN 模型;第3部分介绍了吊装安全监测方法的具体细节;第4 部分介绍了起重机吊装安全智能监测系统的各个模块及功能;第5 部分对本文所提方法进行了总结。

1 监测方法的整体流程

本文提出了一种基于深度学习和机器视觉的起重机吊装安全监测方法,整体流程如图1 所示。首先,在吊装现场采集包含工人与吊物的图片数据集。然后,建立基于工人与吊物的Faster R-CNN 监测模型,该模型能够准确地识别吊装现场的工人与吊物,并且能够自主判断工人是否佩戴安全帽。最后,利用监测模型的识别结果得到工人与吊物之间的空间关系,进而为起重机吊装作业提供安全预警,防止吊物碰撞伤人事故的发生。

图1 监测方法的整体流程

2 基于工人与吊物的Faster R-CNN 监测模型

对监控图像中的工人与吊物进行准确识别和定位是进行吊装安全监测的第一步。因此,首先利用目标检测算法对数据集进行训练获得吊装安全监测模型。Faster R-CNN 将区域推荐网络与卷积神经网络结合在一起完成了目标的精确分类与定位,不仅提高了目标检测的精度,也减少了候选区域的数量、缩短了模型的训练时间。因而,本文选择Faster R-CNN 作为识别和定位工人与吊物的检测算法。

2.1 Faster R-CNN

Faster R-CNN[16]于2015 年被Ross Girshick 提出,在R-CNN[17]和Fast R-CNN[18]的基础上发展而来。Faster R-CNN 主要包含2 个部分,一是深层卷积神经网络,可以自主提取图片的特征信息;二是区域推荐网络,根据卷积神经网络输出的特征图生成高质量的候选区域,大大降低了生成候选区域的时间,提高模型的训练速度。区域推荐网络是Faster R-CNN 的主要创新部分,与深层卷积神经网络共享特征图,因此可以直接学习更深层次的特征,进而能够提高目标的监测算法。

2.1.1 深度卷积神经网络

卷积神经网络能够自主提取图像中的深层次特征,无需人工干预就可以为目标的分类和定位提供特征信息,大大提高了特征提取的效率。卷积神经网络一般包括卷积层、池化层、全连接层和分类层等[19-21]。其中,卷积层是卷积神经网络中最重要的组成部分之一,利用卷积核在输入数据上滑动进行卷积计算获得数据的特征图。卷积核中的参数随着训练的进行会不断地迭代,同时卷积层充分考虑了数据的局部相关性,实现参数共享降低了网络参数的数量。池化层又被称为降采样层,利用池化核在数据上滑动减少数据的尺寸,提高模型的训练速度。全连接层将学习到的分布式特征映射到标记空间。分类层是将学习到的特征进行类别预测,完成目标的分类。此外,卷积神经网络中还使用了激活函数,提高网络的非线性表达能力。本文采用VGG16-Net 作为深度卷积神经网络提取图像的深层次信息。

2.1.2 区域推荐网络

区域推荐网络是在卷积神经网络输出的特征图上运用特定大小的滑动窗口预测多个不同比例的候选区域,并将候选区域输入中间层生成512 维长度的全连接特征。该特征分别被输入2 个全连接层中,第一个全连接层用来预测识别框的位置并进行回归修正;第二个全连接层用来判断候选区域属于正样本还是负样本。当候选框与真实框之间的IoU 大于0.7 时,候选框被标记为正样本,否则被标记为负样本。

为了更好地训练Faster R-CNN 网络,采取四步法训练。首先,训练区域推荐网络;然后利用获得的候选区域训练目标分类及定位;接着,再次训练区域推荐网络;最后,利用更新后的候选区域训练目标分类及定位。根据训练结果发现,这样的训练方式能够提高模型的识别精度。当进一步提高训练次数时,模型的训练精度并没有大幅度提高。

2.2 数据集

为了获得实际场景下的吊装安全数据集,选取某吊装场地进行了实地拍摄,分别在东西和南北2 个方向分别放置一个智能手机,用于水平拍摄吊装过程中吊物的运动状态。视频的拍摄频率为30 FPS、分辨率为1 920×1 280 像素。选择其中的600 张图片作为数据集进行标记,主要包括3 类标签:r 为佩戴安全帽的工人,b 为未佩戴安全帽的工人,w 为吊物。将数据集中的80%作为训练验证集,20%作为测试集。

2.3 训练过程及结果

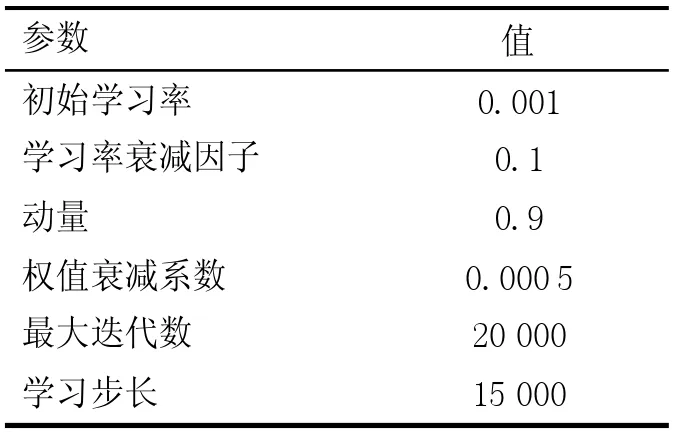

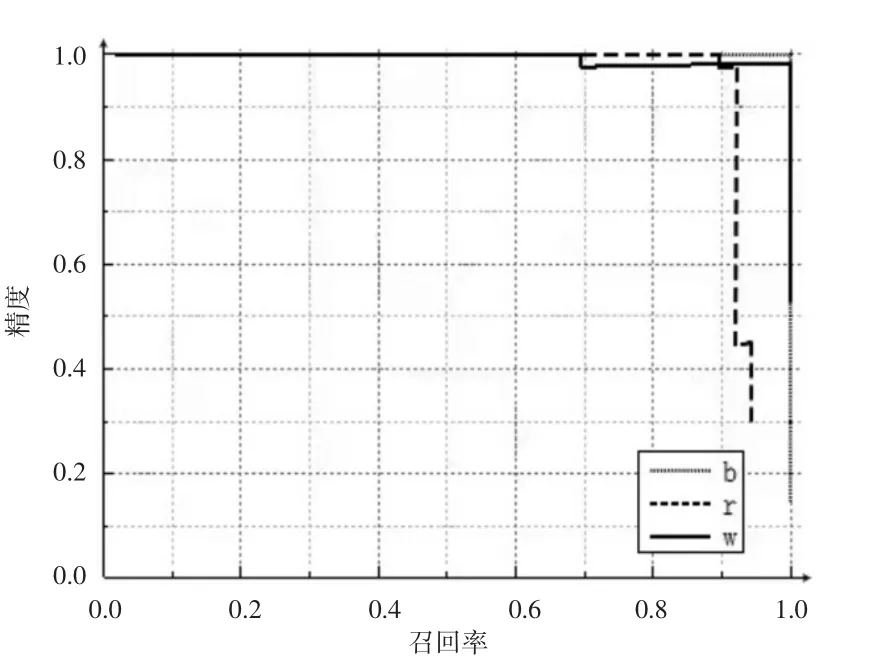

利用基于TensorFlow 框架下的Faster R-CNN 算法对吊装安全数据集进行训练,训练参数见表1。经过10 000 次迭代后获得最终的监测模型,模型的预测-召回率曲线如图2 所示,训练精度见表2。精度和召回率是衡量模型识别能力的重要指标。精度表示识别样本中实际正样本占所有正样本数的比例。召回率表示预测样本中实际正样本数占所有预测样本数的比例。由表2 可知,3 个类别的平均识别精度为0.980 5,能够满足工程实践的需要。

表1 训练参数

表2 训练精度

图2 预测-召回率曲线

为了更加直观地说明模型的识别能力,图3 中展示了这3 类目标的识别结果。从图3 中可以看出,该模型不仅能够高精度地完成佩戴安全帽的工人、未佩戴安全帽的工人和吊物的识别,同时可以完成这3 个类别的精确定位,为进一步监测吊装安全提供基础。

图3 识别结果

3 吊装安全监测

基于工人与吊物的Faster R-CNN 监测模型能够高精度地完成佩戴安全帽的工人、未佩戴安全帽的工人和吊物等3 类目标的识别和定位。在实际工程中为了保障吊装作业的安全性,不仅需要工人佩戴安全帽,而且还需确保工人与吊物之间保持一定的距离,防止出现吊装碰撞、打击等伤人事故。通过训练获得的监测模型对监控图像中3 类目标进行识别和定位,并提取目标识别框的中心点和范围。同时对2 个方向上拍摄的图片进行检测,即可获得工人与吊物之间的空间关系。

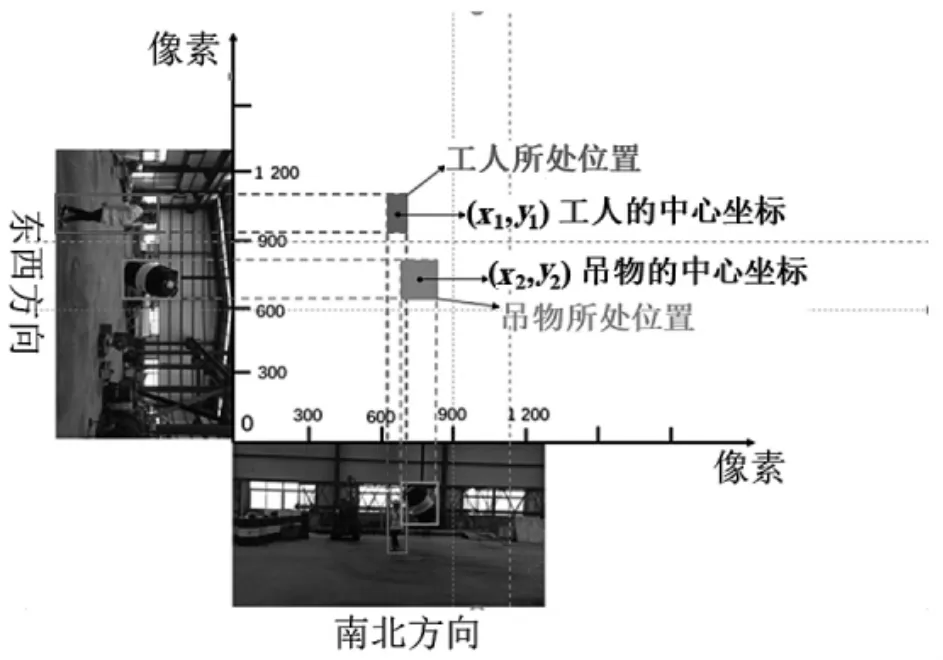

首先,对2 个方向上拍摄的图像进行同步处理。以南北方向拍摄图像的左上角为原点、水平向右为X 轴正向,以东北方向拍摄图像的右上角为原点、水平向左为Y 轴正向,并将该方向拍摄的图像旋转90°,构建如图4 所示的吊装监测坐标系。该坐标系中各点的坐标均为2 个方向拍摄图像的水平像素坐标。以工人为例,同时检测工人在2 个图像中识别框的范围,并提取2个识别框的水平像素坐标。在所建立的吊装监测坐标系中得到的交叉区域即为工人所在的平面位置,该位置的中心即为目标(工人)的中心坐标。同理,可以得到吊物所在的平面位置和中心坐标。

图4 吊装监测坐标系

利用上述方法可以获得各个检测目标(工人与吊物)所在位置和中心坐标,通过平面坐标原理获得工人与吊物之间的距离。随着吊装作业的进行,工人与吊物的中心坐标会不断发生改变,同时产生空间上的互动。因此,根据定位信息可以为吊装监测提供准确的安全预警信息。根据实际需要,可以设定2 种安全预警模式:一是自动预警模式,一旦工人在坐标系下的所处位置与吊物所处位置有任何接触,就立刻触发安全预警信号;二是当工人与吊物的中心距离达到阈值时,立刻触发安全预警信号。

4 吊装安全智能监测系统

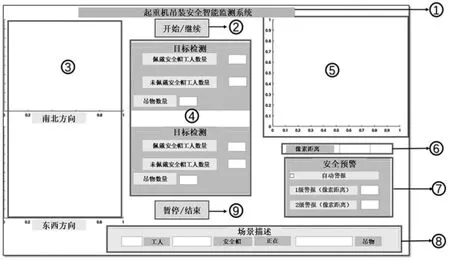

为了对吊装安全进行实时监测,开发完成了起重机吊装安全智能监测系统,系统界面如图5 所示。②是开始/继续监测按钮;③是南北和东西2 个方向上摄像机的实时监控窗口;④是监测模型对2 个监控图像的识别结果,包括佩戴安全帽的工人数、未佩戴安全帽的工人数以及吊物个数;⑤是实时跟踪工人与吊物的中心坐标轨迹图;⑥是工人与吊物之间的像素距离;⑦是安全预警模块,包括自动警报和手动设置阈值进行警报;⑧是场景描述模块,包含工人数量、是否佩戴安全帽以及工人与吊物之间空间趋势;⑨是暂停/结束按钮。

图5 监测系统界面

为了验证所提方法及系统的实时监测效果,将计算机与2 个摄像头相连接,实现吊装安全的实时监控和跟踪。由于计算机性能的限制,监控视频的采集频率应小于17 帧/s。在试验过程中,吊物保持静止,以其投影的中心为圆点,绘制半径为1.5 m 的轨道,工人按照此轨道行走。根据视频拍摄的基本原理,工人的行走轨迹在窗口中呈现椭圆形,监测结果如图6 所示。根据监测结果可知,起重机吊装安全智能监测系统能够对2 个方向上的监控画面进行实时识别和定位,同时对工人与吊物完成实时追踪,绘制出两者中心坐标在平面上的移动曲线,自动完成安全预警。此外,还可根据识别结果输出场景描述,判断工人是在逐渐靠近吊物还是逐渐远离吊物,能够更加智能地预判安全事故的发生。

图6 吊装安全监测结果

5 结论

本文提出了基于深度学习和机器视觉的起重机吊装安全监测方法。首先,通过安置的2 台摄像机同时拍摄吊物及其周围工人。然后,利用训练的监测模型对图像中的吊物、佩戴安全帽的工人和未佩戴安全帽的工人进行识别和定位,模型的平均监测精度为0.980 5。接着,以2 个方向上拍摄的图片建立吊装监测坐标系,获得目标在该坐标系下的所处位置及中心坐标。最后,开发了吊装安全智能监测系统,依据监测模型的识别结果进行安全预警。同时,该系统还可以输出场景描述,判断工人与吊物之间距离的变化趋势,能够一定程度上预判安全事故的发生。因此,本文所提方法能够深层次地理解监控数据,进一步完善了现有的起重机安全监测系统,能够有效防止吊物碰撞伤人事故的发生。