智能蓝军作战行为决策模型优化技术研究*

2024-01-16章乐贵陈希亮张启阳

章乐贵,曹 雷,陈希亮,汤 伟,王 军,张启阳

(陆军工程大学指挥控制工程学院,南京 210007)

0 引言

随着智能化作战行动日趋成为现代化战争中的主角,亟需运用军事智能化手段打造虚拟蓝军,改变将蓝军视为“战术木偶”和“普通配角”的思维,赋予模拟蓝军自主权,以期解决兵棋推演、作战规划等系统实际运用中存在的作战缺对手等问题[1-2];基于决策树的作战实体行为规则建模方法,为作战实体行为规则的格式化表达和形式化描述提供了具体的解决途径,能够以静态的计划或策略的方式驱动蓝军实体行动序列生成,但其适应性和学习能力较差,难以适应动态的决策环境[3]。而当在复杂战场环境下搜索不到可以匹配的行为决策规则时,虽然可运用在线势能评估方法[4],但是权重系数是人为拟定的,且在整个作战过程中权重系数没有变化,这样生成的策略无法确定为最优值,如果系数的偏移度较大,模型质量就会大打折扣,甚至无法作出决策。使用智能化方法提高决策树的动态适应性,不失为另一种解决决策困难问题的好方法,通过使用机器学习算法,分析全局态势,开展智能作战行为建模已经得到广泛关注[5-19]。机器学习方法具有强大的非线性函数表示能力,能从大量数据中学习经验知识,通过深度神经网络将数据逐层抽象得到策略模型,可以较好地模仿人的决策思维活动,但其局限性是需要大量的样本数据,同时模型的可解释性差,在训练数据有限的情况下,样本数据无法覆盖完整的决策空间,学得的策略模型泛化能力有限,导致策略模型适用性不强。在强化学习中引入规则知识,不仅可以提高强化学习的收敛速度,提高智能体的探索能力,还能解决奖赏稀疏性问题。

本文提出一种融合决策树和强化学习的智能蓝军作战行为决策优化技术,既与传统的强化学习从零开始试错不同,也区别于当下流行的将规则作为专家经验引入进而尝试改进算法[20-26]。该技术始终围绕智能蓝军“更像”和“更好”两个目标,在智能体训练整个过程中,把从蓝军条令规范和典型战例里面提取的先验知识作为规则写入系统,让智能体整体保证“蓝”的特征,同时在决策树无法决策节点将决策树模型状态空间输入近端策略优化(proximal policy optimization,PPO),强化学习算法训练得到的网络策略模型生成新的行为动作,赋予智能蓝军实体作战行为决策的灵活性,这也更符合人类的学习习惯,即面对复杂战场环境不能毫无章法也不能墨守成规,要能在关键节点总结战机,提炼战法,不断提高智能蓝军的“对抗性”。

1 基于强化学习的智能蓝军作战行为决策模型优化技术

本文提出的融合决策树和强化学习的智能蓝军作战行为决策优化技术,充分利用规则建模和机器学习算法的优点,以基于决策树的作战行为决策模型为主体框架,将决策知识转化为程序逻辑,解决作战行为决策过程的形式化表达问题,在此基础上,若决策树陷入决策困境,则使用PPO 强化学习方法生成行为规则,优化模型如图1 所示。

1.1 PPO 强化学习算法

PPO 是policy gradient 的一个变形,通过将onpolicy 转变为off-policy,大大提升了采样效率,目前是OpenAI 默认的强化学习算法。

1.1.1 策略梯度

1)策略梯度(policy gradient,PG)基本算法

PG 基本算法也称为直接策略搜索法,其主要思想是将策略π 参数化,通过调整策略的参数,使得优化目标函数达到最大或局部最大。

目标函数L(πθ)=s~ρπ,a~πθ[(rs,a)]

2)信赖域策略优化算法(trust region policy optimization,TRPO)

TRPO 的基本原理是通过一定的约束条件,保证每步策略梯度的更新沿着单调上升的方向进行,以大幅提高训练效率。

TRPO 推导出的带约束的目标函数为:

其中,约束式中的DKL为KL 散度。该约束表明将新旧两个策略的平均KL 散度控制在一定的信赖域中,也即,只要新旧两个策略的差异限制在一定范围内,即可保证策略梯度将单调上升。

1.1.2 PPO 算法基本原理

由于TRPO 算法计算量大,算法效率低,且实现难度大,在TRPO 算法基础上又提出一种高效的PPO 算法。

引入时间下标,可将TRPO 优化目标简写成:

其中,Aθold(st,at)=Qπθold(st,at)-Vπθold(st,at)为策略πθold的优势函数,代表采用该策略时比原价值函数提升的幅度。令:

显然,rt(θ)为新旧策略的比值。将rt(θ)限制在1附近,那么其效果与TRPO 中的约束条件相类似,且避免了复杂的运算。

PPO 算法通过裁剪(Clip)新旧策略比值来完成上述限制,其目标函数为:

当优势函数为正时,此时策略更优,要增加优化力度,但是当rt(θ)>1+时会将其Clip 为1+,优化上限为rt(θ)=1+,这样一来就会防止其过度优化。

当优势函数为负时,此时策略更差,要减小优化力度,即选择更小的rt(θ),当rt(θ)<1-时,会将其下限设置到1-,从而保证策略更新的稳定性。

1.2 融合决策树和PPO 算法的智能蓝军作战行为决策建模

1.2.1 融合建模思路

针对规则知识建模缺乏灵活性、适应性差等问题,采用融合决策树和PPO 强化学习算法的方式,优化智能蓝军作战行为决策模型。以重型战车机动行为决策树属性值在线势能模型权重优化为例,是否收到机动命令、是否满足机动条件和是否通视,可直接从态势数据中得出决策属性值;但是当决策属性值无法从战场态势数据直接得出时,如若蓝方实体在上述机动过程中出现在敌方通视范围内,则此时既定规则无法指导重型战车完成下一步机动位置选择,实体陷入决策困境。虽然可以引入在线势能概念进行评估,但是在线势能的权重参数还是依赖专家系统,且权重系数无法实时更新。利用强化学习较好的学习能力和自适应优势可以走出这一困境,考虑到PPO 算法的使用范围广且比较稳定,当决策树运行过程中实体陷入决策困境时,利用基于PPO 算法训练的网络模型生成最优动作,使得决策树得以继续顺利执行,这将大大提高战车机动、射击等行为决策灵活性和对抗性,对模型整体质量提升起到较好优化作用。

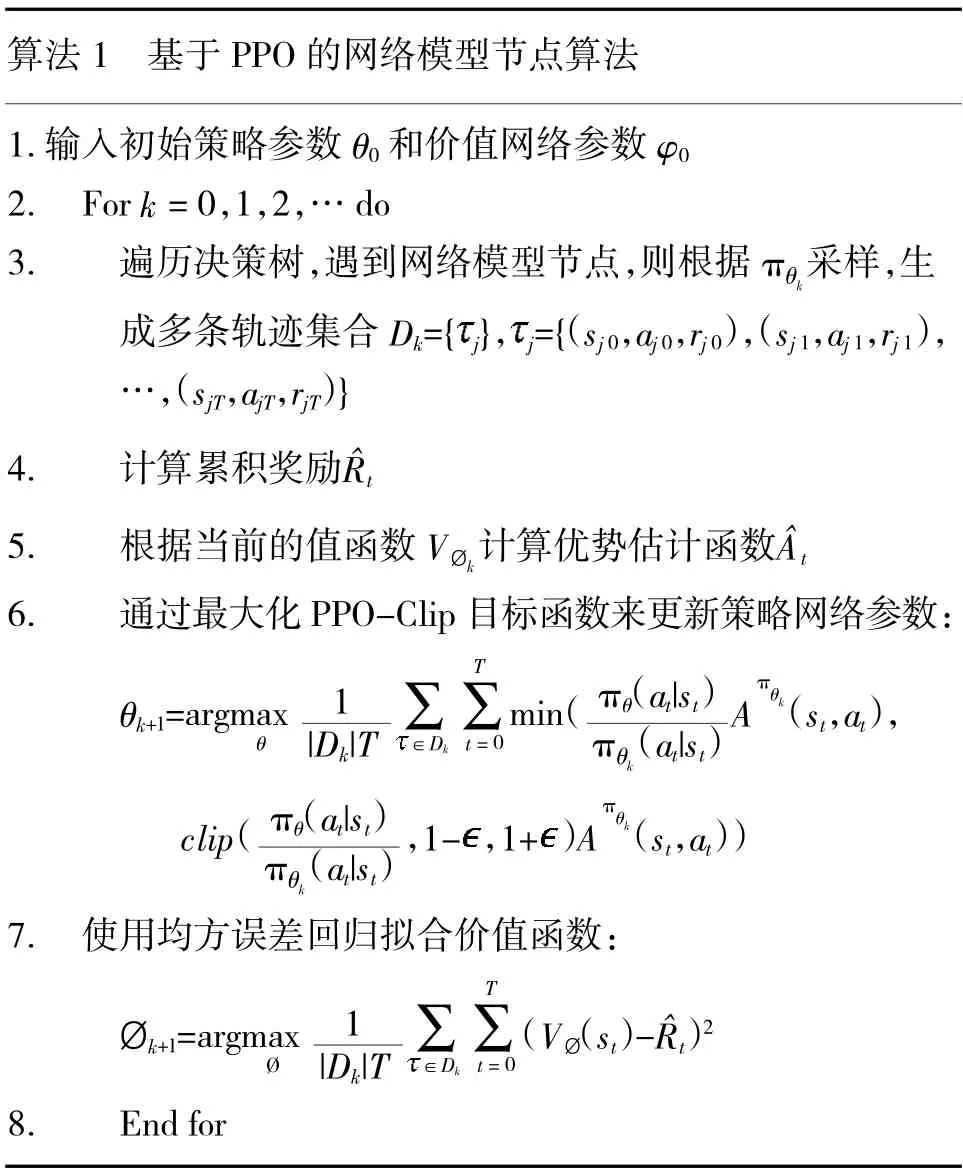

1.2.2 基于PPO 的网络模型节点算法模型

网络模型节点是用深度神经网络模型代替属性值的决策树节点,该网络模型节点的输入为状态,输出直接为动作。网络模型使用PPO 强化学习算法进行训练,训练采用Actor-Critic 架构,即参数为θ的策略网络和参数为Ø 的价值网络。其主要步骤为:

具体算法伪代码如下:

决策树按照规则提取过程自上而下执行作战行为,遇到网络模型节点,则进入强化学习环境,不断探索新的战术策略;决策树按照固有逻辑保持运行,若网络模型节点反馈值符合一定条件,可中止训练,反馈节点值,基于PPO 算法的网络模型节点算法模型训练过程如图2 所示。

1.2.3 融合决策树和PPO 算法的智能蓝军作战行为决策流程

考虑到蓝军模型建设对“像”和“强”的要求,融合决策树和PPO 强化学习算法的智能蓝军作战行为决策模型必须以决策树模型为基本框架,首先还是结合条令规范、战例分析等军事知识分析战术行动任务,按照规则模型构建基本流程构造作战行为决策树,在构建过程中,将无法准确描述的决策属性点设置为网络模型节点;当某时刻状态符合决策树模型判定条件时,调用执行决策树行为策略生成新的状态继续进入决策树判定;当某时刻状态不符合决策树模型判定条件时,模型出现决策困难,进入网络模型节点,此时状态输入PPO 强化学习算法模型,生成的PPO 行为策略进行决策树执行后,生成新的状态进行循环判定调用。

整个优化模型的状态-策略判定调用流程如图3 所示。

2 实验设计与结果分析

2.1 想定描述

1)想定内容

基于庙算·智胜陆战兵棋即时策略人机对抗平台开展的实验,以分队级中等起伏地地形进攻防御战斗为基本想定,在中等起伏地形上,在下页图4中,红蓝分队围绕夺控点开展进攻防御行动,战斗中,双方均忽略其他支援。

对抗兵力:红蓝分队由数量不等的重型坦克、重(中)型战车和步兵分队组成,红蓝双方装备编成与初始部署位置由具体想定确定。

2)任务描述

夺控防御任务:蓝方合成分队主要任务是依据有利地形进行夺控防御,红方主要任务是实施进攻战斗,抢占夺控点。

3)红蓝双方初始态势与部署

蓝方防守方部署于西北(5259)和(5359)位置,红方进攻方部署于东南坐标(5957)和(6070)位置。夺控点位于(5561)和(5260)位置。具体见图5。

图5 红蓝双方初始部署位置及夺控点位置Fig. 5 Initial deployment positions and control point positions of the red and blue parties

4)胜负判定

夺控分:比赛结束时,夺控每个主要夺控点80分,夺控每个次要夺控点50 分。

算子分:己方剩余算子得分

净胜分:一局比赛中,选手获得的“夺控点分+己方剩余算子得分+战斗得分”,与对手获得的“夺控点分+己方剩余算子得分+战斗得分”之间的差值为净胜分。净胜分为正者该局获胜,双方净胜分均为零为平局。

2.2 红蓝智能

红方智能由平台高水平智能体驱动,在分队级中等起伏地地形进攻防御战斗想定红蓝对抗训练中,蓝军智能包含平台基准AI(demo)、基于决策树的行为规则驱动、PPO 算法和论文提出的融合决策树和PPO 强化学习算法的作战行为决策建模技术。

一是基于平台基准AI(demo)驱动的蓝军合成分队与平台高水平AI 驱动的红军合成分队开展对抗训练,红蓝AI 模型进行对抗测试300 次,观察蓝军合成分队的胜率情况。

二是基于决策树的行为规则驱动蓝军合成分队与平台高水平AI 驱动的红军合成分队开展对抗训练,红蓝AI 模型进行对抗测试300 次,观察蓝军合成分队的胜率情况。

三是基于PPO 算法的蓝军合成分队与平台高水平AI 驱动的红军合成分队开展对抗训练,当得到连续10 次更新的模型,利用每次训练完的模型进行对抗测试,每个模型对抗100 次,如果平均累计回报值的误差低于5%,可认为此时模型已训练稳定。

四是本文提出的融合决策树和PPO 强化学习算法的作战行为决策建模技术驱动的蓝军合成分队,与平台高水平AI 驱动的红军合成分队对抗训练,当得到连续10 次更新的模型,利用每次训练完的模型进行对抗测试,每个模型对抗100 次,如果平均累计回报值的误差低于5%,可认为此时模型已训练稳定。

2.3 仿真效果分析

本实验在庙算·智胜陆战兵棋即时策略人机对抗中进行。前面已经对想定进行了描述,依据任务描述,红方以平台高水平AI 驱动开展夺控,蓝方通过平台基准AI(demo)、决策树规则、纯PPO 算法,以及融合决策树和PPO 强化学习算法驱动,学得了稳定的防守策略。

为了比较4 种算法的性能,基于中等起伏地地形进攻防御战斗想定进行训练,每种红蓝AI 模型进行对抗测试300 次,在算法训练过程中,记录不同学习算法下AI 对平台高水平AI 的胜率,可以看出,PPO 算法和PPO 优化的决策树算法随着训练轮次的增大,胜率有提升的趋势。决策树算法和Demo AI 维持在一个平均水平上下震荡,如图6 所示。

图6 4 种蓝军AI 的胜率拟合曲线比较Fig. 6 Fitting curves comparison of AI win rate of four kinds of blue army

备注:庙算平台中比赛结果分胜、平、负3 种情况,本实验对抗仅统计获胜的比例。对抗中PPO 优化的决策树算法最高胜率达45%,PPO 算法训练出的模型最高胜率达30%,决策树算法模型最高胜率达25%。

实验利用学得的模型直接驱动蓝方智能体与平台高水平”AI 红方智能体交战,记录每次交战的得分和胜负情况,实验共分10 组,每组中4 种AI分别进行100 次实验。实验结果如表1 所示。

表1 基准AI、规则AI、PPO 以及规则+PPO 实验Table 1 Benchmark AI,Rule AI,PPO and Rule+PPO experiment

实验结果表明,PPO 算法得分均值为2.16,胜率均值为19.5%。其平均得分高于平台基于AI(demo)的在两个夺控点之间游走的策略,但低于基于决策树的智能蓝军作战行为决策模型展现出的远程支援、围点打援策略。而融合决策树和PPO 强化学习算法的智能蓝军作战行为决策模型,平均得分为9.2 分,胜率达到了41%,比人工制定的基于决策树的智能作战行为决策模型策略胜率高。

通过庙算平台陆战复盘系统,对融合决策树和PPO 的算法模型生成的策略进行了回放,态势快照以原始态势为起点按照锐眼阶段以时间顺序排列,可以看出,融合决策树和PPO 的算法模型驱动的智能重型战车学得了避虚打实的策略,虽然远程突击火力强,但是装甲防护弱,其依靠有利地形,迅速推进至有利位置(4 749),使得敌人无法对其造成威胁,但它可以控制整个通视区域,充分发挥了远程支援打击优势。同时智能步兵分队,学得分而治之策略,依据目标小范围的优势,作战开始就把步兵分为2 个小组分别执行抢占主次夺控点任务。

由于加入了PPO 算法优化,蓝方智能还学会了更多的行为策略,同一想定下,在不突破蓝军整体规则框架的同时,对决策困难位置有了更加精准的判断。通过对智能蓝军作战行为策略回放进行总结,发现除了避虚打实和分兵夺控的策略,智能蓝军还学会围点打援、联合布控的策略,如下页图7所示。

图7 智能蓝军作战行为策略演示Fig. 7 Intelligent Blue Army combat behavior strategy demonstration

从快照中可以看出,重型战车在作战过程中执行远程火力支援,重型坦克在两个夺控附近巡逻,打击出现通视的红方目标,二者形成协同防守态势。在蓝军重型战车和重型坦克分别到达指定防守地域后,蓝方实体主要采取蹲守防御策略。对抗过程中,如果红方损失很大,蓝军则前出,开展巩固行动;如果红方剩余兵力较强,蓝方按兵不动。观察发现,胜率较高的融合决策树和PPO 的算法模型在经过大量的训练后学得了两个策略:首先学会了避虚打实,隐蔽布控,重型战车和重型坦克都不会直接向布控点机动,从起始位置利用有利地形选择背斜位置前进至具备射击优势的地域;其次学会了步步为营。通过分析总结,发现智能体对防御任务理解不断加深,在具备优势的情况下,没有前出追击,而是牢牢守住夺控点,敌人来了就打,跑了就守,在占据有利地形和具备夺控优势情况下,以逸待劳。

3 结论

针对蓝军模型适应性和学习能力较差等不足,提出一种融合决策树和PPO 强化学习的智能蓝军作战行为决策优化技术,在决策树运行过程中若智能体陷入决策困境,使用PPO 强化学习算法,探索生成网络模型节点行为策略,优化决策树模型。基于庙算·智胜陆战兵棋即时策略人机对抗平台开展实验,通过对比基于平台基准AI(demo)驱动、基于决策树驱动以及基于PPO 算法驱动,验证了融合决策树和PPO 强化学习的智能蓝军作战行为决策优化技术的可行性和有效性。虽然从智能蓝军模型构建角度提出了一些技术方法和运用思考,但在具体模型构建实践中还可能出现很多新情况、新问题,有待进一步验证解决,蓝军模型的评价指标是下一步需要深入研究的重点。