基于多形态学成分分析的图像融合

2024-01-09马晓乐王志海胡绍海

马晓乐, 王志海, 胡绍海

(北京交通大学 计算机与信息技术学院,北京 100044)

单个传感器获取到的图像不能完整、准确地描述目标场景。图像融合作为一种有效的图像处理方法,可以将多源传感器采集到的关于同一场景的互补信息进行融合,可以更加准确、可靠地描述场景信息,被广泛应用于医疗诊断、计算机视觉和军事侦察等领域[1-3]。

图像融合[4]可分为像素级融合、特征级融合和决策级融合。基于像素级融合的方法直接对源图像像素进行处理,可以保留最详细的信息,为其他类型的图像融合奠定基础[5]。因此,默认的图像融合方法是基于像素级融合的方法,包括基于空间域的方法、基于多尺度变换的方法、基于稀疏表示的方法和基于深度学习的方法。

近年来,基于深度学习的图像处理方法在图像融合领域得到了广泛应用[6-8]。将人工神经网络作为判别器来判别源图像的信息是否属于融合后的图像[9],再利用建立的网络提取图像特征,最后采用传统的融合方法对提取的特征进行融合[10]。这类方法虽然提高了融合性能,但是无法避免人工设计融合规则的缺点,往往需要标准参考图像和融合参考图像等先验知识。

随着小波及其衍生物的发展[11],多尺度变换(MST)在图像处理中得到了广泛应用,特别是在图像融合领域,如基于多尺度特征分解的红外与视觉图像融合[12]、基于非下采样域局部差分的多模态传感器医学图像融合[13]、基于遗传算法快速曲波变换的多模态医学图像融合[14]。

近年来,压缩感知技术和稀疏表示理论快速发展,基于稀疏表示的图像融合方法越来越受到关注,如基于稀疏表示的高光谱和多光谱图像融合[15]、基于几何稀疏表示的多聚焦图像融合[16]。这类方法的融合过程为:首先对源图像进行块处理,然后采用过完备冗余字典对得到的块进行稀疏编码,接着利用融合规则对稀疏系数进行融合,最后通过稀疏重建得到融合后的图像。通过对稀疏字典进行分类,联合稀疏表示(JSR)可以将多源图像分解为互补分量和冗余分量,形态学成分分析(MCA)则将图像分解为卡通分量和纹理分量[17]。因此,形态学成分分析不仅继承了过完备稀疏表示和信号重建的优异性能,能够以最少的原子捕获图像中的高维奇异性特征,还提供了良好的图像结构和纹理自适应处理机制,在图像处理中具有潜在优势。

不同传感器的成像机理不同,同一传感器的成像条件也不同,因此传感器获取的图像不仅包含冗余信息,还包含互补信息。现有的图像融合方法大多忽略了信息之间的互补和冗余关系,在对源图像进行融合时没有进行区分,导致融合结果不完善。此外,直接对源图像进行处理,将增加冗余信息处理的计算量。因此,提出了一种基于多形态学成分分析的图像融合方法,不仅保留了多尺度变换提取特征信息的能力并避免了固定的正交基函数,还可以更好地应用于随机多样的多模态图像融合。

1 形态学成分分析

根据形态学结构,形态学成分分析[17-19]作为一种基于稀疏表示的图像分解方法,将图像I分解为纹理子图像It和卡通子图像Icar,表达式如下所示:

式中:Dt、Dcar和αt、αcar分别表示纹理子图像和卡通子图像对应的冗余字典和稀疏系数。It只能由Dt稀疏表示,不能由Dcar稀疏表示;Icar只能由Dcar稀疏表示,不能由Dt稀疏表示。相关的稀疏模型可以表示为

式中:μ表示惩罚因子。

以上模型是非凸的,对其求解存在一定的困难,而且随着字典中原子数的增长其求解复杂度也呈指数增长。基追踪(BP)算法作为一种松弛优化算法,将l0范数转化为其他范数,从而非凸优化问题被转化为一个可解的优化问题。因此,将l1范数引入此优化模型,得到以下模型:

2 基于多形态学成分分析的图像融合算法

基于多形态学成分分析的图像融合算法如图1所示。首先对第一幅源图像I1和第二幅源图像I2进行多形态学成分分析,然后对上一尺度的卡通分量进行形态学成分分析以提取丰富的图像特征,最后得到源图 像1 的卡通子 图 像I1car,n和纹理子图 像I1t,n以及源图像2 的卡通子图像I2car,n和纹理子图像I2t,n,其中下标n表示分解层数。采用不同的融合方法实现不同子图像的融合,最终的融合图像IF可以通过融合后的卡通子图像IFcar,n和纹理子图像IFt,n相加重建得到。

2.1 融合卡通子图像

图像融合的目的是充分利用源图像信息之间的互补性,解决冗余信息之间的矛盾并增加源图像的可解释性和清晰度,为原始场景提供更全面、可靠、准确的描述。因此,图像可以被分解为冗余分量Ir和互补分量Icom[20]。类似式(1),联合稀疏表示模型为

式中:Dr、Dcom和αr、αcom分别表示冗余分量和互补分量各自对应的冗余字典和稀疏系数。当源图像的数量为2的时候,式(4)所代表的模型可以简化为

式中:下标1、2 表示源图像的序列号;Dcom1、Dcom2和αcom1、αcom2分别表示源图像1、2各自对应的互补字典和稀疏系数;Bk1和Bk2分别表示第一幅源图像和第二幅源图像的第k个图像块;K表示每幅源图像中图像块的总数。基于式(4)的图像融合流程如图2 所示。图2 中,Ic1、Ic2、IFc表示源图像1、源图像2 以及融合后的互补分量。

图2 基于联合稀疏表示的图像融合Fig.2 Image fusion based on joint sparse representation

2.2 融合纹理子图像

纹理子图像中包括更多的纹理信息、精细的细节和一些自然噪声。为了更有效地保留这些精细的纹理并抑制不必要的噪声,提出了一种基于方向特征(DF)的纹理子图像融合方法,通过比较源图像的图像块中4 个不同方向(包括水平、垂直、左对角线和右对角线方向)的信息差来实现。如图3 所示,4个方向的24个不同子方向包括5个水平、5个垂直、7个左对角线和7 个右对角线子方向。以pm,d(i,j)为中心的大小为n×n的窗口在子方向上的最大值和最小值之间的差由下式得到:

图3 图像块的不同方向Fig.3 Different directions of image blocks

式中:m表示源图像的序列号;d表示图像块的方向。

通过对比源图像中同一方向特征的差,方向权重wm,d(i,j)可以通过下式得到:

式中:M表示源图像的总数;T表示阈值。与周围的像素相比,噪声是不稀疏的并具有突变特性,导致Dm,d(i,j)非常大。因此,通过对比Dm,d(i,j)与阈值T可以抑制或消除噪声。融合后的像素p(i,j)可以通过下式加权求和得到:

式中:N表示方向特征的总数。如图3 所示,当窗口的大小为5×5时,N=24。

3 实验结果与分析

为了验证提出的图像融合算法的性能,将该算法与一些经典、先进的图像融合算法进行对比,包括基于向导滤波(GFF)的图像融合算法[21]、基于稀疏表示(SR)的图像融合算法[22]、基于小波变换(DWT)的图像融合算法[6]、基于深度卷积神经网络(CNN)的图像融合算法[11]、基于多尺度加权梯度(MWGF)的图像融合算法[23]、基于多尺度分解和稀疏表示(MST(NSCT)-SR)的图像融合算法[24]、基于非下采样剪切波变换(NSST-max)的图像融合算法[25]以及当下比较流行的基于生成对抗网络(GAN)的图像融合算法[10]。其中,对于NSST-max算法,采用基于取最大的融合规则。

为了评价上述图像融合算法的性能,采用主观评价和客观评价相结合的方法。客观评价指标[26]包括QMI、QNCIE、QG、QP、QY、QCB。QMI和QNCIE是基于信息论的指标,分别测量源图像与融合图像的互信息和非线性相关信息,分别由下式得到:

式中:RMI(A,F)、RMI(B,F)分别表示源图像A、B与融合图像F的互信息;H(A)、H(B)、H(F)分别表示图像A、B、F的熵;λi表示非线性相关矩阵的特征值;b表示图像的强度等级,通常b=256。QG和QP是基于图像特征的指标,分别测量转移的边缘信息和图像特征,表达式如下所示:

式中:QAF(i,j)、QBF(i,j)分别表示在位置(i,j)处源图像A、B到融合图像F的边缘信息保留值;wA(i,j)、wB(i,j)表示对应的权重;Pp、Pmax、Pmin分别表示相位一致性、最大矩和最小矩;α、β、γ表示系数,可以根据对应分量的重要性调整。QY是基于图像结构相似度的指标,根据结构相似度区别地对待冗余和互补区域,由下式得到:

式中:SSSIM表示图像的结构相似度;wW表示在窗口W中的局部权重。QCB是基于人类视觉感知的指标,与人类的视觉感知一致,由下式得到:

式中:QGQM(i,j)表示全局质量图中的元素。这些指标的值越大,对应的融合图像越好。

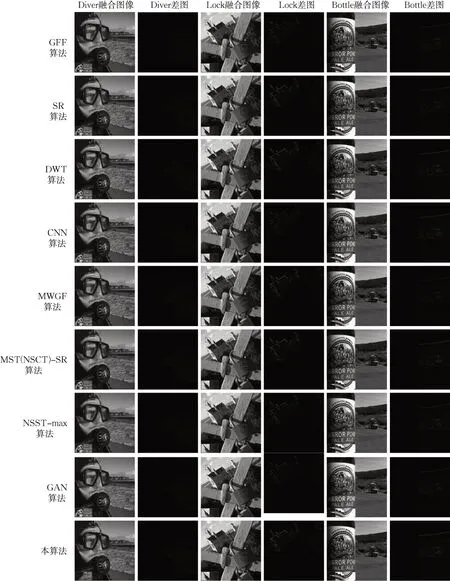

3.1 单模态图像融合对比实验

图4 显示了取自Lytro 数据集的典型彩色多聚焦源图像,融合结果如图5所示。图4中第一行的源图像与融合图像的差图显示在图5对应融合图像的右侧,反映了融合算法将信息从源图像传递到融合图像的能力。

图4 多聚焦源图像Fig.4 Multi-focus source images

图5 融合图像和差图Fig.5 Fused images and difference images

图5的第四列和第六列的差图中存在明显的残差信息,即对应源图像的失焦区域被另一源图像相同位置的聚焦区域替代。基于向导滤波的空间域融合算法在由同一传感器得到的具有更多冗余信息的图像融合方面具有更好的能力,尤其是多聚焦源图像融合。虽然由CNN 得到的融合图像具有不错的视觉效果,但是基于深度学习的算法在无法提取图像特征时可能无效,并且需要可用的数据库。对比结果表明,所提出的图像融合算法对于多聚焦源图像融合更为有效,具有更为满意的视觉效果。

使用客观指标对Lytro 数据集中的20对多聚焦源图像得到的融合图像进行客观评价,每个指标的客观值如表1 所示。可以看到,所提出的算法优于其他图像融合算法,得到的融合图像在Lytro数据集中的整体视觉效果较好。

表1 Lytro数据集中融合图像指标值Tab.1 Index values of fused image in Lytro dataset

3.2 多模态图像融合对比实验

进行对比实验以验证所提算法的有效性和泛化能力,以红外和可见光图像为例。红外图像通过红外感知目标表面温度生成,如图6a所示;可见光图像基于反射特性生成,如图6b所示。图6c、d为医学源图像。

图6 多模态源图像Fig.6 Multi-modal source image

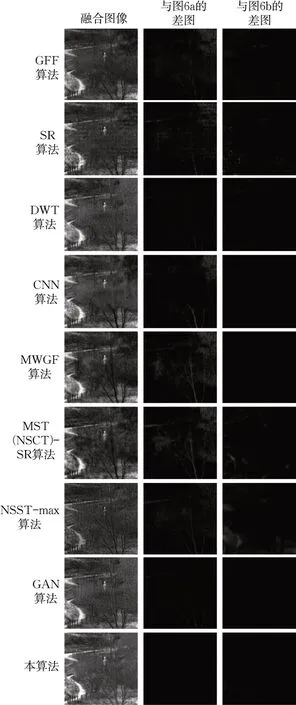

图7和图8为图6的融合图像。与图4中单模态的源图像相比,多模态源图像包含着更多的互补信息和一些冗余信息。因此,差图包含的信息越少,对应的融合图像越好,融合图像中包含的转移信息则越多。可以发现,几乎每种图像融合算法在多聚焦源图像上的融合效果都优于其他种类的源图像。这种现象可以归因于多聚焦源图像具有更多的相似性和冗余信息,易于融合在一起。与之相反,医学图像、红外和可见光图像产生于不同的传感器,具有更多的互补信息,需要更精确的算法。

图7 红外和可见光融合图像与差图Fig.7 Infrared and visible fused images and difference images

图8 医学融合图像与差图Fig.8 Medical fused images and difference images

由于一些算法如CNN 和MWGF 是针对多聚焦源图像提出的,因此由它们得到的融合图像的视觉效果较差。GAN算法是针对红外和可见光图像融合而设计的,得到的融合图像更适合人类视觉系统。对于如图8所示的医学图像融合,基于变换域的算法(如DWT、NSST-max)得到的融合图像的视觉效果更好。通过对比差图可以发现,MST(NSCT)-SR、NSSTmax 融合图像的信息是不完整的。

表2、3 为图7 和图8 中融合图像的客观评价指标值。结果表明,所提出的算法具有更好的融合结果。

表2 红外和可见光图像融合图像的客观指标值Tab 2 Objective index value of infrared and visible fused images

表3 医学图像融合图像的客观指标值Tab 3 Objective index value of medical fused images

4 结语

结合多尺度分解和形态学成分分析,提出了一种多形态学成分分析算法来实现图像融合。综合考虑源图像中同时存在的冗余和互补信息以及不同子图像的信息特征,还提出了一种基于联合稀疏表示和方向特征的融合规则。对单模态和多模态源图像的一系列对比结果表明,所提出的算法对于多样化的图像融合是有效的,可以实现更完整的信息转移并得到更适合人类视觉系统的融合图像。由于采用了包括形态学成分分析和联合稀疏表示的稀疏表示,相比传统的图像融合算法,需要大量的字典训练和稀疏编码计算,算法整体复杂度偏高,在一定程度上影响了算法的实时性。在未来的研究中,计划对字典获取方式和稀疏编码进行进一步的改进与优化。

作者贡献声明:

马晓乐:论文初稿撰写,调试相关实验。

王志海:校核论文,参与论文的修改。

胡绍海:指导论文思路和框图,参与论文的修改。