AI智能算力云计算数据中心供配电系统探究

2023-12-29龙熹

龙熹

1. 腾讯科技(深圳)有限公司 广东 深圳 518063;2. 腾讯云计算(北京)有限责任公司 北京 100000

引言

近年来,5G+、大数据、物联网等技术的发展显著加快,基于数据和算力的AI产品在很多领域都有成功应用,带动了云计算数据中心行业的总体发展,特别是近期ChatGPT产品发布带来的大模型训练浪潮,让数据中心服务器从计算加存储的通用服务器时代进入了追求极致算力的AI服务器时代,加速了数据中心供配电技术变革。当前,数据中心领域对GPU高算力服务器的需求逐年递增,但匹配AI智能算力服务器的数据中心供配电系统的设计难度大、要求高,相关人员必须遵循行业规范,并根据AI算力的特点来优化设计,保障数据中心供配电系统的性能及功能。

1 Al智能算力云计算数据中心供配电系统

世界进入了AI时代,为满足各行各业的实际需求,互联网公司数据中心向云计算、高算力方向的发展成为必然趋势。云计算数据中心可整合计算、网络等资源,提供优质化、精准化服务,以创造更大的价值[1]。同时数据中心的AI算力大小决定了其大数据分析和大模型训练的能力,成为当前重要的数据中心性能指标,数据中心供配电系统的建设需匹配变化趋势。不同于传统的供配电系统,服务于AI算力的云计算数据中心供配电系统需融合多种软硬件技术,并兼具智能化、一体化、模块化特点,能进行实时监测、智能故障分析,并依据算力服务器的特点优化供配电方式,满足AI算力基础设施高效、经济、智能化需求。

2 Al智能算力数据中心供配电系统设计要点

在通用大模型浪潮的推动下,为了满足生成式AI不断增长的需求,以大功率GPU芯片为主的AI算力服务器在新数据中心建设规划中将占据重要份额。相比普通服务器采用GPU芯片的AI服务器对于数据中心供电架构方面有着不同要求。

2.1 数据中心供配电系统要求

2.2.1 电力需求:AI服务器通常具有更高的功耗需求,因为它们需要更多的计算资源来处理复杂的AI任务,AI服务器的功率从750W、1500W、4500W、8000W等不同档次逐步向高端集中,因此,AI服务器需要更强大的电力供应来满足其高功耗需求。

2.1.2 电力密度:由于AI服务器的功耗较高,其电力密度(即每个机柜或机架的功率密度)通常比普通服务器更高。这意味着在设计数据中心供电架构时,需要考虑如何提供足够的电力密度,以满足AI服务器的需求。单个机柜的功率将从目前主流的8~10kW提升到24~70kW,同时这意味着数据中心的电力需求和散热需求将大幅增加,给数据中心的设计、建设和运维带来更大挑战。

2.1.3 散热和冷却:由于AI服务器的功耗较高,它们产生的热量也更多,越来越接近风冷散热的极限,这需要采用更强大的散热冷却系统,比如采用液冷或风液混合的散热方案;同时由于散热功率提升导致单个机柜的冷却设备、通风设备的占地面积增加,意味着更高的散热冷却系统成本;另一方面,单个机柜的功率增加使得热保护关机时间减少,基本上没有机会做保护的动作,这就要求在服务器制冷侧要做连续制冷。

2.1.4 线路容量:由于AI服务器的功耗较高,它们需要更多的电力供应。因此,在数据中心供电架构中,需要确保电力线路具有足够的容量。

2.2 数据中心架构设计原则

2.2.1 高性能:AI数据中心的计算资源、网络资源、基础设施资源具有较高的信息处理与吞吐能力,网络应充分满足数据交换与传输速度,不用存在阻塞,具备对突发流量、突发计算量的承受能力。供配电系统的建设必须遵循为高性能业务服务的原则。并兼顾技术经济性。

2.2.2 扩展性:AI数据中心应具有良好的灵活性与可扩展性,能够根据今后的业务不断深入发展的需求,扩大设备容量与提高用户数量与质量的功能。在供配电系统设计时充分考虑后期的扩容,以及功率弹性。

2.2.3 适应性:供配电系统应能满足标准要求,同时确保各子系统具有良好的电磁兼容性和电气故障隔离功能,当某一点故障时快速实现故障隔离,不影响其他设备连续供电。

2.2.4 可用性:供配电各系统的设计应满足标准要求,工作安全可靠。并在关键部件设计硬件冗余、备份等可靠性技术上采用相关软件技术提供较强的管理机制,控制方法,实现故障监控以及安全授权的措施,提高数据中心可用性。

2.2.5 稳定性:供配电设计应在成熟且广泛应用的基础上追求系统的先进性,做到方案和产品的最优结合,同时考虑系统运行的稳定。

2.2.6 可维护性:对供配电系统采用模块化设计,产品的冗余设计作为重点需求指标。对硬件、软件供应商的实施和售后服务能力进行详细的要求,并准备对应预案。

2.2.7 经济性:以较高的性价比规划、设计和建设数据中心供配电系统,达到投入产出比最大值,确保数据中心安全运营的基础上合理降低Capex和Opex。

2.2.8 节能与环保:供配电规划和设计要采用高效的供配电技术,实现充分的节能与环保要求,实现绿色数据中心。

3 高算力数据中心供配电系统方案对比

AI智能算力数据中心建设要求应满足GB50174 - 2017《数据中心设计规范》在附录“电气”中规定:A级数据中心应满足容错要求,可采用2N系统,也可采用其他避免单点故障的系统配置。A级数据中心供配电系统主要有3种架构:2N、DR、RR[2]。

3.1 各供配电系统架构的特点

3.1.1 2N供配电系统。由两个供配电单元组成,每个单元均能满足全部负载的用电需要,两个单元同时工作,互为备用。正常运行时,每个单元向负载提供50%的电能,当一个单元故障停止运行时,另一个单元向负载提供100%的电能。这种多电源系统冗余的供电方式,克服单电源系统存在的单点故障瓶颈,增加了供电系统可靠性。但是由于设备配置多、成本高,通常情况下效率比N+X系统低。

3.1.2 DR供配电系统。DR是Distribution Redundancy的简称,意思是分布冗余。由N(N ≥ 3)个配置相同的供配电单元组成,N个单元同时工作。将负载均分为N组,每个供配电单元为本组负载和相邻负载供电,形成“手拉手”供电方式。N=3的DR系统正常运行情况下,每个供配电单元的负荷率为66 %。当一个供配电系统发生故障,其对应负载由相邻供配电单元继续供电。

3.1.3 RR供配电系统。RR是Reserve Redundancy的简称,意思是后备冗余。由多个供配电单元组成,其中一个单元作为其他运行单元的备用。当一个运行单元发生故障,通过电源切换装置,备用单元继续为负载供电。

3.2 三种架构供配电系统对比分析

3.2.1 可用度对比。采用电气分析软件ETAP对2N、DR、RR 3种架构的可用度进行分析。

从可用度数值来看,2N、DR、RR 3种架构的可用性大致相同,2N系统可用性最高。

表1 三种架构可用度对比表

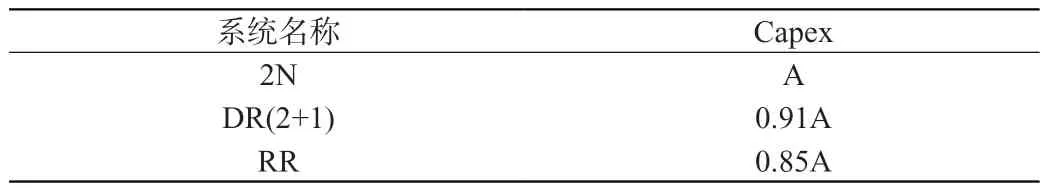

3.2.2 成本对比。建设成本、运行成本(电费)对比分析如下表所示(假设2N系统为A)。

表2 三种架构成本对比表

建设成本2N系统最高,DR系统比2N系统低9 %,RR系统比2N系统低15 %;运行成本RR系统最高,DR系统最低。

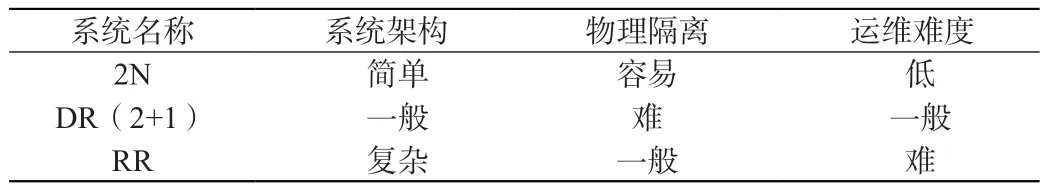

3.2.3 系统架构、物理隔离、运维难度对比。

表3 三种架构复杂性、隔离、运维难度对比表

2N系统架构简单明了,容易实现物理隔离,日常运行维护难度最低;RR系统架构最复杂,日常运行维护难度很高,设备切换需要依靠自动控制系统完成,手动控制难度很大,需要很强大的运行维护团队进行运维保障,对运维专业度要求很高,优点是成本低[3-4]。

3.3 供配电架构对比分析

综上所述,高算力数据中心供配电架构按照当前主流的2N架构设计往DR方案演进2+1方案,后续持续演进到3+1是可行的,如进一步加强运维保障团队则可在确保供电可靠性的基础上进一步优化成本。

4 服务器分布式供电和集中式供电的对比

4.1 分布式供电方案

目前服务器的分布式供电方案基本采用标准通用冗余电源(Common Redundant Power Supplies,CRPS)电源,通用服务器通常采用2个(1+1)12V输出CRPS的方案,GPU服务器可采用6个(3+3或者4+2)54V输出 CRPS(给GPU供电),再加2个(1+1)12V输出CRPS的方案(给主板供电)。

4.2 集中式供电方案

服务器集中式供电方案通常采用计算机电源(Power Supply Unit,PSU)设置,采用10+2或者11+1的冗余设计,额定功率可以达30~33kW,单个PSU功率为3kW;具备集中式电源管理功能,可以兼容19”和21”服务器布置,预留接口兼容冷板液冷服务器。PSU兼容交直流输入(AC 220V、DC 240V),内建ATS功能,可以预设两路输入的工作状态控制两路输入的转换。监控单元具备实时数据汇报、PSU状态监视和工作状态控制、在线升级等功能[5]。

4.3 两种服务器供电方案对比

4.3.1 供电效率:目前的CRPS方案的理论效率最高值为94%。在GPU应用场景下,PSU供电链路采用集中供电效率为95.5%,相比CRPS方案可提升1.5%。

4.3.2 电源总容量:CRPS采用2N的冗余,集中供电采用N+X的冗余。总电源容量以单柜30kW布置为例,CPRS方案需要配置60kW的电源;集中电源按常见布置为N+2的冗余,总电源容量为36kW,即采用集中供电,电源总需求容量降低40%左右。

4.3.3 成本:目前的集中电源产业链不成熟,供应量低,效率与钛金电源相同;产业链成熟后,按照物料成本至少可以做到现在的85%,降本空间较大。

4.4 两种服务器供电方案对比

综上所述,集中式供电方案电源效率更高,对电源总容量要求更低,后续的成本优化空间也较大,在AI算力的GPU服务器供电上有较高的应用价值。

5 结束语

AI智能算力云计算数据中心的设计难度较大,虽行业内陆续出台了相应的参考标准,也开展了一些技术探索,但在具体的设计过程中相关人员需从AI高算力的特点着手,优化设计理念,提升数据中心供配电系统的适配度、可靠性和单位算力的降本能力。