基于多尺度特征注意的遥感图像语义分割方法

2023-12-26赵春晖闫奕名

王 涵,赵春晖,闫奕名

(哈尔滨工程大学 信息与通信工程学院,哈尔滨 150001)

0 引 言

遥感影像作为一种包含大量地面信息的图像载体,在气象监测、防震减灾、军事战争及日常生活[1-4]等领域有着广泛的应用。语义分割是对图像进行逐像素分类的任务,目前在土地覆盖分类、智慧城市和智慧交通等方面发挥着重要作用,张锐等[5]结合了超像素分割的方法对高分辨率影像进行分割,借助高分辨率图像中明显的纹理和色彩信息设计了一种相似度测量方式,并在产生的超像素块上应用分水岭算法以实现精细的分割。自深度学习出现以来,基于卷积神经网络的语义分割模型占据了主流。针对遥感图像中的长距离上下文关系对分割准确性的影响,Mou L[6]提出了空间关系模块和全局关系模块以学习任意两个空间位置或特征映射之间的全局关系,从而生成关系增强的特征表示。针对遥感图像中前景背景不平衡的问题,Zheng Z[7]设计了前后景关系模块并增强前景关联的上下文,同时通过前景感知优化抑制背景,提高了对前景信息的识别能力。Li X[8]针对遥感图像背景的复杂性,提出了点级别的相似性传播模块减少背景噪音,并设计了双点匹配器对特征显著区域和边界区域进行类别匹配。Seong S等[9]为了在高分辨率的图像中提高城市建筑物的分割精度,在HRNet[10]中加入了门控通道和空间注意力机制,提高了对复杂建筑和与周边地区特征相似的大型建筑的分割精度。为了使高分辨率影像的分割适用于实时场景,Bello I M等[11]在网络结构中嵌入了密集连接的设计,使梯度可以轻松地在网络中传播,显著提高了网络的表示能力,且具有较少的训练参数。Transformer[12]因其强大的长距离建模能力而被应用于计算机视觉领域,Wang L等[13]提出了一种将Transformer与卷积结合的双边感知网络,利用依赖路径和纹理路径分别提取长距离关系和细粒度细节,并利用一种线性注意力进行特征的融合,取得了先进的效果。

与自然场景图像相比,遥感图像包含了更丰富的信息量,覆盖范围更加广阔,因此也存在图像中不同类别地物尺度相差甚大,或某些地物类别内部存在较大的尺度方差的问题。随着遥感技术的发展,获取到的遥感影像图像分辨率也逐渐提高,图像纹理更加清晰而产生的类内方差也给分割带来了难度。提出了一种基于多尺度特征聚合和通道注意增强的语义分割方法:基于图像的多尺度特征和注意力机制,提出了一种遥感图像语义分割方法。该方法能够对遥感图像实现端到端的语义分割,且能够在遥感图像中尺度差异较大的地物类别和类内方差较大的类别上实现较高的分类精度,实现智能准确的语义分割。为提高网络对多尺度特征的提取及融合效果,提出了一种双向聚合的特征金字塔网络(Bidirectional Aggregation Feature Pyramid Network,BAFPN),通过双向融合和跳跃连接的方式充分融合图像的底层和高层特征,对多尺度特征进行增强。为适应高分辨率遥感图像较大的类内方差,引入了一条并行的通道注意力分支(Parallel Channel Attention,PCA)用于分配注意力权重,提高特征表达。同时,设计了一个特征聚合模块(Feature Aggregation Module,FAM)进行特征融合,并使用空洞卷积来降低计算成本。

1 方 法

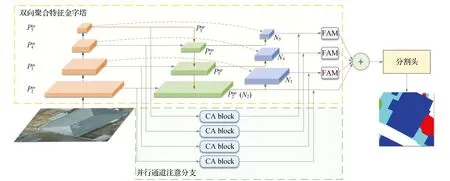

遥感图像的语义分割中,多尺度的特点要求网络有效地融合语义信息丰富的高层特征和保留细节信息的低层特征,并选择关键特征进行增强。为此,本文设计了一种基于Transformer的多尺度特征注意网络,使用Swin Transformer block[14]构成特征提取的主干网络,经过双向聚合特征金字塔网络BAFPN获得增强的多尺度特征;由通道注意力块(Channel Attention block,CA block)构成一条并行的通道注意分支,沿通道维度推导注意力图,用于自适应特征细化;由特征聚合模块FAM对特征进行融合,提取出具有丰富多尺度信息和关系增强上下文的特征(图1)。

图1 网络整体结构Fig.1 Overall network structure

1.1 双向聚合特征金字塔网络

高分辨率遥感图像中的多尺度物体给语义分割带来了困难。小尺度图像的特征主要编码大物体,而大尺度图像的特征更多地响应小物体。多尺度特征融合可将不同分辨率的特征进行有效的融合。尽管最初的特征金字塔网络(Feature Pyramid Network,FPN)[15]使用自顶向下的方法来组合多尺度特征,但仍然受到单向信息的限制。与FPN相比,本文增加了一条自底向上的路径,通过双向融合的方式对多尺度特征进行增强,同时将同层输入节点跳跃连接到自底向上路径的同层输出节点,在不增加额外计算的情况下,使特征融合得更充分。

由于不同的输入特征对应不同的分辨率,它们的贡献是不相等的。因此,在特征融合阶段为每个输入设置额外的权重[16]:

(1)

其中wi是一个可学习的权重,并通过一个ReLU激活函数来保证wi≥0;ε=0.000 1是一个很小的值,用来避免计算出现数值不稳定。

(2)

(3)

(4)

(5)

其中,Conv为一个深度可分离卷积后接一个BN层组成的结构;Up为最近邻插值上采样;w0,w1为分配给不同特征的权重。

双向聚合后的特征金字塔输出特征{N2,N3,N4,N5}融合了不同分辨率的图像特征,可表示为

(6)

(7)

(8)

(9)

其中,Down为最大池化下采样。

1.2 并行通道注意力分支

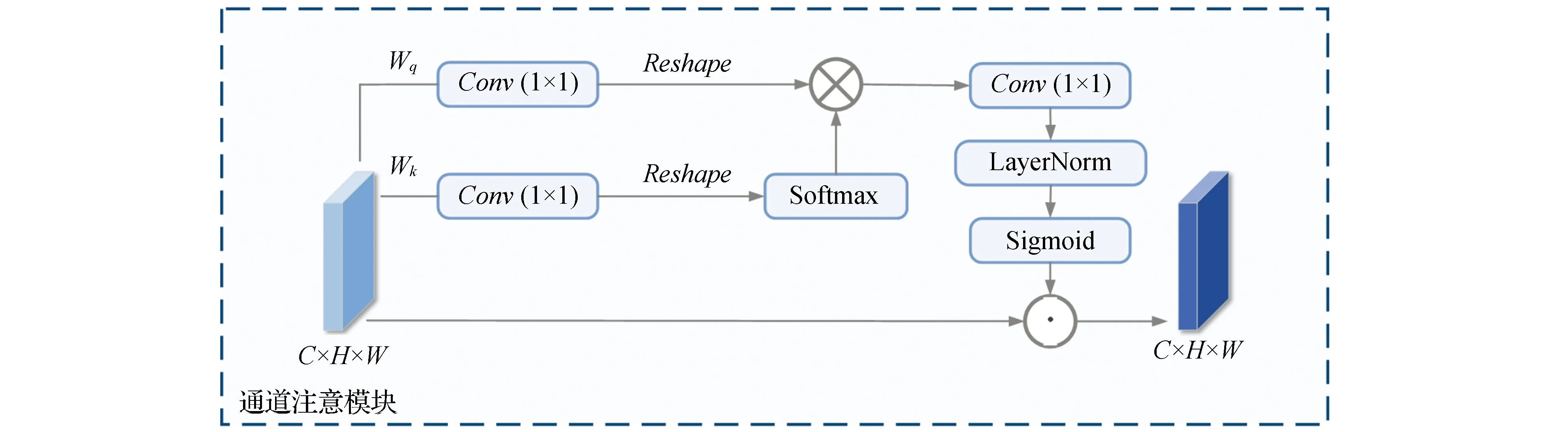

1.2.1 通道注意模块CA block

在语义分割网络中,特征图中的每个通道都是对分割对象的重要响应。在高分辨率遥感图像中,虽然高分辨率带来了更加丰富的信息量,但图像纹理更加清晰,地物类别的表面信息也更加丰富,造成了类内方差大的问题,容易导致语义类别的混淆。

通道注意机制通过显式地建模通道之间的相互依赖关系为每个特征通道生成权重。不同的特征通道对语义类别判断的贡献是不相等的。因此,对于贡献较大的通道,应赋予较高的权重。基于这种考虑,设计了并行通道注意分支生成每个特征映射通道的权重,目的是为了提取到图像中更为关键的分类特征。通过利用不同通道之间的关系,进一步增强了不同语义类别的特征表示。每个通道注意模块(CA block)的结构见图2。

图2 通道注意力模块Fig.2 Channel attention block

将输入变量表示为X∈RC×H×W,其中C,H,W分别为输入图像的通道数、高度和宽度。计算通道注意力,首先将输入变量通过一个标准的1×1卷积来对通道数进行压缩。然后,通过reshape操作将查询特征图(query)和键特征图(key)分别变形为C/2×HW和HW×1×1。参考Liu H[17]的设计,在瓶颈张量处(注意块中最小特征张量),使用针对二维高斯映射的softmax归一化函数进行非线性激活,增加特征的动态注意范围;使用针对二项分布的Sigmoid激活函数进行类别映射。经过通道注意计算,相似性矩阵的计算公式可表示为

A(X)=Fsg[Wv((σ1(Wq(X))×Fsm(σ2(Wk(X))))]

(10)

其中,Wv,Wq和Wk均为1×1卷积;σ1,σ2为reshape操作;Fsm(·)为一个softmax算子,其运算公式可写为

(11)

“×”代表矩阵点积运算,Fsg(·)为一个sigmoid函数。通道注意力模块的输出表示为Z=A(X)·X∈RC×H×W,其中“·”为乘法运算。

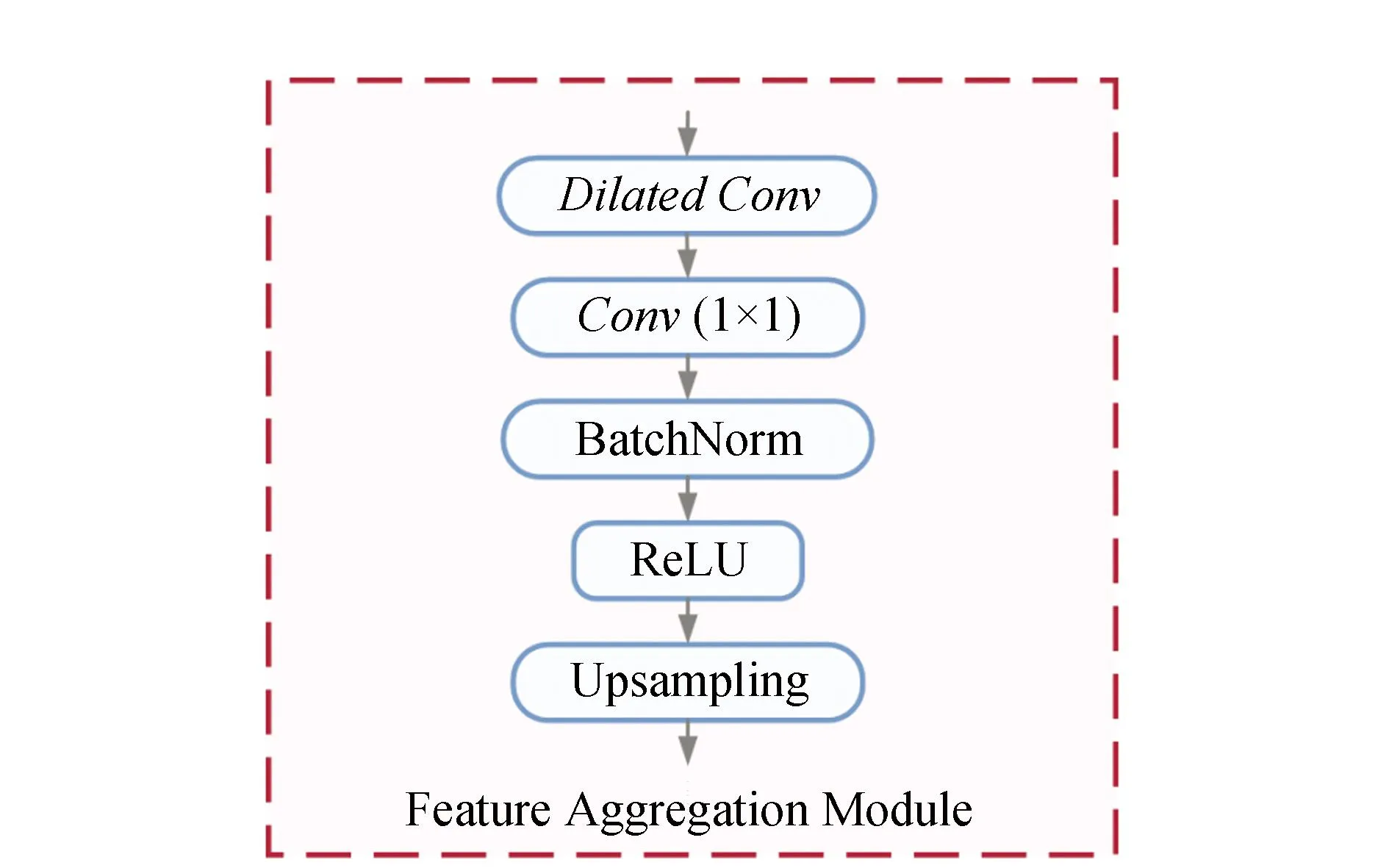

1.2.2 特征聚合模块FAM

将双向聚合特征金字塔输出的特征与并行通道注意力分支的输出相加后,通过一个特征聚合模块FAM来对特征进行聚合。其结构见图3。

图3 特征聚合模块FAMFig.3 Feature aggregation module

由图3可见,每层输入的特征经过一个空洞卷积,使用空洞卷积的目的是减小计算量;通过一个1×1的卷积调整通道数,再通过归一化层和ReLU激活函数;进行上采样到输出图像大小。

2 实验结果与分析

2.1 数据集介绍

采用两个开放基准数据集ISPRS Vaihingen和Potsdam数据集(https://www.isprs.org/education/benchmarks/UrbanSemLab/semantic-labeling.aspx)进行实验,以评估所提出的网络性能。ISPRS Vaihingen数据集由33个图像块组成,平均大小为2 494×2 064像素。地面采样距离(ground sampling distance,GSD)为9 cm。按照基准方法的划分方式使用数据,即其中16张图像作为训练集,其余17张图像作为测试集。ISPRS波茨坦数据集包含38个GSD为5 cm的图像块。所有图像块的大小均为6 000像素×6 000像素。其中编号为7_10的图片有部分标注错误,除此之外,其余23张训练图像用于训练,14张用于评估模型。两个数据集均含有5个地物类别,分别为不透水地表、建筑、低矮植被、树木和车辆。实验中,图片在训练时被随机裁剪为1 024×1 024大小。

2.2 结果展示与分析

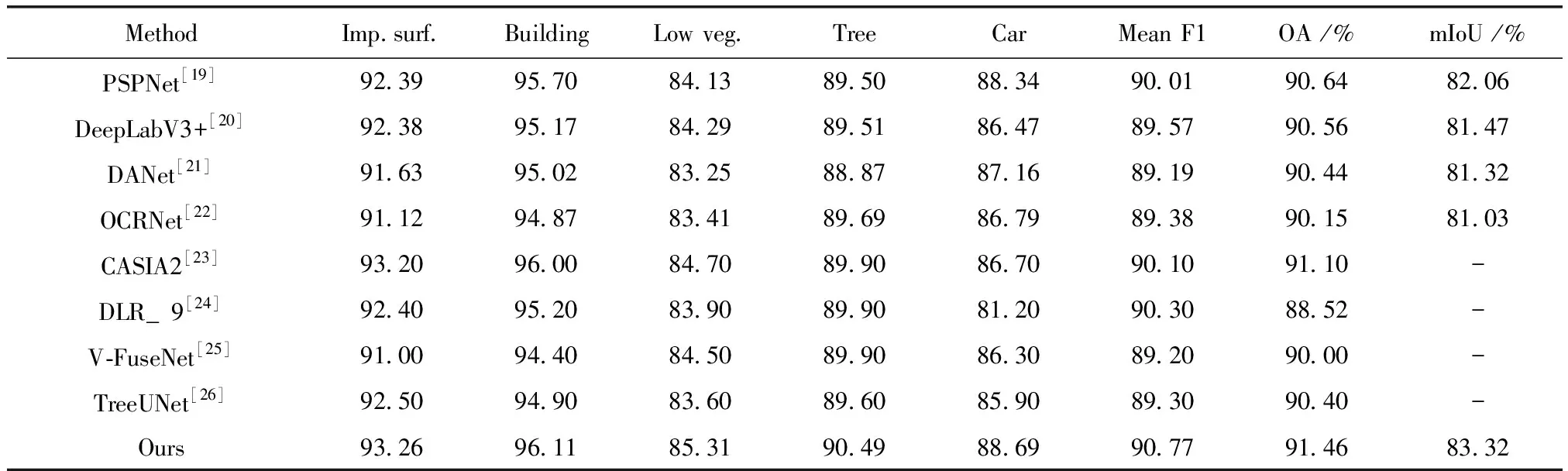

在语义分割中,平均交并比(Mean intersection over union,mIoU)、F1分数(F1-score)和总体精度(Overall accuracy,OA)分别为3个被广泛使用的评估指标。选用上述3指标作为方法有效性的评估标准,具体计算方式可参见文献[18]。表中显示了每个类别的F1分数;OA计算了包括背景在内的所有类别的总体精度。本文方法及其他对比方法在ISPRS Vaihingen和Potsdam数据集上的评价精度分别见表1、表2。

表1 Vaihingen测试集定量比较结果Table 1 Quantitative results on Vaihingen test

表2 Potsdam测试集定量比较结果Table 2 Quantitative results on Potsdam test

由表1和表2可见,本文提出的方法相比于DeepLabV3+、PSPNet等自然场景的语义分割方法,以及V -FuseNet、EaNet等针对遥感图像的语义分割方法,均达到了更高的精度。在Vaihingen测试集上的OA和mIoU分别达到91.46%和83.32%,在Potsdam测试集上OA和mIoU分别达到了91.91%和87.65%。在Potsdam数据集的结果上,本文方法在低矮植被(Low veg.)类别上,相比于表中该类精度第二的CASIA2的F1分数高出0.95%;在树木(Tree)类别上比排名第二的OCRNet高出1.41%。为了验证BAFPN结构及并行通道注意力分支的有效性,本文在两个数据集上分别进行了消融实验,其结果见表3。

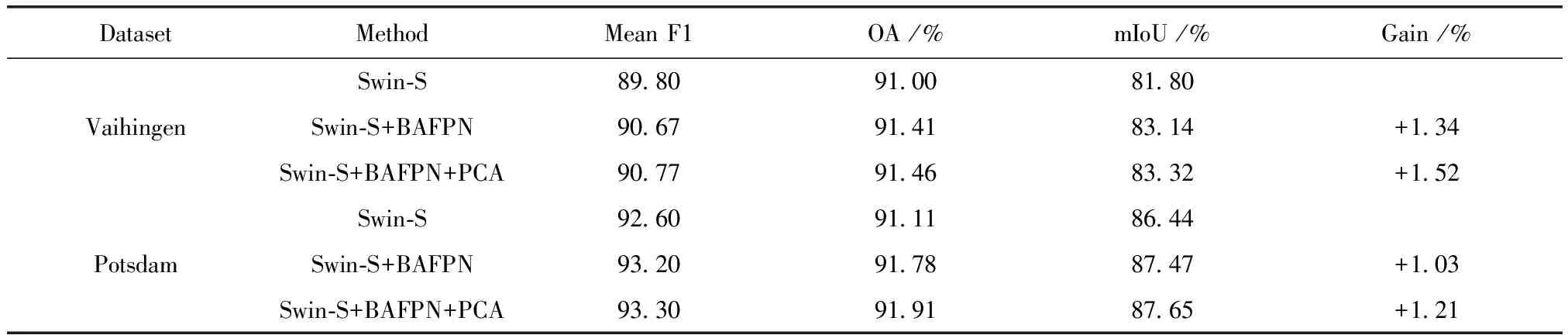

表3 消融实验结果

由表3可见,在Swin-S模型作为baseline的基础上,逐步添加BAFPN和PCA分支。在baseline之上加入BAFPN后,Vaihingen测试集的mIoU增加了1.34%,Potsdam测试集的mIoU增加了1.03%,说明了BAFPN结构通过双向地将主干网络提取到的浅层和深层特征进行充分的融合,增强了网络提取特征的能力,提高了分割网络对于遥感图像尺度变化的自适应能力。进一步加入PCA分支后,本文方法在Vaihingen和Potsdam测试集上的mIoU分别较baseline提高了1.52%和1.21%,表示PCA分支通过对不同层次特征进行通道维度上的注意力权重的分配,加强了对关键特征的利用能力。为了更直观地显示多尺度特征注意网络的有效性,不同方法的可视化结果见图4(上半部和下半部分别为Vaihingen数据集和Potsdam数据集)。

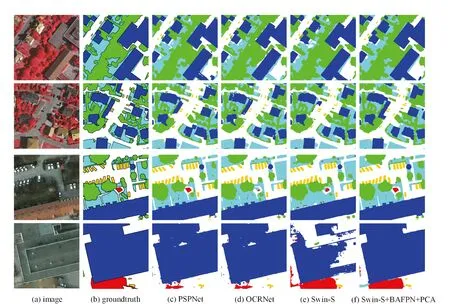

图4 可视化结果Fig.4 Visualization results

由图4可见,相比于其他分割网络,本文方法首先在分割边缘上更加清晰准确,说明BAFPN结构增强了对低层细节特征的提取能力。另外,所占像素较少或面积较小的物体能够被更精确的分类,同时类内尺度变化较大的类别(如建筑物,标签为蓝色)也得到更为准确的分类,说明本方法提高了对多尺度特征的利用能力。最后,纹理复杂的大物体中像素的错分也大大减少,说明方法对关键特征的利用得到增强。综上所述,本文方法提出的多尺度特征注意方法能够在遥感图像中实现更准确有效的语义分割。

3 结 论

提出了一种基于多尺度特征注意网络的遥感图像语义分割方法。多尺度信息对语义分割至关重要,因此首先设计了一种双向聚合多尺度信息的BAFPN,能够将具有更多细节信息的底层特征与语义信息丰富的高层特征进行充分融合,从而更有效地获取图像的多尺度信息。同时,通过PCA 分支对每层的特征进行通道注意力增强,从而提高语义分割的准确性。通过在ISPRS Potsdam 和Vaihingen 数据集上的实验,从定量和定性方面验证了本文方法的有效性,在遥感分割的应用中具有巨大的潜力。