基于改进YOLOv5的蝴蝶兰花朵识别与计数

2023-12-11肖克辉杨宏苏章顺杨小丹

肖克辉 杨宏 苏章顺 杨小丹

摘要:为精确预测蝴蝶兰产量和对蝴蝶兰的生产进行科学管理,对大苗时期的蝴蝶兰植株花朵和花苞进行识别与检测,统计其花量。由于蝴蝶兰花苞目标体积较小,提出一种基于改进YOLOv5的蝴蝶兰花朵与花苞识别方法。首先,修改颈部网络的结构,在特征金字塔FPN(Feature Pyramid Network)和路徑聚合网络PANet(Path Aggregation Network)中引入有利于小目标检测的160×160尺度特征层,以提升对小目标的检测效果;其次,使用K-means++聚类算法针对训练集生成更合适的先验框,并采用载入预训练权重和冻结主干网络的训练方式,以使模型更加容易学习,提高网络模型收敛速度和泛化能力;最后,在颈部网络加入轻量级注意力机制,加强对目标的关注,减少背景干扰,以提升模型的特征提取能力。试验结果显示,该算法对花苞的检测精确率达到89.54%,比改进前提升9.83%;对花苞和花朵的平均精确率达到91.81%,比改进前提升5.56%。该算法有优异的检测精度并有效提高对小目标的检测能力。

关键词:蝴蝶兰花朵;深度学习;目标检测;YOLOv5;聚类算法;注意力机制

中图分类号: TP391.41: S6文献标识码:A文章编号:20955553 (2023) 11015508

Identification and counting of phalaenopsis flowers based on improved YOLOv5

Xiao Kehui Yang Hong Su Zhangshun Yang Xiaodan

(1. College of Mathematics and Informatics, South China Agricultural University, Guangzhou, 510640, China;

2. Key Laboratory of Smart Agricultural Technology in Tropical South China, Ministry of Agriculture and

Rural Affairs, Guangzhou, 510640, China)

Abstract:In order to accurately predict the yield of phalaenopsis and scientifically manage the production of phalaenopsis, this study identified and detected the flowers and buds of phalaenopsis plants in the big seedling stage and counted the number of flowers and buds. Due to the small target volume of phalaenopsis bud,, a phalaenopsis flower and bud recognition method based on improved YOLOv5 was proposed. Firstly, the structure of the neck network was modified in feature pyramid network and Path Aggregation Network. A 160×160 feature map was introduced to improve the detection effect of small targets. Secondly, the K-means++ clustering algorithm was used to generate a more appropriate anchor box for the training set, and the training method of loading pretraining weights and freezing the backbone network was adopted to make the model easier to learn and improve the convergence speed and generalization ability of the network model. Finally, a lightweight attention mechanism was added to the neck network to strengthen the attention to the target and reduce the background interference, to improve the feature extraction ability of the model. The experimental results showed that the AP of the algorithm for buds was 89.54%, which was 9.83% higher than that before the improvement, and the mAP of buds and flowers was 91.81%, which was 5.56% higher than that before the improvement. So, the algorithm has excellent detection accuracy and effectively improves the detection ability of small targets.

Keywords:phalaenopsis flower; deep learning; target detection; YOLOv5; clustering algorithm; attention mechanism

0引言

蝴蝶兰是我国花卉市场中占据份额较大的兰花品种之一[1]。对大苗时期已开放的花朵与未开放的花苞数量进行精确统计有助于预测蝴蝶兰产量,并且对实际生产的规划管理有重要意义。同时,对单株蝴蝶兰的花量统计有助于蝴蝶兰按等级分类,使用自动化的检测和识别手段,可以减少人工投入,提高生产效率。

基于卷积神经网络[2](Convolutional Neural Networks, CNN)的目标检测算法替代传统目标检测算法被广泛应用于计算机视觉中。相比传统目标检测算法需要依赖人为设计特征,卷积神经网络在提取特征时不用关心具体的特征,并且应用局部相关性和权值共享的思想,降低网络的参数量,使它在精度和效率上都有大幅提升。目前,CNN算法主要分为两类:一是两阶段目标检测算法,如RCNN[34](Regions with CNN features)系列、SPPNet[5](Spatial Pyramid Pooling-Net)等,其核心是先获得建议区域,然后在当前区域内进行精确的分類与位置预测。二是一阶段目标检测算法,如SSD[67](Single Shot MultiBox Detector)系列、YOLO[89](You Only Look Once)系列等,其核心是通过单个卷积神经网络处理图像,直接计算出目标的分类结果和位置坐标。

YOLO系列的算法具有高准确率和高检测速度的优点,特征提取也更着眼于整体,所以越来越多的YOLO系列的方法被应用在农业领域。Wu等[10]使用一种基于通道修剪的YOLOv4算法来检测自然环境下的苹果花,发现该算法对变化的果树品种和光照方向具有较好的鲁棒性。胡根生等[11]提出一种基于YOLOv5改进模型的茶尺蠖检测方法,该方法引入卷积核组来提高网络的特征提取能力,并更换边界框回归损失函数来减少前景和背景的类不平衡对检测结果的影响,发现该方法可以实现对茶尺蠖的准确检测。

由于上述基于YOLO系列的改进算法检测单一类型目标时,准确率较高,但针对多种类型目标时,平均准确率较低。且大苗时期的蝴蝶兰图像中,蝴蝶兰花苞具有尺寸小、分辨率低、遮挡较多等特点,容易造成漏检和误检。所以本文关注的主要问题是如何提高对蝴蝶兰花苞这种小目标检测的精确率,同时不会降低对蝴蝶兰花朵的检测效果。

本文在原YOLOv5x模型的基础上进行改进,对大苗时期的蝴蝶兰图像进行花朵识别和检测,解决小尺度花苞目标识别难的问题,通过获取照片中蝴蝶兰花朵和蝴蝶兰花苞2个类型的目标总数,提升单株或多株蝴蝶兰植株图像花量统计的精确程度,为蝴蝶兰植株大苗时期的花量科学管控以及花量预测提供参考。

1试验数据

1.1图像获取

本文试验数据采集自广东省广州市白云区钟落潭镇的广东省农业科学院白云实验基地。本文的试验数据由人工手持Nikon 1 J4数码相机拍摄获得,拍摄内容主要为单株和多株的大苗时期的蝴蝶兰植株,共计1 928张,均使用jpg格式保存。图1为收集的两幅图像。

1.2数据预处理

本文采用PASCAL VOC的数据集格式,使用LabelImg软件手工标注图像中蝴蝶兰的花朵和花苞,生成xml格式的标注文件。标注完成后,随机选择数据集中1552张作为训练集,183张作为验证集,193张作为测试集。

为了提高模型的泛化能力和鲁棒性,需要对数据集进行数据增强,增加数据集的样本数量与噪声数据。本文使用Mosaic数据增强方法[12],具体操作为每次随机读取4张图像,对这4张图像分别进行随机缩放、翻转、色域变换等数据增强方法,然后将4张图像从左上角逆时针拼接到一起并与调整后的标签一同传入网络中进行训练,如图2所示。Mosaic数据增强方法的优点在于检测目标的背景更丰富,且经过标准化BN(Batch Normalization)层时会同时处理4张图片,使得BN层求出的均值与方差更接近于整体数据集的均值与方差,增强了模型的鲁棒性。

2基于YOLOv5蝴蝶兰检测模型改进

YOLOv5架构根据复杂程度的递增分为4种模型,分别为s、m、l、x,本文选择复杂程度最高但同时精度最高的YOLOv5x进行改进。由于大苗时期大部分蝴蝶兰花苞目标面积占整副图像比例较小,极易造成漏检和误检。

针对这个问题,本文提出了一种改进的YOLOv5x模型,以增强对小目标的检测能力。首先,增加更大尺度的检测层,以提升对小目标的检测效果;其次,使用K-means++算法针对训练集聚类出更合适的先验框,以使模型更加容易学习;最后,在颈部网络加入CBAM注意力模块,以增加模型的特征提取能力。

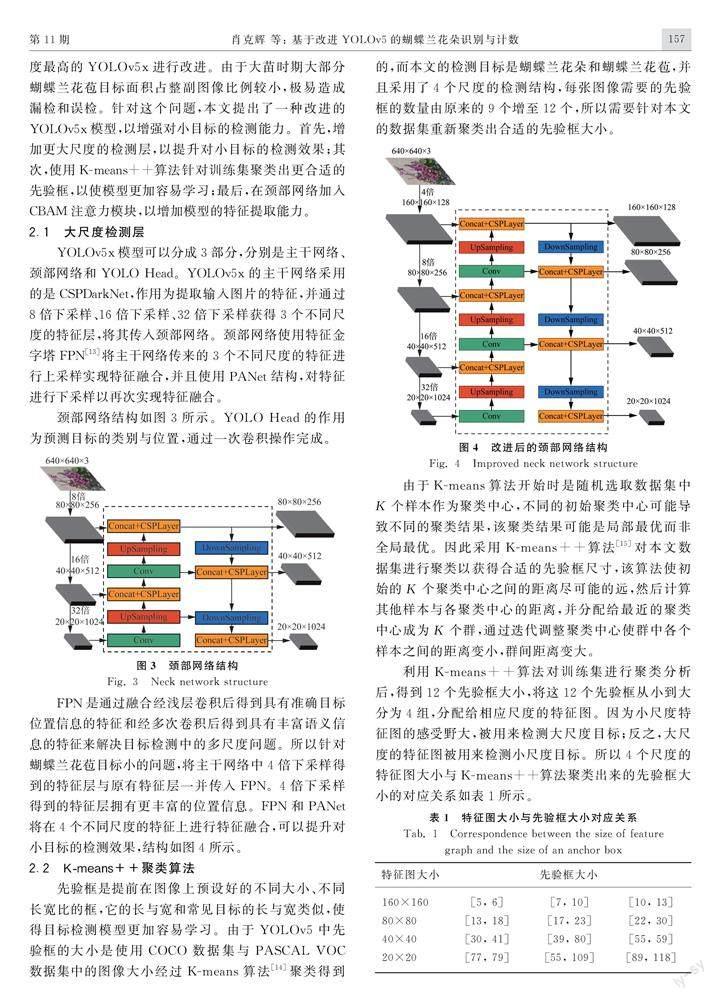

2.1大尺度检测层

YOLOv5x模型可以分成3部分,分别是主干网络、颈部网络和YOLO Head。YOLOv5x的主干网络采用的是CSPDarkNet,作用为提取输入图片的特征,并通过8倍下采样、16倍下采样、32倍下采样获得3个不同尺度的特征层,将其传入颈部网络。颈部网络使用特征金字塔FPN[13]将主干网络传来的3个不同尺度的特征进行上采样实现特征融合,并且使用PANet结构,对特征进行下采样以再次实现特征融合。

颈部网络结构如图3所示。YOLO Head的作用为预测目标的类别与位置,通过一次卷积操作完成。

FPN是通过融合经浅层卷积后得到具有准确目标位置信息的特征和经多次卷积后得到具有丰富语义信息的特征来解决目标检测中的多尺度问题。所以针对蝴蝶兰花苞目标小的问题,将主干网络中4倍下采样得到的特征层与原有特征层一并传入FPN。4倍下采样得到的特征层拥有更丰富的位置信息。FPN和PANet将在4个不同尺度的特征上进行特征融合,可以提升对小目标的检测效果,结构如图4所示。

2.2K-means++聚类算法

先验框是提前在图像上预设好的不同大小、不同长宽比的框,它的长与宽和常见目标的长与宽类似,使得目标检测模型更加容易学习。由于YOLOv5中先验框的大小是使用COCO数据集与PASCAL VOC数据集中的图像大小经过K-means算法[14]聚类得到的,而本文的检测目标是蝴蝶兰花朵和蝴蝶兰花苞,并且采用了4个尺度的检测结构,每张图像需要的先验框的数量由原来的9个增至12个,所以需要针对本文的数据集重新聚类出合适的先验框大小。

由于K-means算法开始时是随机选取数据集中K个样本作为聚类中心,不同的初始聚类中心可能导致不同的聚类结果,该聚类结果可能是局部最优而非全局最优。

因此采用K-means++算法[15]对本文数据集进行聚类以获得合适的先验框尺寸,该算法使初始的K个聚类中心之间的距离尽可能的远,然后计算其他样本与各聚类中心的距离,并分配给最近的聚类中心成为K个群,通过迭代调整聚类中心使群中各个样本之间的距离变小,群间距离变大。

利用K-means++算法对训练集进行聚类分析后,得到12个先验框大小,将这12个先验框从小到大分为4组,分配给相应尺度的特征图。因为小尺度特征图的感受野大,被用来检测大尺度目标;反之,大尺度的特征图被用来检测小尺度目标。所以4个尺度的特征图大小与K-means++算法聚类出来的先验框大小的对应关系如表1所示。

2.3CBAM

卷积注意力机制模块CBAM[16](Convolutional Block Attension Module)是一种结合了空间维度和通道维度的注意力机制模块。注意力机制模仿人类视觉系统看到图像时注意力有选择性地聚集于图像的显著部分的特点。通过注意力机制,图像的重要特征得到关注,不必要的特征被抑制。CBAM关注通道和空间这两个维度上的有意义特征,可以被集成到大部分网络模型中,在不显著增加计算量和参数量的前提下提升网络模型的特征提取能力。为进一步融合主干网络提取到的4个尺度特征图,分离出显著的特征,在颈部网络引入CBAM。

CBAM将通道注意力模块与空间注意力模块串联在一起,学习输入特征中不同通道和不同位置的重要性权值,然后将学习到的重要性权值与输入特征相乘,输出新的特征。通道注意力模块保持通道维度不变,压缩空间维度,因此该模块对蝴蝶兰花朵和花苞目标类别信息敏感;空间注意力模块保持空间维度不变,压缩通道维度,因此该模块对蝴蝶兰花朵和花苞目标位置信息敏感。CBAM结构如图5所示。

改进后的YOLOv5x模型结构如图6所示,基于改进YOLOv5的蝴蝶兰花朵识别与计数过程如下:(1)将任意输入的蝴蝶兰植株图像,经过Mosaic数据增强等预处理操作,将其转换为640像素×640像素×3通道的图像输入到改进的YOLOv5模型中。(2)在主干网络部分进行特征提取,将获取到的4个特征层输入到颈部网络。(3)在改进后的颈部网络进行特征融合,进一步提取特征。(4)将4个经过加强提取的特征层输入到YOLO Head,获得预测结果。

3模型训练

3.1试验环境

本文的实验环境配置如下:CPU为Intel Xeon(R) CPU E5-2620 v4;运行内存为64 GB;GPU为2块12 GB的Tesla K40c;操作系统为Ubuntu 16.04;NVIDIA驱动为418.87.00;编程语言Python与深度学习框架Pytorch的版本分别为3.7和1.2.0。

3.2训练过程

本试验输入图像大小为640像素×640像素,总训练代数设为150世代,批处理大小设为16,优化器选择SGD。初始学习率设为0.01,动量因子设为0.937,为防止过拟合,权值衰减设为0.000 5,门限值设为0.5,每个世代保存一次权值,采用余弦退火学习算法对学习率进行更新。

为缩短训练时间加快迭代收敛,并提升模型鲁棒性,本试验采取迁移学习[17]的方法进行训练。使用经过大型数据集训练的预训练权重,冻结主干网络训练前50世代,以调整非主干网络的权重。后100世代解冻主干网络,对整体网络进行训练。改进后的YOLOv5x模型训练损失如图7所示,其中蓝色折线代表训练集损失,黄色折线代表验证集损失。从图7中可以看出,训练集损失和验证集损失能较快地下降并在110世代开始收敛,显示出模型的有效性和可学习性。

3.3评价指标

4试验结果与分析

由于蝴蝶兰花朵目标体积较大,以下参与试验的各网络模型对其均有良好的检测效果,因此各试验将主要关注各网络模型对体积较小的蝴蝶兰花苞的检测效果,并分析造成该结果的原因。

4.1采用不同注意力机制的模型检测效果

为探究不同注意力机制对蝴蝶兰花苞的检测效果的影响,在已增加更大尺度检测层和经过K-means++算法重新聚类出合适尺寸先验框的YOLOv5x模型的颈部网络中分别加入SE[18](Squeeze and Excitation)模块、CA[19](Coordinate Attention)模块、CBAM模块,进行对比试验,试验结果如表2所示,其中None表示不加入任何注意力机制。P1、R1、F1_1、AP1为各网络模型检测蝴蝶兰花苞的准确率、召回率、F1得分、AP值,AP2為各网络模型检测蝴蝶兰花朵的AP值。检测效果如图8所示,其中红色框为检测到的蝴蝶兰花朵区域,蓝色框为检测到的蝴蝶兰花苞区域,方框上的数字表示被检测成相应目标的概率。

由表2可知,在已增加更大尺度检测层和经过K-means++算法重新聚类出合适尺寸先验框的YOLOv5x模型的颈部网络中加入CBAM模块相比加入SE模块、CA模块准确率分别高出1.27%、2.52%,召回率分别高出2.21%、8.45%。结合图8可知:加入SE模块相比加入CBAM模块,漏检的蝴蝶兰花苞较多,表明它只考虑重新衡量各通道的重要性而忽略了位置信息。加入CA模块相比加入CBAM模块,漏检的花苞较多,表明它虽然关注位置信息但在本文数据集上的效果并没有CBAM模块好。综上可知,将CBAM模块融合入颈部网络的改进方案表现出了更好的适应性和有效性。

4.2采用不同模型的检测效果

在相同的试验条件下采用不同网络模型进行对比试验,并计算各网络模型对蝴蝶兰花苞的准确率、召回率、F1得分、AP值,和对蝴蝶兰花朵的AP值,以及各模型的参数量,试验结果如表3所示。

由表3可知,改进后的YOLOv5x模型检测蝴蝶兰花苞的准确率比Faster RCNN、SSD、CenterNet[20]、YOLOv3、原YOLOv5x分别高出67.96%、55.29%、6.32%、22.75%、3.95%,在召回率上分别高出52.28%、57.58%、42.44%、23.70%、12.18%。参数量相比Faster RCNN少180.44MB,相比SSD、CenterNet、Yolov3、原YOLOv5x分别多242.71MB、217.86MB、106.15MB、162.96MB。并使用FPS(Frame Per Second)衡量检测速度,它表示算法在每秒钟内检测图片的数量。由表3可知,改进后的YOLOv5x模型的FPS比Faster RCNN高1.4,相比SSD、CenterNet、Yolov3、原YOLOv5x分别低5.24、4.02、2.44、1.68。检测效果如图9所示。

结合图9可知,使用Faster RCNN模型时,检测到的花苞数量很少,表明Faster RCNN只是将主干网络提取的最后一层特征信息作为区域生成网络和特征预测头的输入,不利于检测小目标。使用SSD模型时,检测到的花苞数量较少,且锚框尺寸偏大,表明SSD模型使用的锚框尺寸不合适。使用CenterNet模型时,检测到的花苞数量很少,且置信度较低,表明CenterNet模型只提取特征提取网络的最后一层特征信息,丢失了大量的花苞信息,不利于花苞的检测。使用YOLOv3模型时,检测到的花苞数量较少,且部分花苞边缘定位不准确,表明YOLOv3模型使用的锚框尺寸与图像中花苞的尺寸不匹配。使用原YOLOv5x模型时,其很少检测到靠近花梗顶部的体积较小的花苞,表明它对小目标的特征信息提取能力较弱。使用改进的YOLOv5x模型时,克服了原YOLOv5x模型的缺点,能检测到大部分体积较小的花苞,但是模型的参数量比原YOLOv5x多了近一倍,检测速度下降了37.58%。改进的YOLOv5x模型相比于其他各目标检测模型对小目标有最好的检测效果,表现出了极强的优越性,但代价是模型的参数量增多,检测速度降低。

4.3消融试验

本文对YOLOv5x的改进包括增加更大尺度检测层、使用K-means++算法重新聚类先验框尺寸和在颈部网络中加入CBAM模块。为研究各项改进及各项改进之间的组合对算法性能优化的程度,设计了消融实验,消融试验数据如表4所示,其中“√”表示向YOLOv5x模型中加入该项改进。

由表4可知,各项改进方法单独加入或组合加入YOLOv5x模型中均能有效提升模型对体积较小的蝴蝶兰花苞的检测效果。其中加入更大尺度检测层提升效果最明显,相比未加入时对花苞的AP值提升了8.63%,mAP提升了5.06%,但是参数量也增加了160.40MB。在YOLOv5x模型的颈部网络中加入CBAM模块并配合K-means++算法重新聚类先验框尺寸,相比未加入这两项改进,可以在参数量时仅增加1.56MB的情况下,对花苞的AP值提升5.98%,mAP提升3.88%。表明了本文各项模型改进方案的有效性和可行性。

4.4花量计数结果

采用训练后改进的YOLOv5x模型对测试集193幅图像进行测试,通过多个评价指标对模型的性能进行评价。测试集193幅图像共有蝴蝶兰花苞2084个,蝴蝶兰花朵817朵。对花量计数结果如表5所示,由表中数据可知,改进的YOLOv5x模型对于体积较小的蝴蝶兰花苞和体积较大的蝴蝶兰花朵均有良好的计数效果。

5结论

本文提出一种改进的YOLOv5x模型对大苗时期的蝴蝶兰的花朵和花苞进行检测,有效地提高对花苞小目标的检测效果,使对蝴蝶兰花量的统计更加精确。

1) 针对本文的蝴蝶兰数据集,利用K-means++算法重新聚类出新的先验框尺寸,相对于没有使用聚类时对花苞的检测精确率提升了3.24%。

2) 使用更大尺度检测层,相对于原YOLOv5x模型对花苞的检测精确率提升了8.63%,提升了对小目标的特征提取能力。

3) 在颈部网络中加入CBAM模块,相对于原YOLOv5x模型对花苞的检测精确率提升了3.23%,可以有效提高对目标特征的利用率。

4) 改进的YOLOv5x模型对花苞的检测精确率达到89.54%,比改进前提升了9.83%,平均精确率达到91.81%,比改进前提升了5.56%,高于其他5种经典的目标检测模型,且对蝴蝶兰花朵的检测精确率相比改进前提高了1.28%。

5) 为了探究在颈部网络加入CBAM注意力模块对最后检测效果的影响,本文设计了注意力模块对比试验,试验结果表明:CBAM模块相比于SE模块、CA模块在本文数据集上取得了最好的检测效果。并且为了探究各项改进对提升检测效果的贡献程度,本文设计了消融试验,试验结果表明:增加更大尺度的检测层能有效提升对小目标的檢测效果,但是参数量增加近一倍。

由于本文提出的模型对蝴蝶兰花苞仍存在漏检和误检,且模型参数量较大,后续可以进一步改进网络,以减少模型参数,提升运算速度并争取更好的检测效果。

参考文献

[1]王瑞华, 王俊. 中国蝴蝶兰产业现状及发展建议[J]. 湖北农业科学, 2018, 57(3): 45-47, 50.

[2]Lu Jinzhu, Tan Lijuan, Jiang Huanyu. Review on convolutional neural network (CNN) applied to plant leaf disease classification [J]. Agriculture, 2021, 11(8): 707.

[3]Girshick R. Fast R-CNN [C]. Proceedings of the IEEE International Conference on Computer Vision, 2015: 1440-1448.

[4]Jiang H, Learned-Miller E. Face detection with the faster R-CNN [C]. 2017 12th IEEE International Conference on Automatic Face & Gesture Recognition (FG 2017). IEEE, 2017: 650-657.

[5]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[6]Zheng W, Tang W, Jiang L, et al. SE-SSD: Self-assembling single-stage object detector from point cloud [C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 14494-14503.

[6]Belfodil A, Belfodil A, Bendimerad A, et al. FSSD-a fast and efficient algorithm for subgroup set discovery [C]. 2019 IEEE International Conference on Data Science and Advanced Analytics (DSAA). IEEE, 2019: 91-99.

[7]付中正, 何潇, 方逵, 等. 基于改进SSD网络的西兰花叶片检测研究[J]. 中国农机化学报, 2020, 41(4): 92-97.Fu Zhongzheng, He Xiao, Fang Kui, et al. Study on the detection of broccoli leaves based on the improved SSD network [J]. Journal of Chinese Agricultural Mechanization, 2020, 41(4): 92-97.

[9]Shen Z, Liu Z, Li J, et al. DSOD: Learning deeply supervised object detectors from scratch [C]. Proceedings of the IEEE International Conference on Computer Vision, 2017: 1919-1927.

[10]Malty M, Banerjee S, Chaudhuri S. Faster R-CNN and YOLO based vehicle detection: A survey [C]. 2021 5th International Conference on Computing Methodologies and Communication (ICCMC). IEEE, 2021: 1442-1447.

[8]Cheng L, Li J, Duan P, et al. A small attentional YOLO model for landslide detection from satellite remote sensing images [J]. Landslides, 2021, 18(8): 2751-2765.

[9]Jimin Y, Wei Z. Face mask wearing detection algorithm based on improved YOLO-v4 [J]. Sensors, 2021, 21(9): 3263.

[10]Wu D, Lü S, Jiang M, et al. Using channel pruning-based YOLO v4 deep learning algorithm for the real-time and accurate detection of apple flowers in natural environments [J]. Computers and Electronics in Agriculture, 2020, 178: 105742.

[11]胡根生, 吳继甜, 鲍文霞, 等. 基于改进YOLOv5网络的复杂背景图像中茶尺蠖检测[J]. 农业工程学报, 2021, 37(21): 191-198.Hu Gensheng, Wu Jitian, Bao Wenxia, et al. Detection of Ectropis oblique in complex background images using improved YOLOv5 [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(21):191-198.

[12]Dadboud F, Patel V, Mehta V, et al. Single-stage UAV detection and classification with YOLOV5: mosaic data augmentation and PANET [C]. 2021 17th IEEE International Conference on Advanced Video and Signal-based Surveillance (AVSS). IEEE, 2021: 1-8.

[13]Wang Y, Zell A. YOLO+FPN: 2D and 3D fused object detection with an RGB-D camera [C]. 2020 25th International Conference on Pattern Recognition (ICPR). IEEE, 2021: 4657-4664.

[14]Krishna K, Murty M N. Genetic K-means algorithm [J]. IEEE Transactions on Systems, Man, and Cybernetics, Part B (Cybernetics), 1999, 29(3): 433-439.

[15]Kapoor A, Singhal A. A comparative study of K-means, K-means++ and fuzzy C-Means clustering algorithms [C]. 2017 3rd International Conference on Computational Intelligence & Communication Technology (CICT). IEEE, 2017: 1-6.

[16]Woo S, Park J, Lee J Y, et al. CBAM: Convolutional block attention module [C]. Proceedings of the European Conference on Computer Vision (ECCV), 2018: 3-19.

[17]Zhuang F, Qi Z, Duan K, et al. A comprehensive survey on transfer learning [J]. Proceedings of the IEEE, 2020, 109(1): 43-76.

[18]Howard A, Sandler M, Chu G, et al. Searching for MobileNetV3 [C]. Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 1314-1324.

[19]Hou Q, Zhou D, Feng J. Coordinate attention for efficient mobile network design [C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 13713-13722.

[20]Duan K, Bai S, Xie L, et al. CenterNet: Keypoint triplets for object detection [C]. Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 6569-6578.