一种基于Involution和BERT词向量的情感分析算法*

2023-11-27王一凡

王一凡

(悉尼大学工学院,澳大利亚 悉尼 2006)

0 前言

文本情感分析是人工智能领域中自然语言处理(NLP)的一项基本研究任务[1],旨在从文本中提取有用的信息,从而更好地了解用户的情感偏好.它可以帮助企业更好地了解客户或公民的情感,从而改善他们的用户体验,提高其满意度,并有助于企业或相关职能部门更好地理解用户的情感,促进和改善人与人、员工和企业等各级各类关系.

数据的Involution是指数据的深度分析,它是一种深度学习技术,可以从复杂的数据中提取有用的信息,并对数据进行模型构建和预测,从而更好地了解数据.而BERT(Bidirectional Encoder Representations from Transformers)则是一种基于双向Transformer编码器的语言模型,主要用于自然语言处理(NLP)相关研究任务.它可以更好地捕捉句子中的上下文信息,从而提高NLP任务的准确性.BERT可以用于文本分类、问答系统、机器翻译等NLP任务.

但是已有的情感分析的往往受限于以下几点:第一,情感分析模型无法准确地识别文本中的情感偏好;第二,情感分析模型无法准确地识别文本中的情感强度和情感转折;第三,情感分析模型可能无法准确地识别文本中的情感变化.本文提出的一种基于Involution和BERT的情感分析模型能够有效地提取文本数据中的有用信息,并准确地进行情感分析,从而更好地了解用户的情感偏好,并通过实验验证了模型的有效性.

1 相关研究

近年来,文本情感分析已成为自然语言处理领域的一个热门研究课题[2].文本情感分析旨在从文本中提取有用的信息,从而更好地了解用户的情感偏好.近年来,研究人员已经开发出了许多有效的文本情感分析技术[3],如基于机器学习的情感分析技术、基于深度学习的情感分析技术、基于BERT模型的情感分析技术[4]等.这些技术可以帮助企业更好地了解客户的情感,一定程度上改善了客户体验,提高了客户满意度.Involution 模块可以有效获得较好的特征,同时在一定程度上Involution 能够获得空间以及通道的双重特性.Involution 在不同空间领域内各不相同,而在通道上则是共享这些参数.但是已有的Involution研究主要用于图形图像,在文本领域的研究相对较少,众所周知,文本上的上下文关系蕴含更多的信息.如何利用 Involution更有效地预测情感极性是当前研究的一个热点.同时,基于BERT模型的文本情感分析技术也被国内外众多学者关注[5].BERT模型可以捕捉文本中的上下文信息,进而可以更好地捕捉文本中的情感信息.研究人员提出了许多基于BERT模型的文本情感分析技术,如基于BERT的多任务学习技术、基于BERT的双向注意力技术、基于BERT的多层注意力技术[6,7]等.此外,研究人员还在探索新的文本情感分析技术,如基于视觉的情感分析技术、基于语音的情感分析技术等[8],以更好地捕捉文本中的情感信息.

本研究将 Involution 和 BERT 模型相结合,形成了一种新的情感分析模型.这种设计使得模型能够通过 BERT 模型提取出的词向量和 Involution 层提取出的特征信息,进行更为准确的情感极性判断.

2 基于Involution和BERT的情感分析模型

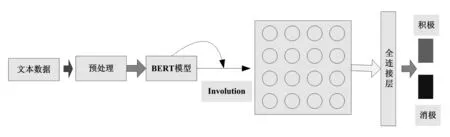

基于Involution和BERT的情感分析模型主要通过以下步骤实现:a.数据预处理,对文本数据进行预处理,如分句、分词以及去除无用的信息等;b.生成BERT词向量,把文本数据输入到BERT模型中,获得相应的词向量.c.Involution层分析,把获得的BERT词向量传入到Involution层获得更好的特征信息;d.情感极性判断,通过级联一个全连接层实现情感极性的情感分类,获得最终的文本情感.模型框架如图1所示.

图1 基于Involution和BERT的情感分析模型

2.1 BERT词向量模块

BERT通过把数据的多个特征进行计算获得其词向量,如公式(1)所示.

Input_EmbeddingsBERT=α×ETE+β×ESE+γ×EPE.

(1)

式(1)中,TE、SE和PE分别表示词向量、句子向量和位置向量, 分别为对应位置向量的权重.ETE∈N*dmodel,N是初始数据的长度,dmodel是对应的词向量维度,并且,ESE∈N*dmodel,EPE∈N*dmodel.

在BERT中子模块中,

dmid1=Layer_N(din+Mask_M_A(din)),

(2)

dmid2=Layer_N(dmid1+Masked_H_A(dmid1,eout)),

(3)

dout=Layer_N(dmid2+FFN(dmid2)).

(4)

其中,din∈M*d和dout∈M*d分别表示相应的输入和输出,Masked_M_A(·)、FFN(·)和MaskedM_H_A(·),分别表示注意力机制、前馈神经网络函数和带掩码的多头attention机制,Layer_N(·)表示归一化函数.

2.2 Involution模块

Invi,j=Φ(Sentencei,j)=Wouter×σ(Winner×Sentencei,j).

(5)

与卷积不同的是,在Involution模块中,其通道共享一致的参数,在不同位置的空间采用不同的参数核心,生成卷积核的公式如式(5)所示.生成Involution的核函数,为非线性激活函数,Sentence为句子矩阵,Sentencei,j为第i行第j个位置的向量.

2.3 全连接层

通过一个全连接层实现情感极性的情感判断,输出为一个具有两个特征的特征向量,分别表示积极和消极两种态度,如式(6)所示.

Output=sig(Wf×F+bf)

(6)

式(6)中,Output为全连接层的输出,结果为两个极性的概率,sig(·)为非线性sigmoid激活函数,Wf为全连接层权重矩阵,bf为偏置向量.

3 实验验证

3.1 实验数据

本文的实验数据采用公开的三个数据集,第一个为中文实验数据集waimai_10k(简记为W_10K,其中正向积极的数据样本为4 000条,负向消极的数据样本为8 000条).另外两个为英文数据集,一个是IMDB(为电影评论数据集,其中正向积极的评价有12 500条,负向消极的评价有12 500条)、Tweet(其中积极评价有2 363条,消极9 178,中性为3 099条,本实验只涉及积极和消极评论实验,不涉及中性数据),三个公开数据集,均为真实用户的评价.

3.2 评价指标

实验采用标准的准确率P、召回率R和F1值作为实验的评价指标.

(7)

式(7)中,TP指的是实际为积极样本且预测为积极样本的本数,FP指的是实际为消极样本但预测为积极样本的样本数;TN指的是实际为消极样本且预测为消极样本的样本数;F1指的是实际为积极样本但预测为消极样本的本数.

3.3 对比模型

基于文本卷积的分类模型T_CNN[9],该模型通过使用CNN卷积操作进行文本特征选择,对选择的结果进行分类,获得情感分类结果.基于双向循环结构R_CNN[10],该模型结合了CNN和RCC的优点.基于门控的GRU模型[11],该模型通过减少一定的参数计算,几乎达到同LSTM一样的效果.长短时记忆LSTM模型[12],该模型在一定程度上解决了CNN遇到的梯度消失和爆炸问题.双向的Bi_LSTM模型[1],通过增加向前和向后两个方向的编码,增加了语义获取的质量.attention_LSTM模型[1],该模型为基于注意力机制的LSTM模型,通过引入注意力机制,更好的关注到更有价值的信息.

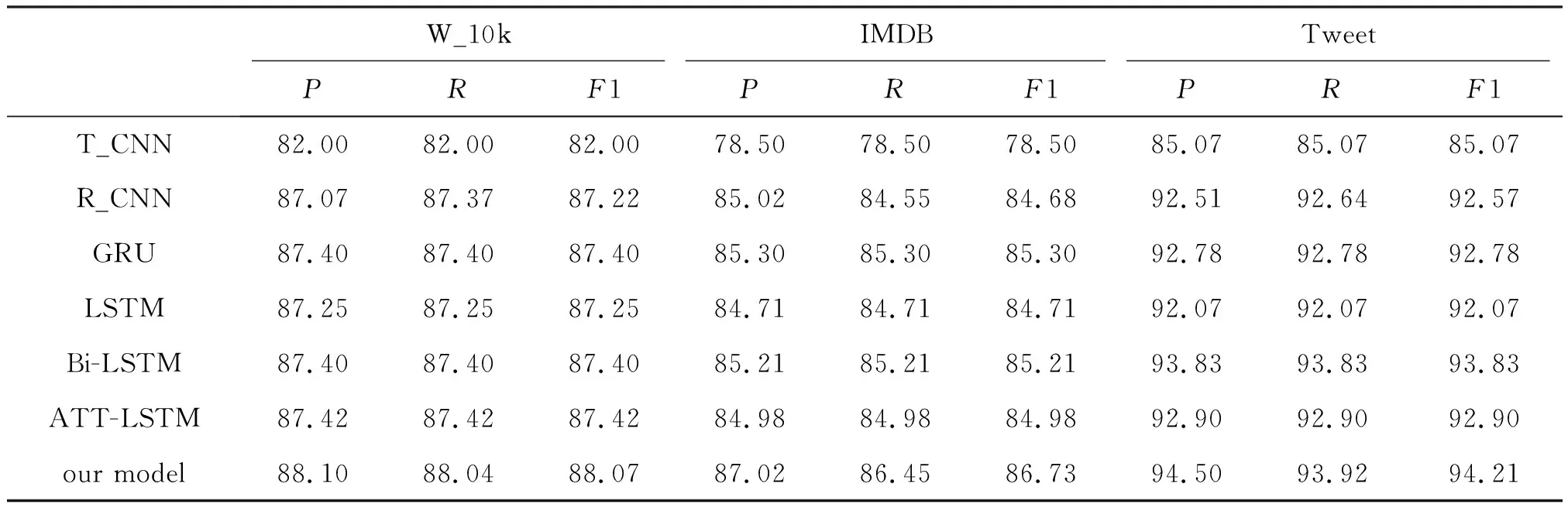

表1 在三种语料上的实验结果

图2 在三种数据集上的准确率对比

图3 在三种数据集上的召回率对比

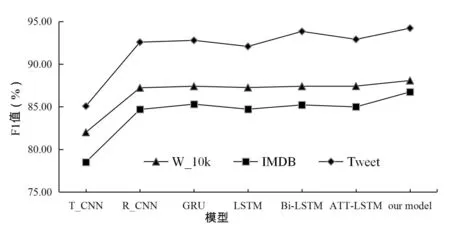

图4 在三种语料上的F1值

从表1和图2~图4的直观展示以及对各个模型深入的分析,可以得出以下结论,首先,T_CNN 模型的效果相对较差.这主要是因为该模型仅考虑了卷积操作,而没有充分考虑序列中的长距离依赖关系.在情感分析任务中,长距离依赖关系对于捕捉文本中的语义信息非常重要.因此,T_CNN 模型在性能上相对较差.GRU 和 LSTM 模型的表现较为接近,LSTM 在长序列中具有更好的性能,而 GRU 作为 LSTM 的简化版本,在性能上有一定提升,且训练时间较短.GRU 模型通过参数共享减少了模型的参数量,从而提高了训练效率.然而,在面对长序列时,GRU 模型的性能可能不如 LSTM.

其次,Bi-LSTM 模型在两个方向上具有学习数据特征,拼接是其最终特征.在准确率、召回率和F1 值等三个评价指标上,Bi-LSTM 模型均取得了一定的提升.这主要是因为 Bi-LSTM 模型能够更好地捕捉到序列中的长距离依赖关系,从而提高了模型的性能.ATT-LSTM 模型引入了注意力机制,使其能更好地学习有用特征信息.在情感极性分类上,ATT-LSTM 取得了与 Bi-LSTM 相近的结果.然而,由于引入了注意力机制,模型的复杂度增加,导致模型训练时间增加.注意力机制需要计算注意力矩阵,增加了计算资源和复杂度,但同时也能够帮助模型更好地捕捉输入序列中的重要程度不同的特征.

最后,与参考对比模型相比,我们的模型在准确率、召回率和F1 值等方面均取得了最佳结果.这主要得益于将生成的 BERT 词向量传入 Involution 层进行分析处理.BERT 词向量能够为文本数据提供丰富的词向量表达,使得模型能够更好地理解文本的语义信息.Involution 层的引入使得模型能够更好地捕捉文本中的长距离依赖关系,从而提取出更为准确的情感特征.通过级联一个全连接层分类器,本文的模型实现了更为准确的情感极性分类.

综上所述,本文的模型在情感分析任务中表现优异,不仅引入了 BERT 词向量和 Involution 层,还采用了级联全连接层进行情感极性判断,从而提高了模型的性能和准确性.

4 结论

本文提出了一种融合Involution和BERT词向量的情感分析算法,基于Involution和BERT的情感分析研究旨在通过深度学习技术,融合并利用Involution和BERT技术,对文本数据进行训练,并最终获得输入文本情感分析.在标准数据集上进行了广泛的实验,研究结果表明,基于Involution和BERT的情感分析模型能够有效地提取文本数据中的有用信息,并准确地进行情感分析,从而更好地了解用户的情感偏好,但仍有较大的改进空间.