空中“低慢小”目标检测跟踪算法的应用研究

2023-11-03肖选杰张浩天艾剑良

肖选杰,张浩天,艾剑良

(复旦大学 航空航天系,上海 200433)

目前空中“低慢小”目标[1]所带来的安全问题日益严重。“低慢小”目标特指飞行高度低于100m、飞行速度低于15m/s、200m 探测范围内雷达反射面积小于2m2的低空目标,常见的有无人机和空飘气球等。因此如何高效治理空中“低慢小”目标具有极为重要的现实意义,在此过程中准确检测并跟踪空中“低慢小”目标是一个重要步骤。

治理方案的首要任务是对此类目标精确检测。自YOLO 等多种One-Stage目标检测算法问世以来,利用深度学习(Deep learning)进行复杂背景下的目标检测取得了重大突破,此类算法的速度、精度和适用性相较于传统目标检测算法都有了极大的提升,并被广泛应用于各个行业。Liu等[2]利用YOLOv4实现了空中小型无人机的检测;Song等[3]利用YOLOv4实现了对高压电线路上异物的检测。虽然上述两种方案检测精度较高,但算法模型较大,无法满足机载设备部署对实时性的要求。Kulshreshtha等[4]利用YOLOv4-Tiny设计了一套户外自动收集垃圾机器人的系统;杨坚等[5]将YOLOv4-Tiny作为基准目标检测模型进行改进,完成了复杂环境下番茄的实时识别;同时,Li等[6]也对YOLOv4-Tiny模型进行改进,实现了对高压电上绝缘子的缺陷检测。上述几个研究虽然都实现了特定实验环境下的目标检测,但是上述模型对图像背景要求较高,且对小目标的检测效果较差。

针对空中“低慢小”目标的跟踪,不仅要考虑精准度,还要考虑机载设备的算力和重量,算法在保证精准度的前提下,要尽可能减小模型大小。目前目标跟踪算法主要有两个方向: 一类基于深度学习,例如,SiamFC(Siamese network Fully Convolutional,全卷积的孪生网络)[7]、SiamRPN(Region Proposal Network,区域候选网络)[8]、SiamRPN++[9]等;另一类基于相关滤波,例如,核相关滤波(Kernel Correlation Filter,KCF)[10]、CSK(explooting the Circulant Structure of tracking-by-detection with Kernels)[11]、DCF(Discriminative Correlation Filter)[10]等。在速度和实时性方面,基于相关滤波的方法要优于基于深度学习的方法,但在精度方面,基于相关滤波的方法相较于基于深度学习的方法较差[12]。本文3.4节的实验发现,目标检测算法在机载计算机(Jetson Xaiver NX)上已经占据了大部分的算力,故而平台上已无足够算力支撑运行基于深度学习的目标跟踪算法,导致无法实时跟踪。调研发现,柳天宇等[13]利用KCF目标跟踪算法实现了对空中目标的跟踪模拟,但其所使用的YOLOv4目标检测模型较大,无法保证部署在机载计算机上的实时性。Yu等[14]通过结合YOLOv4-Tiny目标检测算法和KCF目标跟踪算法设计了一套轻量级的垃圾检测和跟踪系统,但该系统在跟踪过程中存在尺度固定的问题,对运动目标的跟踪存在一定的局限性。

针对现在空中“低慢小”目标的实时检测跟踪算法效率低、准确度不高、易丢失目标等问题,本文创新地提出了360°全景相机和变焦吊舱多源融合的方案,用全景相机进行近距离全方位无死角探测,结合变焦吊舱多倍变焦特性,更快更准更全面地完成“低慢小”目标的检测和跟踪。本文主要贡献有以下3个方面: 第一,基于YOLOv4-Tiny目标检测模型进行改进,提出了YOLOv4-TCA目标检测算法,并用K-means++聚类算法重新聚类锚框,新算法模型的平均精度(mean Average Precision,mAP)较未改进算法提升2.3%;第二,改进KCF目标跟踪算法,自适应选取目标检测结果尺度,提出自适应尺度KCF(Adaptive Scale-KCF,AS-KCF)目标跟踪算法,有效地解决了跟踪过程中目标尺度固定的问题;第三,提出了一种全景相机与变焦吊舱多源融合的目标检测跟踪方案,方案的目标重捕成功率比基线方案高11.66%,目标重捕平均时间比基线方案缩短2.6s。

1 模型与方法

1.1 YOLOv4-Tiny算法

基于深度学习方法的目标检测是当下的主流,特别以One-Stage方法的单步多框目标检测(Single Shot multibox Detector,SSD)[15]、YOLO[16-20]系列为代表,这类方法只将图像进行1 次卷积神经网络(Convolutional Neural Network,CNN)操作就可实现对目标准确的检测和位置输出,其凭借模型轻量且实时性和精度都较高的特性,常常被部署在无人车的嵌入式机载计算机上。

由于无人机上的机载计算机普遍只能搭载轻量化的嵌入式设备,如树莓派或Jetson等。这类嵌入式设备算力普遍较低,故本文选择轻量化的YOLOv4-Tiny作为目标检测算法框架进行改进。YOLOv4-Tiny算法相较于YOLOv4[19]检测精度有所下降,但其实时性更优。YOLOv4-Tiny整体网络结构主要分为两个部分: 主干特征提取网络部分使用的是CSPDarknet53-Tiny,如图1中主干特征提取网络所示,主要作用是提取图像中目标的特征;金字塔网络(Feature Pyramid Networks,FPN)结构的主要作用是对主干网络提取到的特征进行特征融合,最终得到两个不同尺度的输出结果。

图1 YOLOv4-TCA 算法网络结构Fig.1 YOLOv4-TCA algorithm network structure

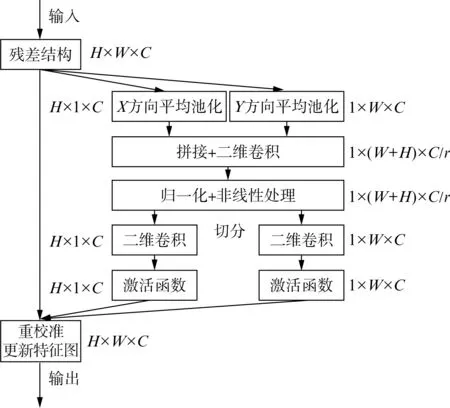

1.2 CA注意力机制

注意力机制已成为当下深度学习优化方法的一个重要研究方向,其能够灵活地捕获全局信息和局部信息之间的联系,突出显著有用特征,抑制和忽略无关特征。本文选取的CA(Coordinate Attention)注意力机制是在通道注意力中加入空间位置信息的坐标注意力机制,CA 注意力机制在通道注意力机制的基础上兼顾其位置关系,将通道注意力与空间注意力联合起来。因此既可以捕获不同通道之间的相互依赖,也能够更好地建立位置信息与长程依赖[21-23]。

CA 注意力机制通过将通道分解为两个并行的垂直和水平方向的特征编码,并且利用这两个方向的一维全局平均池化分别将垂直和水平方向的输入特征融合为两个独立的方向感知特征图,其结构如图2所示。图中C代表通道数,H代表特征图高度,W代表特征图宽度,r为缩减因子。两个嵌入特定方向信息的特征图被分别编码为两个注意力图,在经过一系列的级联、卷积以及激活之后,上述两个注意力图都得到了输入特征图沿着一个空间方向的长程依赖。位置信息被保存在生成的注意力图内,最后两个注意力图被乘到输入的特征图上来增强特征图的表示能力[22]。CA 注意力机制能够进一步抑制背景噪声,且可以有效捕捉目标特征之间的位置信息以及通道关系,增加对无人机及气球目标等重点目标的关注,进而保证输出更清晰的目标特征。

图2 CA 注意力机制Fig.2 CA attention mechanism

1.3 YOLOv4-TCA算法

本文在YOLOv4-Tiny目标检测框架基础上对特征融合颈部网络(Neck network)进行改进,新算法命名为YOLOv4-TCA(YOLOv4-Tiny-CA),改进后的网络结构如图2所示。改进后的算法通过在颈部网络位置引入包含位置信息的CA 注意力机制,能够在特征提取骨干网络之后获得多尺度特征感受野的同时,让两个检测头得到更好的特征信息。利用CA 注意力机制的坐标信息感知能力,在颈部网络中对坐标信息进行更加有效的融合后,结果输出到两个检测头,使检测头能够得到更丰富的位置信息。实验表明,改进后的算法能够提取到更深层的无人机和气球的特征信息,减少误检,网络仅增加0.2MB的模型权重,但能够有效提高模型的检测精度。

1.4 K-means++锚框聚类优化

在目标检测过程中,针对不同类别目标在图像中不同大小的问题,为了得到更好的交并比(Intersection Over Union,IOU)结果,通常需要对数据集中的目标重新聚类,得到一组适宜数据集的锚框(Anchor box)。传统的K-means聚类算法存在收敛较慢、时间复杂度较高、不能保证全局最优等缺点,所以为得到更好的聚类效果,本文选择由K-means算法改进的K-means ++算法进行锚框聚类[24],得到结果如表1所示。

表1 聚类结果Tab.1 Clustering results

1.5 KCF单目标跟踪算法改进

KCF目标跟踪算法[10]是一种基于相关滤波的算法,其运行速度,即帧速率(Frame Per Second,FPS)可以达100帧/s以上。KCF算法利用被跟踪目标的图像来提取目标的方向梯度直方图(Histogram of Oriented Gradient,HOG)特征,并利用循环矩阵,将目标周围的图像循环作为训练样本对目标检测器进行训练。然后,使用高斯核函数(Gaussian kernel function)对跟踪目标及周围图像的HOG 特征进行相关响应计算。最后,使用响应最高的图像重新训练目标检测器,并判定响应最高的就是目标位置。

本文针对KCF算法跟踪过程中跟踪框尺度无法随着目标尺度变化实时更新的问题,提出一种利用目标检测得到的距离视野中心最近邻的目标框尺度更新KCF跟踪框尺度的解决策略。规定每20帧将上述目标尺度用于校正目标跟踪框尺度,改进后的KCF算法命名为AS-KCF。

2 多源融合及目标跟踪算法

2.1 目标坐标系

融合算法的核心是对检测目标的准确定位,首先要完成两个相机的像素坐标系转换。全景相机的分辨率为1920×1080,变焦吊舱的分辨率为640×480。将全景相机的左上角命名为图像坐标原点,建立图3所示坐标系,其中uov为全景相机的像素坐标系,u'o'v'为变焦吊舱的像素坐标系。利用像素坐标与角度的对应原则,判定全景相机的目标中心距离全景图像中心的位置偏移量,生成对应指令控制变焦吊舱完成云台调整,最终使得变焦吊舱的图像中心与全景相机中的目标框中心重合。

图3 图像坐标系Fig.3 Image coordinate system

为获得全景相机坐标与变焦吊舱偏转角度的对应关系,通过实验发现,变焦吊舱偏航角与全景相机中目标中心点位置的映射存在良好的线性关系,定义其线性参数为ε1。因全景相机上下畸变及变焦吊舱像素视野区域限制,定义俯仰角线性参数为ε2。实验得到在全景图像上目标中心点坐标和变焦吊舱需要转动的偏航角αyaw及俯仰角αpitch的对应关系:

经过测试,式中ε1取0.19,ε2取0.1。

2.2 目标跟踪锁定算法

综合考虑机载计算机算力和重量后,本文选用两台Jetson Xaiver NX 机载计算机进行实验验证,系统硬件架构如图4所示,硬件设备安装示意图如图5所示,算法流程如图6所示。先利用YOLOv4-TCA算法对全景图像中的目标进行实时检测。如果360°全景相机中存在待跟踪目标,确认待跟踪目标后,通过自建通信协议和串口通讯,机载计算机A 检测到的目标坐标信息被反馈到机载计算机B。后者再利用变焦吊舱偏转角度计算得到偏航和俯仰的角度,并通过指令控制变焦吊舱旋转到指定位置,实现目标初步锁定。

图4 系统硬件架构Fig.4 System hardware architecture

图5 硬件安装示意图Fig.5 Hardware installation schematic

图6 算法流程图Fig.6 Algorithm flowchart

变焦吊舱运动到指定位置后,再次根据目标检测算法判断是否有目标存在,将对应目标的坐标及尺度信息给到AS-KCF,进行实时目标跟踪。根据目标框尺度信息判断大小是否合理。如果目标过小或者过大,则控制吊舱执行变焦,动态调整检测目标所占据的像素大小,使得检测目标所占据像素不小于32×32,不大于160×160。最后判断目标是否在以吊舱画面中心位置30像素半径范围内,并做相应调整。

2.3 目标丢失重捕算法

在跟踪过程中,可能出现目标框移位的情况。本文规定每20帧为一个关键帧,自动为AS-KCF更新被跟踪目标尺度信息。如果目标丢失,则控制变焦吊舱以10°为搜索角度,执行从左到上到右到下再到左的搜索策略实现目标搜索,如图7所示。如果再次发现目标,则控制吊舱按照既定跟踪策略对目标进行跟踪。若未发现目标,则从机载计算机A 获取目标信息,按照既定流程完成对目标的跟踪。

图7 搜索策略Fig.7 Search strategy

3 实验结果与分析

3.1 数据集

本文数据集根据实际应用场景需求构建,为在外场实验环境下拍摄的视频数据导出构建的“低慢小”目标数据集。数据集一共包含3378张图像,包含气球和多旋翼无人机两种类别,其中训练图像2736张,测试图像338张,验证图像304张,共包含气球目标4118个,多旋翼无人机2894个。

3.2 实验平台

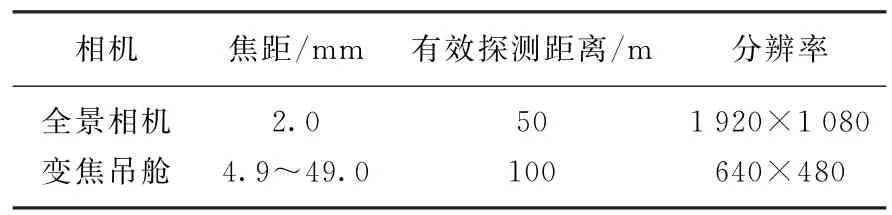

模型训练的PC工作站硬件参数: CPU 为Intel Core i9-10900K @3.7GHZ最高5.3GHZ,GPU 为NVIDIA GeForce RTX 3080TI 12GB。模型训练在Ubuntu18.04 系统中进行,其中CUDA(Compute Unified Device Architecture)版本号为11.6,PyTorch框架版本号为1.12.1,OpenCV 版本号为3.4.16。训练采用随机梯度下降(Stochastic Gradient Descent,SGD)优化器对模型进行优化,动量设置为0.937,初始学习率为0.01,最小学习率为0.0001,分为冻结和解冻两个训练阶段,总共1000个世代数(Epoch)。硬件实验搭载的机载计算机为: Jetson Xaiver NX,全景相机及变焦吊舱主要参数如表2所示。

表2 相机参数Tab.2 Camera parameters

3.3 模型训练结果

实验过程中,若从头开始训练网络,不仅时间成本较高,且训练效果、训练参数及训练过程不好把握。为更快获得更优的收敛权重,本文利用预训练权重,采用迁移学习的方法,能够更快更好地达到预期效果,极大地减少训练时间,提高训练的效率。在本实验过程中模型训练主要有两个训练阶段: 冻结阶段和解冻阶段。冻结阶段利用现有预训练YOLOv4-Tiny模型权重对主干特征提取网络的参数初始化,训练模型的主干特征提取网络参数被冻结,仅对网络其他部分进行微调。冻结阶段设置世代批样本数为64,世代数为50。执行解冻阶段时,模型的全部网络参数都可以进行调整,此时设置世代批样本数为32,总训练世代数为1000。训练后,各算法的mAP[25]、FPS指标如表3所示,模型训练过程中mAP和Loss值变化如图8所示。实验结果显示,模型均训练共计1000个epoch,训练参数均一致,随着epoch不断增加,Loss值不断降低,训练进行到300轮后,Loss值趋于稳定,未出现明显过拟合、欠拟合的现象,参数设置合理。

表3 算法指标Tab.3 Algorithm metrics

图8 模型训练的mAP及Loss值变化Fig.8 MAP and Loss values changes during model training

由表3可以看出,改进后的YOLOv4-TCA 算法与原YOLOv4网络相比,在准确率方面较为相近,但在检测速度方面有明显优势。YOLOv4-TCA网络模型结合重新聚类的锚框训练后,其mAP可达88.76%,较未改进的YOLOv4-Tiny模型比较,虽然FPS下降了3帧/s,但mAP提升了2.3%。可以看出增加CA 注意力机制改进后的网络尽管增加了网络复杂度,增加了检测用时,但仍具有较高效率,同时在检测准确率方面也有显著提升。

3.4 实验结果

3.4.1 目标检测实验结果

随机选取测试集中的图像进行实验,结果如图9 所示。通过目标检测结果可以看出,原始的YOLOv4-Tiny算法对空中的鸟类等多种小目标容易产生误检,且对空中目标的定位精度较差,造成较高的虚警率。本文改进后的YOLOv4-TCA 算法能够有效减少误检,同时也能有效区分密集的空中目标,提高空中“低慢小”目标的检测精度。原因在于本文模型加入了CA 注意力机制,对特征提取进行了改进,使其能提取到更专注的“低慢小”目标特征,获取到更准确的坐标,从而更精确地定位到空中“低慢小”目标。

图9 目标检测结果Fig.9 Object detection results

3.4.2 目标跟踪实验结果

算法部署在两台Jetson Xaiver NX 嵌入式机载计算机平台上,实验硬件平台搭载于自主正向建模的子母一体多旋翼无人机平台进行外场测试,外场实验效果如图10和图11所示。从图中可以看出,实验目标为空飘气球,在不同距离、不同角度、不同速度的实验情况下,利用本文方案均实现了对其的精准检测和跟踪。通过图11的实验结果发现,改进的AS-KCF算法比未改进的KCF算法跟踪框更贴合目标,对目标的跟踪效果更好。

图11 目标检测跟踪结果Fig.11 Object detection tracking results

此外,为验证算法的检测跟踪速度,获取了在机载计算机上全景相机和变焦吊舱所在平台检测和跟踪的平均FPS,如表4所示。可以发现,当利用DeepSort结合YOLOv4-TCA 算法时,因DeepSort占据了一部分算力,导致FPS下降到19帧/s,不满足实验对实时性的需求。但本文方案的检测跟踪实时性指标均大于24帧/s,且变焦吊舱的实时帧率达64帧/s,远超实时性要求。

表4 不同设备算法的FPSTab.4 FPS of different devices and algorithms

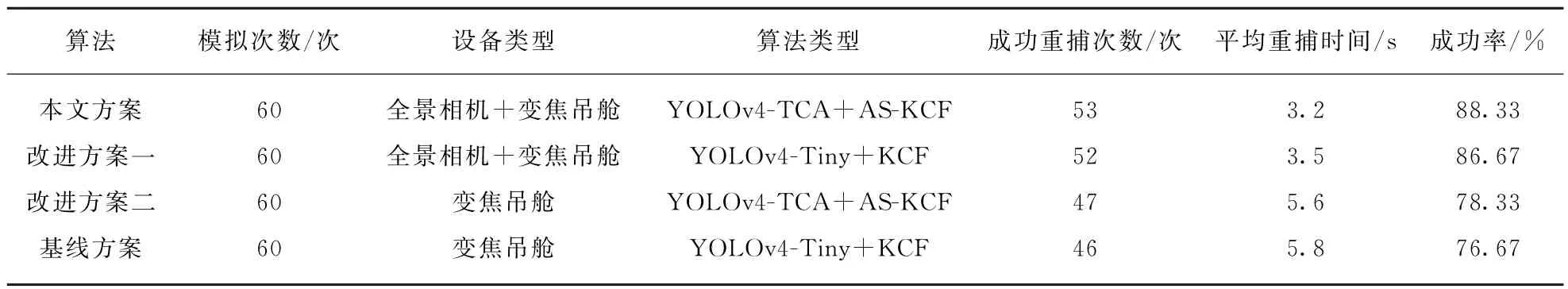

为验证本文方案及基线方案对丢失目标的重捕跟踪效果,实验模拟了目标丢失的情况。实验假设目标在被变焦吊舱跟踪后突然丢失,其再次出现的位置分别对应于全景相机坐标系中的左、上、右、下、极左、极右的6种不同情况,每种情况各进行10次实验。目标重捕方案的实验结果对比如表5所示,实验基线方案的硬件设备仅包含变焦吊舱,使用YOLOv4-Tiny和KCF构建为检测跟踪算法。本文方案的硬件设备包含全景相机和变焦吊舱,算法为YOLOv4-TCA 与AS-KCF 结合。为分析全景相机设备以及改进算法对实验结果的影响,还设计了改进方案一和改进方案二,具体内容如表5所示。本文定义: 重捕时间为从丢失目标到再次成功跟踪目标的时间。

表5 目标重捕方案的实验结果对比Tab.5 Comparison of experimental results of target recapture schemes

实验结果表明,本文方案通过添加全景相机对范围内的目标实施有效检测,能够捕获到更多的目标信息,结合本文改进后的目标检测跟踪算法,使得目标的成功重捕次数大大增加,目标重捕成功率可达88.33%,较基线方案提升11.66%。本文方案的目标平均重捕时间比基线方案更短,平均重捕时间减少2.6s。整体来看,改进的YOLOv4-TCA 和AS-KCF两种算法的结合能提高重捕过程的检测跟踪效率,减少平均重捕时间。本文方案虽也存在部分错误检测跟踪目标和漏掉检测跟踪目标的问题,但相比于基线方案,本文方案大幅提升了跟踪重捕率,减少了重捕时间,并且保持了良好的检测速率,进一步说明了本文方案的高效性和准确性。

4 结语

针对空中“低慢小”目标的检测跟踪问题,本文对YOLOv4-Tiny目标检测模型进行改进,通过选取6种不同尺度的锚框,并引入坐标注意力机制,提高了检测模型对目标的坐标敏感度,更高效地提取了目标的特征信息。实验结果表明,YOLOv4-TCA 算法的mAP提升至88.76%,较基准算法提升2.3%,且部署在嵌入式设备上的平均帧率可达64帧/s,保证了部署的实时性和高精度。通过上述算法和AS-KCF目标跟踪算法结合,完成了对空中气球目标的检测和跟踪,目标重捕成功率达88.33%,较基线方案提升11.66%,平均重捕时间减少2.6s。结果表明,本文提出的方案能够有效提高目标检测跟踪能力和目标重捕能力。下一步将对最新的目标检测算法和基于深度学习的目标跟踪算法展开研究,实现更好的目标检测跟踪效果。