基于数字孪生的无人机平行作战仿真*

2023-10-25侯兴明祁启明范红旗

李 灿,侯兴明,祁启明,杜 泰,范红旗

(1.航天工程大学航天保障系,北京 101416;2.解放军32139 部队,北京 101200;3.国防科技大学ATR 重点实验室,长沙 410073;4.解放军31677 部队,河北 保定 071000)

0 引言

无人机(unmanned aerial vehicle,UAV)是依赖自动飞行控制系统自主完成预定任务或通过地面控制站遥控执行任务的无人平台,集“察、打、扰”于一体,在无人化、智能化战场上应用越来越广泛。无人机作为智能作战单元,具备观察-判断-决策-行动(oberve-orient-decide-act,OODA)杀伤链,可以独立完成“探测、识别、决策、打击”的作战行动[1]。作战行动中,可靠的光学侦察和高效的制导控制是无人机顺利完成任务的关键要求。在无人机投入作战应用前的前期设计验证阶段,必须对其光学侦察系统和飞行控制系统的软件算法进行验证评估,同时需要针对作战预想进行全流程行动方案推演,对操作人员进行培训。当测试无人机的光学侦察能力和制导控制性能时,外场飞行试验是不可避免的。然而,外场飞行试验面临安全隐患大、组织流程繁杂、成本高等问题。为了以低廉成本并安全快捷地完成无人机光学侦察和制导控制的性能评估,实现全流程作战行动方案在复杂场景环境下的推演,为操作人员提供模拟训练环境,需要提出一种高度逼近真实战场的平行仿真方法。

近年来,随着信息技术发展,“元宇宙”这个新概念被越来越多的人关注。元宇宙本质是与现实世界平行存在但又反作用于现实世界的高度发达的虚拟世界[2],提供了一种思路:凭借数字孪生、人工智能等先进技术,可以塑造模拟真实战场的“战场元宇宙”,为武器装备测试评估、作战演练提供虚实结合、人机互动、训战一致的超级时空环境。考虑到真实战场具有地形多样、气象多变、时间动态、电磁环境复杂等特点,再加上人类活动的不确定性,一般的建模仿真方法难以对作战单元的复杂系统行为进行精确描述与预测。数字孪生作为元宇宙的核心技术之一[3-5],能实现物理实体与虚拟模型之间的交互融合,从而多维、多尺度完成物理过程的观测、控制和转换。数字孪生近年来在产品设计、制造、装备运维等多领域进行不断探索,并在军事领域得到初步体现[6-9]。

针对无人机作战行动的OODA 闭环在线实时仿真需求,本文构建了基于数字孪生的无人机平行战场,提出一种无人机平行作战仿真方法。该平行战场为测试验证光学侦察系统的视觉感知算法、飞行控制系统的制导控制算法提供实时在线仿真工具,为全流程作战行动推演助力,为操作人员提供用于模拟训练的保障平台。通过平行作战仿真,无人机从智能算法研发到战术研究再到投入实战的周期能显著缩短。

1 无人机平行战场总体结构

为满足平行作战仿真需求,无人机平行战场需具备如下基本功能:1)自定义飞行场景;2)光学侦察仿真;3)制导控制仿真;4)目标仿真;5)视景显示;6)实时状态数据记录;7)数据可视化与仿真评估。

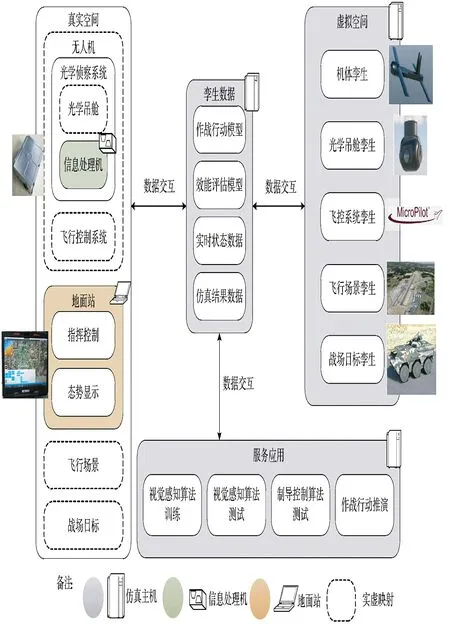

参照上述功能需求和数字孪生五维结构[10],无人机平行战场分为5 个部分:真实空间、虚拟空间、孪生数据、数据交互、服务应用,如下页图1 所示。真实空间是无人机全流程作战行动的基本要素集合。虚拟空间是真实空间的数字化镜像。孪生数据包括平行仿真所需模型和产生的数据,为服务应用提供支持。数据交互规范了不同要素之间的数据传输,定义了数据存储和可视化的形式。服务应用是平行战场的上层人机交互接口,为使用者提供视觉感知算法训练与测试、制导控制算法测试、作战行动推演等功能。

图1 无人机平行战场总体结构Fig.1 General structure of uav parallel battlefield

在真实空间中,构成无人机作战行动的基本要素有无人机、地面站、飞行场景和各种战场目标。无人机用于执行侦察和打击任务时,其光学侦察系统和飞行控制系统是决定作战能力的关键模块,其中,光学侦察系统通常由光学吊舱及其串联的信息处理机组成。信息处理机作为视觉信号处理硬件平台,是视觉感知算法的运行载体。为了提高平行作战仿真中光学侦察系统性能评估的置信度,信息处理机在平行战场中保留为硬件实体。地面站通过建立与无人机的通信连接,指挥控制作战行动,接受无人机的状态反馈信息,显示战场态势,在平行战场中同样保留为硬件实体。

虚拟空间由机体孪生、光学吊舱孪生、飞控系统孪生、飞行场景孪生和战场目标孪生等5 个孪生体组成。机体孪生是无人机机体的实虚映射,由三维显示模型、动力学模型和运动学模型组成。光学吊舱孪生参考光学吊舱实体,主要对光学成像、光轴伺服驱动、控制接口分别建模并整合。飞控系统孪生面向制导单元和控制单元,在飞行控制软件基础上完善输入、输出接口。飞行场景孪生包含三维场景和物理动态环境模型,由地形网格、植被、道路、水系、天空、光照、降雨、云量、风速等内容组成。针对无人机侦察和打击的仿真需求,战场目标孪生主要为地面目标,由三维显示模型和运动模型组成。

孪生数据包括作战行动模型、效能评估模型、实时状态数据、仿真结果数据。作战行动模型由作战行动规则和各孪生体在不同作战阶段下的状态参数设置组成。效能评估模型分为光学侦察评估模型和制导控制评估模型,将记录的状态数据代入效能评估模型,形成作战能力结论。仿真中实时采集各孪生体的状态信息和数据交互信息,存储为实时状态数据。通过对记录的实时状态数据进行分析处理和可视化,获得仿真结果数据。

除去信息处理机和地面站,真实空间中的其余要素映射到虚拟空间,构建孪生体。虚拟空间、孪生数据、服务应用集成于仿真主机,仿真主机、信息处理机、地面站通过建立物理通信连接构成分布式仿真系统。

2 平行战场构建的关键问题

构建无人机平行战场需要解决一些关键问题:实虚映射、数据传输规范、数据存储与可视化。

2.1 实虚映射

由于在室内实验室条件下,光学吊舱难以采集变化场景下的光学图像,飞行控制系统测试依赖姿态转台,导航设备难以运转,故需要将这些模块和飞行场景、战场目标等作战行动基本要素映射到虚拟空间建立孪生体,才能协同起来参与平行仿真。

2.1.1 机体孪生

为完成无人机机体的实虚映射,需要进行三维显示模型设计、动力学与运动学建模。机体三维显示模型是通过3ds MAX、Auto ACD、Maya 等三维建模软件设计的,然后将多面几何体连同材质、贴图一起保存为“.fbx”“.obj”“.3ds”等格式的模型文件,供仿真程序调度显示。动力学与运动学模型可通过引入成熟的飞行力学仿真引擎,如MATLAB 的Simulink 航空宇航模块、JSB 动力学引擎,进行构建。对于以FlightGear 为代表的飞行仿真软件,其飞行器结构、气动参数等内容基于xml 文件形式进行设计,通过配置xml 文件和JSB 引擎进行飞行仿真;此外,V-REP、Gazebo、X-Plane 等基于物理引擎的仿真软件均具有飞行器飞行仿真接口。因此,动力学与运动学模型也可通过引入飞行仿真软件或基于物理引擎的仿真软件进行构建。平行战场选用JSB 动力学引擎进行无人机动力学与运动学计算。

2.1.2 光学吊舱孪生

无人机开展光学侦察时,首先通过光学吊舱采集飞行场景区域的视频图像,然后基于视觉感知算法对视频图像进行智能处理获得战场态势。光学吊舱作为视觉感知前端,其孪生体构建的关键内容是实时的视频图像仿真。

随着计算机图形渲染技术的发展,许多高性能三维仿真引擎应运而生,如Unreal Engine、Unity3D、CryEngine、Unigine 等。这些三维仿真引擎充分集成了计算机图形学的最新技术成果,能较好满足复杂场景的渲染显示需求,其详细介绍与比较可参考文献[11-12]。鉴于Unigine 引擎具有64 位坐标精度和逼真的广域场景渲染效果,构建平行战场时,选用Unigine 2.7.2 Sim 引擎,调用其视口渲染程序接口,对光学吊舱采集的实时视频图像进行仿真。

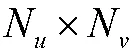

表1 光学吊舱图像仿真的相关参数Table1 Relative parameters of the simulation of electro-optical pod

由于光学吊舱的光轴是可调整的,同时地面站能对光学吊舱进行操作控制,所以构建光学吊舱孪生体时还要对光轴伺服驱动和地面站控制接口进行建模。机载光学吊舱多采用视觉跟踪控制方法[13],自主保持光轴指向关注的目标区域。地面站控制接口建模主要有光学吊舱运行模式调整、姿态控制、焦距调整等内容。光轴伺服驱动模型和地面站控制模型与视频图像渲染联结耦合,构成光学吊舱孪生体。

2.1.3 飞控系统孪生

飞控系统孪生一般由惯导模型、GPS 模型、模态指令生成模型、导引律模型、控制律模型、舵机模型等模块组成。为实现无人机飞行控制系统的实虚映射,可通过引入模型完备的飞控仿真引擎,如MAT LAB 的Simulink 航空宇航模块、商业飞控软件MicroPilot 的仿真模块进行设计。设计中,对惯导、GPS、模态指令生成、导引律、控制律、舵机分别建模,完善信息输入和输出的接口,从而与其他孪生体、硬件实体构成闭环仿真回路。平行战场选用MicroPilot 软件的仿真模块进行飞行控制过程的计算。

2.1.4 飞行场景孪生

飞行场景孪生依托Unigine 引擎进行构建,分为三维场景设计和物理动态环境建模。

三维场景的组成及其设计方法如图2 所示。三维场景一般包括地形、植被、道路、水系、天空、建筑物、人工设施、光照、降雨、云量、风速、海浪等内容。其中,地形可通过Unigine 引擎的场景编辑器随机生成,或者导入GIS 数据及其纹理贴图,利用地形工具生成地形格网;植被、天空、水系、道路等内容可通过场景编辑器的相应工具绘制;建筑物、人工设施与无人机机体的三维显示模型一样,均先通过三维建模软件设计,然后导入场景编辑器进行布设;光照、降雨、云量、风速和海浪等环境特效通过编写场景脚本程序进行设置。

图2 三维场景的组成及其设计方法Fig.2 Composition of 3-d scenery and design method

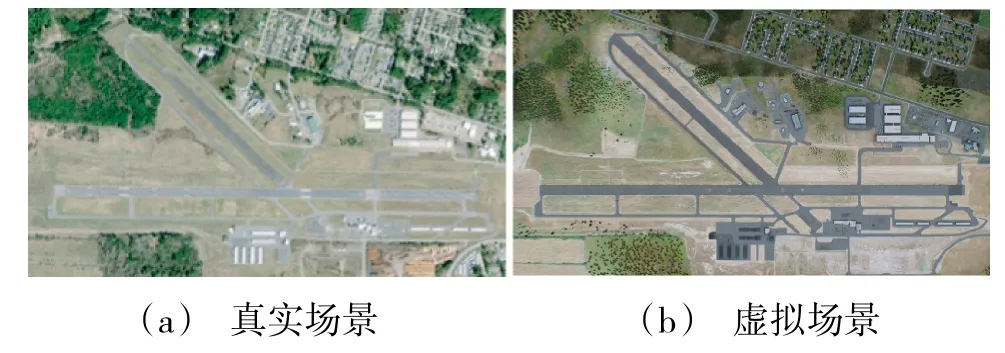

三维场景的设计步骤为:首先导入地形数据制作地形格网,然后使用场景编辑器的植被工具、云层工具、道路工具、水体工具分别添加植被群、云层、道路、河湖海等内容,接着将建筑物、人工设施的三维显示模型导入场景编辑器进行布设,最后编写光照、降雨、云量、风速和海浪等环境显示效果的场景脚本程序。参照实地机场,构建出虚拟机场,如图3 所示。

图3 三维场景设计Fig.3 Design of 3-D scenery

物理动态环境建模重点围绕显著影响飞行动力学特性的温度、湿度、气压、风向风速等因素建模,使设计的三维场景具备对等的动态物理场,使三维视景显示、光学吊舱的视频图像仿真、飞行动力学仿真保持同步一致。

2.1.5 战场目标孪生

战场目标孪生体由三维显示模型和运动模型组成。战场目标的三维显示模型通过三维建模软件设计,保存为离线模型文件后导入仿真程序进行调度显示。面向无人机的侦察打击任务需求,战场目标设置有装甲车、汽车、飞机、舰船等多种类型,如图4 所示。

图4 战场目标的三维显示模型Fig.4 3-D display model of battlefield targets

战场目标的运动建模有两种方式:一是预设运动模式,该模式下,每个战场目标按照预设规划路径进行运动。二是智能运动模式,将自主路径规划、强化学习等智能算法应用于战场目标孪生体,使战场目标孪生体能够自主决策行动、自主规避威胁。

2.2 数据传输规范

数据传输规范主要分为分布式仿真系统通信与同步规范、平行战场信息流规范两方面内容。

平行战场依托分布式仿真系统运行,首先要解决硬件实体间以及仿真主机内不同程序间的数据交互。仿真主机、信息处理机和地面站三者之间采用串行通信端口,如RS422、RS485 等串口模块,进行双向数据通信;仿真主机通过加装的图像注入接口,将光学吊舱孪生体的视频图像注入信息处理机,模拟视频信号回传链路;仿真主机内部不同程序间通过Socket 接口进行数据交互。其次,硬件实体间通信以及仿真主机内部不同程序间的数据交互,都需要通过编写通信协议进行规范。通信协议中每个数据帧一般由固定帧头、帧长、帧类型、信息正文和校验字等内容组成。此外,数据交互还需要解决同步问题。分布式仿真系统采用时钟同步技术[14],通过网络时间协议(network time protocol,NTP)[15]建立全局一致的逻辑时钟,使平行仿真按照逻辑时钟推进。

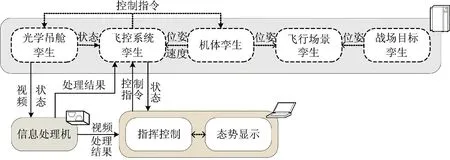

平行战场的关键信息流如图5 所示。其中,实线代表硬件实体间信息流,虚线代表仿真主机内部信息流。光学吊舱孪生体将采集的视频图像注入信息处理机,同时发送状态参数到信息处理机和飞控系统孪生体。经过视觉感知算法计算,信息处理机将战场态势信息反馈给飞控系统孪生体和地面站,同时将视频图像回传至地面站进行显示。地面站将指挥控制指令发送到飞控系统孪生体,然后飞控系统孪生体根据地面站控制指令、机体的位姿速度测量值、光学吊舱状态情况进行导引律、控制律计算,输出控制指令至机体孪生体和光学吊舱孪生体。Unigine 引擎根据机体孪生体和战场目标孪生体的位姿真值渲染得到视景图像和光学吊舱视频图像。

图5 平行战场的关键信息流Fig.5 Key information flow of parallel battlefield

2.3 数据存储与可视化

仿真过程中,仿真主机对各孪生体的状态参数、输入输出数据进行同步记录。数据存储通过多线程编程设计,减少对仿真主程序运行的阻塞,提高仿真过程的实时性。仿真主机启动仿真进程后驱动信息处理机和地面站同步开启数据记录功能。为便于数据分析和无人机作战能力评估,需要将存储的状态数据和结果数据以绘图形式可视化。利用MATLAB软件设计数据可视化程序,将存储的仿真数据,如飞行航迹、机目视线等内容,进行图形化展现。

3 仿真实例

基于构建的无人机平行战场,对视觉感知算法训练与测试、制导控制算法测试、作战行动推演等服务应用内容进行仿真测试。

3.1 视觉感知算法训练与测试

视觉感知算法在实际应用前,需要收集大量不同场景环境下的标注图像进行算法模型训练。但是,收集和标注训练数据集的过程繁琐费时。近年来,一些研究团队基于三维仿真引擎进行二次开发设计出虚拟图像生成工具[16-18],并将制作的虚拟图像数据集用于智能视觉算法的训练和评估。同理,平行战场基于Unigine 引擎设计了虚拟标注图像生成工具。

如图6 所示,虚拟标注图像生成工具不仅能采集虚拟图像,还能通过修改目标的材质和纹理颜色分割出目标像素,对源图像进行标注。相比采集真实图像,该方法不仅能灵活调整曝光、焦距、色差、分辨率等相机参数,还能快速变换环境背景和目标的外部纹理,满足对图像数据采集的多样性和高效性要求。基于虚拟图像训练的视觉算法在实际应用中的效力与用真实图像训练的视觉算法基本一致[18],故平行战场可用于光学侦察中视觉算法的训练准备。

图6 虚拟标注图像生成Fig.6 Generation of virtual annotation images

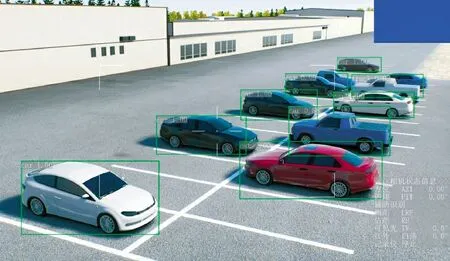

将信息处理机加载的视觉感知算法设定为3部分:YOLO v3 目标检测、SORT 数据关联[20]和GOTURN 目标跟踪[19-21]。首先,YOLO v3 和SORT联合检测多目标,其中,SORT 将每帧图像中YOLO v3 的检测结果关联;随后,GOTURN 用于对SORT关联度最高的目标进行跟踪。假设光学吊舱输出图像的分辨率为1 920×1 080,帧率为25 f/s,下面对目标检测、目标跟踪分别测试。

对于目标检测,目标能被正确检测识别的关键因素是其在图像中占有的像素数量,而像素数量直接由目标大小和距离决定。测试中,将无人机和目标设置为静止状态,分别改变机目高差H、机目水平距离D、吊舱视场角ω 3 个变量进行测试,统计检测识别精度。如图7 所示,当H=10 m,D=15 m,ω=57.3°时,11 辆轿车中除了2 辆因被遮挡而遗漏,其余9 辆车被正确检测识别。根据效能评估模型提供的轿车数量和图像坐标真值,选择合适评价指标,如mAP[22],对该条件下算法的目标检测性能进行评估。这样,分别改变H、D、ω 3 个变量的数值连续测试,可获得该场景条件下目标检测的有效范围。

图7 目标检测测试Fig.7 Test of target detection

与目标检测测试相比,目标跟踪测试需要额外考虑机目相对径向速度和切向速度。测试中,将无人机设置为静止状态,改变机目高差H、机目水平距离D、吊舱视场角ω、机目相对径向速度、切向速度5 个变量进行测试,计算该场景条件下目标跟踪的有效范围。如图8 所示,当目标以切向速度运动时,测量跟踪波门的平移跟进速度;当目标以径向速度运动时,测量跟踪波门的大小调整速度。根据效能评估模型提供的轿车在图像中的移动速度和像素数量,选择合适评价指标,如VOT[23],对该条件下算法的目标跟踪性能进行评估。综上所述,分别改变5 个变量的数值连续测试,可获得该场景条件下视觉感知算法的有效作用域。

3.2 制导控制算法测试

无人机在锁定目标后,对目标进行自杀式打击。为了精准命中毁伤目标,无人机需要有良好的制导控制能力。在制导打击阶段,将机目视线真值取代机目视线测量值,解除制导控制与机目视线测量的耦合,对制导控制算法进行单独测试。无人机转入制导打击阶段后,初始状态参数有:机目高差H、机目水平距离D、机目视线水平投影角、无人机速度vM、目标速度vT。改变该5 个初始状态参数的数值,进行连续测试,记录每次测试的脱靶量(Miss Distance,MD)和飞行时间(Time-to-Go,TOG)。最终,将初始状态参数和对应的脱靶量和飞行时间进行数值拟合,获得制导控制算法的有效作用域。

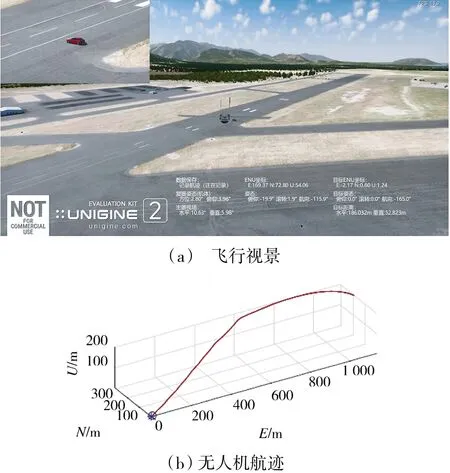

假设目标为一辆静止的红色轿车,无人机转入制导打击阶段的初始状态为:H=198.978 m,D=694.671 m,=-9.35°,=30 m/s,导引律选择比例导引。测试中的飞行视景与无人机飞行航迹如图9 所示,在该初始状态设定下,脱靶量为0.4 m,飞行时间为25.93 s,命中目标。

图9 制导控制算法测试Fig.9 Test of guidance control algorithm

3.3 作战行动推演

将光学侦察仿真、制导控制仿真以及其他仿真要素融合,进行无人机作战行动推演。基于平行战场的作战行动推演能为无人机实地飞行测试提供航线规划预案,为作战运用提供流程方案参考。

设定推演初始条件,如表2 所示。无人机起飞后转入巡航阶段,其光学吊舱对地面进行搜索寻找目标。光学侦察系统对可能的目标完成检测和识别后,在地面站上选择并锁定一架固定翼飞机作为打击对象,然后无人机转入制导打击阶段,光学侦察系统对目标持续跟踪,飞行控制系统按照比例导引朝目标俯冲,进行自杀式打击。测试中,飞行视景、目标检测视频图像与目标跟踪视频图像分别如图10 所示。

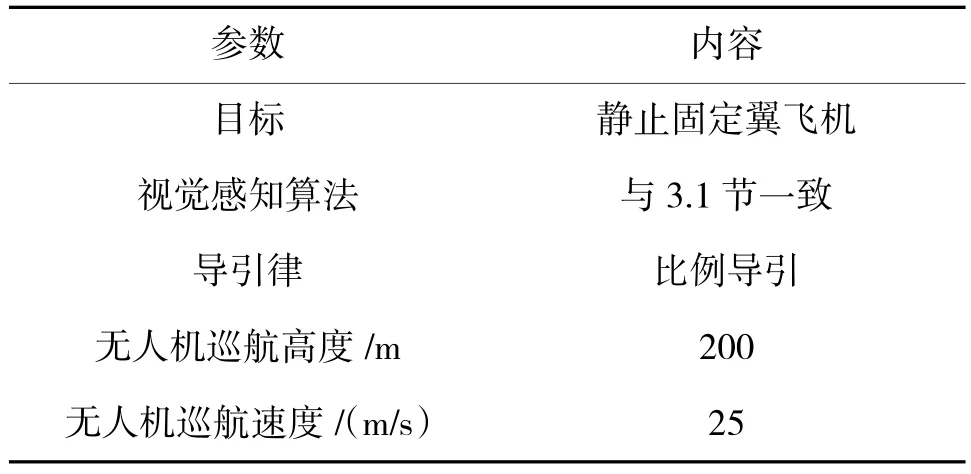

表2 推演初始条件Table 2 Initial conditions of deduction

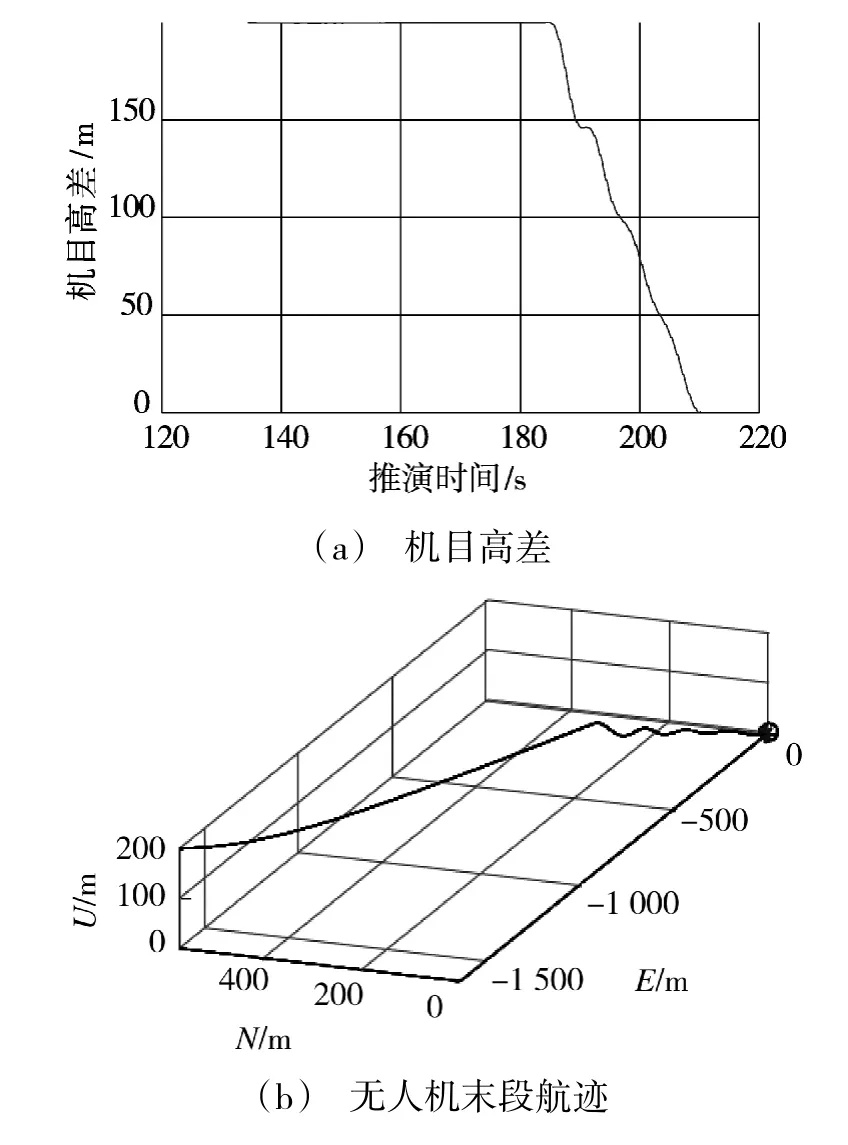

为评估该作战行动效能,将仿真结果数据可视化,其中,机目高差与无人机飞行航迹如图11 所示。推演进行至180.4 s 时,光学侦察系统进入目标跟踪模式,在185.6 s 时,无人机转入制导打击阶段。经过时长为24.7 s 的制导控制,无人机命中目标,脱靶量为1.819 m,完成自杀式打击。从推演结果可知,该作战行动是可行的。

图11 作战行动评估Fig.11 Combat action assessment

4 结论

本文基于数字孪生构建了无人机平行战场,用于平行作战仿真。平行战场依托分布式仿真系统运行,由真实空间、虚拟空间、孪生数据、数据交互、服务应用等5 部分组成。构建平行战场过程中解决了实虚映射、数据传输规范、数据存储与可视化等关键技术问题。通过平行作战仿真,能实时在线测试验证光学侦察系统的视觉感知算法、飞行控制系统的制导控制算法,同时对无人机全流程作战行动进行推演,为操作人员提供模拟训练环境。下一步,研究对无人机平行战场补充电磁环境孪生、雷达吊舱孪生、火力载荷孪生,增加通信链路模型、红外成像模型,满足无人机多波段侦察、电子干扰等作战仿真需求。