面向视障患者的跨模态环境感知与导航系统

2023-10-21沈立新胡威王艳红

沈立新,胡威,王艳红

(1.长春师范高等专科学校,长春 130216;2.长春理工大学 计算机科学技术学院,长春 130022)

据世界卫生组织(WHO)数据显示,全球约有7 500 万盲人和约1.24 亿的视力低下的人群。由于视力受损,该人群的自理能力和生活质量都受到了极大的影响。随着物质生活和科技水平的不断提高,视障患者也有与正常人一样享受物质文化成果和体验科技进步的需求。然而,视觉的缺失严重限制了视障患者的信息获取能力,在无他人帮助的情况下,视障患者无法通过自主运动而完成正常的生活活动。同时,视力受损导致的行动能力缺失,使视障患者无法参与到社会活动中。

区别于室外导航服务系统,室内环境普遍存在遮挡和多径效应,因此,无法通过接收卫星定位信号为用户提供位置服务[1-2]。视障患者在室内空间中迫切需要确定自身位置并感知环境信息,因此,研究和开发不依赖卫星信号的室内辅助导航系统是十分重要的。近年来,随着图像处理与传感器技术的发展,视觉驱动的定位方法逐渐成为了辅助导航领域的研究热点。

室内辅助导航根据其使用设备不同,可分为视觉导航系统、视觉-深度(RGB-D)导航系统、智能手杖系统以及辅助导航车系统等[3-5]。综合考虑定位精度、有效距离以及使用便利性等因素,认为RGB-D 辅助导航系统在保证性能的同时,更具有使用便利性。视障患者受制于生理缺陷,无法通过视觉系统获取导航指引信息和环境感知结果。因此,跨模态的信息交互方法是指导患者完成环境感知和自主运动的关键。Li 等人[6]提出了可穿戴式辅助导航系统,该系统虽然可以在室外环境中借助于GPS 信号为患者提供位置信息,但该系统无法在室内环境中工作。Hirano 等人[7]通过触觉感知系统将运动指导信息传递给参与运动的视障患者,并对患者的运动动作提供指导。近年来,语音提示功能被引入到面向视障患者的环境感知和辅助导航系统中[8-9]。但是,视障患者无法通过语音提示(例如“前、后、左、右”等方位提示)理解环境中地理要素的准确位置,尤其是当患者需要与室内设施发生互动时,准确的方位指引便显得尤为重要。因此,在本文中,将视觉可见的地理要素转化为虚拟声源,以跨模态的方式传递给视障患者。通过调制虚拟声场的频率、振幅和响度,赋予地理要素不同的语义标签,从而指导视障患者完成环境感知。在此基础上,通过深度学习方法,实现对视障患者的跨模态导航。

1 系统介绍与地理要素识别

本文提出的跨模态导航系统由两个消费级传感器(RGB-D 传感器和骨传导耳机)以及一个微型计算机构成,如图1所示。在该系统中,RGB-D传感器采集室内环境中的视觉特征以及视觉特征对应的深度信息。视觉和深度信息在计算机中进行处理和运算,生成听觉导航信息,并由骨传导耳机传递给视障患者。震动马达放置于患者的腰部,用于发送运动方向指令。

图1 辅助导航系统示意图

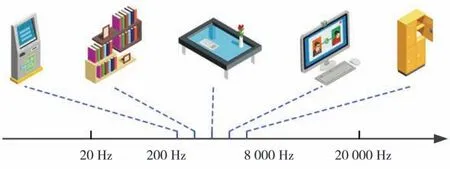

在跨模态导航系统中,视觉传感器采集到的信息首先被输入到YOLO-V3 深度学习模型[10]中,对室内场景中的重要地理要素进行识别和标记。对于视障患者来说,室内环境中的重要地理要素主要包括生活中所必须使用的生活设施,例如桌椅、电器、衣柜等。通过深度学习方法可以对图像中的地理要素进行识别并加以理解和标记。获得地理要素标签后,将地理要素以声学符号的形式加以描述,并以虚拟声源的方式将地理要素进行表示。在室内地理要素转换为虚拟声源之前,需要根据人耳的听力范围,对不同的语义元素进行音频编码,即对不同的语义元素赋予不同频率的音频信号,频谱划分示例如图2 所示。人的听觉系统可以分辨20~20 000 Hz 范围内的声音信号。本系统中选用更为舒适的频率区间(即200~8 000 Hz)用于对地理要素的音频编码。

图2 虚拟声源频谱划分示例

2 视觉地理要素的跨模态声学渲染

在本导航系统中,将采用头相关传输函数进行视觉地理要素的跨模态声学渲染。头相关传输函数(Head Related Transfer Function,HRTF)是一个与头部相关脉冲响应的傅里叶变换,头相关传输函数结果取决于患者与地理要素之间的相对位置。头相关传输函数是一个线性时不变的传递函数,因此可以用线性时不变模型来近似[11]。本系统中主要利用头相关传输函数的空间指向特性来实现对地理要素的声学渲染。

根据RGB-D 传感器的原理可知,视觉图像中地理要素与传感器之间的距离可以通过深度传感器进行测量,该距离r在本系统认为是患者与地理要素之间的距离。利用头相关传输函数可以对地理要素进行二维声学渲染,得到在P位置处的渲染结果为:

其中,方位角φk表示患者与地理要素在水平面上的相对位置关系;wk为与方位角相关的权重。如果将RGB-D 传感器上彩色相机的光心与地理要素之间的连线称为视觉线,那么方位角即为视觉线与彩色相机光轴在水平面上的夹角。

由式(1)可知,P位置处的声学渲染结果是由已测量的HRTF 函数结果f(φk) 加权相加得到的。

通过参数(φ,r) 可以表示出患者与地理要素之间的相对位置关系。当地理要素与患者的方向角为φ(φk≤φ≤φk+1)时,利用邻域线性插值法可得[12]:

由式(3)可知,视障患者与地理要素之间的相对位置关系由渲染结果表示。在实际应用过程中,需要针对左右耳分别进行声学渲染,从而获得左右耳的渲染结果和。此外,地理要素与患者之间的距离用音频的强度来表示,不同地理要素之间用不同频率的音频信号来加以区分。这样,RGB-D 传感器采集到的视觉信号便转化为了视障患者可以感知的音频信号。

3 基于深度学习的辅助导航

本系统中提出了基于深度学习的视听觉协同导航框架(如图3 所示),在此框架下为视障患者提供环境感知和辅助导航信息。视听觉协同导航框架包含有三个卷积神经网络(CNN)层(卷积核尺寸分别为8 × 8、4 × 4 以及3 × 3)、一个线性层以及一个门限循环单元。导航框架的输入是视觉信息、深度信息以及经过处理的双耳音频信号,经过卷积网络处理后,得到向量VV、VD和VA。将三个向量串联并输入到门控循环单元中,门控循环单元同时处理当前输入状态ht和历史累积状态ht-1,从而更新当前状态,并输出观测状态ot。利用评判(Critic)模块和执行(Actor)模块可以进一步计算出状态值V(ot,ht-1)以及策略分布πφ(at|ot,ht-1)。动作采样器对执行模块数据进行处理,并结合室内环境形成“动作-状态”集反馈给输入端,从而为下一步运动提供参考策略。

图3 基于深度学习的视听觉协同导航框架

面向视障患者的辅助导航系统在提供运动决策方案时,需要预先定义运动指令集合A={MF,TL,TR,LF,RF,S} ,其中,MF 表示前进、TL 表示左转、TR 表示右转、LF 表示向左前方前进、RF表示向右前方前进,S表示停止。在某个时间t,室内环境状态为st∈S,辅助导航系统观测到的状态为ot,该状态包含有辅助导航系统渲染的音频、RGB-D 传感器采集的视觉和深度信息。辅助导航系统根据先前状态ht-1和当前观测状态ot制定策略πt,θ:A→[ 0,1] ,其中,辅助导航系统在时刻t指导患者实施动作a(tat∈A)的概率是πt,θ(at|ot,ht-1)。当辅助导航系统进入下一个状态st+1,即时奖励定义为rt∈ℝ。未来衰减奖励之和Gt,γ为:

其中,γ∈[ 0,1] 是衰减系数,用于调节对近期或长期奖励权重;Vt,θ(ot,ht-1)的值是期望回报。本系统采用近端策略优化(Proximal Policy Optimization)[13]对导航系统进行优化,近端策略优化是一种具有高鲁棒性和高采样率的一阶优化方法,在充分考虑视障患者运动特性和安全约束规则的条件下,近端策略算法可以实现对患者运动方案的优化,从而提高辅助导航系统的性能表现。优化后的导航系统可以向视障患者发出运动指令,指导患者在室内环境中进行自主移动。

在辅助导航系统运行过程中,室内环境信息(包括障碍物检测结果、人类状态识别结果等)和辅助导航信息通过骨传导耳机和振动马达传递给视障患者,指导患者与室内设施的互动,并指引患者进行自主运动。具体来说,患者利用数字键盘选择一个地理要素作为导航目的地,这样患者便可以通过音频渲染结果识别出地理要素的距离和方位,同时通过振动马达感知运动方向。这样,视障患者便可以在已知目的地方位的情况下,依据震动信号进行室内行走,更有利于发挥患者的主观能动性,更好地完成自主运。

4 实验结果与分析

本文中提出的辅助定位系统以RGB-D 传感器(Intel Real Sense D435i)作为信息输入设备,信息经过微型计算机运算和加工后,导航信息通过骨传导耳机(SHOKZ Open Run Pro)和震动马达传递给视障患者。辅助导航系统运行在ubuntu18.04 操作系统上,配备有Intel I7 9700K 处理器和NVIDIA GeForce RTX 2070 SUPER 显卡。本文实验主要验证辅助导航系统的导航指引性能和地理要素感知性能。

辅助导航系统通过渲染声音信号,为患者提供地理要素指引信息,即方位信息。为了验证辅助导航系统的方位指引能力,实验前召集了16 名身体健康的志愿者作为测试对象。测试对象接收到音频信号后,需要根据左右耳信号差别,判断地理要素的方向。实验中共设置12 类生活常用物品(包括冰箱、电视机、计算机、打印机等),对不同种类物品赋予不同的音频标签,以供用户判断物品种类。不同物品分别摆放在与人体矢状面夹角为-90°、-60°、-30°、0°、30°、60°、90°位置处,不同位置被编号为P1、P2、…、P7。对于每位待测试志愿者,分别在不同位置摆放不同物品用于测试,每个物品重复测试10 次,计算志愿者感知到的方位与真实方位之间的角度误差,结果如表1 所示。综合分析16 名志愿者的方向指引结果,在位置P1、P2、P3、P4、P5、P6、P7处的平均方位指引误差分别为2.5°、3.3°、4.5°、8.1°、4.9°、4.2°、2.7°。

表1 辅助导航系统方位指引误差统计表

从辅助导航系统方位指引误差统计结果来看,方位指引精度在人体矢状面夹角为-90°和90°时,方位指引精度最高;物品位置与人体矢状面夹角为0°时,方位指引误差较大。该结果表明,当被测试者接收到的左右耳信号差别较大时(即在P1和P7位置处),被测试者方位辨别能力较强;当被测试者接收到的左右耳信号差别较小时(即在P4位置处),被测试者方位辨别能力较弱。对于所有被测试志愿者,不同角度下的方位指引平均误差为4.31°。

在蒙住眼睛的情况下,志愿者佩戴导航系统进行室内行走实验,导航目的地为预先设定好的地点。志愿者事先不了解测试场地的实际情况,开始测试时蒙住眼睛并由工作人员带领至测试场地。导航开始后,志愿者仅依靠辅助导航系统在室内进行自主行走。测试场地中安装有光学三维动作捕捉系统,可以完整记录志愿者的运动轨迹。通过比较志愿者的运动轨迹和导航规划路径,可以评估辅助导航系统的性能表现。图4 所示为某个志愿者的辅助导航结果示例,图中由黑色圆点组成的轨迹是导航系统的规划路径,由星号组成的轨迹是志愿者实际运动路径。

图4 辅助导航结果示例

通过图4 所示结果可知,当导航系统引导志愿者进入转弯状态时,产生的导航误差较大;当志愿者直行时导航误差较小。这是因为导航系统向志愿者发出转弯信号后,志愿者接收信号并执行时会产生偏差,从而导致实际路径与规划路径不一致。导航系统的引导误差用均方根误差(RMSE)进行评价,计算公式如下:

其中,pi为导航规划路径点;p̂i为志愿者实际运动轨迹点。

在实际的辅助导航实验中发现,导航系统在引导视障患者直线行走时,导航精度较高;当导航系统引导患者进行转弯时,产生的引导误差大于直行引导误差。因此,本文对不同导航状态下的引导误差进行了统计,结果如表2 所示。对于16 位参与实验的志愿者,每位志愿者均在导航系统的指引下完成10 次辅助导航任务,直行状态平均引导误差为5.936 cm,转弯状态平均引导误差为17.793 cm,不同导航引导状态下的平均引导误差为15.125 cm。通过分析导航误差结果可知,在辅助导航系统引导志愿者进行直行时,引导误差较低,仅为5.936 cm。但是,当辅助导航系统引导志愿者进行转弯时,平均导航误差达到17.793 cm。

表2 辅助导航引导误差统计表

在转弯状态下,导致系统引导误差较高的原因主要有两个方面:(1)志愿者接收到系统发送的以震动形式传递的转弯信号后,需要一段反应时间,导致运动方向的改变滞后于系统指令;(2)志愿者对方位理解存在偏差,无法准确地对“向左前方前进”、“向右前方前进”等指令做出准确的响应动作。针对以上两个问题,可以让使用辅助导航系统的患者参加短期导航训练。实验表明,当16 名志愿者分别参加20 次导航训练后,转弯引导误差的平均值可以降至9.476 cm,综合导航引导误差可以控制在10 cm 以内。

5 结论

针对视障患者在室内场景中行动困难的问题,提出了跨模态环境感知与导航系统,该系统通过头相关传输函数将RGB-D 相机采集的视觉和距离信息转化为视障患者可以感知的音频信号,并利用深度学习方法实现辅助导航功能,以震动方式将导航信号传递给视障患者,从而使视障患者在感知地理要素方位的同时,在导航系统的指引下完成运动。实验结果表明,辅助导航系统的平均方位指引误差为4.31°,平均导航误差为9.476 cm,可以有效帮助视障患者在室内场景中完成自主运动。