高低维特征引导的实时语义分割网络

2023-10-21虞资兴瞿绍军何鑫王卓

虞资兴,瞿绍军*,何鑫,王卓

高低维特征引导的实时语义分割网络

虞资兴1,瞿绍军1*,何鑫2,王卓1

(1.湖南师范大学 信息科学与工程学院,长沙 410081; 2.湖南华诺星空电子技术有限公司,长沙 410221)( ∗ 通信作者电子邮箱qshj@hunnu.edu.cn)

多数语义分割网络利用双线性插值将高级特征图的分辨率恢复至与低级特征图一样的分辨率再进行融合操作,导致部分高级语义信息在空间上无法与低级特征图对齐,进而造成语义信息的丢失。针对以上问题,改进双边分割网络(BiSeNet),并基于此提出一种高低维特征引导的实时语义分割网络(HLFGNet)。首先,提出高低维特征引导模块(HLFGM)来通过低级特征图的空间位置信息引导高级语义信息在上采样过程中的位移;同时,利用高级特征图来获取强特征表达,并结合注意力机制来消除低级特征图中冗余的边缘细节信息以及减少像素误分类的情况。其次,引入改进后的金字塔池化引导模块(PPGM)来获取全局上下文信息并加强不同尺度局部上下文信息的有效融合。在Cityscapes验证集和CamVid测试集上的实验结果表明,HLFGNet的平均交并比(mIoU)分别为76.67%与70.90%,每秒传输帧数分别为75.0、96.2;而相较于BiSeNet,HLFGNet的mIoU分别提高了1.76和3.40个百分点。可见,HLFGNet能够较为准确地识别场景信息,并能满足实时性要求。

实时语义分割;上采样;注意力机制;金字塔池化;上下文信息

0 引言

语义分割(semantic segmentation)是计算机视觉领域的研究热点之一,它的主要价值是能够将图像分割成几组具有某种特定语义的像素区域,并识别每个区域的类别,最终获得几幅具有像素语义标注的图像。因此语义分割在室内导航、地理信息系统、自动驾驶、虚拟增强现实系统和场景理解等领域有着重要的应用价值[1]。传统语义分割利用图像灰度、空间纹理、颜色和几何形状等低级特征将图像分割成不同部分,主要有基于阈值的分割方法[2]、基于边缘的分割方法[3]、基于区域的分割方法[4-5]和基于图的分割方法[6]等。虽然这些方法分割速度快,但需要人为设计特征提取器,同时对复杂场景的分割效果不佳。基于深度学习的语义分割方法表现出强大的特征提取能力,Long等[7]提出全卷积网络(Fully Convolutional Network, FCN),将卷积神经网(Convolutional Neural Network, CNN)[8]中的全连接层替换为全卷积层以实现像素级的密集预测,使用反卷积对特征图上采样,并提出跳跃连接充分融合全局语义信息和局部位置信息,实现精确分割[9],为语义分割的快速发展奠定了基础。

尽管FCN模型强大且普适,但它固有的空间不变性导致它没有考虑有用的全局上下文信息;同时,随着图像不断的下采样操作,分辨率不断缩小,导致部分像素丢失,严重影响了最终的分割精准性。针对前者,金字塔场景解析网络(Pyramid Scene Parsing Network, PSPNet)[10]使用金字塔池化(Pyramid Pooling)模块抽取多尺度的上下文信息,以解决物体多尺度的问题从而提升精度;DeepLab-v2[11]提出了一种新的空洞卷积(Atrous Convolution),以抽取多尺度上下文信息。针对后者,Ronneberger等[12]提出了一种编码器‒解码器的网络模型U-Net,U-Net由收缩路径和扩展路径组成:收缩路径利用下采样捕捉上下文信息,提取特征;扩展路径是一个解码器,使用上采样操作还原原始图像的位置信息,逐步恢复物体细节和图像分辨率。Yu等[13]利用双分支结构设计了双边分割网络(Bilateral Segmentation Network, BiSeNet),主要思想是用一个带有小步长的空间路径保留空间位置信息,生成低级的高分辨率的特征图;再用轻量特征提取网络结合全局池化操作,合并不同层(level)的中间特征与全局池化的输出,得到高级的低分辨率的语义信息,最后将两者融合得到高级的高分辨率特征图。但是,上述方法并没有考虑多尺度特征融合过程中语义信息丢失的问题。语义流网络(Semantic Flow Network, SFNet)[14]将光流法的思想应用在特征对齐中,提出了流对齐模块以加强特征表示;但是它的计算成本太高,导致网络并不适用于实时应用。

针对语义分割模型在多尺度特征融合过程中出现语义信息丢失、细节信息冗余的问题,提出一种高低维特征引导的实时语义分割网络(High-Low dimensional Feature Guided real-time semantic segmentation Network, HLFGNet)。

本文的主要工作如下:

1)提出高低维特征引导模块(High-Low dimensional Feature Guided Module, HLFGM),解决BiSeNet在合并不同level的中间特征时,由于特征图尺寸不同出现的语义信息丢失问题。

2)提出金字塔池化引导模块(Pyramid Pooling Guided Module, PPGM)。改进金字塔池化模块(Pyramid Pooling Module,PPM),利用原始特征图引导不同尺度的池化特征图,加强不同尺度局部信息的有效融合,增强全局上下文信息提取能力。

在公开数据集Cityscapes[15]和CamVid[16]上的实验结果显示,HLFGNet具有较好的分割效果。

1 相关工作

1.1 基于卷积神经网络的语义分割

DeepLab-v1使用空洞卷积[17]解决编码过程中因为信号不断被下采样导致细节丢失的问题;使用全连接条件随机场(Fully-connected Conditional Random Field)提高模型捕获结构信息的能力,从而扩大感受野和捕捉边缘细节,但并未注意多尺度信息。DeepLab-v2[11]提出空洞空间金字塔池化(Atrous Spatial Pyramid Pooling, ASPP)模块,在给定的特征层上使用不同扩展率(dilation rate)的空洞卷积,可以有效地重采样。通过构建不同感受野的卷积核获取多尺度物体信息,解决不同检测目标大小差异的问题。随着空洞率的增大,卷积核的有效参数越来越少,最终会退化成1×1的卷积核。DeepLab-v3[18]将ASPP模块中尺寸为3×3、膨胀率=24的空洞卷积替换成一个普通的1×1卷积,以保留滤波器中间部分的有效权重;最后的特征图通过16倍双线性插值上采样变为与输入图像相同大小的分辨率,但这种方法无法获得分割目标的细节。DeepLab-v3+[19]在DeepLab-v3的基础上引入解码网络以恢复丢失的边界信息,提高了物体边界分割的准确度。PSPNet[10]采用4路并行的不同尺度自适应平均池化,分别获取不同尺度划分下的局部上下文信息后在通道上合并,提高全局信息的获取能力。

1.2 实时语义分割

实时语义分割算法需要一种快速生成高质量预测的方法,即推理速度要达到30 frame/s。现阶段的算法主要通过裁剪或限定图像大小降低计算复杂度,或通过分解卷积提高实时性。用于实时语义分割的深度神经网络架构——高效神经网络(Efficient neural Network, ENet)[20]通过早期下采样策略,裁剪模型通道,减少运算和降低内存占用,但裁剪会丢失细节信息;图像级联网络(Image Cascade Network, ICNet)[21]使用图像级联加速语义分割方法;BiSeNet[13]利用一条浅层分支获取空间细节,另一条分支获取深层的语义信息,再将两条分支融合输出;BiSeNet V2[22]去掉了旧版本中耗时的跨层连接,深化细节路径以编码更多细节,设计了基于深度卷积的轻量级语义路径组件;Fan等[23]重新设计网络架构,将空间边界信息的学习集成到低层级部分,同时设计短期密集连接(Short-Term Dense Concatenate, STDC)模块,融合连续若干个不同感受野的卷积核以弥补语义分支感受野的不足,有效提取语义边界区域特征;Peng等[24]提出一种高效的实时语义分割模型PP-LiteSeg,在解码器的部分逐步减少特征通道并恢复分辨率,保证深层阶段语义信息的完整,同时减少浅层阶段的冗余计算。

1.3 注意力机制

注意力可以有效地捕获不同位置(像素)之间的长程相关性,所有位置的加权和得到每个位置的特征;因此,每个位置(像素)都可以获得全局视野,并且不降低特征映射(分辨率降低)。压缩激励网络(Squeeze-and-Excitation Network, SENet)[25]通过全局平均池化(Global Average Pooling, GAP)和全连接层获得通道注意图;卷积块注意模块(Convolutional Block Attention Module, CBAM)[26]将GAP和全局最大池化结合1×1卷积操作,得到一个带有注意力的特征图。双重注意网络(Dual Attention Network, DANet)[27]提出整合局部信息和全局信息以捕捉上下文信息,再由注意力机制获得特征表达。双边注意力网络(Bilateral Attention Network, BANet)[28]利用通道相关系数注意模块学习通道映射之间的正负依赖关系,并利用所有通道映射的加权和更新每个通道映射。全局上下文注意力模块(Global Context Attention Module, GCAM)[29]由注意力细化模块分别对平均池化和最大池化后的特征进行通道加权,重新调整特征权重,得到与它们大小对应的权重图,再由元素加法操作融合特征,以极少的计算量获得更加丰富的全局上下文信息,最后利用3×3卷积进一步增强特征的表达能力。注意力网络(ATTention Network, ATTNet)[30]提出空间‒条形注意力模块,采用1×和×1的条形池化核提取特征,避免传统池化核带来的无关信息和额外参数计算,从而有效捕获局部区域的长距离依赖关系。基于注意力感知的全卷积网络CANet(Context Attention Network)[31]提出空洞空间金字塔注意力模块,在空洞空间金字塔中嵌入像素相似注意力模块,增强像素之间的联系,解决像素丢失的问题。轻量级注意力引导的非对称网络(Lightweight Attention-guided Asymmetric Network, LAANet)[32]提出注意力引导的扩展金字塔池化(Attention-guided Dilated Pyramid Pooling, ADPP)模块和注意力引导的特征融合上采样(Attention-guided Feature Fusion Upsampling, AFFU)模块,分别用于聚合多尺度上下文信息和融合不同层的特征。残差高效学习和注意期望融合网络(Residual Efficient Learning and Attention Expected fusion Network, RELAXNet)[33]将注意力机制引入编码器和解码器之间的跳跃连接中,促进高层特征和低层特征的合理融合。

1.4 特征融合

特征融合模块(Feature Fusion Module, FFM)常用于语义分割,加强特征表示。除了逐元素求和外,研究人员还提出了以下几种方法。在BiSeNet中,FFM采用element-wise mul方法融合自空间和上下文分支的特征。为了增强具有高级上下文的特征,深层特征聚合网络(Deep Feature Aggregation Network, DFANet)[34]提出了一个具有多次连接结构的语义分割模块,最大化多尺度的感受野。为了解决错位问题,SFNet和特征对齐分割网络(feature-Aligned Segmentation network, AlignSeg)[35]首先通过CNN卷积学习变换偏移量,其次利用变换偏移量引导低级特征和高级特征的融合。特征金字塔聚合网络(Feature Pyramid Aggregation Network, FPANet)[36]利用可学习的向量进行加权以平衡两个特征的级联,再使用一个1×1卷积和三个不同速率的空洞卷积组成金字塔特征融合模块。

2 高低维特征引导的实时语义分割网络

BiSeNet是一个端到端的实时语义分割网络,通过双分支结构获取高分辨率的高级特征图。本文借鉴该思想,改进该网络结构,设计了基于高低维特征引导的实时语义分割网络(HLFGNet)。

2.1 网络整体结构

本文网络的整体结构如图1所示,由一个提取高级语义特征的语义分支(Semantic Branch)、一个提取空间细节信息的细节分支(Detail Branch)和FFM构成。注意力细化模块(Attention Refinement Module, ARM)和FFM模块为BiSeNet中的两个模块,后文不再介绍。

图1 高低维特征引导的实时语义分割网络

在语义分支中,主干网络采用在ImageNet上预先训练并去掉最后全连接层的残差网络ResNet-18(Residual Network-18)[37],即图1中的第1个卷积(Conv)池化操作和后续的4个残差(Res)块,它的详细结构如表1所示。

表1 ResNet-18的详细结构

注:“7×7”表示卷积核大小为7×7,“64”为卷积核数(输出通道数),“stride=2”表示步长为2,Maxpool表示最大池化,“×2”表示输入数据将会执行该矩阵结构2次,后续结构以此类推。

每个Res(=1,2,3,4)都包含一个基本结构(包含残差(residual)结构),具体结构如表1中Res块的矩阵所示。首先,Res3块经过ARM得到Out3,Res4块经过PPGM获取具有全局上下文信息的Out4,此时特征映射的大小减小到原始图像的1/32。其次,Out3与Out4经过HLFGM得到原始图像1/16大小的特征图,该特征图再和Res2块一起作为输入,经过HLFGM得到语义分支的最终输出,此时特征映射的大小为原始图像的1/8。

在细节分支中,原始图像经过4个浅层的Stage得到原始图像1/8大小的特征图,它的详细结构如表2所示。其中,Conv2d代表Conv+BN(Batch Normalization)+ReLU(Rectified Linear Unit)组合操作。

表2 细节分支的详细结构

最后将两个分支的输出经过FFM融合,再经过上采样恢复成最终的预测分割图。

2.2 高低维特征引导模块

语义分割的最终目的是获得一幅高分辨率的高级语义特征图。但是在卷积网络中,图像通过不断的下采样操作扩大感受野和获取语义特征,降低了图像的分辨率,导致空间细节信息丢失。一些网络利用空洞卷积加强特征提取,同时保持高分辨率,但空洞卷积需要耗费较多的计算力,导致推理速度变慢;另外一些网络将高级语义特征图双线性插值上采样后再与对应分辨率的低级特征图融合,逐步将分辨率恢复至原图大小,但高层特征在经过padding、卷积等操作后和低层特征之间的精确位置对应关系已经丢失,而简单的双线性插值并不能解决该问题。SFNet[14]提出同一张图像任意分辨率的两个特征图之间的关系,可以用一个特征图到另一个特征图的每个像素的“运动”表示,借助该运动关系引导高级特征图的扩张可以有效减少语义信息的丢失。根据这一思想,结合SENet[25]中的通道注意力机制,提出高低维特征引导模块(HLFGM),利用低级特征图中的空间位置信息引导高级语义信息在上采样过程中的位移,同时利用高级特征图中的强特征表达消除低级特征图中冗余的细节特征。HLFGM的详细结构如图2所示,计算方法如下:

其中:,为低级特征图;,为高级特征图;×为矩阵的乘法;δ为Sigmoid激活函数;BN为批标准化操作;为标准的卷积操作,即图2中的Conv1,卷积核大小为1×1,采样步长为1,d为空洞率,默认为1,不做任何填充,卷积操作不改变特征图的尺寸;AvgPool为顺着空间维度平均池化;,用来指导低级特征图上采样的位移图;为标准的卷积操作,即图2中的Conv3,卷积核大小为3×3,采样步长为1,在特征图外侧进行尺度为1的全1填充;Cat表示级联拼接操作;Up为双线性插值操作;GU为指导上采样的对齐操作;为ReLU激活函数;为权重系数,值为0.7。

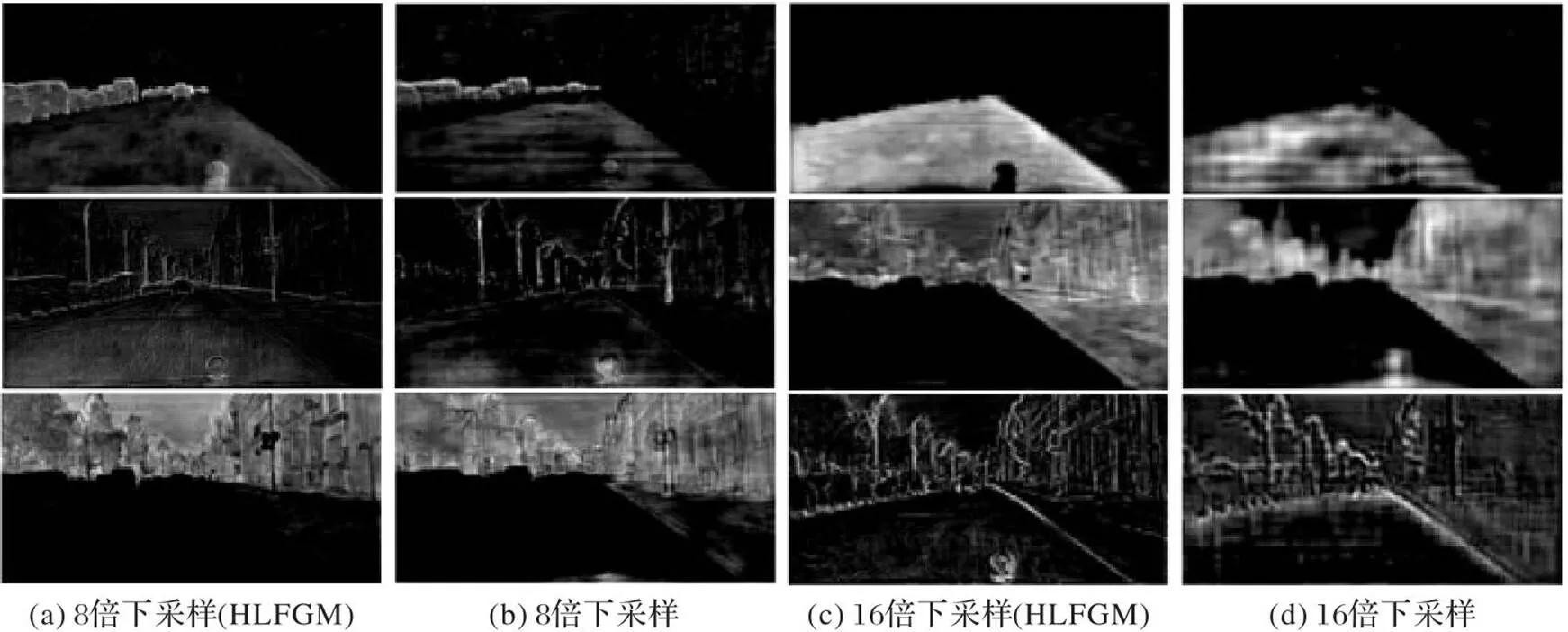

图3(a)和图3(c)分别为经过HLFGM得到的8倍和16倍下采样可视化图,图3(b)和图3(d)为未经过HLFGM得到的8倍和16倍下采样可视化图。对比图3(a)和图3(b)可以看出,前者获取的细节信息和语义信息更加丰富,如第1行图中车的轮廓、第3行图中左侧树的轮廓和右侧建筑的细节,而第2行图中后者丢失远处路杆特征;对比图3(c)和图3(d)可以看出,后者的整体效果较为模糊,细节信息丢失严重,而且第3行图中的街边和左侧车底轮廓出现重影。另外图3(b)和图3(d)的第1行图都出现了较为明显的条状纹理。

图3 高层特征图的可视化对比

2.3 金字塔池化引导模块

全局上下文信息和子区域上下文信息有助于区分各种类别。大感受野可以提升大尺寸目标的分割效果,对网络的性能具有重要意义。随着卷积层越来越多,感受野也随之变大,但Zhou等[38]证明CNN的经验感受野远小于理论感受野。BiSeNet使用GAP解决这一问题。虽然GAP广泛应用于图像分类中,并且它的计算量和内存消耗量低,但是对于复杂场景的图像,GAP不足以覆盖必要的信息,而且直接将图像信息融合形成单个向量的形式可能会失去空间关系并导致歧义,影响最终的分割效果。因此本文采用改进的金字塔池化引导模块(PPGM)获取全局上下文信息,扩大感受野。PPGM的详细结构如图4所示,计算方法如下:

图4 金字塔池化引导模块

3 实验与结果分析

3.1 实验数据集

Cityscapes[15]是一个街道场景语义分割数据集,每一张图像从行驶中的汽车的角度拍摄,从全世界50个不同的城市街道场景中收集5 000张高质量的像素级标注图,其中训练集、验证集和测试集的图像数分别为2 975、500和1 525张。5 000张图像标注的类别有33类,本文训练中只关心其中的19类。大类包括地面、建筑、人、天空、自然、背景、道路标志和车辆,小类将大类类别再细分(如车辆分为小汽车、公交等)。图像分辨率大小均为2 048×1 024像素的RGB通道的彩色图像,数据集还提供了20 000张粗略标注的图像用于训练弱监督分类网络的性能。

CamVid[16]是来自剑桥的道路与驾驶场景图像分割数据集,图像数据自视频帧提取,原始分辨率大小为960×720像素,包括32个类别。分为367张训练图像、100张验证图像和233张测试图像。

3.2 评估指标

在分割评价方面,采用平均交并比(mean Intersection over Union, mIoU)和每秒传输帧数,即帧率作为评价指标。mIoU为图像像素每个类的交并比(Intersection over Union, IoU)值累加后的平均值,如式(10)所示:

3.3 实验细节

本文深度学习框架为PyTorch1.4,训练时将图像大小调整为1 024×1 024像素作为网络输入,损失函数采用交叉熵损失函数,验证时图像输入大小为1 024×2 048像素。在两块Tesla-T4 GPU上训练,在一块Tesla-T4上测试模型。在训练过程中,采用带动量的随机梯度下降法(Stochastic Gradient Descent, SGD)用于模型训练,学习率下降公式为:

3.4 实验分析和比较

为了验证所HLFGM和PPGM的有效性,验证HLFGNet的改进效果,使用3.1.3节的参数和配置,采用ResNet-18作为网络主干,在Cityscapes数据集上展开消融和对比实验,结果如表3所示。

表3分别为HLFGM和UP(采用双线性插值上采样的方式)的对比,以及PPGM和AVG(采用全局平局池化操作的方式)、PPM的对比。将AVG改为PPM后,网络的参数量降低,这是因为AVG中卷积操作多,而PPM中池化和上采样操作多。相较于UP+AVG,HLFGM+AVG的mIoU仅提升0.19个百分点;相较于UP+PPM,HLFGM+PPM的mIoU提升0.80个百分点,说明在使用PPM的情况下使用HLFGM,网络提升显著。此外,相较于UP+AVG,UP+PPM的mIoU仅提升0.30个百分点;而相较于HLFGM+AVG,HLFGM+PPM的mIoU提升了0.91个百分点,说明在使用HLFGM的情况下使用PPM,网络提升显著。根据上述4组对比,可以发现HLFGM和PPM有相互促进的作用,进一步说明HLFGM能有效引导高级特征图的上采样,并且它的提升效果也与高级特征图所含信息的丰富性有关。相较于UP+PPM,UP+PPGM的mIoU提升1.04个百分点;相较于HLFGM+PPM,HLFGM+PPGM的mIoU提升0.66个百分点。因此相较于PPM,PPGM对网络提升的效果更佳。最终HLFGNet采用HLFGM+PPGM的方式,相较于采用UP+AVG的BiSeNet,mIoU提高了1.76个百分点,参数量减少了0.82 MB,推理速度仅降低了8 frame/s,模型的综合性能达到最佳。

表3 在Cityscapes 验证集上验证不同设置下的性能

表4 权重系数实验结果

相较于HLFGM,PPGM只使用了低级特征图引导高级特征图的路径,同时为了验证Guide操作(图4)对不同尺度特征图的有效性,展开了对比实验,如表5所示。可以看到,PPGM-1~PPGM-4的参数量都为50.53 MB,这是由于每个Guide操作只使用2个卷积核,因此增加多个Guide操作并不会增加过多的参数量。从表5还可以看出,随着逐渐增加对不同尺度特征图的Guide操作,推理速度逐渐降低。PPGM-2和PPGM-3的mIoU提升效果较为明显,为使速度和精度达到最佳平衡,最终选取PPGM-3,即只对3×3和6×6这两个尺度的特征图进行Guide操作,相较于PPM,mIoU提升0.66个百分点,速度下降3.0 frame/s。

表5 对不同尺度特征图进行Guide操作的对比实验结果

注:PPGM-代表对不同尺度的特征图进行Guide操作,代表经过降维后的不同尺度特征图,“√”表示对该尺度特征图进行Guide操作。

表6为不同网络在Cityscapes数据集上的对比结果,对比网络包括ICNet[21]、DFANet-A[34]、BiSeNet[13]、BiSeNet V2[22]和边界感知的实时语义分割网络(Boundary-Aware real-time Semantic segmentation Network, BASeNet)[39]、快速的实时语义分割网络(FasterSeg)[40]、STDC2(Short-Term Dense Concatenate)-Seg75[23]和STDC2-Seg75*[23](“*”表示未使用预训练模型)。

表6 不同网络在Cityscapes数据集上的实验结果对比

从表6可以看出,HLFGNet在测试集上的mIoU为75.4%,只比STDC2-Seg75低1.40个百分点,但HLFGNet的参数量比STDC2-Seg75少11.14 MB且帧率提高了26.1 frame/s。HLFGNet的帧率为75.0 frame/s,低于BiSeNet、BiSeNet V2和FasterSeg。但是,HLFGNet在测试集上的mIoU有着明显的优势,分别提升了0.9、2.5和3.9个百分点。在参数量上,HLFGNet也优于BiSeNet。相较于BiSeNet V2-L和STDC2-Seg75*,无论是速度、参数量还是mIoU,HLFGNet都有优势。由此可见,本文提出的HLFGNet在精度和推理速度上取得了较好的平衡,能够在保证精度较高的同时提高推理速度。

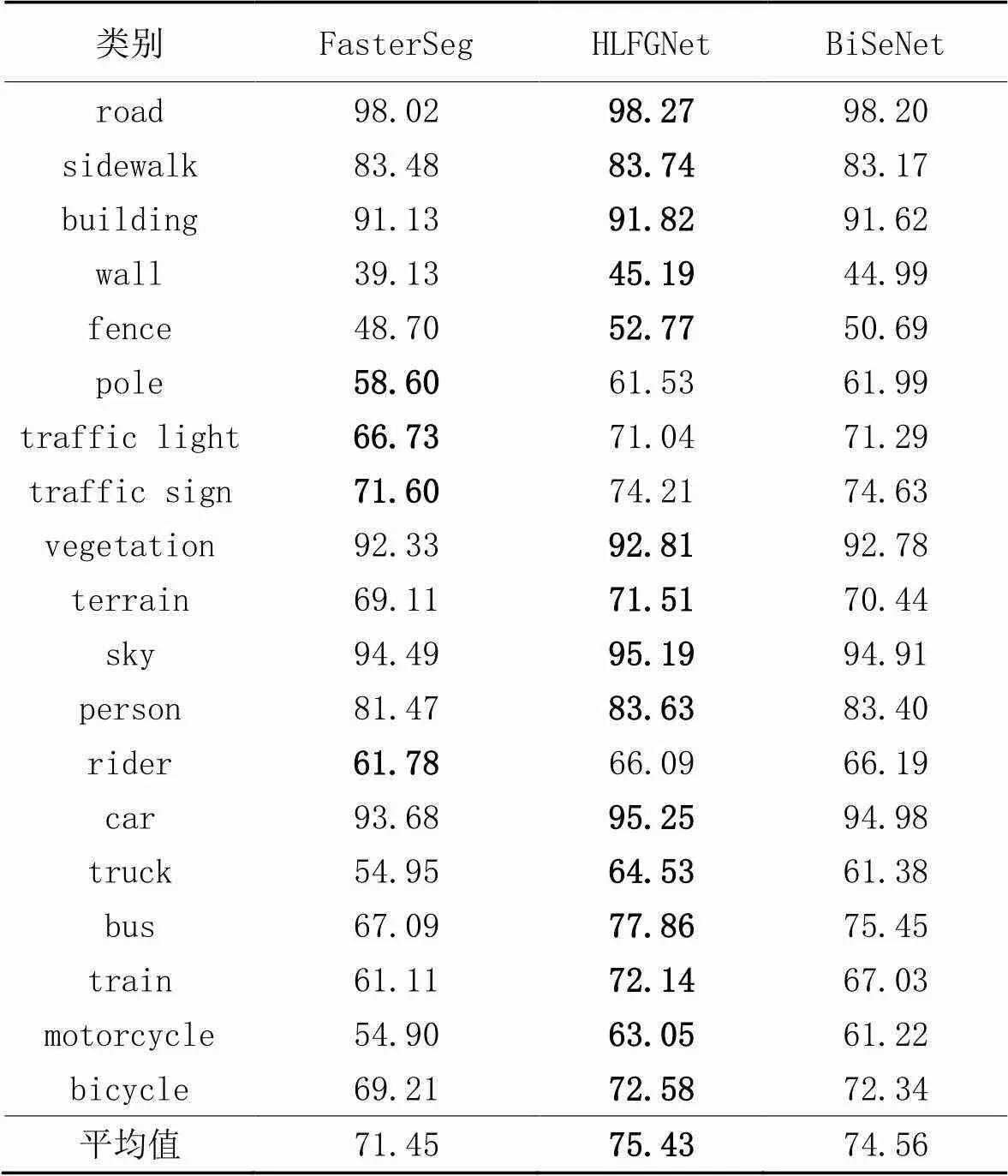

表7为FasterSeg、BiSeNet、HLFGNet在Cityscapes测试集上19种分类的结果。相较于FasterSeg,HLFGNet在所有分类上都有明显优势;相较于BiSeNet,HLFGNet在大部分的分类都有优势,特别是车类,如motorcycle、bus、train,这3类的准确率得到了提升,提升了1.83~5.11个百分点。

表7 Cityscapes测试集上各个类别的准确率 单位:%

为了验证HLFGNet的泛化性,本文在CamVid数据集上展开实验。将训练集和验证集一起用于训练,测试集用于评估。训练和评估的输入分辨率和输出分辨率都为720×960像素。训练参数设置与在Cityscapes数据集上基本保持一致。实验结果如表8所示,HLFGNet在CamVid测试集上能够达到70.90%的mIoU,推理速度为96.2 frame/s,相较于BiSeNet V2,mIoU提高了0.10个百分点,且推理速度提升14.3 frame/s。虽然HLFGNet的推理速度低于BiSeNet,但mIoU提升了3.40个百分点。另外,相较于SegNet、ICNet和ENet[20],无论在mIoU上还是在速度上都有优势。由此可见,HLFGNet在CamVid数据集上也获得了良好的性能。

表8 不同模型在CamVid测试集上的对比分析

3.5 实验定性分析

图5直观地展示了BiSeNet和HLFGNet在Cityscapes数据集上的可视化语义分割效果对比。从第1行图像的虚线标记框可以看出,对于自行车和汽车交叠部分和人脚与自行车的交叠部分,BiSeNet无法得到正确的分割边界;而HLFGNet通过利用HLFGM加强低级细节信息,有效增强像素之间的语义边界关系,准确地区分和分割了交叠部分。并且在第1行图像的实线框中,HLFGNet分割的人型轮廓相较于BiSeNet模型更细致。在第2行图像中,BiSeNet无法识别道路两边的栏杆,而HLFGNet虽然对于道路左侧的栏杆无法得到准确的分类,但是能够利用获取的细节信息较好地分割栏杆的轮廓细节。第3行图像的虚线标记框中,可以看出对于远距离路灯杆HLFGNet的识别能力更强;实线框中,BiSeNet分割的建筑物和路灯有部分像素点缺失;点线框中汽车和背景出现了融合的情况。在第4行图像的虚线框中,BiSeNet并未识别出左侧人物,右边重合的两人也丢失了大致轮廓细节;而HLFGNet不仅识别并分割了左侧人物,同时右侧两人重合后的区域边缘信息相对完整。在实线框中,BiSeNet分割出的柱体有部分像素错误分类,这是由于缺乏多尺度信息,而HLFGNet使用改进后的PPGM获取多尺度信息,因此柱体语义分类完整。

图5 语义分割实验效果的可视化对比

综上所述,HLFGNet相较于BiSeNet能够更好地识别出不同类别之间的语义轮廓,减少交叉划分的错误现象。同时HLGFM模块减少语义信息的丢失并且增强了细节信息使物体的边缘信息更加完整。

4 结语

为保证语义分割网络在精度和速度之间达到良好平衡,本文提出一种改进的实时语义分割网络(HLFGNet)。为减少多级特征图在融合过程中出现语义信息丢失的现象,提出了高低维特征引导模块,该模块利用低级特征图的空间位置信息指导高级特征图在上采样过程中的语义信息对齐,同时结合注意力机制,利用高级特征图获取到的强特征引导低级特征图去除冗余的细节特征;另外引入金字塔池化模块,并对它加以改进,使不同尺度的局部上下文信息能更好地融合,提高整体分割效果。为验证HLFGNet的有效性,在相同的环境配置下,分别在Cityscapes和CamVid数据集上展开实验,实验结果表明,HLFGNet能够在精度和推理速度之间取得较好的平衡,相较于其他网络,表现出了良好的性能。但HLFGNet还存在一定不足,语义分支采用的特征提取骨干网络为ResNet-18,该网络更适用于分类场景,所以在提取特征图的多尺度信息和全局上下文信息方面表现有所不足。因此在后续的研究中,需要考虑如何设计更适用于语义分割的特征提取网络。

[1] 罗会兰,张云. 基于深度网络的图像语义分割综述[J]. 电子学报, 2019, 47(10):2211-2220.(LUO H L, ZHANG Y. A survey of image semantic segmentation based on deep network[J]. Acta Electronica Sinica, 2019, 47(10): 2211-2220.)

[2] 张新明,李振云,郑颖. 融合Fisher准则和势函数的多阈值图像分割[J]. 计算机应用, 2012, 32(10):2843-2847.(ZHANG X M, LI Z Y, ZHENG Y. Multi-threshold image segmentation based on combining Fisher criterion and potential function[J]. Journal of Computer Applications, 2012, 32(10): 2843-2847.)

[3] 柳萍,阳爱民. 一种基于区域的彩色图像分割方法[J]. 计算机工程与应用, 2007, 43(6):37-39, 64.(LIU P, YANG A M. A method of region-based color image segmentation[J]. Computer Engineering and Applications, 2007, 43(6): 37-39, 64.)

[4] 李翠锦,瞿中. 基于深度学习的图像边缘检测算法综述[J]. 计算机应用, 2020, 40(11):3280-3288.(LI C J, QU Z. Review of image edge detection algorithms based on deep learning[J]. Journal of Computer Applications, 2020, 40(11): 3280-3288.)

[5] 宋杰,于裕,骆起峰. 基于RCF的跨层融合特征的边缘检测[J]. 计算机应用, 2020, 40(7):2053-2058.(SONG J, YU Y, LUO Q F. Cross-layer fusion feature based on richer convolutional features for edge detection[J]. Journal of Computer Applications, 2020, 40(7): 2053-2058.)

[6] 瞿绍军. 基于最优化理论的图像分割方法研究[D]. 长沙:湖南师范大学, 2018:32-66.(QU S J. Research on image segmentation based on optimization theory[D]. Changsha: Hunan Normal University, 2018: 32-66.)

[7] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2015: 3431-3440.

[8] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[9] 张鑫,姚庆安,赵健,等. 全卷积神经网络图像语义分割方法综述[J]. 计算机工程与应用, 2022, 58(8):45-57.(ZHANG X, YAO Q A, ZHAO J, et al. Image semantic segmentation based on fully convolutional neural network[J]. Computer Engineering and Applications, 2022, 58(8): 45-57.)

[10] ZHAO H, SHI J, QI X, et al. Pyramid scene parsing network[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6230-6239.

[11] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[12] RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[13] YU C, WANG J, PENG C, et al. BiSeNet: bilateral segmentation network for real-time semantic segmentation[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11217. Cham: Springer, 2018: 334-349.

[14] LI X, YOU A, ZHU Z, et al. Semantic flow for fast and accurate scene parsing[C]// Proceedings of the 2020 European Conference on Computer Vision, LNCS 12346. Cham: Springer, 2020: 775-793.

[15] CORDTS M, OMRAN M, RAMOS S, et al. The Cityscapes dataset for semantic urban scene understanding[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 3213-3223.

[16] BROSTOW G J, SHOTTON J, FAUQUEUR J, et al. Segmentation and recognition using structure from motion point clouds[C]// Proceedings of 2008 the European Conference on Computer Vision, LNCS 5302. Berlin: Springer, 2008: 44-57.

[17] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[EB/OL]. (2016-06-07) [2022-10-01].https://arxiv.org/pdf/1412.7062.pdf.

[18] CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[EB/OL]. (2017-12-05) [2022-10-24].https://arxiv.org/pdf/1706.05587.pdf.

[19] CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 801-818.

[20] PASZKE A, CHAURASIA A, KIM S, et al. ENet: a deep neural network architecture for real-time semantic segmentation[EB/OL]. (2016-06-07) [2022-04-10].https://arxiv.org/pdf/1606.02147.pdf.

[21] ZHAO H, QI X, SHEN X, et al. ICNet for real-time semantic segmentation on high-resolution images[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11207. Cham: Springer 2018: 418-434.

[22] YU C, GAO C, WANG J, et al. BiSeNet V2: bilateral network with guided aggregation for real-time semantic segmentation[J]. International Journal of Computer Vision, 2021, 129(11): 3051-3068.

[23] FAN M, LAI S, HUANG J, et al. Rethinking BiSeNet for real-time semantic segmentation[C]// Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2021: 9711-9720.

[24] PENG J, LIU Y, TANG S, et al. PP-LiteSeg: a superior real-time semantic segmentation model[EB/OL]. (2022-04-06) [2022-08-06].https://arxiv.org/pdf/2204.02681.pdf.

[25] HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018:7132-7141.

[26] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 3-19.

[27] FU J, LIU J, TIAN H, et al. Dual attention network for scene segmentation[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 3141-3149.

[28] WANG D, LI N, ZHOU Y, et al. Bilateral attention network for semantic segmentation[J]. IET Image Processing, 2021, 15(8): 1607-1616.

[29] 文凯,唐伟伟,熊俊臣. 基于注意力机制和有效分解卷积的实时分割算法[J]. 计算机应用, 2022, 42(9):2659-266.(WEN K, TANG W W, XIONG J C. Real-time segmentation algorithm based on attention mechanism and effective factorized convolution[J]. Journal of Computer Applications, 2022, 42(9): 2659-266.)

[30] 吴琼,瞿绍军. 融合注意力机制的端到端的街道场景语义分割[J]. 小型微型计算机系统, 2023, 44(7):1514-1520.(WU Q, QU S J. End-to-end semantic segmentation of street scene with attention mechanism[J]. Journal of Chinese Computer Systems, 2023, 44(7): 1514-1520.)

[31] 欧阳柳,贺禧,瞿绍军. 全卷积注意力机制神经网络的图像语义分割 [J]. 计算机科学与探索, 2022, 16(5):1136-1145.(OU Y L, HE X, QU S J. Fully convolutional neural network with attention module for semantic segmentation[J]. Journal of Frontiers of Computer Science and Technology, 2022, 16(5): 1136-1145.)

[32] ZHANG X, DU B, WU Z, et al. LAANet: lightweight attention-guided asymmetric network for real-time semantic segmentation[J]. Neural Computing and Applications, 2022, 34(5): 3573-3587.

[33] LIU J, XU X, SHI Y, et al. RELAXNet: residual efficient learning and attention expected fusion network for real-time semantic segmentation[J]. Neurocomputing, 2022, 474: 115-127.

[34] LI H, XIONG P, FAN H, et al. DFANet: deep feature aggregation for real-time semantic segmentation[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 9514-9523.

[35] HUANG Z, WEI Y, WANG X, et al. AlignSeg: feature-aligned segmentation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(1): 550-557.

[36] WU Y, JIANG J, HUANG Z, et al. FPANet: feature pyramid aggregation network for real-time semantic segmentation[J]. Applied Intelligence, 2022, 52(3): 3319-3336.

[37] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[38] ZHOU B, KHOSLA A, LAPEDRIZA A, et al. Object detectors emerge in deep scene CNNs[EB/OL]. (2015-04-15) [2022-05-12].https://arxiv.org/pdf/1412.6856.pdf.

[39] 霍占强,贾海洋,乔应旭,等. 边界感知的实时语义分割网络[J]. 计算机工程与应用, 2022, 58(17):165-173.(HUO Z Q, JIA H Y, QIAO Y X, et al. Boundary-aware real-time semantic segmentation network[J]. Computer Engineering and Applications, 2022, 58(17): 165-173.)

[40] CHEN W, GONG X, LIU X, et al. FasterSeg: searching for faster real-time semantic segmentation[EB/OL]. (2020-01-16) [2022-06-14].https://arxiv.org/pdf/1912.10917.pdf.

High-low dimensional feature guided real-time semantic segmentation network

YU Zixing1, QU Shaojun1*, HE Xin2, WANG Zhuo1

(1,,410081,;2,410221,)

Most semantic segmentation networks use bilinear interpolation to restore the resolution of the high-level feature map to the same resolution as the low-level feature map and then perform fusion operation, which causes that part of high-level semantic information cannot be spatially aligned with the low-level feature map, resulting in the loss of semantic information. To solve the problem, based on the improvement of Bilateral Segmentation Network (BiSeNet), a High-Low dimensional Feature Guided real-time semantic segmentation Network (HLFGNet) was proposed. First, High-Low dimensional Feature Guided Module (HLFGM) was proposed to guide the displacement of high-level semantic information during the upsampling process through the spatial position information of the low-level feature map. At the same time, the strong feature representations were obtained by the high-level feature maps, and by combining with the attention mechanism, the redundant edge detail information in the low-level feature map was eliminated and the pixel misclassification was reduced. Then, the improved Pyramid Pooling Guided Module (PPGM) was introduced to obtain global contextual information and strengthen the effective fusion of local contextual information at different scales. Experimental results on Cityscapes validation set and CamVid test set show that HLFGNet has the mean Intersection over Union (mIoU) of 76.67% and 70.90% respectively, the frames per second reached 75.0 and 96.2 respectively. In comparison with BiSeNet, HLFGNet has the mIoU increased by 1.76 and 3.40 percentage points respectively. It can be seen that HLFGNet can accurately identify the scene information and meet the real-time requirements.

real-time semantic segmentation; upsampling; attention mechanism; pyramid pooling; contextual information

This work is partially supported by National Natural Science Foundation of China (12071126).

YU Zixing, born in 1997, M. S. candidate. His research interests include computer vision, deep learning.

QU Shaojun, born in 1979, Ph. D., senior experimentalist. His research interests include image segmentation, computer vision, deep learning.

HE Xin, born in 1987, Ph. D. His research interests include deep learning, radar-vision fusion.

WANG Zhuo, born in 2000, M. S. candidate. Her research interests include computer vision, deep learning.

1001-9081(2023)10-3077-09

10.11772/j.issn.1001-9081.2022091438

2022⁃09⁃29;

2022⁃12⁃06;

国家自然科学基金资助项目(12071126)。

虞资兴(1997—),男,湖南株洲人,硕士研究生,CCF会员,主要研究方向:计算机视觉、深度学习; 瞿绍军(1979—),男,湖南永顺人,正高级实验师,博士,CCF会员,主要研究方向:图像分割、计算机视觉、深度学习; 何鑫(1987—),男,湖南邵阳人,博士,主要研究方向:深度学习、雷达视觉融合; 王卓(2000—),女,湖南邵阳人,硕士研究生,CCF会员,主要研究方向:计算机视觉、深度学习。

TP391.4

A

2022⁃12⁃12。