基于对比记忆网络的弱监督视频异常检测

2023-10-17李文中吴克伟孙永宣焦畅熊思璇

李文中 吴克伟 孙永宣 焦畅 熊思璇

摘 要:异常检测使用有限的训练集获得区分度高的特征,但是当异常实例与正常实例存在较多相似特征时,模型会因为异常特征参与正常特征编码产生误差。针对上述问题,提出了一种新型的对比记忆网络的弱监督视频异常检测方法。该方法在自动编码器的基础上使用对比学习框架,分离出与实际异常相似的样本特征,并设计记忆网络抑制正常样本内偏向异常的特征表达,提高了重建样本的稳定性。该算法构建了一种两阶段的异常行为检测网络。在阶段一,利用对比学习方法来增加正常行为特征和异常行为特征的差异,并利用该阶段学习到的特征构造记忆网络的增强项与抑制项。在阶段二,将记忆网络增强项设为多时刻正常行为特征,并利用记忆网络的抑制项更新增强项中偏向异常的特征信息,从而区分编码中正常与异常特征。该方法在UCF Crime和ShanghaiTech数据集的平均AUC值达到83.26%和87.53%,相较于现有方法分别提升了1.14%和2.43%。结果显示,该方法能够有效预测异常事件的发生时间。

关键词:异常检测;对比学习;记忆网络

中图分类号:TP381 文献标志码:A 文章编号:1001-3695(2023)10-043-3162-06

doi:10.19734/j.issn.1001-3695.2022.12.0829

Video anomaly detection combining with contrastive memory network

Li Wenzhong,Wu Kewei,Sun Yongxuan,Jiao Chang,Xiong Sixuan

(School of Computer Science & Information Engineering,Hefei University of Technology,Hefei 230601,China)

Abstract:Anomaly detection aims to capture the discriminative features with limited training samples.However,when some anomalies share common compositional patterns with the normal training data,the model likely reconstructs the anomalies well,leading to the miss detection of anomalies.To mitigate this drawback,this paper proposed a novel contrastive memory network,which used the contrast learning framework to separate the sample features based on the autoencoder,and then designed a memory network to suppress the normal features similar to anomaly.This method proposed a two-stage framework for detecting abnormal events.In the first stage,the method used contrastive learning to increase the difference between normal features and abnormal features,and gained representation to be the augment memory and suppression memory of memory network.In the second stage,the model used augment memory to record multi-time normal behavior features,and used suppression memory to constrain the expression of pseudo anomaly items in the augment memory.The AUC value reached 83.26% on UCF Crime datasets and 87.53% on ShanghaiTech datasets,which were 1.14% and 2.43% higher than the existing methods.The results demonstrate that this method can efficiently predict the temporal localization of anomaly events.

Key words:anomaly detection;contrastive learning;memory network

0 引言

视频监控中的异常检测指的是对不涉及普通行为的异常检测[1,2],在智能监控等领域应用广泛。该技术主要存在两个难点。首先是异常行为具有歧义性,在界定异常行为时,相似的动作在不同场合却是不同类型,如自行车行驶在公路上是正常的,出现在人行道则是异常的。其次是异常样本难以直接获取,真实场景中正常动作多,而异常行为少,异常样本不仅在长序列视频中占比低,而且缺乏帧级标签,这使异常检测难以像有监督学习般获取与类型相匹配的特征,考虑到视频级标签容易获取,因此多采用弱监督方法定位异常视频帧。

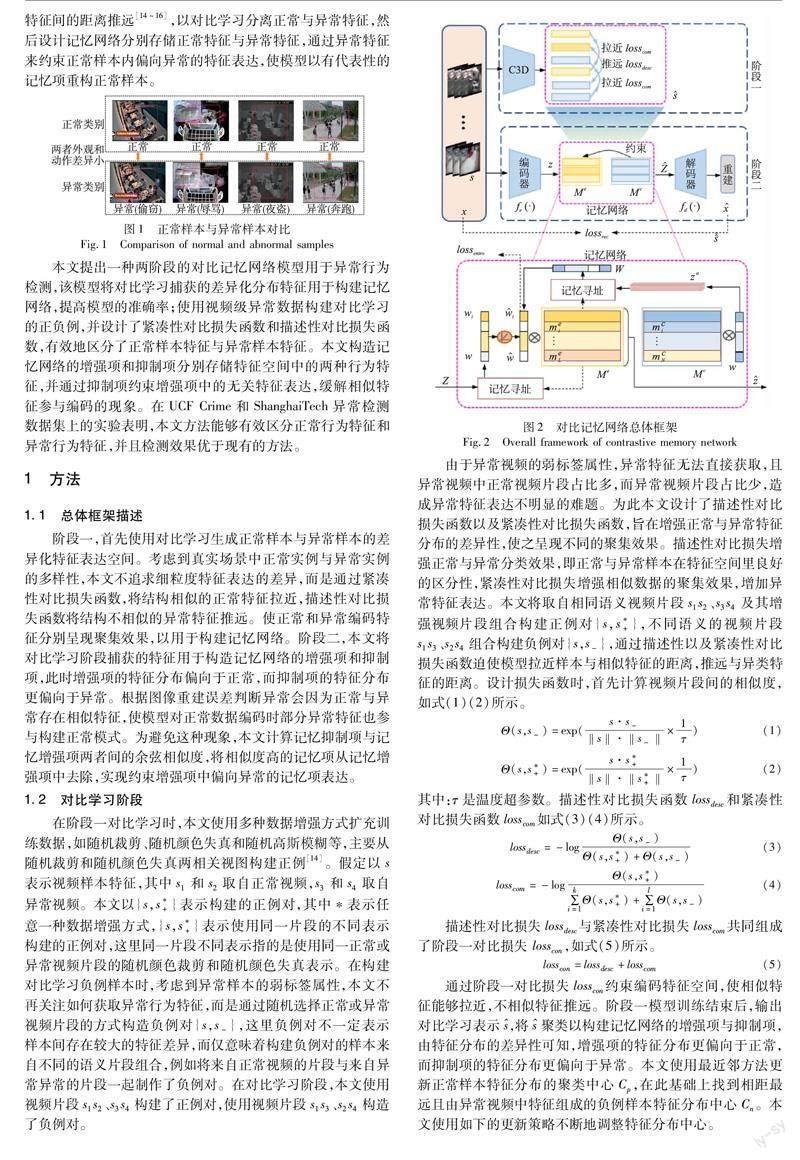

大多数现有弱监督方法[3~8]依赖多实例学习,虽然可以通过视频级标签检测异常帧,但是当异常视频片段与正常视频片段存在较多相似特征时,多实例学习往往难以准确定位异常帧。文献[9~13]通过重建视频帧的方法检测异常,使用正常视频数据训练编码器来获得正常数据的分布。在测试过程中,正常测试样本具有较小的重构误差,异常样本具有较大的重构误差。只使用正常视频样本训练编码器,在辨别异常样本时,编码器会因为从未见过异常样本而给出较高的重建误差,有利于区分异常,当异常外观呈现多样化時,编码器又会因为没有见过异常样本而无法检测微小的或者部分可见的异常。如在图1中,编码器获得正常帧的分布表示,因为没有用异常帧进行训练使得异常帧重建误差大,但是针对不同的异常种类,如偷窃、辱骂、夜盗和奔跑,由于异常帧与正常帧外观和运动动作差异小,编码器会因为没有见到异常导致误判。如果以弱监督异常视频样本训练编码器,由于缺少异常帧级标签而无法直接获取异常特征。本文在自动编码器的基础上使用对比学习框架,考虑到对比学习能将相似特征间的距离拉近,并将不相似特征间的距离推远[14~16],以对比学习分离正常与异常特征,然后设计记忆网络分别存储正常特征与异常特征,通过异常特征来约束正常样本内偏向异常的特征表达,使模型以有代表性的记忆项重构正常样本。

本文提出一种两阶段的对比记忆网络模型用于异常行为检测,该模型将对比学习捕获的差异化分布特征用于构建记忆网络,提高模型的准确率;使用视频级异常数据构建对比学习的正负例,并设计了紧凑性对比损失函数和描述性对比损失函数,有效地区分了正常样本特征与异常样本特征。本文构造记忆网络的增强项和抑制项分别存储特征空间中的两种行为特征,并通过抑制项约束增强项中的无关特征表达,缓解相似特征参与编码的现象。在UCF Crime和ShanghaiTech异常检测数据集上的实验表明,本文方法能够有效区分正常行为特征和异常行为特征,并且检测效果优于现有的方法。

1 方法

1.1 总体框架描述

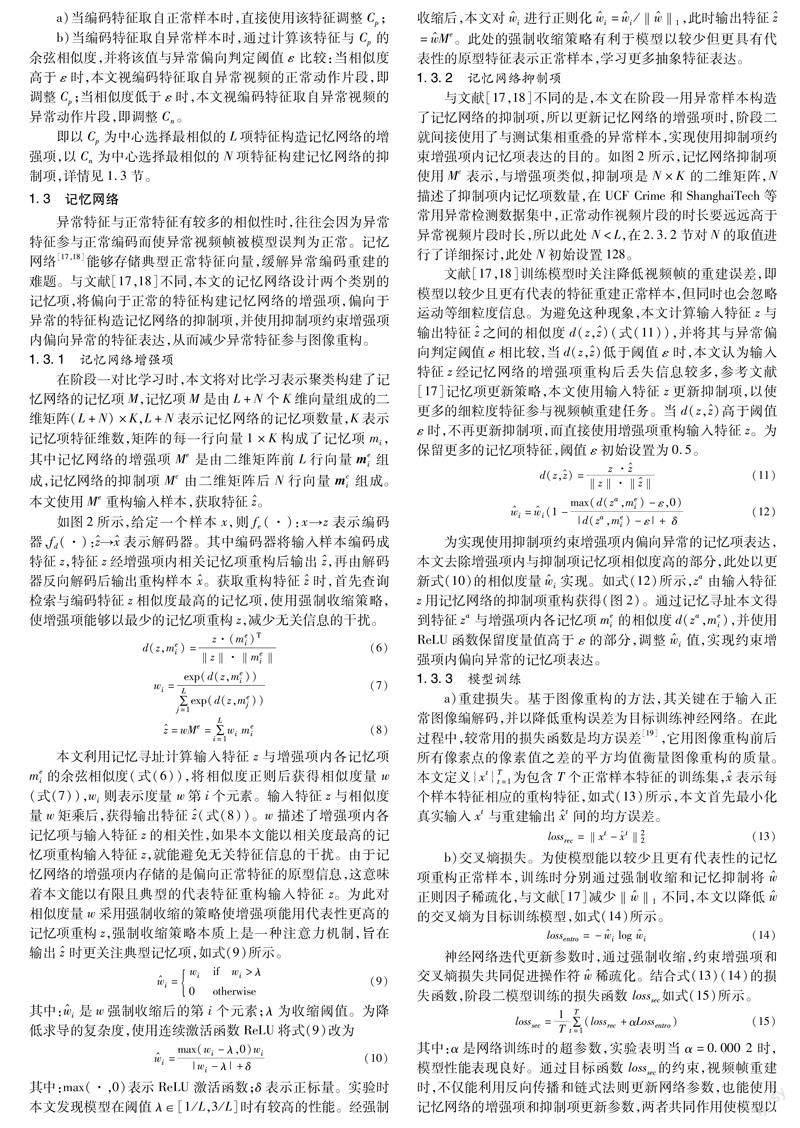

阶段一,首先使用对比学习生成正常样本与异常样本的差异化特征表达空间。考虑到真实场景中正常实例与异常实例的多样性,本文不追求细粒度特征表达的差异,而是通过紧凑性对比损失函数,将结构相似的正常特征拉近,描述性对比损失函数将结构不相似的异常特征推远。使正常和异常编码特征分别呈现聚集效果,以用于构建记忆网络。阶段二,本文将对比学习阶段捕获的特征用于构造记忆网络的增强项和抑制项,此时增强项的特征分布偏向于正常,而抑制项的特征分布更偏向于异常。根据图像重建误差判断异常会因为正常与异常存在相似特征,使模型对正常数据编码时部分异常特征也参与构建正常模式。为避免这种现象,本文计算记忆抑制项与记忆增强项两者间的余弦相似度,将相似度高的记忆项从记忆增强项中去除,實现约束增强项中偏向异常的记忆项表达。

1.2 对比学习阶段

在阶段一对比学习时,本文使用多种数据增强方式扩充训练数据,如随机裁剪、随机颜色失真和随机高斯模糊等,主要从随机裁剪和随机颜色失真两相关视图构建正例[14]。假定以s表示视频样本特征,其中s1和s2取自正常视频,s3和s4取自异常视频。本文以{s,s+}表示构建的正例对,其中*表示任意一种数据增强方式,{s,s+}表示使用同一片段的不同表示构建的正例对,这里同一片段不同表示指的是使用同一正常或异常视频片段的随机颜色裁剪和随机颜色失真表示。在构建对比学习负例样本时,考虑到异常样本的弱标签属性,本文不再关注如何获取异常行为特征,而是通过随机选择正常或异常视频片段的方式构造负例对{s,s-},这里负例对不一定表示样本间存在较大的特征差异,而仅意味着构建负例对的样本来自不同的语义片段组合,例如将来自正常视频的片段与来自异常异常的片段一起制作了负例对。在对比学习阶段,本文使用视频片段s1s2、s3s4构建了正例对,使用视频片段s1s3、s2s4构造了负例对。

由于异常视频的弱标签属性,异常特征无法直接获取,且异常视频中正常视频片段占比多,而异常视频片段占比少,造成异常特征表达不明显的难题。为此本文设计了描述性对比损失函数以及紧凑性对比损失函数,旨在增强正常与异常特征分布的差异性,使之呈现不同的聚集效果。描述性对比损失增强正常与异常分类效果,即正常与异常样本在特征空间里良好的区分性,紧凑性对比损失增强相似数据的聚集效果,增加异常特征表达。本文将取自相同语义视频片段s1s2、s3s4及其增强视频片段组合构建正例对{s,s+},不同语义的视频片段s1s3、s2s4组合构建负例对{s,s-},通过描述性以及紧凑性对比损失函数迫使模型拉近样本与相似特征的距离,推远与异类特征的距离。设计损失函数时,首先计算视频片段间的相似度,如式(1)(2)所示。

通过阶段一对比损失losscon约束编码特征空间,使相似特征能够拉近,不相似特征推远。阶段一模型训练结束后,输出对比学习表示,将聚类以构建记忆网络的增强项与抑制项,由特征分布的差异性可知,增强项的特征分布更偏向于正常,而抑制项的特征分布更偏向于异常。本文使用最近邻方法更新正常样本特征分布的聚类中心Cp,在此基础上找到相距最远且由异常视频中特征组成的负例样本特征分布中心Cn。本文使用如下的更新策略不断地调整特征分布中心。

a)当编码特征取自正常样本时,直接使用该特征调整Cp;

b)当编码特征取自异常样本时,通过计算该特征与Cp的余弦相似度,并将该值与异常偏向判定阈值ε比较:当相似度高于ε时,本文视编码特征取自异常视频的正常动作片段,即调整Cp;当相似度低于ε时,本文视编码特征取自异常视频的异常动作片段,即调整Cn。

即以Cp为中心选择最相似的L项特征构造记忆网络的增强项,以Cn为中心选择最相似的N项特征构建记忆网络的抑制项,详情见1.3节。

1.3 记忆网络

异常特征与正常特征有较多的相似性时,往往会因为异常特征参与正常编码而使异常视频帧被模型误判为正常。记忆网络[17,18]能够存储典型正常特征向量,缓解异常编码重建的难题。与文献[17,18]不同,本文的记忆网络设计两个类别的记忆项,将偏向于正常的特征构建记忆网络的增强项,偏向于异常的特征构造记忆网络的抑制项,并使用抑制项约束增强项内偏向异常的特征表达,从而减少异常特征参与图像重构。

1.3.1 记忆网络增强项

在阶段一对比学习时,本文将对比学习表示聚类构建了记忆网络的记忆项M,记忆项M是由L+N个K维向量组成的二维矩阵(L+N)×K,L+N表示记忆网络的记忆项数量,K表示记忆项特征维数,矩阵的每一行向量1×K构成了记忆项mi,其中记忆网络的增强项Me是由二维矩阵前L行向量mei组成,记忆网络的抑制项Mc由二维矩阵后N行向量mci组成。本文使用Me重构输入样本,获取特征。

如图2所示,给定一个样本x,则fe(·):x→z表示编码器,fd(·):→表示解码器。其中编码器将输入样本编码成特征z,特征z经增强项内相关记忆项重构后输出,再由解码器反向解码后输出重构样本。获取重构特征时,首先查询检索与编码特征z相似度最高的记忆项,使用强制收缩策略,使增强项能够以最少的记忆项重构z,减少无关信息的干扰。

本文利用记忆寻址计算输入特征z与增强项内各记忆项 mei的余弦相似度(式(6)),将相似度正则后获得相似度量w(式(7)),wi则表示度量 w第i个元素。输入特征z与相似度量w矩乘后,获得输出特征(式(8))。w描述了增强项内各记忆项与输入特征z的相关性,如果本文能以相关度最高的记忆项重构输入特征z,就能避免无关特征信息的干扰。由于记忆网络的增强项内存储的是偏向正常特征的原型信息,这意味着本文能以有限且典型的代表特征重构输入特征z。为此对相似度量w采用强制收缩的策略使增强项能用代表性更高的记忆项重构z,强制收缩策略本质上是一种注意力机制,旨在输出 时更关注典型记忆项,如式(9)所示。

其中:max(·,0)表示ReLU 激活函数;δ表示正标量。实验时本文发现模型在阈值λ∈[1/L,3/L]时有较高的性能。经强制收缩后,本文对i进行正则化i=i/‖‖1,此时输出特征=Me。此处的强制收缩策略有利于模型以较少但更具有代表性的原型特征表示正常样本,学习更多抽象特征表达。

1.3.2 记忆网络抑制项

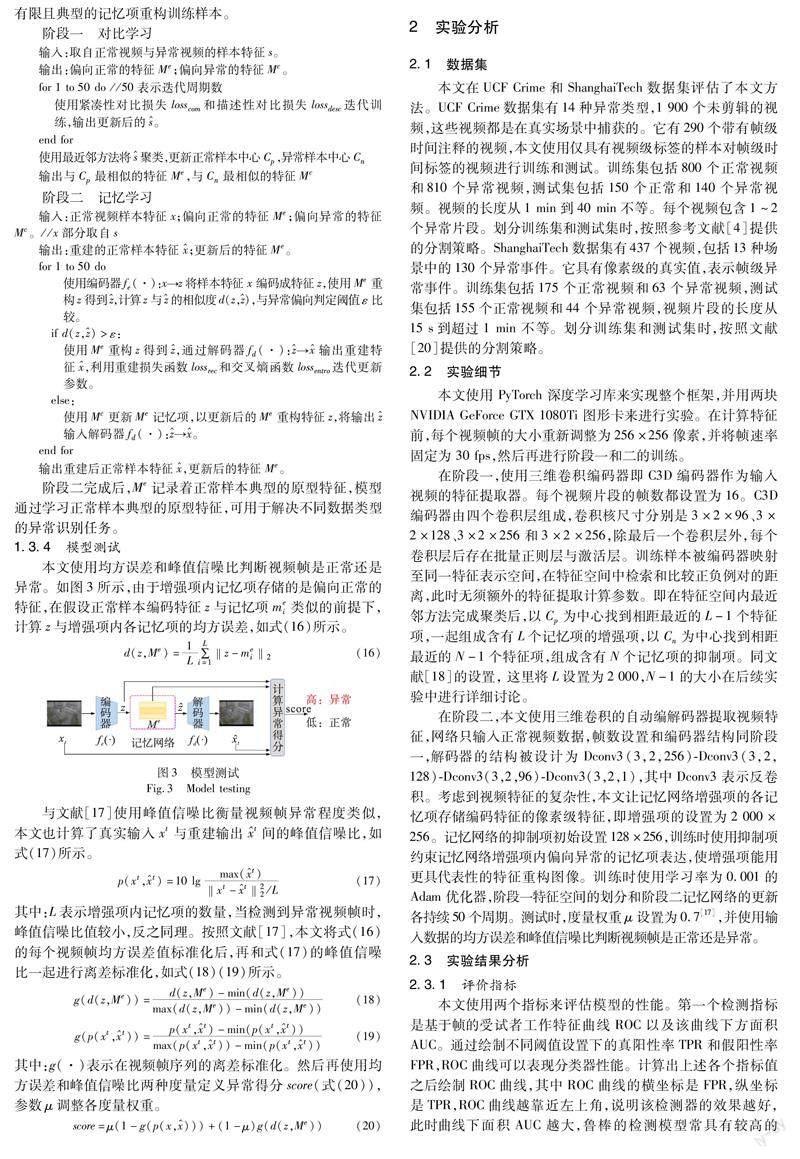

与文献[17,18]不同的是,本文在阶段一用异常样本构造了记忆网络的抑制项,所以更新记忆网络的增强项时,阶段二就间接使用了与测试集相重叠的异常样本,实现使用抑制项约束增强项内记忆项表达的目的。如图2所示,记忆网络抑制项使用Mc表示,与增强项类似,抑制项是N×K 的二维矩阵,N描述了抑制项内记忆项数量,在UCF Crime和ShanghaiTech等常用异常检测数据集中,正常动作视频片段的时长要远远高于异常视频片段时长,所以此处 N 文献[17,18]训练模型时关注降低视频帧的重建误差,即模型以较少且更有代表的特征重建正常样本,但同时也会忽略运动等细粒度信息。为避免这种现象,本文计算输入特征z与输出特征之间的相似度d(z,)(式(11)),并将其与异常偏向判定阈值ε相比较,当d(z,)低于阈值ε时,本文认为输入特征z经记忆网络的增强项重构后丢失信息较多,参考文献[17]记忆项更新策略,本文使用输入特征z更新抑制项,以使更多的细粒度特征参与视频帧重建任务。当d(z,)高于阈值ε时,不再更新抑制项,而直接使用增强项重构输入特征z。为保留更多的记忆项特征,阈值ε初始设置为0.5。 为实现使用抑制项约束增强项内偏向异常的记忆项表达,本文去除增强项内与抑制项记忆项相似度高的部分,此处以更新式(10)的相似度量i实现。如式(12)所示,za由输入特征z用记忆网络的抑制项重构获得(图2)。通过记忆寻址本文得到特征za与增强项内各记忆项mei的相似度d(za,mei),并使用ReLU函数保留度量值高于ε的部分,调整i值,实现约束增强项内偏向异常的记忆项表达。 1.3.3 模型训练 a)重建损失。基于图像重构的方法,其关键在于输入正常图像编解码,并以降低重构误差为目标训练神经网络。在此过程中,较常用的损失函数是均方误差[19],它用图像重构前后所有像素点的像素值之差的平方均值衡量图像重构的质量。本文定义{xt}Tt=1为包含T个正常样本特征的训练集,表示每个样本特征相应的重构特征,如式(13)所示,本文首先最小化真实输入xt与重建输出t间的均方误差。 其中:α是网络训练时的超参数,实验表明当α=0.000 2时,模型性能表现良好。通过目标函数 losssec的约束,视频帧重建时,不仅能利用反向传播和链式法则更新网络参数,也能使用记忆网络的增强项和抑制项更新参数,两者共同作用使模型以有限且典型的记忆项重构训练样本。 阶段一 对比学习 输入:取自正常视频与异常视频的样本特征s。 输出:偏向正常的特征Me;偏向异常的特征Mc。 for 1 to 50 do //50表示迭代周期数 使用紧凑性对比损失losscom和描述性对比损失lossdesc迭代训练,输出更新后的。 end for 使用最近邻方法将聚类,更新正常样本中心Cp,异常样本中心Cn 输出与Cp最相似的特征Me,与Cn最相似的特征Mc 阶段二 记忆学习 输入:正常视频样本特征x;偏向正常的特征Me;偏向异常的特征Mc。//x部分取自s 输出:重建的正常样本特征;更新后的特征Me。 for 1 to 50 do 使用编码器fe(·):x→z将样本特征x编码成特征z,使用Me重构z得到,计算z与的相似度d(z,),与异常偏向判定阈值ε比较。 if d(z,)>ε: 使用Me重构z得到,通过解码器fd(·):→输出重建特征,利用重建损失函数lossrec和交叉熵函数lossentro迭代更新参数。 else: 使用Mc更新Me记忆项,以更新后的Me重构特征z,将输出输入解码器fd(·):→。 end for 输出重建后正常样本特征,更新后的特征Me。 阶段二完成后,Me记录着正常样本典型的原型特征,模型通过学习正常样本典型的原型特征,可用于解决不同数据类型的异常识别任务。 1.3.4 模型测试 本文使用均方误差和峰值信噪比判断视频帧是正常还是异常。如图3所示,由于增强项内记忆项存储的是偏向正常的特征,在假设正常样本编码特征z与记忆项mei类似的前提下,计算z与增强项内各记忆项的均方误差,如式(16)所示。 2 实验分析 2.1 数据集 本文在UCF Crime和ShanghaiTech数据集评估了本文方法。UCF Crime数据集有14种异常类型,1 900个未剪辑的视频,这些视频都是在真实场景中捕获的。它有290个带有帧级时间注释的视频,本文使用仅具有视频级标签的样本对帧级时间标签的视频进行训练和测试。训练集包括800个正常视频和810个异常视频,测试集包括150个正常和140个异常视频。视频的长度从1 min到40 min不等。每个视频包含1~2个异常片段。划分训练集和测试集时,按照参考文献[4]提供的分割策略。ShanghaiTech数据集有437个视频,包括13种场景中的130个异常事件。它具有像素级的真实值,表示帧级异常事件。训练集包括175个正常视频和63个异常视频,测试集包括155个正常视频和44个异常视频,视频片段的长度从15 s到超过1 min不等。划分训练集和测试集时,按照文献[20]提供的分割策略。 2.2 实验细节 本文使用 PyTorch 深度学习库来实现整个框架,并用两块 NVIDIA GeForce GTX 1080Ti 图形卡来进行实验。在计算特征前,每个视频帧的大小重新调整为256×256像素,并将帧速率固定为 30 fps,然后再进行阶段一和二的训练。 在阶段一,使用三维卷积编码器即C3D编码器作为输入视频的特征提取器。每个视频片段的帧数都设置为16。C3D编码器由四个卷积层组成,卷积核尺寸分别是3×2×96、3×2×128、3×2×256和3×2×256,除最后一個卷积层外,每个卷积层后存在批量正则层与激活层。训练样本被编码器映射至同一特征表示空间,在特征空间中检索和比较正负例对的距离,此时无须额外的特征提取计算参数。即在特征空间内最近邻方法完成聚类后,以Cp为中心找到相距最近的L-1个特征项,一起组成含有L个记忆项的增强项,以Cn为中心找到相距最近的N-1个特征项,组成含有N个记忆项的抑制项。同文献[18]的设置, 这里将L设置为2 000,N-1的大小在后续实验中进行详细讨论。 在阶段二,本文使用三维卷积的自动编解码器提取视频特征,网络只输入正常视频数据,帧数设置和编码器结构同阶段一,解码器的结构被设计为Dconv3(3,2,256)-Dconv3(3,2,128)-Dconv3(3,2,96)-Dconv3(3,2,1),其中Dconv3表示反卷积。考虑到视频特征的复杂性,本文让记忆网络增强项的各记忆项存储编码特征的像素级特征,即增强项的设置为2 000×256。记忆网络的抑制项初始设置128×256,训练时使用抑制项约束记忆网络增强项内偏向异常的记忆项表达,使增强项能用更具代表性的特征重构图像。训练时使用学习率为0.001的Adam 优化器,阶段一特征空间的划分和阶段二记忆网络的更新各持续50个周期。测试时,度量权重μ设置为0.7[17],并使用输入数据的均方误差和峰值信噪比判断视频帧是正常还是异常。 2.3 实验结果分析 2.3.1 评价指标 本文使用两个指标来评估模型的性能。第一个检测指标是基于帧的受试者工作特征曲线ROC以及该曲线下方面积AUC。通过绘制不同阈值设置下的真阳性率TPR和假阳性率FPR,ROC曲线可以表现分类器性能。计算出上述各个指标值之后绘制ROC曲线,其中ROC曲线的横坐标是FPR,纵坐标是TPR,ROC曲线越靠近左上角,说明该检测器的效果越好,此时曲线下面积AUC越大,鲁棒的检测模型常具有较高的AUC值。另一个检测指标是虚警率。由于FPR也被称为虚警率,这里使用 50%阈值的 FPR 作为虚警率。由于实时监控视频的主要部分是正常的,所以健壮的模型在正常片段上也应具有较低的虚警率。 2.3.2 消融实验 为获取更加真实的实验效果,本文在ShanghaiTech数据集上进行了如下消融实验,分别包括:a)评估对比记忆网络不同级别的损失函数对实验结果的影响;b)评估抑制项内记忆项数量对于检测结果的影响;c)评估异常判定阈值 ε对于检测结果的影响。 1)评估对比记忆网络中不同级别的损失函数对实验结果的影响 图4展示了网络不同级别的损失函数对实验结果的影响。由于缺少异常行为片段的帧级标签,常见的基于记忆模型的异常行为检测方法[17,18]中只使用和测试集不重叠的正常视频计算重构损失lossrec,让网络只记忆正常行为特征。本文以此为基线,在训练集中引入异常视频,并提出紧凑性对比损失losscom和描述性对比损失lossdesc,从两者的结合角度引入不同的训练样本和损失函数约束网络,性能表现如图4所示。 从图4可以看出,在训练集中引入异常行为视频可以有效提升网络的检测性能,这是因为异常行为视频的引入增加了不同运动特征之间的差异性,此时网络在学习的过程中不仅关注如何降低重构误差,而且关注如何学习区分度高的特征,避免只识别单一行为时导致网络泛化能力过强。同时可以看到描述性对比损失lossdesc和紧凑性对比损失losscom在单独使用时对检测效果的提升类似,这是因为两者只关注视频内部或者视频之间的差异性和联系性,当共同考虑两者时,即考虑不同类别运动的差异性和同类运动的联系性时,效果得到提升。 本节进一步展示了不同的损失对于聚类空间的影响,使用 t-SNE[21]对特征分布进行可视化分析,如图5所示。图5(a)~(d)分别对应图5中的不同方法。 图(a)表示不引入正负例对,在训练的过程中只通过重构损失lossrec调整网络。由于没有计算特征之间的相似度,来自正常视频中的片段与来自异常视频中的片段特征均匀地分布在特征空间中,此时没有获得运动特征的抽象表达。引入正负例后,图(b)表示使用重构损失lossrec和紧凑性对比损失losscom训练模型,图(c)表示使用重构损失lossrec和描述性对比损失lossdesc调整网络。从图(b)和(c)可以看出,动作特征相似的片段会在特征空间中聚集,但单独的紧凑性对比损失losscom或描述性级损失lossdesc无法更加细致地描绘出各个特征之间的异同点,图中出现了多个聚集区域,无法用于构建记忆网络的记忆项。 图(d)表示引入正负例对后使用重构损失lossrec、紧凑性对比损失lossrec以及描述性对比损失lossdesc来调整网络。正常视频之间的紧凑性级损失可以使正常特征相互吸引,异常视频之间的紧凑性损失可以分离出视频中的异常行为片段和正常行为片段,最后通过描述性对比损失拉近不同视频中类似特征的距离,增加不相似特征间的距离。 2)评估抑制项内记忆项数量对于检测结果的影响 如表1所示,展示了抑制项的记忆项数量不同时对检测结果的影响。根据文献[17]的设置,记忆网络增强项的项数设置为2 000,用于存储正常行为特征。记忆网络的抑制项主要存储和正常行为相似度较低的特征,经由式(12)选取相似度最低的N项特征进行更新,N取不同值时,抑制项对增强项的约束程度也会有变化。N从128开始,每隔128进行一次实验,从表1中可以看出,当N=256时,检测效率最高,当N超过256时,导致记忆网络增强项内需要更新的记忆项数超过了10%,使部分正常特征也被更新,造成最终检测效率逐步下降。 3)评估异常判定阈值ε对于检测结果的影响 表2给出了不同的判定阈值对于检测结果的影响,当特征相似度高于阈值ε时,认为这两项特征来自于同一类型的运动,反之认为这两项特征属于不同类型的运动。从表2可以看出,当ε过小或者过大的时候,检测效果提升都不明显。这是因为当ε过大的时候,检测网络对正常行为的要求增加,此时符合要求的数量减少,记忆网络的增强项中存储的特征无法很好地描述正常行为,导致将部分正常行为视为异常行为;当ε过小,檢测网络对正常行为的要求降低,此时符合要求的数量增加,使部分异常行为也被判定为正常行为。从表2中可以看出,当ε=0.7 时检测效果最佳。 2.3.3 对比实验 为说明模型提高了异常检测效果,将本文方法与其他现有的基于自动编码器的主流方法进行比较,如表3所示。这些方法在训练过程中只学习正常视频的正常模式,测试时根据样本与模型的偏离程度判断其异常性,属于无监督学习的范畴。由于在训练过程中没有异常视频参与,该类方法也会将异常样本误判为正常。本文方法从视频和片段两个层面进行特征对比,降低时空噪声对检测结果的影响,并利用记忆网络存储行为特征的抽象表达,避免无关运动的影响。在UCF Crime和ShanghaiTech数据集,平均AUC值达到83.26%和87.53%,证明了本文方法的改进,提升了异常事件的检测。 从表3可以看出,相较于图卷积编码器[20],U-Net编码器[22]、U-LSTM编码器[24]和全卷积编码器[25,26],采用C3D网络[4,23]作为编码器效果更好,说明C3D能够获得更加稳健的深度特征。文献[17,18]在自动编码器的基础上添加记忆网络,该网络存储的典型样本特征提升了正常样本重建的稳定度,性能表现优于普通的全卷积编码器,但弱于C3D网络作为编码器的方法,这可能因为C3D网络能更有效地捕捉时空特征,所以本文在对比学习阶段也选择C3D网络编码器,以提高模型特征提取效果。本文方法性能较文献[17,18]有所提升,这是因为模型使用记忆网络的抑制项约束了增强项内偏向异常的记忆项表达,使模型不仅能够根据正常样本与异常样本间特征差异进行聚类,还能在使用编码器编码、解码器解码的过程中清除原始视频中的无关特征。 在UCF Crime和ShanghaiTech数据集上的实验结果表明,本文方法能够提高异常检测的效果。特别地,UCF Crime数据集包含13个不同的场景,这增加了在该数据集上异常检测的难度。ShanghaiTech数据集中的场景均为校园道路环境,此时正常事件和异常事件有相同的定义,同时在高层次特征上也有类似的表现。实验表明,本文模型可以增加对异常事件的识别能力。 本文使用两张NVIDIA GeForceGTX 1080Ti 图形卡在ShanghaiTech数据集研究了所提方法的计算复杂度。测试时,对比记忆网络检测出视频帧是否异常总耗时35.4 ms(28 fps),优于文献U-Net编码器[22]的40 ms,VGG-f[28]编码器的50 ms。与每帧需要耗时35.4 ms相比,更新记忆网络项几乎不消耗额外的计算时间,每帧仅耗时0.5 ms。 本节将模型在 UCF Crime 和 ShanghaiTech 数据集上进一步可视化,并与文献[24,26]对比检测效果。如图6、7所示,其中灰色填充部分表示异常行为发生的真实时间段。图6展示了在ShanghaiTech数据集的01_0014.mp4视频上的检测结果,图7展示了在UCF Crime数据集的Burglary021_x264.mp4视频上的检测结果。从图6、7中可以看出,本文方法能有效检测出异常行为的发生。 3 结束语 本文基于对比记忆网络进行异常行为检测,其目标是在无帧级标签时划分特征空间内正常行为和异常行为,根据两种行为的差异进行异常行为检测。本文使用编码器生成潜在特征空间,在该空间上对正常特征和异常特征进行聚类,然后选取聚类后的特征分别作为记忆网络的增强项和抑制项,其中记忆网络的抑制项约束了增强项内偏向异常的特征表达,缓解了正常与异常的相似特征参与图像重构的难题。在UCF Crime和ShanghaiTech数据集上的实验研究表明,本文方法能够预测异常事件的发生时间,并且优于现有方法。但缺点是记忆网络只存储正常行为与异常行为的典型特征,限制了部分低层次特征的表达。C3D编码特征内存在丰富的时序信息,接下来研究重点是找到高效的时序建模方法,提高模型对异常事件的识别能力。 参考文献: [1]Cook A A,Msrl G,Fan Zhong.Anomaly detection for IoT time-series data:a survey[J].IEEE Internet of Things Journal,2019,7(7):6481-6494. [2]吕承侃,沈飞,张正涛,等.图像异常检测研究现状综述[J].自动化学报,2022,48(6):1402-1428.(Lyu Chengkan,Shen Fei,Zhang Zhengtao,et al.Review of image anomaly detection[J].Acta Automatica Sinica,2022,48(6):1402-1428.) [3]Paszke A,Gross S,Massa F,et al.PyTorch:an imperative style,high-performance deep learning library[C]//Proc of the 33rd Conference on Neural Information Processing Systems.Red Hook,NY:Curran Associates Inc.,2019:8024-8035. [4]Sultani W,Chen Chen,Shah M.Real-world anomaly detection in surveillance videos[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2018:6479-6488. [5]Tian Yu,Pang Guansong,Chen Yuanhong,et al.Weakly-supervised video anomaly detection with robust temporal feature magnitude lear-ning[C]//Proc of IEEE/CVF International Conference on Computer Vision.Piscataway,NJ:IEEE Press,2021:4955-4966. [6]Wu Peng,Liu Jing,Shi Yujia,et al.Not only look,but also listen:learning multimodal violence detection under weak supervision[M]//Vedaldi A,Bischof H,Brox T,et al.Computer Vision.Cham:Springer,2020:322-339. [7]Zhong J X,Li Nannan,Kong Weijie,et al.Graph convolutional label noise cleaner:train a plug-and-play action classifier for anomaly detection[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2019:1237-1246. [8]肖进胜,申梦瑶,江明俊,等.融合包注意力机制的监控视频异常行为检测[J].自动化学报,2022,48(12):2951-2959.(Xiao Jinsheng,Shen Mengyao,Jiang Mingjun,et al.Abnormal behavior detection algorithm with video-bag attention mechanism in surveillance vi-deo[J].Acta Automatica Sinica,2022,48(12):2951-2959.) [9]Cai T T,Frankle J,Schwab D J,et al.Are all negatives created equal in contrastive instance discrimination?[EB/OL].(2020-10-25).https://arxiv.org/abs/2010.06682. [10]Gudovskiy D,Ishizaka S,Kozuka K.CFLOW-AD:real-time unsupervised anomaly detection with localization via conditional normalizing flows[C]//Proc of IEEE/CVF Winter Conference on Applications of Computer Vision.Piscataway,NJ:IEEE Press,2022:1819-1828. [11]Sepehr M,Sasan M,Jennings N R.Unsupervised anomaly detection with LSTM autoencoders using statistical data-filtering[J].Applied Soft Computing,2021,108:article ID 107443. [12]周佳航,邢紅杰.基于双自编码器和Transformer网络的异常检测方法[J].计算机应用,2023,43(1):22-29.(Zhou Jiahang,Xing Hongjie.Novelty detection method based on dual autoencoders and Transformer network[J].Journal of Computer Applications,2023,43(1):22-29.) [13]陈澄,胡燕.融合记忆增强的视频异常检测[J].计算机工程与应用,2022,58(15):253-259.(Chen Cheng,Hu Yan.Video anomaly detection combining memory-augmented[J].Computer Engineering and Applications,2022,58(15):253-259.) [14]Chen Ting,Kornblith S,Norouzi M,et al.A simple framework for con-trastive learning of visual representations[C]//Proc of the 37th International Conference on Machine Learning.[S.l.]:JMLR.org,2020:1597-1607. [15]Winkens J,Bunel R,Roy A G,et al.Contrastive training for improved out-of-distribution detection[EB/OL].(2020-07-10).https://arxiv.org/abs/2007.05566. [16]Bommes L,Hoffmann M,Buerhop-Lutz C,et al.Anomaly detection in IR images of PV modules using supervised contrastive learning[J].Progress in Photovoltaics:Research and Applications,2022,30(6):597-614. [17]Park H,Noh J,Ham B.Learning memory-guided normality for anomaly detection[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2020:14360-14369. [18]Gong Dong,Liu Lingqiao,Le V,et al.Memorizing normality to detect anomaly:memory-augmented deep autoencoder for unsupervised ano-maly detection[C]//Proc of IEEE/CVF International Conference on Computer Vision.Piscataway,NJ:IEEE Press,2019:1705-1714. [19]Bergmann P,Lwe S,Fauser M,et al.Improving unsupervised defect segmentation by applying structural similarity to autoencoders[C]//Proc of the 14th International Joint Conference on Computer Vision,Imaging and Computer Graphics Theory and Applications.Pisca-taway,NJ:IEEE Press,NJ,2019:372-380. [20]Zhong J X,Li Nannan,Kong Weijie,et al.Graph convolutional label noise cleaner:train a plug-and-play action classifier for anomaly detection[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2019:1237-1246. [21]Van Der Maaten L.Accelerating t-SNE using tree-based algorithms[J].The Journal of Machine Learning Research,2014,15(1):3221-3245. [22]Liu Wen,Luo Weixin,Lian Dongze,et al.Future frame prediction for anomaly detection:a new baseline[C]//Proc of IEEE/CVF Confe-rence on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2018:6536-6545. [23]Zhao Yiru,Deng Bing,Shen Chen,et al.Spatio-temporal autoencoder for video anomaly detection[C]//Proc of the 25th ACM International Conference on Multimedia.New York:ACM Press,2017:1933-1941. [24]Li Yuanyuan,Cai Yiheng,Liu Jiaqi,et al.Spatio-temporal unity networking for video anomaly detection[J].IEEE Access,2019,7:172425-172432. [25]Dubey S,Boragule A,Gwak J,et al.Anomalous event recognition in videos based on joint learning of motion and appearance with multiple ranking measures[J].Applied Sciences,2021,11(3):1344. [26]Zaheer M Z,Mahmood A,Astrid M,et al.CLAWS:clustering assisted weakly supervised learning with normalcy suppression for anomalous event detection[C]//Proc of the 16th European Conference on Computer Vision.Berlin:Springer-Verlag,2020:358-376. [27]Hasan M,Choi J,Neumann J,et al.Learning temporal regularity in video sequences[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2016:733-742. [28]Ionescu R T,Smeureanu S,Alexe B,et al.Unmasking the abnormal events in video[C]//Proc of IEEE International Conference on Computer Vision.Piscataway,NJ:IEEE Press,2017:2914-2922. 收稿日期:2022-12-28;修回日期:2023-02-25基金項目:安徽省重点研究与开发计划资助项目(202004d07020004);安徽省自然科学基金资助项目(2108085MF203);中央高校基本科研业务费专项资金资助项目(PA2021GDSK0072,JZ2021HGQA0219) 作者简介:李文中(1995-),男,河南信阳人,硕士研究生,主要研究方向为异常检测、视频图像分析;吴克伟(1984-),男(通信作者),安徽合肥人,副教授,硕导,博士,主要研究方向为计算机视觉、人工智能、模式识别(wu_kewei1984@163.com);孙永宣(1978-),男,安徽合肥人,讲师,博士,主要研究方向为智能信息处理;焦畅(1998-),男,安徽黄山人,硕士研究生,主要研究方向为计算机视觉、群组行为识别;熊思璇(1997-),女,湖北襄阳人,硕士研究生,主要研究方向为计算机视觉.