轻量化无人机遥感图像小目标检测算法

2023-10-12王恒涛

张 上,张 岳,王恒涛*,王 杰

(1.三峡大学 湖北省建筑质量检测装备工程技术研究中心,湖北 宜昌 443002;2.三峡大学 计算机与信息学院,湖北 宜昌 443002)

0 引言

伴随相关科技的发展,无人机遥感在各个领域的应用越来越广泛。例如,无人机遥感可应用于湿地水动力研究[1]、建筑物震害识别[2]和黄土滑坡识别[3]等实际场景;在地震应急救援、核泄漏和应急测绘等场景中也有着突出表现[4]。无人机遥感图像在遥感图像的分辨率和精度上,相比传统卫星遥感等手段具有显著提高,但仍未解决遥感图像需要人工辅助处理而导致的工作强度大、效率低等问题。

随着人工智能技术,特别是深度学习技术的逐步发展,基于深度学习的目标检测算法在多个领域与遥感图像进行了有效结合,用于解决工业、农业与生态等领域的多种实际问题[5]。时启龙等[6]基于U-Net神经网络与SegNet神经网络,对无人机遥感松材线虫病疫木进行了自动识别提取。Youme等[7]基于SSD目标检测算法,对西非塞内加尔的圣路易斯地区无人机遥感图像中的隐蔽垃圾堆进行了目标检测。王恒涛等[8]针对无人机航拍的特点,提出了一种轻量化无人机航拍目标检测算法。

当前基于深度学习的目标检测算法,可根据有锚框与无锚框来进行区分。而其中有锚框的算法又可分为双阶段法与单阶段法。前者的检测精度与效果更好,但由于将备选框的生成与判断分开,所以存在计算量大而导致检测速度慢的问题。如R-FCN[9]、Mask R-CNN[10]、SPP-Net[11]等。后者相对于双阶段法而言检测速度更快、效率更高且移植至边缘设备上更加简便,所以应用更加广泛。如OverFeat[12]、SSD[13]、YOLOv3[14]、YOLOv4[15]与YOLOv5等。

针对无人机遥感图像背景复杂、检测目标小且密度大的特点,本文提出一种基于YOLOv5的轻量化无人机遥感小目标检测算法——LUSS-YOLO,主要贡献归纳如下:

① 针对无人机遥感影像成像高度高、检测目标密集且尺寸小的特征,重设计网络结构。通过调整特征提取网络结构和特征融合网络结构来增加小感受野,增加浅层网络特征权重。重构特征融合网络,强调多尺度特征融合,实现小目标感受野权重加权处理。

② 引入EIoU损失函数,使回归过程中高质量样本的重要程度提高,从而加速收敛,并提高回归精度。

③ 引入VairFocal Loss使IACS回归,均衡正负样本的同时按权重增加样本的影响因子,并且在加速模型训练收敛速度的同时提高精度。

④ 为验证算法的有效性,在Visdrone2019数据集上对LUSS-YOLO算法进行验证,平均准确率(mean Average Precision,mAP)达到了41.3%,相较YOLOv5有6.4%的提升。

1 LUSS-YOLO介绍

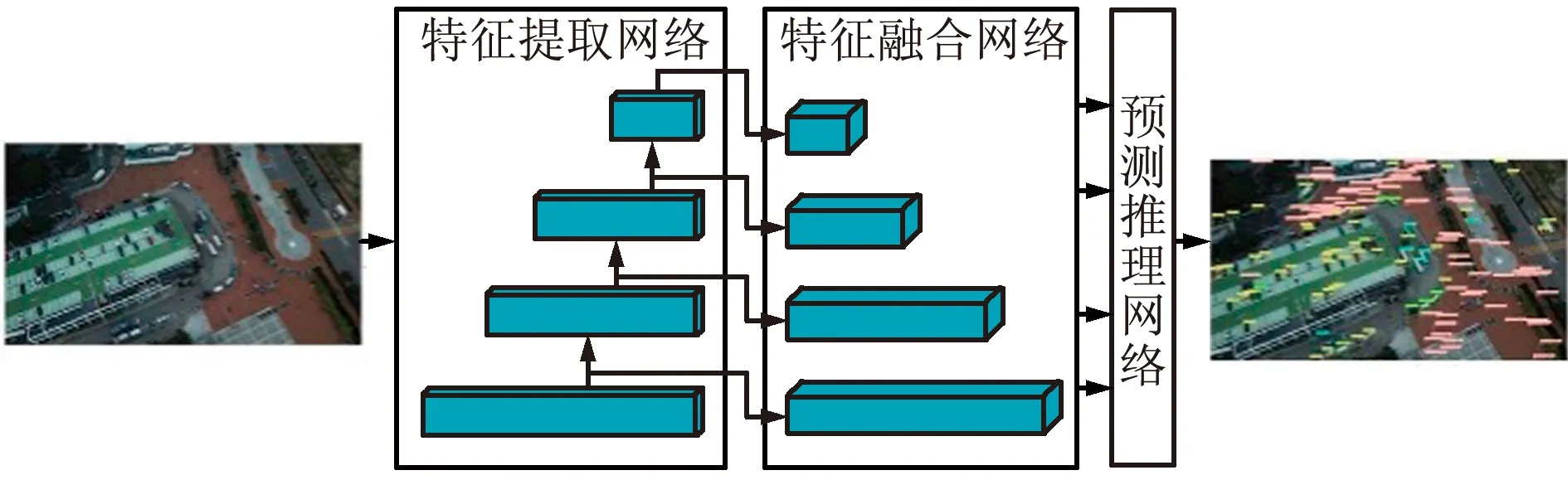

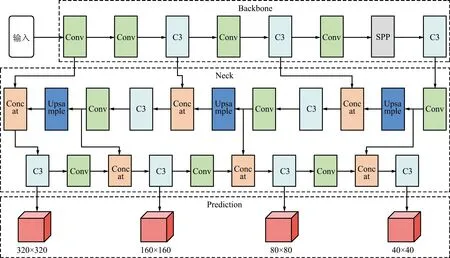

主流YOLO算法改进以添加注意力机制、改变卷积层、叠加与修改网络模块为主,而忽略了基于检测目标本身特点来建立合适的网络结构。针对无人机遥感图像的小目标特性,本文设计LUSS-YOLO算法,其系统架构如图1所示。

图1 LUSS-YOLO系统架构Fig.1 LUSS-YOLO system architecture

LUSS-YOLO的核心思想是针对无人机遥感图像的小目标特性,对网络结构进行重构并对网络模型进行轻量化处理,分别对网络模型的长度与宽度,降低冗余模块与参数,使网络结构更适用于无人机遥感图像小目标检测。LUSS-YOLO由重设计网络结构、EIoU损失函数与VariFocal Loss组成。首先,对小目标感受野权重进行调整,修剪特征提取网络;对特征融合网络架构进行调整并剔除冗余模块。然后,使用EIoU损失函数替换原CIoU损失函数,强调回归过程中的高质量样本,以加速收敛并提高回归精度。最后,使用VariFocal Loss,保证均衡正负例的同时更加突出正例贡献,使IACS回归,在加速模型训练收敛速度的同时提高模型精度。如图1所示,通过轻量化处理特征提取网络与特征融合网络,提高模型检测无人机遥感图像小目标的能力。

LUSS-YOLO网络结构削减了冗余模块与参数,在计算量、模型体积和检测速度上均有巨大改善。

2 LUSS-YOLO设计

2.1 网络重构

原YOLOv5算法使用的特征图分别为20 pixel×20 pixel、40 pixel×40 pixel与80 pixel×80 pixel,为实现无人机遥感小目标检测的准确性,LUSS-YOLO对其进行扩充和修改,实现了160 pixel×160 pixel与320 pixel×320 pixel特征图的提取,并删除20 pixel×20 pixel大感受野的尺度,使其更适用于检测无人机遥感图像小目标。

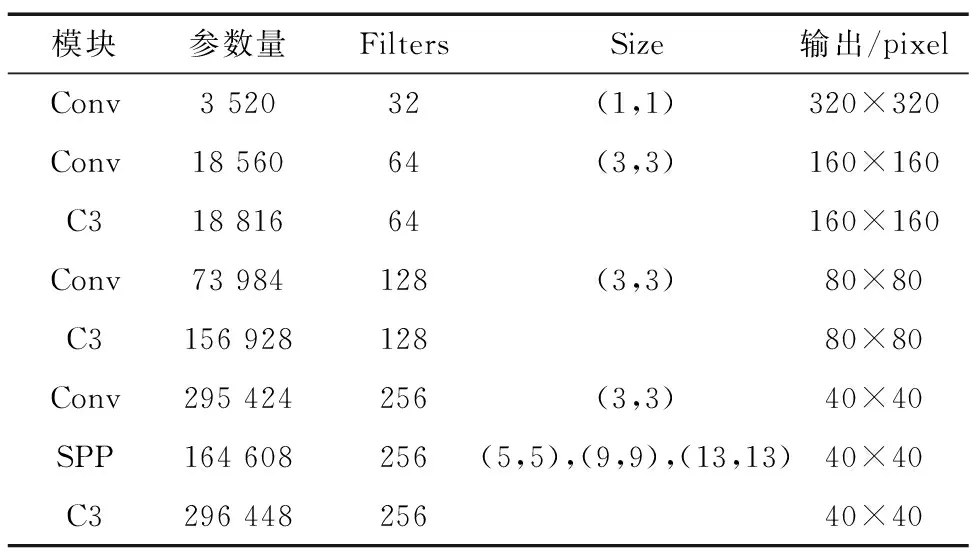

在无人机遥感图像中,检测目标占图像中的部分较小,背景面积较大。在卷积过程中,图像迭代会导致检测目标信息出现丢失,针对该情况,LUSS-YOLO通过降低卷积迭代次数与突出底层特征图来增强检测效果。重构后的CSPDarkNet如表1所示,改进后的特征提取网络经历4次下采样、3次卷积操作,从而保证降低计算量与参数量的同时,有效减少小目标特征信息丢失。

表1 重构CSPDarkNet结构Tab.1 Reconstructed CSPDarkNet structure

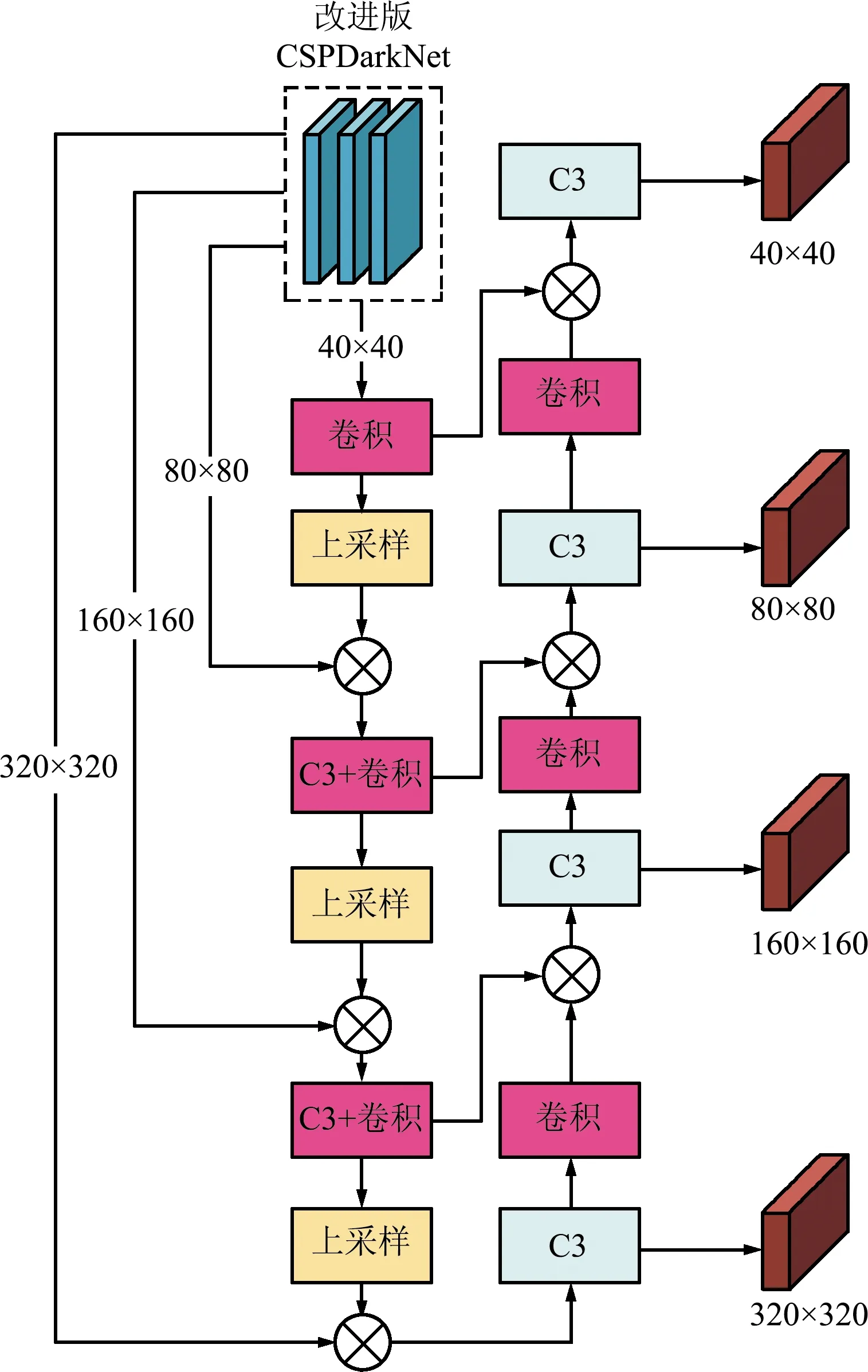

LUSS-YOLO特征图大小为40 pixel×40 pixel与80 pixel×80 pixel,因此原特征融合网络不再适用于新的特征提取网络,需要改进。

改进后的特征融合网络如图2所示。对感受野融合位置进行了调整,首先进行浅层语义与深层语义的特征融合,依次进行320 pixel×320 pixel、160 pixel×160 pixel、80 pixel×80 pixel与40 pixel×40 pixel特征图融合;再进行深层语义与浅层语义的特征融合,即40 pixel×40 pixel、80 pixel×80 pixel与160 pixel×160 pixel特征图融合。由此,可在原网络基础上提升浅层语义特征权重,旨在减少卷积带来的目标特征信息丢失。

图2 特征融合网络结构Fig.2 Structure of feature fusion network

LUSS-YOLO算法结构如图3所示。LUSS-YOLO分别对特征提取网络与特征融合网络进行重设计。首先对特征提取网络CSPDarkNet进行重设计,去除20 pixel×20 pixel特征图提取模块,提高网络内的小感受野权重,降低了模型的计算量与体积;然后对改进后的CSPDarkNet进行特征融合,分别实现从320 pixel×320 pixel浅层语义,沿160 pixel×160 pixel、80 pixel×80 pixel到40 pixel×40 pixel深层语义的特征信息融合;再从40 pixel×40 pixel深层语义,沿80 pixel×80 pixel、160 pixel×160 pixel到320 pixel×320 pixel浅层语义的特征信息融合。

图3 LUSS-YOLO网络结构Fig.3 LUSS-YOLO network structure

2.2 损失函数改进

YOLOv5使用的CIoU损失函数会同时考虑回归框的宽高比例,以及真实框与预测框的中心距离,但其仅将宽高比作为影响因子会导致部分情况下计算结果与损失的目标不相符。CIoU计算如下:

(1)

式中:IoU为预测框与真实框的交并比,取值[0,1],b与bgt分别为预测框和真实框的中心点,ρ(·)为求预测框和真实框中心点之间的欧氏距离,c为预测框和真实框最小外接矩形的对角线距离,α为平衡参数,不参与梯度计算,v用来衡量预测框和真实框的宽和高之间的比例一致性。

针对此情况,采用EIoU[16]损失函数进行改进,直接对宽w和高h的预测结果进行惩罚,包括宽高损失、重叠损失和中心距离损失3种情况。其中新加入的宽高损失主要解决CIoU宽高不能同时增大或缩小的情况,直接使真实框与预测框之间的宽高差达到最小。因此,EIoU损失函数收敛更快、回归精度更高。EIoU计算如下:

(2)

式中:cw、ch分别为覆盖2个box的最小外接框宽度与高度,b与bgt分别为预测框和真实框的中心点,ρ为求预测框和真实框中心点之间的欧氏距离,w、h与wgt、hgt分别为预测框与真实框的宽、高。

2.3 VariFocal Loss

在无人机遥感图像中,小目标所占区域较少。对无人机遥感图像进行小目标检测时,会出现目标类与背景类极端不均衡问题。使用Focal Loss能够有效解决目标类与背景类之间不均衡的问题。Focal Loss计算如下:

(3)

式中:p为[-1,1]的目标类预测概率,y为取值1或-1的真实正负样本类别,α为可调比例因子,(1-ρ)β为目标类调制因子,pβ为背景类调制因子,此2类调制因子旨在减少简单样本贡献,增加误检样本的重要性,从而有效增加对困难样本的关注度,使Focal Loss能够通过加权方式解决IACS回归训练时会出现的类别不均衡问题。

对于Focal Loss[17]采用平等方式处理正负样本的方式,VariFocal Loss进行了改进,提高了正例的贡献权重。VariFocal Loss基于binary cross entropy loss,借鉴了Focal Loss的加权方式并加以改进,以处理IACS训练回归过程中类别不匹配的问题。VariFocal Loss计算如下:

(4)

式中:p为代表目标分数的IACS预测值,q为分类条件。其条件为:若为目标类,则将正样本类的q值设置为预测框和真实框之间的IoU值,否则设置为0;若为背景类,则将目标q值均为0。如式(8)所示,VariFocal Loss通过pβ缩放因子对负样本进行了处理,但不会影响正样本,旨在突出正样本的贡献。

2.4 锚框参数优化

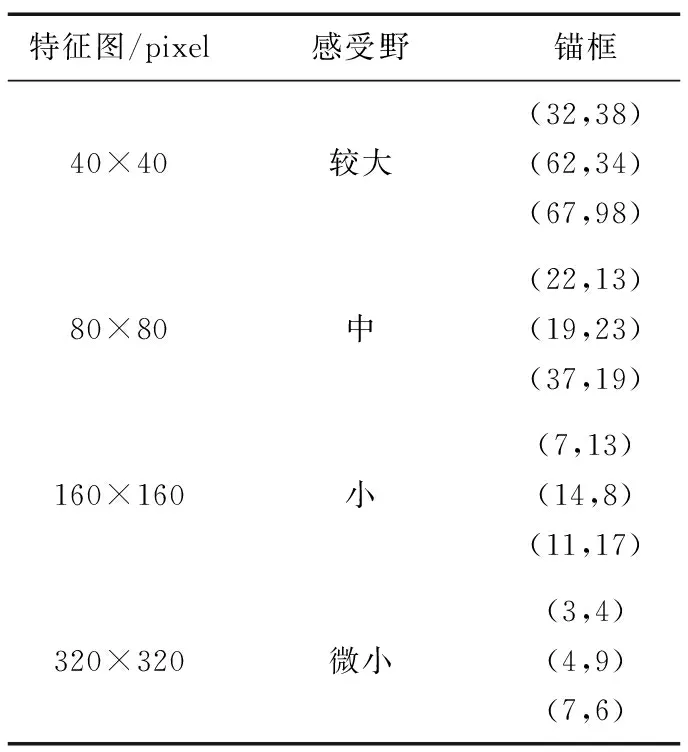

本文对网络结构进行了重设计,同时对锚框大小进行了重构。在使用k-means聚类与遗传算法对预测框大小进行分析与聚类后,得到了最适合的锚框大小,旨在提高回归速度与训练精度。

最终锚框分配如表2所示,通过删除20 pixel×20 pixel特征图的方式实现感受野调整,旨在使其更适用于无人机遥感图像检测场景。

表2 锚框分配Tab.2 Anchor box allocation

3 实验及结果分析

本文实验配置为:操作系统Windows 11,CUDA12.0;GPU为NVIDIA GTX1660ti Max-Q,6 GB显存,调用GPU进行训练;框架基于Pytorch;YOLOv5工程版本为v6.0,基准模型为YOLOv5s。

3.1 VisDrone2019数据集

本文采用VisDrone2019进行算法验证。VisDrone数据集由AISKYEYE团队发布,数据集来自14座不同城市的不同环境,包括城市与乡村的多种天气和光照条件,检测目标多样,稀疏环境与密集环境都具备,是目前中国无人机遥感图像中数据量最大、类型最全面、环境最复杂、覆盖范围最广的数据集之一。

VisDrone2019数据集共包括10类航拍检测目标,由7 019张训练集、548张预测集与1 610张测试集组成。10个类别分别为pedestrian、people、bicycle、car、van、truck、tricycle、awning-tricycle、bus与motor。

3.2 评测指标

计算机视觉对于算法有数个用以评价的指标,包括mAP、召回率(Recall,R)和准确率(Precision,P)。其中,召回率为正确检测的正例比例;准确率是预测与实际都为正的样本所占比例。召回率、准确率与平均准确率的计算如下:

(5)

(6)

(7)

(8)

式中:TP(True Positive)为检测结果为真的正例,FN(False Negative)为检测结果为非真的正例,FP(False Positive)为检测结果为真的负例,AP为单个类别准确率,mAP为所有类别的准确率均值,c为类别数。

3.3 实验结果与分析

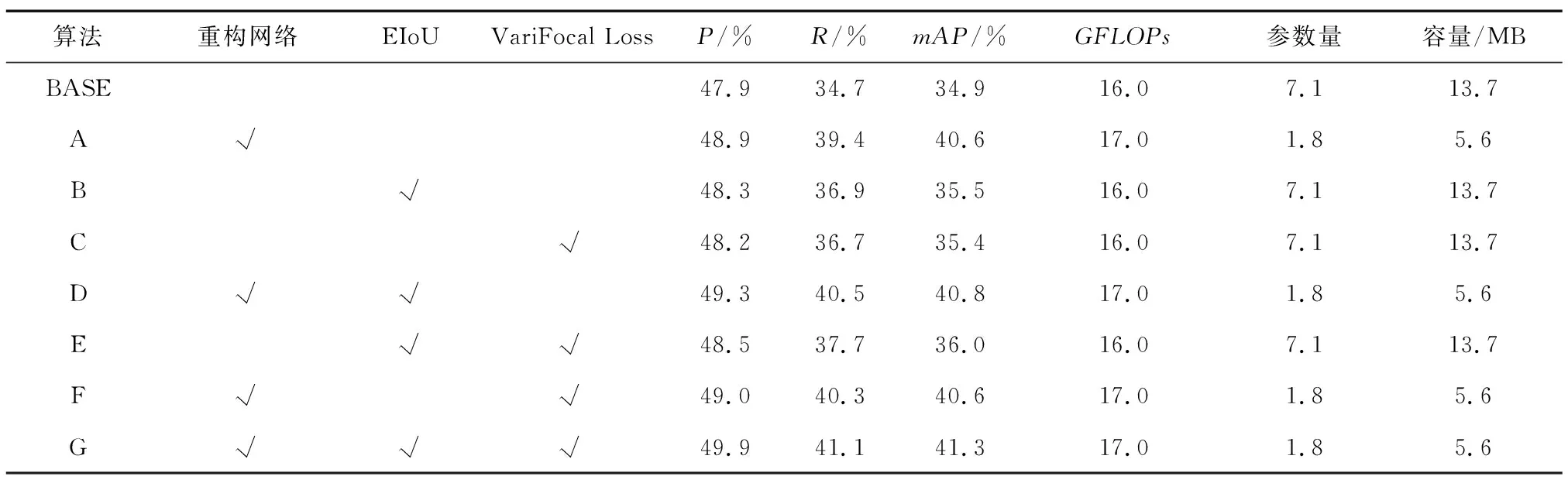

对于LUSS-YOLO各改动点在无人机遥感图像上对小目标检测的有效性,在VisDrone2019数据集上进行了消融实验。消融实验结果如表3所示。

表3 消融实验Tab.3 Ablation experiment

其中BASE算法为YOLOv5s模型。由消融实验结果可知,网络结构重构后,准确率、回归率和平均检测精度均有明显提高;其中平均检测精度提高最大,提高至40.6%;计算量有略微增长,增长幅度为1.0 GFLOPs;模型容量与参数量同样大幅下降,相较未重构模型下降59.1%与74.6%;可证明对网络结构的轻量化改进具有显著效果。在引入EIoU损失函数后,准确率与回归率均明显提高,分别提高0.4%与2.2%;引入VariFocal Loss后,准确率与回归率均明显提高,分别提高0.3%与2.0%;同时引入EIoU损失函数与VariFocal Loss后,准确率与回归率均大幅提高,分别提高0.6%与3.0%;证明在无人机遥感图像的小目标检测场景中,同时强调高质量样本权重与强调正面样本权重具有互不冲突的正面改进效果。

综上,在重构网络、EIoU和VariFocal的作用下,模型平均精度、回归率和准确率均达到最高,每个模块均对无人机遥感小目标检测起到积极作用;重构网络的轻量化改进效果显著,模型容量与参数量均有大幅下降。

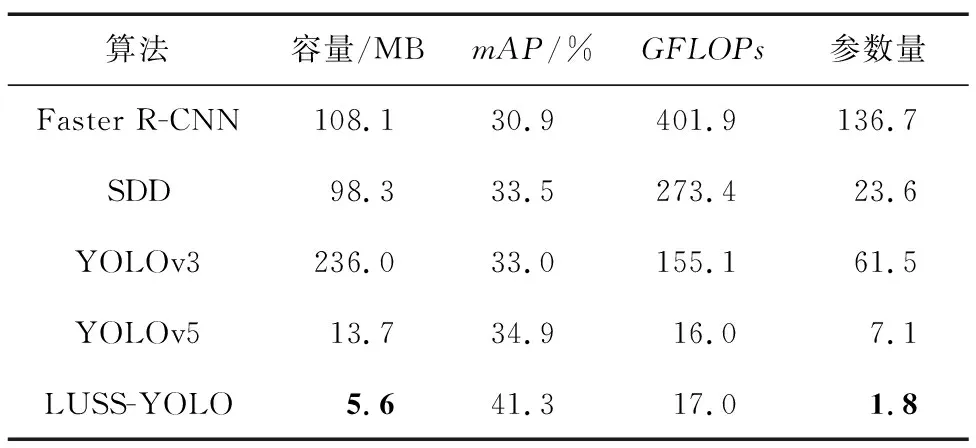

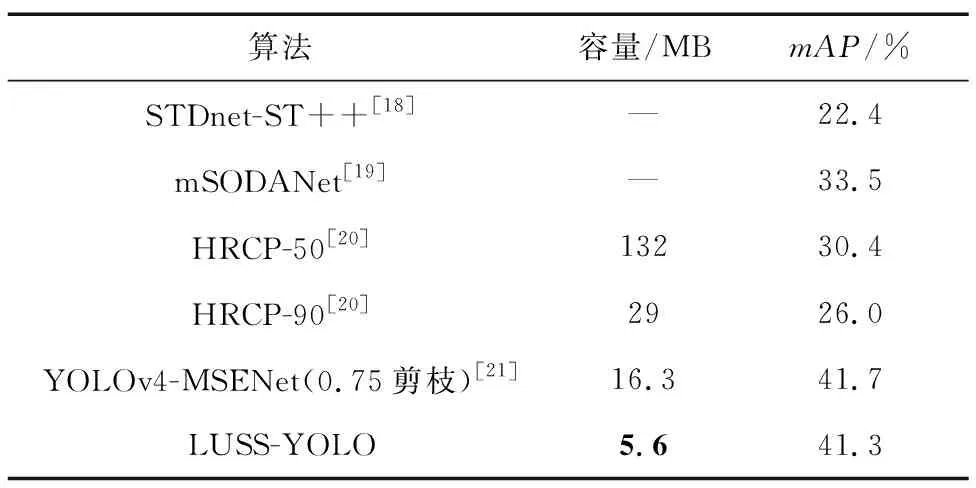

3.4 与先进算法对比实验

为了验证LUSS-YOLO算法的先进性,本文将其与主流经典算法与部分先进算法进行对比实验。与经典算法的对比结果如表4所示,LUSS-YOLO对比其他主流经典算法,在平均检测精度上表现最好,可达到41.3%,相较于Faster R-CNN、SDD、YOLOv3与YOLOv5分别提升了10.4%、7.8%、8.0%与6.4%;模型容量仅为5.6 MB,相比Faster R-CNN、SDD、YOLOv3与YOLOv5分别下降94.8%、94.3%、97.6%与59.1%;计算量相较Faster R-CNN、SDD与YOLOv3分别下降95.8%、93.8%与89.0%,仅略高于YOLOv5;参数量与Faster R-CNN、SDD、YOLOv3、YOLOv5相比下降98.7%、92.4%、97.1%、74.6%。

表4 经典算法对比Tab.4 Comparison of classical algorithms

与部分先进算法的对比结果如表5所示,LUSS-YOLO对比其他先进算法,在容量与平均检测精度上都具有明显优势。平均检测精度仅对比0.75通道剪枝的YOLOv4-MSENet下降0.4%,模型容量则下降65.6%。对比输入大小为604的HRCP在0.5通道剪枝与0.9通道剪枝情况下,平均检测精度分别上升10.9%与15.3%,容量分别下降95.8%与80.7%。对比mSODANet与STDnet-ST++,平均检测精度分别上升7.8%与18.9%。

表5 部分先进算法对比Tab.5 Comparison of selected advanced algorithms

由上述数据可知,LUSS-YOLO在模型体积上改进幅度显著,在平均检测精度上提升明显,且在计算量与参数量上大大减少,可满足多种无人机遥感图像在检测小目标时的轻量化需求。

3.5 实验效果与分析

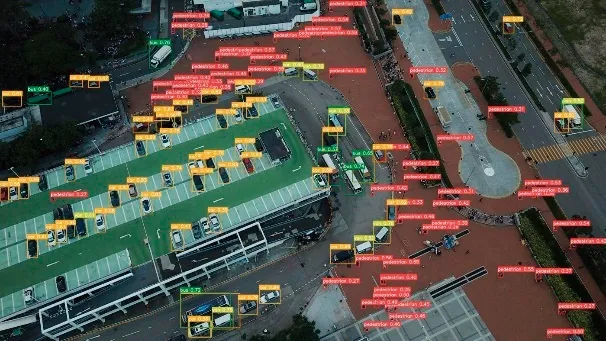

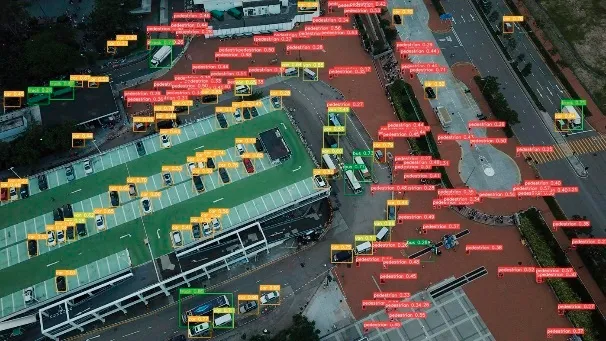

本文选取了部分难度较大的数据集内图片进行检测,并与基准模型YOLOv5s算法进行对比,对比结果如图4所示。

(a)基准模型密集场所检测效果

(b)改进模型密集场所检测效果

(c)基准模型多人群场所检测效果

(d)改进模型多人群场所检测效果

(e)基准模型夜间场所检测效果

(f)改进模型夜间场所检测效果

(g)基准模型较大目标检测效果

(h)改进模型较大目标检测效果图4 效果对比Fig.4 Effect comparison

左侧为YOLOv5s算法检测效果,右侧为LUSS-YOLO检测效果。由对比可知,本文提出的算法相较原始算法,在检测目标密集,且检测目标特征与背景相近时可以做到检测更加准确,对于模糊的遥感图像也可以检测出更多的小目标与远距目标。由于算法在判断目标时会更加谨慎,所以以提升部分漏检率为代价,降低了部分误检率。在夜间低光照环境下,LUSS-YOLO的检测准确率进一步提升,误检率与漏检率均有明显降低。对于较大目标检测,LUSS-YOLO也并未出现检测混淆的情况。通过调整小感受野、重设计特征融合网络以及对特征提取网络进行符合图像特点的轻量化处理,LUSS-YOLO可以有效从拥有大量多尺度特征信息的区域内分离出小目标特征区域,因此在不同环境下都能表现出较强的特征提取能力,并具有显著的抗干扰能力。

综上所述,LUSS-YOLO相比YOLOv5s,在其他目标检测效果对比平稳的前提下,对于无人机遥感图像中的小目标检测优势明显,尤其在背景复杂或目标密集情况下,具有更强的特征提取能力与检测能力。同时,在漏检率和错检率上有显著降低。

4 结束语

针对无人机遥感图像成像距离远、目标成像小等特点,提出了轻量化无人机遥感图像小目标检测算法——LUSS-YOLO。LUSS-YOLO分别从多尺度特征融合和感受野两方面对特征提取网络和特征融合网络进行重设计,轻量化处理网络结构、突出底层特征图权重、深化多尺度融合并增加小感受野,从而实现底层语义与深层语义融合,实现模型轻量化并提高精度,满足无人机遥感图像检测算法模型轻量化需求。同时,使用EIoU强调高质量样本权重,并引入VariFocal Loss,在损失计算中强调底层正例样本信息特征的重要性,从而实现加快模型收敛速度并提高精度。在VisDrone2019数据集上的实验结果表明,LUSS-YOLO算法在检测精度上有显著提高,大幅减少了参数量,模型容量为基准模型的一半。对比其他经典目标检测算法,LUSS-YOLO在模型容量、模型计算量、算法复杂度以及参数量上均大幅降低,且算法检测精度有所提高。对比其他先进目标检测算法,LUSS-YOLO在容量和模型精度上优势明显。本文提出的LUSS-YOLO算法在模型精度、模型容量与参数量上具有先进性。