多尺度选择注意力的双模态目标追踪算法

2023-10-12晏开祥周冬明王长城周子为

晏开祥,周冬明,王长城,周子为

(云南大学 信息学院,云南 昆明 650500)

0 引言

视觉目标追踪(Visual Object Tracking,VOT)作为计算视觉领域的一项基础任务,具有广阔的科研和工业价值[1]。近年来,以相关滤波和Siamese Net为基础的多项目标跟踪算法在跟踪速度和精度上均取得了令人瞩目的成绩[2]。但可见光传感器在恶劣环境(如雨雪、浓雾、夜晚等情况)下有限的图像捕捉能力限制了跟踪算法性能的进一步提升。因此,克服上述问题是该领域的一个重要研究方向[3-4]。红外光传感器因其独特的成像原理,可有效识别出目标(热源)与背景的信号差异,能够在雨雪、浓雾和夜晚等情况下,保持跟踪目标的图像获取能力。因此,融合了红外光与可见光(RGB and Thermal,RGBT)互补特性的目标跟踪算法已成为视觉目标跟踪领域的一个热门研究方向。近期,多项基于RGBT的目标跟踪研究结果[5-7]表明,引入红外光图像作为补充手段,可有效提高目标跟踪性能。例如,MANet[6]通过共享RGBT图像的特征编码权重,实现了远高于传统可见光跟踪算法的任务性能。DAPNet[7]通过全局平均池化和加权随机选择,去除噪声和冗余特征,从而提高了该模型的跟踪性能。TFNet[8]通过评估来自双模态的特征信息,增强其中特定模态的部分特征信息,强化特征图对目标所在区域的特征表现。这些RGBT跟踪算法虽然实现了很好的跟踪效果,但在真实场景中存在的干扰情况[9-10](例如画面模糊、目标快速移动、目标特征变化和镜头抖动等)使得上述算法难以保持稳定的跟踪状态。这些干扰往往不具备统一的尺度和类似的形态,所以传统的卷积网络无法利用其固定大小的卷积核识别目标与背景的差别[11]。为降低此类多尺度和多形态的干扰,增强大尺度变化下的目标特征提取能力,本文设计了一种基于多尺度选择注意力机制的RGBT融合目标跟踪算法(Selective Kernel Attention Fusion Tracking Network,SKANet)。通过在神经网络的单个卷积层中嵌入并行的多尺度卷积核提取不同尺度和形态下的目标特征,再利用通道选择注意力筛选出其中目标特征质量较高的特征图,可有效提升算法的追踪精度和稳定性。在开源的公开数据集RGBT234[12]和GTOT[13]上的实验结果表明,SKANet具备良好的稳定性和跟踪精度。

针对上述问题,本文的主要贡献如下:

① 提出了一个用于RGBT目标跟踪的算法(SKANet)。该算法通过内部并行的三条通道分别提取可见光、红外光以及红外可见光融合模态特征,从而增强RGBT目标跟踪性能。

② 提出了多分支选择卷积模块(Diverse-branches Selected-convolution Module,DSM)。DSM通过提取不同尺度的图像特征,不仅保留了不同尺度级别的图像语义信息,还降低了其中低质量特征和图像干扰信息对算法精度的影响。

③ 设计了一个动态自适应融合模块(Adaptive Fusion Module,AFM)。AFM为各尺度级的图像特征匹配了一个自适应权重参数,并利用该参数对送入的各尺度级的图像特征进行加权求和,从而实现对各尺度级的图像特征的融合。

1 相关工作

1.1 基于融合策略的RGBT目标跟踪

目标跟踪任务中,为全面覆盖真实的目标跟踪场景,跟踪视频序列往往采集自低照度、黑夜、雨雪和沙尘等极端场景。这类极端场景极大地影响了算法的跟踪精度和鲁棒性[14-15]。为应对此类情况,大量研究尝试利用红外与可见光图像的互补特性,设计RGBT目标跟踪算法,以此增强跟踪算法的稳定性和精度[16-17]。例如,Lu等[6]通过对红外光模态、可见光模态以及红外可见光融合模态分别建立特征提取通道,设计了用于RGBT融合目标追踪的多适配器跟踪算法。该算法不仅保留了RGBT所特有的模态信息,还建立了红外与可见光融合信息编码器。在此基础上,Lu等[18]利用双门机制分类处理各类干扰问题,进一步提升了目标跟踪的连续性和稳定性。Tu等[19]则在其设计的跟踪算法模型中加入了相关滤波块,以此衡量上级神经网络特征图的可靠性,并选择其中可靠性更高的特征图作为下一级神经网络的输入,有效地提高了跟踪算法的鲁棒性。此外,随着注意力机制[20]在计算机视觉领域中的快速发展,涌现了一批基于视觉注意力机制的RGBT跟踪算法。例如Feng等[21]在其研究中利用Resnet50作为特征提取基干,使用Transformer机制作为特征融合策略,实现了特征增强和深层次语义特征提取,改善了以往模型中因本地特征匹配精度较低造成的跟踪误差。Liu等[22]在双模态独立卷积特征提取结构的基础上,引入了空间-轴向多头注意力,在轴向与空间2个维度上分别进行注意力机制计算,实现了特征图的像素级融合以及对目标位置信息的上下文编码。

1.2 基于注意力机制的VOT算法

注意力机制在自然语言处理领域的大规模应用推动了基于视觉注意力机制的追踪算法的快速发展[20]。通过对高密度信息和高质量特征区域进行编码和权值重排,注意力机制可以将模型的注意力权重合理地分配到目标所在区域,同时抑制特征中存在的部分噪声,改善低质量特征对模型带来的不利影响。参考自然语言处理中的注意机制将句子视为序列的做法,ViT[23]将图像转换为序列,并将其送入多头注意机制中进行分类,进而实现了注意力机制在计算机视觉中的应用。王淑贤等[24]设计的SiamMCA通过多尺度通道注意力沿特征图轴向维度,建立选择向量空间,选择轴向维度上特征表现更优的特征图,实现了注意力机制在跟踪算法中的应用。江英杰等[25]使用Transformer建立了一个双流编解码追踪网络,通过Transformer构成的编码-解码器学习追踪目标的图像特征,提高了跟踪算法的鲁棒性。

现有的RGBT双模态数据集中,视频序列不仅在可见光模态中存在前文所述的多类型干扰,还在红外光模态中存在热交叉、红外传感器底噪和红外目标重叠等干扰情况[26]。随着目标的快速移动,这些干扰使得画面质量迅速恶化,固定尺寸的感受野无法稳定捕捉目标特征[8]。为改善这一情况,本文设计了一种具备多尺度SKANet。通过配备的多尺度的卷积核,在不同尺度上获取图像的特征信息,再经过通道选择注意力,增强各尺度特征图中跟踪目标的特征信息,降低上述提及的各类型干扰,提高RGBT跟踪的精度和稳定性。

2 基于多尺度选择注意力的RGBT跟踪算法

2.1 整体结构

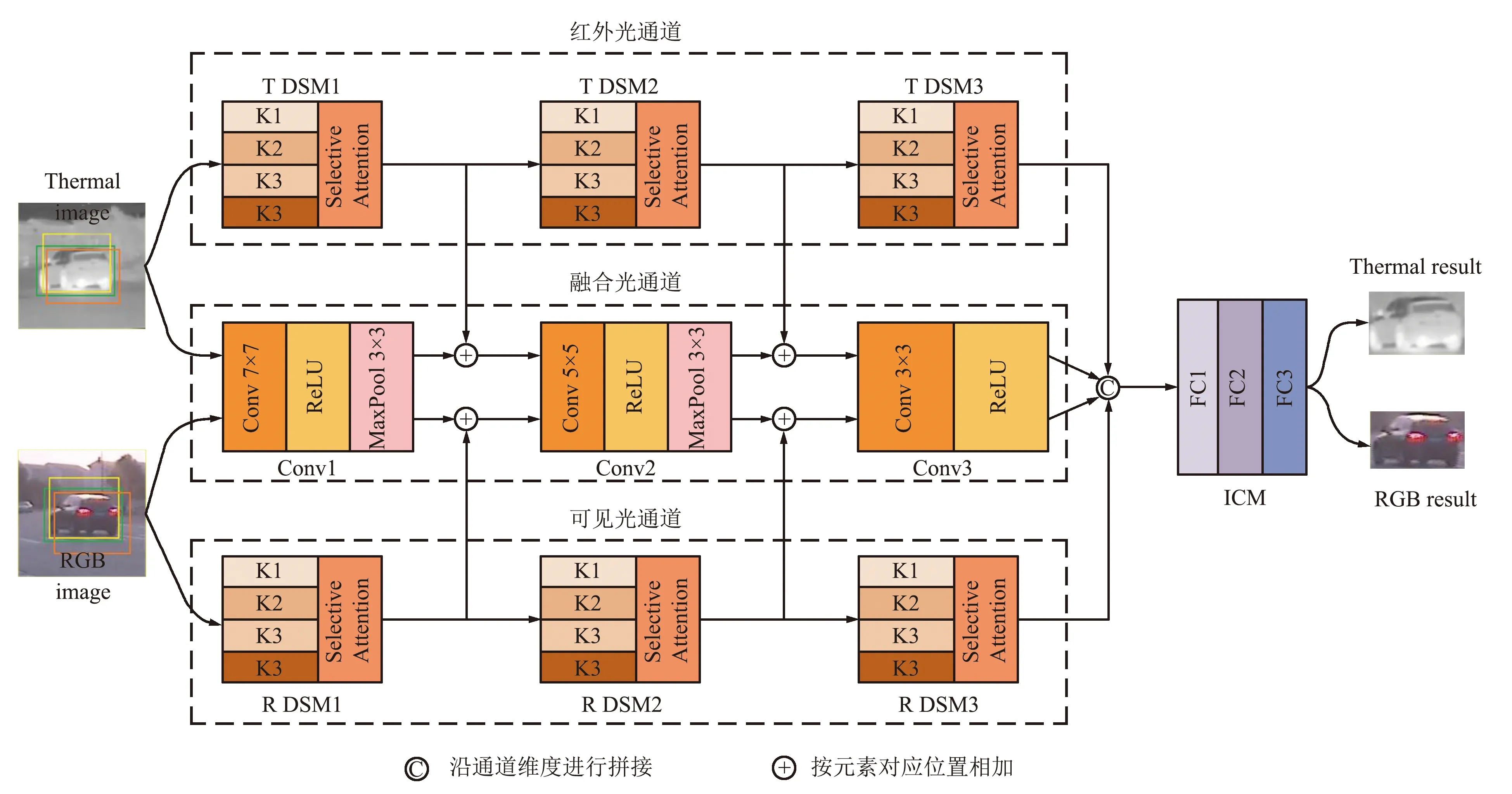

为克服不同尺度和形态的干扰,本文通过多个感受野所组成的卷积模块获取来自各度级的卷积特征,以增强算法应对目标大小变化、画面干扰的能力。SKANet整体结构如图1所示。

图1 SKANet 整体结构Fig.1 Structure of SKANet

SKANet主要由并行的融合通道(Conv1~Conv3)、可见光通道(R DSM1~R DSM3)、红外光通道(T DSM1~T DSM3)以及一个实例分类模块(Instance Classification Module,ICM)组成。其中3个并行的融合通道和可见光通道、红外光通道分别用于提取红外-可见光融合模态、可见光模态和红外光模态的图像特征,而实例分类模块则用于确认跟踪目标是否存在于这些特征之中。可见光通道与红外光通道结构类似,由3个多分支选择卷积模块(Multi-branch Selective Convolution,DSM)级联而成,由浅到深地提取图像特征。融合通道中Conv1与Conv2结构相同,由卷积层、ReLU激活层和最大池化层组成,而Conv3仅包含卷积层和ReLU激活层。Conv1~Conv3中所有可学习权重参数结合了可见光和红外光各自的图像特性,增强了2种模态特征提取的特点。实例分类模块由3个全连接层级联而成,分别是FC1、FC2和FC3。Conv1~Conv3、 R DSM1~R DSM3、T DSM1~T DSM3的主要输入输出参数如表1所示。

表1 模型中主要模块输入输出参数Tab.1 Input and output parameters of main modules in the model

2.2 多分支选择卷积模块

为从不同尺度的感受域提取目标特征,并合理地融合这些特征,本文在SKANet中设计了DSM,结构如图2所示。

图2 DSM结构Fig.2 Structure of DSM

单个DSM主要由多尺度卷积(Multi-scale Convolution Module,MCM),选择注意力(Selected Attention Module,SAM)以及AFM三部分组成。MCM由K1~K4四个不同尺度的卷积块构成,每个卷积块均由卷积层、BatchNorm层、ReLU激活层和最大池化层级联而成,K1~K4卷积层的卷积核大小分别为1×1、3×3、5×5、7×7。为充分利用特征图中的高质量特征信息,MCM在K1~K4之后还分别级联了一个SAM模块,沿特征图的轴向挑选各尺度的卷积特征图。最后将挑选后的特征图交由AFM进行自适应权重融合。该过程的详细步骤是:首先将输入特征fin∈B×C×H×W同时输入Ki(i=1,2,3,4) 分支,相应得到特征fi∈C×H×W(i=1,2,3,4) 。而后将fi分为其中输入对应的SAM模块Attentioni(i=1,2,3,4)得到对应的注意力图ai∈C×H×W(i=1,2,3,4),将ai与进行哈德玛积运算,从而得到分支Ki的输出结果ki∈C×H×W(i=1,2,3,4) 。最后利用AFM对ki进行自适应特征融合后,得到最终的输出结果output∈C×H×W。在自适应特征融合过程中,为避免数据溢出造成的数值发散,引入了非线性归一化函数,对自适应权重值进行了归一化运算。其中SAM和AFM模块的详细过程如下:

(4)

式中:i=1,2,3,4,Fi∈B×C×H×W,wi表示Fi所对应的可学习的自适应权重。

2.3 实例分类模块与损失函数

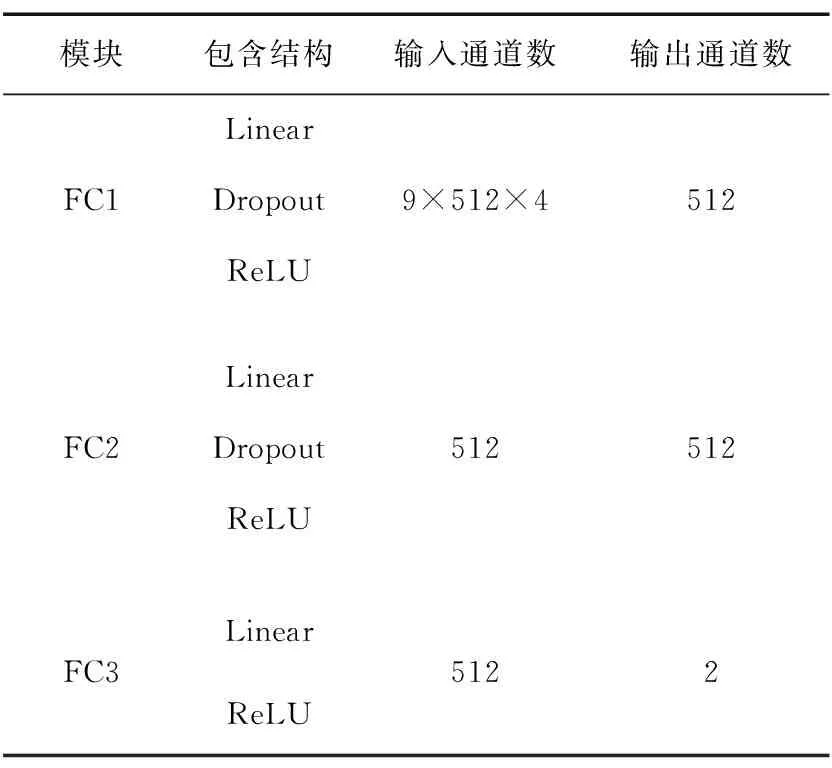

为实现模型的训练及验证,SKANet模型利用ICM模块对输入的正负样本特征进行评分,按照正负样本的分值,将输入样本确定为目标或背景(分值为正值的是正样本,反之为负样本)。ICM的整体结构可参见图1,ICM由3个全连接层(FC1~FC3)组成,详细参数情况如表2所示。其中FC1与FC2结构类似,由Linear层、Dropout层和ReLU激活层组成,FC3则只包含Linear层与ReLU层。FC3的输出结果是形状为2×1的向量。

表2 实例分类模块详情Tab.2 Details of instance classification

SKANet的中的二分类损失函数(Binary Loss)通过计算输出结果中记录的正负样本损失值,逐步优化模型参数,从而提高模型区分采样框中目标和背景的能力。为防止在损失计算过程中出现数据值溢出,SKANet在损失函数计算的基础上扣除最大值,并利用非线性归一化函数将损失值约束为0~1。损失函数的详细计算过程如下:

式中:posi表示记录在FC3输出结果向量中第i个正样本的损失值,posmax表示单个批次(batch)中正样本损失中最大值,在实际训练过程中设置单批次的正样本数n1=32,负样本数n2=96,negi表示第i个负样本的损失值,negmax表示所有正样本损失中最大值,Losspos表示正样本损失,Lossneg表示负样本损失,总损失Loss等于正负样本损失之和。

2.4 实验设计

为详细验证和比较算法模型性能,本文利用开源数据集RGBT234和GTOT进行了交叉训练和验证,并与MANet++[6]、JMMAC[27]、ECO、MANet[28]、MDNet+RGBT、DAPNet[7]、SGT[29]等7项目前主流的RGBT目标追踪算法进行性能比较。实验平台配置:处理器intel i7 10700k,显卡NVIDIA RTX 3080 Ti,内存32 GB DDR4 3 200 Hz,开发框架Pytorch1.9.1,编程语言Python3.6。

RGBT234数据集由234个真实场景下拍摄的视频序列组成,每个序列均包含RGBT两个模态的图像。RGBT234数据集中标注了12类挑战属性:无遮挡(No Occlusion,NO)、局部遮挡(Partial Occlusion,PO)、严重遮挡( Heavy Occlusion,HO)、低照度(Low Illumination,LI)、低分辨率(Low Resolution,LR)、热交叉( Thermal Crossover,TC),畸变(Defor-mation,DEF)、快速运动(Fast Motion,FM)、尺度变化(Scale Variation,SV),运动模糊(Motion Blur,MB),相机运动(Camera Moving,CM) 和背景干扰(Background Clutter,BC)。

与RGBT234数据集不同的是,GTOT数据集由50个场景序列构成,且仅包含7类挑战属性:OCC、SO、LSV、LI、FM、TC以及DEF。

训练时, SKANet围绕输入目标样本中心点,按照标准正态分布或均匀分布分别生成指定数量的正样本或负样本采样点(SKANet训练过程中正样本数量为32,负样本数量为96),而后以这些采样点为采样框中心,按照指定的正、负样本数量裁切出用于训练的样本(裁切样本与标定样本的交并比值(IoU)大于0.6的设为正样本,小于0.3的设为负样本)。为匹配不同模块的训练速度,SKANet将模型中的融合通道、可见光通道、红外光通道以及实例分类模块的可学习参数的学习率分别设置为0.000 5、0.000 5、0.000 5以及0.000 1。因为RGBT234与GTOT数据集的数量差异,SKANet在2个数据集上的训练轮次分别是200、120。

验证时,SKANet的工作流程分为初始化训练与单帧跟踪。初始化训练时,SKANet利用每一个序列的第一帧中标记框位置,生成500个正样本和5 000个负样本,并利用这些正负样本对FC1~FC3进行50轮次的初始化训练。单帧跟踪时,SKANet基于上一帧的预测结果中心点,按照均匀采样生成256个样本。根据256个样本在SKANet中的预测结果,选取其中得分排名前五的样本框,使用这5个样本框的中心点、长宽值的平均值作为该帧的预测结果。

为量化地评估算法在数据集上的性能表现,实验中使用精度(Precision Ratio,PR)和成功率(Success Ratio,SR)来分别衡量算法的精度和稳定性。具体的计算如下:

式中:pi表示当前第i帧是否符合实验中设定的成功率精度,若其预测框bbi中心与标记的真实框gti的欧氏距离低于门限值thrPR则取1(使用GTOT数据集时设置为5像素值,使用RGBT234数据集时设置为20像素值),否则取0。而整个数据集上的平均PR,则需要累加整个数据集上所有的序列帧后求平均。SR的计算与PR计算有区别的地方是计算IoU,再与门限值thrSR(文中设置为0.6)相比较,从而判断是否满足要求。

3 实验结果与分析

3.1 RGBT234数据集验证结果

SKANet在RGBT234数据集上的验证结果如表3所示,可以看出,在共同验证的8项算法中,SKANet的平均PR、SR值均为第一,且分别超过第二名0.5%、0.4%。而在RGBT234数据集的12项详细测试结果中,SKANet的SR值在BC、FM、HO、LR、PO等5项场景下位列第一;在CM、DEF、MB、NO、TC等5项场景下位列第二。而PR值在BC、FM、LR、PO、TC等5项场景下位列第一;在DEF、HO、LI等3项场景下位列第二。由上述结果可以看出,SKANet在RGBT234数据集上拥有更强的稳定性,相较于平均SR值位列第二的JMMAC,SKANet在FM、HO、LR、PO等场景下具有更稳定的跟踪性能,能够更好地抵抗BC、FM、HO、LR、PO、TC等5项场景中存在的相机快速移动、画面严重污染、低分辨率和画面部分遮挡带来的不良影响。

表3 RGBT234验证结果Tab.3 Evaluated result on RGBT234

3.2 GTOT数据集验证结果

SKANet在GTOT数据集上的验证结果如表4所示。可以看出,在共同验证的8项算法中,SKANet的平均PR、SR值均为第一,分别超过第二名0.7%、0.3%。SKANet的PR值在OCC、SO、FM、TC等4项场景下位列第一;在LSV、LI等2项场景下位列第二。其SR值在OCC、LSV、TC、DEF等4项场景下位列第一;在SO、LI等2项场景下位列第二。通过各分类PR、SR值可以看出,SKANet在GTOT数据上相较于比较算法拥有更高的准确率和相对持平的稳定性,同时在面对画面存在遮挡、跟踪目标较小和镜头快速晃动等情况时具备明显优于比较算法的跟踪性能,能够保持较高的跟踪精度和跟踪稳定性。

表4 GTOT分类验证详情Tab.4 Evaluated result on GTOT

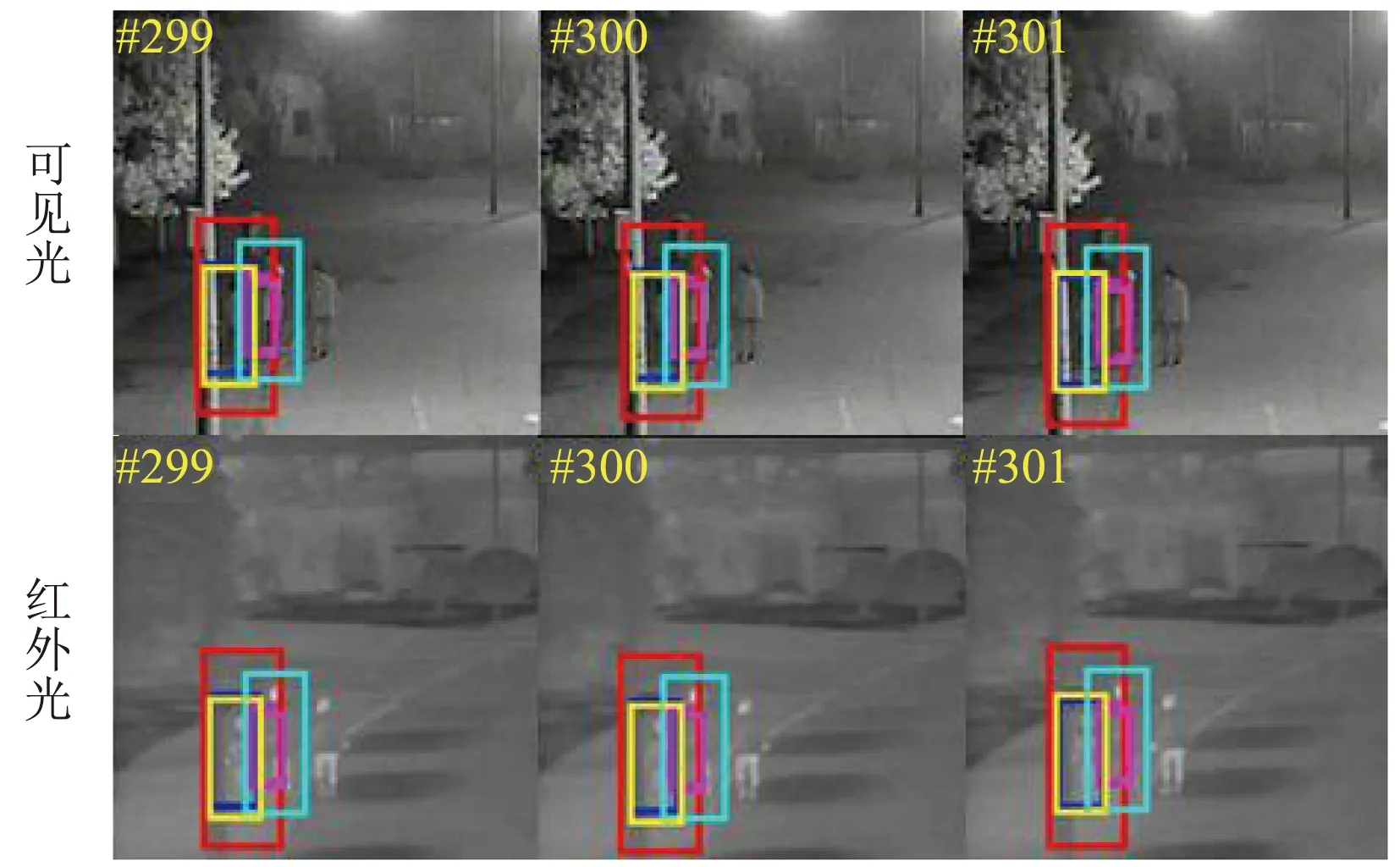

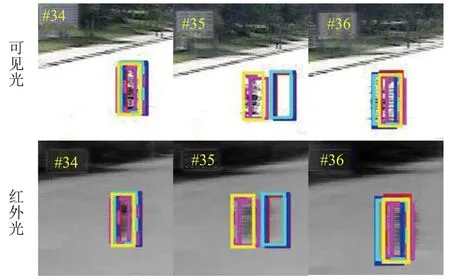

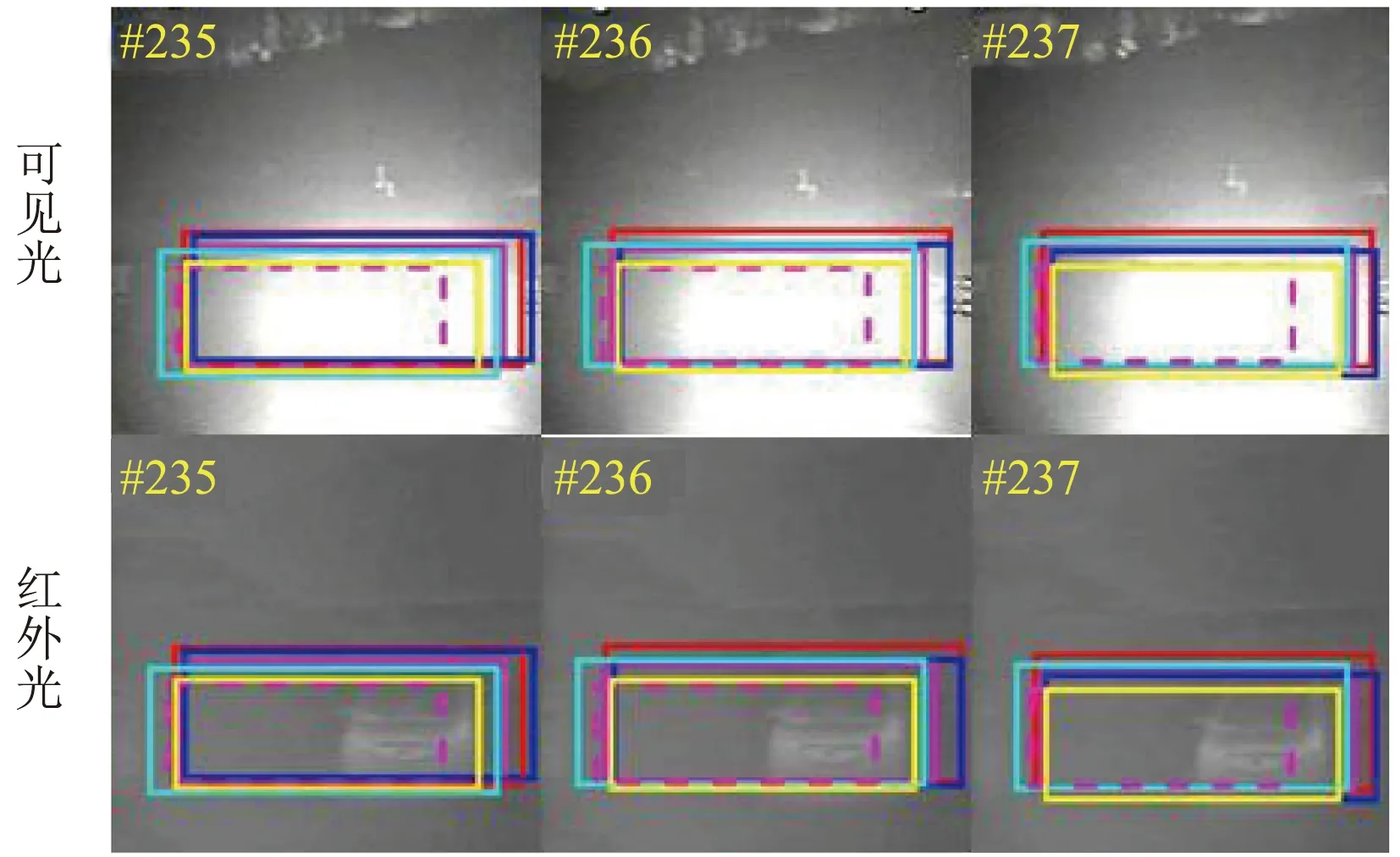

3.3 部分序列跟踪结果可视化比较

为在跟踪画面中直观展示SKANet的跟踪性能,本文挑选了JMMAC[27]、 ECO、MANet[28]、MDNet+RGBT、 SGT[29]等5项算法作为对比对象,选取RGBT234数据集中4个典型序列的连续3帧跟踪结果进行可视化展示。可视化的跟踪结果如图3所示。

(a)目标干扰(第299、300、301帧)

(b)镜头抖动(第34、35、36帧)

(c)部分遮挡(第12、13、14帧)

(d)镜头眩光(第235、236、237帧)图3 部分可视化跟踪结果Fig.3 Visual results of partial sequences

可以看出,本文提出的SKANet在4个序列中的跟踪结果均优于比较算法。同时,从存在目标干扰时的结果(图3(a))可以看出,在跟踪画面中存在与跟踪对象外形相似的其他跟踪目标时,SKANet能识别目标与干扰对象之间的差异。从存在镜头抖动时的跟踪结果(图3(b))可以看出,跟踪画面在第35帧时出现了明显的镜头抖动,因而产生了明显的虚影和扭曲,但SKANet仍然能够稳定地保持对目标的跟踪。从存在部分遮挡时的跟踪结果(图3(c))可以看出,当目标运动至画面中的电线杆附近时,被电线杆及附近灌木丛遮挡了部分特征,除SKANet与JMMAC之外的大部分比较算法因无法应对此类干扰而丢失目标。从存在镜头眩光时的跟踪结果(图3(d))可以看出,在可见光模态下,画面中充斥着因车辆灯光直射而产生的大量镜头眩光,目标的可见光特征因此被大部分遮挡,除SKANet、JMMAC和MANet之外的其他对比算法的跟踪框皆产生了更大的漂移。

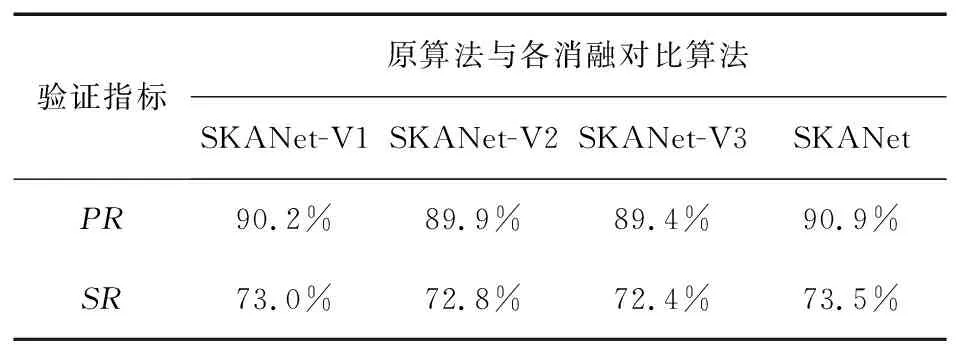

3.4 消融实验结果

为分析验证SKANet中各部分的效能,设计了3个消融实验:① 使用融合通道中的Conv1~Conv3替换可见光通道中的R DSM1~R DSM3,建立SKANet的变体网络:SKANet-V1。② 使用融合通道中的Conv1~Conv3替换红外通道中的T DSM1~T DSM3,建立SKANet的变体网络:SKANet-V2。 ③ 使用融合通道中的Conv1~Conv3替换可见光以及红外通道中的R DSM1~R DSM3与T DSM1~T DSM3,建立SKANet的变体网络:SKANet-V3。使用与实验中同样的训练策略与验证设置,在RGBT234数据集上对SKANet-V1、SKANet-V2以及SKANet-V3进行训练,然后使用GTOT数据集对其进行验证。

消融实验结果如表5所示。可以看出,通过引入DSM,建立用于可见光模态的特征提取通道可有效提高算法的跟踪精度和稳定性;通过引入红外光模态图像,建立红外光模态的DSM特征提取通道,可将跟踪精度从89.9%提升至90.9%,将跟踪成功率从72.8%提升至73.5%,较建立可见光模态的DSM特征提取通道效果更为明显;通过分别建立RGBT模态的DSM特征提取通道,可将跟踪精度提升1.5%、成功率提升1.1%。

表5 消融实验结果Tab.5 Result of ablation experiments

4 结束语

在真实场景中,目标跟踪任务不仅需要克服跟踪目标尺度大范围变化造成的特征变化,还要抵抗真实场景中复杂背景条件和图像捕捉装置自身因素产生的干扰。本文设计的SKANet,通过DSM,从多尺度感受野上提取追踪目标图像特征,再利用SAM对这些图像特征进行过滤和筛选,降低其中存在干扰的特征图对整个模型跟踪精度和稳定性的影响。通过实验结果以及消融实验可以看出,SKANet利用红外与可见光图像的互补特性,显著地提高了视觉目标的跟踪精度和鲁棒性。相较于其他主流RGBT跟踪算法,SKANet在跟踪画面存在干扰时,能够保持更高的跟踪精度和稳定性。