基于特征图可视化的医学图像分析

2023-10-09汪颖萍邵海见

汪颖萍,邵海见,2*,邓 星,2

(1.江苏科技大学 计算机学院,镇江 212100)

(2.东南大学 自动化学院 复杂工程系统测量与控制教育部重点实验室,南京 210009)

近年来随着计算机硬件的发展,卷积神经网络(convolutional neural networks,CNN)处理图像的效率和性能都得到不断提升.基于CNN的医学图像分类方法,利用卷积操作自动提取图像的形态、纹理和颜色等特征,并结合损失函数和优化器对学习到的特性不断加以修改,使网络模型达到较好的分类效果.

经典卷积神经网络模型由卷积、池化、全连接层组成,如AlexNet,VGG,GoogLeNet,ResNet等,其中VGG模型[1]使用了较小的卷积核和池化核,同时增加了模型深度,丰富了模型非线性表达能力而被广泛用.文献[2]提出GoogLeNet模型采用不同大小的卷积核和Inception分支结构,将不同分支上提取得到的特征拼接映射成为输出特征,拓宽了模型的宽度.文献[3]提出的ResNet模型设计了残差结构,使得模型在训练过程中能够学习信息量的差值,克服了神经网络因深度增加导致性能易退化的缺点.为了强调重要的特征信息,提出注意力机制,如通道、空间注意力赋予特征图以不同的权重,按照这种方式训练得到的网络能达到更好的效果.

基于深度学习的发展,提出许多利用CNN实现医学图像分类任务的方法,大致分为两类:基于单一网络模型的方法和基于模型融合的方法.文献[4]提出了一种基于图像补丁的方法训练AlexNet,通过输入高分辨率组织病理学图像,将乳腺肿瘤分为良、恶性两类.文献[5]基于迁移学习技术,加载Resnet50网络在ImageNet数据集上训练得到的权重参数,对BreaKHis数据集[6]中不同放大倍数的图像依次分类.单一的网络模型面临一些复杂多样的医学图像时,提取到的特征信息往往不够全面,此时可以采用多个模型融合的方式,来提高网络的分类性能.文献[7]提出了一种混合Inception-V3和循环深度神经网络的方法用于乳腺癌组织病理图像分类,有效综合了CNN和递归神经网络的优势.文献[8]将DenseNet与SENet模块交错使用,构建一种新的网络模型用于乳腺癌的分类,提高了特征信息的传递和复用.

虽然深度学习在医学图像研究中已经取得了不错的成绩,但深度学习模型的可解释性问题一直存在.被称为“黑盒”的深度学习,依赖于从大量的训练数据中提取特征,而对提取出来的特征数据缺乏可解释性.仅有一个好的分类模型不够,还需要用科学可行的方法对模型给出合理的分析和解释.为此,文中基于CNN在多个医学图像数据集上分类,利用可视化网络特征图的方法对提取到的特征进行分析,从而对分类性能给出合理的解释.

1 基于特征图可视化的医学图像分析方法

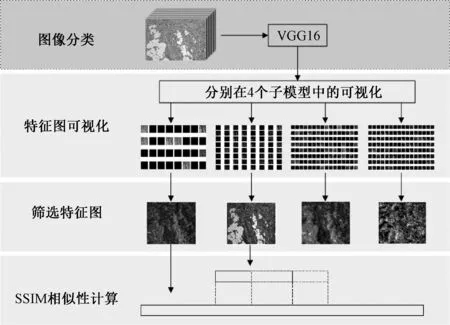

基于CNN特征空间可视化的医学图像分析方法,如图1,直观地给出了网络中卷积层所产生的特征图,以灰度图显示,并结合图像结构相似性(structual similary, SSIM)找出数据集在网络中存在的差异,正是这些差异最终导致了分类结果的不同.每一阶段的描述如下:

图1 基于特征图可视化的医学图像分析方法

图像分类.利用改进后的VGG16网络分别对BreaKHis、Retinal OCT和Chest X-Ray Images数据集分类,从定性的角度找出同一网络在不同数据集上的差异性.

特征图可视化.输入图片经过4个特征图可视化模型后将生成一系列的特征图,以视觉更为直观的方式观察每一次卷积运算后习得的特征信息.

筛选特征图.计算每个可视化模型产生所有特征图的图片信息熵,从中分别挑选信息熵最大的特征图,其代表该可视化模型提取特征的能力.

SSIM相似性计算.由于部分卷积层输出特征图的大小不同,导致4个可视化模型输出的特征图尺寸不同,文中采取滑动窗口的策略计算可视化模型输出特征图的结构相似性,从定量的角度分析同一网络在不同数据集上的特征提取能力.

1.1 改进的VGG16网络模型

基于VGG16网络进行分类,VGG16网络模型由13层卷积层、3个全连接层组成,是针对在Imagenet大型数据集上的分类问题而设计的,因此VGG16网络的卷积层和全连接层参数量巨大,而文中所使用到的3个医学图像数据集在数量和类别均远小于Imagenet数据集.为了避免出现过拟合问题,对VGG16网络模型进行了相应改进,使得该网络模型更加适合需求.

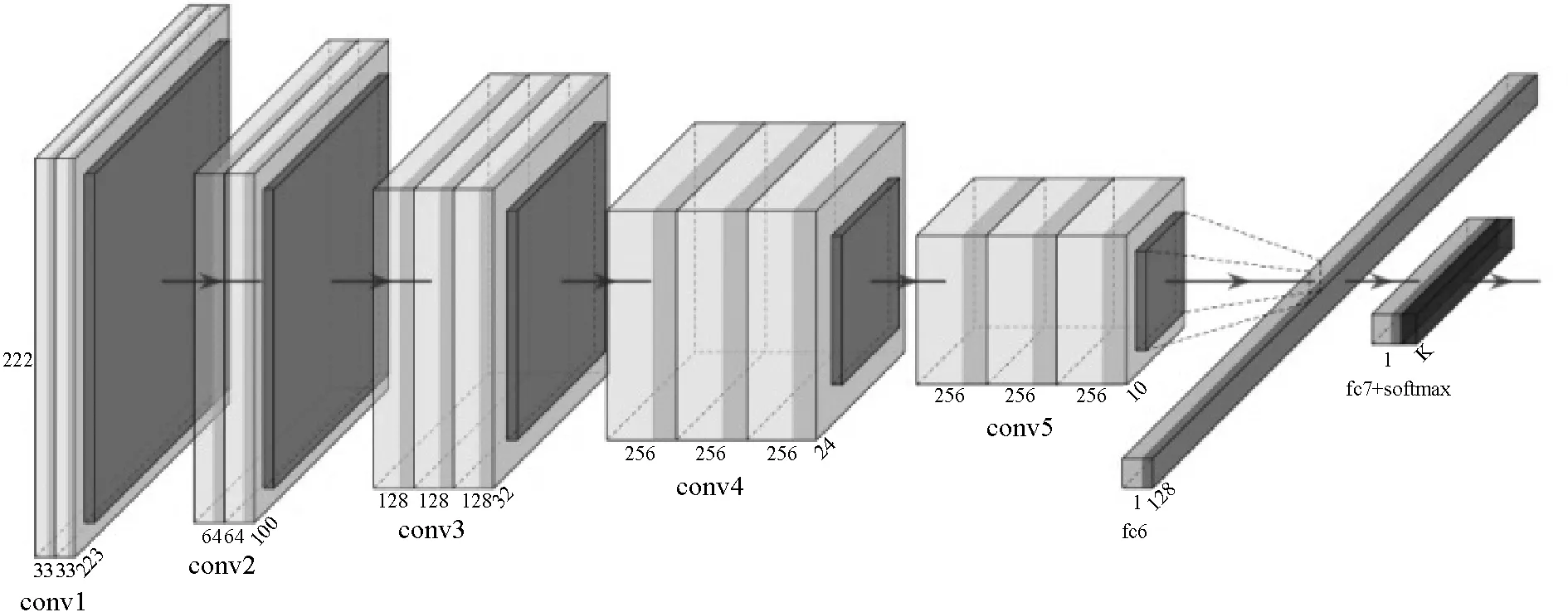

文中重新设计了卷积层和全连接层,保持了卷积核大小和5个最大池化,改进后的VGG16网络模型如图2.对于卷积层,减少每层卷积核的数量,降低参数量,缩减了网络规模;同时每个卷积块中的第一个卷积层不进行图像填充,剩余卷积层保持输入输出的大小不发生变化.如卷积块conv1的第一个卷积层,输入224×224×3的图片经过32个3×3的卷积核卷积后变成了222×222×32.针对全连接层,将原有的3层改进为2层,并减少相应层中的神经元数量,使用Relu激活函数,加入dropout层以防止过拟合,调整最后的输出分类为相应类别.

图2 改进后的VGG16网络模型

1.2 特征图可视化模型

激活图,称为特征图,捕获将过滤器应用于输入的结果,例如输入图像或特征图.使学习到的特征显式的方法称为特征可视化.鉴于网络的复杂性和不透明性,特征可视化是分析和描述网络的重要步骤.

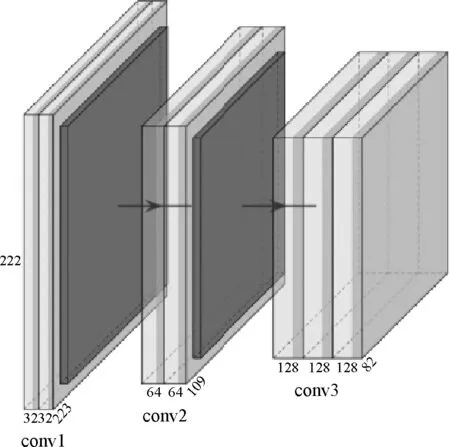

为了探索特征图的可视化,需要输入可用于创建激活的VGG16模型.文中利用每个卷积层输出的特征图的尺寸等信息,设计4个新模型,这些模型是完整VGG16模型中的子集.具有与原始模型相同的输入层,但输出将是给定卷积层的输出.在可视化特征图的过程中,使用这些模型进行预测,将给出指定输入图像经过特定卷积层后产生的特征图.

4个可视化模型的输出分别是VGG16网络的第一、三、五以及第七个卷积层的输出,即大小分别为222×222×32、109×109×64、52×52×128和52×52×128的一系列特征图.图3为最后一个可视化子模型的网络结构,在该模型中,使用与VGG16模型相同数量和尺寸的卷积过滤器,然而子模型仅专注于特征提取阶段.图中浅色部分代表经过卷积层后产生的特征图,深色部分代表经过池化操作后得到的特征图.对于最后一个特征图可视化模型,将输出待预测图片在网络中的128个特征图.

图3 可视化子模型

1.3 相似性计算

文中使用文献[9]提出的SSIM结构相似度评估特征图,从亮度、对比度、结构3个方面度量图像相似性,其定义为:

(1)

式中:x、y为输入的两张大小相同二维特征图矩阵;α、β、γ为相关权重系数,均大于0;l(x,y)、c(x,y)、s(x,y)分别为亮度、对比度、结构相似度函数.

(2)

(3)

(4)

式中:u为特征图的平均灰度矩阵;σ和σxy分别为标准差与协方差矩阵;C为常数.

从4个可视化模型产生的特征图中分别筛选出信息熵最大的特征图,用SSIM指标衡量特征图间的相似性.由于不同可视化模型产生特征图的大小不同,文中采用序列滑动的策略.将特征图拉平成一维向量,以短序列的1/2为步长,使短序列在长序列上滑动,确保用于计算相似性的特征图具有相同的维度,依次计算出两者SSIM值,结果取平均值.SSIM值越高,即两张特征图的相似度越高,则两个可视化模型间提取到的特征重叠性越大.

2 实验与结果

2.1 数据集

2.1.1 BreaKHis数据集

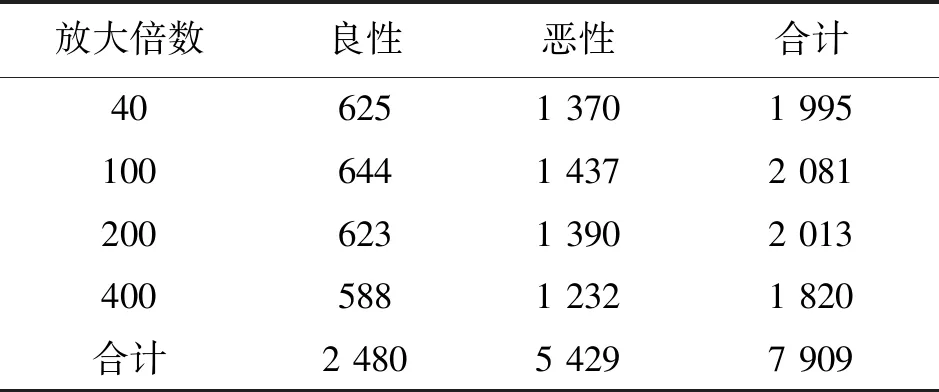

乳腺癌组织病理学图像[6],样本从乳腺组织活检玻片中提取,通过SOB活检方法得到并用苏木精-伊红染色法染色,选取厚度约3 μm的部分.通过免疫组织化学来评估乳腺肿瘤标本,分别使用不同的放大倍数获得乳腺肿瘤组织的显微图.数据集共包括来自82位患者的7 909张病理图像,其中良性样本2 480张和恶性样本5 429张,样本分布见表1.不同放大倍数的乳腺组织病理图像在VGG16网络上的分类性能差异并不大,故文中选用放大倍数为40的所有样本为例,进行可视化分析.

表1 BreaKHis数据集中的样本分布

2.1.2 Retinal OCT数据集

视网膜光学相干断层扫描(OCT)可提供活体患者视网膜高分辨率横截面的图像.Retinal OCT数据集共包含84 484张X射线图像,4个类别及数量分别为:脉络膜新生血管(CNV),37 455;糖尿病黄斑水肿(DME),11 598;脉络膜小疣(DRUSEN),8 866;正常(NORMAL),26 565.

图4为不同种类中具有代表性的光学相干层析成像图像,并用不同的记号标识了各类病变独具的特征形态.从左到右依次是CNV表现为新生血管膜和视网膜下液;DME表现为视网膜增厚、出现相关视网膜内液体;DRUSEN含有多个脉络膜小疣;正常视网膜NORMAL呈中央凹陷状、无视网膜内液和水肿产生[10].

图4 OCT数据集中的4类图像

2.1.3 Chest X-Ray数据集

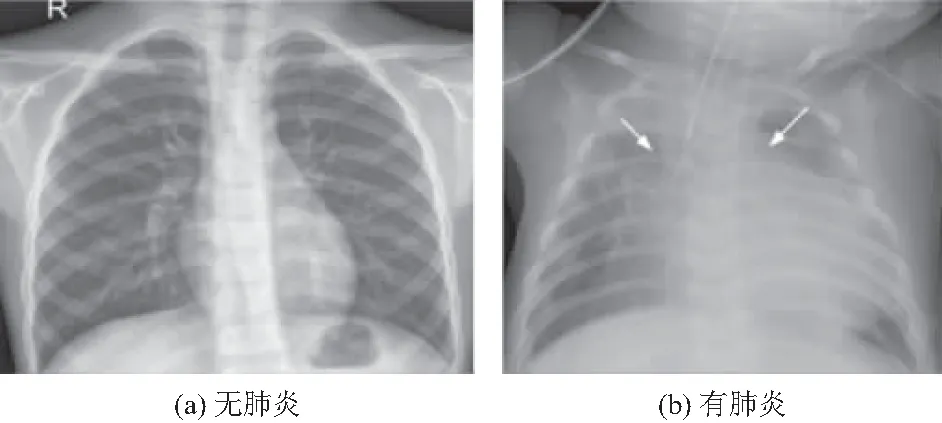

胸部X射线图像数据集收集了广州市妇女儿童医疗中心1~5岁儿童患者的5 856张X射线图像,其中正常胸部图像有1 583张,患有肺炎的有4 273张[11].图5展示了数据集中两类图像,左图正常胸部X光片肺部清晰明显,无异常混浊区域,而患肺炎一般在X光片上表现为双肺纹理增多增粗紊乱,并见斑片状密度增高影,边缘模糊.

图5 有/无肺炎的胸部X光片

2.2 实验结果与讨论

2.2.1 特征图可视化

文中分别给出了3类数据集在4个可视化模型上的输出.所有实验均在同一台设备上进行,利用同一个CNN在3个数据集上分类,选择分类性能最好的迭代次数,并尽可能调整参数使其达到最优.

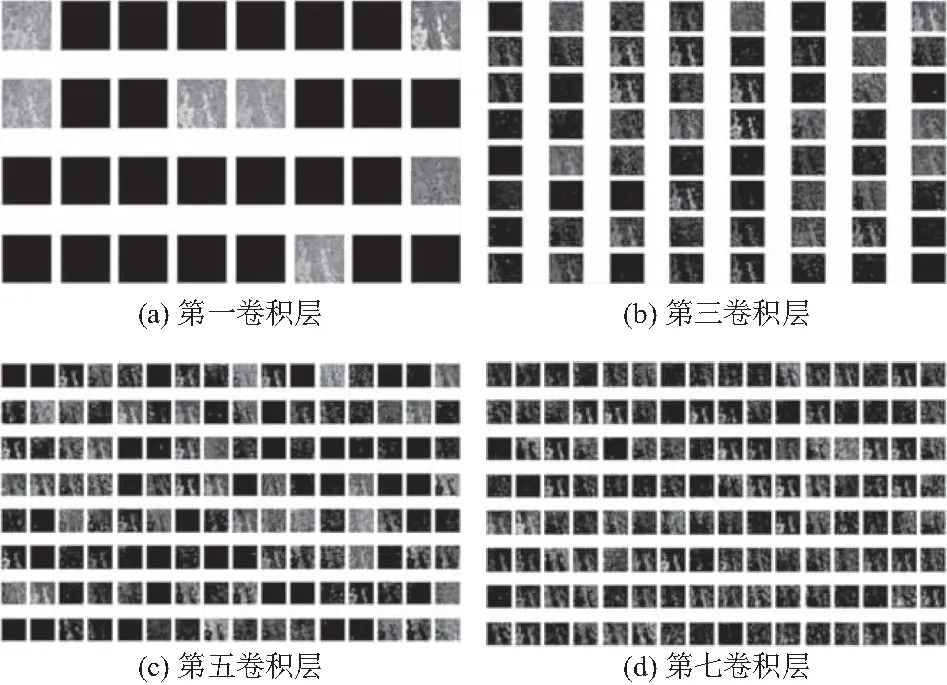

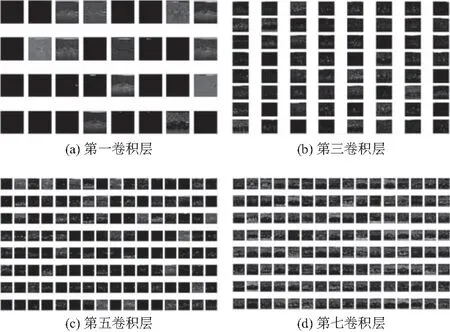

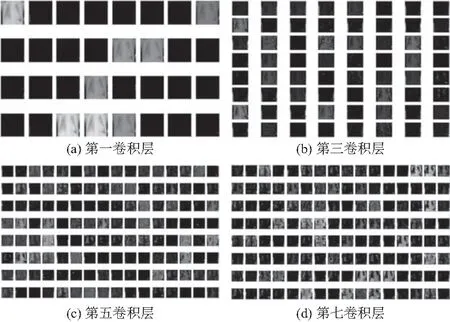

从图6~8可视化的结果中观察到浅层的卷积层提取到的是输入图像的边缘、轮廓、线条等特征,特征清晰明显.图6中为BreaKHis数据集中某一恶性乳腺癌图像依次在4个可视化模型的输出,特征图的尺寸分别是222×222×32、109×109×64、52×52×128和52×52×128.随着网络层数加深,深层卷积层在浅层卷积层的基础上提取的特征更加复杂,故而第四个可视化模型输出的特征也更为抽象.图7为Retinal OCT数据集中的某一脉络膜新生血管视网膜疾病图像分别在4个可视化模型的输出.图8为在Chest X-Ray数据集中某一肺炎图像依次在4个模型上的可视化结果.

图6 特征图的可视化-恶性乳腺癌

图7 特征图的可视化-脉络膜新生血管

图8 特征图的可视化-肺炎

对于在4个模型上可视化后的一系列特征图,将从中筛选出信息熵最大的特征图,用于代表该可视化模型的特征提取能力.如图9,箭头左侧代表预测图像,与图6~8的输入一致,对于每类数据集,箭头右侧从左到右依次为在4个可视化模型输出中筛选出的特征图.

2.2.2 可视化结果分析

图像中包含信息量大小的量化称为图像熵,一定程度上代表信息的混乱程度,熵值越大图像所蕴含的信息则越多.选取每层中图像熵最大的特征图,以此来代表当前卷积层提取特征的信息量.将不同灰度的熵值累加得到图像熵[12]为:

(5)

式中:pi是灰度值为i在该图像中出现的概率,可由灰度直方图获得.

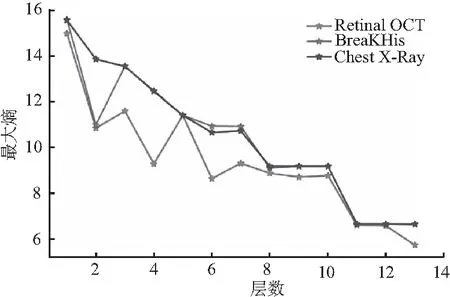

VGG16网络每层卷积层产生特征图的最大图像熵变化趋势如图10,随着网络层数加深特征图熵值降低,每层卷积层所提取到的特征信息量减少.其中在Retinal OCT数据集上图像熵的波动幅度明显,层与层之间提取的特征信息有增有减、互不影响,在该数据集上后续卷积层依旧能提取到丰富的特征信息.而在BreaKHis和Chest X-Ray数据集上特征图的最大信息熵变化趋势相对平缓,且在网络的前8层提取到的特征信息量逐层递减.

图10 特征图的最大熵变化

分别测试3个数据集在VGG16网络上的分类性能,如表2,表中的SSIM取4个可视化模型所提取特征间相关性的平均值.

表2 在VGG16网络上的分类

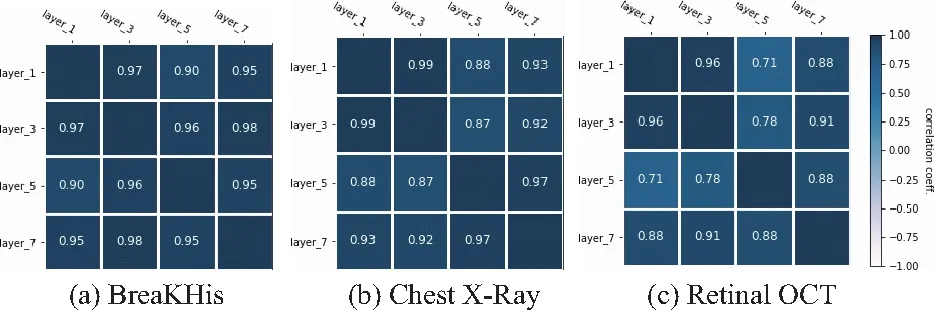

通过SSIM指标对从图9中筛选出的特征图进行相似性分析,以此评估4个可视化模型所提取到的特征信息.如图11,数据集上的相关性分析,图中的layer_1表示第一个可视化模型所提取到的特征,layer_3表示VGG16的第三个卷积层即第二个可视化模型所提取到的特征信息,其余以此类推.对每一数据集,VGG16网络中可视化模型间提取的特征相似性较强,在BreaKHis数据集上相似度集中在0.95,其次是Chest X-Ray数据集约为0.93,在Retinal OCT数据集上相似度最低,约为0.85.4个可视化模型提取到的特征包含相似处,这可能是较重要、具代表性的突出特征.而Retinal OCT数据集相比于BreaKHis和Chest X-Ray数据集相关性更低,在该数据集上通过卷积操作提取到了更丰富、更具多样性的特征信息,在面对复杂多样的病变图像时也能有较好的分类能力,因此在同一网络上分类性能最好.

图11 可视化模型所提取特征间的相关性-VGG16

通过可视化模型的输出,并对经过筛选后的特征图进行SSIM相似性分析,发现了不同数据集之间的共性和异性.共性即数据集经过CNN,提取到的特征信息相似性较高,从可视化的灰度图(图6~8)和SSIM指标(图11)证明了这点.而3个医学数据集之间的异性在于,Retinal OCT数据集数量大,且4种类型的视网膜光学图像差异性明显、易于区分,BreaKHis和Chest X-Ray数据集虽然都只包含两类,但在Chest X-Ray数据集中肺炎图像的病变类型复杂,多数图像之间仅存在细微的差异,BreaKHis数据集中的乳腺癌细胞病变形态多样,经过卷积层习得的特征不具有较强的泛化性能.更进一步的,对于VGG16网络,分类能力差异性极大,从表2中可以观察到Retinal OCT数据集的分类性能最好.这是由于Retinal OCT数据集通过网络的逐层提取学习到的特征信息更加丰富,在该数据集上可视化模型所提取特征间的结构相似性在0.71~0.96,集中在0.85,相似度相对较低.而在BreaKHis数据集上卷积层提取到的特征相似性极强,均大于0.90,见图11(a),卷积层之间提取的特征单一,从而导致在同一网络上取得的分类性能较低,分类精度为75.96%.

2.2.3 模型性能对比

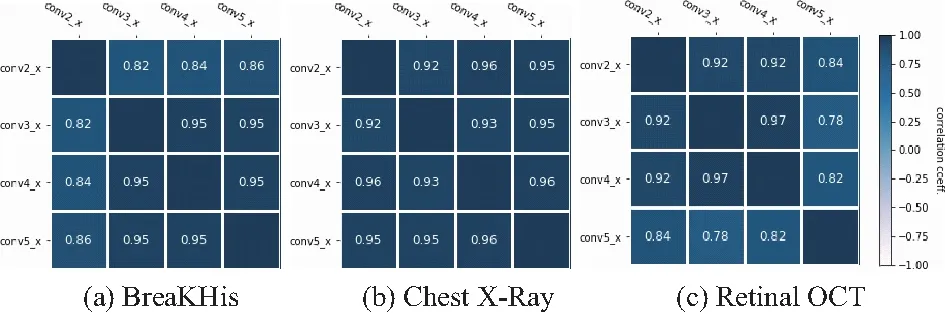

为了验证所提出基于特征图可视化的医学图像分析方法的普适性,将其应用到ResNet18网络上.由于该网络的参数量较大,故将卷积核的数量缩减一半,增加一个神经元个数为128的全连接层,分类性能见表3.预测图片输入到基于ResNet18的可视化模型后,对应输出分别是网络的4组残差块的输出,即大小分别是56×56×32、28×28×64、14×14×128和7×7×256的4组特征图.从中筛选出信息熵最大的特征图,用于代表4个可视化模型的特征提取能力,利用SSIM指标对可视化模型提取到的特征信息进行相关性分析,如图12.

表3 在ResNet18网络上的分类

图12 可视化模型所提取特征间的相关性-ResNet18

图中conv2_x代表第一个可视化模型,对应ResNet18网络中的第一组残差块.其中在Chest X-Ray数据集上可视化模型所提取特征间的相关性均大于0.92,呈极强的相关性关系,特征间的重叠性极高.

从表3观察到ResNet18网络在3类数据集上的分类性能表现出同样的趋势,即分类精度取决于网络的特征提取能力.同一网络在Retinal OCT数据集上可视化模型提取特征间的相似性较低,获取的特征更丰富多样,从而表现出更好的分类性能.

此外,ResNet18在BreaKHis数据集上的分类性能明显优于VGG16网络,相比提高了9.62%,对应的SSIM值却低于VGG16网络.可见CNN的特征提取能力在一定程度上决定了网络的分类性能.

3 结论

为提高医学图像分类任务中深度学习模型的可解释性,基于4个可视化模型生成的特征图,研究一种对网络模型产生不同决策的分析方法.通过大量实验得出以下结论:

(1) 在CNN中,浅层卷积层提取的是边缘、轮廓、线条等特征,且可视化后的特征图明显清晰.而深层卷积层提取的特征相比于浅层更抽象.

(2) 随着网络层数的加深特征图所蕴含的信息量总体上呈波动式下降.

(3) 神经网络的逐层提取机制使得卷积层之间提取得到的特征具有相似性.

(4) 网络中层与层之间提取到的特征差异性越大,该数据集在同一网络上的分类性能则越好.