基于惯性测量与视频图像信息综合的抗遮挡跟踪策略在机载光电侦察瞄准系统中的应用研究

2023-09-15吉书鹏刘志广渠继峰许建铮李同海

吉书鹏 刘志广 渠继峰 许建铮 李同海

摘要: 目标跟踪是机载光电侦察瞄准系统的一个重要工作模式, 其性能的优劣直接决定着载机系统完成任务使命的效能。 针对机载光电侦察瞄准系统目标跟踪应用中存在的主要问题和技术难点, 本文基于系统多源传感器构型及应用特点, 综合组合惯导、 运动测量、 伺服控制、 地理坐标及图像信息等多维度参数, 提出了一种基于惯性测量与视频图像信息综合的智能目标跟踪策略, 通过仿真分析与飞行测试表明, 该策略有效提高了目标跟踪抗遮挡性能, 实现了全动态复杂场景下稳健持久跟踪, 提升了载机系统侦察监视、 目标定位、 瞄准引导的作战能力。

关键词: 光电侦察瞄准; 信息融合; 惯性测量; 视频图像; 深度学习; 目标跟踪; 抗遮挡; 智能化

中图分类号: TJ760 文章编号: 1673-5048(2023)04-0001-09

文献标识码: A DOI: 10.12132/ISSN.1673-5048.2022.0227

0引言

機载光电侦察瞄准系统采用陀螺稳定平台及惯性导航技术, 装载可见、 红外和激光等光电传感器, 遂行侦察监视、 识别定位、 跟踪瞄准和武器引导等任务使命。 光电侦察瞄准系统不仅要实现高分辨率目标探测识别、 精准测量定位, 而且要实现精确瞄准和武器引导, 以上任务的完成都是建立在高性能目标跟踪基础之上, 目标跟踪性能直接决定着载机系统完成任务使命的效能。

随着计算机视觉、 图像处理技术及应用需求的发展, 视频图像目标跟踪(视觉跟踪)技术取得了突破性进展, 新算法众多。 根据目标模型构建方式的差异, 视觉跟踪算法通常分为生成类和判别类。 由于生成类算法忽略背景影响, 抗干扰能力较弱, 当目标被遮挡时易导致失跟, 该类算法主要包括均值漂移(Mean Shift)、 粒子滤波(Particle Filtering)和光流法(Lucas Kanade)等。 判别类跟踪算法考虑背景建模, 具有更好的目标跟踪鲁棒性, 目前已成为视觉跟踪的主流算法, 该类算法主要包括相关滤波(Correlation Filter)和深度学习(Deep Learning)等。

基于最小化均方误差(MOSSE)[1]滤波目标跟踪算法将时域计算转换到频域计算, 显著提升了目标跟踪速度, 开创了视觉跟踪的新时代。 为进一步提升性能, 在MOSSE基础上出现了很多改进算法(CSK[2], KCF[3], BACF[4], SAMF[5]等), 成为目标跟踪算法的研究热点[6-7]。 CSK通过样本循环移位增加样本数量, 利用循环结构性质和傅里叶变换快速计算, 使得训练出的滤波器更加稳健。 文献[8]在KCF算法框架下融合HOG特征和CN特征, 增强了对目标外观表征, 提升目标跟踪的精度和鲁棒性。 文献[9]提出依据多峰检测与置信度(APCE)的目标模型更新策略, 一定程度上解决了目标被遮挡问题, 提高了目标跟踪效果。 SAMF和DSST在KCF算法的基础上引入尺度估计, 改进目标尺度变化对跟踪的影响。 在SRDCF的基础上, 文献[10]提出CCOT算法, 将时域离散位置估计转换为时域连续位置估计, 提升目标位置估计的精准性。 文献[11]从训练样本、 滤波器系数和模板更新等方面对CCOT进行改进, 提出ECO算法, 显著降低了计算复杂度。

近些年, 随着神经网络技术的发展, 深度学习算法凭借其优秀的建模能力, 在目标跟踪领域取得了巨大的进展, 涌现出大量算法, 提升了目标跟踪的精准性和鲁棒性。 基于深度学习的目标跟踪算法主要分为两类, 即以相关滤波作为跟踪框架的目标跟踪算法和完全基于神经网络框架的目标跟踪算法。 文献[12]提出基于多层卷积特征的跟踪算法(HCFT), 结合多层深度网络特征与相关滤波算法, 取得很好的效果。 文献[13]提出循环目标强化跟踪算法(RTT), 使用RNN网络提取目标显著性特征, 将其加到相关滤波器系数上, 增强相关滤波器对于背景噪声信息的抗干扰能力。 文献[14]提出一种全卷积孪生网络结构, 通过一对在大型数据集上离线训练的通用孪生网络框架提取目标模板与候选区域特征, 然后将目标模板与候选区域进行卷积操作, 得到目标响应图, 响应最大候选区域位置即目标位置。 该方法模型构建简单, 跟踪速度可达到58帧/秒, 而且跟踪精度高。 目前, 基于神经网络的目标跟踪算法普遍实时较差, 对硬件资源要求高, 而且需要大样本量的训练数据支撑, 限制了其在视频跟踪中的应用。

机载光电侦察瞄准系统目标跟踪属于动基平台上的全动态场景目标持久跟踪, 由于跟踪过程中目标场景和环境的复杂多变性, 目标跟踪过程中会出现以下情况: (1)长时间跟踪误差累计、 瞄准线漂移, 导致失跟; (2)相似目标或强背景物体出现, 导致错跟; (3)目标被烟、 云、 物等遮挡, 导致失跟; (4)目标特征剧烈变化、 瞄准线跳动, 导致失跟。 通过应用实践证明, 仅采用视频图像跟踪技术, 不能满足机载光电侦察瞄准系统对运动目标长时间韧性跟踪的要求, 不能有效解决运动目标跟踪抗遮挡等问题[15-16]。

为了提高光电侦察瞄准系统目标跟踪对复杂环境的适应能力, 本文通过对系统组合导航、 惯性测量和视频图像等多维度参数信息的综合分析, 提出一种基于惯性测量与视频图像信息融合的智能目标跟踪策略, 提高目标跟踪的韧性和抗遮挡性能, 实现了全动态复杂场景高精度稳健自主跟踪。

1机载目标跟踪策略原理分析

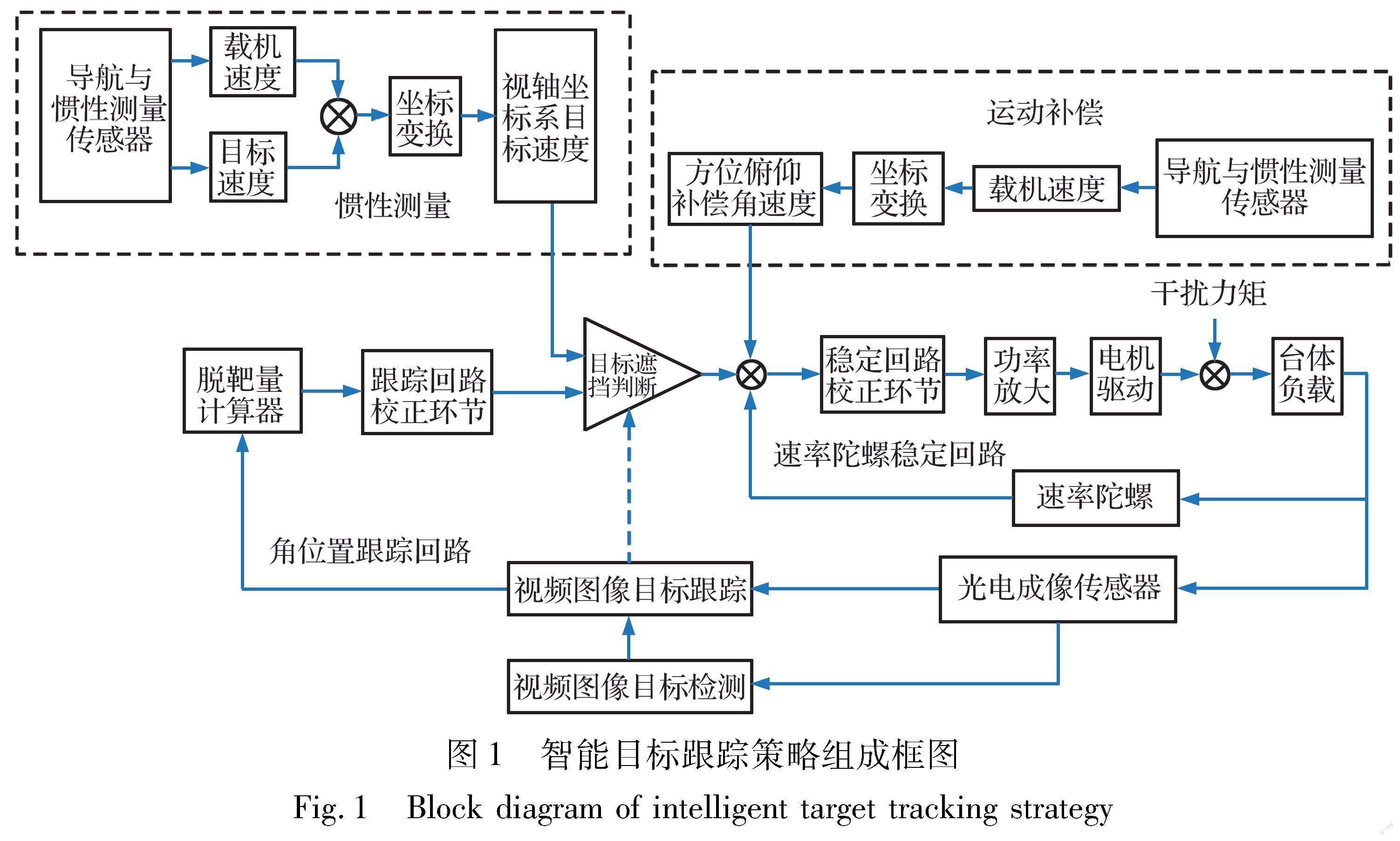

图1为智能目标跟踪策略的原理框图, 其主要由惯性测量、 运动补偿、 视频图像目标检测跟踪及伺服跟踪控制等功能单元组成。 本文提出一种多算法协同目标跟踪策略: 基于深度学习的智能目标检测算法[17], 实现多目标快速检测、 搜索区域目标自动捕获及失跟目标的搜索和再捕获; 基于改进型核相关滤波跟踪算法, 实现全动态复杂场景目标稳健跟踪和状态估计; 采用基于惯性测量的目标运动描述与瞄准线指向控制算法, 实现记忆跟踪, 提升目标跟踪抗干扰能力。

导航与惯性测量传感器获取载机大地坐标、 地理坐标系下的航姿角及速度参数, 稳定平台速率传感器获取目标跟踪过程中视轴指向姿态角和速度参数, 激光传感器获取目标距离。 综合以上信息解算目标在地理坐标系下的运动速度和方向, 对目标运动特性进行学习及轨迹描述, 解算载机与目标在视轴坐标系下的方位/俯仰方向的角速度信息, 输入伺服跟踪控制回路进行运动补偿和视轴指向控制[18]。 系统进入目标跟踪模式后, 智能目标检测算法进入目标检测和自动识别状态, 并自主捕获视场搜索区域目标, 识别确认目标身份后实施自动捕获跟踪。 视频图像跟踪算法实时解算目标图像坐标参数, 经处理形成的脱靶量参数输入伺服跟踪回路控制瞄准线随目标移动。 当遇到遮挡等干扰情况, 视频图像跟踪算法对跟踪状态进行评估并給出目标失跟提示, 自主进入记忆跟踪状态。 伺服跟踪系统基于学习得到的目标运动特性, 控制瞄准线随目标运动, 保证目标始终处于视场中心一定区域内。 同时, 视频图像跟踪算法转入目标搜索状态, 待再次检测捕获目标, 自主转入视频图像跟踪状态, 实现持久目标稳定跟踪。

1.1视频图像跟踪

光电成像传感器、 视频跟踪器及伺服控制器构成视频图像跟踪功能单元。 光电成像传感器采集目标区域图像信息, 经图像预处理及格式变换, 形成动态视频图像流输入视频图像跟踪器。 视频图像跟踪器进行目标搜索检测, 提取目标偏离视场中心像素坐标数据, 形成目标的脱靶量信息, 经图像校正处理后输出至伺服控制分系统, 驱动稳定平台视轴转动减小脱靶量, 以一定的跟踪控制率将目标稳定控制在视场中心, 实现目标的自主跟踪。

视频图像跟踪是基于初始帧图像目标位置, 预测后续帧图像中目标位置的过程。 主要由四个功能模块组成: 特征提取、 模型构建、 搜索策略和模板更新。 特征提取是实现目标跟踪的基础, 提取的目标特征应具有旋转、 尺度、 光照、 颜色、 亮度及对比度等变化的鲁棒性; 模型构建是实现检测跟踪的关键、 学习能力的体现, 模板更新机制(模型参数学习优化)是提高抗干扰的核心。

本文提出的视频图像跟踪算法是对相关滤波(KCF)跟踪算法[19]进行改进设计: (1)基于深度学习获取目标场景特征, 提高算法的鲁棒性和场景适应能力; (2)采用置信度和平均峰值能量比准则进行参数学习和模型优化, 提高目标跟踪的抗干扰性能。

KCF算法将目标跟踪转化为目标检测分类问题, 基于正则最小二乘分类器学习准则辨识目标, 基于循环移位采样和快速傅里叶变换技术, 利用傅里叶空间中循环矩阵可对角化性质, 解决稠密采样计算量问题, 显著降低样本训练和目标检测的运算复杂度。 通过核函数非线性映射, 将样本向量映射到高维特征空间, 显著提升分类器性能, 并且特征空间满足线性回归关系, 实现核空间的线性回归。 算法具有计算量小、 实时性强、 跟踪精度高, 以及复杂动态场景适应能力强等特点。

对于训练样本(xi, yi)和线性分类函数f(xi)=wTxi, 基于正则化风险最小分类器的损失函数为

式中:

采用梯度下降法求解, 可得模型参数w=(XTX+λE)-1XTy; 矩阵X=[x1, x2, …, xn], 每一列代表一个样本特征向量; y为列向量, 每个元素代表一个样本标签。 基于正则化线性模型表示定理, 并通过核函数非线性映射变换, 将样本向量映射到高维特征空间φ(x):

损失函数变换为

式中: 求偏导可得模型参数a=(K+λE)-1y; K=φ(X)φ(X)T, kij=φ(xi)Tφ(xj)为核函数矩阵; E表示单位矩阵; λ表示为正则化系数。

采用循环移位产生的目标区域图像作为分类器的训练样本, 生成训练样本矩阵。 对于测试样本Z=(z1, z2, …, zn), Kxz=φ(X)Tφ(Z)为循环矩阵, 降低计算复杂度, 利用其傅里叶变换可对角化的性质, 则有

算法迭代优化得到模型参数后, 对于输入帧图像, 利用已有的模型参数进行目标跟踪, 以上一帧图像中目标的检测位置为中心, 获取待跟踪图像区域。 通过核函数计算出待跟踪图像区域的响应图, 根据响应图中最大值所在的位置得到目标位置(如图2所示), 并更新模板参数。

当出现目标被遮挡等干扰场景时, 跟踪算法的特征响应图会出现多峰现象, 如图3所示。

针对多峰响应情况, 算法基于置信度和平均峰值能量比准则, 进行参数学习和模型优化, 提高目标跟踪的抗干扰性能和失锁估计精准度。 响应的最大值计算:

Fmax=maxF(s, l, w)(5)

式中: s, l, w表示目标图像的尺度、 响应图的长和宽。 平均峰值方差比计算:

式中: Fmax, Fmin, Fh, v分别表示响应图F(s, l, w)中最大、 最小以及h行v列的的响应值; Apvr值反映响应图的波动情况和检测目标的置信水平。 出现遮挡情况时, Apvr值会变小、 置信度下降。 采取的学习优化: 如果Fmax和Apvr的计算值大于其前序计算均值的β1和β2倍, 则当前的跟踪结果置信水平高, 模型参数以更新率η更新。 否则, 给出目标丢失标识Lott, 系统转入记忆跟踪通道, 视频跟踪进入目标搜索捕获状态:

1.2惯性测量跟踪

机载光电侦察瞄准系统目标跟踪分为手动跟踪和自动跟踪工作模式。 手动跟踪模式由操作人员控制系统视轴移动, 进行目标跟踪或场景凝视观测, 本文提出的智能目标跟踪策略引入基于惯性测量的运动补偿跟踪控制策略, 实现视轴指向稳定控制。

自动跟踪模式采用基于深度学习的智能目标检测算法对搜索区域目标进行检测和自主捕获, 基于深度神经网络构建目标模型, 按照一定的搜索策略在当前帧中进行搜索评估, 确定目标初始位置; 基于导航与惯性测量传感器获取的目标位置与运动参数信息, 构建目标的运动模型, 融入目标搜索策略, 辅助视轴指向控制, 实现高效目标搜索。 视频图像跟踪过程中, 出现目标被遮挡等干扰场景时, 跟踪控制系统收到视频跟踪算法给出的失跟信息后, 自主转入基于目标运动测量的记忆跟踪状态, 控制瞄准线随目标运动, 直至目标再次捕获。

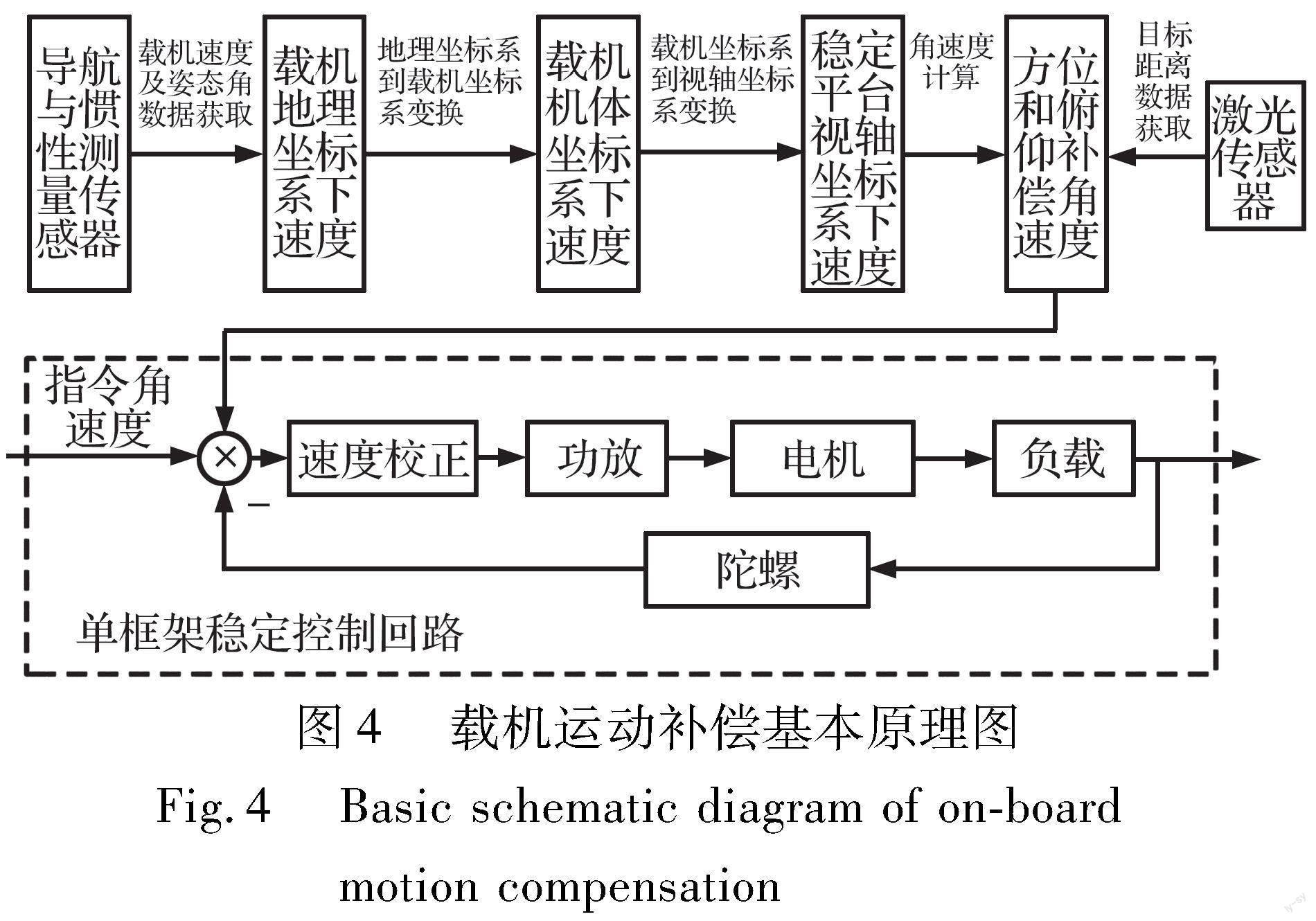

1.2.1基于载机运动补偿的视轴指向控制

载机飞行过程中, 光电侦察瞄准系统稳定平台隔离载机振动及姿态运动, 但载机飞行运动会引起视轴移动导致目标失跟, 同时视轴移动也会影响目标搜索与场景凝视侦测效能。 本文提出在跟踪控制回路中增加视轴指向运动补偿算法, 实现目标跟踪视轴指向稳定。 如图4所示。

算法基于导航与惯性测量传感器获得的载机飞行速度和航姿角信息, 通过坐标变换解算视轴坐标系下的速度, 基于激光传感器获取的目标距离信息, 解算目标相对稳定平台视轴的方位/俯仰角速度, 对场景运动进行补偿, 实现视轴指向稳定。

式中: ωz为方位角速度; ωy为俯仰角速度。 以ωz和ωy分别作为稳定平台方位和俯仰控制回路的输入, 实现载机的运动补偿。

1.2.2基于目标运动测量的记忆跟踪

基于组合惯导传感器和稳定平台姿态测量参数, 光电侦察瞄准系统不仅能实现目标定位和运动补偿等功能, 还可以对目标运动跟踪测量, 获取目标速度、 运动方向和运动轨迹信息, 在跟踪目标遇到被遮挡等干扰状况, 导致目标跟踪丢失时, 实施记忆跟踪策略, 维持对目标的跟踪。 其工作原理如图5所示。

基于目标运动测量获取的地理坐标系下目标运动速度, 解算出光轴坐标系下目标运动角速度。 以该角速度作为前馈输入伺服跟踪控制回路, 在视频图像跟踪算法给出失跟信息后, 算法自主断开视频跟踪通道, 进入记忆跟踪通道, 控制视轴指向随预测的目标运动轨迹转动, 实现被跟踪运动和静止目标的记忆跟踪, 如图6所示。

激光测照器获取目标距离D, 则目标相对平台的角速度ω为

ω=ωzωy=Cωv·vot=01/D0001/Dvot (15)

式中: ωz为方位角速度估计; ωy为俯仰角速度估计。 在目标被遮挡时, 以此角速度估计值作为平台稳定回路的角速度输入, 实现对目标的记忆跟踪。

2仿真分析与飞行测试

由图1可知, 本文提出的智能抗遮挡目标跟踪策略主要由载机运动补偿、 记忆跟踪、 智能目标检测与视频跟踪等多算法构成。 本节对记忆跟踪及运动补偿性能、 目标检测与视频跟踪性能进行仿真分析, 并给出飞行试验结果。

2.1记忆跟踪及运动补偿性能仿真分析

光电侦察瞄准系统对目标进行记忆跟踪的基本原理

其中, 组合惯导传感器安装偏差角(ε、 ψ、 θ)作为系统误差可通过标定进行校准补偿。 由式(8), (10), (12)~(15)计算坐标变换与误差传递模型:

根据误差函数传递理论[20], 当上述直接测量参数相互独立时, 视轴指向转动角速率误差可以表示为

如果抗遮挡时间为t, 则在遮挡时间内产生的角度误差Δθ为

式(16)~(19)给出了记忆跟踪误差的理论模型。

记忆跟踪补偿角速度用到的参数及误差分布如表1所示, 这些参数的误差决定了记忆跟踪和运动补偿精度。 在视频跟踪状态下, 伺服控制系统工作在载机运动补偿模式。

采用蒙特卡罗法进行记忆跟踪误差仿真计算, 其原理是利用计算机产生同分布随机数模拟表1中误差量叠加到相应测量值中, 以概率统计来模拟系统中的不确定因素进行仿真计算。 设载机飞行高度为5 km, 飞行速度为200 km/h, 地面目标运动速度为100 km/h, 目标距离D≤10 km, 抗遮挡记忆跟踪时间为5 s, 视轴方位角a在0°~360°内, 俯仰角b在-60°~60°(向下为0°)内, 目标和载机相对位置在上述角度范围内随机生成, 测量误差根据表1用蒙特卡罗法生成随机误差序列后代入计算模型, 进行记忆跟踪仿真, 得到方位、 俯仰跟踪误差如图7所示。

由图7可知, 记忆跟踪误差的分布在接近零中心区域概率越大, 边缘区域概率越小, 服从正态分布, 误差的期望E(Δθy), E(Δθz)和标准差σ(Δθy), σ(Δθz)统计结果如下:

設成像系统视场角为(α, β), 像素分辨率为(m, n), 跟踪搜索区大小为(p, q), 则重捕获时允许的最大记忆跟踪误差为Δθmax为

系统的可见光视场为1.1°×0.6°, 分辨率为1 920×1 080, 红外视场为1.1°×0.88°, 分辨率为640×512, 跟踪搜索区为288×228, 上述参数代入式(21)得到可见光重捕允许最大误差为(0.17°, 0.13°), 红外重捕允许最大误差为(0.5°, 0.39°), 均大于记忆跟踪误差3σ(Δθy)和3σ(Δθz)值。 表明遮挡结束后, 目标仍保持在视频跟踪算法的搜索区域内, 能够可靠重新捕获目标。

2.2视频图像跟踪性能仿真分析

光电成像传感器、 视频跟踪器、 伺服控制及稳定平台结构构成光电侦察瞄准系统闭环跟踪系统。 基于光电成像传感器与视频跟踪器获取的目标脱靶量, 驱动稳定平台以一定的角速度跟踪系统瞄准线, 并达到所要求的稳态和动态性能指标。 影响伺服系统性能的主要因素是跟踪回路系统的带宽和开环增益等。

伺服跟蹤控制系统采用双环设计, 内环为角速率稳定回路, 外环为角位置跟踪回路。 采用误差反馈+前馈速度补偿控制算法[21]提高系统跟踪精度, 如图8所示。

由于图像跟踪器误差信号输出通常有至少一帧的延迟, 带来开环放大系数下降, 开环截止频率和系统带宽变小, 导致跟踪精度降低, 采用视频延时自适应补偿及前馈补偿技术, 提升控制系统带宽。 设载机飞行高度为5 km, 飞行速度为200 km/h, 建立数学仿真模型如图9所示, 方位和俯仰跟踪误差仿真结果如图10所示。

在该飞行条件下, 方位跟踪误差小于74 μrad, 俯仰跟踪误差小于84 μrad, 可以满足目标测量定位和瞄准引导的应用需求。

2.3跟踪抗干扰能力飞行测试

本文提出的智能目标跟踪策略装载于某型机载光电侦察瞄准系统, 对跟踪策略的环境适应性及抗干扰能力进行了飞行试验测试。 载机飞行高度5 km, 飞行速度200 km/h, 对公路上行驶的车辆进行自动跟踪能力测试, 车辆行驶速度为100 km/h。 选择具有高架桥梁的公路区域, 并且在公路上相隔一定距离设置相似目标(同型车辆)、 烟雾释放装置等干扰场景, 如图11所示。

载机飞行到达A点(距目标区域约10 km左右)前调节可见光或者红外传感器调整到合适的视场清晰成像, 并启动智能目标检测模式, 对公路上的车辆进行智能检测并自主捕获目标, 进入自动跟踪模式。 跟踪中的目标车辆分别在C, E, F点开始行驶穿过烟雾遮挡区域、 相似目标干扰区域和高架桥梁。

在车辆自动跟踪中, 智能跟踪模块实时获取目标距离参数、 载机位置、 航姿角及瞄准线指向参数, 解算出车辆行驶速度和方向, 并对车辆运动特征进行学习记忆。 当车辆进入干扰区域(穿越烟雾、 车辆和高架桥遮挡)时, 视频跟踪算法自主给出失跟标识, 并转入记忆跟踪模式; 待车辆穿出干扰区域, 视频跟踪算法智能搜索检测并自动捕获跟踪车辆。

试验设置不同航线、 不同场景对可见光和红外传感器成像目标进行自动跟踪及抗干扰能力测试。 经过多个飞行架次的试验结果表明, 基于本文提出的智能目标跟踪策略能够有效对抗相似目标、 烟雾及桥梁遮挡等干扰, 实现全动态复杂环境条件下的目标稳健持久跟踪。 图12给出了车辆穿行、 烟雾及桥梁遮挡干扰情况下目标跟踪视频截图。

3结束语

“物竞天择、 适者生存”。 为了提高光电侦察瞄准系统在复杂环境下自主目标跟踪能力, 提升光电侦察瞄准系统对武器体系贡献率和作战效能, 必须提升系统的智能化, 智能化发展是光电侦察瞄准系统的必然趋势。

随着任务需求发展、 技术进步及小型化设计能力提高, 光电侦察瞄准系统集成的传感器种类和数量愈来愈多, 能够获取目标场景及系统状态信息的数据愈来愈丰富。 如何对获取的异构多源信息进行有效的综合处理和分析归纳, 形成对目标场景变化规律及环境态势的认知, 进而自主生成最佳目标跟踪策略, 是提升系统智能化的关键。 本文提出的基于多源信息综合、 多算法协同的智能目标跟踪策略, 有效提升了系统在“全动态场景运动目标的快速检测捕获、 持久韧性跟踪、 目标被干扰遮断时视轴指向稳定及目标出现后再捕获”等方面的性能, 提升了系统使用效能。

图12目标跟踪抗干扰飞行试验视频截图

Fig.12Antijamming flight test results of intelligent target tracking strategy

机器学习是指从有限的观测数据中学习出具有一般性的规律, 并利用这些规律对未知数据进行预测的方法。 机器学习[22-23]已成为当前系统智能化技术研究的主要方向, 其成功的先决条件是“大数据、 好算法、 强算力”。 对于机载光电侦察瞄准系统应用领域, 存在“用于训练的样本数据少、 算法实时性要求高、 系统尺寸重量小”等约束条件, 小样本学习能力、 算法泛化迁移能力、 在线自主学习能力、 低复杂度高效算法、 超算力AI片上系统等已成为系统智能化发展的关键技术。

参考文献:

[1] Bolme D S, Beveridge J R, Draper B A, et al. Visual Object Tracking Using Adaptive Correlation Filters[C]∥ Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 2544-2550.

[2] Henriques J F, Caseiro R, Martins P, et al. Exploiting the Circulant Structure of TrackingbyDetection with Kernels[C]∥12th European Conference on Computer Vision, 2012: 702-715.

[3] Henriques J F, Caseiro R, Martins P, et al. HighSpeed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[4] Galoogahi H K, Fagg A, Lucey S. Learning BackgroundAware Correlation Filters for Visual Tracking[C]∥International Conference on Computer Vision, 2017: 1144-1152.

[5] Li Y, Zhu J K. A Scale Adaptive Kernel Correlation Filter Tracker with Feature Integration[C]∥European Conference on Computer Vision, 2014: 254-265.

[6] 张微, 康宝生. 相关滤波目标跟踪进展综述[J]. 中国图象图形学报, 2017, 22(8): 1017-1033.

Zhang Wei, Kang Baosheng. Recent Advances in Correlation FilterBased Object Tracking: A Review[J]. Journal of Image and Graphics, 2017, 22(8): 1017-1033.(in Chinese)

[7] 葛宝义, 左宪章, 胡永江. 视觉目标跟踪方法研究综述[J]. 中国图象图形学报, 2018, 23(8): 1091-1107.

Ge Baoyi, Zuo Xianzhang, Hu Yongjiang. Review of Visual Object Tracking Technology[J]. Journal of Image and Graphics, 2018, 23(8): 1091-1107.(in Chinese)

[8] 黄巍, 袁亮, 张建杰, 等. 抗遮挡与尺度自适应的长时间目标跟踪算法[J]. 电光与控制, 2021, 28(10): 44-48.

Huang Wei, Yuan Liang, Zhang Jianjie, et al. An AntiOcclusion and ScaleAdaptive LongTime Target Tracking Algorithm[J]. Electronics Optics & Control, 2021, 28(10): 44-48.(in Chinese)

[9] Wang M M, Liu Y, Huang Z Y. Large Margin Object Tracking with Circulant Feature Maps[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4800-4808.

[10] Danelljan M, Robinson A, Shahbaz Khan F, et al. Beyond Correlation Filters: Learning Continuous Convolution Operators for Visual Tracking[C]∥European Conference on Computer Vision, 2016: 472-488.

[11] Danelljan M, Bhat G, Khan F S, et al. ECO: Efficient Convolution Operators for Tracking [C]∥ IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6638-6646.

[12] Ma C, Huang J B, Yang X K, et al. Hierarchical Convolutional Features for Visual Tracking[C]∥International Conference on Computer Vision, 2015: 3074-3082.

[13] Cui Z, Xiao S T, Feng J S, et al. Recurrently TargetAttending Tracking[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1449-1458.

[14] Bertinetto L, Valmadre J, Henriques J F, et al. FullyConvolutional Siamese Networks for Object Tracking[C]∥European Conference on Computer Vision, 2016: 850-865.

[15] 孟琭, 楊旭. 目标跟踪算法综述[J]. 自动化学报, 2019, 45(7): 1244-1260.

Meng Lu, Yang Xu. A Survey of Object Tracking Algorithms[J]. Acta Automatica Sinica, 2019, 45(7): 1244-1260.(in Chinese)

[16] 陈旭, 孟朝晖. 基于深度学习的目标视频跟踪算法综述[J]. 计算机系统应用, 2019, 28(1): 1-9.

Chen Xu, Meng Zhaohui. Survey on Video Object Tracking Algorithms Based on Deep Learning[J]. Computer Systems & Applications, 2019, 28(1): 1-9.(in Chinese)

[17] Ren S Q, He K M, Girshick R, et al. Object Detection Networks on Convolutional Feature Maps[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(7): 1476-1481.

[18] 羅勇. 基于信息融合的运动平台光电跟踪控制技术研究[D]. 成都: 中国科学院大学(中国科学院光电技术研究所), 2019.

Luo Yong. Information Fusion Based Research on OptoElectronical Tracking Control on Moving Platform[D]. Chengdu: Institute of Optics and Electronics, Chinese Academy of Sciences, 2019. (in Chinese)

[19] Yao R, Xia S X, Shen F M, et al. Exploiting Spatial Structure from Parts for Adaptive Kernelized Correlation Filter Tracker[J]. IEEE Signal Processing Letters, 2016, 23(5): 658-662.

[20] 袁峰, 李凯, 张晓琳. 误差理论与数据处理[M]. 2版. 哈尔滨: 哈尔滨工业大学出版社, 2020: 77-85.

Yuan Feng, Li Kai, Zhang Xiaolin. Error Theory and Data Processing[M]. 2nd ed. Harbin: Harbin Institute of Technology Press, 2020: 77-85.(in Chinese)

[21] 吕明明, 侯润民, 柯于峰, 等. 光电跟踪平台脱靶量滞后补偿方法[J]. 西安交通大学学报, 2019, 53(11): 141-147.

Lü Mingming, Hou Runmin, Ke Yufeng, et al. Compensation Method for Miss Distance TimeDelay of ElectroOptical Tracking Platform[J]. Journal of Xian Jiaotong University, 2019, 53(11): 141-147.(in Chinese)

[22] 邱锡鹏. 神经网络与深度学习[M]. 北京: 机械工业出版社, 2020: 171-175.

Qiu Xipeng. Neural Networks and Deep Learning[M]. Beijing: China Machine Press, 2020: 171-175.(in Chinese)

[23] 张学工, 汪小我. 模式识别: 模式识别与机器学习[M]. 北京: 清华大学出版社, 2021.

Zhang Xuegong, Wang Xiaowo. Pattern Recognition: Pattern Recognition & Machine Learning[M]. Beijing: Tsinghua University Press, 2021.(in Chinese)

Application Research on AntiOcclusion Target Tracking Strategy Based on IMU and Video Image Information Synthesis in Airborne ElectroOptical Reconnaissance and Aiming System

Ji Shupeng1,2, Liu Zhiguang2*, Qu Jifeng2, Xu Jianzheng2, Li Tonghai2

(1. China Airborne Missile Academy, Luoyang 471009, China;2. CAMA (Luoyang) Measurements & Controls Co. Ltd, Luoyang 471009, China)

Abstract: Target tracking is a core working mode of airborne photoelectric reconnaissance and aiming system, and its performance directly determines the mission efficiency of the airborne system. Aiming at the outstanding problems and technical difficulties in the application of target tracking, according to the multisensor configuration and application characteristics of the system, an intelligent target tracking strategy based on inertial measurement and video image information fusion is proposed, which integrates multidimensional information such as inertial navigation, motion measurement, servo control, geography and image coordinates. Simulation analysis and flight test show that the strategy can effectively improve the antijamming performance of target tracking, realize the robust and persistent target tracking in full dynamic complex scenes, and improve the combat ability of reconnaissance and surveillance, target positioning, weapon guidance of the airborne system.

Key words: photoelectric reconnaissance and aiming system; information fusion; inertial measurement; video image; deep learning; target tracking; antiocclusion; intelligent