结合仿真迁移学习和自适应融合的无人机小目标检测

2023-08-29郑华飞蒋鸿宇郭有为

陈 蕊,郑华飞,蒋鸿宇,郭有为

1(中国工程物理研究院 研究生院,四川 绵阳 621999)

2(中国工程物理研究院 电子工程研究所,四川 绵阳 621999)

1 引 言

近年来,无人机在农业、工业、军事等领域得到广泛应用,虽然给生产生活带来了很多便利,但是也带来了极大的安全隐患,例如非法侵入、非法投递、间谍飞行等现象频频发生,因此,对无人机的目标检测与识别的技术研究一直在飞速发展.目前,无人机的目标检测技术普遍基于深度学习目标检测算法[1].虽然深度学习方法在通用物体检测方面取得了很大进步,但一些常见的目标检测模型如 Fast R-CNN[2]、Faster R-CNN[3]、SSD[4]、YOLO[5]和RetinaNet[6]在小目标检测任务中仍然表现不佳,典型任务包括例如无人机检测[7]、行人检测[8]、交通标志检测[9]等.目前最新算法模型在小目标上检测的平均精度(APs)仅为43.9%[10],其中“小目标”的定义(像素大小在[0,322]范围内)参考 MS COCO 数据集[11].

基于深度学习的小目标检测性能不佳主要有两个原因.一个原因是监督数据的数量有限,深度学习算法需要大量数据支撑,在具有足够的训练样本条件下才可能很好地收敛,但是在实际情况中往往无法收集到充足的有监督数据.以无人机为例,收集数量足够多、内容足够丰富的无人机目标图像数据,不仅需要持证的专业飞手在多种复杂环境中驾驶无人机,还需要多种型号、款式的无人机,以及高清摄像头、手持云台等专业摄录设备,成本十分高昂.此外,在收集到无人机目标图像数据之后,仍然需要大量的工作进行人工标注.另一个原因是图像中无人机目标的尺寸较小,小目标的特征在通过卷积网络等神经网络层时逐渐稀疏甚至消失.通用目标检测算法的多尺度特征学习仅适用于数据集目标大小分布均匀的情况,而无人机数据集受到无人机各个尺度和拍摄视角的影响,其目标大小分布往往是不平衡的,这导致检测器在无人机小目标上性能不佳.目前,进行数据增强和改进多尺度特征学习是小目标检测器中广泛使用的方法,例如Kisantal等人[12]提出了一种数据增强方法,即对包含小目标的图像进行过采样并多次复制粘贴小目标;Deng 等人[13]提出了扩展特征金字塔网络(EFPN),它引入了一个专门用于小目标检测的超高分辨率金字塔模块;马跃等人[14]提出将SSD模型中深层特征图分段进行分段反卷积并与浅层特征图融合以增强小目标在模型下的检测效果.

基于以上分析,本文从数据增强以及多尺度特征学习两个方面改进无人机小目标检测.为解决监督数据稀缺问题,首先,本文从互联网上收集21,803张包含无人机目标的真实图像数据,并花费了大量人力资源进行标注,以构建用于训练和测试的真实数据集.此外,基于AirSim和Unreal Engine 4(UE4)搭建的仿真平台,本文构建了一个涵盖8个场景和4个常见无人机模型的仿真无人机数据集,以辅助模型训练.然而,真实数据和仿真数据之间存在数据分布差异,因此本文引入模型参数知识迁移的迁移学习方式来减小数据分布差异带来的负面影响.实验表明,与直接在真实数据集上训练的YOLO v5模型相比,通过迁移学习得到的模型在APs上实现了2.7%的增长,证明了基于仿真数据增强的迁移学习方法有利于提升深度学习模型在无人机小目标检测任务上的性能.此外,为了解决无人机目标尺度较小导致的特征稀疏或消失问题,本文修改了YOLO v5模型的网络结构并引入了一种自适应特征融合机制,旨在将浅层和深层特征更好地融合到神经网络的颈部(neck)模块中,使模型更好地适应无人机小目标检测场景.实验结果表明,与基准YOLO v5相比,引入自适应融合的模型在APs上获得了6.2%的提升,证明了适当抑制深层特征的传播有利于提升小目标的检测性能.最后,通过实验表明,基于仿真迁移学习和自适应融合机制相结合的方法,与基准YOLO v5相比,获得了7.2%的性能提升.

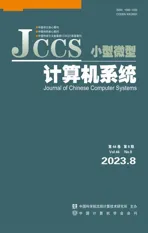

本文工作的贡献如图1所示,可以总结如下:

图1 本文提出的方法说明

1.构建并公开发布两个数据集:真实数据集(RD)和仿真数据集(SD).真实数据集(RD)由互联网上收集的图像组成并人工标注.仿真数据集(SD)由仿真平台生成的高保真无人机小目标图像数据组成,涵盖了丰富的飞行环境和无人机模型,旨在减轻对稀缺真实数据的依赖;

2.引入迁移学习,通过迁移从仿真数据(源域)中学习到的一般知识,减小由仿真数据与真实数据的数据分布差异带来的负面影响,即使在真实数据资源不足的情况下,也能提高真实数据(目标域)的性能;

3.在YOLO v5神经网络中引入自适应融合机制,提出了一种新的深度神经网络模型AF-YOLO.改进后的模型实现了浅层特征和深层特征的更好融合.

2 相关工作

针对本文工作所提出的3点贡献,相关工作将在无人机小目标检测数据集、迁移学习和多尺度特征融合3个方面分别进行阐述.

2.1 无人机小物体检测数据集

虽然目前学术界已发布较多的面向通用目标检测的数据集,例如MS COCO、PASCAL VOC[15]、ImageNet[16]等.但针对无人机目标的数据集较为少见,更多情况是无人机作为一个目标类别出现在某些通用数据集中,例如,TrackingNet[17]是一个包含无人机目标的通用目标跟踪数据集,其中包含从 YouTube-BB 数据集[18]中选取的 30,511 段视频流.然而,无人机目标在TrackingNet中仅占5%.LaSOT[19]是另一个用于通用目标检测和跟踪的视频数据集,手动收集的 1400 段视频中,只有 20 段包含无人机目标,且这些视频流大多为中型或大型目标.USC数据集[20]是一个专用于无人机检测和跟踪数据集,包含在USC校园拍摄的30段视频流.虽然USC数据集的视频是在多种背景中拍摄的,但只使用了一台无人机,总体上还是缺乏一定的数据多样性.此外,上述3个数据集存在一个共同问题:无人机目标的大小分布不均匀,并非专门面向无人机小目标.

本文利用两个方法来应对无人机小目标检测数据集缺乏的问题.首先,通过互联网搜索引擎搜索相关图像或从其他视频跟踪数据集(例如 USC 数据集)中筛选图像,并进行人工标注.其次,应用AirSim(1)https://microsoft.github.io/AirSim/和UE4(2)https://www.unrealengine.com/搭建的仿真平台来生成覆盖各种场景和无人机模型的高保真图像.为促进无人机小目标检测的技术研究,两类数据均已公开发布(3)https://github.com/mlcaepiee/SimUAV.

2.2 迁移学习

在监督学习的大多数任务中,往往假设训练(假设数据分布为P)和推理(假设分布为Q)期间使用的数据服从近似的分布(即P≈Q).然而,在实际中两类数据往往具有不同的分布(P≠Q).迁移学习试图解决源域数据(训练数据)与目标域数据(推理或测试数据)的分布差异问题,研究如何利用源域数据和目标域数据来训练适合目标域的模型.

通常情况下,源域中的数据相对容易获取,目标域中的数据则相对缺乏.相比较于传统的机器学习任务,迁移学习是利用以往任务中学出的“知识”,比如数据特征、模型参数等,来辅助目标域任务的学习.根据所迁移的“知识”内容可将迁移学习的方法大致分为4类[21]:

1.实例知识迁移,即使用源域数据辅助目标域数据进行模型训练,例如将源域中与目标域数据使用相同的特征和标签的数据进行加权后与目标域的数据一起用于模型训练[22];

2.特征表示知识迁移,即将源域所提取到的有利的特征表示(常为低维特征表示)进行迁移,以最小化源域与目标域的差异,并减小模型分类回归误差;

3.模型参数知识迁移,即当源任务与目标任务所使用的模型存在共享参数或相似的超参数先验分布时,直接对共享的参数或先验知识进行迁移;

4.相关性知识迁移,即将源域与目标域数据的相关性迁移到目标域.

目前,迁移学习已经应用于动作识别[23]、视觉分类[24]、情感分析[25]和图像融合[26]等多个领域.Yosinski等人[27]证明了神经网络的前3层所提取到的特征基本为通用特征,进行迁移的效果比较好;另一方面,Yosinski等人还证明了采用迁移学习的深度神经网络的效果优于对网络参数进行随机初始化,同时迁移学习还可以加速网络的学习和优化.

本文采用模型参数知识迁移的方法,将从仿真数据集中学习到的共享参数迁移到真实数据集的学习过程中,加快深度神经网络模型在少量真实数据集上的学习和收敛,从而减少对于大量真实数据的依赖.

2.3 多尺度特征融合

在深度神经网络模型检测目标过程中,不同阶段(不同网络层级)的特征图代表不同层次的抽象信息.浅层特征图的感受野小,但位置和边缘信息丰富,有利于小目标检测;深层特征图具有较大的感受野和丰富的语义信息,适用于检测较大的目标.因此,融合不同阶段的特征图来提高多尺度(大、中、小多种尺度)目标检测的性能.自2017年提出特征金字塔网络(FPN)[28]以来,各种检测器都加入了特征融合的过程,引入了不同的算法进行特征融合.路径聚合网络(PANet)[29]引入了一种基于 FPN 的自底向上的路径增强;多级特征金字塔网络(MLFPN)[30]首先使用细化的U形模块和特征融合模块提取更具代表性的多层和多尺度特征,然后使用尺度特征聚合模块融合多层特征;双向FPN(Bi-FPN)[31]实现了自顶向下和自底向上的特征融合,并在特征融合阶段引入了权重.

针对无人机小目标检测任务,本文通过将自适应融合机制引入YOLO v5网络模型中实现多尺度特征融合,有效抑制了对大目标敏感的深层特征的传播,使模型更加适应无人机小目标检测.

3 原理与方法

3.1 问题定义

基于传统的目标检测任务定义,本文给出了无人机小目标检测任务的描述:判断输入图像中是否存在无人机的小目标实例,如果存在,则输出每个无人机实例在图像中的空间位置以及边界框(bounding box),空间位置使用(x,y)表示,边界框使用(w,h)表示.其中,“小目标”是指在640×640的图像中每个无人机实例的边界框大小不大于32×32像素.

3.2 数据生成

对于大多数数据驱动的深度学习算法来说,数据集起着重要的作用.如上文所述,通常难以获得足够规模的无人机小目标数据集.为此,本文构建了两类数据集:真实无人机数据集和仿真无人机数据集.真实数据集由从互联网收集到的部分视频流或图像组成;仿真数据集则是本文利用仿真平台生成的.

3.2.1 真实数据集

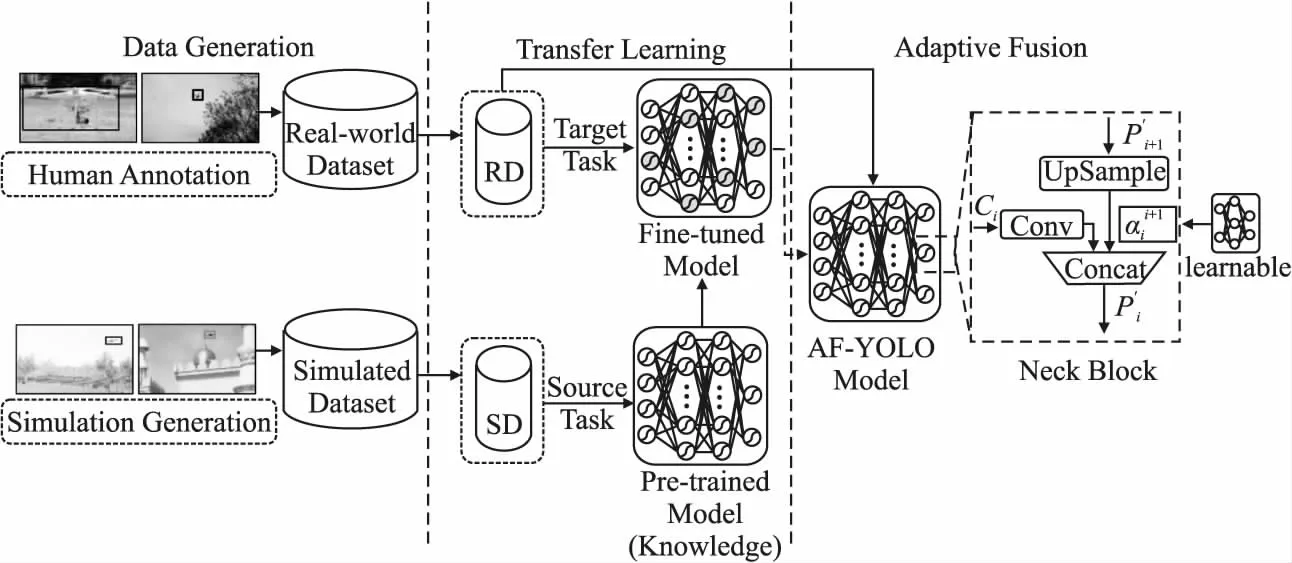

本文构建了一个包含21,803张图像的真实无人机数据集,包括来自USC数据集的17,853张图像以及来自Amateur Unmanned Air Vehicle Detection Dataset数据集的2,863 张图像[32]和Kaggle Drone Dataset数据集[33]的1,087 张图像,并人工完成所有图像的数据标注.图2(a)展示了真实数据集中的若干示例图像.

图2 真实数据集的示例,仿真所用无人机模型及仿真数据集示例

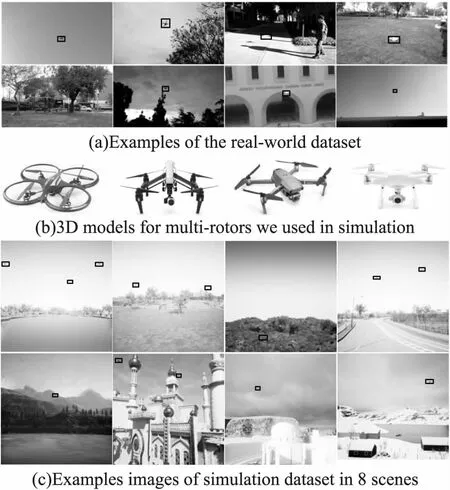

由于图像的收集和搜索目标大小不可限定,因此无法保证真实数据集的目标尺寸符合“小目标”的条件.图3(a)为真实数据集中无人机目标大小的分布情况,其中小目标(像素≤322)占53.5%,但同时大目标(像素≥962)也占据一定比例.针对无人机小目标检测,本文从真实数据集中筛选出一部分仅包含小目标的图像,作为评估模型效果的测试数据集.

图3 真实数据集中的目标大小分布情况与仿真数据集中的虚拟场景和无人机模型分布

3.2.2 仿真数据集

本文应用基于AirSim和UE4的仿真平台生成无人机小目标仿真图像数据集.AirSim是微软开源的一个跨平台的多旋翼无人机模拟器,可实现无人机飞行过程中精确的物理和动力学模拟,UE4虚拟引擎可实现复杂飞行环境的渲染.该仿真平台可实现在逼真的虚拟环境中以各种速度和指定路径飞行无人机,并进行数据采集和存储.仿真数据集共包含29,568张图像,涵盖8个虚拟场景和4种多旋翼无人机3D模型.图3(b)展示了不同场景和无人机模型的比例.图2同时展示了仿真数据集的若干示例以及所使用的4种无人机3D模型,其中,图2(b)为无人机3D 模型示例,图2(c)为在8个虚拟场景中的示例图像.

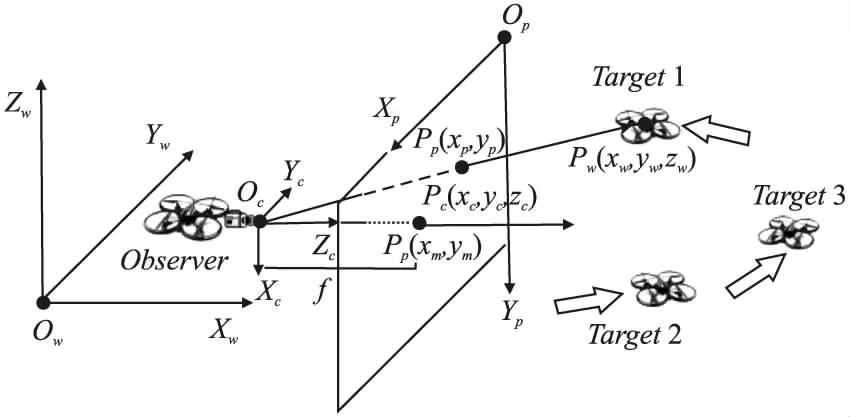

如图4所示,在仿真实现方法中,仿真平台创建4台多旋翼无人机模型放入虚拟环境中,一台无人机作为观察者(Observer),可使用机载摄像头进行图像数据采集,其他4台作为靶机(Target)在观察者的机载摄像头光电探测范围内飞行.当飞行距离合适时,靶机将被观察者的机载摄像头捕获并生成无人机小目标图像数据.

图4 仿真方法:观察者用机载摄像头拍摄靶机过程

在生成无人机小目标图像时,仿真平台利用靶机和机载摄像头的位姿计算出每张图像中靶机的标签,即靶机在图像中的空间位置和边界框,由此完成图像数据的自动标注.以图4中的靶机Target1为例,计算其坐标涉及到3个坐标系:世界坐标系、相机坐标系和像素坐标系,分别用OwXwYwZw、OcXcYcZc和OpXpYp表示,则Target1在3个坐标系中的位置分别表示为Pw(xw,yw,zw)、Pc(xc,yc,zc)和Pp(xp,yp).其中,Pp(xp,yp)即靶机在无人机小目标图像中的空间位置,可以通过以下公式(1)和公式(2)计算:

(1)

其中R∈{R|RTR=I3,det(R)=1}是相对于从OwXwYwZw到OcXcYcZc的旋转矩阵,t是平移向量,即机载摄像头在世界坐标系中的位置(R和t可以通过 AirSim 提供的API获得).

(2)

其中f为机载摄像头的焦距,Pp(xm,ym)是像素坐标系的中心位置,例如Pm(320,320)是640×640图像的中心位置.利用同样的方法,也可以计算出靶机在图像中的边界框.

综上,本文通过仿真平台生成了涵盖丰富飞行环境和无人机模型的图像数据并实现了自动标注.

3.3 迁移学习

3.3.1 YOLO v5模型介绍

YOLO v5(4)https://github.com/ultralytics/yolov5为开源目标检测架构和模型,具有优秀的检测精度和推理速度,代表目前目标检测领域中的杰出水准.YOLO v5包含3个部分,其中Backbone部分从输入图像中提取丰富的信息特征,Neck部分生成特征金字塔以对特征进行进一步处理与利用,最后Head部分进行分类与定位.YOLO v5的损失函数包含了分类损失(classification loss)、定位损失(localization loss)和置信度损失(confidence loss)3类,总体的损失即为以上3类的加权相加,通过改变权值可以调整对3类损失的关注度.其中,分类损失函数采用BCE loss二分类交叉熵损失函数:

(3)

LGIoU=1-GIoU

(4)

其中GIoU可由下式得出:

(5)

其中,A、B为两个边界框,C为其对应的最小凸集(包围A、B的最小包围框),IoU(Intersection over Union)[15]为A和B的交并比.置信度损失函数与分类损失函数形式类似.

3.3.2 模型参数知识迁移

由于仿真数据和真实数据之间存在一定的数据分布差异,这种差异广泛体现在背景、光影、材质、视角、无人机模型等方面,如果同时使用真实数据集和仿真数据集进行模型训练并在真实数据集进行测试,这种差异必然对检测器的泛化性产生一定影响,即使模型产生泛化误差.因此,需要尽可能减小模型的仿真数据(源域)误差和真实数据(目标域)误差之间的差异.

本文采用模型参数知识迁移的迁移学习方式,以减小模型的泛化误差,并尝试降低模型对大量真实数据的依赖.具体来说,本文首先将丰富的仿真数据作为辅助训练样本,对YOLO v5目标检测模型进行预训练,从而使模型获得无人机小目标检测的通用特征抽取能力;其次,将该预训练模型及参数权值作为在真实数据集上的初始化模型和初始参数重新进行训练,对比在真实数据集进行参数随机初始化训练,参数知识迁移使模型更快收敛,并能更好地识别真实图像的无人机小目标.本文在实验部分设计了多组对比实验,验证了迁移学习可有效提高模型精度并降低对大量真实数据的需求.

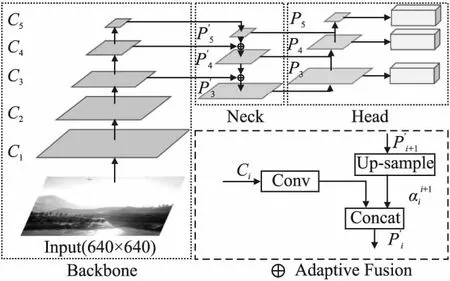

3.4 自适应特征融合

参考3.3.1节的YOLO v5模型结构,PANet已经集成到YOLO v5模型的Neck模块,用于实现不同层次的特征融合.

由于融合不同层特征的方式决定了目标检测的性能,本文基于YOLO v5模型结构,提出了一种AF-YOLO网络模型,该模型引入了自适应融合机制(Adaptive Fusion)来控制深层和浅层特征之间的融合程度.如图5所示,P′5,P′4,P′3表示自顶向下路径生成的不同特征图.P3,P4,P5表示路径聚合生成的特征图并与P′3,P′4,P′5相对应.在图5中右下部分,详细展开了自适应融合机制原理,该机制将Ci的自顶向下卷积特征和P′i+1经过2倍上采样之后的特征融合在一起,P′i由以下公式给出:

图5 AF-YOLO 网络模型

(6)

4 实验与结果分析

在本节中,首先介绍了各实验所用到的数据集的划分和对各模型性能进行评估时所采用的统一评估标准.其次,为了验证仿真数据集的有效性,本文设置了多组实验对真实数据集和仿真数据集进行评估对比.最后,本文进一步通过实验证明了模型参数知识迁移学习和自适应融合机制对于无人机小目标检测性能的显著提升.本文使用YOLO v5模型作为基准,基于Pytorch实现,训练时参数epoch和batch size分别设置为200和16.

4.1 数据集与评估标准

4.1.1 数据集划分

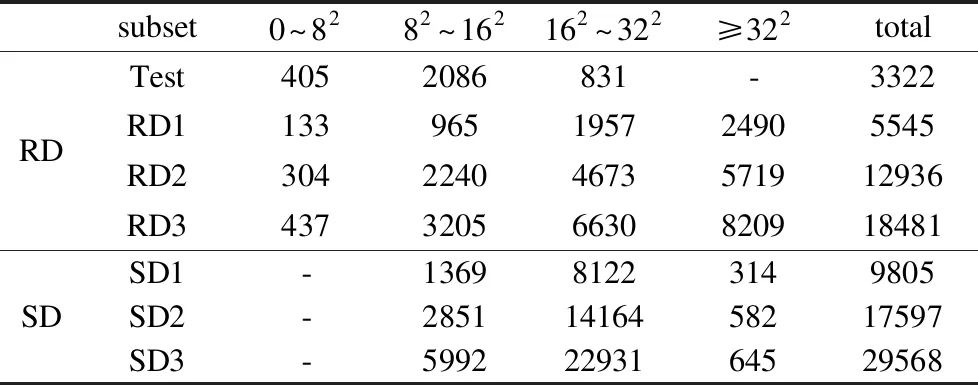

本文实验数据来自前文所提出的真实数据集和仿真数据集.为探索监督数据的数据量对于模型性能的影响,本文将真实数据集(测试集除外)均匀分成3份,并将第一份作为RD1,前两份作为 RD2,所有3份作为RD3.同理,将整个仿真数据集进行划分并构造SD1、SD2和SD3这3份仿真数据集.表 1展示了实验所用的所有数据集以及其对应的无人机目标大小分布情况.

4.1.2 评估标准

由于无人机小目标检测任务中只有无人机一个类别,本文使用目标检测任务常用指标AP[15]来评估模型的性能.检测器返回的预测值(b,conf),其中b是边界框,conf是置信度,如果重叠率IoU预测的b与真实值之间的差小于 0.5,视为TP(True Positive)样本.基于TP检测,可以设置不同的置信阈值β计算出不同的精确率和召回率对(P(β),R(β)).从而通过不同的(P,R)对[35]得出不同召回率(recall)所对应的精确率(precision).最后,从以下公式推导出平均精度AP:

(7)

其中:

(8)

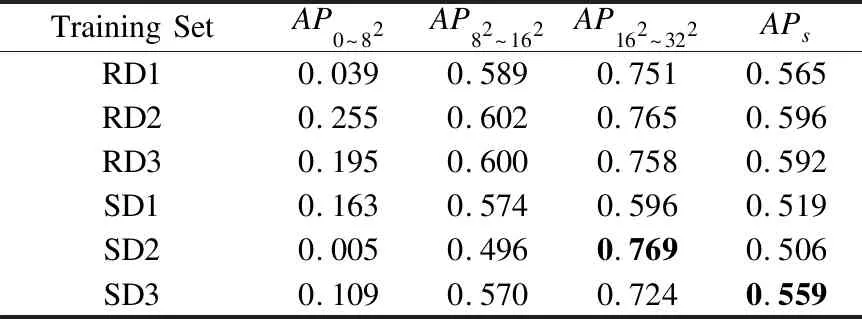

4.2 仿真数据集有效性验证

为了验证仿真数据集能否有效应用于无人机小目标检测任务,本文设计了一组实验,将YOLO v5模型在所有真实和仿真数据集上进行训练并评估.表2展示了不同目标尺寸下所有数据集的评估结果.

可以发现,真实和仿真数据集对应的APs均在50%到60%的范围内,证明仿真数据集能够有效应用于无人机小目标检测任务.比较在大致相同数据量的真实和仿真数据集(RD3和SD2)上训练的模型,在AP162~322指标上,SD2比RD3高出了1.1%,结合表1和表2,分析原因为SD2的目标尺寸主要分布在162~322的范围,所以在该尺寸范围上表现较好,充分说明了目标尺寸分布差异对模型性能具有重要影响.

表1 实验各数据集的图像数量及其尺寸分布

表2 不同训练数据集的基线模型(YOLO v5)的性能

4.3 模型参数知识迁移学习

本文引入迁移学习以达到两个目标:通过模型参数知识迁移减小仿真数据和真实数据的数据分布差异带来的负面影响,提升模型在真实无人机小目标检测场景下的性能;当真实数据不足时,通过迁移学习可以提高真实数据的使用效率,即利用模型参数知识迁移使模型在少量真实数据集上达到大量真实数据集上训练的效果.

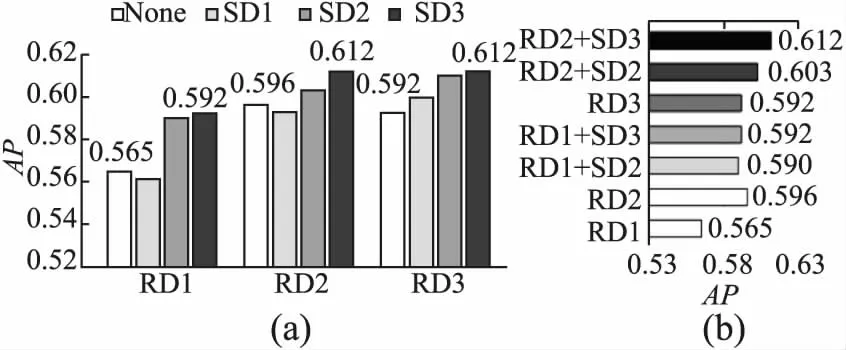

本文以3个真实数据集(RD1、RD2、RD3)所直接训练出的模型为基准,对比了使用基于不同仿真数据量(SD1、SD2、SD3)的迁移学习模型的性能,如图6所示.

图6 使用仿真数据和迁移学习方法的模型性能比较图

图6(a)展示了不同真实数据集(RD1、RD2、RD3)直接训练和做基于不同仿真数据量的迁移学习训练的APs值比较.可以发现,迁移学习的引入使得所有模型均有性能提升,提升幅度为1.6%~2.7%,证明了基于仿真数据的迁移学习方法能有效改善无人机小目标检测性能.此外,随着仿真数据量的增加,模型的性能逐渐上升,这表明更多的仿真数据可以帮助模型更有效地学习到无人机小目标检测的通用知识.

图6(b)展示多组迁移模型和原始模型的APs值,其中RD2+SD3表示为在SD3上进行预训练并在RD2上做微调训练.实验证明了在使用较少的真实数据和足够多的仿真数据情况下,模型的性能已经接近(RD1+SD3与RD3)甚至超过(RD2+SD2与RD3)在较多真实数据上直接训练的原始模型性能.

4.4 自适应融合机制

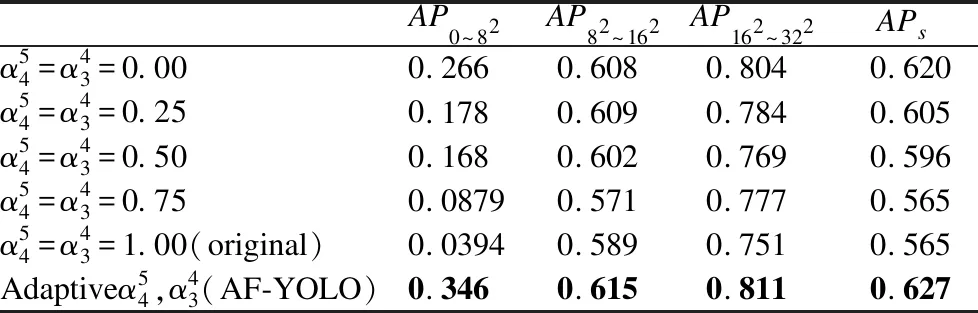

为了让模型更加适应小目标的检测场景,本文提出了AF-YOLO模型,该模型在YOLO v5特征融合模块的自上而下路径中引入了自适应融合机制,具体可见3.4节.如表3所示,本文在真实数据集(RD1)上训练AF-YOLO 模型,并与不同的融合系数所对应的基准模型进行比较.

表3 不同融合系数的影响

表3表明了自顶向下路径中的融合系数对小目标检测有着显著的影响.首先,本文所提出的AF-YOLO模型性能(APs)相较于原始模型提升了6.2%,在不同融合系数对应的若干模型中表现最佳.其次,本文设置了不同的固定融合系数以探究融合系数对于模型性能的影响.可以得出,随着融合系数的下降,基准模型在小目标检测方面的性能呈现上升趋势,这表明对于小目标检测任务,深层特征确实会阻碍浅层的小目标检测.与固定融合系数相比,AF-YOLO采用自适应可学习的融合系数,可以更好地融合不同尺度的特征图.

4.5 基于仿真迁移学习与自适应融合机制相结合方法

表4对比了多种方法的模型性能,第1行表示基准模型在RD1上直接训练的方法,第2行表示运用模型参数知识迁移的方法,第3行表示AF-YOLO模型直接训练方法,第4行表示基于仿真迁移学习和自适应融合机制相结合的方法.实验结果证明了基于仿真数据迁移学习的有效性,使模型性能提高2.7%;同时,自适应融合机制可以实现模型6.2%的提升.最终,与基准模型相比,本文所提出的综合方法可以实现 7.1% 的提升.

表4 结合迁移学习和自适应融合的模型性能

5 结 论

针对无人机数据集缺乏和无人机小目标检测困难问题,本文提出了一种结合了仿真迁移学习和自适应融合机制的无人机小目标检测方法.该方法使用仿真平台生成大量高保真无人机小目标图像数据,在此基础上使用迁移学习以利用从仿真数据中提取的知识来减少对真实数据的需求并提高检测性能.同时,本文提出自适应融合机制进一步改进网络融合深层特征和浅层特征的方式,从而显着提高小目标检测性能.

虽然本文提出的无人机仿真数据集包含4种常见无人机机型,以及常见的8种场景,但在实际运用中,无人机机型繁多,飞行场景复杂多变,因此需进一步扩充仿真数据;此外,本文引入自适应融合机制以改进模型特征融合方法,但在一定程度上,这种改进是通过牺牲大目标检测的性能来获得的,因此,如何平衡大小目标的检测需要进一步研究.在下一阶段工作中,将专注于进一步扩展数据集,以涵盖更常见的无人机模型、传感器类型和真实飞行场景.此外,还将探索不同传感器(如RGB、IR、雷达)的多模态学习,以提高目标检测算法在各种天气、环境条件下的适用性.