面向低照度复杂空间的目标物识别方法

2023-06-29裴泽霖刘行健刘海波

李 特, 裴泽霖, 刘行健, 刘海波

(大连理工大学 高性能精密制造全国重点实验室, 辽宁 大连 116000)

0 引 言

在航空、航天等高端装备的制造及服役过程中,安全检测、故障检修是十分重要的工序,关系到服役可靠性。例如:长期服役装备油箱中进入的多余物,松动掉落的螺栓等,早期发现这些故障是保障装备可靠服役的安全屏障。然而,随着高端装备性能要求越来越高,高度集成化的装备结构不断趋于整体化、复杂化,检测维护作业往往在光线十分昏暗、狭小的空间内进行,检测人员操作难度大、劳动负荷大。为此,研究低照度复杂空间目标物智能识别技术十分必要。

近年来,低照度图像增强和目标检测等计算机视觉问题成为了研究热点。在低照度图像增强方法方面,分为监督学习、无监督学习和零次学习等方式,主要有基于Retinex理论和无参考损失理论两类方法。在目标检测模型方面,主要分为两类:第一类是两阶段的目标检测方法,如Faster-RCNN[1],第一步先从图像中生成候选区域框,再从候选区域框中生成最终的物体边框。虽然准确率高,但是其冗余计算量很大,因此网络的检测速度很慢;第二类是单阶段目标检测方法,如SSD[2]和YOLO[3],一般速度较快、具有实时检测能力。王超等[4]通过Retinex方法对井下黑暗图像进行增强,基于RetinaNet改进基础网络,提高细节特征提取效果,对煤矿输送带的异物进行检测。王秋茹[5]提出了基于YOLOv4改进的机场小目标异物检测方法。史凌凯等[6]基于Laplace算子对井下低照度、高粉尘环境下采集的图像进行预处理,然后改进Mask R-CNN对刮板输送机铁质异物进行检测。俞军燕等[7]提出了一种基于MobileNet CNN改进的单帧图像轨道异物检测方法。何自芬等[8]针对飞机在夜间起降时机场跑道上侵入的异物严重威胁航空运输安全的问题,提出了一种融合自注意力的CSPTNet夜间机场跑道异物检测方法。郝帅等[9]通过分析输送带中异物目标图像受煤尘干扰、输送带高速运动以及光照不均的影响,其造成传统图像检测算法难以准确检测,提出了一种融合卷积块注意力模型的YOLOv5目标检测算法。

笔者针对高端装备制造过程中,在管道、箱体等低照度复杂空间中发现的断屑、螺母、垫片等目标物智能识别方法开展研究,考虑到复杂空间的极端环境导致图像信息的提取和感知十分困难,采用基于VGG自然特征保持损失进行不同尺度大小特征的保留,解决图像语义信息少的问题;一般方法增强极端黑暗图像由于缺少通道维度的限制,色偏和噪声问题严重,采用通道平滑损失分别在RGB三通道限制极端像素值的出现,从而平滑整张图像的颜色,消除噪声;由于大量获取高质量增强图像进行目标物检测数据集的训练和标注费时费力,采用基于小样本迁移学习的方法快速进行目标物检测模型的开发。

1 低照度目标物智能识别算法

1.1 算法总体框架

为解决箱体、管道空间中的目标物识别问题,文中结合改进的低照度图像增强算法和基于小样本迁移学习理论训练自定义目标物检测数据集,提出了一种面向复杂黑暗空间的自动化目标物检测方法,算法的流程如图1所示。

图1 自动化目标物检测算法总体框架Fig. 1 Overall framework of automatic target detection algorithm

由图1可见,检测算法包括低照度图像增强和目标物检测两个部分:一是视觉传感器采集的输入图像通过改进的低照度图像增强网络获得增强图像;二是改进的目标检测网络推理计算增强图像的目标物类别和目标框位置,实现目标物的自动化检测。

1.2 改进ZeroDCE图像增强方法

基于监督学习的低照度图像增强方法往往需要获取成对的图像进行训练,有时由于空间环境特征限制,成对数据集获取较为困难。ZeroDCE[10]基于深度曲线估计的零次学习低照度图像增强方法,不需要费力地获取成对图像,仅仅需要一个大动态范围的数据集,通过全卷积神经网络估计每个像素点的亮度增强S曲线来恢复一张低照度图像。由于不存在配对的图像进行监督学习,因此需要通过无参考损失函数(空间一致性损失、曝光控制损失、颜色一致性损失和照度平滑损失)进行图像噪声、色偏和高低层级语义特征的约束。但是这些无参考损失函数,在增强复杂空间低照度图像时,无法完全恢复图像的细节和照度,会出现人工伪影与色偏,这是由复杂空间环境的特征较少,噪声较大和光照不均所致。

改进的低照度图像增强网络结构,如图2所示。网络主干采用6个连续的3×3×32的卷积核提取特征,网络的非线性能力通过ReLU和Tanh激活函数得到增强,拼接操作融合通道维度特征,防止特征退化。

图2 改进的低照度图像增强网络Fig. 2 Improved low-light image enhancement network

文中对ZeroDCE[10]进行改进,将基于VGG的特征保持损失函数和颜色通道平滑噪声损失函数添加到低照度图像增强网络中,恢复图像的照度和细节特征,对色偏、噪声和光照不均进行控制,防止出现人工伪影。计算公式分别为

(1)

式中:Lfea——自然特征保持损失函数;

αi——VGG16特征提取网络;

y——ImageNet数据集的图像;

Ci——第i个像素的通道维度;

Hi——第i个像素的高维度;

Wi——第i个像素的宽维度。

(2)

式中:Lcha——颜色通道平滑损失函数;

R——红色颜色通道;

G——绿色颜色通道;

B——蓝色颜色通道;

Om——增强图像在m通道的像素特征图;

In——Om的像素均值。

通过(Om-In)2约束输出特征图与每个特征图像素均值的距离,在通道维度控制色偏和噪声。

1.3 小样本的快速识别方法

使用检测算法进行目标物检测模型的开发,若从头开始训练,需要收集大量的图像,对其标注工作耗费时间较大,有时由于光照原因,收集大量令人满意的增强图像甚至是不现实的,因此,文中基于小样本迁移学习理论快速地训练自定义YOLOv5目标物检测数据集。

YOLOv5是在前几代YOLO版本基础上迭代的实时性非常好的目标检测算法,其结构可以分为三个部分,分别是主干特征提取网络CSPDdarknet,进行加强特征提取的拼接操作和CSPLayer,以及YOLOHead用来推理分类预测结果和回归预测结果。

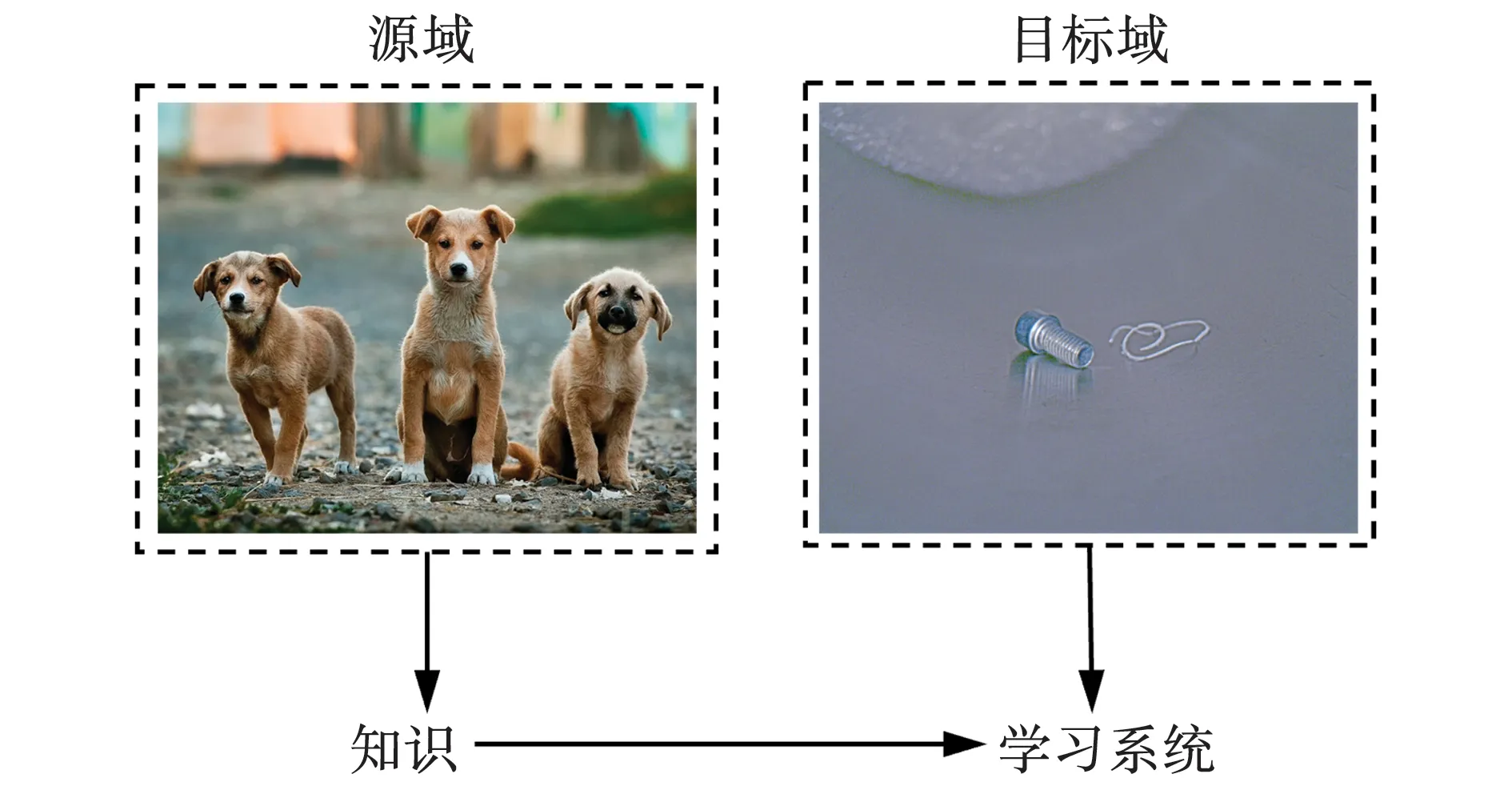

迁移学习是一种节省时间资源和计算资源的训练方法,可以广泛用于工业缺陷检测和零件识别的训练中。数学定义如下所示:源域为DS={XS,fS(X)},学习任务为TS。目标域为DT={XT,fT(X)},学习任务为TT。迁移学习的目标是,通过使用DS和TS中的知识,来提升DT中目标预测函数fT(X)的学习能力,其中,DS≠DT或者TS≠TT。由于目标物的边缘、轮廓等这些泛化特征在ImageNet数据集中也存在,因此,文中改进的目标物检测方法将在ImageNet数据集中训练的YOLOv5x模型作为目标物检测模型开发的初始点,如图 3所示。

在图3中,源域的ImageNet数据量非常大,目标域的目标物数据量比较小,通过迁移学习,可以保证源域的大部分自然泛化特征已经被融合到训练的模型中。具体步骤为,先冻结backbone全部的十层特征层,然后在目标物数据集的输入-输出对上微调YOLOv5 head的14层权重,以适应目标物检测任务。基于小样本迁移学习理论的YOLOv5网络结构,如图4所示。

图3 迁移学习训练目标物检测数据集Fig. 3 Transfer learning training object detection datasets

图4 改进的目标检测网络Fig. 4 Improved object detection network

2 实验结果与分析

2.1 实验环境

文中采用蛇形臂机器人视觉检测平台,如图 5所示。

由图5可见,其主要包括5个部分:驱动模块、移动滑台、蛇形臂本体、视觉传感器和模拟的管道黑暗空间。驱动模块通过电机驱动蛇形臂本体产生俯仰、偏航动作,移动滑台提供横向进给运动的自由度,使蛇形臂末端能够探入管道空间,视觉传感器部分通过调整环形光源的亮度使其捕捉图像不含有过曝部分,然后通过调整相机的工作距离来拍摄对焦良好的低照度图像。

图5 蛇形臂机器人视觉检测平台Fig. 5 Vision detection platform of a snake-arm robot

训练低照度图像增强网络时采用的是PyTorch框架,工作站配置的CPU型号是Xeon(R),GPU是4块12G的TITAN Xp。训练目标物检测数据集时采用的也是PyTorch框架,工作站配置是Xeon(R)Gold 6226R型号的CPU和4块24G的3090GPU。视觉模块采用的设备为 GEV厂商的MV-CA013-20GC型号的视觉传感器,型号是JS-24V50W-1T的单通道光源控制器。

2.2 数据集的建立

目标物图像增强数据集4 590张划分为训练集4 055张和测试集535张,来源为ZeroDCE[10]高动态范围数据集、EnlightenGAN[11]明暗配对数据集以及用来扩充上述数据集动态范围在模拟管道黑暗空间场景拍摄的低照度图像。

对目标物图像增强数据集中测试集的535张图像进行增强测试,将其作为目标物检测的数据集,其中,344张为训练集,86张为验证集,105张为测试集。使用roboflow标注软件对430张含有螺栓(bolt)、断屑(chip_breaking)、钻头(drill)、垫片(gasket)、钉子(nail)、螺母(nut)、螺钉(screw)的图像进行标注,生成训练集和验证集所对应的图像和标签文件。

2.3 评价标准

盲/无参考图像空间质量评估器(BRISQUE)、自然图像质量评估器(NIQE)和基于感知的图像质量评估器(PIQE)通常被用于评估基于零次学习增强图像的质量,低分数表示感知质量高,高分数表示感知质量低。

目标检测实验中运用mAP 0.5作为评价指标,0.5为预测框与真实框交并比αmAP的阈值,mAP为多类检测模型中所有类别平均准确率的平均值,αmAP的值越大、越接近1,表示模型识别定位的准确率越高,其计算公式为

(3)

式中:αmAP——目标检测任务中所有类别平均准确率的平均值;

C——目标检测中目标类别的数量;

Pek——各类检测目标的平均准确率。

Pek的值由P-R曲线围成的面积计算而得,P-R曲线是指精确率P和召回率R的代数关系曲线。精确率P为检测模型预测正确的部分占所有预测结果为正样本的比例。召回率R是检测模型预测正确的部分占所有正样本中的比例。精确率和召回率的计算公式为

(4)

(5)

式中:TP——网络模型正确检测的样本数量;

FP——网络模型误检的样本数量;

FN——网络模型漏检的样本数量。

2.4 实验结果与分析

2.4.1 图像视觉质量比较

为验证改进的低照度增强模型性能,将其与输入、LightenNet[12]方法、RetinexNet方法、ZeroDCE[10]方法、无特征保持损失、无通道平滑损失和无两种损失进行对比,图像的视觉质量如图6所示。

低照度公开数据集DICM数据集的图像质量对比,如图7所示。

图7 DICM数据集图像视觉质量对比Fig. 7 Comparison of visual quality of images in DICM Dataset

由图6可见,管道黑暗空间中经过略微补光后的输入图像是极其黑暗的,仅能看到图像中有目标物,但不能看清细节。LightenNet[12]无法有效地增强图像,RetinexNet产生了严重的绿色色偏、ZeroDCE[10]增强的图像存在人工伪影,且照度不足。无特征保持损失的增强图像存在轻微的噪声及人工伪影,无通道平滑损失的增强图像存在严重的噪声及紫色色偏,无两种损失的图像同样存在噪声、色偏和人工伪影,不能恢复图像的细节特征,改进的方法取得了最好的图像视觉质量。由图7可见,将上述增强方法应用于低照度公开图像数据集,产生的增强结果与图6相似,同样是改进的方法,提升了图像的整体质量。

2.4.2 无参考质量分数

各增强方法无参考图像质量分数和各损失函数无参考图像质量分数对比,如表1和2所示。

表1 各增强方法无参考图像质量分数对比Table 1 Comparison of non-reference image quality scores for each enhancement method

由表1可见,改进的方法取得了最好的分数6.606,且远远超过其他分数,但是在BRISQUE和NIQE中,RetinexNet和ZeroDCE[10]分别取得了最好的分数,略微超过改进的方法。

由表2可见,虽然改进的方法没有取得最好的分数,但是与其他的分数很接近。原因是目前的无参考评价质量分数并不能在每个领域的图像中广泛适用,这些评价指标是基于一个公开的图像数据集质量的好坏来作为判断标准的。在RetinexNet和无通道平滑损失增强的图像中,很明显存在严重的噪声和色偏,却在NIQE和BRISQUE中取得了较好的分数,因此需要寻找更好的图像质量评价标准,如综合评价噪声和色偏的指标。

表2 各损失函数无参考图像质量分数对比Table 2 Comparison of non-reference image quality scores for each loss function

2.4.3 目标物检测

在图像预处理阶段,先将图像调整到640×640的尺寸,然后设置训练参数,学习率设置为cos曲线形式,共迭代300个epoch。训练过程如图8所示。用时0.423 h,训练模型总共86 258 188个参数,86 258 188个梯度,204.8 GFLOPs。

图8 目标物检测网络训练过程中损失函数的迭代曲线Fig. 8 Iteration curve of loss function during object detection network training

在图8中,改进的基于小样本迁移学习理论的目标物检测算法在训练接近50次迭代时基本收敛。表明改进的方法在较少的迭代次数和较短的时间内就能快速收敛,得到令人满意的结果。在验证集上进行的指标测试结果,如表3所示。

表3 验证集指标Table 3 Indicators of validation datasets

由表3可知,改进的方法全部图像和每类目标物图像的 0.5均接近于1,表明模型的识别准确率很高。在进行测试集检测时,预处理时间0.3 ms,推理时间8.5 ms,非极大值抑制1.6 ms,满足实时性检测的需求,可以用于高端装备复杂空间低照度场景的部署。管道中目标物的实际检测结果,如图9所示。

图9 异物检测结果Fig. 9 Results of foreign object detection

3 结 论

(1)针对高端装备的箱体、管道等低照度复杂空间中存在的目标物,提出了一种先增强后识别的自动化检测方法,为安全检测、故障检修提供了有效手段。

(2)文中使用了基于VGG特征保持损失函数和颜色通道平滑噪声损失函数,解决了低照度复杂空间因光照不均而导致的图像在增强过程中产生的高低层级语义信息退化、色偏和噪声问题。

(3)由于低照度复杂空间个性化较强,样本获取困难,提出了基于小样本理论的迁移学习方法。采用344张图像作为目标物检测训练数据集,在验证集上达到了97.4%,节省了大量收集和标注图像的时间,提高了效率。