油菜地块边界提取研究

2023-06-15付健薛新宇孙竹徐阳

付健 薛新宇 孙竹 徐阳

摘要:油菜地块精准提取可实现道路、田埂和地块三部分的分离,为植保无人机提供准确作业区域和非作业区域,推动植保无人机实现自主作业。基于甘肃省张掖市民乐县油菜地无人机低空RGB影像,构建基于简单线性迭代聚类(SLIC)分割和VGG16分类网络相结合的方法实现油菜田地块边界提取。首先,以过绿指数方式灰度化图像,区分裸露地表与植被覆盖区域,其次,通过直方图分析、轮廓检测提取地块主体部分;最后,通过简单线性迭代聚类(SLIC)和VGG16模型相结合,划分网格,识别过分割区域中的作物种植区域,提取完整地块。对比所提算法与传统边界检测算法地块边界提取效果,结果表明:所提模型的平均交并比和平均准确率分别为95.9%、96.0%,边界提取精度和完整性明显优于传统算法。所提模型能够消除低空拍摄下杂草的影像,可为农田边界提取提供参考,可为植保无人机完全自主作业做好铺垫。

关键词:地块提取;无人机;过绿指数;超像素分割;VGG16;图像识别

中图分类号:S565

文献标识码:A

文章编号:2095-5553 (2023) 04-0137-08

Abstract: The precise extraction of oilseed rape field can realize the separation of road, field ridge and plot, provide accurate operation area and non-operation area for plant protection UAV, and promote the realization of autonomous operation of plant protection UAV. Based on UAV low-altitude RGB images of rapeseed field in Minle County, Zhangye City, Gansu Province, this paper constructed a method combining simple linear iterative clustering (SLIC) segmentation and VGG16 classification network to achieve boundary extraction of rapeseed field blocks. Firstly, the image was grayed with green index to distinguish bare ground and vegetation covered area. Secondly, the main part of the field was extracted by histogram analysis and contour detection. Finally, by combining simple linear iterative clustering (SLIC) and VGG16 model, the grid was divided to identify the cropping regions in the segmented region and extract the whole field. The results showed that the average intersection ratio and average accuracy of the proposed model were 95.9% and 96.0%, respectively. The accuracy and integrity of the proposed model were better than those of the traditional algorithm. The model proposed in this paper can eliminate the images of weeds taken at low altitude, which can provide reference for the extraction of farmland boundaries and pave the way for the autonomous operation of plant protection UAV.

Keywords: field extraction; UAV; excess green index; super pixel segmentation; VGG16; image recognition

0 引言

精准农业主要是通过对作物生长区域进行细分化管理,优化肥料和农药等农业生产投入[1]。油菜盛花期田间管理主要包括施肥和病虫害管理,由于传统的人工施肥和背负式喷雾机施药,作业劳动强度大,作业范围受限,主要依赖于植保无人机进行施肥和飞防作业。目前,无人机自主作业是通过人手持 RTK在每一块田进行打点定位,然后再手动生成作业路径,打点工作繁琐,给无人机自主作业造成不便。故通过精准农田划分,快速完成不同田块的精准定位,对优化植保无人机作业路径,实现完全自主作业具有重要意义。

农田划分是将农场以单一田块作为单元划分为不同的封闭区域[2]。传统数字农田划分是基于卫星遥感数据,依托数字图像处理技术提取农田边界线,进而划分出独立农田[3-5]。但由于遥感卫星数据存在时间成本较高、受大气因素和影像分辨率的影响,边界提取精度较差等弊端[6-8],农田划分结果难以用于指导植保无人机作业。近年来,随着人机技术的发展和成熟,由于其具有机动性高、成本和获取影像过程中不容易受到大氣干扰、易获取低空高分辨率图像等优点[9-10],已经被广泛应用于农田分类、农田边界提取以及水渠提取等农田信息的研究[11-15]。基于以上两种数据类型的农田边界提取方法以经典边界检测算法为主,代表算法有Canny边界检测、分水岭边界检测、均值漂移区域生长分割以及基于Gpb+SLIC的轮廓检测法[16-21],此类算法大多依据图像的像素值分布,将像素值梯度超过某值的位置作为农田边界,但该类算法,在不同种植区域,不同分辨率[22]、不同采样距离[23]的情况下,算法的鲁棒性较差。除经典边界检测算法外,有研究者采用深度学习的方法进行探索。杨蜀秦等[24]结合DeepLab V3+语义分割模型,实现基于无人机采集的多光谱数据影像的农田作物分类,为农田边界提取提供新的思考方向。由于农田影响数据的复杂性,现有的农田划定方法存在一些缺点:一是不能提取田埂,会导致植保无人机在非种植区域作业,造成化肥和农药的浪费;二是由于地块尺寸不一致,形状不同,使得农田种植区域分割为非种植区域,称为农田过分割,导致无人机作业范围存在遗漏之处,降低植保效果。

针对上述问题,本文以甘肃省张掖市民乐县张家庄为研究区域,以油菜田为研究对象,构建了基于简单线性迭代聚类(SLIC)分割和VGG16分类网络的地块边界识别模型。首先采用超像素分割给地块预分割图像划分网格,其次,采用VGG16对过分割区域的网格块再识别,提高体块边界提取精度,进而提取完整地块。

1 数据获取与处理

1.1 研究区域概况

本文研究区域为甘肃省张掖市民乐县,东经100.489 44°,北纬38.529 8°,位于祁连山北麓,河西走廊中段,海拔高度2 000~2 850 m,属于沿山冷凉灌区,属温带大陆性荒漠草原气候,年平均降水量351 mm,无霜期140天,气候冷凉湿润、昼夜温差大、光照充足,病虫害轻,是种植油菜的适宜区域,张掖市油菜种植常年播种面积约20 000 hm2,是当地重要的经济作物。所采集区域地形平坦,具有代表性和适用性。

1.2 数据采集

本文采用的拍摄平台为大疆Air 2S无人机遥感影像采集平台,展开尺寸(长×宽×高)为183 mm×253 mm×77 mm,对角线轴距302 mm,搭载CMOS影像传感器,视角为88°,35 mm等效焦距为22 mm。图像采集时间为2021年7月5日,天气晴朗,炎热无风,拍摄对象为赣油杂8号,油菜所处时期为盛花期,无人机拍摄航高为100 m,图像数据格式为RGB,相机与垂直方向夹角为0°,图像分辨率为4 000×3 000,影像储存格式为JPG。图1为本次数据采集样本,可以看出油菜种植区域地块标准,边界成直线形状,地块呈现成三角形和规则四边形,部分地块面积不大,种植不均匀,田埂处存在较多杂草,容易导致过分割或欠分割。

2 研究方法

目前农田边界提取的无人机遥感影像的拍摄高度为110~500 m[13-15, 21-23]。随着拍摄高度下降,农田信息更加丰富,田埂杂草的影响逐渐凸显,基于经典边缘检测的农田边界提取方法对田埂杂草的鲁棒性差。故本文提出了SLIC+VGG16模型以识别种植区域和杂田埂杂草区域,该模型包含两个过程:一是地块预提取;二是利用SLIC+VGG16修正地块预提取结果,得到完整地块。

2.1 地块预分割

地块预提取是通过图像灰度化、直方图分析、图像增强、二值化、形态学处理等数字图像处理方法得到二值图像,采用轮廓查找方法提取油菜农田的主体部分。下文重点阐述地块预提取过程中的灰度化,直方图分析、轮廓查找3个关键步骤。

1) 图像灰度化。油菜和杂草(非种植区域)为绿色植物,像素值分布较为相近,与裸露地表(田埂道路)在像素值分布上存在明显差异,可采用过绿指数(ExG)[25-26]对图像进行灰度化,区分植被覆盖区域和裸露地表。过绿指数计算公式如式(1)所示。

3) 轮廓查找地块。轮廓对象一般存在于不同的位置,但是有时是一个轮廓形状位于另一个轮廓形状的内部,我们称最外层的为一级轮廓,第二层的为二级轮廓,以此类推。在本文研究内容中,一级结构应该是农田的边界和地块外部的其他物体轮廓。基于农田为图像中的主体部分,单块农田轮廓应为封闭边界,且其包围的面积应该远远大于其他噪声产生的轮廓。故可依据农田面积和封闭轮廓作为条件,筛选图像中的一级结构,可以消除部分农田内部的“空洞”和外部杂草等噪声。经过轮廓查找筛选后的结果如图4(c)所示。

2.2 地块再提取

为解决上文地块预提取带来的地块“过分割”现象,本文提出了超像素分割和VGG16模型相结合的方法。将预处理后未能认定为边界的部分如图5所示,通过超像素分割为阈值相近的子块,并将子块喂入到VGG16识别网络中,预测每个子块是否属于农田。

3) 迭代优化。根据距离度量给每个种子点2S邻域内的每个像素分配类标签,若D′≤D,则将像素点更新为当前种子点,并令D=D′。然后进行重复迭代,直至每个像素标签类别不再发生变化,一般需要迭代10次。

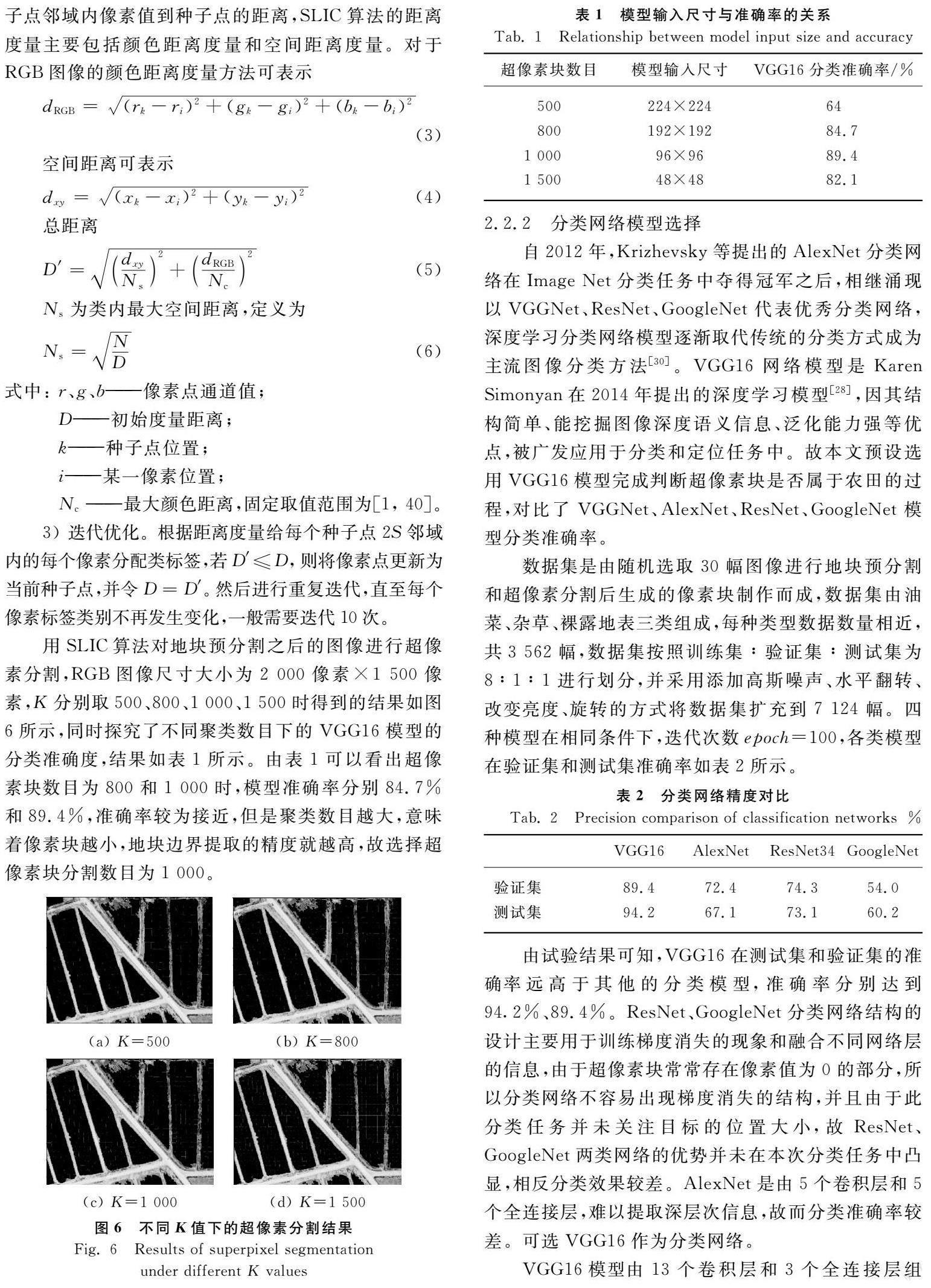

用SLIC算法对地块预分割之后的图像进行超像素分割,RGB图像尺寸大小为2 000像素×1 500像素,K分别取500、800、1 000、1 500时得到的结果如图6所示,同时探究了不同聚类数目下的VGG16模型的分类准确度,结果如表1所示。由表1可以看出超像素块数目为800和1 000时,模型准确率分别84.7%和89.4%,准确率较为接近,但是聚类数目越大,意味着像素块越小,地块边界提取的精度就越高,故选择超像素块分割数目为1 000。

2.2.2 分类网络模型选择

自2012年,Krizhevsky等提出的AlexNet分类网络在Image Net分类任务中夺得冠军之后,相继涌现以VGGNet、ResNet、GoogleNet代表优秀分类网络,深度学习分类网络模型逐渐取代传统的分类方式成为主流图像分类方法[30]。VGG16网络模型是Karen Simonyan在2014年提出的深度学习模型[28],因其结构简单、能挖掘图像深度语义信息、泛化能力强等优点,被广发应用于分类和定位任务中。故本文预设选用VGG16模型完成判断超像素块是否属于农田的过程,对比了VGGNet、AlexNet、ResNet、GoogleNet模型分类准确率。

数据集是由随机选取30幅图像进行地块预分割和超像素分割后生成的像素塊制作而成,数据集由油菜、杂草、裸露地表三类组成,每种类型数据数量相近,共3 562幅,数据集按照训练集∶验证集∶测试集为8∶1∶1进行划分,并采用添加高斯噪声、水平翻转、改变亮度、旋转的方式将数据集扩充到7 124幅。四种模型在相同条件下,迭代次数epoch=100,各类模型在验证集和测试集准确率如表2所示。

由试验结果可知,VGG16在测试集和验证集的准确率远高于其他的分类模型,准确率分别达到94.2%、89.4%。ResNet、GoogleNet分类网络结构的设计主要用于训练梯度消失的现象和融合不同网络层的信息,由于超像素块常常存在像素值为0的部分,所以分类网络不容易出现梯度消失的结构,并且由于此分类任务并未关注目标的位置大小,故ResNet、GoogleNet两类网络的优势并未在本次分类任务中凸显,相反分类效果较差。AlexNet是由5个卷积层和5个全连接层,难以提取深层次信息,故而分类准确率较差。可选VGG16作为分类网络。

VGG16模型由13个卷积层和3个全连接层组成,模型的原输入尺寸为224×224,原输出类别为20。表1探究了不同输入尺寸下,模型的准确率,可知,当输入尺寸为96×96时,模型准确率最高为89.4%。结合超像素的分割数目为1 000时,超像素块的图像尺寸,调整模型输入尺寸为96×96;根据数据集类别为油菜、杂草、裸露地表三类,调整模型输出类别为3,修改后的模型如图7所示。

3 试验结果与分析

3.1 不同算法提取效果对比

为验证本地块提取方法的先进性,对比了Canny边缘检测、分水岭(Watershed)分割算法以及Mean Shift算法。Canny边缘检测算法和分水岭(Watershed)分割算法采用中灰度化处理方式采用过绿指数。

如图8所示,五种算法在地块边界提取的完整性为图8(d)>图8(c)>图8(b)>图8(a),地块提取的准确率为图8(d)>图8(c)>图8(b)>图8(a)。Canny边缘检测受到田埂杂草和道路杂草的影响,封闭完整的地块边界提取效果非常差,产生了较多冗余信息;Watershed算法和Mean Shift算法能够提取大部分完整、独立的地块边界,但无法提取田埂杂草较多的位置处的地块边界,造成相邻地块检测为同一地块;SLIC+VGG16地块边界提取方法可将单一田块作为独立种植单元进行提取,但受到分类网络精度影响,不完整地块差生过分割或欠分割现象。

除此之外,本文统计不同算法的平均识别时间,Canny边缘检测、Watershed分割算法、Mean Shift算法以及SLIC+VGG16算法分别为0.8 s,0.83 s,20 s,1.9 s。Mean Shift算法提取效果优于Canny和Watershed算法,但是速度较慢,主要原因是Mean Shift算法在图像全局进行搜索,效率低下;SLIC+VGG16相对传统的识别算法,速度并没有明显下降,但是精度却提升较大。

以上对比可知,传统边界提取方法由于提取方式单一、鲁棒性差等问题,在低空遥感图像下无法消除杂草带来的影响。本文所提方法可以弥补传统边缘检测算法无法有效区分田埂杂草区域和地块种植区域的弊端和无法划定单一农田作为独立区域管理单元的问题,模型识别时间在2 s内,能够在低空遥感图像背景下,提取准确、完整的单一田块。

3.2 地块提取准确度评价

以采用Labelme软件标注的标签值作为人工地块提取的真实值,类比于语义分割模型评价指标,提出单块农田平均交并比(mIoU)和像素精度(mPA)两项评价指标上的表现,并给出了最大交并比(IoUmax)、最小交并比(IoUmin)、最大像素精度(PAmax)和最小像素精度(PAmin),对比了本文所提模型和均值漂移算法,结果如表2所示。

由表3可知,SLIC+VGG16的mIoU为95.9%,比Mean Shift算法提高了9.4%,mPA为96.0%,比Mean Shift提高了6.6%,可知SLIC+VGG16模型能够准确提取地块,提取的地块与目标地块高度重合,满足提取精度要求;SLIC+VGG16的IoUmax和IoUmin差值为18.9%,较Mean Shift减小了16.2%;SLIC+VGG16的PAmax和PAmin的差值为18.9%,较Mean Shift减小了16.2%,SLIC+VGG16模型和Mean Shift算法的IoUmax和PAmax的值较为接近,IoUmin和PAmin的值却相差很大,其主要原因是Mean Shift算法无法识别田埂杂草和作物区域的边界,相邻两部分地块识别为单一地块,可知本模型较Mean Shift对地块边界提取有更好的适应性。

4 讨论

通过对比分析本文所提模型与可以看出,本文所提模型边界提取精度较传统的边界检测算法有较大的提升,其主要原因:(1)给出了一种低空提取农田边界的方法。与研究高空遥感下的农田边界划定不同,本文针对的低空遥感图像下数据信息更为丰富,杂草等冗余信息复杂的问题,提出SLIC +VGG16的地块提取方法,解决了低空遥感图像独立地块提取复杂的问题,提高了地块提取精度,有利于实现以地块为单元的精准区域管理;(2)給出了一种消除地块过分割现象的方法。传统边缘检测算法在消除杂草的影响过程中会产生过分割的现象,故对过分割区域进行超像素分割和分类识别,进一步判断过分割是否属于农田种植区域。文中没有对原图像进行超像素分割,而是经过预处理之后再进行超像素分割,其原因有:消除田埂杂草的影响;降低图像处理的时间成本。

但是该模型也存在一定的局限性:(1)VGG16分类网络的准确率很难得到进一步的提升;(2)由于超像素块边界不圆滑导致地块边界容易差产生极度不规则的形状;(3)未探究模型在其他高度的无人机遥感影像数据的边界提取效果。作者将对以上问题做进一步研究。

5 结论

1) 由于在低空下拍摄的无人机遥感图像地块信息更为丰富,细节也更为复杂,田埂杂草和作物像素值相近,传统边界检测模型、语义分割模型难以提取田埂杂草密集处的边界。针对以上问题,本文根据杂草阈值分布特点,提出了对田埂杂草适应性强的SLIC +VGG16地块边界提取模型。

2) 该模型首先采用超绿指数方法对应进行灰度化;其次统计裸露地表、作物以及田埂的灰度值直方图,确定低阈值TH1=70、高阈值TH2=150进行二值分割,以消除不同田埂杂草和部分冗余噪声;再者采用轮廓检测方法消除部分阈值分割产生的作物区域出现的大面积空洞;然后采用超像素分割将上述确定为非作物区域的位置分割为超像素块,喂入训练好的VGG16分类网络中,进一步确定是否属于作物区域;最后对比了VGG16网络与其他分类网络的分类精度,通过对比的方法检验了SLIC+VGG16与Mean Shift等四种边界提取算法的效果和精度。结果表明,VGG16网络分类准确度最高,为94.2%;本文模型能够消除田埂杂草的影响,相较于其他四种边界提取算法具有更好的适应性;从SLIC+VGG16与Mean Shift对比试验来看,模型边界提取精度mIoU和PA分别为95.9%、96.0%,较Mean Shift算法都有较大的提升,同时具有较小的极值差,说明该模型的边界提取的适应性较好。

本模型采用的边界提取模型相较于传统的边界提取算法能够更好地消除杂草的影响,对低空无人机遥感影像具有更好的适应性,可为无人机低空遥感影像农田划分提供参考。

参 考 文 献

[1] Georgi C, Spengler D, Itzerott S, et al. Automatic delineation algorithm for site-specific management zones based on satellite remote sensing data [J]. Precision Agriculture, 2018, 19(4): 684-707.

[2] Fmb A, Lsg B, Rd B, et al. Delineation of management zones in agricultural fields using cover-crop biomass estimates from PlanetScope data [J]. International Journal of Applied Earth Observation and Geoinformation, 2020, 85.

[3] Muoz X, Freixenet J, Cuf X, et al. Strategies for image segmentation combining region and boundary information-ScienceDirect [J]. Pattern Recognition Letters, 2003, 24(1-3): 375-392.

[4] 贾坤, 李强子, 田亦陈, 等. 遥感影像分类方法研究进展[J]. 光谱学与光谱分析, 2011, 31(10): 2618-2623.

Jia Kun, Li Qiangzi, Tian Yichen, et al. A review of classification method of remote sensing imagery [J]. Spectroscopy and spectral analysis, 2011, 31(10): 2618-2623.

[5] 陈君颖, 田庆久. 高分辨率遥感植被分类研究[J]. 遥感学报, 2007, 11(2): 221-227.

Chen Junying, Tian Qingjiu. Vegetation classification based on high-resolution satellite image [J]. Journal of Remote Sensing, 2007, 11(2): 221-227.

[6] Watkins B, Niekerk A V. A comparison of object-based image analysis approaches for field boundary delineation using multi-temporal Sentinel-2 imagery [J]. Computers and Electronics in Agriculture, 2019, 158: 294-302.

[7] Watkins B, Niekerk A V. Pre-print automating field boundary delineation with multi-temporal sentinel-2 imagery [J]. Computers and Electronics in Agriculture, 2019, 167: 105078.

[8] 李森. 高空间分辨率遥感影像耕地地块提取方法研究[D]. 北京: 中国科学院大学, 2019.

Li Sen. Research on cultivated land parcel extraction method based on high spatial resolution remote sensing image [D]. Beijing: University of Chinese Academy of Sciences, 2019.

[9] 王利民, 劉佳, 杨玲波, 等. 基于无人机影像的农情遥感监测应用[J]. 农业工程学报, 2013, 29(18): 136-145.

Wang Limin, Liu Jia, Yang Lingbo, et al. Applications of unmanned aerial vehicle images on agricultural remote sensing monitoring [J]. Transactions of the Chinese society of Agricultural Engineering, 2013, 29(18): 136-145.

[10] 张正健, 李爱农, 边金虎, 等. 基于无人机影像可见光植被指数的若尔盖草地地上生物量估算研究[J]. 遥感技术与应用, 2016, 31(1): 51-62.

Zhang Zhengjian, Li Ainong, Bian Jinhu, et al. Estimating aboveground biomass of grassland in Zoige by visible vegetation index derived from unmanned aerial vehicle image [J]. Remote Sensing Technology and Application, 2016, 31(1): 51-62.

[11] 纪景纯, 赵原, 邹晓娟, 等. 无人机遥感在农田信息监测中的应用进展[J]. 土壤学报, 2019, 56(4): 773-784.

Ji Jingchun, Zhao Yuan, Zou Xiaojuan, et al. Advancement in application of UAV remote sensing to monitoring of farmlands [J]. Acta Pedologica Sinica, 2019, 56(4): 773-784.

[12] Fang H, Chen H, Jiang H, et al. Research on method of farmland obstacle boundary extraction in UAV remote sensing images [J]. Sensors, 2019(19): 4431-4444.

[13] 韓文霆, 张立元, 张海鑫, 等. 基于无人机遥感与面向对象法的田间渠系分布信息提取[J]. 农业机械学报, 2017, 48(3): 205-214.

Han Wenting, Zhang Liyuan, Zhang Haixin, et al. Extraction method of sublateral canal distribution information based on UAV remote sensing [J]. Transactions of the Chinese society for Agricultural Machinery, 2017, 48(3): 205-214.

[14] 郭鹏, 武法东, 戴建国, 等. 基于无人机可见光影像的农田作物分类方法比较[J]. 农业工程学报, 2017, 33(13): 112-119.

Guo Peng, Wu Fadong, Dai Jianguo, et al. Comparison of farmland crop classification methods based on visible light images of unmanned aerial vehicles [J]. Transactions of the Chinese Society of Agricultural Engineering, 2017, 33(13): 112-119.

[15] Wang L, Wang Y, Zhang J, et al. Research on boundary recognition and extraction method of field operation area based on UAV remote sensing images [J]. IFAC-Papers OnLine, 2019, 52(30): 231-238.

[16] Bergado J R, Persello C, Stein A. Recurrent multiresolution convolutional networks for VHR image classification [J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(11): 6361-6374.

[17] Cheng T, Ji X, Yang G, et al. DESTIN: A new method for delineating the boundaries of crop fields by fusing spatial and temporal information from WorldView and Planet satellite imagery [J]. Computers and Electronics in Agriculture, 2020, 178.

[18] Hong R, Park J, Jang S, et al. Development of a parcel-level land boundary extraction algorithm for aerial imagery of regularly arranged agricultural areas [J]. Remote Sensing, 2021, 13(6): 1167.

[19] Wagner M P, Oppelt N. Extracting agricultural fields from remote sensing imagery using graph-based growing contours [J]. Remote Sensing, 2020, 12(7): 1205.

[20] 蒋军娟. 基于不同算法的地类边界轮廓检测效果对比分析[J]. 北京测绘, 2020, 34(12): 1763-1766.

Jiang Junjuan. Comparison and analysis of the detection effect of the boundary contour of land class based on different algorithms [J]. Beijing Surveying and Mapping, 2020, 34(12): 1763-1766.

[21] 庞新华, 朱文泉, 潘耀忠, 等. 基于高分辨率遥感影像的耕地地块提取方法研究[J]. 测绘科学, 2009, 34(1): 48-49, 161.

Pang Xinhua, Zhu Wenquan, Pan Yaozhong, et al. Research on cultivated land parcel extraction based on high-resolution remote sensing image [J]. Science of Surveying and Mapping, 2009, 34(1): 48-49, 161.

[22] 楊亚男, 康洋, 樊晓, 等. 基于地形特征的无人机遥感梯田影像边缘提取方法[J]. 智慧农业, 2019, 1(4): 50-61.

Yang Yanan, Kang Yang, Fan Xiao, et al. Edge extraction method of remote sensing UAV terrace image based on topographic feature [J]. Smart Agriculture, 2019, 1(4): 50-61.

[23] 吴晗, 林晓龙, 李曦嵘, 等. 面向农业应用的无人机遥感影像地块边界提取[J]. 计算机应用, 2019, 39(1): 298-304.

Wu Han, Lin Xiaolong, Li Xirong, et al. Land parcel boundary extraction of UAV remote sensing image in agricultural application [J]. Journal of Computer Applications, 2019, 39(1): 298-304.

[24] 杨蜀秦, 宋志双, 尹瀚平, 等. 基于深度语义分割的无人机多光谱遥感作物分类方法[J]. 农业机械学报, 2021, 52(3): 185-192.

Yang Shuqin, Song Zhishuang, Yin Hanping, et al. Crop classification method of UVA multispectral remote sensing based on deep semantic segmentation [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(3): 185-192.

[25] 汪小钦, 王苗苗, 王绍强, 等. 基于可见光波段无人机遥感的植被信息提取[J]. 农业工程学报, 2015, 31(5): 152-159.

Wang Xiaoqin, Wang Miaomiao, Wang Shaoqiang, et al. Extraction of vegetation information from visible unmanned aerial vehicle images [J]. Transactions of the Chinese Society of Agricultural Engineering, 2015, 31(5): 152-159.

[26] 田振坤, 傅莺莺, 刘素红, 等. 基于无人机低空遥感的农作物快速分类方法[J]. 农业工程学报, 2013, 29(7): 109-116, 295.

Tian Zhenkun, Fu Yingying, Liu Suhong, et al.Rapid crops classification based on UAV low-altitude remote sensing [J]. Transactions of the Chinese Society of Agricultural Engineering, 2013, 29(7): 109-116, 295.

[27] Alastair P M, Simon P, Jonathan W, et al. Superpixel lattices[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Anchorage, Alaska, USA, 2008.

[28] 韩纪普, 段先华, 常振. 基于SLIC和区域生长的目标分割算法[J]. 计算机工程与应用, 2021, 57(1): 213-218.

Han Jipu, Duan Xianhua, Chang Zhen. Target segmentation algorithm based on SLIC and region growing [J]. Computer Engineering and Applications, 2021, 57(1): 213-218.

[29] 任欣磊, 王阳萍. 基于改进简单线性迭代聚类算法的遥感影像超像素分割[J]. 激光与光电子学进展, 2020, 57(22): 354-362.

Ren Xinlei, Wang Yangping. Supper-pixel segmentation of remote sensing image based on improved simple linear clustering algorithm [J]. Laser & Optoelectronic Progress, 2020, 57(22): 354-362.

[30] 张珂, 冯晓晗, 郭玉荣, 等. 图像分类的深度卷积神经网络模型综述[J]. 中国图象图形学报, 2021, 26(10): 2305-2325.

Zhang Ke, Feng Xiaohan, Guo Yurong, et al.Overview of deep convolutional neural networks for image classification [J]. Journal of Image and Graphics, 2021, 26(10): 2305-2325.