基于多尺度特征融合的图片情感分布学习

2023-04-29张建军赵小明何亚东文虹茜卿粼波

张建军 赵小明 何亚东 文虹茜 卿粼波

摘 要 :视觉情感分析旨在分析人们对视觉刺激的情感反映,近年来受到了共享平台和网络社交等多媒体视觉数据相关领域的关注.传统的图片情感分析侧重于单标签的情感分类,忽略了图片表达的情感的复杂性和图像潜在的情绪分布信息,不能体现出图片所表达的不同情绪之间的相关性.针对以上问题,首先采用ViT和ResNet网络进行全局和局部融合的多尺度情感特征提取,通过主导情绪分类和标签分布学习进行图片情感识别,充分表征图片的复杂情感.在公开的Flickr_LDL数据集和Twitter_LDL数据集上取得了显著的效果,证明了提出方法的有效性.

关键词 :视觉情感分析; 深度学习; 标签分布学习; 图片情感

中图分类号 :TP391.4 文献标识码 :A DOI : 10.19907/j.0490-6756.2023.043002

Image emotion distribution learning based on multi-scale feature fusion

ZHANG Jian-Jun 1, ZHAO Xiao-Ming 1, HE Ya-Dong 1, WEN Hong-Qian 2, QING Lin-Bo 2

(1. CHN ENERGY Dadu River Dagangshan Power Generation Co., Ltd, Yaan 625409, China;

2.College of Electronics and Information Engineering, Sichuan University, Chengdu 610065, China)

Visual emotion analysis aims to analyze the emotional response of human beings to visual stimuli, which has attracted multimedia visual data related fields such as sharing platforms and social networking in recent years. Traditional image emotion analysis focuses on the classification of single label emotions, ignoring the complexity of emotions expressed in pictures and the potential emotional distribution information of images, and failing to reflect the correlation between different emotions expressed in pictures. To solve the above problems, ViT and Resnet networks are used to extract multi-scale emotional features with global and local fusion, and the label distribution learning method is used for image emotion prediction. Significant results are achieved on the public available Flickr_LDL dataset and Twitter_LDL dataset, which demostrate the effectiveness of the proposed method.

Visual emotion analysis; Deep learning; Label distribution learning; Image emotion

1 引 言

理解图像轮廓和色彩中隐含的情感表达一直以来受到艺术与心理学领域的关注,随着互联网的发展,视觉情感分析成为计算机视觉领域的一个重要课题 [1,2],应用在美学分析、智能广告和社交媒体舆情检测等 [3-6]众多领域.为了分析图片表达的情感,需要对图片进行情绪标注,通过手工设计或深度学习的方法提取图片的特征,完成情绪的识别与归类,并在此基础上做进一步的分析.目前大部分的方法忽略了图片隐含的情绪分布信息,如何有效提取图片的情感特征也是一个亟待解决的问题.

视觉特征的提取是图片情绪识别的重要内容 [1].传统的视觉情绪识别使用底层特征和中高层特征 [7-8].底层视觉特征包括颜色、构图、形状和纹理等多维度的信息,需要针对不同类型的图片设计不同的特征.Machajdik等 [9]通过手工提取关于艺术和心理学相关理论的视觉特征组合.Lu等 [10]研究了图像的纹理特征对情绪的影响.Zhao等 [11]根据艺术原则设计了更健壮的视觉特征组.这些手工制作的视觉特征在一些小的数据集上被证明是有效的 [1].底层视觉特征与人类感知的高层情感语义之间存在一定差异,因此一些研究者开始尝试构建中层语义特征或更高维的特征.Borth等 [12]利用中层语义信息作为情感的中间表征,统计词袋的方法 [13]也被应用于图像语义分类.随着深度学习的发展 [14-18]和多媒体数据的日渐丰富,使用数据驱动学习的深度表征在图片情感分析中取得了显著的效果 [19,20].You等 [21]设计了一种鲁棒的渐进CNN架构模型——PCNN,用于视觉情感分析.Rao等 [22]提出一种多层次的深度网络(MldeNet),用于统一图像的低级和高级信息.Tripathi等 [23]提出FTEC-net,用于解决三个高度相关的情绪分析任务:情绪识别、情绪回归和情绪导向.

虽然已经有很多方法在学习挖掘图片的情感特征,但是大部分方法忽略了情感的复杂性,只预测主导情绪.然而实际的网络图片种类多样,图片中包含的元素丰富,仅使用单一情绪解释图片的情感表达比较困难.目前常用的标签分配方式有单标签学习和多标签学习 [1].多标签学习虽然在一定程度上解决了标签模糊的问题,但也存在局限性,无法体现不同标签的相对重要性.而标签分布学习(Label Distribution Learning, LDL)是一种更细致的标签分配方式,更适合具有模糊性的图片情感分析 [24-26].标签分布学习描述了不同标签对同一实例的重要程度,是单标签学习和多标签学习的通用模式.标签分布学习具有更灵活的输出空间,也更具挑战,过于最小化预测和真实值间的散度可能会混淆主导标签.

传统的标签分布学习方法包括问题转换、算法自适应和专用算法三种策略 [27,28].近年来,基于CNN的标签分布学习方法也不断被提出 [1,2,29-32]并应用于图片情感分析领域.Gao等 [33]使用深度标签分布学习(DLDL),在特征提取和分类中利用标签歧义防止网络过拟合,在小数据集上取得了良好的性能.Peng等 [30]提出卷积神经网络回归(CNNR)处理图片情感标签分布问题,该方法对每个情感类别都有欧氏损失,将回归结果归一化为所有情绪的概率,但是该方法对每一类情绪构建损失,网络参数复杂.CSR [2]、SSDL [31]和E-GCN [29]利用情感理论先验知识,使用情感极性、情感强度和情感间的相关性等信息进行情绪分布学习,但是没有充分考虑图片本身不同尺度特征的关联.

本文针对单一情绪无法充分表征图片情感的问题,采用标签分布学习进行图片情感分析,更好地实现了图片实例到情感空间的映射;针对图片中情感特征的提取,使用ViT和ResNet网络进行多尺度特征提取并进行特征层融合;最终实现标签分布预测和主导情绪分类两个任务.与之前的研究相比,本文的方法在大型公开数据集Flickr_LDL和Twitter_LDL上取得了很好的效果.

2 图片情感分布学习

目前图片情感分析研究一般是基于图片整体的视觉特征 [34],并且忽略了情感分析问题的主观性.针对这些问题,本文提出如图1所示的基于ViT的多尺度融合图片情感分析模型.对于全局尺度,使用基于视觉的Transformer通道提取图片中的情感特征和关系特征,学习由于卷积操作的限制而遗漏的部分全局性特征向量.同时,表征的深度对于视觉识别任务至关重要 [35],因此,对于局部尺度,使用基于残差结构的ResNet卷积架构进行深层信息的提取.最后使用Transformer编码器网络融合推理不同尺度特征间的相互联系并同时进行主导标签分类任务和标签分布预测任务,得到最终的结果.

2.1 特征提取

2.1.1 全局特征 图片的全局特征能表征图像的整体属性,包含了完整的情感特征,但是各部分之间全局性的联系容易被人们忽略,卷积操作中感受野的局部相关性也使部分大尺度特征被遗漏.为了提取有效的全局情感特征,本方法引入在ImageNet [36]上预训练ViT网络 [37]作为特征提取的骨干网络.基于Transformer架构的ViT 是基于多头自注意力机制的一种神经网络,利用自注意力机制可以有效提取全局性特征,ViT网络结构如图2所示.

具体来说,使用四通道ViT对图片进行特征提取再整合,获得全局特征信息.ViT首先进行分块和平展,并使用可训练的线性投影将其映射输出,成为固定大小的补丁嵌入.为了补充分割图块时丢失的位置信息,在每一个图块补丁前加上位置嵌入,如图2所示.其中,位置中的0是额外增加的可学习嵌入[*].最终的嵌入向量序列作为Transformer编码器的输入,基于自注意力机制提取相关特征.输出的向量序列与输入序列长度相同,其中位置0得到了所有图块之间的相关性.最终整合的大尺度情感特征有效表征了图片各部分之间的关联信息和全局信息.

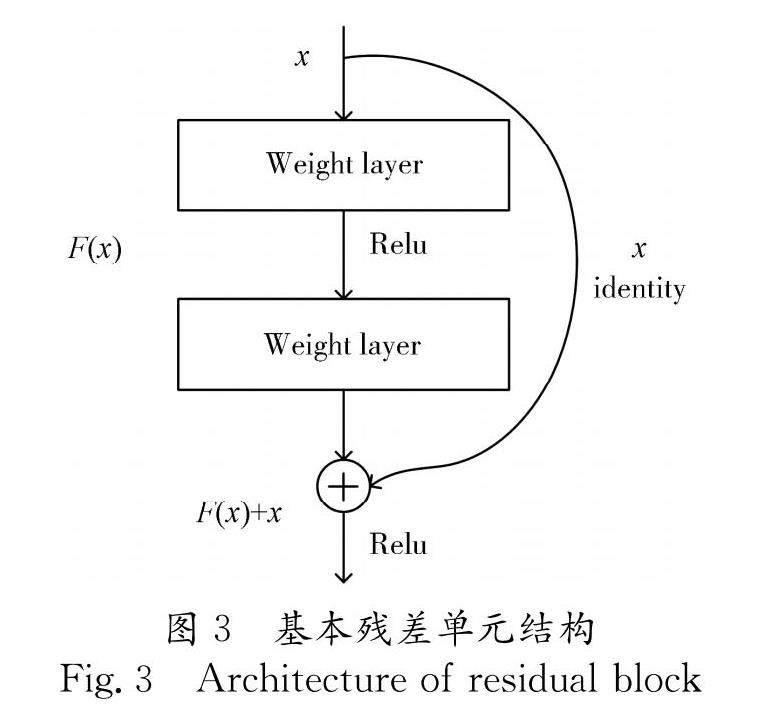

2.1.2 局部特征 多数图片中局部的重要性不同 [38],因此在提取图片情感特征时有必要考虑到局部信息.图片情感分析研究中提取的特征一般包含低层视觉内容、中层语义和深度特征.传统手工特征包括颜色、纹理和形状轮廓等,但是随着数据量增大和数据内容丰富度增加,深度特征更能表征抽象的局部情感特征,也更加具有鲁棒性.因此本文采用基于残差结构的ResNet卷积架构进行深层情感特征的提取,图3所示是ResNet中基本残差单元的结构示意图.表征的深度对于视觉识别任务是至关重要的 [35],而ResNet网络结构可以通过堆叠基本残差单元来加深网络的深度,在增加表征深度时避免因网络过深产生梯度爆炸等问题.

2.1.3 特征融合 为了融合提取的不同尺度的特征,使用具有推理多个输入内在关系能力的Transformer编码器网络,综合挖掘图片的情感信息.Transformer编码器的输入为特征提取模块中提取的五个特征向量以及一个额外添加的可学习嵌入块,学习最终的主导情绪分类和标签分布预测信息.

2.2 分布学习

现有的大多数图片情感分析工作往往使用单标签预测主导情绪的类别,简化了情绪的复杂度.多标签中一个实例具有多个标签,但是标签没有权重,标签之间的相对重要性无法体现.而标签分布学习对实例的描述包括各个标签的程度,表示该标签相对于示例的重要程度.

图4为三种标签分配方式示例,图片及标注来自Flickr_LDL [32]数据集.由于情感的主观性和复杂性,不同的人对同一张图片的情感有不同的判断,同一个人对同一张图片也可能有多种情感产生,包括主导情绪和其他情绪.例如对图4左边的风景,多数人会感到敬畏,也有人会产生愉快、激动等情绪.而单标签和多标签都不能充分表现图片情感的特征与联系.因此,使用标签分布学习更能描述情感的模糊性与情感间的联系.Kullback-Leibler (KL) [39]loss是用于分布学习的损失函数,能衡量由于预测分布与标记分布不一致而导致的信息损失,见式(1).

L=- 1 N ∑ N i=1 ∑ C j=1 y ij ln y ︿ ij (1)

其中, y 表示从数据集标记的情绪分布; y ︿ 表示预测的情绪分布; N 表示特定数据集中图片的数量; C 表示所涉及的情感类别.

3 实验结果与分析

3.1 数据集

本文在两个大型公共图片情感分布数据集上评估了提出的方法:Flickr_LDL和Twitter_LDL [32].FlickrLDL和TwitterLDL是两个主要用于情绪分布学习的数据集,它们的标签属于典型的八种情绪分类:anger、 amusement、awe、contentment、disgust、excitement、fear和sadness.Flickr_LDL包含11 150张图片,Twitter_LDL包含 10 045张图片,多名参与者根据8种情绪对这些图像进行了标记,标记通常将归一化为概率值作为情感分布的真实值标签.

3.2 实施细节

在实验中,深度骨干网络使用Resnet-101 [35]架构,在大规模视觉识别数据集ImageNet [36]上进行预训练,取消最后一层输出分类的全连接层.局部特征骨干网络使用ViT [37]预训练的网络架构,更改输出特征为1024维,与深度特征融合后输入全连接层.Flickr_LDL和Twitter_LDL被随机分割为训练集(80%)和测试集(20%).对于训练/测试集,将图像统一调整为500×500后随机裁剪到224×224,并以0.5的概率进行水平翻转.网络以端到端方式训练,使用KL loss和交叉熵进行学习.初始学习率为0.001,每10个回合除以10,总回合数为50,网络整体参数量约为500 M.网络框架使用PyTorch实现,实验环境为Ubuntu 18.04,NVIDIA GTX 3090Ti GPU.

3.3 与其他方法对比

为了验证所提出模型的有效性,将其与之前的研究方法进行了比较,主要分为以下四种类型.

(1) 问题转换(Problem Transformation, PT).PT-Bayes和PT-SVM基于传统的分类方法SVM和Naive Bayes,将标签分布学习问题转化为加权的单标签学习问题 [27].

(2) 算法自适应(Algorithm Adaptation, AA).将传统的机器学习算法kNN和BP神经网络扩展到处理标签分布学习,分别用AA-knn和AA-BP表示 [27].

(3) 专用算法(Specialized Algorithm, SA).根据标签分布学习的特性设计的算法,包括SA-IIS [28]、SA-BFGS [27]和SA-CPNN [28].SA-IIS采用了一种类似于改进迭代缩放的策略,假设每种情绪的概率为最大熵模型.基于IIS的SA-BFGS采用了一种有效的拟牛顿方法改进优化.SA-CPNN是条件概率神经网络.

(4) 基于CNN的方法(CNN-based).CNNR [30]使用欧几里德损失进行学习.DLDL [33]使用KL散度作为损失函数.ACPNN [32]基于条件概率神经网络进行改进,将图像标签编码成二进制表示来代替CPNN中使用的无符号整数,并加入噪声和增强情感分布进行训练.JCDL [1]通过优化KL loss和softmax loss联合学习视觉情感的分布和分类.SSDL [31]采用结构化稀疏标注框架,考虑了情感的极性和强度特征.E-GCN [29]用图卷积网络捕获情绪之间的相关性进行情绪分布学习.CSR [2]使用先验知识,构建环形情感向量表征并用于损失学习.

根据文献[27]的建议,实验中使用了6种分布学习测量方法对结果进行评价.其中,距离度量包括Chebyshev距离(↓)、Clark距离(↓)、Canberra度量(↓)和KL散度(↓).相似性度量包括Cosine系数(↑)和Intersection相似性(↑).向下的箭头表示越低越好,向上的箭头表示越高越好.此外,Clark距离和Canberra度量的最大值由情绪类别数决定,为进行标准化比较,与之前的工作采用一样的操作:将Clark距离除以情绪类别数的平方根,将Canberra度量除以情绪类别数.此外,进一步引入top-1准确度作为评价指标,对主导情绪的预测情况进行比较.

实验结果如表1和表2所示,表中括号内为指标排名,最好结果加下划线.从表中可以看出,在两个公开的图片情感分布数据集上,不同类型的方法有明显不同的实现效果.基于问题转换的方法(PT)将复杂的标签分布任务转化为简单的单标签任务,然而对于分布间相关性的学习可能不敏感,因此六个指标的平均排名(Average Rank)和主导标签分类准确度排名都基本处于最后.基于算法自适应的方法(AA)在已有的机器学习算法上进行拓展,其中kNN算法特别适合多分类问题,特别是对类域的交叉或重叠较多的待分样本集,因此在Clark距离和Canberra度量两个指标上取得了极好的结果.专用算法(SA)是为特定的标签分布问题设计,充分考虑了标签分布问题的特性,取得了不错的结果.与传统方法相比,基于CNN的方法(CNN-based)获得了显著的性能提升,证明了其在特征提取方面的优势.而本文提出的方法综合考虑了局部深层特征和全局特征与其之间的相关性,在两个广泛使用的数据集上都获得了更好的分类和分布结果,证明了所提方法的优越性.

数据集预测实例如图5所示,分别展示了实验结果中预测效果的正反例.可以看出,图5a中对于主导情绪Contentment和整体情绪分布的预测都比较准确;而图5b中对于主导情绪Fear和情绪分布的预测都有所偏差,情绪分布中近似出现了两个峰值.说明图片中多种元素的风格一致性会对分布结果产生一定影响,图5b中的黑猫和花朵两类元素对比较为强烈,影响了识别结果.同时也说明了对于同一张图片,其表现的情绪较为复杂,如何准确检测图片情绪需要进一步研究.

3.4 消融实验

为了验证所提出 模型中各个模块的有效性,本文设计了消融实验.实验包括三个部分,第一部分使用在ImageNet上预训练Resnet-101网络和单标签分类常用的交叉熵进行学习;第二部分增加ViT通道提取特征;第三部分增加KL损失学习分布特征.

实验结果如表3所示,消融实验在Flickr_LDL和Twitter_LDL两个数据集上都表现出了相似的效果.具体而言,仅使用ResNet网络进行特征提取和学习时结果很差,标签分布预测的六个指标和主导情绪分类的准确率指标都没有达到很好的结果.在融入ViT模块进行特征提取后,主导情绪分类的准确率有了明显的提升,但是分布学习指标结果变差.表明ViT能提取更多的抽象情感特征,弥补局部特征的不足,实现更高的主导情绪分类准确率,但是没有考虑其他非主导情绪之间的相关性,对于标签分布学习还存在局限性.在加入KL损失函数模块后,主导情绪分类准确率和分布学习指标都有提升,所有指标达到了最佳结果.表明了KL损失模块对于标签分布预测的有效性,并且提高分布学习的预测效果的同时也提高了主导情绪分类的准确率.最终提出的模型取得了最好的分布预测结果和分类结果,证明了模型的有效性和模型各部分的必要性.

4 结 论

针对图片情感分析研究中单一情绪无法表征具有模糊性的图片情绪的分布问题和对图片的视觉情感特征提取不够充分的问题,本文使用ViT和Resnet网络进行多尺度情感特征提取并进行特征层融合推理,实现标签分布预测和主导情绪分类两个任务.消融实验和对比实验的结果表明,ViT能提取更多的全局抽象情感特征,弥补局部深层特征的不足;KL损失模块在优化标签分布预测结果的同时没有抑制主导情绪分类的识别效果,进一步提升了主导情绪分类的准确率;最终模型在广泛使用的Flickr_LDL和Twitter_LDL数据集上对于标签分布预测和主导情绪分类两个任务都取得了良好结果,证明了所提出模型的有效性.我们会继续研究情绪特征的更多表示方法,进一步优化图片情感特征提取方法.

参考文献:

[1] Yang J, She D, Sun M. Joint image emotion classification and distribution learning via deep convolutional neural network [C]// Proceedings of the 26th International Joint Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2017: 3266.

[2] Yang J Y, Li J, Li L D, et al. A circular-structured representation for visual emotion distribution learning [C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 4235.

[3] Chen Q, Zhang W, Zhou N, et al . Adaptive fractional dilated convolution network for image aesthetics assessment [C]//Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 14114.

[4] Hosu V, Goldlucke B, Saupe D. Effective aesthetics prediction with multi-level spatially pooled features [C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 9375.

[5] Sidorov O. Changing the image memorability: from basic photo editing to GANs [C] // Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2019.

[6] Li Z, Fan Y, Jiang B, et al . A survey on sentiment analysis and opinion mining for social multimedia[J]. Multimed Tools Appl, 2019, 78: 6939.

[7] 王仁武, 孟现茹. 图片情感分析研究综述[J]. 图书情报知识, 2020, 195: 121.

[8] 杜茂康, 李晓光, 刘岽. 融合遗传算法的特定领域情感词库构建 [J].重庆邮电大学学报: 自然科学版, 2022, 34: 576.

[9] Machajdik J, Hanbuby A. Affective image classification using features inspired by psychology and art theory [C]// Proceedings of the 18th ACM International Conference on Multimedia. New York: ACM Press, 2010: 83.

[10] Lu X, Suryanarayan P, Adams Jr R B, et al . On shape and the computability of emotions [C]// Proc of the 20th ACM International Conference on Multimedia. New York: ACM Press, 2012: 229.

[11] Zhao S, Gao Y, Jiang X, et al . Exploring principles-of-art features for image emotion recognition [C]// Proceedings of the 22 th ACM International Conference on Multimedia. New York: ACM Press, 2014: 47.

[12] Borth D, Ji R, Chen T, et al . Large-scale visual sentiment ontology and detectors using adjective noun pairs [C]// Proceedings of the 21 th ACM International Conference on Multimedia. New York: ACM Press, 2013: 223.

[13] Lu Z, Wang L, Wen J R. Image classification by visual bag-of-words refinement and reduction[J].Neurocomputing, 2016, 173: 373.

[14] 文虹茜, 卿粼波, 晋儒龙, 等. 基于表情及姿态融合的情绪识别[J]. 四川大学学报:自然科学版, 2021, 58: 043002.

[15] 王化明, 刘茂兴, 熊峻峰, 等. 基于深度学习的牙刷姿态识别方法[J]. 江苏大学学报: 自然科学版, 2021, 42: 298.

[16] 李婷婷, 胡玉龙, 魏枫林. 基于GAN改进的人脸表情识别算法及应用[J]. 吉林大学学报: 理学版, 2020, 58: 605.

[17] 杨宇, 崔陶. 基于深度学习和水平集的彩色图像分割方法[J]. 四川大学学报:自然科学版, 2021, 58: 041004.

[15] 晋儒龙, 卿粼波, 文虹茜. 基于注意力机制多尺度网络的自然场景情绪识别[J]. 四川大学学报:自然科学版, 2022, 59: 012003.

[19] Chen M, Zhang L, Allebach J P. Learning deep features for image emotion classification [C]// Proceedings of IEEE International Conference on Image Processing. Piscataway: IEEE Press, 2015: 4491.

[20] Zhao S, Zhao X, Ding G, et al . Emotiongan: unsupervised domain adaptation for learning discrete probability distributions of image emotions [C]// Proceedings of the 26th ACM International Conference on Multimedia. New York: ACM Press, 2018: 1319.

[21] You Q, Luo J, Jin H, et al . Robust image sentiment analysis using progressively trained and domain transferred deep networks [C]// Proceedings of the 29th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2015: 381.

[22] Rao T, Li X, Xu M. Learning multi-level deep representations for image emotion classification[J].Neural Process Lett, 2020, 51: 2043.

[23] Tripathi S, Acharya S, Sharma R D, et al . Using deep and convolutional neural networks for accurate emotion classification on DEAP dataset [C]// Proceedings of the 31th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2017: 4746.

[24] Chen S, Wang J, Chen Y, et al . Label distribution learning on auxiliary label space graphs for facial expression recognition [C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 13984.

[25] Zhang Z, Lai C, Liu H, et al . Infrared facial expression recognition via Gaussian-based label distribution learning in the dark illumination environment for human emotion detection [J]. Neurocomputing, 2020, 409: 341.

[26] Zhao Z, Liu Q, Zhou F. Robust lightweight facial expression recognition network with label distribution training [C]//Proceedings of the 35th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2021: 3510.

[27] Geng X. Label distribution learning[J]. IEEE T Knowl Data En, 2016, 28: 1734.

[28] Geng X, Yin C, Zhou Z H. Facial age estimation by learning from label distributions[J]. IEEE T Pattern Anal, 2013, 35: 2401.

[29] He T, Jin X. Image emotion distribution learning with graph convolutional networks [C]//Proceedings of the 2019 on International Conference on Multimedia Retrieval. New York: ACM Press, 2019: 382.

[30] Peng K C, Chen T, Sadovnik A, et al . A mixed bag of emotions: model, predict, and transfer emotion distributions [C]// Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2015: 860.

[31] Xiong H, Liu H, Zhong B, et al . Structured and sparse annotations for image emotion distribution learning [C]// Proceedings of the 33th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2019: 363.

[32] Yang J, Sun M, Sun X. Learning visual sentiment distributions via augmented conditional probability neural network [C]// Proceedings of the 31th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2017: 224.

[33] Gao B B, Xing C, XIE C W, et al . Deep label distribution learning with label ambiguity [J]. IEEE T Image Process, 2017, 26: 2825.

[34] 孟祥瑞, 杨文忠, 王婷. 基于图文融合的情感分析研究综述[J]. 计算机应用, 2021, 41: 307.

[35] He K, Zhang X, Ren S, et al . Deep residual learning for image recognition [C]//Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 770.

[36] Deng J, Dong W, Socher R, et al . Imagenet: A large-scale hierarchical image database [C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2009: 248.

[37] Dosovitskiy A, Beyer L, Kolesnikov A, et al . An image is worth 16x16 words: transformers for image recognition at scale[EB/OL].[2022-07-01].https:∥ arxiv.org/pdf/2010.11929v1.pdf.

[38] Sun M, Yang J, Wang K, et al . Discovering affective regions in deep convolutional neural networks for visual sentiment prediction [C]// Proceedings of IEEE International Conference on Multimedia and Expo. Piscataway: IEEE Press, 2016: 1.

[39] Kullback S, Leibler R A. On information and sufficiency [J]. Ann Math Stat, 1951, 22: 79.