会聊天的ChatGPT具有哪些法律风险

2023-03-31刘亚

刘亚

最近,一款新的聊天机器人火了。它既能写代码写作业,能做题写剧本,还能回答各类话题——它就是美国人工智能研究公司OpenAI刚刚推出的人工智能聊天程序ChatGPT。

究竟什么是ChatGPT?这款被称为“全能AI”的软件到底多能整活?为此,《方圆》记者和ChatGPT进行了一场对话,聊了聊关于爱、永恒和法律的问题。

《方圆》记者提出问题:爱是永恒的吗?从法律的角度看,它是一种不可抗力吗?

“爱是一种强烈的情感,它可以在特定的情况下持续很长时间,但是并不能说它是永恒的。爱是一种可以变化和演变的情感,它可以随着时间和环境的改变而改变。因此,爱不能简单地定义为永恒的。”

“爱本质上不是一种不可抗力。爱是一种人类的情感,它受到我们的意识和控制能力的影响。虽然有时我们可能觉得爱是不可抗力的,但实际上它是可以通过自我意识和自我控制来管理和影响的。因此,不能说爱是不可抗力。”

可以说,ChatGPT的回答的还是不错的。所以,提问开始增加难度——比如偷走别人的心是否构成盗窃罪、结婚是否相当于被判处一辈子无期徒刑?

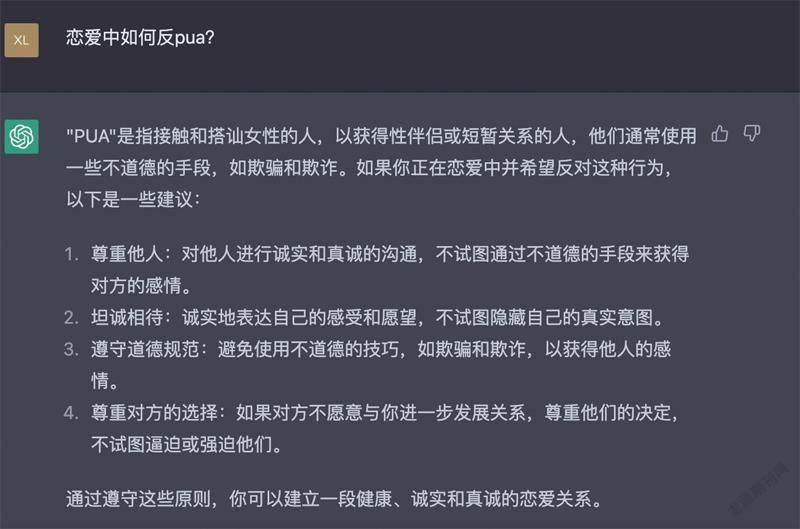

“偷走别人的心属于不道德行为,但不能简单地被视为盗窃。”“结婚是一种愿意和彼此共同生活的决定。”ChatGPT的回答令人眼前一亮。最后,我们还请ChatGPT给恋爱中的人们提了几个反PUA的小建议。

什么是ChatGPT

从简单的体验中,《方圆》记者已感受到了ChatGPT的强大。自去年11月底OpenAI将ChatGPT推出,仅两个月就达到了1亿月活跃用户,用户增长速度堪称史无前例。从最初用户程序员、工程师、AI从业者,到现在无数的普通人,大家都好奇,究竟ChatGPT是什么?

中国科学院大学人工智能学院教授、亚太人工智能学会执行主席雷渠江接受《方圆》记者采访时表示,ChatGPT是基于聊天的生成预训练转换器,是由OpenAI开发的最先进的自然语言处理(NLP)模型。它是流行的GPT-3模型的变体,GPT-3模型已经在来自各种来源(如书籍、文章和网站)的大量文本数据上进行了训练。企业和个人可以将其用于许多场景,如新闻文章、小说和诗歌的文本生成,总结较长的文件或文章,编辑故事,生成产品描述、博客文章和其他内容类型等。

(本图系《方圆》记者委托国外同学提问并截图)

“ChatGPT具有巨大的创新性,在很多方面都可以成为人们工作和生活的强有力助手。它利用从大型文本语料库中所学到的内容,可以自主生成文本,帮助用户找到问题的答案。ChatGPT除了能够模拟自然对话外,还能够执行写邮件、视频脚本、文案、翻译等任务。”雷渠江指出,不过,ChatGPT还处于早期发展阶段,引发的担忧和风险相伴而来。

北京师范大学新闻传播学院院长张洪忠在接受《方圆》记者采访时表示,对我们国家来说,除了上述风险,ChatGPT还带来巨大的技术差距,更应该思考在人工智能领域,我们能否以大计算来生成这样的大产品。不过,在对社交机器人的长期跟踪研究中张洪忠发现,社交机器人已经在社交媒体中大规模使用,存在着虚假信息、侵害著作权、泄露隐私、干扰舆论等风险。

ChatGPT可能带来法律风险

“ChatGPT能够生成类似人类的文本,因此它迅速成为广泛应用的首选工具,从语言翻译和文本摘要到问题回答等。不过也面临很多问题,如数据隐私和安全等。”雷渠江告诉记者,比如ChatGPT这样的第三方语言模型是在大量文本数据上进行训练的,并且存在一种风险,即敏感信息可能无意中包含在模型的参数中。因此,在使用像ChatGPT这样的语言模型时,采取适当的安全措施(如加密和安全访问控制)以及监视模型的输出以获取可能生成的任何敏感信息是非常重要的。

“另外,使用第三方语言模型还可能引起与数据隐私法、知识产权法和其他法规相关的遵从性问题。在法律框架下,充分理解ChatGPT的服务条款以及提供商添加的使用限制都是很重要的。”雷渠江进一步说道,ChatGPT也面临侵犯用户隐私的可能性,因为它未经用户同意就收集数据。此外,机器人抓取网站可能会侵犯版权法,主要是因为它的行为就像人工智能自己提出的信息,没有引用来源。

此外,人工智能生成的信息并不总是准确的。在江苏新天伦律师事务所律师林晓莉看来,ChatGPT常常出现“一本正经地胡说八道”的情况,需要一定的专业知识才能辨别真伪;也可能有不法分子恶意“训练”人工智能,使其提供诈骗信息、钓鱼网站等内容,损害公民人身财产安全。对于这类隐患,平台应充分提示用户其生成的内容可能为虚假信息,且在其生成疑似违法信息时进行拦截或提示用户存在安全风险。

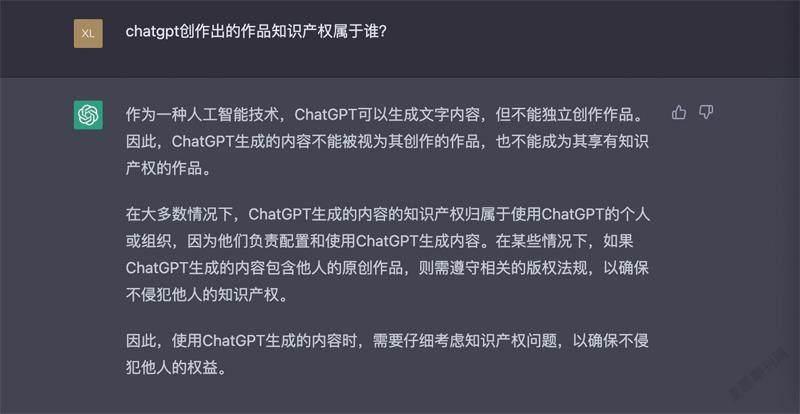

(本图系《方圆》记者委托国外同学提问并截图)

当然,《方圆》记者也问了问ChatGPT自己这个问题。可以说,ChatGPT回答非常专业。

ChatGPT生成的文字知识产权属于谁

由ChatGPT生成的文字,知識产权属于谁?“ChatGPT目前处于初期快速发展阶段,它的法律影响尚未实现。我个人观点认为ChatGPT生成的内容不牵涉著作权问题,它在中国也还未申请软件著作权,不排除未来很快进行申请进行软著保护。”雷渠江说。

那么,利用ChatGPT写论文、写模仿小说,所写的论文和小说知识产权能否归利用ChatGPT写论文和小说的人呢?

得到的回答是:作为一种人工智能,ChatGPT可以生成文字内容,但不能独立创作作品。因此,ChatGPT生成的内容不能被视为其创作的作品,也不能成为其享有知识产权的作品。在大多数情况下,ChatGPT生成的内容的知识产权归属于使用ChatGPT的个人或组织,因为他们负责配置和使用ChatGPT生成内容。在某些情况下。如果ChatGPT生成的内容包含他人的原创作品,则需要遵守相关的版权法规,以确保不侵犯他人的知识产权。

“原论文著作所有者能否认为该行为侵权是普遍存在的问题。ChatGPT是在大量数据为基础训练出来的语言处理模型,在搜集信息和数据方面是否会侵犯个人隐私、企业和组织等数据的安全问题,同时ChatGPT搜集数据的方式是否合法,也是需要思考的。”雷渠江说。

“在数据搜集方面,如果有数据是假的或者某些信息是错误的,就可能导致输出一些具有歧视性、欺骗性等结果。另外还有利用ChatGPT犯罪问题,比如犯罪分子更容易获取犯罪技巧,这将增加犯罪风险和数量。此外,还面临更深层次的伦理和道德问题——因为人工智能模型既没有伦理也没有道德,ChatGPT并不总是正确的,在数据输入、总结和输出方面会有偏差。如何平衡技术进步应用和伦理道德问题也需要思考。”雷渠江表示,针对以上所说的问题,我们还是要在保护好数据和隐私方面做好防范,正确对待ChatGPT并加强独立思考和辩证的能力。

2019年,国际保护知识产权协会(AIPPI)发布《人工智能生成物的版权问题决议》,认为人工智能生成物在其生成过程中有人类干预,且该生成物符合受保护作品应满足的其他条件情况下,能够获得保护,对于生成过程无人类干预的人工智能生成物无法获得版权保护。

(本图系《方圆》记者委托国外同学提问并截图)

今年2月,多家国内学术刊物针对ChatGPT发声。《暨南学报(哲学社会科学版)》发布关于使用人工智能写作工具的说明提到,暂不接受任何大型语言模型工具(如ChatGPT)单独或联合署名的文章。在论文创作中使用过相关工具,需单独提出,并在文章中详细解释如何使用以及论证作者自身的创作性。如有隐瞒使用情况,将对文章直接退稿或撤稿处理。《天津师范大学学报(基础教育版)》发布声明,建议作者在参考文献、致谢等文字中对使用人工智能写作工具(如ChatGPT等)的情况予以说明。

“翻墙”使用ChatGPT可能违法

随着ChatGPT爆火网络,国内用户的使用需求也与日俱增。据了解,由于OpenAI的注册限制,在国内注册ChatGPT需要满足两个前置条件,一是需要一个国外手机号来接收短信验证码,二是需要使用国外的代理服务器或VPN。第一个前置条件通过特定的在线接码平台就可以实现,而第二个前置条件基本上只能通过“翻墙”来实现。

浙江理工大学法政学院特聘副教授郭兵向《方圆》记者介绍,对于大多数“翻墙”的网民而言,或许并知道,在我国即便使用“翻墙”软件也构成违法。实践中,已经有许多地方的网民因为使用“翻墙”软件上网而被公安机关处罚。公安机关处罚的依据是《计算机信息网络国际联网管理暂行规定》,其中第六条规定:“计算机信息网络直接进行国际联网,必须使用邮电部国家公用电信网提供的国际出入口信道。任何单位和个人不得自行建立或者使用其他信道进行国际联网。”而第十四条规定:“违反本规定第六条、第八条和第十条的规定的,由公安机关责令停止联网,给予警告,可以并处15000元以下的罚款;有违法所得的,没收违法所得。”

“相对于‘翻墙注册使用ChatGPT的网民而言,提供‘翻墙服务的个人或者组织面临的法律责任更为严重。”郭兵进一步指出,实践中,有大量为用户提供“翻墙”访问而被追究刑事责任的案件,有的被认定为非法经营罪,有的被认定为提供侵入、非法控制计算机系统程序、工具罪。所以,对于那些试图通过山寨版ChatGPT等进行流量变现的个人或者组织,一定要意识到“翻墙”或者提供“翻墻”服务的不利法律后果。

不过,在大多数人还对ChatGPT云里雾里时,国内已涌现出了一批山寨小程序。由于国内注册使用限制,网上各种注册使用ChatGPT的“指南”不断推出,各种山寨版小程序充斥于各类网络平台。《方圆》记者在微信平台上搜索“ChatGPT”,就能看到“ChatGPT AI”“Chat人工智能问答”等数十个公众号搜索结果,甚至还有“ChataGTP”这种“山寨版”账号。随机挑选一个,系统均提示需充值额度后才可继续使用。不过近期,各大平台也明显加大了对山寨版ChatGPT的处置力度。

需警惕ChatGPT山寨版

在雷渠江看来,由于ChatGPT的火热,山寨版的小程序已经出现很多了,很多时候这种情况会跟诈骗,骗取个人信息等手段联系在一起。使用时一定要擦亮眼睛,使用正版程序。另外,我们应提高著作权保护意识,完善法律法规,更好地进行普法宣传,增强法律意识。

“同时,行业组织也可以在规制山寨问题方面起到一定作用,比如我们亚太人工智能学会、中国人工智能学会等学术组织可以进行正确的引导,开展适当宣传等工作,引导企业和个人正确使用ChatGPT程序,保护知识产权,避免山寨。行业组织也可以制定相应的行业标准,合理合法使用ChatGPT程序和应用场景。”雷渠江说。

除了山寨版ChatGPT需要警惕,其暴露出的法律风险亦需要及时应对。2018年7月,中国科学院软件研究所联合15家产学研单位共同编制首个国内人工智能深度学习算法标准《人工智能深度学习算法评估规范》。这一规范基于深度学习算法可靠性的内部和外部影响,结合实际应用场景,确定了由7个一级指标和20个二级指标组成的算法可靠性评估指标体系,做了场景化和精细化算法治理实践的有益尝试。

2022年出台的《互联网信息服务算法推荐管理规定》明确要求,人工智能的算法应当坚持社会主义主流价值观,不能利用算法危害国家安全和社会公共利益、扰乱经济秩序和社会秩序、侵犯他人合法权益。今年1月10日起施行的《互联网信息服务深度合成管理规定》明确,任何组织和个人不得利用深度合成服务制作、复制、发布、传播法律、行政法规禁止的信息,不得利用深度合成服务从事危害国家安全和利益、损害国家形象、侵害社会公共利益、扰乱经济和社会秩序、侵犯他人合法权益等法律、行政法规禁止的活动。

在上海政法学院人工智能法学院副教授郭金兰看来,对人工智能的监管,需要深入人工智能系统的整个生命周期,从模型的建立、语料库的标注、模型训练、投放市场后的迭代进化直到系统退出使用。监管需要关注到每个具体的环节,包括语料库的筛选标准制定、参与人工标注的人员培训、开发者的价值观考察等。对ChatGPT这类生成式人工智能的监管必须将算法监管和数据监管结合起来。在算法监管机制的未来探索中,应充分考虑算法决策的主体类型和作用类别,探索场景化和精细化的算法治理机制。