自注意力引导的红外与可见光图像融合算法

2023-03-05王天元罗晓清张战成

王天元,罗晓清,张战成

(1.江南大学 人工智能与计算机学院,江苏 无锡 214122;2.苏州科技大学 电子与信息工程学院,江苏 苏州 215009)

0 引言

图像融合是一种图像增强技术,旨在合并通过不同类型的传感器获得的多幅图像,来生成一幅鲁棒性更好,信息更加丰富的图像,便于源图像的进一步的后处理[1],图像融合技术被广泛应用于遥感[2],医学[3]和军事[4]等领域。红外与可见光图像融合是该领域的一项重要课题,红外图像可以获取到物体的热辐射信息,而可见光图像可以获取到更多的细节信息,这两种类型的图像可以提供具有互补属性的不同方面的场景信息[5]。红外和可见光图像融合的目标是得到一张既保留了红外图像中目标突出的区域,又具有可见光图像中丰富细节信息的融合图像。

在过去的几十年中,许多传统的图像融合方法被提出,这些图像融合算法大致可以分为两类,即空间域算法和变换域算法。空间域算法[6]首先根据某种策略将源图像划分为若干个图像块,然后对每对图像块根据计算活动度量融合在一起。而变换域图像融合算法[7]首先通过多尺度几何分解将源图像分解为具有不同频带的子图像,然后根据分解后的频带系数的特征设计融合规则,最后通过相应的逆变换获得融合图像。这些方法虽然都取得了一定的效果,但都存在着一些缺陷,例如空间域算法的结果取决于图像块的选择,在不同明暗的图像上具有较大的差别;而变换域算法需要选择多尺度分解方法并手工设计融合规则,无法在多种场景下都自适应地取得好的效果。

近年来,深度学习技术已广泛应用于各种计算机视觉任务,并在图像融合领域取得了显著效果。例如Liu 等人[8]将多焦点图像融合问题转化为基于卷积神经网络的二进制分类问题。在其第一阶段,根据图像块的模糊程度,对许多带有聚焦和未聚焦标签的小图像块进行分类器训练。然后,由训练好的分类器预测标签图,并通过基于该图的得分情况融合图像。但是在红外和可见光图像融合任务中难以预测标签图,原因在于红外和可见光图像具有不同的模态,并且其特征在模态和图像场景之间存在很大差异,因此,Liu 的方法不能直接用于融合红外和可见光图片。之后,Ma等人[9]提出了一种基于生成对抗网络的无监督融合模型,通过生成器和鉴别器的对抗游戏,生成了基于红外光和可见光的融合图像并获得更多可见光图像中的细节信息,但是在生成器和鉴别器的对抗学习中,图像的一部分细节信息会丢失,这不利于最后的融合结果。同年,Li 等人[10]利用密集卷积网络来融合红外和可见光图像,图像特征的跳跃链接可以很好地保留源图像的细节信息,但是在融合过程中没有很好地考虑源图像特征的内部相关性,手动融合规则的设计使得最后的融合结果并不完美。这些基于深度学习的融合方法的不足主要表现在:①根据网络中某一层的输出来设计融合策略,忽略了其他层的重要信息;②受卷积神经网络感受野维度的限制,很难提取图像中的长距离依赖;③忽略了人眼主观感知对融合结果的需求。

在卷积神经网络,由于卷积一般是局部操作,受到感受野大小的限制很难提取到图像中长距离依赖。一般的策略是增加网络深度或扩大卷积核的尺寸,然而这种处理方式并不高效,会使网络的训练参数大幅度增加,失去参数迭代的效率优势。2017年,Wang 等人[11]提出了非局部神经网络,计算图像中某个位置的响应时,考虑到所有位置的加权。通过结合自注意力模型和卷积运算,来捕获特征图像间的中长距离依赖关系,有效地提取图像特征,加强特征间的联系。Zhang 等人[12]将自注意力机制引入到生成对抗网络中,通过加强特征图各局部位置和全局位置的联系,使生成对抗网络在多类别图像上生成高质量图像。自注意力机制不仅能够捕捉全局的信息来获得更大的感受野和上下文信息,而且将所有位置的特征加权和作为单个位置的注意力度,在建立长距离依赖模型和提高计算效率间实现平衡。杨等人[13]提出了一种注意力机制的多波段图像特征级融合方法,该方法通过特征图与注意力权重图的点乘和相加获得特征增强图,在保留背景信息的同时增强了细节特征。Jian等[14]提出了一种具有残差块的对称自编码网络,根据训练网络获得的模型提取红外图像和可见光图像的中间特征,并将根据中间特征手工生成的注意力图与输入特征均值融合后输入解码层重构得融合图像。然而,杨等的方法[13]通过注意力机制对特征图进行增强,未利用注意力图获取特征间长距离依赖关系的特性进行特征融合;Jian 等的方法[14]利用注意力图设计了加权平均的融合策略,但注意力引导机制仅在测试阶段进行,设计的融合策略无法适合所有图像场景,不能保证注意力图的有效性。

在图像融合任务中,建模源图像间图像特征的全局信息至关重要。受此启发,本文提出了一种自注意力引导的红外与可见光图像融合算法。在训练阶段,通过密集卷积网络可以更好地提取图像的特征,在融合阶段,基于自注意力机制设计了平均融合策略,这使得本文方法的特征在融合时既包含特征图上的全局信息又包含源图像之间的特征通道信息,最后根据注意力图调整损失函数,以期获得更好的融合效果,提高融合图像的质量。

1 本文算法

1.1 网络结构

本文算法的网络架构主要由生成器和鉴别器两部分组成。生成器的网络结构如图1 所示,由编码层,融合层和解码层组成。编码层包含红外图像分支和可见光图像分支,每个分支包括5 个可训练的卷积层,卷积核大小为3×3,为了保留图像的细节信息,本文的编码器的前4 个卷积层中添加了密集的短连接操作。融合层将编码层输出的特征图插入到3 个可训练的卷积层中,其卷积核大小为1×1,并通过矩阵运算和softmax 函数获得红外图像和可见光图像的注意力图,根据平均加权策略融合红外和可见光的特征图。解码层包含3 个可训练卷积层,卷积核大小为1×1。由于每次下采样会丢失源图像中的细节信息[9],因此,本文网络中只含有卷积层,而不进行下采样操作,故将每层的步幅设置为1,除此之外,每个卷积层都使用批标准化[15]和Leaky ReLU 激活函数,而最后一个卷积层使用tanh 激活函数来输出融合图像。

图1 生成器的网络结构Fig.1 Network architecture of generator

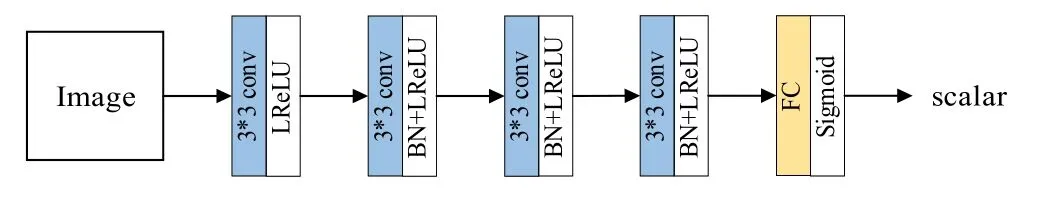

鉴别器的网络结构如图2 所示,由4 个卷积层和1 个全连接层组成,所有卷积层的卷积核大小均为3×3,并将内核步幅设置为2,用于提取输入图像的特征图,然后将它们的特征图递送至全连接层进行处理,输出该图像来自真实图像还是融合图像的概率。由于鉴别器与生成器具有对称性,故鉴别器的第一个卷积层中仅使用Leaky ReLU 激活函数,而其他卷积层使用批标准化和Leaky ReLU 激活函数,对于最后一层,最终输出的是图像来自真实图像还是融合图像的概率,因此,最后一层使用Sigmoid 激活函数。

图2 鉴别器的网络结构Fig.2 Network architecture of discriminator

1.2 基于自注意力机制的融合规则

大多数基于神经网络的图像融合方法一般使用卷积层搭建网络架构,然而由于卷积操作在局部区域处理信息,仅利用卷积层对于图像中长距离的依赖关系无法进行良好的建模。在本文中,改进了Zhang 等人[12]的自注意力生成对抗网络,使红外和可见光图像在空间域上建立有效的关系模型。

如图3 所示,定义编码层的输出为,x∈RC×H×W其中C,H和W是编码层输出特征图的通道数,宽和高。首先将x转换至f,g和h的特征空间中,如式(1)所示:

图3 融合层框架Fig.3 Fusion layer framework

式中:Wf、Wg和Wh是1×1 卷积层的可学习权重矩阵,然后对特征空间f,g和h进行维度转换,将它们的维度变为C×N,即f(x),g(x),h(x),x∈RC×H×W,其中N=H×W。接下来,计算f(x)、g(x)的自相关矩阵并将其进行标准化,如式(2)所示:

式中:Si,j=f(xi)T·g(xi),βj,i表示特征图中第j个像素点对第i个像素点的影响,这样可以获得一个N×N的自注意力图β。在本文的网络中,红外图像和可见光图像分别获得一个注意力图βir和βvr,最后利用加权平均融合策略结合自注意力机制获得注意力层的输出,如式(3)所示:

式中:δ是可学习的标量,并将其初始化为0。

1.3 损失函数

本文方法的损失函数由两部分组成,分别是鉴别器损失LD和生成器损失LG。鉴别器的损失只包含对抗损失,本文方法使用的是交叉熵损失来充当对抗损失,鉴别器的对抗损失如式(5)所示:

式中:Igt和If分别表示的是真实图像和融合图像;D(Igt)是真实图像通过鉴别器输出的概率值;D(If)是融合图像通过鉴别器输出的概率值。生成器的损失包括对抗损失,内容损失和感知损失,生成器的损失如式(6)所示:

式中:内容损失Lcon和对抗损失Ladv旨在获得一幅视觉良好,细节丰富的融合图像,而感知损失Lper可以使融合图像获取到更多源图像中的细节信息。在公式中,α,γ和ε用于平衡不同的损失函数,下面分别介绍这3 个损失函数。本文生成器的对抗损失采用的是与鉴别器的对抗损失相对应的交叉熵损失,生成器的对抗损失如式(7)所示:

式中:D(If)与式(5)相同。内容损失是测量融合图像与真实图像之间的距离,相似度计算算法SSIM(x,y)是用于计算两个图像x和y之间的亮度,对比度和结构差异的值,本文使用的SSIM 来构造内容损失函数:

式中:If为融合的图像;Igt为真实图像。感知损失是融合图像与真实图像高级特征图之间的均方差,在本文中,使用在ImageNet 上预训练VGG19 网络最后一个池化层前的特征图来构造感知损失,公式如下所示:

式中:C、W和H表示特征图的通道数、高度和宽度;ϕf和ϕgt分别表示融合图像和真实图像的特征图。

2 实验

多焦点图像数据集与其他类型的图像数据集相比,更容易生成真实图像,更重要的是,当使用多焦点图像数据集训练模型时,该模型可以更好地完成红外和可见光图像的融合[16]。因此,在本文中,通过对NYU-D2 数据集[17]的训练序列进行统一采样,构建了大规模的训练集,该训练数据集由大约50000 对RGB图像组成,所有这些图像已调整为120×120。此外,本文从TNO 数据库中选择所有红外和可见光图像对作为测试数据,测试数据集由43 对红外和可见光图像组成。

为了评估本文提出算法的融合性能,我们与基于卷积稀疏表示的图像融合方法(convolutional sparse representation,CSR)[18],基于梯度转移的图像融合方法(gradient transfer fusion,GTF)[19],基于密集卷积网络的图像融合方法(DenseFuse)[10],基于卷积神经网络的通用图像融合框架(image fusion with convolutional neural network,IFCNN)[16],基于生成对抗网络的图像融合方法(fusion with generative adversarial network,FusionGAN)[9],基于双鉴别器生成对抗网络的图像融合方法(dual-discriminator conditional generative adversarial network,DDcGAN)[20]和基于残差块的对称自编码网络的图像融合方法(symmetric encoderdecoder with a residual block fusion,SEDRFuse)[14]进行实验结果的对比,这7 种方法的实现都是公开可用的,它们的参数均使用文献中的默认参数,其中训练的数据集与本文算法相同。本文算法中参数α,γ,ε设置如下:α=1,γ=100,ε=1,优化器为Adam,学习率为0.0001,在tensorflow 中实现并在NVIDIA GTX 1080Ti 的平台上训练和测试。

2.1 主观评价

本文选择TNO 数据集中的两对图像(Kaptein_1123 和Marne_04)为例进行主观评价。

如图4 所示,从热红外目标的显著上检视,由于FusionGAN 中鉴别器将可见光图像作为鉴别器的真实图像,故丢失了大量红外目标信息,融合图像中红外目标较模糊;DDcGAN 中具有两个鉴别器,融合图像比FusionGAN 突出显示红外目标,但由于对抗性损失的复杂性,双重鉴别器难以达到纳什平衡,DDcGAN 的融合图像红外目标仍然模糊;CSR 和GTF的融合图像中缺少地砖纹理的表达;我们的方法在全局纹理和目标显著性方面比较均衡。

图4 场景1 融合效果Fig.4 Image fusion results (Scene 1)

图5 进一步放大显示融合图像中其他部分的细节信息,可以看到,DenseFuse 和IFCNN 由于其手动调整融合规则的优越性,DenseFuse 和IFCNN 的融合图像具有较高的对比度热目标,然而,预训练网络提取的特征具有不确定性,丢失大量源图像的纹理细节信息,例如车窗和树木;CSR,GTF,FusionGAN 和DDcGAN 的融合图像保留了部分的细节信息,但其融合图像较为模糊;SEDRFuse 与本文所提出的方法同样使用了自注意力图进行融合,保留了较好的纹理信息和红外目标信息。本文方法的融合结果包含了更多的红外目标区域和纹理细节信息,并且很好地保留了图像的显著区域,对一些微弱的边缘也起到了增强的效果,融合的结果对不同清晰度的图像具有较强的鲁棒性,但在图像部分区域重建的过程中,由于注意力学习的误差,存在过度增强,例如图5 中天空和云朵的融合效果,需要进一步改进。

图5 场景2 融合效果Fig.5 Image fusion results (Scene 2)

2.2 客观评价

本文采用了熵(Entropy,EN),标准差(standard deviation,SD),相关系数(correlation coefficent,CC),空间频率(spatial frequency,SF),平均梯度(mean gradient,MG),边缘强度(edge intensity,EI)作为评价指标对融合效果进行客观评价。EN 用于测量图像信息,SD 用于衡量图像中的灰度值分布,CC 测量两图像之间的线性相关程度,SF 能够衡量图像的纹理细节信息,MG 用于计算图像的梯度信息,EI 是指边缘与邻近像素的对比强度,所有评价指标的值与图像的融合质量成正比例关系。

表1 中给出了测试集中所有图片客观评价指标的平均值,所提出的方法能够在评估指标SF,MG 和EI上获得最大的平均值,这进一步说明本文算法感知损失的细节留存与自注意力机制的注意力分配的重要作用;对于EN,本文的方法仅次于DDcGAN,这是由于DDcGAN 中双鉴别器的作用,可以使融合图像尽最大可能地获得源图像的细节纹理信息,融合图像的信息更丰富,信息量更大;对于SD,本文的方法仅次于DDcGAN,这说明本文的方法融合图像有较好的主观视觉效果;对于 CC,本文的方法仅次于DenseFuse,这是由于DenseFuse 手动设计了更适合红外与可见光图像融合的融合规则,使融合图像与源图像的线性相关性更高。

表1 不同融合方法的客观评价结果Table 1 Objective evaluation results of different fusion methods

综合对红外和可见光图像数据集定性和定量的评估结果表明,本文算法使用的自注意力机制使网络对热辐射目标和纹理细节分配更多的关注,同时损失函数中的内容损失和感知损失使源图像更多的细节信息留存在融合图像中。

2.3 自注意力机制可视化分析

为了更好地了解自注意力机制学习的内容,验证网络学习到每个点的长距离依赖的可靠性,本文对自注意力机制进行了可视化,如图6 所示。

对于每对输入图像,选择两个点,并在接下来的两列中显示它们对应的注意力图,注意到位置注意模块可以捕获清晰的语义相似性和长距离关系。例如,对于图6(a),红点标记在人上,图6(b)显示了人所在的大部分区域,而蓝点标记在墙壁上,图6(c)不仅突出显示了墙壁的区域,还获得了大部分人所在的区域,对于图6(d),红点标记在墙壁边缘上,图6(e)突出显示了与墙壁边缘梯度相似的区域,蓝点标记在草丛和墙壁的边缘上,图6(f)显示了草丛和墙壁的大多数位置。第二组图像也是如此,红外图像的注意力图不仅可以获得标记的区域,还可以获得大多数红外目标的区域,而可见光图像的注意力图可以尽最大可能地获取到标记的区域,还可以获得图像中梯度相似的区域。从图中可看出,本文算法能够根据颜色和纹理的相似性分配注意力,这进一步验证了本文自注意力机制的有效性。

图6 TNO 数据集上自注意力模块的可视化结果Fig.6 Visualization results of the self-attention module on TNO dataset

3 结论

本文提出了一种自注意力引导的红外和可见光图像融合算法,采用端到端无监督训练方式,简化了传统图像融合算法中活动水平测量和权重分配的复杂性。为了强化特征表达能力和关键信息提取能力,引入了自注意力机制至融合网络中与卷积操作形成互补以在获取局部特征的同时捕获图像中的长距离依赖。特别的是,本文设计了3 个损失函数和网络结构以改善融合性能。在TNO 数据集上,从定量和定性层面,与7 种主流融合算法对比检验了本文算法在保留红外图像中的热辐射目标和保留可见光图像中丰富的纹理细节的能力。