基于核扩展字典学习的目标跟踪算法研究

2022-12-18王员云杨文烩习帅斌章利民邓承志

王员云,杨文烩,习帅斌,章利民,尹 鹏,邓承志

(南昌工程学院 信息工程学院,江西 南昌 330099)

目标跟踪作为计算机视觉领域的重要研究分支之一,其任务是估计目标在视频序列中每一帧中的状态。目标跟踪在交通监控、自动驾驶[1]、人机交互[2]以及海洋侦查[3]等领域得到广泛的应用。虽然该技术正在快速发展,但由于受到局部遮挡、形变、运动模糊以及快速移动等因素的影响,目标跟踪在实际应用中仍然是一个非常具有挑战性的任务[4]。

目标跟踪基本框架由以下4个部分组成[5]:特征模型、运动模型、表观模型以及更新模型。特征模型利用相关技术提取目标的特征进行目标表示,并且用于建立表观模型。常用于目标跟踪的特征有颜色特征[6]、深度特征[7]、纹理特征[8]。在目标跟踪中,需要根据提取的特征判断候选区域是否为被跟踪的目标,因此,对跟踪目标的表观建模尤为重要[9]。基于目标的表观模型,目标跟踪算法可以分为生成式模型方法[10]和判别式模型方法[11]两大类。生成式模型方法通过在当前帧提取特征对目标进行外观建模,然后在下一帧中搜索与模型最匹配的区域,用这个区域就确定所预测的目标位置[12]。与生成式模型方法不同,判别式模型方法是将目标跟踪看作一个二分类问题[13],通过学习一个分类器将目标从背景环境中区别出来,因此基于判别式模型的目标跟踪方法很大程度上取决于特征空间上目标与背景的可分性。

近年来,许多高效、鲁棒的跟踪算法被提出。Mei[14]等人将稀疏表示方法应用在目标跟踪中,该算法对局部遮挡和噪声的影响等具有较好的鲁棒性。然而,在跟踪过程中需要解决L1最小化问题,当出现严重遮挡时,该算法跟踪性能不够理想。在文献[15]中,提出了一种基于稀疏的协同目标表示方法,该方法充分结合了生成式模型方法和判别式模型方法的优点。相关滤波算法[16]在跟踪速度上的优势受到了广泛关注,被成功应用于目标跟踪中。在文献[17]中,提出的CSK算法利用循环矩阵的性质进行密集采样,提高跟踪性能。随后越来越多的研究者通过从特征选择、正则化入手将相关滤波引入目标跟踪领域。Henriques[18]等人在特征选择方面上对CSK算法进行改进,提出了KCF算法,KCF算法将CSK算法使用的灰度特征改进为HOG特征和高斯核函数。然而,问题仍未得到有效解决,如光照变化、遮挡以及相似背景等。

深度卷积神经网络[19]因其在特征提取方面优越的性能而受到广泛关注。文献[20]提出了一种全卷积孪生网络的目标跟踪算法,利用该网络结构,将与模板最相似的候选目标作为跟踪目标,该算法取得了实时的速度与较好的跟踪精度。文献[21]在孪生网络的基础上加入区域提议网络,更好地对目标尺度进行估计[22],提高了跟踪的鲁棒性。最近,字典学习被广泛应用于人脸识别、目标跟踪等领域。字典学习一般是在给定一组训练样本的基础上,通过学习得到字典,为每个训练集找到最佳表示并使表示更加具有区分性[23]。

针对上述问题,本文提出了基于核扩展字典学习的目标跟踪算法。首先,将提取的特征经过核判别分析(Kernel Discriminant Analysis,KDA)[24]进行投影得到在非线性子空间中的特征向量。在视频的第一帧,在被跟踪的目标的较小的领域中收集一组与目标相同大小的图像块,经过KDA投影后得到一组特征向量,这组特征向量分别构成基础字典和核扩展字典[25],分别表示目标的信息和目标表观变化。在后续的跟踪中,连续核扩展字典进行更新,以适应不断变化的目标表观。将投影得到的基础字典和经过投影、更新后的核扩展字典联合进行目标候选块的表示,也就是每个目标候选块可以表示为这两种字典的一个线性组合。基于这种目标表示方法,本文提出了一种新的目标跟踪算法。通过表观模型得到的扩展字典在核空间中可有效地表示可能的目标表观变化,将基础字典与扩展字典相结合可以更准确地表示目标候选块。基础字典中保留了更多的目标初始信息,有效防止了目标漂移现象。核扩展字典在不断更新的过程中,包含了目标的多种表观变化,提升了目标表观模型的自适应能力。本研究主要贡献如下:

(1)提出一种基于基础字典和扩展字典联合表示的目标表观模型。将目标特征向量经过KDA投影获得在非线性子空间中的特征表示;收集一组字典样本并经过KDA投影后得到基础字典和扩展字典;基于基础字典和扩展字典联合进行目标候选块的近似表示。

(2)在粒子滤波框架下,提出一种新的目标跟踪算法。基础字典中保留了更多的目标初始信息,有效地减轻了目标漂移现象。扩展字典在不断更新的过程中,包含了目标的多种表观变化,提升了目标表观模型的自适应能力。在挑战性的数据集上的测试与对比结果表明所提出的跟踪器有较好的鲁棒性。

1 核扩展字典学习与目标跟踪

在目标跟踪中,首要的任务是建立鲁棒的目标表观模型。本文提出一种基于核的基础字典与扩展字典的目标表示方法,并在粒子滤波框架中设计基于该目标表示的跟踪算法。接下来将主要介绍粒子滤波框架、基于基础字典与扩展字典的目标表示以及目标候选块的似然估计等。

1.1 粒子滤波

粒子滤波器是一种顺序重要性采样方法,通过在状态空间中选择一组随机样本来近似表示概率密度函数,并且利用样本的平均值取代积分运算来获得最小方差估计,这些样本被称为“粒子”。在目标跟踪过程中,每个目标候选块可以看成是一个“粒子”,在获取一组图像观测向量y1:t=[y1,y2,…,yt]后,通过计算粒子的后验概率进行目标状态估计。

(1)

(2)

式中yt为时间t中的状态变量。基于目标候选粒子的权重,相应的目标在当前帧的状态可表示为

(3)

1.2 基于核扩展字典的表观模型

本文提出一种基于基础字典与扩展字典的目标表示方法,并在粒子滤波框架下设计一种目标跟踪算法。首先,通过一组训练样本学习获得核判别分析函数KDA。收集一组目标模板样本经过核判别分析投影得到基础字典,收集目标表观变化样本经过核判别分析投影后得到核扩展字典。最后,使用基础字典和扩展字典中的原子线性组合进行候选目标的近似表示。下面将介绍核判别分析函数,设在非线性映射空间F中,φ为非线性映射函数,核函数在特征空间F上定义为

〈φ(z),φ(z′)〉=k(z,z′),

(4)

式中k(z,z′)为核函数。设有一组训练样本为Z=[Z1,Z2,…,Zn]∈Rd×n,使用Z中的n个样本进行KDA的映射向量的学习,学习后得到的映射向量表示为

(5)

式中α·=·[α1,α2,…,αn]T是KDA的系数向量。

核空间的样本z可以通过KDA进行投影,其在核空间的内积可以由核函数计算得到,表示如下:

(6)

在基于基础字典与扩展字典的目标表示方法中,使用训练集Z中的前n-m个样本作为基础字典的训练样本,后m个样本作为扩展字典的训练学习样本。该m个样本主要用于表示目标的表观变化,在后续帧的跟踪中,需要进行连续的更新。在特征空间F中该m个样本的协方差表示为

(7)

(8)

将训练集Z=[Z1,Z2,…,Zn]∈Rd×n中的前n-m样本通过KDA投影构建基础字典,如式(9)所示:

D1=〈vφ,φ(Z)〉,

(9)

(10)

在跟踪过程中,首先将目标候选块y通过KDA投影获得相应的特征向量,如式(11)所示:

Y=〈vφ,φ(y)〉.

(11)

为了更好地适应目标表观变化,同时又保持更多的目标信息,使用基础字典和扩展字典联合表示目标候选块y为

(12)

式中δ>0为标量常数;D=[D1,D2]用于对目标候选块进行重建;β=[β1,β2]T是字典D的系数。在以往的目标表示中,一般都是将Y看成是字典矩阵D和稀疏系数β的线性组合,如如式(13)所示:

(13)

为了更好地处理局部遮挡、噪声等的影响,本算法中使用稀疏约束进行目标候选块的近似估计,针对式(12)的求解中,可以将其看成经典的LASSO问题进行求解。

1.3 似然估计

提出的基于核扩展字典学习的目标跟踪算法中,使用基础字典与扩展字典中的原子的线性组合来近似表示候选目标。候选目标y的观察概率通过候选目标与目标模型之间的重构误差来计算,如式(14)所示:

ρ(Y∣z)=σexp {-θd(Y,Dβ)},

(14)

其中,δ>0和θ>0是标量常数。d(Y,Dβ)是候选目标y与字典中原子线性组合的近似表示Dβ之间的距离,也就是它们之间的重构误差,计算如式(15)所示:

d(y,Dβ)=(Y-Dβ)T(Y-Dβ).

(15)

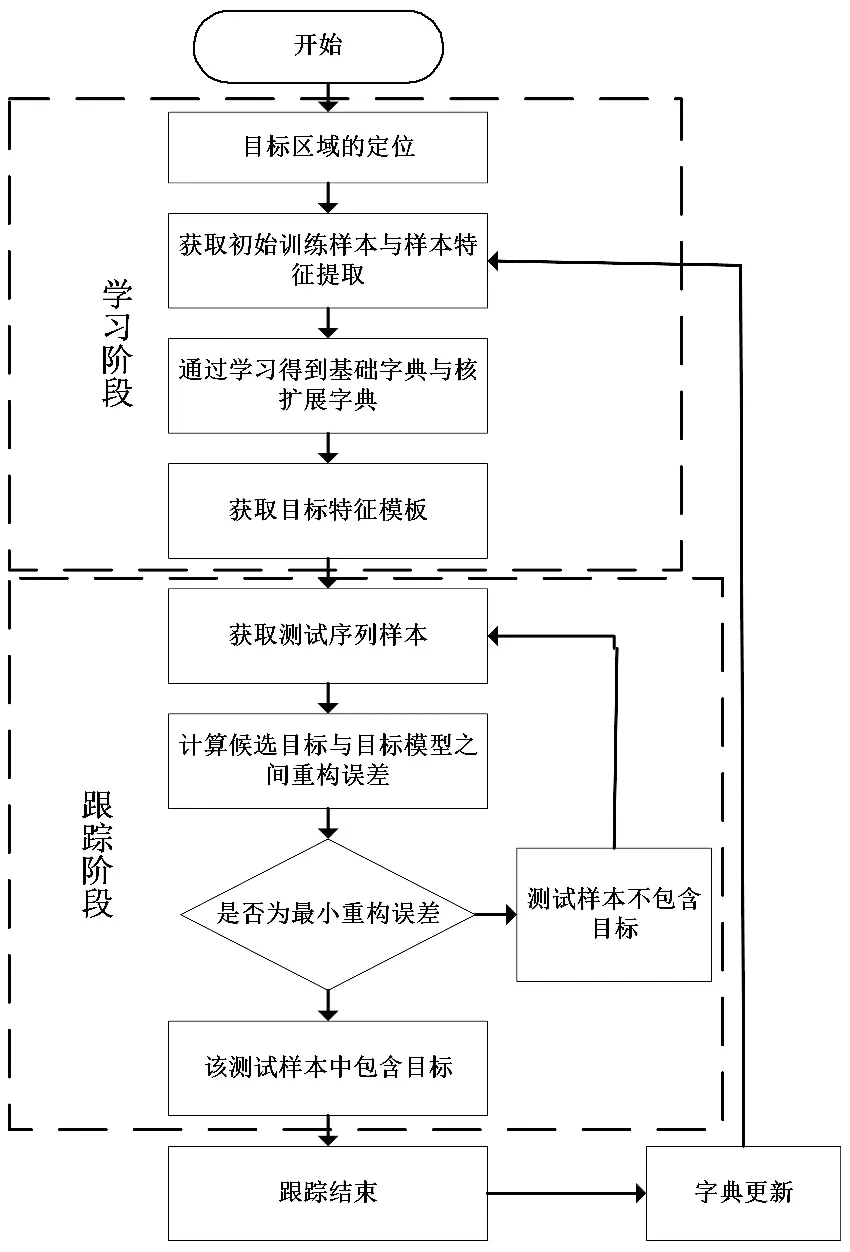

在基于核扩展字典的表观模型和似然估计的基础上,本文提出一种新的跟踪算法(跟踪算法流程如图1所示)。在第一帧中,在被跟踪的目标周围收集n个图像块作为初始训练样本,用初始训练样本进行学习得到KDA。由前n-m个样本学习得到基础字典,训练样本中的后m个样本通过KDA投影得到核扩展字典。在之后的跟踪过程中,获取到当前跟踪结果后,对训练样本中的后m个样本进行更新,也就是将当前帧的跟踪结果对应的图像块作为新的样本加入扩展字典的训练样本中,同时删除原样本中系数权重最小的样本。当前帧的跟踪结果作为样本加入扩展字典学习样本集中,更多地包含了目标的表观变化,进一步提升了目标表观模型的自适应性。

图1 跟踪算法流程图

2 实验结果与分析

在这一节,使用视觉跟踪标准数据集OTB2015[26]对跟踪器的性能进行测试,同时介绍实验数据集、评估指标,并对实验结果进行定量和定性分析。在Windows系统平台下使用Matlab2018b开发环境实现本文提出的跟踪算法,相应的硬件配置为Intel(R)Core(TM)i5-6300HQ 2.30GHZ处理器和8GB内存。在粒子滤波框架中,若粒子数过多,则会影响跟踪器的时效性;若粒子数过少,则会降低跟踪器的准确率。综合考虑,每帧中的粒子数设置为300。确保跟踪器的有效性和时效性,并通过大量实验表明,在第一帧中,选取25个训练样本,其中前5个为基础字典的学习样本,后20个样本作为扩展字典的训练样本。在后续帧的跟踪,每帧都进行扩展字典样本的更新并重新投影得到新的扩展字典。

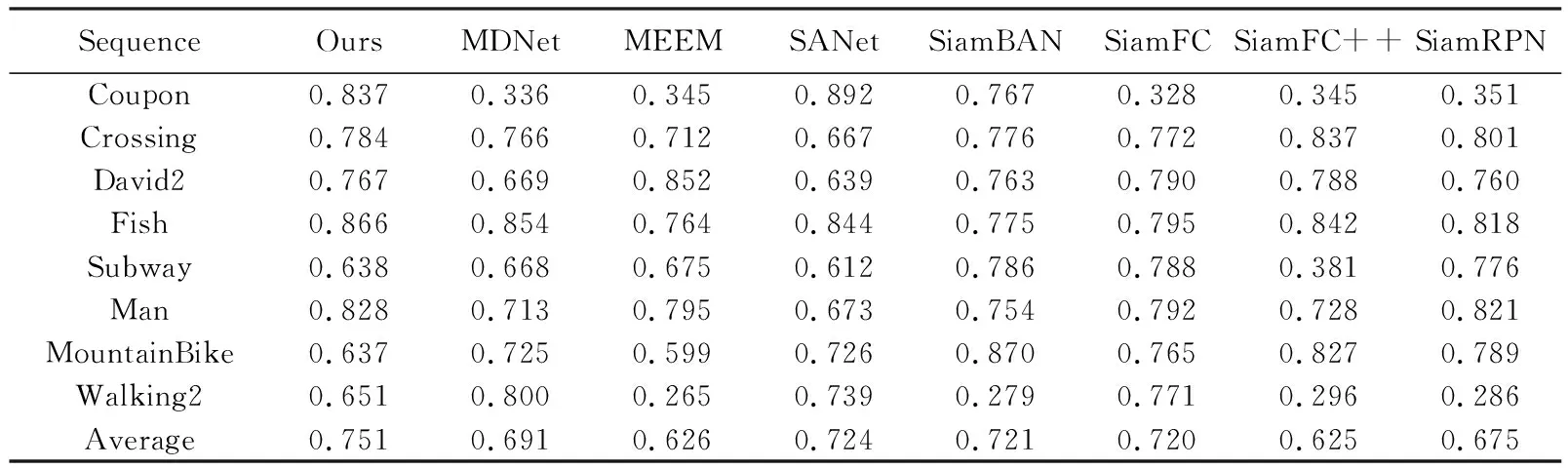

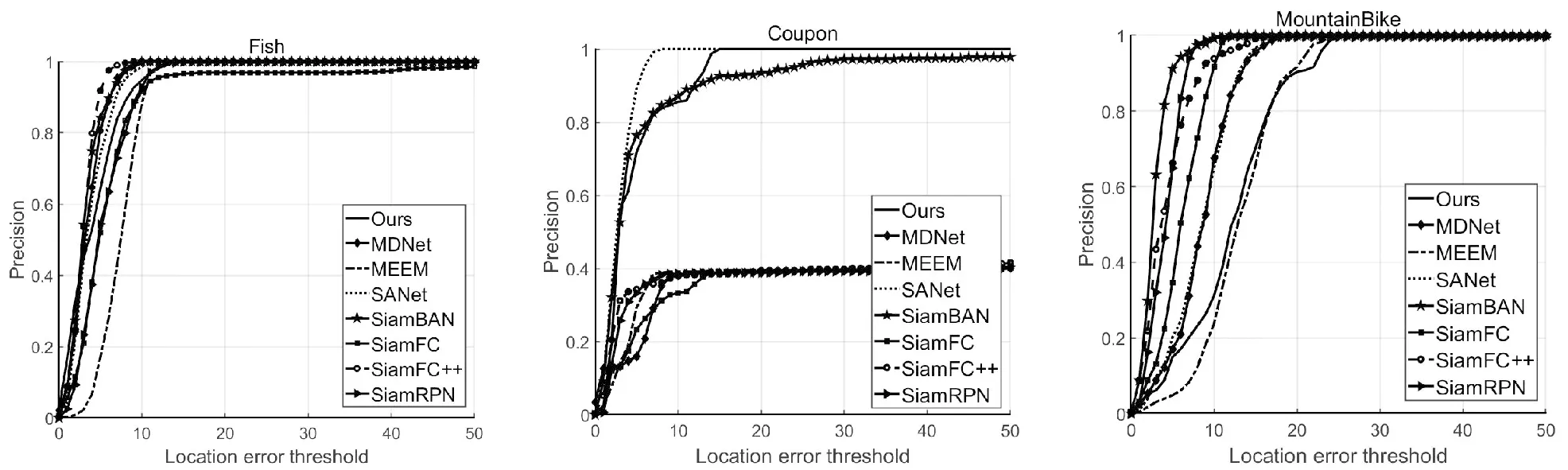

本文在OTB2015视觉跟踪数据集中选择了8个视频序列进行了实验对比。这些视频序列包括了多种目标外观变化,例如光照变化、部分遮挡、相似的背景、快速运动以及平面内外旋转等。并将所提出的跟踪算法与当前一些流行的跟踪算法进行比较,对比算法包括MDNet[27]、MEEM[28]、SANet[29]、SiamBAN[30]、SiamFC[20]、SiamFC++[31]和SiamRPN[21]。实验结果采用平均重叠率和跟踪成功率两种评估指标进行定量分析。平均重叠率是跟踪目标框与目标真实值的交集与并集的比值,而成功率是在不同阈值下的成功跟踪的比率。通过这两种评估指标验证跟踪器的有效性,定量分析和定性分析跟踪结果如图2~3所示。其中定量分析是通过平均重叠率和跟踪成功率两种评估指标的具体实验数据对跟踪性能进行分析。在定量分析的基础上,针对不同的跟踪算法进行定性分析,进行不同算法的优劣性能的对比,分析跟踪算法针对不同挑战因素的处理能力等。

2.1 定量分析

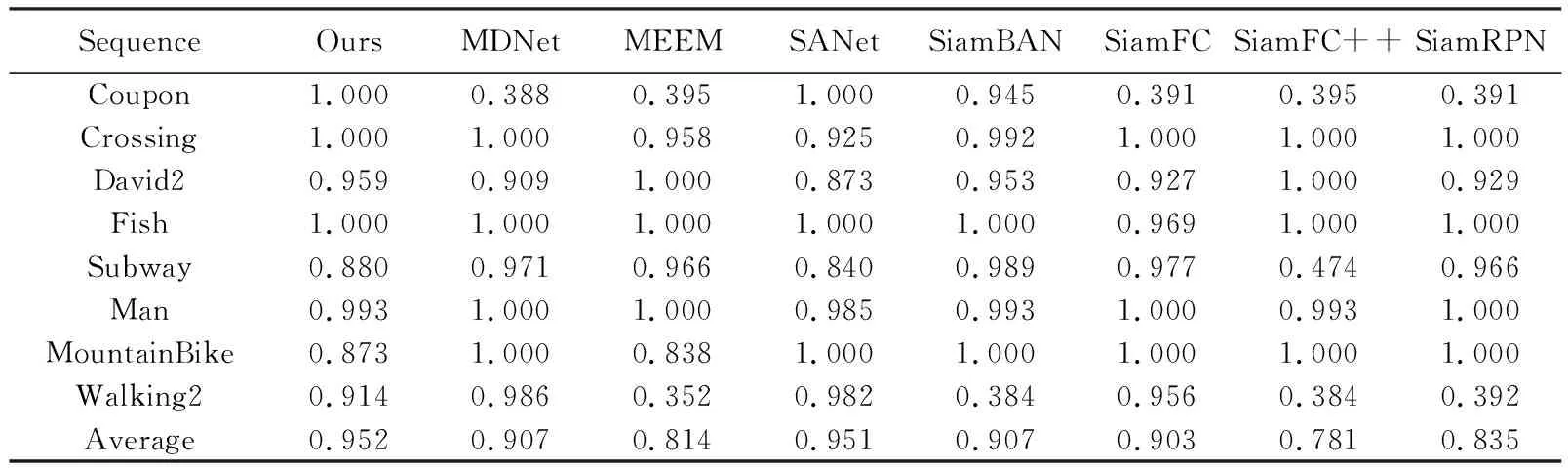

在8个视频序列上进行实验对比,表1所示为8个跟踪算法的平均重叠率。图2中为上述的跟踪算法在视频序列上的跟踪准确率曲线图。由表1与图2可以看出,所提出的跟踪算法在8个视频序列中以0.751获得最佳平均跟踪性能,并在Fish和Man视频序列中获得了最好的跟踪性能,以及在Coupon视频序列中获得了第二跟踪性能。另外,SANet与SiamBAN在这8个视频序列上分别获得了第二和第三的跟踪效果。

表1 平均重叠率

图2 跟踪精确度曲线图

表2为以上8个跟踪算法在8个视频序列上的跟踪成功率,图3给出了与其它跟踪器在不同挑战性视频序列上对比的跟踪成功率图。本文中提出的跟踪算法在8个视频序列中以0.952获得最佳平均成功率,并在Coupon、Crossing和Fish视频序列中获得了最佳性能以及在David2视频序列中获得了第三跟踪性能。SANet算法在8个视频序列中以0.951获得第二平均跟踪性能,并且在Coupon、Fish和MountainBike视频序列中获得最佳跟踪成功率,还在Walking2视频序列中获得第二跟踪成功率。另外MDNet和SiamBAN在8个视频序列中以0.907同时获得第三平均跟踪性能。

表2 跟踪成功率

图3 跟踪成功率曲线图

2.2 定性分析

图4为在不同挑战性视频序列中部分关键帧的对比跟踪结果(其中图a~c为Coupon序列上的跟踪结果,图d~f为Subway序列上的跟踪结果,实线方框为本文算法的跟踪结果)。这些视频序列包括了一种或多种目标外观变化,例如光照变化、部分遮挡、快速运动以及平面内外旋转。下面将从光照变化、遮挡、相似目标等方面来详细分析跟踪算法性能。

(1)遮挡。如图4所示,Coupon和Subway序列中的目标在运动过程中都经历了部分遮挡。在Subway序列中,第39帧时跟踪目标被部分遮挡,多个跟踪器发生了不同程度的偏离目标甚至完全丢失目标,例如SiamFC++、SiamFC以及SiamRPN。其中,SiamFC++将目标特征作为一个整体,与搜索区域进行相似性计算。然而,在跟踪过程中,目标通常会产生剧烈的目标表观变化,对可变目标使用这种全局匹配可能导致匹配结果不够准确。所提出的跟踪器利用基础字典和核扩展字典学习的表观模型能有效区分目标的相关信息,具有较高的跟踪精度和鲁棒性。

(2)相似目标。Coupon和Subway序列中的目标和背景相似,例如Coupon序列中的第153帧与Subway序列中第101帧。SiamFC、SiamFC++和SiamRPN对跟踪目标产生了误判,将相似的背景作为跟踪目标进行跟踪,导致跟踪失败。而本文所提出的基于基础字典和核扩展字典学习的跟踪器在相似的背景环境下取得了较好的跟踪结果。

图4 不同视频序列上的跟踪结果

3 结束语

在本文中,针对在剧烈表观变化下目标跟踪性能较差的问题,提出了一种基于基础字典与扩展字典的联合目标表示方法。首先在视频的初始帧收集一组训练学习样本,通过核判别分析投影获得基础字典和扩展字典。基础字典在跟踪过程中不进行更新,从而更多地保留了目标的原有信息。在跟踪过程中扩展字典连续进行更新,以更好地学习目标的表观变化,提升表观模型的自适应性。目标候选块由基础字典与扩展字典的线性组合进行联合表示。基于联合字典的目标表示与字典的更新,本文在粒子滤波框架下提出了一种基于扩展字典学习的目标跟踪算法。在挑战性的数据集上进行广泛的对比实验表明,与最先进的跟踪算法相比,所提出的跟踪算法在实验评估中也取得了优异的跟踪性能。