一种面向中文的实体关系联合抽取方法研究

2022-12-06李代祎李忠良

李代祎,李忠良,严 丽

(南京航空航天大学 计算机科学与技术学院,南京 211106)

1 引 言

实体和关系抽取[1]是信息抽取(Information Extraction,IE)的两个重要子任务,旨在从非结构化文本数据中检测出实体的同时,识别出实体之间的语义关系,最终将非结构化的数据自动转换为结构化数据.因此,构建一个具有高效、稳定性能的实体关系联合抽取模型,将非结构化文本数据自动、精确和全面地转化为符合大众需求的结构化数据,可以在减少人工成本的同时,更加高效地处理海量数据和构建大规模知识图谱[2].同时,实体关系联合抽取模型可以为许多的自然语言处理(Natural Language Processing,NLP)应用提供基础的技术支持,具有较高的实际应用价值和经济效益.

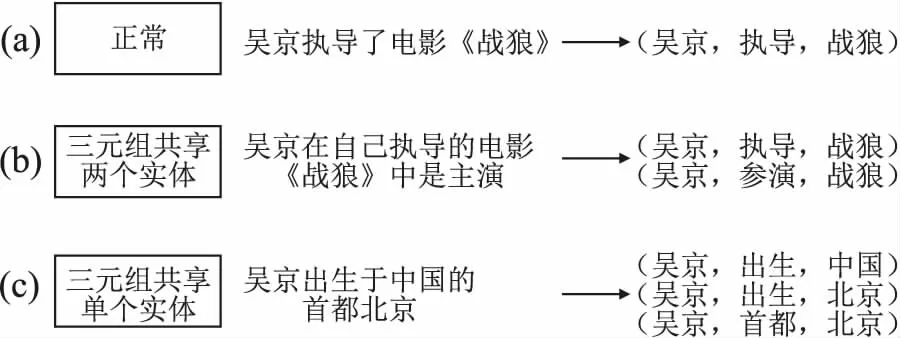

近年来,为了有效解决手动特征工程问题,基于深度学习[3,4]的实体关系抽取方法取得了较好的研究成果.基于深度学习的流水线抽取方法[5-9]主要将命名实体识别和关系抽取作为两个单独的任务完成,这些方法尽管可以自动获取文本深度特征,且模型灵活,但是却不能有效解决错误传播的问题.而基于深度学习的联合抽取方法[10-21]主要的目的是同时实现句子中实体的识别和实体对间关系的抽取,这些方法尽管可以有效利用实体和关系之间的关联信息,大大提高了模型的性能.但是许多联合抽取模型将实体对间的关系作为实体对上的离散函数,这些方法会因为训练样本数据的不足造成参与共享同一实体的多种关系很难被正确的识别,从而导致无法有效解决多三元组重叠问题(如图1所示).

图1 三元组重叠实例

综上所述,基于深度学习的联合实体关系抽取模型大都将关系视为分配给实体对的离散标签,从而造成关系分类成为一个难题,主要原因有:1)关系类别分布不平衡,造成所识别的实体对中,大多数没有提取出有效的关系;2)当多个关系共享同一个实体时,如果没有足够的训练样本,关系分类器很难判断出实体参与的关系.因此,本文构建了一个新的实体关系联合抽取模型,通过该模型来解决三元组重叠问题.具体地,该模型将关系建模为头实体映射到句子中相对应尾实体的函数.假设头实体表示为s,关系表示为r和尾实体表示为o.本文的方法不是学习关系分类器f(s,o)→r,而是采用类似文献[20,21]中的标记方案fr(s)→o.具体地,先识别出头实体s,然后根据s语义信息和位置信息抽取出每一种特定关系r下对应的尾实体o,如果没有给定关系的尾实体,则返回空,表示给定的头实体和关系没有三元组.具体过程分为两步:首先,确定一个句子中所有可能的头实体;然后,对于每个头实体,应用特定的二进制标记来标识所有可能的关系和相应的尾实体.本文的主要贡献如下:

1)将BERT预训练模型引入到头实体的识别中,构建了一个实体识别模型BERT-BiLSTM-ATT.该模型可以根据字符的上下文信息获取字符的语义信息,并且通过BiLST-ATT获取句子中最重要的语义信息.

2)为了有效利用句子中包含头实体的语义信息,构建了一种条件正则化方法对编码序列做归一化处理.该方法可以有效地将头实体的语义信息整合到句子特征中.

3)为了有效解决三元组重叠问题,设计了一个针对特定关系的尾实体标记模型BiLSTM-ATT.该标记模型可以有效识别特定关系下给定头实体对应的所有可能尾实体.

2 相关工作

实体和关系提取是构建大规模知识库的一个重要步骤,可以为许多的NLP应用提供基础的技术支持.当前,有两个主要的框架被广泛用于解决实体识别及其关系的提取问题.一种是流水线方法,另一种是联合抽取方法.

2.1 流水线抽取方法

流水线方法[5-9]是将此实体关系抽取任务视为两个独立的任务,主要通过两个独立的步骤完成关系三元组的抽取:1)通过命名实体识别(Named entity recognition,NER)技术[22],识别出句子中包含的所有实体;2)然后利用关系抽取(Relation extraction,RE)技术对识别出的实体对进行关系分类[23].由于基于统计的流水线抽取方法过度依赖人工特征,耗时费力.因此,基于神经网络的流水线抽取方法近年来被广泛研究.例如,Xu等人[5]构建了一种SDP-LSTM关系抽取模型,通过融入依存句法树的结构信息提高模型准确率;Chan等人[6]构建了一种新的算法,通过句法语义结构信息提高关系抽取模型的性能;Zhou等人[7]构建了一个Att-BiLSTM关系抽取模型,可以有效获取句子中最重要的语义特征;Lin等人[8]构建了基于注意力机制与神经网络相融合的关系抽取方法,有效较低了关系的错误标记;Peng等人[9]通过优化损失函数,有效提高了模型的准确率.

尽管基于深度学习的流水线抽取方法取得了显著的成果,但是流水线方法往往存在错误传播问题,且忽略了两个任务之间的相关性.实体识别的准确率直接影响关系抽取模型的性能,实体的错误识别往往会导致抽取的关系无效.为了解决上述问题,本文构建了一个新的实体关系联合抽取模型,该模型包含头实体识别和与头实体具有相应关系的尾实体识别.

2.2 联合抽取方法

基于流水线的实体关系抽取模型过度依赖NLP工具,且大多需要人工提取特征,从而影响模型性能.例如,需要额外的数据预处理工作、NLP工具的性能可以直接影响模型抽取结果和计算复杂性增加.

为了解决上述问题,基于深度学习的联合抽取方法引起越来越多研究者的关注.例如.Gupta等人[10]提出了一种多任务递归神经网络(TF-MTRNN)模型,将实体识别和关系抽取任务转化为表格填充问题,并对两个任务之间的相关性进行建模;Miwa等人[11]构建了一个端到端的实体关系抽取中,使得实体识别和关系抽取之间相互影响;Adel等人[20]构建了一个基于深度学习实体关系抽取模型,可以识别给定句子的两个候选实体的类型和它们之间的关系.Zheng等人[12]提出一种新的标注方案,将联合抽取任务转化为序列标注问题.Katiyar等人[13]构建了基于RNN改进的实体关系联合抽取模型,该模型根据指针网络的实体指针和关系指针结合注意力机制找出来两个实体的关系.Bekoulis等人[14]构建了一个基于RNN的实体关系抽取模型,该模型在不使用依存句法树特征的情况下有效提取出句子中实体及实体对之间的关系.Dai等人[15]构建了一个基于PA-LSTM的联合抽取模型,可以根据查询位置直接标记实体和关系,并获取了较好的结果.Sun和Fu等人[16,17]都是利用图神经网络(GCN)构建了一个端到端的关系抽取模型,通过关系加权的方法来学习实体和关系之间的交互.Nayak等人[18]提出一种编码器-解码器体系结构的实体关系联合抽取方法来抽取实体及实体间的关系,取得了较好的结果.尽管这些方法有效解决手动特征工程问题,但是不能有效地解决同一句子中多个关系共享相同实体的三元组重叠问题,从而由于实体对的冗余造成关系分类器性能的下降[19].

为了有效解决多关系三元组重叠问题,Yu等人[20]提出了一种新的分解策略,利用span的标记方案将联合抽取任务分解为两个相互关联的子任务(HE抽取和TER抽取);Wei等人[21]提出了一种新的级联二元标注框架CasRel,将三元组的抽取任务转换为主实体、关系和对象实体3个级别的问题.本文在Yu和Wei等人研究的基础上,构建了一个新的基于BERT的中文实体关系联合抽取模型.该模型引入了BERT预训练模型[24],有效获地获取了句子中重要的语义信息.同时,通过条件正则化方法对编码序列做归一化处理,有效地将头实体的语义信息整合到句子信息中.最后,设计了一个针对特定关系的尾实体标记模型,可以有效识别特定关系下给定头实体对应的所有可能尾实体.

3 基于BERT的中文实体关系联合抽取模型

3.1 模型整体框架

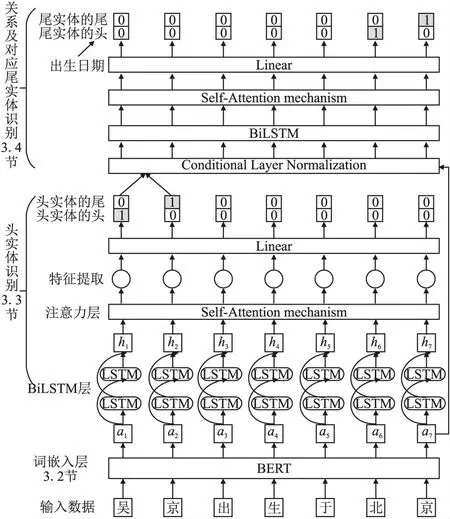

本文提出了一个基于BERT的中文实体关系联合抽取模型(整体框架如图2所示),主要分为头实体识别模块和关系及其尾实体识别模块.首先,该模型通过引入的BERT预训练模型获取包含上下文信息的中文字符特征,不仅解决了因中文分词错误而造成的误差传播问题,同时也充分考虑到了中文句子的全局信息.其次,构建了一种条件正则化方法对编码序列做归一化处理,可以有效地将头实体的语义信息整合到句子信息中.最后,通过构建的BiLSTM-ATT模型完成头实体的识别以及针对特定关系的尾实体抽取.

图2 基于BERT的中文实体关系联合抽取框架

3.2 基于BERT的词嵌入模块

在NLP领域,词嵌入技术可以将词映射到低维空间,有效地解决了文本特征稀疏的问题,从而使语义相似的词在空间中的距离更近.传统的词向量嵌入方法有one-hot、word2vec和Elmo等预训练的语言模型,大多仅仅对单独的词表征,因此很难准确地表示词的多义性.然而,BERT模型可以依据上下文信息,通过无监督的方式表征单个中文字符,从而有效地解决多义词的表征问题.

如图3所示,在BERT模型中,多层双向transformers被用作编码器,每个单元由前馈神经网络(feed-forward)和多头注意机制组成,因此每个字符的表征可以融合其左右两边的信息.注意机制的功能是计算输入句子中的每个字符权重,以获得句子中字符之间的关联度,然后调整权重系数矩阵以获得单个字符的向量表示.具体的计算见公式(1):

图3 基于transformers的编码器结构

(1)

其中,Q,K和V分别表示输入的字向量矩阵;dk表示输入向量的维度;QKT表示输入字符向量之间的关系计算.Transforms的计算采用了多头注意机制,通过多个线性变换对进行投影,以增强模型捕获不同位置特征的能力.具体计算结果见公式(2)和式(3):

MultiHead(Q,K,V)=Concat(head1,head2,…,headk)W0

(2)

(3)

其中,W0表示模型的附加权重矩阵,主要用于获取不同的空间位置信息.同时,为了解决深度学习中的退化问题,在Transforms编码单元中加入了残差网络和归一化层.具体的计算见公式(4)和式(5):

(4)

FFN(Z)=max(0,ZW1+b1)W2+b2

(5)

其中,在公式(4)中α和β表示学习参数,μ和σ表示输入层的均值和方差.假设自我注意机制的结果表示为Z,偏差项表示为b.最后,全连通前馈网络(FNN)的表示如公式(5)所示.

3.3 实体关系抽取模块

词嵌入:通过BERT模型获得输入句子的嵌入向量.假设给定输入的句子S=[w1,w2,…,wn]∈Rn×d,那么最后输出的句子表示为:

E=[e1,e2,…,en]=BERT([w1,w2,…,wn])∈Rn×d

(6)

其中,句子中每个字符用w表示;每个字符对应的嵌入向量用e表示.

(7)

其中,n表示句子长度,d表示维度.为了有效地关注特定时间下输入序列中的重要特征,本文在BilSTM模型的基础上引入了注意力机制[26](如图4所示).通过对输入序列中不同字符赋予不同的权重,有选择地突出关键词的重要性.例如,给定的句子“吴京是电影《战狼》的导演”,其中“吴京”和“战狼”是头尾实体,实体中的各个字之间关系密切,而与句子中其它的字符关系较弱.显然,各个字符对头实体的识别作用是不一样的.因此,本文通过对每个字符分配不同的权重来提高头实体的识别准确率.

图4 嵌入注意力机制的BiLSTM模型

注意力层:注意力计算如图4所示,详细步骤如下:

首先,对目标字符与输入序列中的所有字符进行相似性计算.假设两个字符间的注意力权重为αi,t,其含义为第t个目标字符与第i个输入字符之间的相似性.具体的计算见公式(8)和式(9):

(8)

(9)

其中,ui,t被定义为余弦定理,其值越大,表明xi和xt的相似性越强.w表示加权点乘.

其次,采用获取的注意力权重为αi,t与BiLSTM的输出进行加权求和,获到第t个包含上下文信息的全局向量Ct.

(10)

最后,将全局向量Ct与BiLSTM编码层的输出ht进行合并,然后将合并后的向量[C:ht]通过激活函数获得注意力权重输出.具体的计算见公式(11):

Zt=tanh(W[Ct·ht])

(11)

头实体解码层:针对头实体识别,本文采用二进制标记(0/1)来识别头实体的开始和结束位置,即该标记表明当前的位置是否是头实体的开始或结束.

通过对BiLSTM-ATT编码层输出的结果进行两次标注,识别出句子所包含的所有可能的头实体S.使用两次标注,主要原因是一个头实体可能是由多个连续的字符构成.因此,很难通过一次标注将表示同一个实体的不同字符正确标注,所以,本文采用两次标注的方法,分别对头实体的开始位置和结束位置进行正确标注,具体的方法如见公式(12)和公式(13):

Ps-start(t)=Sigmoid(Ws-startZt+bs-start)

(12)

Ps-end(t)=Sigmoid(Ws-endZt+bs-end)

(13)

其中,Ps-start(t)和Ps-end(t)分别表示将时刻输出序列中的token识别为头实体的开始和结束位置的概率.如果概率超过设置的阈值,则相应位置的token标注为1,否则将其被标注伪0.Ws-start和Ps-end表示可训练的权重,bs-start和bs-end表示偏置向量,Sigmoid表示相应的激活函数.

关系和尾实体解码层:为了有效识别出句子中的尾实体,本文在头实体识别的基础上,针对所有的关系进行尾实体的识别.首先,考虑BiLSTM-ATT编码层的输出特征向量,获取包含上下文信息的序列特征向量;其次,通过条件正则化方法对编码序列做归一化处理,有效地将头实体的语义信息整合到句子信息中.最后,将头实体特征融入序列特征中,通过构建的标注模型对关系和尾实体进行识别.具体的步骤如下所述:

1)BERT编码层:BiLSTM-ATT编码层与3.3节中相同,通过BERT模型获取输入序列的特征向量(如公式(6)所示),该序列特征将用于同头实体特征相结合.

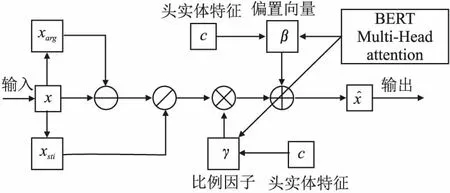

2)条件正则化层:图像处理中流行的条件批量正则化(Condition batch normalization)是将现有正则化方法中的和变量转化为输入条件的函数,目的是让生成的结果可以由条件控制[27].同样的,在BERT模型中,主要的正则化方法是层正则化.因此,相应的β和γ变量成为输入条件的函数,以控制Transformer模型的生成行为.条件正则化(Conditional layer normalization,CLN)的具体框架如图5所示.

图5 条件正则化的框架

本文以文本中头实体的编码向量为条件,将其通过层正则化融合进变量β和γ中,从而将头实体的语义信息整合到文本中.在同一层中,所有隐藏单元条件正则化的统计信息计算如下:

(14)

其中,E表示文本通过BERT学习后的融合上下文特征的序列向量;C表示目标条件特征.条件正则化方法中的参数γ表示添加目标条件后的比例因子,β表示添加目标条件后的偏置向量.

3)关系和尾实体解码层:针对每个头实体,本文采用二进制标记(0/1)来识别每种关系下对应的尾实体,即该标记表明当前的位置是否是尾实体的开始或结束.

该模块可以有效识别出头实体对应的关系以及相关的尾实体.首先,通过BERT模型获得包含上下文信息的序列特征.其次,通过条件正则化方法有效融合头实体的向量特征.最后,同3.3节中头实体解码层的方法相同,针对每一种关系,识别出与头实体相关的尾实体.具体的方法如下所示:

(15)

(16)

3.4 损失函数

针对头实体和尾实体的标记任务中,本文采用二进制标记(0/1)来预测头实体和尾实体的开始和结束位置.实际上这个任务可以认为是个二分类问题,因此本文使用二分类交叉熵的改进版focal loss作为损失函数.同时,通过对样本数据的分析发现,标签为“1”的样本较多,而标签为“0”的较少,样本数据不均衡.使用focal loss作为损失函数对正负样本进行惩罚,通过提高预测值以避免候选项为空的情况,可以有效处理数据样本不平衡问题.头实体识别的损失函数见公式(17)~公式(19):

(17)

(18)

(19)

其中,pt表示对标签为“1”类别的估计;α表示增加的权重参数,两者的具体定义见公式(20)和公式(21):

(20)

(21)

同样地,针对尾实体识别的损失函数见公式(22)~公式(24):

(22)

(23)

(24)

由于抽取尾实体信息时,融入了头实体的相关特征,因此总体的损失函数定义为头实体和尾实体识别的损失函数相加.

4 实 验

4.1 实验数据与评估指标

实验数据集:在实验中,本文使用3种公开的信息抽取数据集:1)百度提供的关系抽取数据集DuIE[28],该数据集的主要来源是百度百科和百度新闻,包含近43万三元组;2)中文医学信息抽取数据集CMeIE[29],该数据集的主要来源是儿科疾病和百种常见疾病,包含近7.5万三元组;3)NYT是一个英文新闻语料关系抽取数据集,通过远程监督方式生成.3种数据集的具体统计分析如表1所示.

表1 数据集统计分析

其中,数据集DuIE包含近17万条中文句子和50种预定义关系类型.数据样例为{"object_type": "人物","predicate": "演员","object": "吴京","subject_type": "电影","subject": "战狼"};数据集CMeIE包含近2.8万条中文句子和53种预定义关系类型,数据样例为{"Combined": true,"predicate": "放射治疗","subject": "慢性胰腺炎","subject_type": "疾病","object": {"@value": "外照射"},"object_type": {"@value": "其他治疗"}}.数据集NYT采用Zeng 等人[30]发布的数据集,包含近6万条句子,24种预定义关系类型.

评估指标:本文通过常用的实体关系抽取评估指标对构建的实体关系联合抽取模型进行性能评估,主要有精确率(P)、召回率(R)和F1衡量值.

(25)

其中,TP表示正确预测三元组的个数;FP表示错误预测为三元组的个数;FN表示真实三元组没被正确预测的个数.在本文中构建的是联合抽取模型,因此当头实体、关系和尾实体全部预测正确,才确定为三元组被正确预测.

4.2 模型参数设置与实验环境

参数设置:本文通过模型训练和参考相关文献中的工作,选择实体关系联合抽取模型的最优超参数值.目前,有两种预训练语言模型:BERT-Base和BERT-Large,两者的区别重要在于参数量的不同.根据实验室硬件条件,实验中本文选择BERT-Base模型来获取包含上下文信息的序列特征向量.同时,采用嵌入注意力机制的BiLSTM模型来获取文本句子中的局部特征和全局特征;使用Adam[31]优化算法获取合适的学习率.模型中具体的参数值如表2所示.

表2 超参数值选择

实验环境:在实验中,本文采用深度学习中的Pytorch框架.同时,模型训练和测试主要在AMD Ryzen 2700X (64GB)CPU和NVidia RTX2080Ti (11GB)GPU上完成.

4.3 结果与分析

在本文研究中,为了验证本文构建的实体关系联合抽取模型是有效且稳定的,在DuIE数据集、CMeIE数据集和NYT数据集上分别对所提出的模型和当前较好的方法进行了对比实验.

Attention-BiLSTM:在BiLSTM中嵌入注意力机制,可以有效捕获句子中较为重要的关键字信息,从而有效获得输入句子的局部特征和全局特征.

CopyMTL[32]: CopyMTL是在CopyRE模型基础上的一种改进该模型.首先,在编码层主要采用BiLSTM模型捕获句子的全局信息,构建句子的特征向量.其次,在解码层主要采用Attention_LSTM模型对关系,头实体和尾实体依次进行预测识别.

WDec[18]:该模型提出了一种编码器-解码器体系结构的实体关系联合抽取方法,有效解决了句子中三元组重叠问题,提高了实体关系联合抽取模型的性能.

Seq2UMTree[30]:该模型是在CasRel模型[21]基础上的改进,在解码层采用树形结构来对句子中实体关系进行联合抽取,有效解决了数据中标签不平衡问题.

MHS[33]: 该模型是一个实体关系联合抽取模型,没有额外的手工特征和外部工具.通过CRF层将实体识别任务和关系抽取任务转换为一个多头选择问题,有效提高了实体关系联合抽取模型的性能.

CasRel[21]:该模型是一种新的级联二元标注框架,将三元组的抽取任务转换为主实体、关系和对象实体三个级别的问题.同时,将关系抽取看做是两个实体的映射关系,有效解决了句子三元组重叠问题.

FETI[34]:该模型在编码层采用BiLSTM模型捕获输入句子的全局特征.然后,在解码层采用树形结构进行句子中实体和关系的联合抽取,有效提高了模型性能.

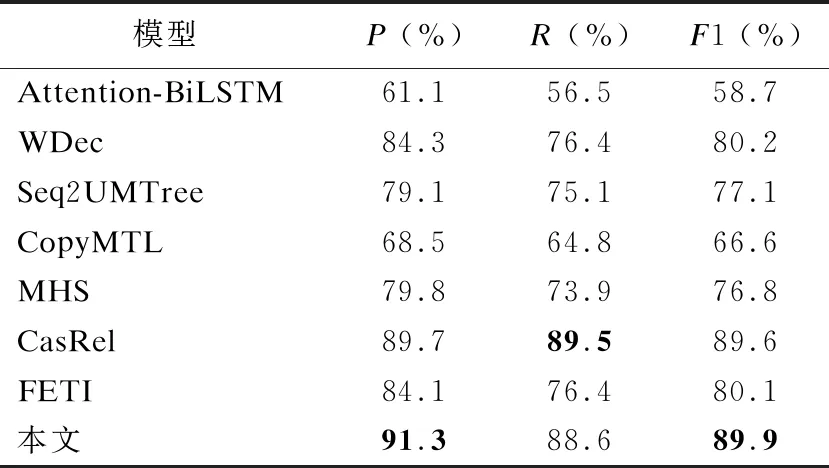

在DuIE数据集上,本文提出的基于BERT的实体关系联合抽取模型与上述基线模型的性能比较如表3所示.

表3 不同模型在DuIE数据集上的结果

如表3所示,将本文构建的实体关系联合抽取模型与现有的几种基线模型在DuIE数据集生进行性能对比,基于BERT的实体关系联合抽取模型的性能显著提高.例如,本文提出的中文实体关系联合抽取模型在DuIE数据集上获得了最高的平均F1值(79.2%),R值(77.8%)和P值(80.6%).它比FETI基线模式的平均F1值高出约3.0%.此外,通过对比发现,实体关系联合抽取模型明显优于传统的流水线方法(Attention-BiLSTM),主要原因是流水线的方法存在错误的传播.同时,实验结果还表明,CasRel方法将关系转换为头实体映射到尾实体的函数,可以准确识别出句子中更多的实体.本文在CasRel方法的基础上构建了基于BERT的中文实体关系联合抽取模型,不仅充分考虑到了句子中中文字符的上下文信息,而且还更好地解决了中文句子中三元组重叠的问题,从而有效提高了模型的实体关系抽取能力,可以准确提取出更多有效的三元组信息.

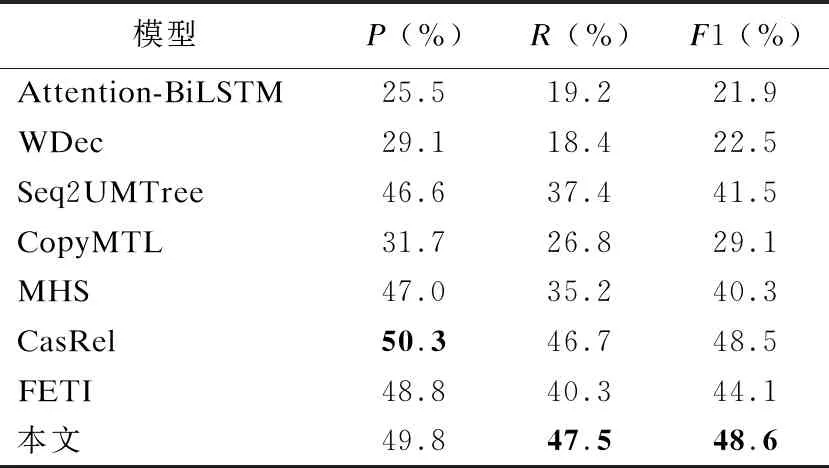

在CMeIE数据集上,本文提出的基于BERT的实体关系联合抽取模型与上述基线模型的性能比较如表4所示.

表4 不同模型在CMeIE数据集上的结果

如表4所示,将本文构建的实体关系联合抽取模型与现有的几种基线模型在CMeIE数据集上进行性能对比.测试结果表明,本文构建的中文实体关联合抽取模型在CMeIE数据集上是有效的,获得了49.8%的精确率、47.5%的召回率和48.6%的F1值.同时,从实验结果显然可以看出实体关系联合抽取模型要优于传统的流水线模型.此外,通过实验结果分析,本文构建的实体关系联合抽取模型在CMeIE医学关系抽取数据集的性能提升较少,主要原因可能是本文采用的BERT模型是通过在大规模通用语料上训练学习后获取的,而CMeIE数据集是中文医学领域标准的关系抽取数据集.因此,BERT模型可能在该医学领域数据上表征较差,任务之间的错误传播较多,从而造成较多三元组的错误抽取.

在NYT数据集上,本文提出的基于BERT的实体关系联合抽取模型与上述基线模型的性能比较如表5所示.

表5 不同模型在NYT数据集上的结果

如表5所示,将本文构建的实体关系联合抽取模型与现有的几种基线模型在NYT英文关系抽取数据集上进行性能对比.测试结果表明,本文构建的实体关系联合抽取模型的在英文关系抽取语料上也获得较好的结果,在NYT数据集上获得了最高的平均F1值(89.9%)和P值(91.3%).此外,通过分析表5中的结果可以得出以下结论:1)本文构建的联合抽取方法优于流水线方法(Attention-BiLSTM),主要原因是流水线方法存在错误传播,且没有考虑实体识别和关系抽取之间的内在关联;2)本文借鉴了CasRel模型的全局指针网络解码思路,构建了基于BERT的中文实体关系联合抽取模型.结果表明本文模型性能优于CasRel和FETI等联合抽取模型,主要原因是本文模型不仅充分考虑到了句子中中文字符的局部信息和全局信息,而且在识别关系和尾实体时有效利用了头实体的相关信息.

4.4 模型的消融实验

为了分析本文构建的实体关系联合抽取模型中各个模块的贡献,在DuIE数据集上做了相关消融实验.各个基线模型的性能指标结果如表6所示.

表6 不文模型中各个模块的作用

BERT模块:在实体关系联合抽取模型中引入BERT,主要为了获取包含上下文信息的句子表征.

BiLSTM-ATT:将训练好的句子向量输入到BiLSTM-ATT模块中,可以获取句子中最重要的全局语义信息.

条件层正则化:通过条件层正则化方法对编码序列做归一化处理,可以有效地将头实体的语义信息整合到句子信息中.

为了验证提出实体关系联合抽取模型中各个模块的作用,将其与相应的基线模型进行了比较.表6中的结果表明本文提出的模型具有更好的性能.将BERT层叠加到经典基线模型上,并将ATT嵌入BiLSTM中,模型的性能得到了显著的提高.同时,通过条件正则化方法将头实体的语义信息整合到句子信息中,进一步提高了模型的性能.

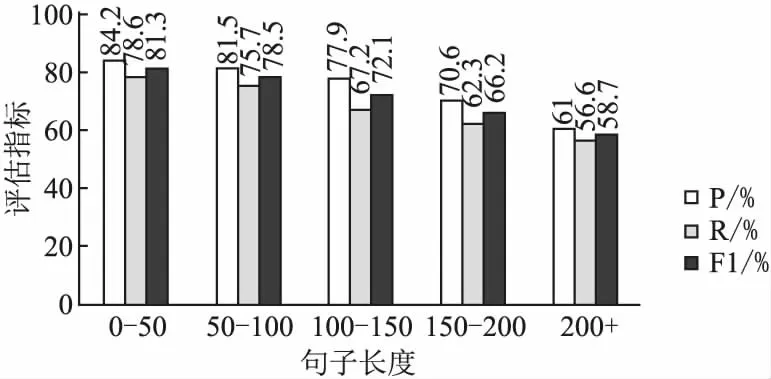

4.5 不同句子长度对模型的影响

为了研究不同句子长度对本文提出的实体关系联合抽取模型的影响程度.首先,将DuIE的测试集中句子的长度分为5个类别;其次,通过构建的模型对测试集上的句子进行实体和关系抽取,并统计结果(如图6所示).统计结果表明本文构建的模型在长句子上的实体关系抽取结果明显比短句子上的差.分析认为原因有两点:1)短文本中包含的实体和关系数量比长文本中的少,错误识别的可能性小;2)通过二进制指针网络标注序列.由于目标实体词明显比非目标实体词要少许多,因此导致标注的类别不均衡(标签0比标签1要多得多).同时,随着句子长度的增加,类别的不均衡现象会更严重.

图6 模型在不同句子长度下的性能

5 结 论

传统的实体关系抽取方法依赖于专业的领域知识和大量的人工参与来提取特征.同时,在中文实体关系抽取任务中也存在更多挑战,如多义现象和没有边界标识符的汉语词等.为了解决这些问题,本文提出了一个新的实体关系联合抽取模型.首先,通过构建的BERT-BiLSTM-ATT模型识别句子中包含的所有头实体;然后,以头实体的BERT编码向量作为条件,通过构建的条件正则化方法将头实体的语义信息整合到句子信息中.最后,通过构建的BiLSTM-ATT模型完成句子中关系和尾实体的识别.同时,为了讨论本文提出的中文实体关系联合抽取模型的有效性,使用DuIE数据集、CMeIE数据集和NYT数据集作为模型性能评估的数据集.通过与最近的一些研究结果相比,本文提出的模型取得了良好的效果.

本文提出的模型的主要优势在于,它可以对中文字符的上下文信息进行学习,从而获得融合上下文语义信息的句子表征,这使得该模型的性能优于其他基线.同时,注意机制被嵌入到BiLSTM模型中,可以增强句子中重要特征的提取.此外,本文的新框架不再将关系视为离散的标签,而是将关系建模为头实体映射到句子中尾实体的函数,这有效解决了三元组重叠问题,从而进一步提高中文实体关系联合抽取模型的性能.下一步的工作是研究特定领域下中文实体关系抽取的构建方法,并测试所提出的模型在多领域实体关系抽取任务中的有效性和泛化能力.