基于光流注意力网络的梅花鹿攻击行为自动识别方法

2022-11-03侯鹏飞熊家军许学林

高 云 侯鹏飞 熊家军 许学林 陈 斌 李 康

(1.华中农业大学工学院, 武汉 430070; 2.生猪健康养殖协同创新中心, 武汉 430070;3.华中农业大学动物科技学院, 武汉 430070)

0 引言

人工集约化养殖梅花鹿作为我国一种半驯化的特种经济动物,其鹿茸有着极高的药用价值[1]。雄性梅花鹿在发情期间,攻击行为发生次数剧增,极易造成鹿茸损伤,打斗激烈时,还会造成鹿只伤残,甚至死亡,给鹿业养殖户造成巨大的经济损失[2]。目前实际生产中,主要依靠人工观察鹿只的攻击行为并进行人为干涉。人工观察攻击行为费时费力,难以实现长时间监控,且容易漏判,不适合大规模采用。

近年来,机器视觉技术在动物动作监测和识别领域得到长足的发展。在传统攻击行为识别算法研究中,支持向量机(SVM)和聚类算法等模式识别方法被用于区分畜禽攻击行为。改进SVM算法区分生猪攻击行为正确率[3]达到95.70%[4]、97.50%[4]、97.60%[5]。SVM算法也被用于区分鹿的采食行为,正确率为90.00%[6]。基于分层聚类改进生猪攻击行为识别算法正确率达85.43%[7],高度攻击行为识别正确率达95.80%[8]、97.04%[9],中度正确率能够达92.30%[8]、95.82%[9]。聚类算法中的K-means算法可实现种鸡打斗、采食、饮水、交配、振翅等行为的识别,正确率达84.03%[10]。此外,也有学者选用线性分类器,即采用线性混合模型实现生猪攻击行为识别,正确率为73.90%和89.00%[11]。随着神经网络和深度学习的高速发展,其在动物行为识别研究中的应用也成为近年来的热点[12-16]。

注意力机制于20世纪90年代初次被引入传统机器视觉。2014年后,注意力机制与深度学习相结合在工业和农业上都得到了较好应用[17]。注意力机制中自注意力和软注意力应用广泛。自注意力也称为内部注意力,目的是计算序列的表达形式。软注意力更关注区域或通道,包含空间域、通道域和混合域(融合空间和通道)等类别。在相关研究中[18-23],注意力机制被加入到深度网络,分别应用于图像中的目标识别、图像分割和视频中的表情识别,与未加入注意力机制的网络对比,注意力机制能够提取重点特征,明显提升网络识别的正确率。如果将注意力机制加入到动作和行为识别网络,将会有效提升重点特征的提取,使识别效果更好。

梅花鹿的攻击行为特征相比其它动物有其特殊性,如常采用鹿角或鹿蹄等部位进行攻击。在行为识别算法的研究中需要专门针对其特点研究可行的识别网络。本文结合光流法和注意力机制,在长期循环卷积网络(Long-term recurrent convolutional networks, LRCN)[24]的基础上进行改进,研究梅花鹿行为的分类算法,行为包括攻击、采食、躺卧和站立等,其中攻击行为包括角斗、脚踢等特有攻击性行为动作。本文基于该算法设计鹿只行为自动识别系统,以实现各项行为在线自动监测和记录。

1 数据采集与数据集构建

1.1 数据采集

试验数据采集于2020年11月20日至2021年3月10日,采集地点为湖北省某鹿业有限公司。试验圈舍尺寸为30 m×12 m(长×宽),其中休息区96 m2、活动区264 m2,外墙高2.2 m。圈舍中设料槽,圈内饲养 5~6岁龄、体况相近的42头雄性梅花鹿。试验对接种了KISS1-GnRH双表达DNA去势疫苗的雄性梅花鹿的攻击行为进行了测试,42头雄性梅花鹿随机均分为2组,一组进行疫苗肌肉注射(试验组),另一组不做处理(对照组),关于该疫苗试验内容另撰文描述[25]。

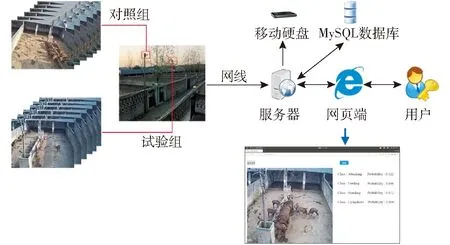

视频采集选用海康威视网络红外摄像头(3T56WD-I3型),镜头采用8 mm焦距,F1.6定焦光圈镜头。摄像头通过网线连接到服务器,安装MySQL数据库服务器(MySQL 8.0.24,MySQL AB公司,瑞典),同时连接移动硬盘(WDBU6Y0050BBK-WESN 4TB,西部数据,美国),服务器可通过浏览器对摄像头和数据进行访问。采集图像尺寸为2 560像素×1 920像素,帧率为4 f/s,以avi格式存储于移动硬盘。

由于梅花鹿圈舍分为休息区和活动区两部分,为了获取梅花鹿白天主要的活动,试验期间摄像头选择安装在鹿只主要活动区域,即活动区一角,可以俯视拍摄到院内鹿只所有活动。摄像头安装位置距圈舍围墙水平距离6 m,距地面高度约8 m,以俯视15°拍摄,水平视场角为37.5°,垂直视场角为27.8°,对角线视场角为47.5°。为了方便进行每日对比,试验拍摄时间为07:00—18:00,以采集鹿只白天院内所有活动。

1.2 雄鹿攻击行为定义

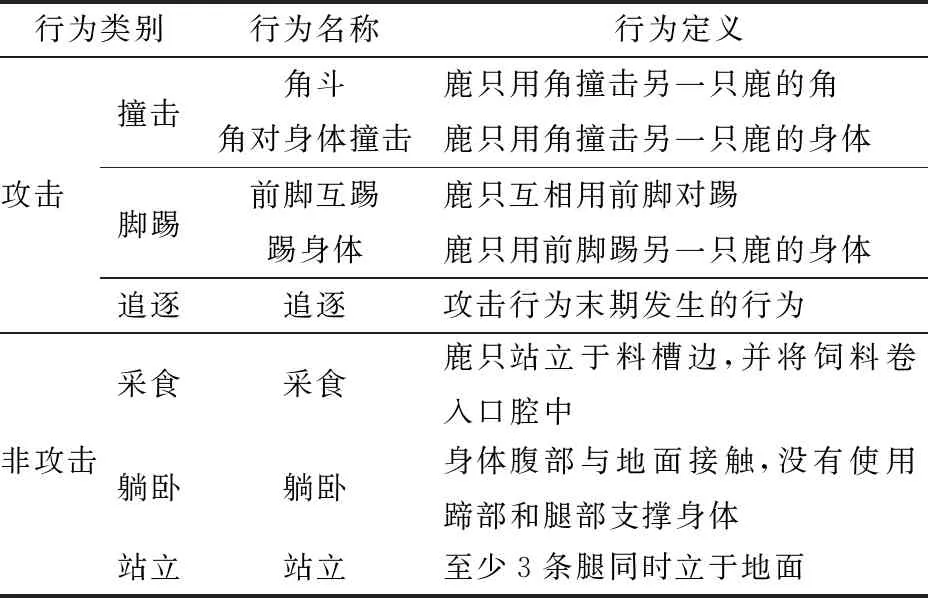

雄鹿在发情期间,攻击行为发生次数剧增。鹿只在进食时,会频繁用角顶撞其他鹿只的身体;在站立时,会发生角斗,即鹿只用鹿角撞击另一只鹿的角。攻击期间,鹿只间会前脚互踢,或一只鹿用前脚踢另一只鹿的身体。攻击末期,还会发生追逐行为。根据攻击发生的部位和发生的阶段将鹿只的攻击性行为细分为撞击、脚踢、追逐。同时,本文为区分鹿只的攻击行为和非攻击行为,将非攻击行为细分为采食、躺卧、站立,各行为的细分说明如表1所示。

表1 鹿行为定义Tab.1 Definition of deer’s behavior

1.3 数据集制作

梅花鹿RGB行为数据集采用行为优先级(Attacking precedence,AP)的方法制作,优先标注攻击行为,其次标注采食、站立和躺卧等行为。由于梅花鹿是群居动物,一般表现出群体性行为,而攻击行为发生在不少于两只鹿只之间的小群体性特异行为,持续时间较短,并且通常发生于采食、站立和躺卧行为中,采用AP法标注有助于训练模型提高对攻击行为的识别正确度。本研究中采用该方法分别对试验组和对照组截取图像的行为进行标注,网络模型优先对视频段中的攻击行为进行学习。标注鹿群其他日常行为时,多数鹿只同时发生的行为标注为该群体性行为。由于视频邻帧间,鹿只运动幅度较小,所以以1 f/s截取视频帧。标注结果如图1所示。上一行为视频中直接截取的图像帧,下一行为图像帧放大后的行为图像。本次试验共标注视频10 942段,共310 574帧,标注时长5 175.95 min。

图1 鹿的行为帧Fig.1 Frames of deer’s behavior

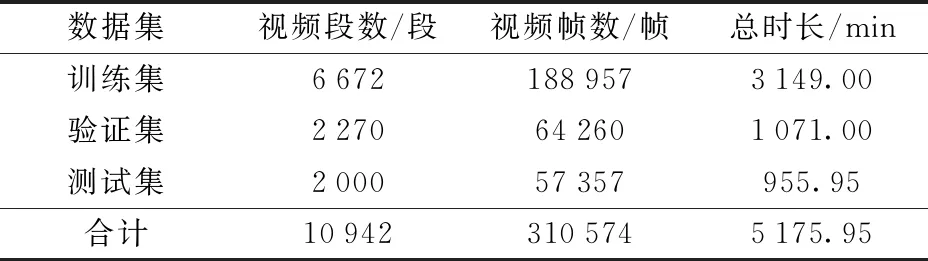

针对鹿只运动时身体的变化,采用LK光流算法(Lucas kanade optical flow algorithm)进行识别,这是一种计算相邻图像帧鹿只运动所产生像素点变化的计算方法。用此方法制作光流数据集,并按照3∶1∶1随机划分为训练集、验证集和测试集,如表2所示。

表2 光流数据集划分Tab.2 Division of optical flow dataset

2 行为攻击识别算法

2.1 算法设计

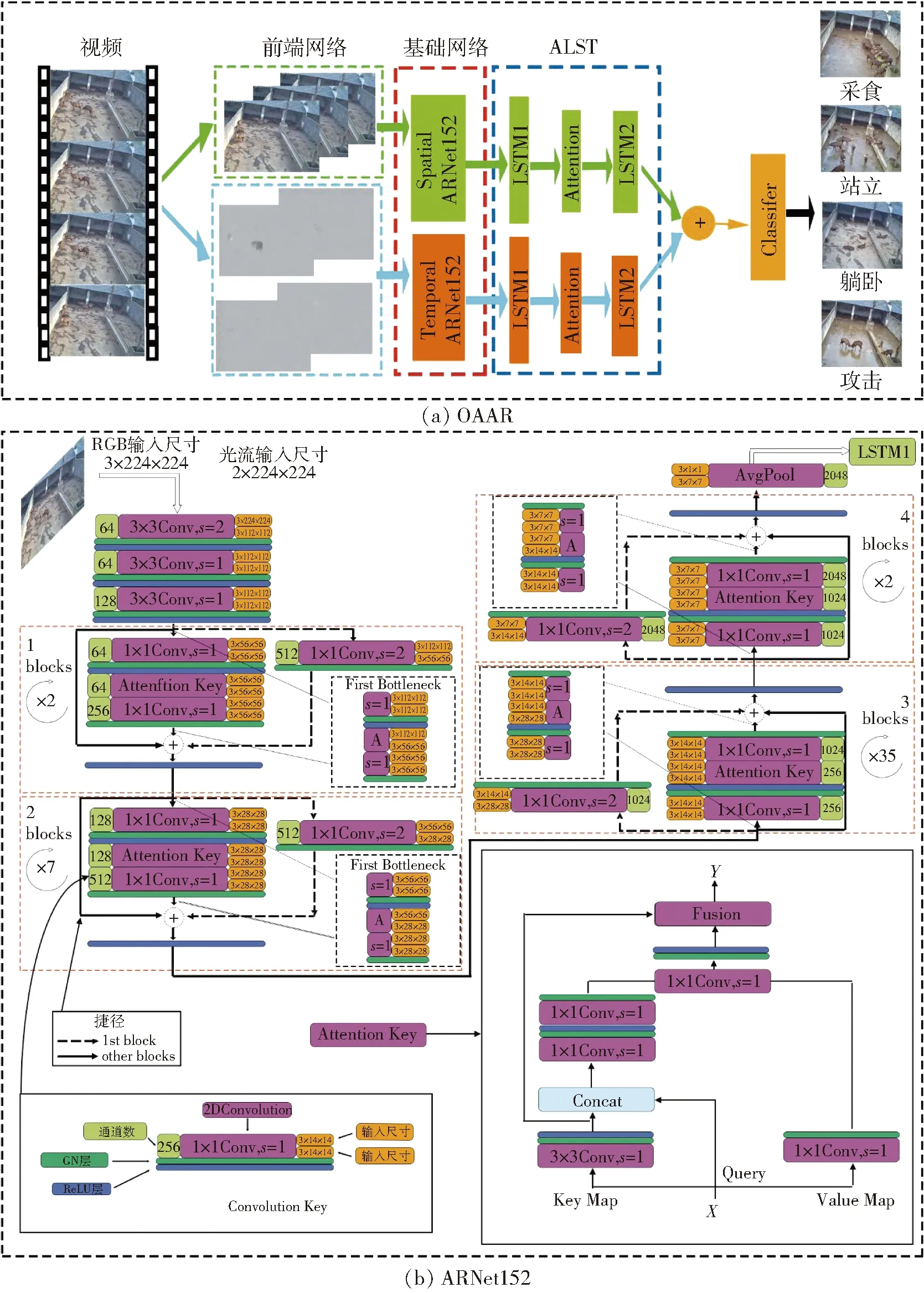

梅花鹿攻击行为相比其它动物有其特殊性,如常采用鹿角或鹿蹄等部位进行攻击。为了区分鹿只攻击行为与非攻击行为,解决鹿只之间的遮挡问题,提升视频识别效率和正确率,在算法中加入光流算法和注意力机制。设计光流注意力网络(Optical flow attention attacking recognition network, OAAR),改进攻击行为监测网络来对攻击行为和其它行为进行识别,该网络包括前置网络、基础网络和时序网络。前置网络由LK光流算法组成,提取RGB数据光流信息;基础网络采用自注意力模块将ResNet-152网络改造为ARNet152(Attention ResNet-152),用于将RGB、光流数据集提取特征后输入时序网络;时序网络采用添加注意力模块的长短记忆序列(Attention long short term network,ALST),并通过分类器输出行为得分和分类结果。

2.1.1前置网络

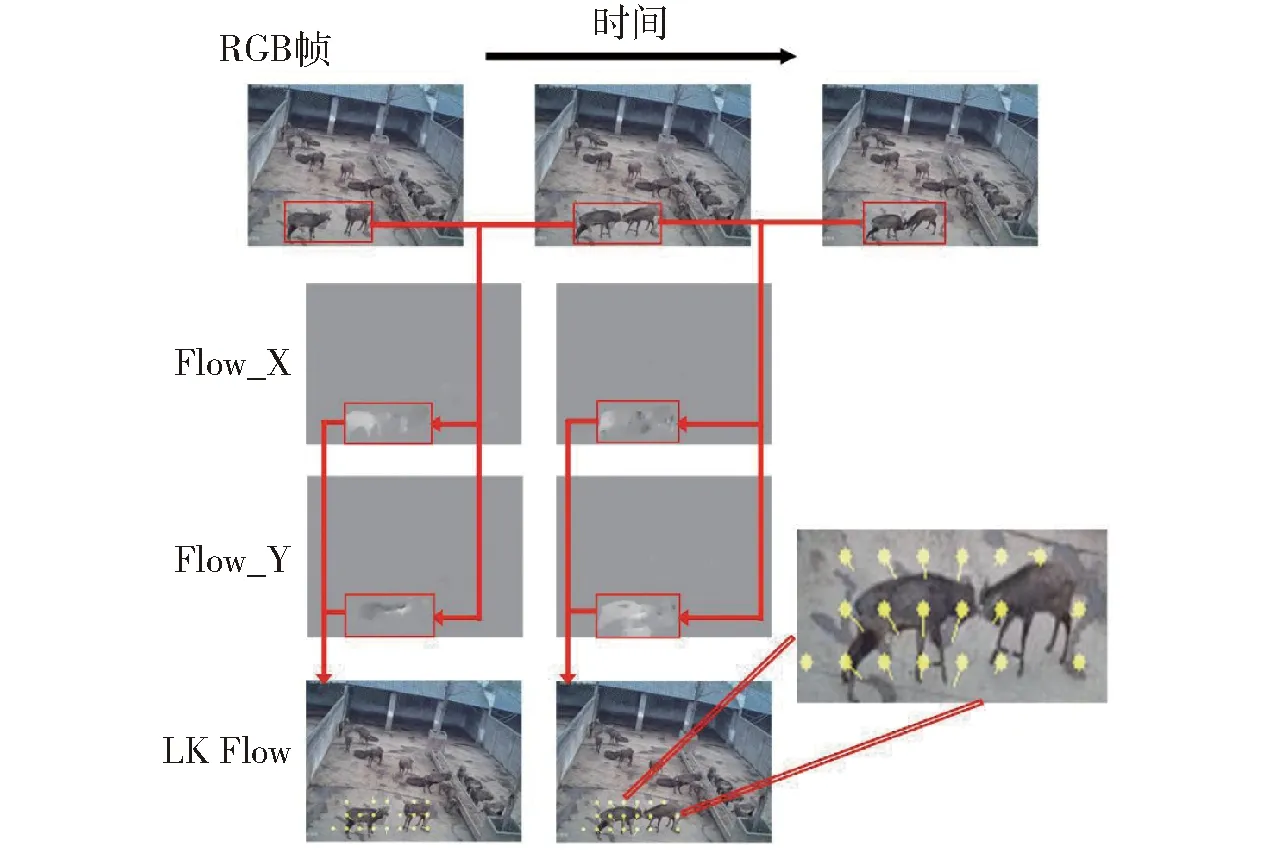

观察鹿只日常情况可知,相比于背景鹿只的运动,发生攻击行为的鹿只前后帧图像变化较激烈。为了从背景中提取鹿只,并区分攻击行为与非攻击行为,在前置网络中设计LK光流算法,计算鹿只相邻图像帧(图2中相邻的3帧图像)之间光流数据V。提取光流信息前,先排除图像不清晰、场景光线暗,或有拖尾的行为帧,共排除435个。将剩余文件接入前置网络接口后,根据鹿只行为发生时身体上重点发生变化的位置,计算两帧之间光流V关于X、Y两个方向的信息。

IxVx+IyVy+It=0

(1)

式中Ix、Iy、It——图像中像素点灰度关于X、Y、T方向偏导数

Vx、Vy——X、Y方向光流向量

图2 光流提取过程示意图Fig.2 Extracted optical flow

结合相邻m×m范围内的像素点,采用最小二乘法计算出最终光流信息,并保存光流帧,如图2中Flow_X帧和Flow_Y帧。将X、Y方向光流信息结合生成输出矢量V并在前一帧图像上显示,即图2中LK Flow帧。将LK Flow帧放大后,黄色点(图2右图中小圆点)表示像素起始位置,引出线表示像素点的光流方向。可以直观看到,RGB帧经前置网络处理后,输出的光流帧能够捕获到运动的鹿只。由此可知,LK光流法能够关注行为的位置变化,忽略计算背景光流信息,有效节约制作光流数据集的时间成本。

2.1.2基础网络和时序网络

为了快速提取攻击行为特征信息,如攻击行为发生时鹿角、鹿蹄等位置变化,减少背景等非行为特征计算,节省网络计算成本,从而提升视频识别的效率和正确率,在基础网络和时序网络中引入了注意力机制。基础网络和时序网络在长期递归卷积网络(Long-term recurrent convolutional networks, LRCN)[24]的基础上针对鹿的攻击行为进行改进和搭建(图3a中基础网络和ALST)。长期递归卷积网络是一种将卷积神经网络和长短时序网络相结合的网络,能够提取序列视频或图像特征,并预测目标动作信息。基础网络负责计算RGB、光流数据集中的行为特征值;时序网络基于长短记忆序列建模时序信息,并输出得分;最终通过分类器按特征权重的差异分类,输出攻击、采食、躺卧和站立4种行为得分。

由于网络训练长视频时,随着时间维变化会遗忘最初的行为信息,所以本文通过ALST提取行为时序信息。输入数据集视频帧尺寸为320像素×240像素,每段视频选取首尾2帧以及中间随机的3帧进行训练。对数据集中每一段RGB帧、光流帧进行transformer处理后,尺寸裁剪为3×224×224和2×224×224(深度×帧长×帧宽),并通过pytorch框架的dataloader接口分别传入基础网络中,调用forward函数进行训练。

图3 OAAR结构示意图Fig.3 Structure diagram of OAAR

基础网络由空间网络(Spatial ARNet152)和时间网络(Temporal ARNet152)构成。RGB帧和光流帧分别经过由ARNet152搭建的空间网络和时间网络提取特征权重,并将权重传入ALST网络。ARNet152在ResNet152网络基础上插入自注意力卷积模块[26](Attention key),即自注意力卷积模块替换ResNet152中的3×3卷积键,自注意力模块可建模动、静态上下文信息,提取鹿只攻击行为特征,提高鹿只行为识别的精度,如图3b所示。ARNet152网络中,数据先经过3个卷积核为3×3的卷积键卷积计算,第1个2Dconv步长为2,其余卷积层步长为1,填充像素(padding)均为(1,1)。卷积键(Convolution key)包含1层2Dconv卷积层、1层GN(Group normalization)层、1层ReLU层,卷积层左边绿色框为通道数,右边橙色框为特征图输入、输出尺寸。数据依次经过包含3、8、36、3个Bottleneck的残差块(Blocks)提取特征权重。经过4个循环提取特征后,通过自适应池化层(AvgPool)输出3×1×1特征图,并输入ALST网络中。第1至第4循环的第1个Bottleneck的自注意力卷积模块和下采样步长均为2,填充像素均为(1,1),以减少输入参数量,防止参数太多数据爆炸。Bottleneck由主路径(main path)和捷径(shortcut)组成。主路径包括2个1×1 conv卷积键和1个自注意力卷积模块。自注意力卷积模块输入的特征值X重新定义为Key Map、Query和Value Map 3个值。先将Key值进行3×3卷积,输出静态上下文建模矩阵K1。融合计算K1和Query值后,进行2次1×1卷积计算,输出动态上下文Attention矩阵。经Attention矩阵与Value值卷积计算后,由Softmax输出自注意力特征值Y。每个循环中第1个Bottleneck的捷径由1个1×1 conv卷积键构成(图3b虚线框),实现对数据降维,输出维度即卷积键通道数,其余捷径(图3b实线框)不经过降维,直接将主路径输入数据与输出结果相加,blocks下的数字表示循环次数。

ALST网络由2层512个LSTM单元组成的时序结构和1层注意力机制层组成,注意力机制层计算公式为

(2)

式中at——源端对齐位置(aligned position)向量

ht——decoder隐状态

hs——源端隐状态

align()——对齐函数

每个LSTM单元由输入门、遗忘门和输出门构成,实现对数据特征时序信息的提取计算,注意力机制层的作用是为了减少遗忘门遗忘量。时序信息建模完成后输入分类器。分类器(Classifier)由1层全连接层和1层softmax层构成,将双流信息融合计算后,对不同类别的特征权重分类,最终输出4类行为得分。

OAAR网络的主要改进包括:①加入前置网络。前置网络由LK光流算法提取前后帧中的动作形成光流数据帧,增强后续网络输入的运动信息,减少背景的影响。②用自注意力模块替换ResNet152网络中残差结构的3×3卷积键,同时用GN层替换BN层,加上ReLU层和dropout层组成新的残差结构。自注意力模块可建模动、静态上下文信息,提取鹿只攻击行为特征,提高鹿只行为识别的精度。③LSTM层中间插入注意力机制层,减少LSTM单元中遗忘门的遗忘量,改进时序网络,加强对时序信息的提取。除了对网络结构进行改进外,本文在网络训练方式中也进行了改进,每段训练样本视频选取首尾2帧以及中间随机3帧进行训练,突出行为视频中关键动作特征的提取,同时节省网络训练成本。

2.2 网络参数设置

2.2.1损失函数设置

OAAR结合双流信息得分通过标准分类交叉熵损失(Cross-entropy loss)得到损失函数。采用交叉熵损失函数的优势在于,输出值和真实值的差值仅与最后一层权重梯度成正比,能够加快网络收敛速度。同时,网络反向传播的连乘计算,会加快更新整个权重矩阵。另外,多分类交叉熵损失函数求导更易求解,其损失率仅与正确类别的概率相关,降低了网络的计算量。损失函数公式为

(3)

式中yi——类别i的真实值

C——总类别数L——损失函数

2.2.2网络参数初始化

网络训练平台使用64位ubantu18.04系统,搭建GPU版pytorch框架,采用单GPU(GeForce GTX 1080 12GB,NVIDIA,美国)进行训练。网络采用随机梯度下降法 (SGD) 作为优化器,动量设为0.9,能够有效抑制振荡,加快收敛速度。批量大小(Batch size)设为8,批量大小过小会导致训练速度太慢,过大会导致显卡占用内存溢出。迭代周期(Epoch)设为100,初始学习率设为1×10-3,Dropout设为0.8,增加迭代次数,降低学习率,能够使网络输出模型识别效果更精确,提升训练速度。但网络训练到一定程度时,模型趋于饱和且学习停滞,所以在第30和第60个迭代周期,学习率为原来的1/10。

3 结果与分析

3.1 模型训练过程分析

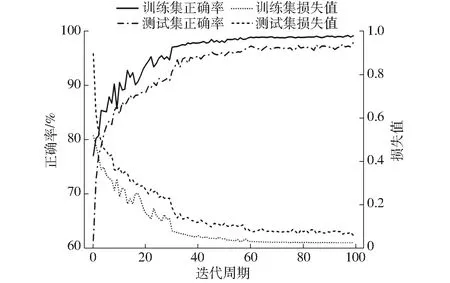

为解决网络深度增大时鲁棒性差的问题,在正式训练前,先预训练OAAR网络。将空间网络加载ImageNet预训练权重初始化网络,输出空间网络权重后,时间网络加载该权重完成初始化训练。采用pytorch自带tensorboardX记录模型训练过程,模型正确率和损失值如图4所示。由于设置训练迭代次数到达第30和第60个迭代周期时,学习率下降至原来的1/10,所以在第30个迭代周期时,正确率出现大幅增加,损失值大幅减小;在到达第60个迭代周期前训练集正确率和损失值逐渐趋于稳态;第60个迭代周期后,训练集正确率继续小幅提高,损失值小幅下降。验证集验证过程中的正确率、损失值和训练集对应的值贴合较好,较为近似。在模型中适当调低学习率有助于网络加快学习速度和对特征点细节的继续学习。最终得出OAAR网络模型在训练集上正确率为99.16%,损失值为0.026 4,在验证集上正确率为97.91%,损失值为0.061 2。

图4 OAAR网络识别正确率和损失值Fig.4 Recognition accuracy and loss value of OAAR

3.2 行为识别评价指标与结果

采用正确率(Accuracy)、召回率(Recall)、精确率(Precision)和F1值(F1 score)[15]作为评价模型性能的指标。

正确率常被用于评价鹿只所有行为识别正确的比重,但当样本不平衡时,仅依靠正确率不能正确评价模型。因此采用召回率、精确率和F1值对模型进行综合评价。PR曲线中的平衡点(BEP)对应F1值的计算结果,表示模型的综合性能。

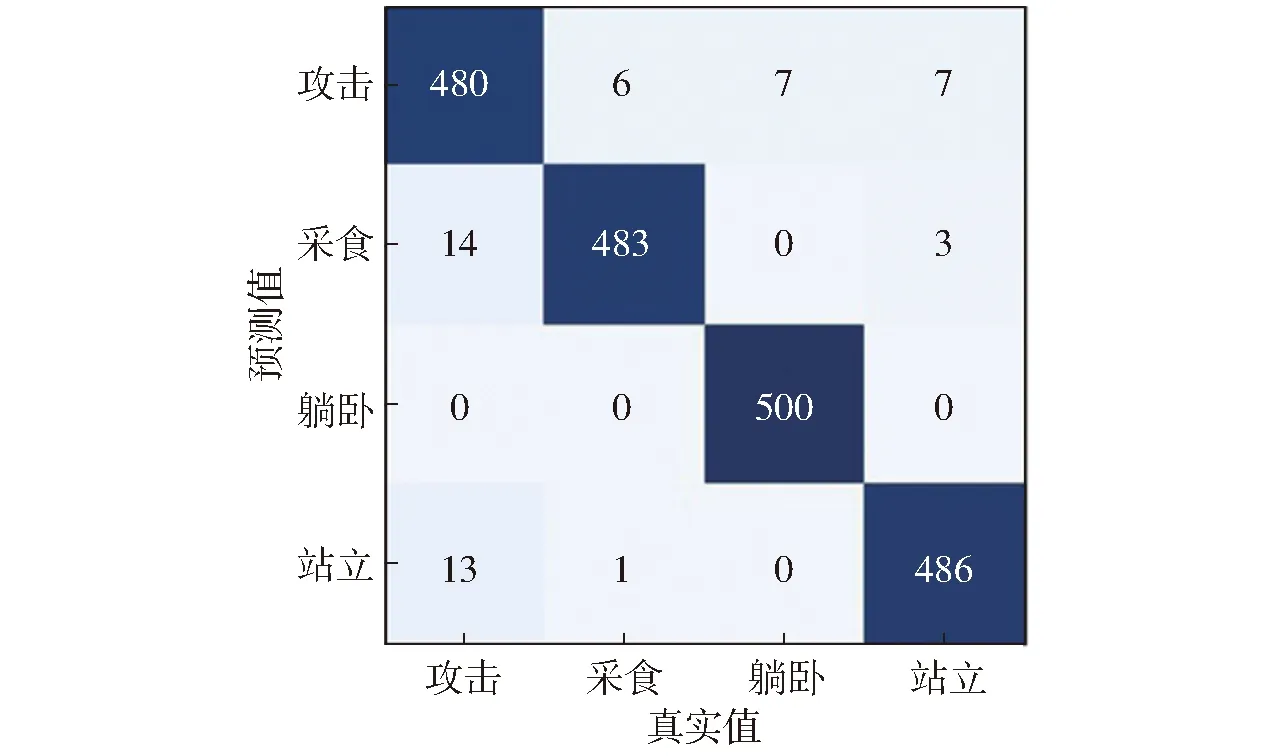

测试集中每类行为包含500段视频,合计2 000段视频,其中共1 949段视频被正确识别,51段视频未能被正确识别,OAAR网络混淆矩阵如图5所示。模型对攻击、采食、躺卧、站立行为识别精确率分别为96.00%、96.60%、100%、97.20%。

图5 OAAR分类结果混淆矩阵Fig.5 Confusion matrix of OAAR

由图5可知,攻击行为的精确率较其它3种行为略低。原因可能是:①鹿只严重重叠或遮挡时,识别较为困难。部分视频帧中出现鹿只之间严重重叠、遮挡问题,如鹿只的头部、脚部被其他鹿只或树等物体全程遮挡时,模型未能检测到鹿只攻击动作。②攻击行为发生时间极短时难以识别。当鹿只攻击行为持续时间太短,部分视频只持续1~2帧攻击动作,这部分行为较难被模型识别。③发生行为时前后帧图像变化幅度较小时较难识别。攻击动作发生的前后两帧变化幅度很小时,前置网络难以获取其动作,模型的注意力在鹿只的其他行为,导致攻击行为的置信度低于其他行为,所以分类结果输出为非攻击行为。

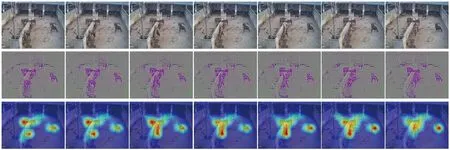

从特征可视化角度验证OAAR网络识别效果,如图6所示。图中第1行为测试集中随机选取的一段连续的攻击行为帧,第2行为通过网络最后一层卷积操作输出的特征可视化结果,第3行在第2行基础上通过特征注意力机制生成热力图,颜色越偏近暖色表示攻击动作越激烈。从热力图中可以观察到,高亮部分集中在发生不同程度攻击行为的3个区域。因此,验证了自注意力模块能够有效识别鹿只攻击行为。

图6 特征可视化Fig.6 Feature visualization

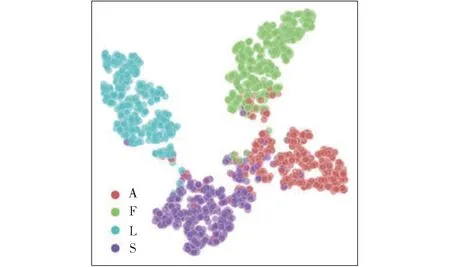

将网络最后1层特征映射在二维空间,如图7所示。图中每个点代表测试集的1段视频,每个行为类别采用一种颜色表示,类别A(攻击)、F(采食)、L(躺卧)和S(站立)特征映射点分别采用红色、绿色、蓝色、紫色表示,图7中不同行为分别聚集于4个角,攻击行为与躺卧、站立、采食有很少量混杂,且每种行为自身的聚集度较高。特征嵌入图说明了OAAR网络对攻击、采食、躺卧和站立行为类别的区分度较高。

图7 特征嵌入Fig.7 Feature embedding

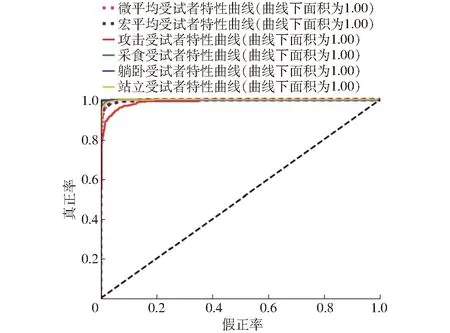

图8 ROC曲线Fig.8 ROC curve

4种行为的受试者特性(ROC)曲线如图8所示。ROC曲线均位于随机猜测线左上方,曲线距左上角越近,显示分类结果越准确。采用宏平均和微平均综合评价网络分类性能。宏平均先计算每类行为ROC值,再计算算术平均值;微平均先计算所有类真正率和假正率的平均值,再作ROC插值。从图8可知,采食、躺卧和站立行为接近理想指标,即对某类识别效果极好,攻击行为趋于理想指标,各分类的曲线下方面积(AUC)均趋于1。综上所述,OAAR能够对各类行为进行较好的识别和分类。

3.3 不同网络对比分析

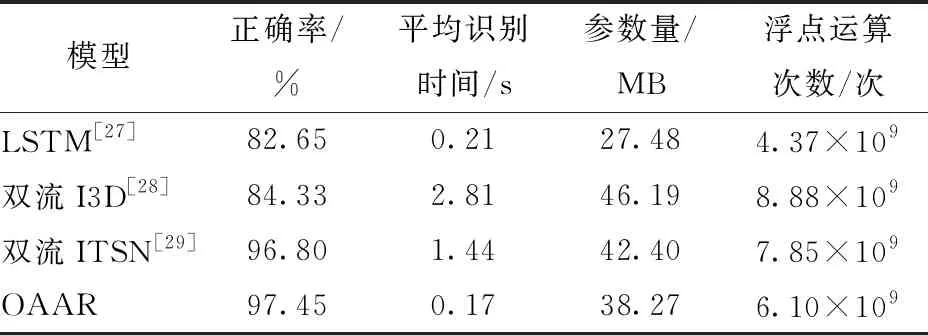

为了验证OAAR网络对梅花鹿行为识别的有效性,选取长短时记忆网络(Long short term memory network,LSTM)[27]、双流I3D网络(Two-stream inflated 3d convNets)[28]和双流ITSN网络(Improvement temporal segment network)[29]与OAAR网络进行对比验证。LSTM采用decoder和encoder两个环节配合完成行为识别。双流I3D网络采用膨胀3D卷积计算RGB、光流数据特征,利用空间感受野融合时间感受野,实现特征信息识别和分类。双流ITSN基于长范围时间建模,在原本TSN网络的基础上替换2D卷积为3D卷积。用视频数据集分别训练各网络,并将各网络在测试集上的识别结果与本文中的OAAR网络的分类结果进行对比分析。结果如表3所示,各网络模型正确率分别为82.65%(LSTM)、84.33%(双流I3D)、96.80%(双流ITSN)和97.45%(OAAR)。

表3 当前常用网络模型比较Tab.3 Comparisons with state-of-the-art results

由表3可知,OAAR识别单个视频的平均时间明显短于LSTM、双流I3D和双流ITSN。由于双流I3D网络基于3D卷积的InceptionV1网络提取特征[28],网络的参数量和浮点运算次数剧增,同时识别单个视频的时间也会增加。双流ITSN网络中,采用视频分段的形式训练模型网络[29],并使用Resnet3d-50作为提取特征的基础网络,基础网络中的残差结构能够有效降低实际训练的参数量和浮点运算次数,同时提升网络的识别正确率。LSTM的基础网络采用传统2D卷积的CNN网络[27],提取单帧图像特征后,传入LSTM单元中关联前后行为特征信息,参数量和浮点运算次数在4种网络中最小,但由于基础网络没有提取到有效的攻击行为特征,该网络的识别正确率较其他网络略低。在OAAR网络中,基础网络基于注意力机制模块和残差结构搭建的ARNet152,侧重提取鹿角、鹿蹄等攻击行为特征,同时时序网络中的注意力机制能够有效减少遗忘门的遗忘量,从而提高了视频行为识别的效率和正确率,验证了注意力机制的有效性。

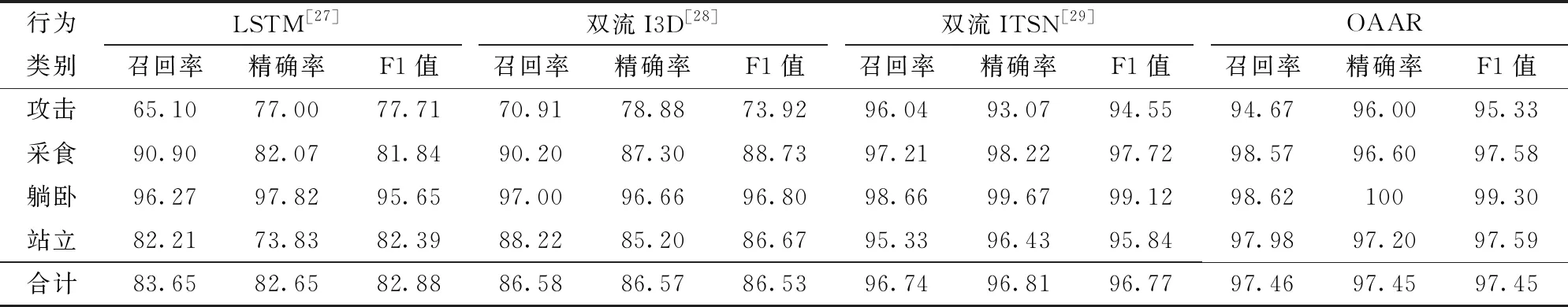

表4分别列出了4种网络对测试集识别的结果,OAAR精确率为97.45%,召回率为97.46%,远高于LSTM精确率(82.65%)、召回率(83.65%)和双流I3D精确率(86.57%)、召回率(86.58%),略高于双流ITSN精确率(96.81%)、召回率(96.74%)。相比于LSTM网络、双流I3D网络和双流ITSN网络,OAAR网络主要从4方面优化了其性能:①前置网络提取了行为随时间变化的动作特征。前置网络提取鹿只身体的位置变化,抑制背景噪声的影响。通过训练双流网络后,取空间和时间网络输出得分的均值,有效提升网络行为识别的准确度。②自注意力模块使发生攻击行为的鹿只更加突显。由于在基础网络中使用自注意力卷积模块加工动、静态上下文信息,提取鹿只攻击行为特征,较大提升了鹿只攻击行为识别正确率。③残差结构能够获取更多行为特征信息。残差结构保留了更多的低层特征信息,在网络加深的过程中,有效避免了过拟合、梯度爆炸和消失等问题,加快网络训练进程。④每段视频选取首尾2帧以及中间随机的3帧进行稀疏训练。为避免行为视频过长时导致重要行为特征削弱的现象,每段视频选取首尾2帧以及中间随机的3帧进行训练,以便在训练过程中突出视频中的关键动作特征,节省训练成本。

表4 各模型性能统计Tab.4 Performance statistics of models %

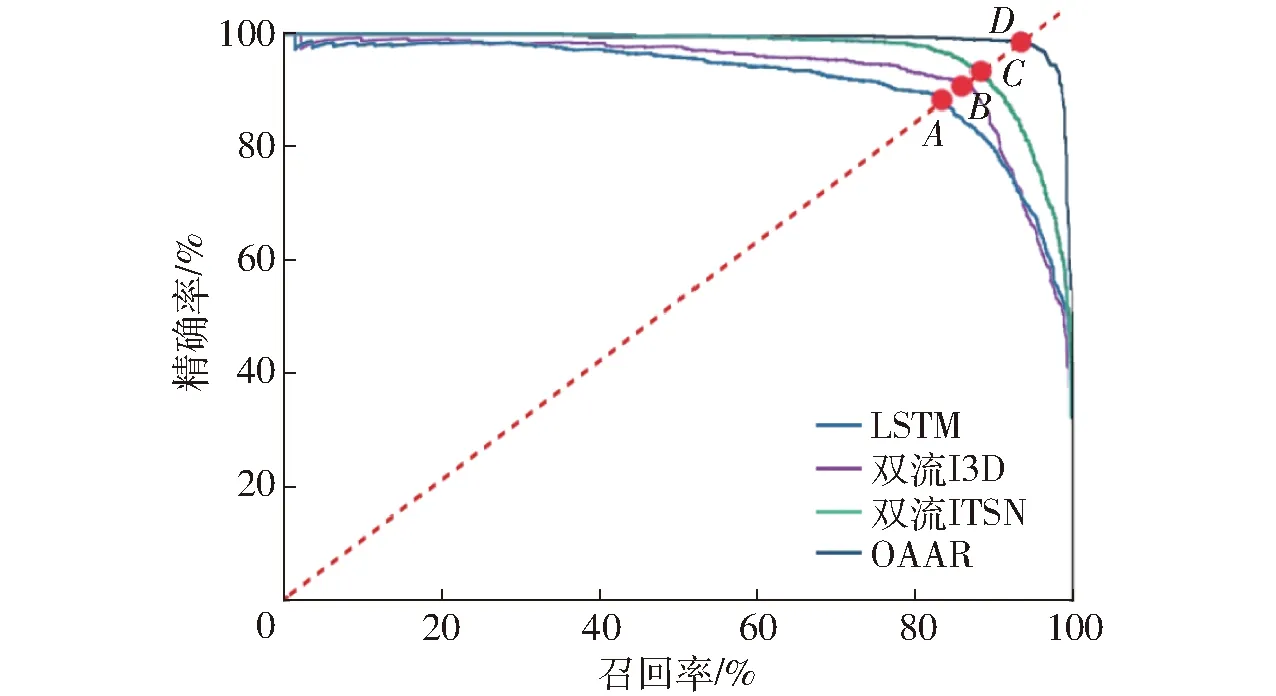

用精确率-召回率曲线直观比较4种网络识别效果,如图9所示。点A、B、C、D为4种网络的精确率-召回率曲线的平衡点,对应各网络的F1值。图9中, OAAR网络的平衡点D高于点A、B、C,说明OAAR网络识别效果优于LSTM网络、双流I3D网络和双流ITSN网络。

图9 精确率-召回率曲线Fig.9 Precision-recall curves

图10 鹿只行为自动识别系统Fig.10 Sika deer behaviors’ automatically recognition system

4 模型部署及应用

基于OAAR网络搭建的鹿只行为自动识别系统如图10所示。该系统采用摄像头获取视频上传至服务器,后端框架调用服务器中部署的OAAR网络模型,计算视频鹿群中是否发生包括攻击、采食、站立、躺卧行为,并进行置信度打分,并将鹿群中发生的行为打上时间戳存储在服务器中的MySQL数据库中,相关信息可通过网页发布,并供用户远程访问。

5 结论

(1)新增了前置网络提取光流数据。前置网络采用LK光流算法计算光流数据帧,提取前后帧中鹿只身体位置的变化,抑制背景噪声的影响。其输出的光流数据帧与RGB数据帧共同作为基础网络的输入数据,进一步加强了行为特征,削弱了背景噪声,试验证明了本文方法能够有效解决行为被遮挡的问题。

(2)将注意力机制分别加入基础网络和时序网络。基础网络中将自注意力卷积模块替换为ResNet152中的3×3卷积层,分别加工动、静态上下文信息。时序网络在2层LSTM层中加入注意力机制层,减少LSTM单元中遗忘门的遗忘量,提升网络处理时序信息的能力。

(3)OAAR网络在测试集上的识别正确率高达97.45%,高于LSTM正确率(82.65%)、双流I3D正确率(84.33%)和双流ITSN正确率(96.80%)。OAAR精确率和召回率也分别优于其它3个网络。受试者特性曲线和特征嵌入图均显示了OAAR网络具有较好的区分性、泛化和抗干扰能力。

(4)集成OAAR网络的鹿只行为自动识别采集系统实现了梅花鹿行为的自动识别功能,为提高梅花鹿养殖生产管理水平和生产效率提供了可行的途径。