一种改进的U-Net网络用于黑色素瘤病变分割研究

2022-08-31代楚航文正洙

代楚航 文正洙

摘要:残差网络(ResNet)和密集连接网络(DenseNet)显著提高了深度卷积神经网络(DCNNs)的训练效率和性能,但二者存在识别连续特征能力不足、模型复杂等缺陷。密集残差(DR-Net)网络将残差网络与密集连接网络的优异处结合起来,模型结构较DenseNet精简,与ResNet相比,额外加入了的跳跃链接。研究将该方法集成到一个编码器-解码器DCNN模型中,用于图像分割。利用ISIC2017挑战测试集,得到训练完成的DRU-Net卷积网络评估指标。结果表明,与基于ResNet、基于DenseNet的方法相比,该研究方法获得了更高的分割精度。

关键词:卷积神经网络;医学图像分割;黑色素瘤;DR-Net;ResNet;DenseNet

中图分类号:TP183 文献标识码:A

文章编号:1009-3044(2022)18-0001-02

开放科学(资源服务)标识码(OSID):

1 引言

黑色素瘤作为一种常见且高危险性的皮肤癌,目前的检测方法是在皮肤镜下生成高分辨率的皮损图像。但医疗资源紧张,癌变诊断耗时且对医生专业素养要求极高,因此计算机辅助医疗显得格为重要,而皮肤病变图像分割在该诊断研究中占据尤其重要的位置。过去十年间,有如阈值处理、活动轮廓模型、监督学习等[1-2]算法被开发出来用于皮损图像分割。但以上方法均有耗时、复杂、对医学知识储备要求较高等不足之处。由Long等人开发的一种用于语义分割[3]的全卷积网络(Fully Convolutional Network,FCN),该模型DCNN反卷积层被卷积层替换,对标签图进行上采样获取每一特征像素的分类结果。2015,U-Net[4]这种新类FCN结构被Ronneberger等人提出,首次被应用于细胞图像分割。目前提出的U-Net的几种变体,主要集中于提高特征信息在层内和层间传递的分割精度和效率。

如,H-DenseU-Net[5]结合了密集连接的网络[6]和U-Net的方法,用于三维肝脏和肿瘤分割。U-Net++[7]应用不同层间的密集跳跃连接,将编码器与解码器连接到一起。MDU-Net[8]提出在U-net中同时增加三个多尺度的密集连接,即密集编码器、解码器及其之间的连接。以往的研究,多通过集成复杂的网络模块获得更好的性能,这需要学习更多参数。本研究对比残差网络与密集网络的性能,提出一些改进。相较残差网络、密集网络的方法,本研究的方法需要更少的模块参数。

2 DRU-Net

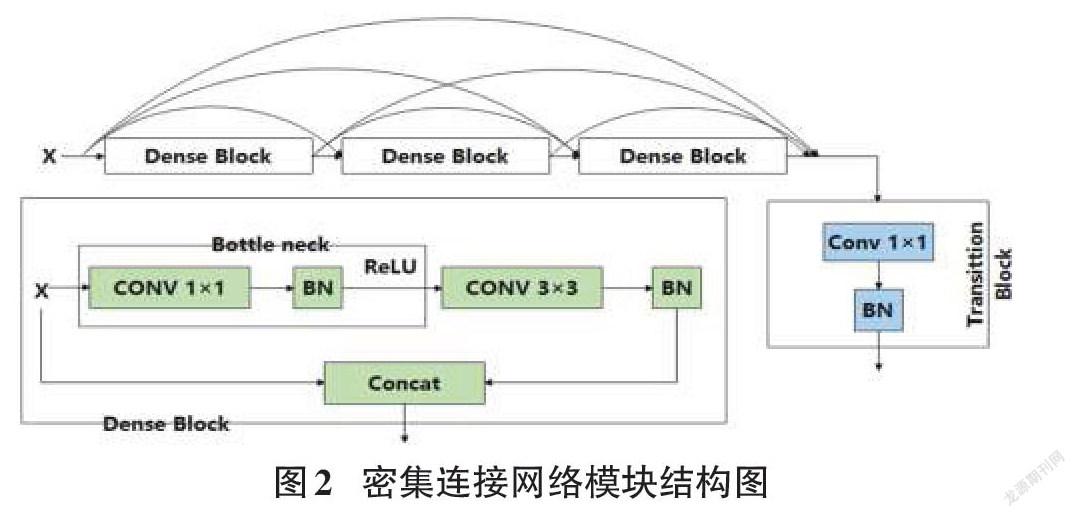

选择U-Net作为不同网络块性能比较的基本结构。除了原始的U-Net之外,每一层都添加一个批规范化(BN),用于网络模型实现更快更稳定的训练任务。区别于传统Conv-ReLU,ResNet在C-R-C-R的环节中加入了快速连接,如图1所示。DenseNet结构由数个相互连接的密集块组成,如图2所示。每个密集块的输入,是当前所有密集块的输出与第一个密集块的原始输入连接的特征图。

残差连接原理是将输入与输出特征相加,密集连接模块将之前连接模块的输出与原本输入连接到一起。残差网络最大的不足之处是缺少先前卷积输入的连续特征。而密集连接网络可以从先前的卷积块中提取特征,保证梯度有效传输的同时,融合更丰富的信息,在连续图层中进行特征提取,但此方法需额外进行特征图降维,高效特征图合并的代价是额外的运算参数与繁杂的网络结构。

综合两种两个网络的优缺点,DRU-Net在编码器与解码器中应用如图3两种方法。

研究将第一个Conv-BN操作的输出和最后一个Conv-BN的输出之间添加一个额外的连接(图1中的圆形部分)进行特征图求和操作。将编码器中的第一个卷积与最后一个卷积结果做残差连接,再与输入连接得到合并输出结果。在解码器中,在第一个卷积块与最后的卷积结果间,应用残差连接操作,再与输入经卷积1×1降维后的结果拼接,得到合并输出结果。综合两种操作的模块即为密集残差模块(DR)。研究将集成的密集残差模块(DR)应用到U-Net的编码器和解码器中,得到改进的DRU-Net网络模型。基于上述修改,DRU-Net的总体方案如图4所示。

3 实验与结果

3.1 实验数据集与运行环境

3.1.1 ISIC2017

本研究应用国际皮肤成像协作组织(ISIC)提供的开源黑色素瘤病变皮肤镜图像数据库ISIC2017数据集。包含2000幅训练图片、150幅验证图片和600幅测试图片,尺寸540×722~4499×6748。每幅图像均包含人工标注。经裁剪翻转等处理后,扩增为13000张,尺寸统一改为512×512。

3.1.2 运行环境

实验的仿真平台为Pycharm,利用TensorFlow框架对模型进行了训练和测试。GPU為RTX2080Ti(11G),操作系统为Windows 10,编程语言Python3.7。对比模型的编码器与解码器路径层数均为5。实验选用Adam优化器,损失函数为交叉熵损失函数,初始学习率设为0.001。对ISIC2017数据集,所有方法均进行50次迭代训练,批次大小为8。

3.2 算法评价指标

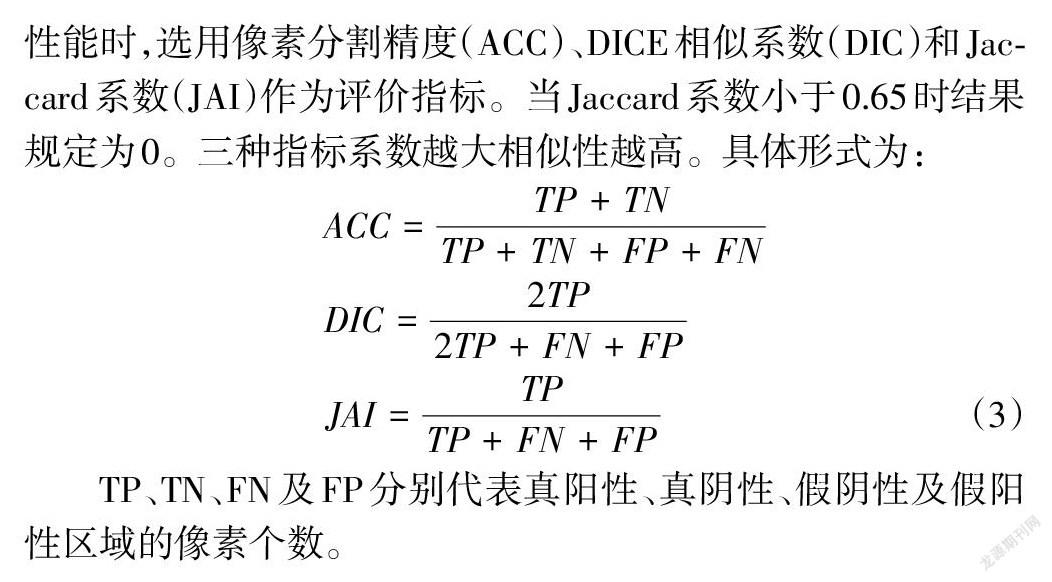

皮肤病图像分割主要工作是分割病变区域,因此衡量算法性能时,选用像素分割精度(ACC)、DICE相似系数(DIC)和Jaccard系数(JAI)作为评价指标。当Jaccard系数小于0.65时结果规定为0。三种指标系数越大相似性越高。具体形式为:

[ACC=TP+TNTP+TN+FP+FN]

[DIC=2TP2TP+FN+FP]

[JAI=TPTP+FN+FP] (3)

TP、TN、FN及FP分别代表真阳性、真阴性、假阴性及假阳性区域的像素个数。

3.3 实验结果

在ISIC 2017数据集分别对训练好的U-Net、残差U-Net网络(RU-Net)、密集连接U-Net网络(DU-Net)与改进DRU-Net网络进行评估。实验结果表1表明,U-Net的ACC精度,DIC系数与Jaccard系数值最低。在DIC、Jaccard与精度ACC方面,DU-Net的性能优于U-Net与RU-Net。对比本次实验的其他网络,本研究的改进DRU-Net在各项指标性能上均为最优。U-Net、RU-Net、DU-Net的可视化预测图如图5所示。可以看出,DRU-Net的分割结果,尤其是病变边界周围区域,与真实标签更为接近。U-Net与RU-Net无法精确的分割病变边界。

4 讨论

本研究将基于编码-解码器结构的改进卷积网络DRU-Net用于黑色素瘤病变分割任务。结合Dense-Net和Res-Net的优势。将每一层的输入到输出进行连接,利用特征映射聚合的方 式,使得模型学习效率更高。通过在ISIC2017皮肤损伤数据集上评估U-Net,RU-Net,DU-Net与改进DRU-Net方法。本研究的改进DRU-Net具有显著的优异性,尤其针对像素少、待分割区域面积小的皮损图像。笔者只证明了改进DRU-Net在编码器-解码器DCNN模型中图像分割精度的优异性。将此改进模型应用于其他具有更大数据集的适用性与优异性将会在之后的工作中研究。

参考文献:

[1] Korotkov K,Garcia R.Computerized analysis of pigmented skin lesions:a review[J].Artificial Intelligence in Medicine,2012,56(2):69-90.

[2] Silveira M,Nascimento J C,Marques J S,et al.Comparison of segmentation methods for melanoma diagnosis in dermoscopy images[J].IEEE Journal of Selected Topics in Signal Processing,2009,3(1):35-45.

[3] Shelhamer E,Long J,Darrell T.Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[4] Ronneberger O,Fischer P,Brox T.U-net:convolutional networks for biomedical image segmentation[J/OL].[2015?05?18].https://arxiv.org/pdf/1505.04597.pdf.

[5] Li X M,Chen H,Qi X J,et al.H-DenseUNet:hybrid densely connected UNet for liver and tumor segmentation from CT volumes[J].IEEE Transactions on Medical Imaging,2018,37(12):2663-2674.

[6] Huang G,Liu Z,van der Maaten L,et al.Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.July 21-26,2017,Honolulu,HI,USA.IEEE,2017:2261-2269.

[7] Zhou Z W,Rahman Siddiquee M M,Tajbakhsh N,et al.UNet++:a nested U-net architecture for medical image segmentation[C]//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support,2018:3-11.

[8] Zhang J W, Jin Y Z, Xu J L, et al, MDU-Net: Multi-scale Densely Connected U-Net for biomedical image segmentation[J] .10.48550/arXiv.1812.00352,2018.

【通联编辑:唐一东】