裁判文书诉辩双方互动论点对识别方法研究

2022-08-02王宇杰

张 虎,季 泽,王宇杰,李 茹,2

(1. 山西大学 计算机与信息技术学院,山西 太原 030006;2. 山西大学 计算智能与中文信息处理教育部重点实验室,山西 太原 030006)

0 引言

近年来,人工智能与大数据技术的快速发展推动了智慧司法服务的广泛应用,当前面向司法行业真实需求的司法服务越来越多地依赖于自然语言处理技术,我国司法部2019年在开展的“数字法治、智慧司法”信息化建设中指出,运用大数据和人工智能等技术引领和带动司法事业发展是一项意义重大的任务。为进一步促进智慧司法相关技术的发展,推动自然语言处理技术在裁判文书争议焦点提取问题中的应用,“中国法研杯”司法人工智能挑战赛 (CAIL) 于2020年开设了论辩挖掘任务。

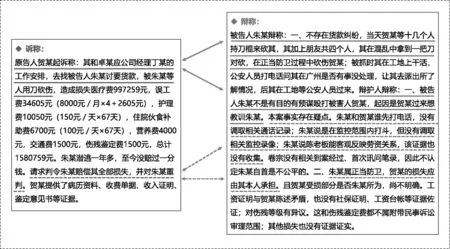

裁判文书诉辩双方互动论点对的识别是归纳案件争议焦点的前提和基础。诉辩双方互动论点对由原告诉方的控诉和被告辩方相应的抗辩组成。裁判文书只记载了法院审判过程中诉辩双方的完整陈述,并没有进一步细化形成条理清晰、逻辑鲜明的诉辩交互论点对,仍需要法官人工阅读并对其进行分析与整理,这一步会耗费大量的时间与精力。图1显示了裁判文书中的诉辩双方陈述交互示例。

图1 裁判文书中的诉辩双方陈述交互示例

目前针对论辩中互动论点对识别的研究主要面向英文论坛数据,Tan等人[1]依托国外社交网站辩论版块中丰富的辩论资源构建了英文辩论数据集,Ji等人[2]在此基础上构建了一个互动论点对数据集,提出了互动论点对识别任务。已有研究主要从重构论点表示入手,未利用效果更好的预训练语言模型获得通用的语言特征表示,也未考虑模型的鲁棒性与泛化性能。基于此,本文主要面向中文司法领域的数据集进行互动论点对识别研究,主要贡献包括:

(1) 基于预训练语言模型和微调方式实现诉辩论点的特征表示;

(2) 利用注意力机制获得诉辩论点的交互表示;

(3) 采用对抗训练增强模型的鲁棒性与泛化能力。

1 相关工作

目前关于互动论点对识别的相关研究主要有以下几个方面: 论点与论辩的定义、计算论辩的发展及自然语言处理技术在其中的应用,以及对抗训练的相关内容。

论点是对所要论述的问题提出的主张及理由。Walton等人[3]定义论点由三类部件构成: 一系列前提,一个结论以及从前提到结论的推论。论辩则是使用论点来达到说服、同意的效果。根据论辩类型的不同,Wachsmuth等人[4]将论辩分为独白式论辩和对话式论辩,按表达方式的不同又可细分为口述式和文本式,独白式论辩可看作由一位参与者对某一特定问题进行论述,例如,政治演说、主题演讲属于口述式独白论辩,新闻社论、议论文写作属于文本式独白论辩。Besnard等人[5]认为对话式论辩可看作由多位参与者进行的一系列论点的互动。Hunter等人[6]认为对话式论辩发生在讨论、辩论、劝说、谈判等过程中,是参与者之间直接观点冲突的对话过程,例如,辩论赛、日常争论属于口述式对话论辩,在线论坛讨论、社交网站上的评论反驳属于文本式对话论辩。

近年来,计算论辩成为自然语言处理的一个研究热点。当前工作主要针对文本形式的论辩,即文本式独白论辩与文本式对话论辩。主要研究方向有论点与论辩的计算模型、论辩分析与总结的计算方法、用于论辩开发与评估的语料资源和基于论辩模型与方法的应用等[4]。计算论辩在应用方面有Wachsmuth等人[7]研究的论点搜索引擎,可根据用户输入的主题,自动返回与主题相关的论点;Rinott等人[8]研究的决策支持助手,可根据用户给定的结论,自动给出支持的前提(也叫证据);Wang等人[9]研究的自动论点摘要,能够从大量的观点性信息中生成简洁连贯的观点摘要;Samadi等人[10]的研究主张正确性检测是一项有趣的研究,给定一些断言(也叫主张),然后验证、提取从网络上搜集到的支持或反对主张的证据,再对证据来源的可靠性以及断言正确性进行联合评估;Stab[11]研究的议论文写作支持,能够自动解析议论文中的论证结构。

基于自然语言处理技术进行计算论辩研究的主要内容有论辩挖掘、论辩评估和论辩生成等。论辩挖掘是要自动地从文本中挖掘论点及其关系,Cabrio等人[12]将其分为两步: 一是论点提取,首先要从文本中检测出论点,需要细粒度地识别论点构成部件,如前提和主张;二是关系预测,预测前一阶段提取到的论点间的关系,如支持或反对。廖祥文等人[13]提出了将论辩挖掘的子任务联合并行训练的多任务迭代学习方法。论辩评估是对论点与论辩性质的评估,包括论辩结构评估、论辩推理评估、论辩质量评估等。Wachsmuth等人[14]提出修辞动作流模型,将文本映射到全局特征空间以捕捉独白式论辩的语篇级论证结构。Feng等人[15]介绍了举例论证、因果论证、后验论证等论证推理模式,并按其对论点分类。Wachsmuth等人[16]认为论辩质量包括逻辑、修辞、辩证等方面,逻辑性质由论点说服力体现,修辞和辩证则由论辩的有效性和合理性体现。Ji等人[17]提出了一种基于共同注意力机制的模型,可捕捉对话论辩中参与者之间的交互以应用于论辩说服力评估。Taghipour等人[18]探索了基于循环神经网络的方法建模论文内容与分数的关系以进行论文自动打分。论辩生成是对论点与论辩的总结。Bilu等人[19]利用从主张中回收的谓语来生成新的论点主张。Sanchan等人[20]研究利用聚类方法从大量对话论辩信息中生成论辩话题摘要。Chen等人[21]利用自编码器生成与新闻标题中政治偏见相反立场的观点。杨亮等人[22]针对裁判文书案情描述与判决结果,利用生成对抗网络模型进行控辩焦点的生成。

对话论辩是生活中随处可见的一种论辩方式,多数对话论辩都是非标准化与非结构化的,其内容和形式与标准论证结构有很大差别,目前Misra等人[23]对相似论点识别进行了研究,而对语义有更高要求的互动论点对识别的研究还较少。

为了使模型在解决特定问题的同时还能兼顾其鲁棒性与泛化能力,有关自然语言处理领域中对抗训练的研究逐渐出现。对抗训练可看作应用于监督学习模型的一种正则化手段,通过向原样本中添加微小扰动构建出可能使模型产生误判的对抗样本,再将其与原样本一起在模型中训练,期望模型对原样本与对抗样本能产生相同的输出分布。Miyato等人[24]提出在模型词嵌入位置添加基于梯度的对抗扰动来构建对抗样本,相关实验结果表明,相比于添加随机噪音,这种方法能学到更好的语言特征表示。Sato等人[25]将对抗扰动的方向限制为词向量空间中已有词的位置,从可解释性角度研究了添加到词向量空间中的对抗扰动,在文本分类与序列标注任务上取得了一定的效果。

鉴于预训练语言模型、交互方法和对抗训练在很多任务上的优势,本文结合以上技术提出了裁判文书诉辩双方互动论点对识别方法。

2 互动论点对识别方法

2.1 问题描述

互动论点对识别任务具体描述如下: 给定一句诉方论点sc,五句候选辩方论点candidates=[bc1,bc2,bc3,bc4,bc5],其中包括一项与诉方论点sc在逻辑交互关系上最匹配的辩方论点bcpositive,四项不存在交互关系或存在弱交互关系的辩方论点bcnegative,以及诉方论点与辩方论点所在裁判文书中诉辩双方的完整陈述,模型需要从候选辩方论点candidates中选出与诉方论点sc最具交互关系的一项。

2.2 模型结构

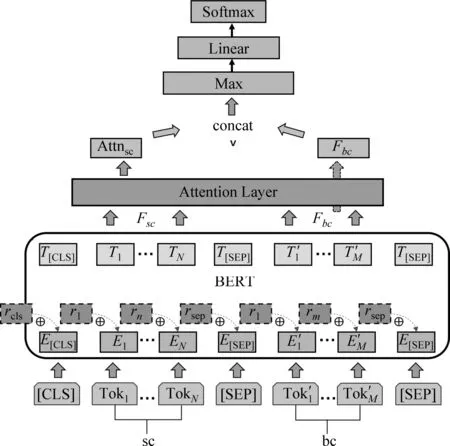

本文结合预训练语言模型BERT、注意力交互方法Attention和对抗训练FGM提出的互动论点对识别模型 (BERTAF) 主要包括四部分: 编码层、交互层、预测层和对抗学习层,模型结构如图2所示。模型的输入为一句诉方论点与一句候选辩方论点,输出为0~1之间的概率值,代表其交互匹配程度。

图2 模型结构图

2.2.1 编码层

编码层将诉方论点与辩方论点的文本符号表示转换为语义空间的向量表示,这里我们利用BERT实现编码转换,输入格式如式(1)所示。

Input=[CLS]+sc+[SEP]+bc+[SEP]

(1)

其中,sc代表经BERTTokenizer处理后的诉方论点句的字符级表示,sc={Tok1,…,TokN},bc代表辩方论点句的字符级表示,bc={Tok′1,…,Tok′M},[SEP]为分隔符, 用于区分诉方论点与辩方论点,

[CLS]为整个输入序列的语义标志位,在向量转换时可作为整个输入序列的集成语义表示。

BERT对输入序列编码后有两个输出,如式(2)所示。

S,C=BERT(Input)

(2)

其中,S代表输入序列Input编码后的向量表示,S={T[CLS],T1,…,TN,T[SEP],T′1,…,T′M,T[SEP]},S∈RL×h,L为输入序列Input的长度,L=N+M+3,N代表诉方论点句sc的长度,M代表辩方论点句bc的长度,h为BERT向量编码维度,T为输入序列Input中每个字符经BERT编码转换后的特征表示,T∈Rh。C代表提取的编码后的[CLS]语义标志位的信息,其融合了整个输入序列编码后的语义信息,C∈Rh。

2.2.2 交互层

交互层Attention Layer的作用是使诉方论点感知到辩方论点,通过计算诉方论点到辩方论点的注意力,获得了诉方论点的新特征表示Attnsc,具体如图3所示。

图3 交互层结构图

(3)

(4)

(5)

(6)

2.2.3 预测层

2.2.4 对抗学习层

对抗学习层的工作是构建对抗样本进行对抗训练。模型在训练时以交叉熵作为损失函数,损失loss具体计算如式(9)、式(10)所示,其中,logits为预测层输出的不匹配与匹配的概率,label为该输入对应的标签,label∈{0,1},label=1代表输入的诉方论点与辩方论点存在逻辑交互关系即是匹配的,label=0则相反。

loss(logits,label)=-logits[label]+log(U)

(9)

(10)

输入序列Input展开如式(11)所示,送入BERT后首先经过BERT词向量矩阵O编码,O∈RV×h,V为BERT词汇表大小,得到输入序列对应的词向量矩阵E,E∈RL×h,如式(12)所示。

Input={[CLS],Tok1,…,TokN,[SEP],Tok′1,…,Tok′M,[SEP]}

(11)

E={E[cls],E1,…,EN,E[sep],E′1,…,E′M,E[sep]}

(12)

前向传播后交叉熵损失函数计算损失loss,再进行反向传播计算损失对相关参数的梯度,其中包括对bert词向量矩阵的梯度g,g∈RV×h,据此构造对抗扰动r,r∈RV×h,具体计算如式(13)、式(14)所示。

其中,ε为超参数,||g||2为梯度g的L2范数。然后将所得的对抗扰动r与BERT词向量矩阵O相加得到新的词向量矩阵Or,Or∈RV×h。将输入序列Input再次送入模型进行预测,先经BERT词向量矩阵Or编码后得到对抗样本Er,如式(15)所示。

(15)

前向传播结束后,利用交叉熵损失函数计算对抗损失lossadv。对抗训练反向传播时与之前原样本反向传播时得到的梯度叠加,对抗训练结束后将添加了扰动的BERT词向量矩阵Or恢复到原词向量矩阵O以准备下一轮训练,此时优化器再根据所求梯度对模型相关参数进行更新。

3 实验

3.1 数据集及评价指标

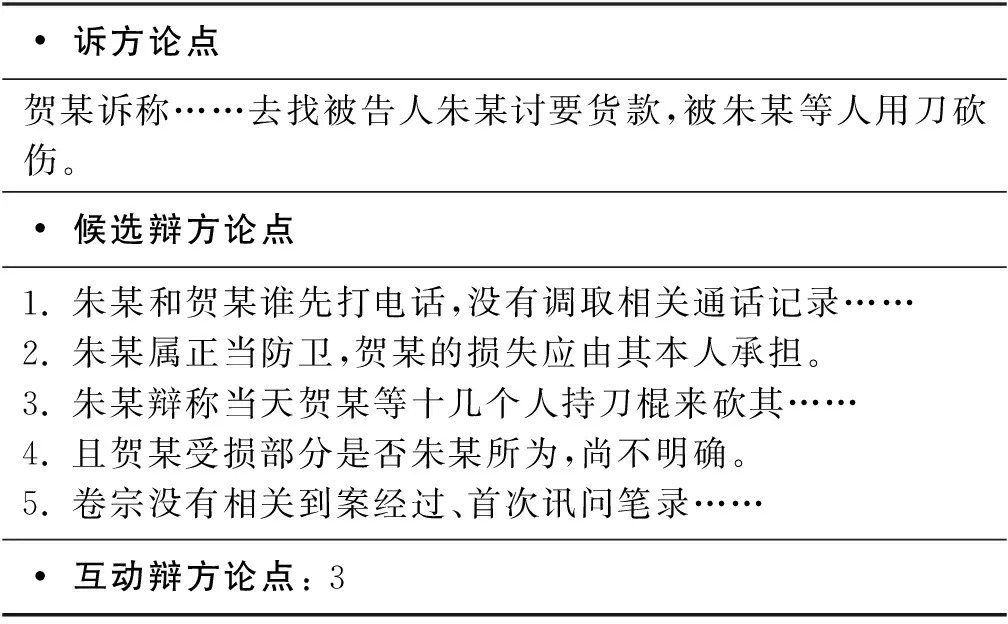

实验数据来源于CAIL2020论辩挖掘任务,每条数据都是经人工标注的存在互动关系的论点对(1)一句诉方论点,五句候选辩方论点以及正确答案。,数据集示例如表1所示。

表1 数据集样例

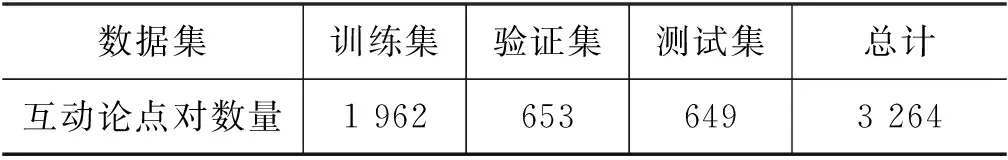

CAIL2020公布了评测过程中两阶段的训练数据,共3 264组人工标注的互动论点对,本文将人工标注的互动论点对按3:1:1的比例划分为训练集、验证集和测试集,具体数据分布如表2所示。

表2 数据集分布

验证集上的评价指标采用宏平均F1macro,即求出每个选项标签的F1值再求平均,具体计算如式(16)、式(17)所示。我们在验证集上调整参数,保证模型性能最优,再应用到测试集上进行测试。测试集上的评价指标采用准确率Accuracy,其计算如式(18)所示,其中,N+代表模型选对的样例数量,N代表测试集总样例数量。

3.2 实验设置

本文使用PyTorch版本的BERT-Base-Chinese预训练语言模型,BERT隐藏层维度为768,设置最大输入序列长度为512。训练期间设定初始学习率为3e-4,采用线性学习率预热方法,预热步数设为总训练步数的50%左右,预热期间学习率从0线性增加到设置的初始学习率,预热阶段之后学习率会从初始学习率线性降低到0。优化器采用AdamW,梯度裁剪中设置梯度最大范数为1e-3,随机dropout比例为0.01,批处理大小为24,共训练10轮。采用两块GPU并行训练,GPU型号为Tesla P100-PCIE-16GB,Python版本为3.6.9,PyTorch(1.5.0+cu101)。实验所用全部代码将放在Github:https://github.com/findQin/interactive-argument-pair-ide-ntify。

3.3 实验结果及分析

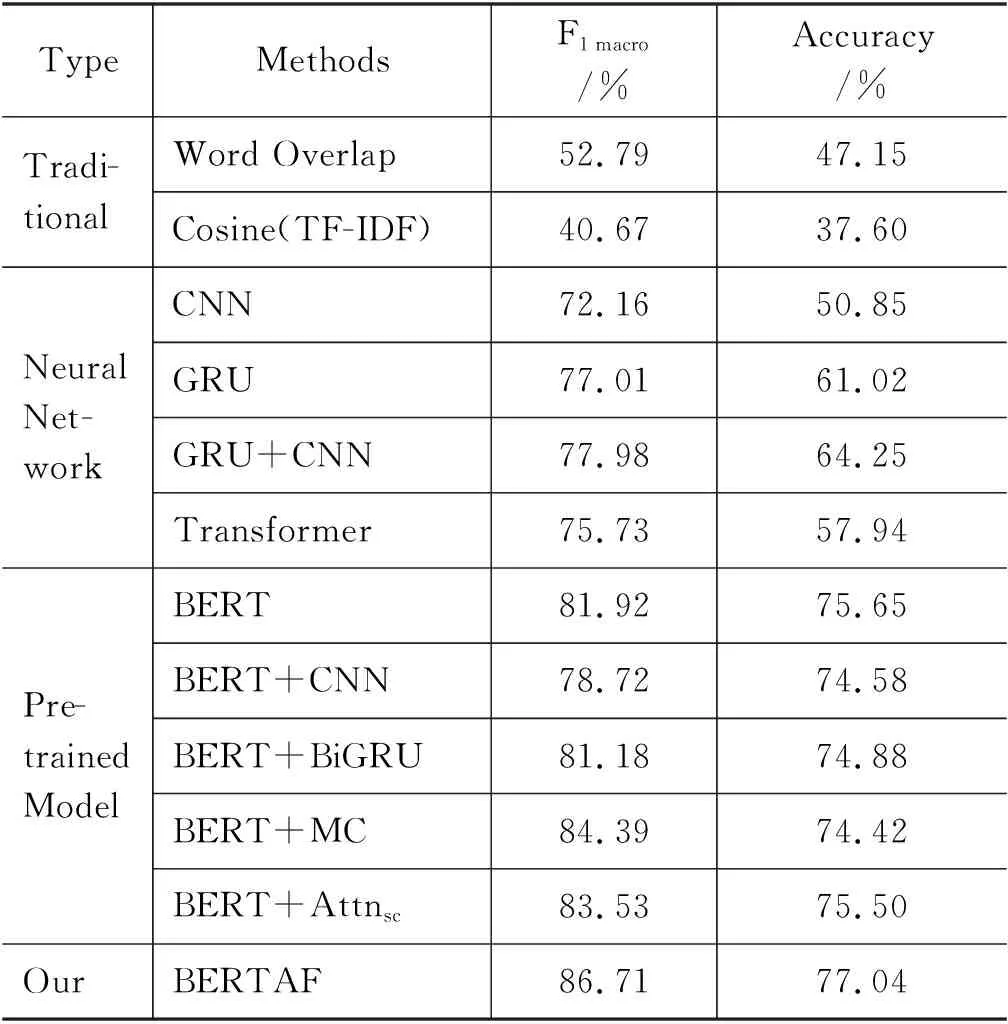

为了验证所提方法的有效性,本文使用传统机器学习模型与深度学习模型作为基线对比。机器学习模型使用词重叠方法Word Overlap和基于词频-逆文档频率的余弦相似度方法Cosine(TF-IDF)。深度学习方法使用了神经网络模型与预训练语言模型,神经网络模型如CNN、GRU、GRU结合CNN、Transformer;预训练语言模型如论辩挖掘评测基线Bert、Bert结合CNN、Bert结合BiGRU、Bert结合多项选择框架、Bert结合注意力机制。表3列出了基线模型与本文方法预测结果的对比情况。

表3 模型实验结果

从表3的结果可以看出,基于TF-IDF的余弦相似度的方法效果较差,主要由于缺少特定领域的逆向文档频率 (IDF) 语料库,TF-IDF提取句子中关键词的能力有限,并且余弦相似度虽可识别相似度较高的两段文本,但对两段无显式交互特征的对话性质的文本的识别能力较弱;Word Overlap方法对诉方论点句与候选辩方论点句分词后选取与诉方论点句词重叠程度最高的辩方论点句作为答案,仅能简单地选择具有表面浅层相关性的答案,无法识别更高级的具有语义交互关系的答案。

神经网络系列模型如CNN、GRU等结构简单,参数量少,采用随机初始化的词向量,整体运行速度快,但准确率较低。CNN可捕捉文本序列的局部特征,在文本序列上的卷积操作相当于N-gram,其卷积核数量没有确定的标准,会影响特征提取的效果。GRU是RNN的一种变体,通过门控机制将重要的历史特征信息保存下来并向后传递,适合处理文本序列这种具有前后依赖性的数据。Transformer模型中引入了多头自注意力机制,也能较好地捕捉长距离依赖特征。

基于预训练语言模型进行微调的BERT+CNN,BERT+BiGRU,结合多项选择框架对5个候选辩方论点之间的关系进行建模的BERT+MC(Multiple Choice),以及结合注意力机制以便让诉方论点感知到辩方论点的BERT+Attnsc,这些模型都是在已具有较好特征表示能力的预训练模型BERT的基 础上添加了一些特定的神经网络层,以期在本任务上能够进一步提升特征表示与特征提取的能力。其中,BERT+MC模型借鉴了机器阅读理解多项选择自动答题任务的模型框架,此任务在形式上一般包括阅读材料、相关问题和对应的多个候选答案选项,阅读理解模型根据问题和阅读材料从候选项中选出正确答案[26]。本文研究的任务在形式上等同于没有加入阅读材料的多项选择题,因此,我们尝试用阅读理解模型的答题框架进行互动论点对识别。然而,实验结果表明,上述这些模型的鲁棒性与泛化能力普遍不太好,不能有效捕获深层的语义交互特征。

本文方法在验证集和测试集上都取得了最好的效果,在测试集上的准确率比论辩挖掘评测基线BERT提升了1.39个百分点。为了进一步验证所提方法的有效性,本文通过对比BERT系列模型在测试集上的预测结果,选取了一条支持本文方法的正向样例,如图4所示。该示例中针对诉方提出的“张某上诉称一审量刑重”这一论点,本文方法成功捕捉到了第二项候选辩方论点中的“…检察院出庭意见: …建议二审量刑…对张某酌情从轻”这一符合逻辑又具有语义交互的论点。除本文方法外的其他BERT系列模型,均在第一项与第四项候选辩方论点上混淆,泛化能力较弱。结果表明了本文方法的有效性。

图4 正向样例

3.4 消融实验结果

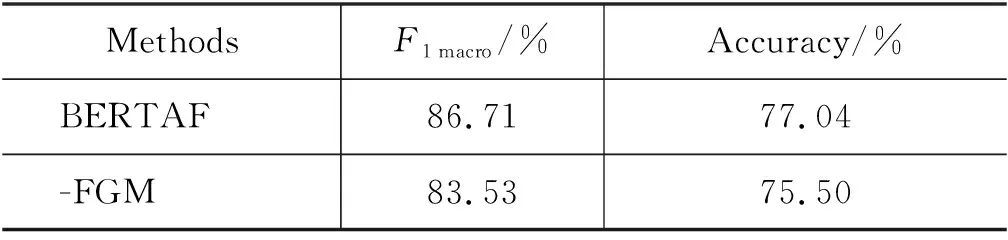

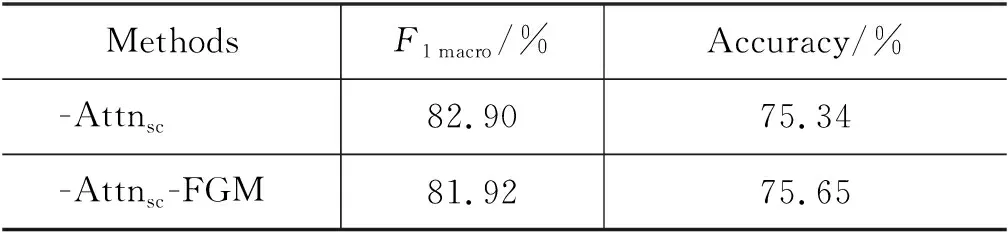

为了评估本文方法不同部分的贡献,我们分别尝试去除对抗训练模块和注意力机制模块进行了消融实验,实验结果如表4所示。

表4 消融实验结果

续表

从表4的结果可以看出,去除对抗训练模块FGM之后模型为BERT+Attnsc,在验证集和测试集上的效果均有下降, 说明对抗训练模块对模型的鲁棒性与泛化能力有一定帮助;去除注意力机制模块Attnsc后此时模型为BERT+FGM,在验证集与测试集上的效果比只去除对抗训练模块FGM又有所下降,说明注意力模块在捕捉诉辩论点的交互中也发挥了作用;将对抗训练模块FGM与注意力模块Attnsc都去除后模型为评测所给基线,在验证集上效果继续下降,在测试集上无明显变化,这主要是因为实验测试数据存在一些标注错误的问题。

3.5 错误分析

尽管本文所提方法已取得了较好的结果,但与真实应用的要求还存在一定差距。通过分析已有数据集,发现其中包含一些标注错误或不一致的问题,例如,在一条诉方论点中提到了n个被告,而这些被告也都作了回应,这就形成一条诉方论点对应n条辩方论点的情况,现有数据集将这种情况拆分成了n条数据样例,即用该诉方论点分别搭配这n条辩方论点,具体示例如图5所示。

图5 干扰数据样例

图5的具体示例显示,两条不同的标注数据包含同样的诉方论点,但其对应的互动辩方论点在一个样本中标注为正确,在另一个样本中却标注为错误。类似的数据标注错误会对模型学习造成困扰,影响模型的效果。

4 结论

本文针对裁判文书诉辩双方互动论点对识别问题进行研究,首先基于预训练语言模型BERT实现诉辩论点的特征表示,再利用注意力机制获得诉辩论点的交互表示,最后采用对抗训练增强模型的鲁棒性与泛化能力。在裁判文书互动论点对识别数据集上的实验结果表明,本文方法在提升互动论点对识别能力的同时也具备一定的鲁棒性。

本文所提方法在处理同一诉方论点对应多条辩方论点的情况时能力较弱。未来工作中,我们将继续探索新的方法以解决发现的问题,进一步提升识别裁判文书诉辩双方互动论点对的能力。