基于联合条纹关系的车辆重识别

2022-07-05张廷萍帅聪杨建喜邹俊志郁超顺杜利芳

张廷萍,帅聪*,杨建喜,邹俊志,郁超顺,杜利芳

基于联合条纹关系的车辆重识别

张廷萍1,帅聪1*,杨建喜1,邹俊志2,郁超顺3,杜利芳3

(1.重庆交通大学 信息科学与工程学院,重庆 400074; 2.重庆交通大学 土木工程学院,重庆 400074; 3.重庆交通大学 交通运输学院,重庆 400074)(*通信作者电子邮箱308156154@qq.com)

为了解决车辆重识别过程中因车辆特征图分块所导致的空间信息丢失问题,提出一种联合条纹特征之间关系的模块以弥补丢失的空间信息。首先,针对车辆特殊的物理结构,构建了一种双分支神经网络模型,对输出的特征图进行水平和垂直均等分割并在不同的神经网络分支上进行训练;然后,设计多激活值模块以减少噪声并丰富特征图信息;接着,使用三元组和交叉熵损失函数对不同的特征进行监督训练以约束类内距离并扩大类间距离;最后,设计批量归一化(BN)模块消除不同损失函数在优化方向上存在的差异,从而加速模型的收敛。使用所提方法在VeRi-776和VehicleID两个公共数据集上进行实验,结果表明该方法的Rank1值优于现有最好的方法VehicleNet,验证了其有效性。

车辆重识别;条纹关系;特征图分块;多激活值;批量归一化

0 引言

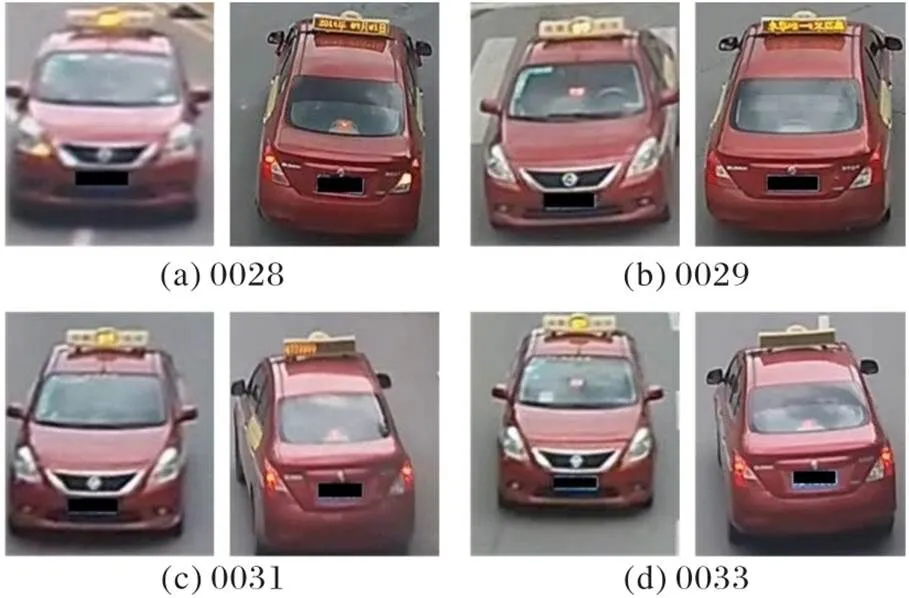

车辆重识别任务是计算机视觉中的重要任务,它的目的是在不重叠的摄像头中寻找感兴趣的车辆,可以应用于智能交通运输系统中的实际情况,例如车辆跨摄像头跟踪和监控。车辆重识别受益于行人重识别[1-2],其网络体系结构、损失函数设计、数据增强、特征提取的方法都可由此借鉴;然而,与已经发展较为成熟的行人重识别技术相比,车辆的类间差异性更小、受视角引起的偏差更大等特点使车辆重识别任务更具有挑战性[3-4]。如图1所示,不同身份的车辆具有高度相似性,肉眼难以区分不同车辆。

在车辆重识别研究早期,基于外观建模的方法是一种有效的方法,车辆具有车标、车牌、颜色等信息,研究学者从车辆的不同角度对车辆特征进行人工提取[5-6],或根据车辆自身属性进行手工特征提取以获得图像的属性达到对车辆身份识别的目的[7];但是由于车辆在不同视角下的图像会存在完全不一样的情况以及光线的巨大差异,基于手工方法提取的特征通常不具有鲁棒性。在最近的研究工作中,车牌信息被抹除,基于手工特征的方法逐渐被遗弃,大量基于深度学习的车辆重识别方法[8-11]迅速发展,且已被证明比传统的手工方法具有更好的性能。

图1 带有身份的相似车辆示例

在基于深度学习的方法中,对特征图分割[12]后融合全局信息与局部信息的方法在行人数据集上表现出了出色的效果,但是对特征图进行分割也带来了相邻块之间信息丢失的问题;在车辆重识别领域,许多方法借助此思想,在特征图上进行水平和垂直均等划分。Wang等[12]利用多重粒度网络(Multiple Granularity Network, MGN)将特征图均等划分为3部分,利用局部的特征图信息大幅提高了重识别的准确率,成了当时流行的方法。Qian等[13]在此基础之上,将特征图分割得更为细致,沿竖直方向上将特征图分割为8部分,强迫网络去关注更细微的局部信息以达到提高准确率的目的。这种基于块的操作能简单有效地利用局部特征进行分类,但如图2所示,也面临着以下问题:由于车辆姿态变化和尺寸差异,会出现车辆结构无法对齐的现象;单一地对几个区域进行预测,未使用相邻块之间存在的关联特征,可能导致具有判别性的信息丢失;由于车辆的特殊物理结构,不同块之间存在固定的联系(如车的顶部和车标具有一定联系),但基于块的操作却忽略了块与块之间特征的关系。

图2 图像分块引起的无法对齐问题

针对上述问题,本文提出一种联合条纹特征关系的车辆重识别算法。该算法以使用最广泛的ResNet-50[14]作为骨干网络,并将骨干网络输出的特征图进行水平和竖直均等分割,使用关系描述模块对特征块之间的关系建模以弥补特征分块后的空间信息丢失;其次,设计多激活值模块以最大限度地去除噪声保留有效信息;接着,组合三元组损失(Triplet loss)函数与交叉熵损失(Cross-entropy loss)函数对网络进行监督训练;最后,设计组归一化模块以消除损失函数在优化方向上的差异。

1 联合条纹关系的车辆重识别

1.1 网络结构

考虑到MGN在行人重识别领域中结合全局与局部特征信息表现出了非常好的效果,在车辆重识别中同样考虑结合全局与局部特征信息去描述每一辆车。将ResNet-50作为骨干网络,最后一个卷积层的步幅设置为1,以获得更大分辨率的特征图,并且将最后的分类层和平均池化层删除。根据车辆独有的物理结构,将特征图沿垂直和水平方向上均等分割都具有一定意义,所以在骨干网络之后设置一个并行的双分支神经网络,使得沿不同方向上切割的局部特征能在不同的分支网络结构中学习。由于Fu等[11]在一系列的实验中发现,在车辆重识别领域中使用全局最大池化(Global Max Pooling, GMP)技术对特征图进行操作要优于全局平均池化(Global Average Pooling, GAP),因此,在对特征图分块后使用GMP对每一分割块进行操作。

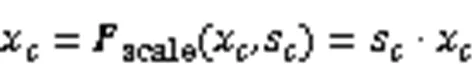

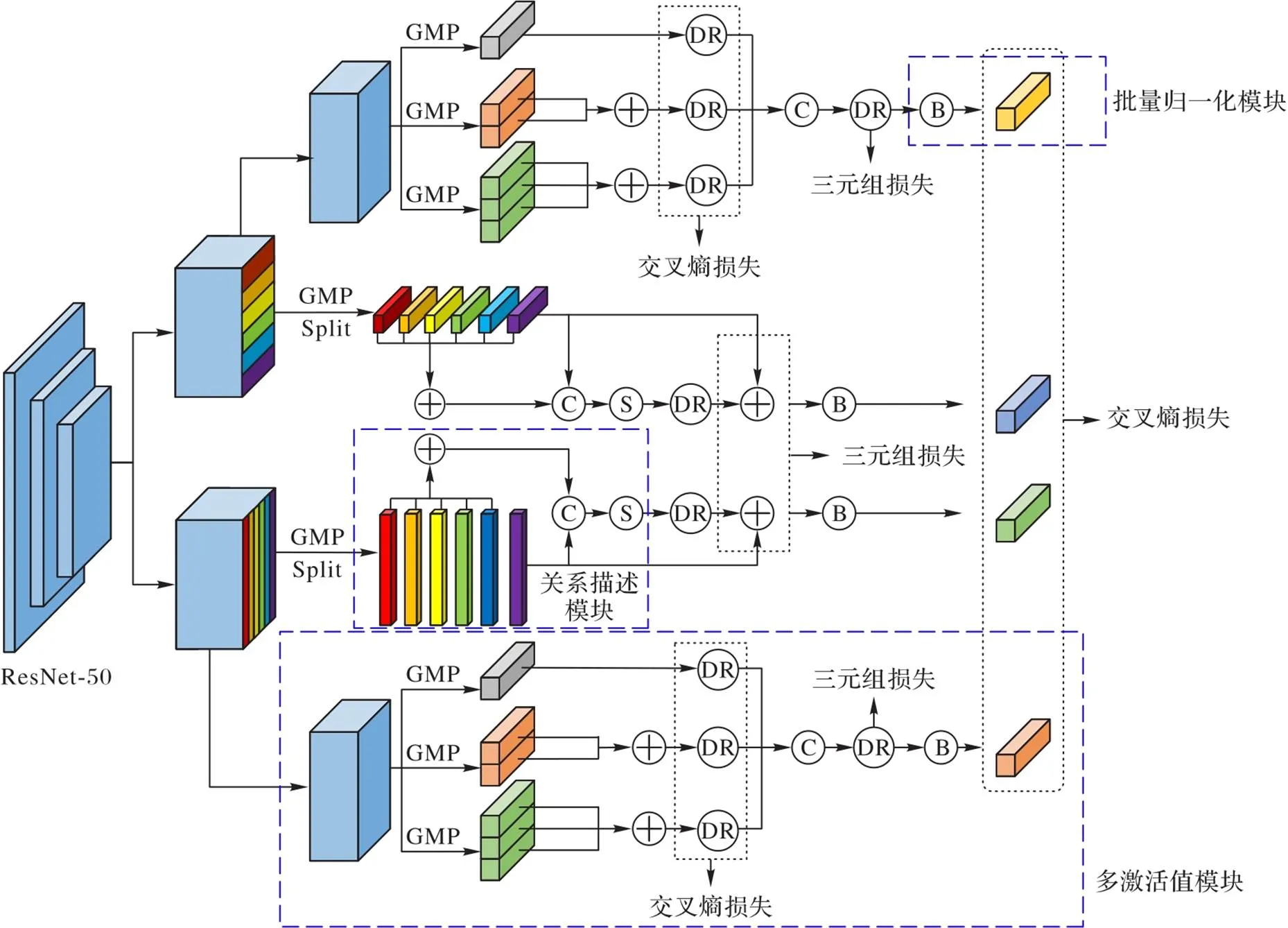

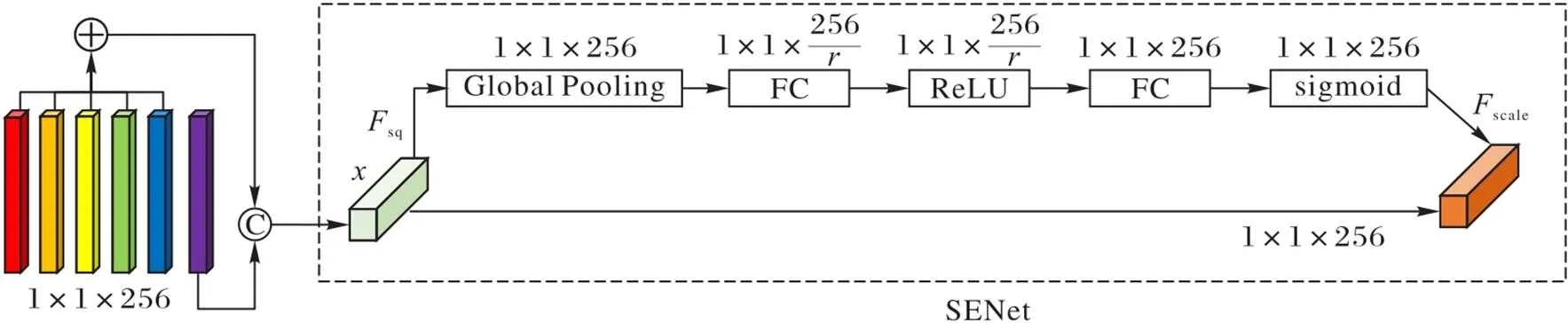

本文提出了一种联合条纹特征关系的双分支深度卷积神经网络来学习车辆的有效特征嵌入,其总体框架如图3所示。图3中除骨干网络外还包含三个模块:关系描述模块、多激活值模块和批量归一化(Batch Normalization, BN)模块。将车辆图像作为模型的输入,来自骨干网络的堆叠卷积层将自动形成特征图,此时特征图将沿垂直和水平方向均等分割为块,沿不同方向上切割的特征块将会沿不同的网络分支继续向下传播。图3中:GMP是对特征图常见的操作;“Split”代表对特征图均等分割,以迫使网络利用局部信息进行车辆重识别;“⊕”代表特征图张量相加;“C”代表特征图以通道维度连接;“S”代表通道注意力机制[15],由于通道注意力机制可以显式地建模通道之间的关系,利用此方法可将特征块按通道维度连接,并使用通道注意力机制建模特征块之间的关系,以弥补特征分块后的空间信息丢失;“DR”代表降维,降维操作既能减小特征的维度从而节约计算资源,又能减小车辆的表示特征维度以获得更快的推理速度;“B”代表BN模块,可以加快模型的收敛。模型中具体的小模块结构将在下面的小节进行详细说明。

1.2 关系描述模块

由于车辆数据集中存在大量难以区分的样本,相比使用单一的全局特征,采用更加精细的局部特征可以减少车辆数据集复杂化的影响,而且这些关键的局部特征更具有代表性,判别力更强,是区分不同车辆的重要依据。目前常用的提取局部特征的方法有图像切块、基于关键点位置[16]以及注意力机制等。

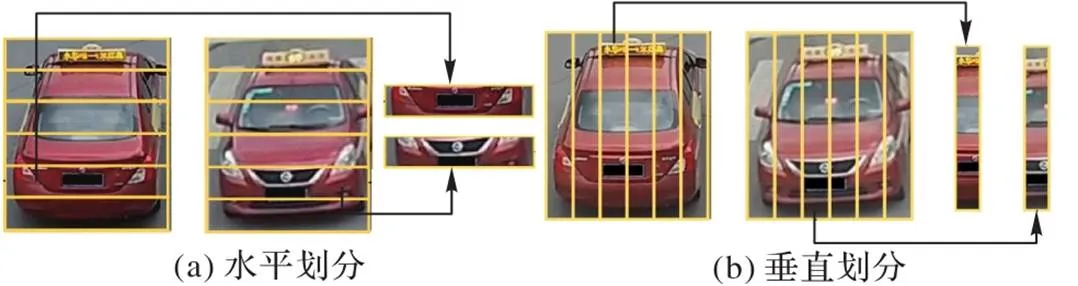

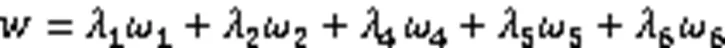

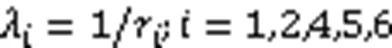

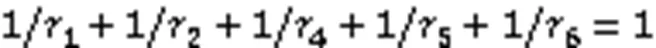

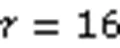

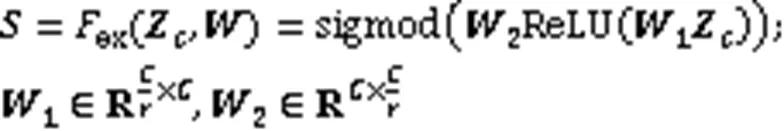

为了得到车辆的有效特征嵌入,本文算法根据车辆的结构特征将特征图进行垂直和水平分割。由于分割后会出现相邻块与不相邻块之间的重要信息丢失,因此提出联合关系模块。如图4所示,为了描述各个分区之间的关系,首先将特征图均等分割成6份,依次按顺序选择其中一块条纹特征图,其余5块条纹特征图附上权重且相加后与被选择的特征图以通道维度相连后使用关系描述模块,其中权重的大小与被选择的条纹特征图与当前特征图的距离相关,距离越近则权重越大。将特征图依次编号1~6,如选择第3块特征图时,则其余5块相加如下所示:

图3 本文方法总体框架

图4 关系描述模块

1.3 多激活值模块

近年来,车辆重识别工作普遍使用全局最大池化;然而,全局最大池化只考虑特征图上最大的激活值,虽然尽可能地减少了噪声,但也会造成特征图的空间信息丢失。对于全局平均池化,将特征图上所有数值平均后得到的值作为最终值,虽然考虑到了全图的信息,特征图包含的信息更广,但是由此带来的噪声也更多。Zheng等[17]综合全局最大池化和全局平均池化丰富了信息,减少了噪声,但随之而来的是模型的复杂度增加。

为了使特征图尽可能地减少噪声并极大地丰富特征图信息,构建了多激活值模块来解决此问题,其网络结构如图3虚线框中所示。首先,为了尽可能地减少噪声,加入了全局最大池化层;其次,为了同时考虑特征图上的多个区域的信息,将特征图分块进行最大池化后相加可丰富特征图信息;接着为了弥补分块后信息的丢失,考虑在特征图上取1个激活值、2个激活值和3个激活值;最后为了降低特征图的维度以节约计算资源,在模块内部将进行两次降维操作。由此设计的多激活值模块既丰富了特征图信息又极大地抑制了噪声。

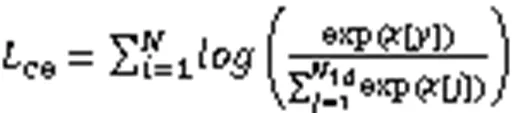

1.4 多损失联合学习

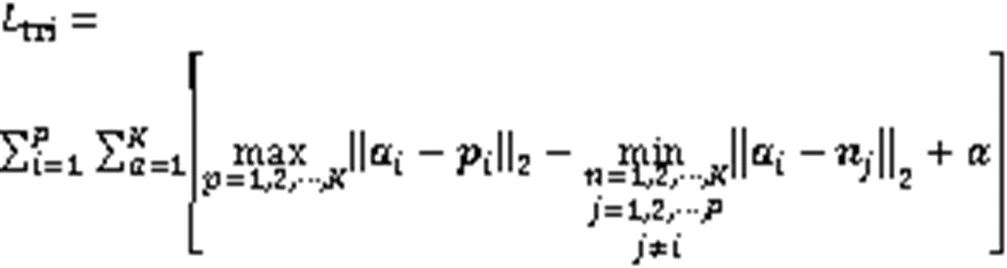

三元组损失在度量学习中应用广泛,其定义如下:

1.5 批量归一化模块

在深度学习领域中,混用具有不同量纲或量纲单位的评价指标容易使得数据中出现奇异样本数据,从而造成训练时间过长以及损失无法收敛的问题。因此,为了消除指标之间量纲的影响,需要对数据进行归一化。

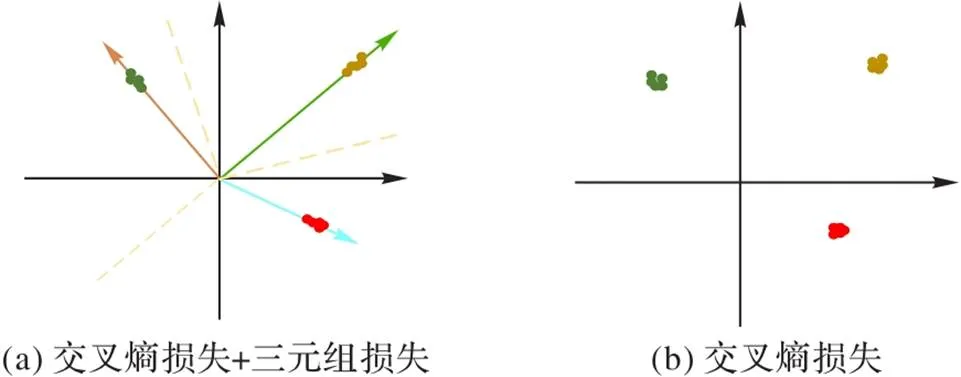

在车辆重识别中普遍采用三元组损失和交叉熵损失函数对模型进行监督优化,当交叉熵损失函数和三元组损失函数共同优化一个特征时,损失函数的优化方向可能出现差异,如图5在做三分类时,交叉熵损失函数经改进后使用余弦距离进行度量,通过构造超球面的方式将嵌入空间分成3个不同的子空间,3种类别中的每个特征都被映射为超球面上的点,这样每个类别的特征会被分配到不同的子空间;三元组损失函数则采用欧氏距离进行度量。当这两种损失函数对网络中的同一个特征向量进行监督时,二者优化方向的差异可能会使得训练过程中一个损失减小,而另一个损失振荡发散,最终导致整个训练过程中损失的收敛难度变大。

图5 不同损失函数下样本分布二维可视化

图6 批量归一化模块

2 实验及结果分析

2.1 评价指标

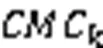

车辆重识别是一个图像检索子问题,在衡量重识别方法的性能时,采用的评价指标主要包括平均精度均值(Mean Average Precision, mAP)、累计匹配性能曲线(Cumulative Matching Characteristics curve, CMC)。

2.2 数据集

为了对模型的有效性进行验证,选取公共数据集VeRi-776和VehicleID分别进行实验验证。

2.2.1 VeRi-776

VeRi-776是由Liu等[19]提出的,包含由20个摄像头拍摄的超过50 000张关于776辆汽车的图像,标注信息丰富,包括边界框、车辆类型、颜色、厂商、车牌、时间戳和地理位置。在测试阶段,由于重识别(Re- identification, Re-id)任务面对的是跨摄像头搜索任务,因此在测试阶段会将同一摄像头下的同一身份的车辆图像忽略。

2.2.2 VehicleID

VehicleID是由Liu等[18]提出的大规模车辆再识别数据集,其中包括221 763张关于26 267辆汽车的图像,主要包含前后两种视角。为了使车辆再识别方法的性能评测更加全面,VehicleID将测试集按照车辆图像的规模划分为大、中、小共3个子集。在测试时遵循一般原则并为了计算累计匹配性能,将每个测试子集中的每辆车的一张图片随机拿出来合成为图库集,其余全为查询图片。在测试时为了保证模型不因为图片的随机选择产生较大的偏差,在测试时随机选取10次图片进行反复测试后求平均值作为最终的结果。

2.3 实验环境及训练细节

2.3.1 实验环境介绍

实验采用开源的 Pytorch1.6.0 深度学习框架,CPU配置为 Intel Core i9-9900KF,显卡为GeForce RTX 2080Ti,内存大小为64 GB,系统为ubuntu18.04 LTS,Python3.7.7,CUDA 10.2,cuDNN 7.6.5,OpenCV 4.4.0环境。

2.3.2 训练细节

在实验中采用ResNet-50作为骨干网络,具体来说在ResNet-50中的layer3以前为骨干网络,其后的网络结构被设置为一模一样的上下双分支网络结构以供竖直和水平条纹的局部特征学习。在训练过程中将每张图像的大小调整为384像素×384像素,然后采用在线数据增强的方式对每张图片进行矩形区域像素随机擦除和随机翻转的操作。

在损失计算阶段采用三元组和交叉熵作为损失函数,每一个经过三元组优化的特征都会经过批量归一化模块后在分类中使用交叉熵损失进行优化。

在推理阶段,采用三元组损失函数优化的全部特征串联起来作为车辆图像的特征。由于在训练阶段每张图片以0.5的概率随机水平翻转,所以在推理阶段原图和水平翻转后的图像的特征会连接起来作为车辆的最终表示特征。

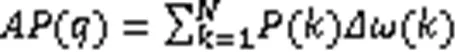

训练完成后对网络中各层的卷积进行了可视化,如图7所示,其中图(a)为车辆原图,图(b)从上到下为网络结构逐渐加深的部分卷积可视化图。由图易见,浅层网络习得的是线条、颜色、纹理等特征,而位于中间层的网络,背景噪声逐渐被忽略并学习到了更抽象的特征。在较深层的网络中,注意力会集中在更有辨识性的一些局部特征,例如车顶、车尾等地方,这也表明该方法能够提取出图像中具有区分度的局部特征以供模型分类。

图7 卷积特征可视化

2.4 实验结果可视化展示

在模型训练完成后,从8个不同的视角中选择8个查询图像,结果根据相似度评分从左到右排序。其中,错误匹配使用方框标出,如图8所示。不难发现被框标注出的错误识别主要集中在相同车型及相同颜色的车辆之间,并且肉眼也无法简单地区分这两类车。因此,受限于光线、分辨率、视角等问题,精准的车辆重识别仍是一项具有挑战性的任务。

2.5 实验结果分析

2.5.1 模型最优实验验证

在模型训练过程中,为了达到模型最好的实验效果,除了调参等技术会影响实验结果外,所设计的关系描述模块和多激活值模块中存在的参数也需要讨论。因此有以下三个问题需要考虑:一是对特征图沿单一方向进行均等分割和沿两个方向同时进行分割,哪种效果更好;二是将特征图均等分割为多少块才能达到最佳效果;三是在多激活值模块中最高选取多少个激活值可以达到模型最优。以上三个问题在VeRi-776数据集上展开实验验证。

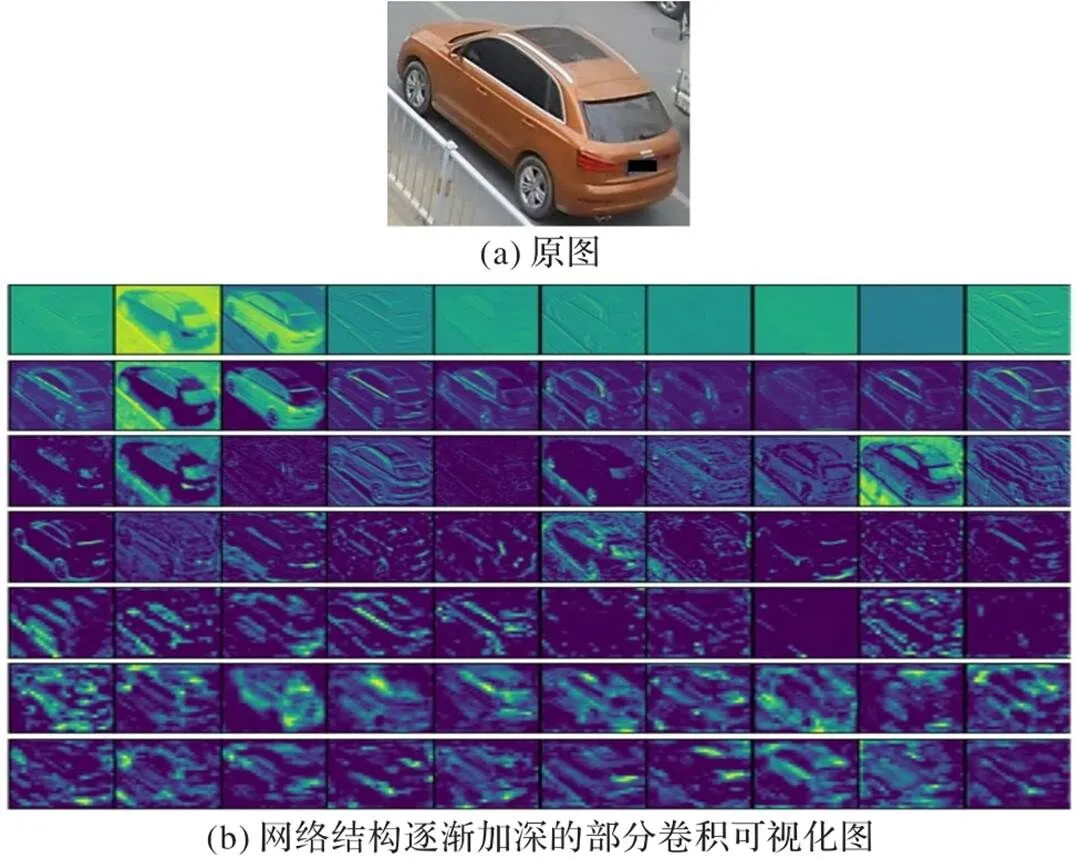

针对问题一,在模型中分别对沿垂直方向分割、沿竖直方向分割和同时沿两个方向分割做对比实验,结果如表1所示。可以看出,沿两个方向同时分割时,各类评价指标均要高于沿其中任何一个方向对特征图进行分割,且沿竖直方向进行分割的结果要明显好于沿水平方向进行分割的结果,可能的原因是车辆存在大量不同的视角,沿垂直方向分割比沿水平方向分割的物理结构更易对齐。

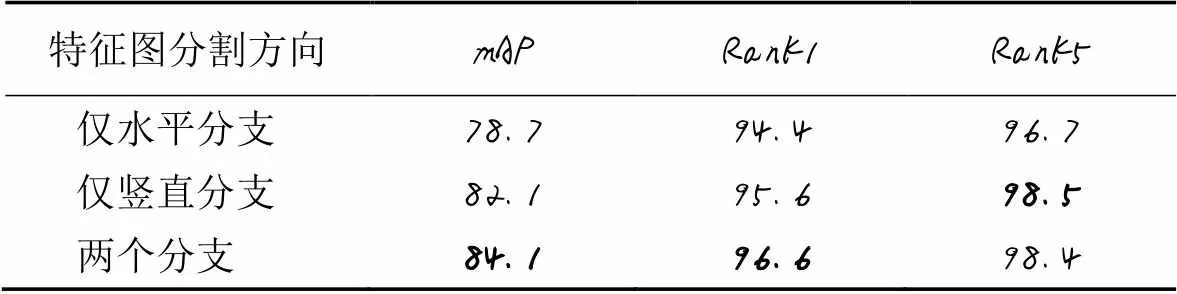

针对问题二,为进一步探究最佳分割数目,分别取均等分割数目为2、4、6、8进行实验,结果如表2所示。可以看出:当分支数为6时,mAP达到了84.1%;在分支数为4时,mAP达到了83.1%,略低于6分支结构,在要求模型复杂度低的情况下可优先选择4分支网络结构。

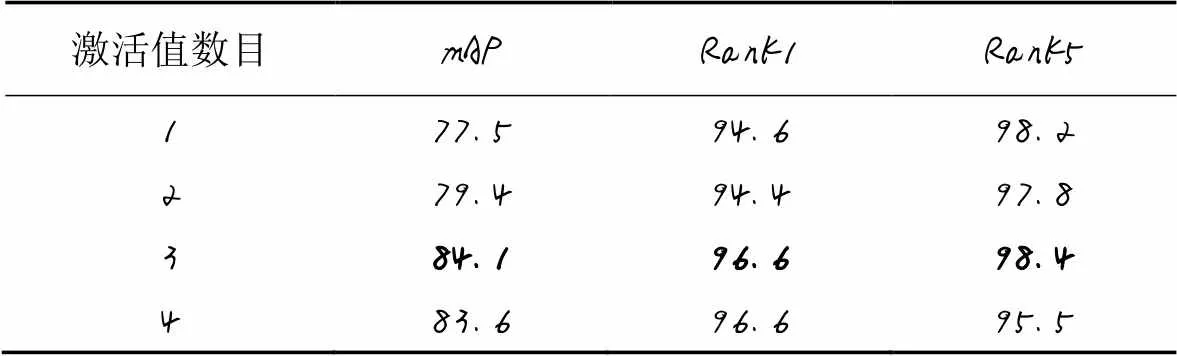

针对问题三,设定最高激活值数目分别为1、2、3、4进行实验,结果如表3所示。可以看出:取3个激活值时效果达到了最优;取4个激活值时,模型复杂度更高,且效果较取3个激活值时略差。

图8 查询可视化Rank-10结果

表1 特征图分割方向对模型性能的影响 单位: %

表2 特征图分割数目对模型性能的影响 单位: %

表3 激活值数目对模型性能的影响 单位: %

2.5.2 消融实验结果分析

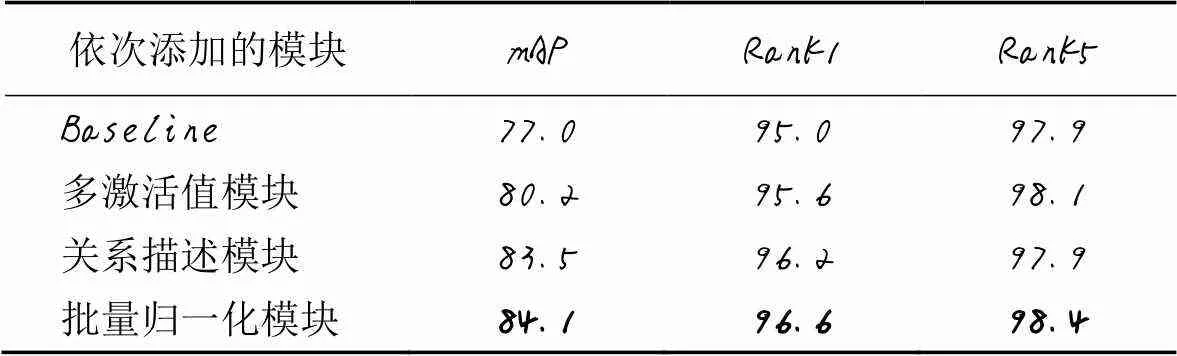

为进一步分析所加入的每种网络结构对模型整体的影响,将本文提出的重识别算法划分成4组不同的网络模型在VeRi-776数据集上进行消融实验。第一组代表Baseline算法,之后依次添加多激活值模块、关系描述模块和批量归一化模块,即第四组为本文所提出的联合条纹关系的车辆重识别算法,实验结果如表4所示。由表4可以看出,在加入激活值模块后,丰富了图像信息并抑制了噪声,提高了模型的泛化能力,相比Baseline,mAP值整体提高了3.2个百分点,Rank1提高了0.6个百分点;增加了关系描述模块后,弥补了图片分块后的空间信息丢失,相比Baseline+激活值模块,mAP值提高了3.3个百分点,Rank1值提高了0.6个百分点;第四组的本文算法在加入了批量归一化模块后,相比Baseline+激活值模块+关系描述模块,mAP值提高了0.6个百分点,Rank1值提高了0.4个百分点。

表4 消融实验 单位: %

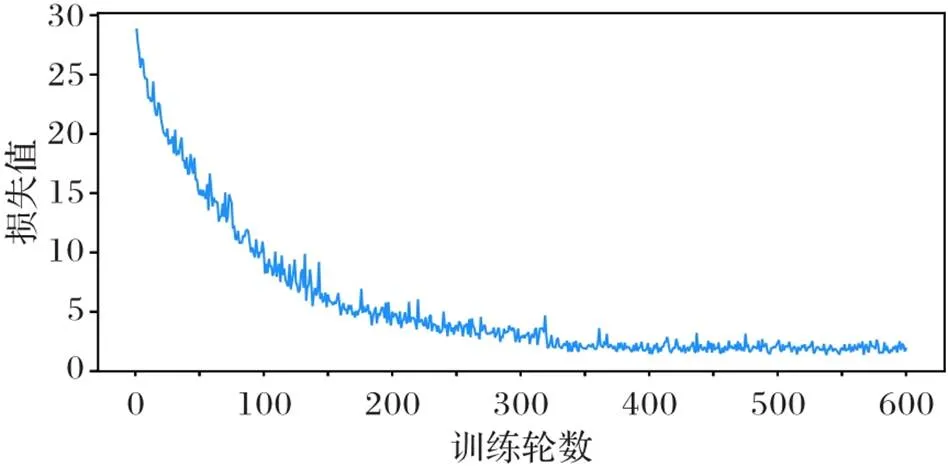

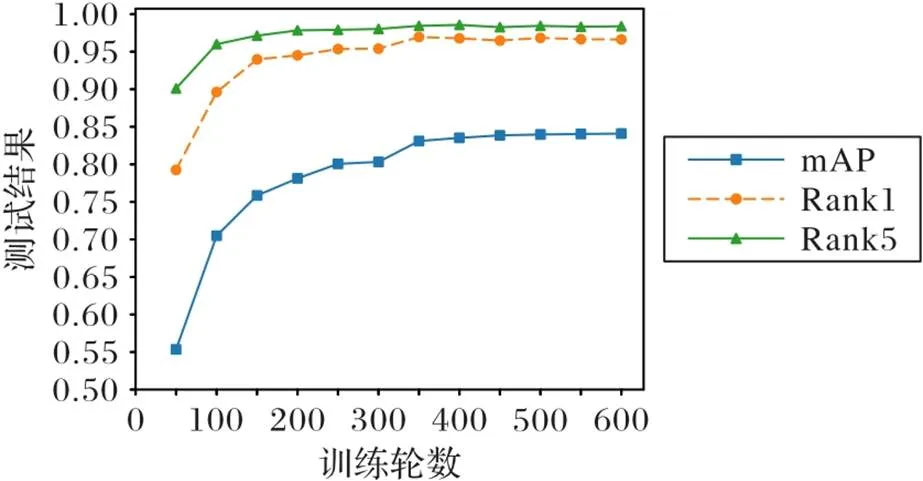

实验中还发现,加入批量归一化模块的网络能更快收敛到最优值。为了更直观地表现出本文模型的效果,引入loss收敛曲线图和每50轮测试的mAP、Rank1、Rank5的折线图,如图9、10。从图9、10中可以看出,模型loss不断下降,mAP、Rank1、Rank5值不断上升,说明模型在训练过程中逐步收敛且效果较好。

综上所述,本文提出的每一种网络模块均具有一定效果,在对车辆的重识别中,最终的模型相较于Baseline,mAP值、Rank1值和Rank5值分别提升了7.1、1.6和0.5个百分点。

图9 损失收敛曲线

图10 测试结果

2.5.3 本文算法与其他重识别算法结果对比

为了验证本文算法的有效性与优势,分别在VeRi-776和VehicleID数据集上与其他车辆重识别算法进行对比,对比算法包括PRN(Partition and Reunion Network)[20]、PNVR (Part-regularized Near-duplicate Vehicle Re-identification)[21]、VANet (Viewpoint-aware Attentive Network)[22]、MRL (Multi-View Ranking Loss)[9]、GS-TRE (Group Sensitive Triplet Embedding)[23]、EVER (Excited Vehicle Re-identification)[24]、SAN (Stripe-based and Attribute-aware deep convolutional neural Network)[12]、VehicleNet[25],结果如表5、6所示。

从表5中可以看出,在VeRi-776数据集上,本文算法取得了最佳的mAP值、Rank1值以及Rank5值。此外,在VeRi-776数据集中,由于数据的特性,还可以进一步利用重排序算法(Re-ranking)[26]来提升算法的性能。重排序是一种后处理算法,能提高最终结果的精度。当不使用重排序技术时,相比目前效果较优的VehicleNet,本文算法的mAP增加了0.7个百分点,Rank1相差不大,仅降低了0.1个百分点;而重排序后,本文算法要比VehicleNet算法的mAP值高2.6个百分点,Rank1要高0.7个百分点,验证了本文算法的有效性。

从表6中可以看出,在VehicleID数据集中,本文算法在小型、中型、大型这三个规模测试集中均取得了最佳的识别效果,在大型测试集上Rank1值比VehicleNet算法高出了0.7个百分点,Rank5值高出2.4个百分点。

表5 不同算法在VeRi-776数据集上的对比 单位: %

表6 不同算法在VehicleID数据集上的对比 单位: %

3 结语

本文提出一种基于联合条纹关系的特征融合的车辆重识别算法,使用条纹关系模块弥补了在特征图分割时丢失的空间信息;并提出了多激活值模块,丰富了特征图信息,减少了噪声;还设计了批量归一化模块,减弱了不同损失函数在优化监督时的冲突影响。通过在VeRi-776和VehicleID两个公共数据集上进行实验,验证了本文算法的有效性与优势,它能够有效提高车辆重识别的准确度。

[1] SUN Y F, ZHENG L, YANG Y, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[C]// Proceedings of the 2018 European Conference on Computer Vision, LNIP 11208. Cham: Springer, 2018: 501-518.

[2] ZHENG L, ZHANG H H, SUN S Y, et al. Person re-identification in the wild[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 3346-3355.

[3] 刘凯,李浥东,林伟鹏. 车辆再识别技术综述[J]. 智能科学与技术学报, 2020, 2(1):10-25.(LIU K, LI Y D, LIN W P. A survey on vehicle re-identification[J]. Chinese Journal of Intelligent Science and Technology, 2020, 2(1):10-25.)

[4] 邱铭凯,李熙莹. 用于车辆重识别的基于细节感知的判别特征学习模型[J]. 中山大学学报(自然科学版), 2021, 60(4):111-120.(QIU M K, LI X Y. Detail-aware discriminative feature learning model for vehicle re-identification[J]. Acta Scientiarum Naturalium Universitatis Sunyatseni, 2021, 60(4):111-120.)

[5] ZAPLETAL D, HEROUT A. Vehicle re-identification for automatic video traffic surveillance[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2016: 1568-1574.

[6] FERENCZ A, LEARNED-MILLER E G, MALIK J. Building a classification cascade for visual identification from one example[C]// Proceedings of the 10th IEEE International Conference on Computer Vision. Piscataway: IEEE, 2005: 286-293.

[7] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[8] 陈莉,王洪元,张云鹏,等. 联合均等采样随机擦除和全局时间特征池化的视频行人重识别方法[J]. 计算机应用, 2021, 41(1):164-169.(CHEN L, WANG H Y, ZHANG Y P, et al. Video-based person re-identification method by jointing evenly sampling-random erasing and global temporal feature pooling[J]. Journal of Computer Applications, 2021, 41(1):164-169.)

[9] LIN W P, LI Y D, YANG X L, et al. Multi-view learning for vehicle re-identification[C]// Proceedings of the 2019 IEEE International Conference on Multimedia and Expo. Piscataway: IEEE, 2019: 832-837.

[10] LIU K, XU Z, HOU Z H, et al. Further non-local and channel attention networks for vehicle re-identification[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2020: 2494-2500.

[11] FU Y, WEI Y C, ZHOU Y Q, et al. Horizontal pyramid matching for person re-identification[C]// Proceedings of the 33rd AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2019: 8295-8302.

[12] WANG G S, YUAN Y F, CHEN X, et al. Learning discriminative features with multiple granularities for person re-identification[C]// Proceedings of the 26th ACM International Conference on Multimedia. New York: ACM, 2018: 274-282.

[13] QIAN J J, JIANG W, LUO H, et al. Stripe-based and attribute-aware network: a two-branch deep model for vehicle re-identification[J]. Measurement Science and Technology, 2020, 31(9): No.095401.

[14] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[15] HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 7132-7141.

[16] WANG Z D, TANG L M, LIU X H, et al. Orientation invariant feature embedding and spatial temporal regularization for vehicle re-identification[C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 379-387.

[17] ZHENG Z D, JIANG M Y, WANG Z G, et al. Going beyond real data: a robust visual representation for vehicle re-identification[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2020: 2550-2558.

[18] LIU H Y, TIAN Y H, YANG Y W, et al. Deep relative distance learning: tell the difference between similar vehicles[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 2167-2175.

[19] LIU X C, LIU W, MA H D, et al. Large-scale vehicle re-identification in urban surveillance videos[C]// Proceedings of the 2016 IEEE International Conference on Multimedia and Expo. Piscataway: IEEE, 2016: 1-6.

[20] CHEN H, LAGADEC B, BREMOND F. Partition and reunion: a two-branch neural network for vehicle re-identification[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2019: 184-192.

[21] HE B, LI J, ZHAO Y F, et al. Part-regularized near-duplicate vehicle re-identification[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 3992-4000.

[22] CHU R H, SUN Y F, LI Y D, et al. Vehicle re-identification with viewpoint-aware metric learning[C]// Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2019: 8281-8290.

[23] BAI Y, LOU Y H, GAO F, et al. Group-sensitive triplet embedding for vehicle reidentification[J]. IEEE Transactions on Multimedia, 2018, 20(9): 2385-2399.

[24] PERI N, KHORRAMSHAHI P, RAMBHATLA S S, et al. Towards real-time systems for vehicle re-identification, multi-camera tracking, and anomaly detection[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2020: 622-623.

[25] ZHENG Z D, RUAN T, WEI Y C, et al. VehicleNet: learning robust visual representation for vehicle re-identification[J]. IEEE Transactions on Multimedia, 2021, 23: 2683-2693.

[26] ZHONG Z, ZHENG L, CAO D L, et al. Re-ranking person re-identification with-reciprocal encoding[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 3652-3661.

Re-identification of vehicles based on joint stripe relations

ZHANG Tingping1, SHUAI Cong1*, YANG Jianxi1, ZOU Junzhi2, YU Chaoshun3, DU Lifang3

(1,,400074,;2,,400074,;3,,400074,)

In order to solve the problem of spatial information loss caused by the splitting of vehicle feature maps in the process of vehicle re-identification, a module combining the relationship between stripe features was proposed to compensate for the lost spatial information. First, a two-branch neural network model was constructed for the special physical structure of the vehicle, and the output feature maps were divided horizontally and vertically equally and trained on different branches of the neural network. Then, a multi-activation value module was designed to reduce noise and enrich the feature map information. After that, triplet and cross-entropy loss functions were used to supervise the training of different features to restrict the intra-class distance and enlarge the inter-class distance. Finally, the Batch Normalization (BN) module was designed to eliminate the differences of different loss functions in the optimization direction, thereby accelerating the convergence of the model. Experimental results on two public datasets VeRi-776 and VehicleID show that the Rank1 value of the proposed method is better than that of the existing best method VehicleNet, which verifies the effectiveness of the proposed method.

vehicle re-identification; stripe relation; feature map splitting; multi-activation value; Batch Normalization (BN)

This work is partially supported by Humanities and Social Science Project of Ministry of Education (20YJAZH132), Science and Technology Research Program of Chongqing Municipal Education Commission (KJZD-M202000702).

ZHANG Tingping, born in 1978, Ph. D., professor. Her research interests include evaluation of node importance in complex networks.

SHUAI Cong, born in 1996, M. S. candidate. His research interests include vehicle tracking.

YANG Jianxi born in 1977, Ph. D., professor. His research interests include bridge health structure monitoring.

ZOU Junzhi born in 1994, M. S. candidate. His research interests include bridge health structure monitoring.

YU Chaoshun born in 1997, M. S. candidate. His research interests include vehicle tracking.

DU Lifang born in 1997, M. S. candidate. Her research interests include vehicle re-identification.

TP391.1

A

1001-9081(2022)06-1884-08

10.11772/j.issn.1001-9081.2021040544

2021⁃04⁃12;

2021⁃08⁃10;

2021⁃08⁃11。

教育部人文社会科学研究一般项目(20YJAZH132);重庆市教委科学技术研究计划项目(KJZD‑M202000702)。

张廷萍(1978—),女,贵州遵义人,教授,博士,主要研究方向:复杂网络节点重要度评估;帅聪(1996—),男,重庆人,硕士研究生,主要研究方向:车辆跟踪;杨建喜(1977—),男,宁夏青铜峡人,教授,博士,主要研究方向:桥梁健康结构监测;邹俊志(1994—),男,四川自贡人,硕士研究生,主要研究方向:桥梁健康结构监测;郁超顺(1997—),男,上海人,硕士研究生,主要研究方向:车辆跟踪;杜利芳(1997—),女,四川广元人,硕士研究生,主要研究方向:车辆重识别。