基于边缘强化的Unet-TIC模型对前列腺自动勾画研究

2022-07-01陈洪涛郑芳高艳史亚滨邓小年钟鹤立

陈洪涛,郑芳,高艳,史亚滨,邓小年,钟鹤立

深圳市人民医院(暨南大学第二临床医学院,南方科技大学第一附属医院)肿瘤放疗科,广东深圳 518020

前言

基于医学图像的人体组织器官自动分割是指在无人干预下自动定位组织并对其进行分割与勾画的过程,是医学图像分析的一个重要步骤,其分割结果直接影响疾病诊断和治疗[1]。人体内部结构相对固定,分割目标在人体图像中的分布具有规律性,语义明确,从而计算机视觉广泛应用于医学影像领域,对提高医疗工作准确性以及效率有非常重要的意义。尤其是在放疗工作中,医生通常需要在影像图上手动勾画靶区和危及器官,这一工作需要花费大量的精力和时间,此外医生之间存在专业知识与经验的差异,很容易产生勾画误差,从而影响治疗的效果。截止目前,针对医学图像分割已有众多算法被提出,大致分为两类:基于预先标记的Atlas 图像集的非刚性配准[2-4]和深度学习自动识别分割。前者将已标记好的图像与患者图像进行非刚性配准并融合,从而在患者影像上实现目标分割。然而此方法的准确性依赖于配准结果,配准误差导致准确率低。后者通过训练神经网络模型从而实现目标自动识别与分割,具有更高的准确性和鲁棒性,而且速度也更快[5]。

近年来多种基于卷积神经网络图像自动分割技术被提出[6-13]。由于临床数据具有隐私性、保密性,具有较高的获取难度,Unet 采用overlap-tile 策略,适用于医学图像小样本数据训练,从而被广泛应用于医学图像的自动分割[14]。本文在深入研究Unet网络前提下,以前列腺分割为例,提出一种改进Unet网络的器官组织分割及勾画算法。本研究主要分成两步:第一步增加Unet上采样高分辨率信息,下采样的同层输入和输出高分辨率特征与对应的上采样输出相结合,连续上采样卷积层可以根据这些信息组装一个更精确的输出;第二步对训练图像进行边缘强化,为了避免强化效果会导致精细结构的损失,增加模型输入通道并行提取和学习原始图像和边缘强化图像特征。

1 图像处理

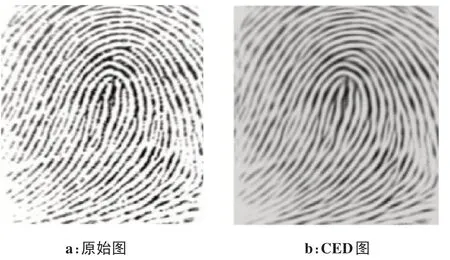

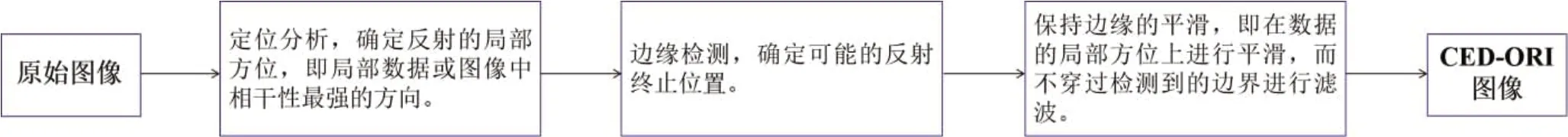

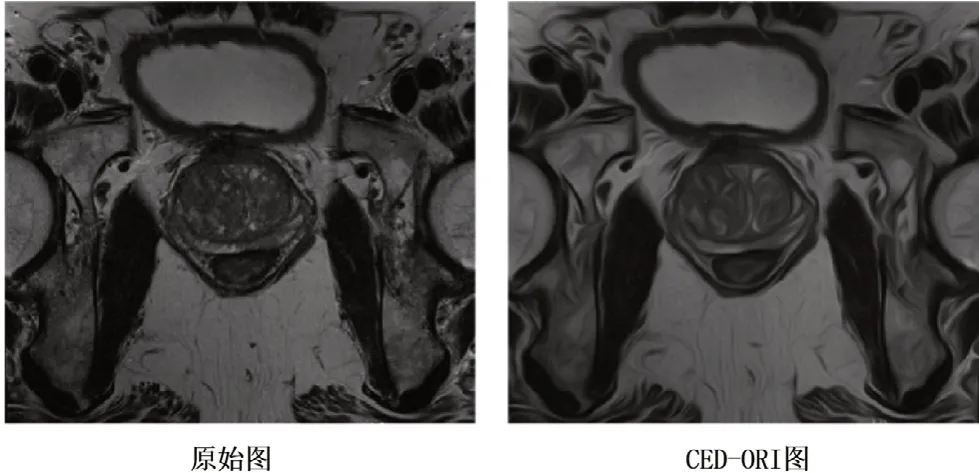

由于医学图像质量的限制,如低对比度分辨率和过多的噪声,大大降低了计算机从周围组织中准确分辨目标器官或病变边界的能力。对于单一的核磁序列(MRI),如强度不均一、边缘不完整和形状变化大等问题,使前列腺的自动分割具有挑战性。正如Cheng等[15]所讨论的,伪影存在噪声和低对比度区域,一些组织器官边缘边界可能丢失或与周围的组织混合。因此,我们在MRI 影像中应用Coherence-Enhanced Diffusion(CED)[16]方法来强化前列腺的边缘。CED 在灰度图像中增强目标边界和纹理特征有明显的优势,具有多尺度空间操作的非线性扩散滤波器特征,如图1所示,CED 明显增强了脊状纹理的相干性[17]。CED 能有效地抑制图像处理过程对边缘区域噪声的放大,并且能通过边缘定向扩散实现沿边缘区域边缘方向的噪声抑制,确保能有效抑制边缘中存在的噪声又不模糊边缘[18]。在本研究中采用优化旋转不变性CED 滤波(CED-ORI)[19],其流程如图2所示。实验结果表明,该算法不仅在旋转不变性方面表现出明显的更好的性能,而且产生的模糊伪影更少,比其他算法更准确和高效。图3显示了应用CED-ORI 滤波器前后前列腺图像比较。从该图中可以看出,CED-ORI 产生了更平滑的结果,压制无用噪声,突出边缘,减少颗粒模糊,这将有助于计算机视觉系统利用增强的边界进行语义特征学习。同时,考虑到强化效果会导致精细结构的损失,在本研究中建立双输入收缩路径结构并行使用原始图像和CED-ORI图像。

图1 脊状纹理相干性增强效果[17]Figure 1 Coherenceenhancement performanceof theridge-like texture[17]

图2 相干性增强扩散流程图Figure 2 Flowchart of coherence-enhanced diffusion

图3 CED-ORI处理前后前列腺图像比较Figure 3 Comparison of prostate images before and after CED-ORI

2 网络结构模型及改进

2.1 Unet-c模型

传统的Unet 网络被广泛应用于图像分割,其由收缩路径(编码器)和扩张路径(解码器)两部分组成一个对称结构,其中通过连接层将收缩路径和扩张路径联合,将收缩路径提取的特征直接传递至对应的扩张路径层级,助于扩张路径增加特征信息。然而其仍存在缺点,收缩路径在卷积过程中会出现信息丢失,无法生成更多的特征图信息[20],跳跃连接在每层级的卷积后,给扩张路径输送的信息有限,尤其是医学图像边界模糊、梯度复杂,语义识别需要较多的高分辨率信息。在Unet 结构基础上,为了增加上采样过程中特征信息,将下采样路径的同层输入和输出高分辨率特征与对应的上采样输出相结合[14],构成Unet-c,如图4所示。在收缩路径中经过池化后的特征图,与经过两个卷积块提取的特征图通过concatenate 联合,然后在扩张路径中与upsampling block 后的特征图融合,而后连续的卷积层可以根据这些信息组装一个更精确的输出。

图4 Unet-c结构图Figure 4 Unet-c structure

2.2 Unet-TIC模型

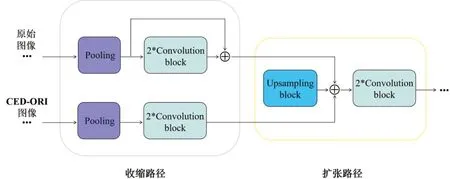

Cheng 等[15]提出的增强HNN 模型利用双通道卷积神经网络并行训练原始图像和增强处理图像,取得更加准确的语义分割结果。受其启发,本研究采用CED-ORI 方法对训练图像进行边缘强化,为了弥补强化效果会导致精细结构的损失,在Unet-c模型基础上增加模型输入通道并行训练原始图像和边缘强化图像。对于CED-ORI 通道,为了突出其边缘强化的特征,同样将下采样路径的同层输出高分辨率特征与对应的上采样输出相结合,如图5所示。Convolution block 包含convolution、ReLU 激活函数以及归一化操作。Upsampling block 包含upsampling和convolution 操作。在扩张路径中,每层的输入与对应的收缩路径层级的特征图通过连接层进行特征融合。

图5 Unet-TIC模型收缩路径与扩张路径连接构造Figure 5 Connection of contraction path and expansion path in Unet-TIC model

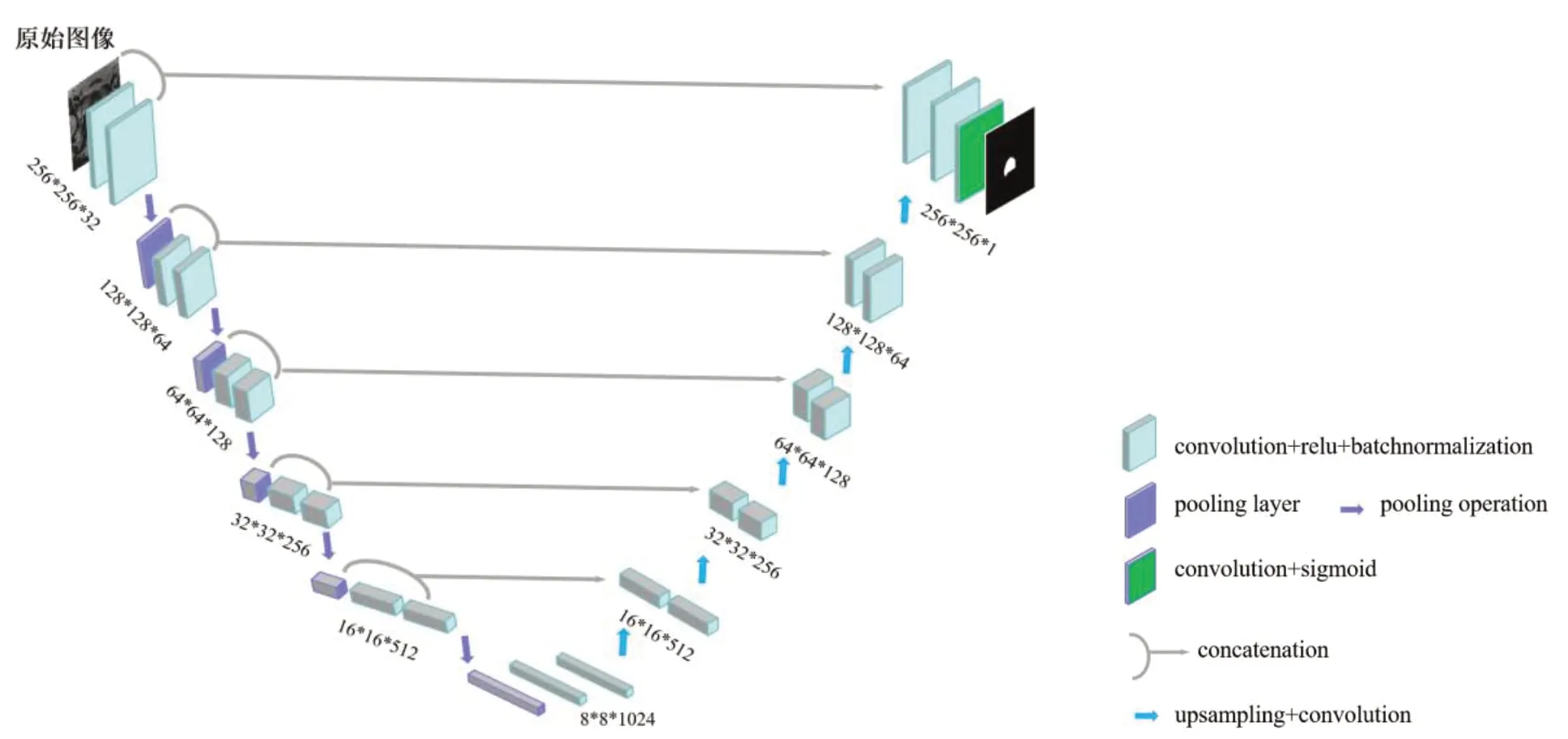

Unet-TIC(Unet-Two Input Channel)模型如图6所示。整个网络可分为两个部分,左边为收缩路径,通过下采样提取特征图,右边为扩张路径,通过上采样以及与收缩路径的特征连接增加分辨率并精确定位[14]。该模型采取非对称结构,其中收缩路径包含两个下采样通道,分别为原始图像下采样通道和CED-ORI 图像下采样通道。我们采用3×3 卷积核和2×2 最大池化层。特征图数量随着深度增加而扩大一倍,特征图尺寸随着深度增加而缩小一倍。在网络模型底层,将原始图像特征图与CED-ORI 图像特征图融合进行上采样。上采样通道中随着深度减少特征图数量减少一倍,尺寸扩大一倍。最后输出层采用1×1卷积层,输出通道为1,激活函数为Sigmoid,获得最终的分割结果。

图6 Unet-TIC模型Figure 6 Unet-TIC model

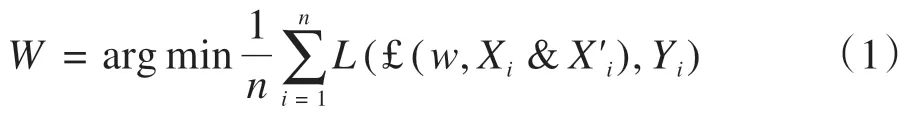

将训练数据定义为S={(Xi&X'i,Yi),i=1,…,n},其中Xi指第i张输入的原始图像,X'i指第i张输入的CED图像,Yi指第i张训练图像对应的分割标注图像。在本研究中,通过数据扩增训练图像n。每张图像尺寸为256×256。w为网络参数,输出图像为£(w,Xi&X'i)。目标函数为:

其中,W是训练得出的最优解,L(£(w,Xi&X'i),Yi)是Loss 函数。输出图像£(w,Xi&X'i)像素值为0 或1,令其像素值为{pji,j=1,…,2562},Loss函数为:

其中,a设置为1,避免分母为0的情况。在测试集中,Xtest和X'test分别为测试输入原始图像和CED 图像,Yout输出图像为:

图7展示出基于边缘强化的Unet-TIC 自动分割与勾画流程。首先,原始图像被裁剪成256×256 尺寸,然后图像经过CED-ORI算法处理强化边缘,与处理前的图像并行输入网络模型。在标准的Unet上设置跳跃连接构成Unet-c,以保证收缩路径和扩张路径之间的信息流动。另外我们建立了双通道结构的Unet来适应两两并行的原始和CED-ORI图像。通过CED-ORI 方法对图像进行边缘强化,双输入通道结构Unet-TIC 并行提取原始和CED-ORI 图像特征,共享一条扩张路径,并通过连接层突出CED-ORI 边缘强化的特征。最后将得到的输出图像映射到原始图像域并勾画出前列腺区间。

图7 基于边缘强化的Unet-TIC自动分割与勾画流程Figure 7 Automatic segmentation and delineation of Unet-TIC based on boundary enhancement

2.3 实验设置

随机选取深圳市人民医院50 例检查者前列腺MRI 图像,以及MICCAI Grand Challenge 数据库50例前列腺核磁图像,两个数据集都是用于解决前列腺自动分割问题,二者在支撑研究内容上是一致的。我们将其合并成一个数据集,丰富样本数量,满足大规模神经网络训练需求。尽管来源不同的数据集之间会有成像参数和成像质量的差异,但这些差异反而有益于提高网络模型的鲁棒性和泛化性,能更真实地检测网络模型的性能。随机选取81例作为训练集(1 457 张),10 例作为验证集(179 张),9 例作为测试集(165 张)。所有的图像手动勾画由一名经验丰富的影像医师完成,勾画软件是ITK-SNAP,并由其生成二值化分割图像,如图8所示。

图8 手动勾画与分割过程Figure 8 Process of manual delineation and segmentation

为了避免数据集太小造成模型的过拟合导致模型较差的泛化性,本文采用弹性变换将训练数据拓增至20 万张(原始图像10 万张,CED-ORI 图像10 万张)。本文采用Tensorflow 深度学习框架以及Adam优化器,学习率设为0.001,迭代次数epoch设为40。

3 结果

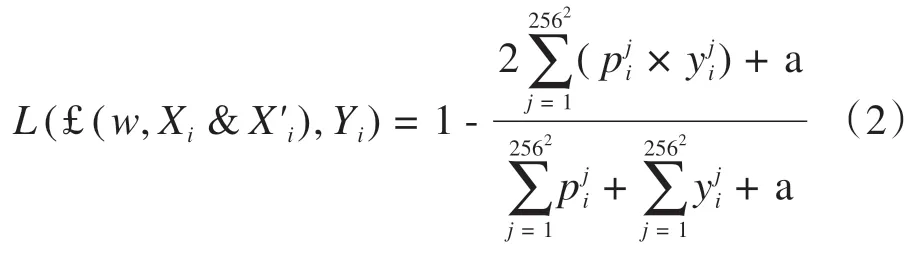

本文用Accuracy、Mean DSC、Median DSC、ASD、MSD、RVD 6 个指标对Unet、Unet-c 和Unet-TIC 3 种方法进行评估。其中Accuracy 指的是测试集中所有图像的Dice 系数。Mean DSC 指的是以扫描对象为单位的Dice 系数平均值,同样Median DSC指的是以扫描对象为单位的Dice 系数中位值。ASD指的是平均表面距离,如式(6)所示。MSD 指的是最大对称表面距离,如式(7)所示。RVD 指的是相对体积差,如式(8)所示。

其中,Aseg指前列腺自动分割边界像素点,Agt指医生分割的前列腺边界像素点,Sseg指前列腺自动分割区域像素点的总量,Sgt指医生分割的前列腺区域像素点的总量。

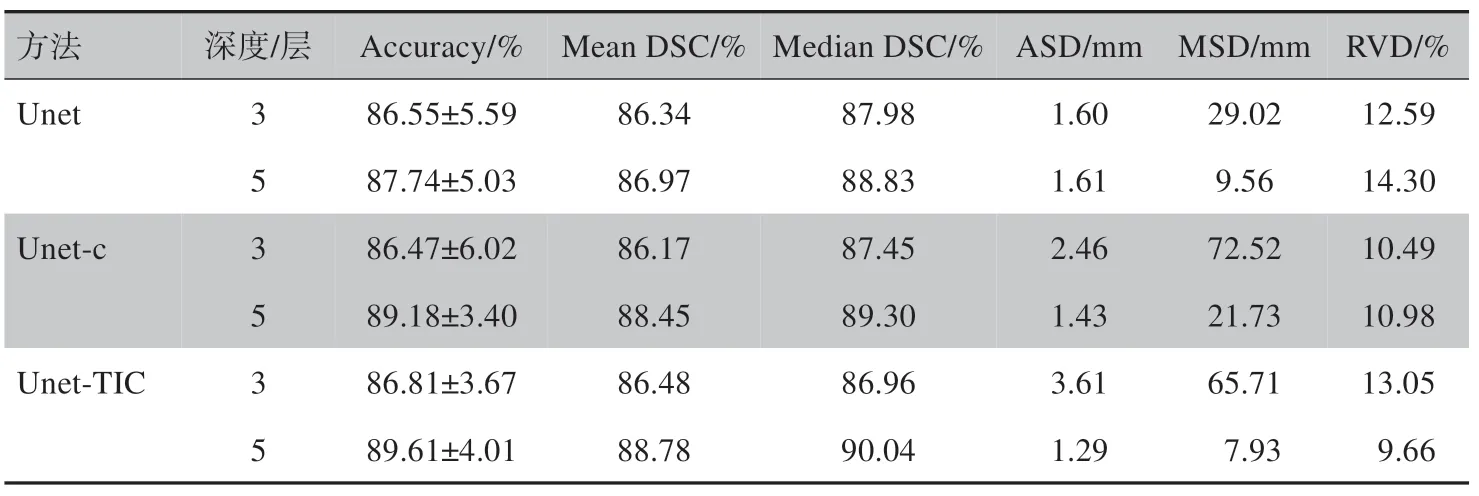

不同深度的Unet、Unet-c、Unet-TIC 在测试集的表现对比如表1所示。Unet、Unet-c、Unet-TIC深度为5 层时均好于其深度为3 层的表现。深度为5 层时,本研究提出的Unet-c 5 个评估指标结果均明显优于Unet,而Unet-TIC 6 个评估指标结果均明显优于Unet。 其中Unet-c 相较于Unet,Accuracy 提高1.44%,Mean DSC 提高1.48%,Median DSC 提高0.47%,ASD 降低0.18 mm,RVD 降低3.32%。Unet-TIC 相较于Unet,Accuracy 提高1.87%,Mean DSC 提高1.81%,Median DSC 提高1.21%,ASD 降低0.32 mm,MSD 降低1.63 mm,RVD 降低4.64%。3 个模型对比,Unet-TIC 在6 个指标均取得最好表现,不仅在测试集整体取得更高的准确率,以扫描个体为单位分割表现也优于Unet 和Unet-c。结果说明,本研究提出的Unet-c 模型通过增加Unet 上采样高分辨率信息,将下采样的同层输入和输出高分辨率特征与对应的上采样输出相结合,的确可以优化模型,提高模型输出的准确性。另外,提出的Unet-TIC 模型增加输入通道并行提取和学习原始图像和边缘强化图像特征,进一步提高模型分割性能。

表1 不同深度的Unet、Unet-c和Unet-TIC在测试集的表现对比Table 1 Performance comparison among Unet,Unet-c and Unet-TIC at different depths in the test set

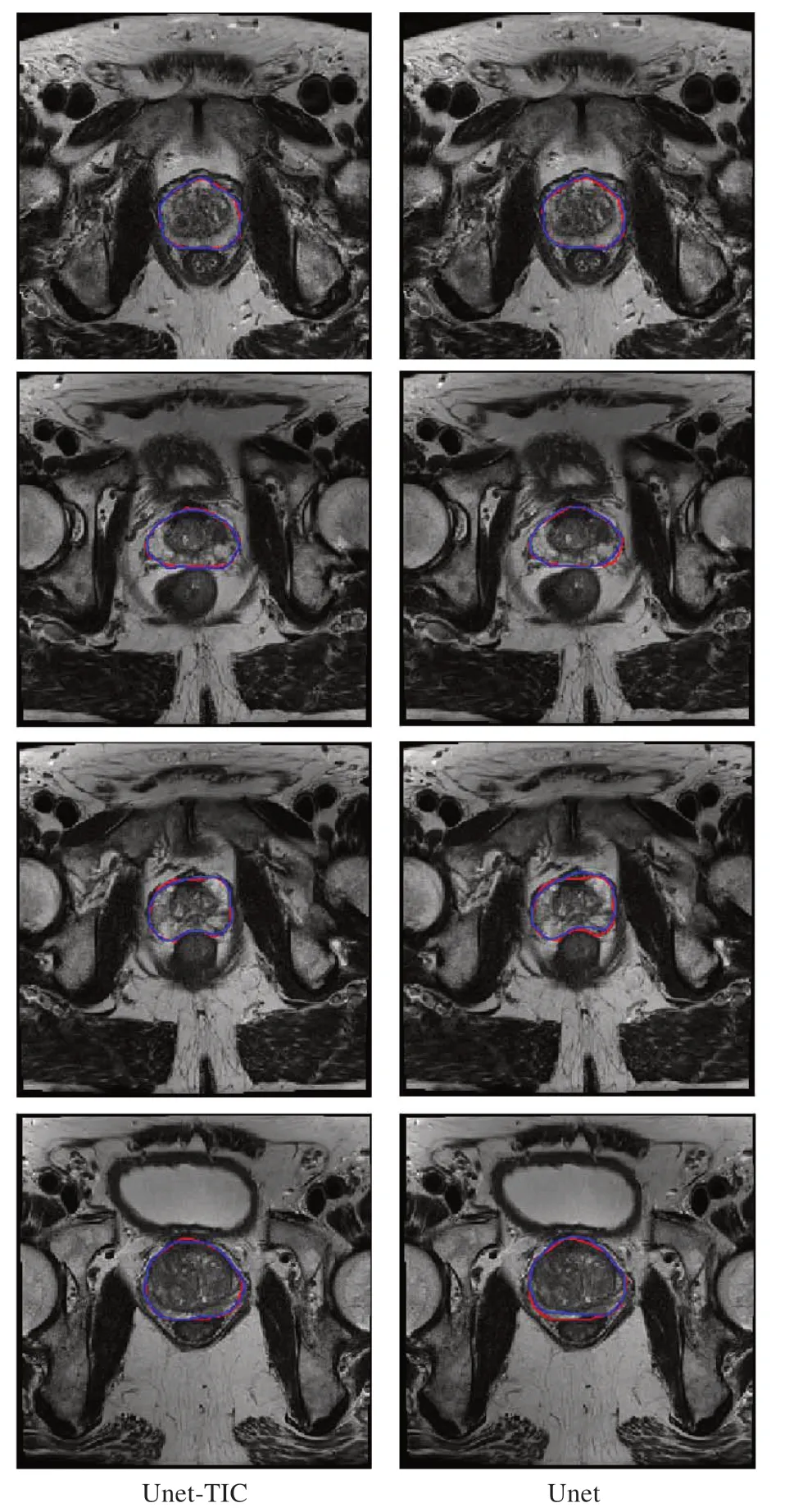

图9展示了Unet-TIC(左)与Unet(右)勾画效果对比。红色线为医生手动勾画,作为真实标准,蓝色线为网络模型自动分割勾画。蓝色线与红色线吻合度越高,说明自动分割与勾画越准确。对比得知,Unet-TIC 勾画更加精准,更能捕捉到复杂的前列腺形状的变换,尤其是辨别混淆性、类似性边界区域。

图9 Unet-TIC与Unet勾画效果对比Figure 9 Comparison of segmentation performances between Unet-TIC and Unet

4 讨论

本研究针对目前在医学影像自动分割勾画方面应用广泛的深度学习Unet 网络模型提出改进,其中Unet-c 将池化后的特征图与经过两个卷积块提取的特征图和对应的上采样层联合,再通过连续的卷积层可以根据这些信息组装一个更精确的输出,增加上采样分辨率并精确定位。另外,通过CED-ORI 方法对图像进行边缘强化,该方法在图像平坦区域向各个方向均匀扩散,而在图像的边缘区域则沿边缘方向扩散,所以经边缘扩散处理后图像平坦区域的噪声将得到有效抑制,而图像的边缘也将得到一定程度的锐化,具有更好的连贯性[17]。我们建立双输入收缩路径结构的Unet-TIC 并行提取和学习原始和CED-ORI图像特征,共享一条扩张路径,并通过连接层突出CED-ORI 边缘强化的有效特征,获取更多多维信息增加上采样分辨率。实验结果表明,本研究提出的方法通过有限的训练数据就能得到较好的结果,其中Unet-TIC模型6个评估指标表现均明显优于Unet。直观勾画方面也更加精准,细节方面更能捕捉到复杂的形状变换,尤其是辨别混淆性、类似性边界区域。但是相较于Unet,本文提出方法在网络参数方面有较多的增加,对设备的运算性能有较高要求。

未来工作将运用本方法对更多器官进行分割与勾画,加强深度学习在医学影像方面的应用研究,进一步改进与提高模型方法的准确性和鲁棒性。