基于DenseNet的自然场景文本检测

2022-07-01宋彭彭曾祥进郑安义

宋彭彭,曾祥进,郑安义,米 勇

武汉工程大学计算机科学与工程学院,湖北 武汉 430205

近年来,深度学习与机器学习的不断发展,使得目标检测技术在各领域的应用获得了出色的成果[1]。文本检测技术在其影响下也从传统的手工设计特征转为神经网络提取特征[2]。随着文本检测技术在交通标志识别、盲人文本阅读系统、图像与视频中的文本信息提取等方面的应用越来越广泛,使得准确获取文本中的文字位置并识别语义内容成为文本分析与计算机视觉领域的重点研究课题[3]。由于自然场景中的文本受背景混乱、文本方向不同、空间分布不均匀、光照强度等因素影响,使得文本检测技术面临更大的挑战[4]。

为了解决自然场景中不同因素对文本检测带来的影响,提出了许多基于深度学习的场景文本检测方法。主要方法有:(1)基于区域建议的文本检测方法。如:Shi 等[5]提出了SegLink 文本检测方法,该方法思路与SSD[6]算法一致,并融入了CTPN[7]算法的细粒度候选框,使得模型不再受限于默认比例的人工设定文本框,最终得到的网络在多方向文本与长文本中有较好的检测结果,但该模型对于弯曲文本和间距较大文本检测结果较差。文献[8]提出了SegLink++文本检测方法弥补了SegLink 的不足,该方法通过明确分块间的关系,使得模型对密集文本进行分离,改进损失函数增加检测难度较大区域的损失权重,最终实现对旋转、密集以及水平文本的检测;(2)基于图像分割 的 文 本 检 测 方 法。 如Long 等[9]提 出 了TextSnake 模型,该模型对文本几何属性的表示很灵活,采用圆环作为基础,使用FCN 来逐渐预测文本区域、文本的中心线以及圆环表示的属性,通过堆叠圆环来构成序列以表示文本行属性,最终的模型可以较好地检测不规则文本。

现有的深度学习文本检测方法主要由特征提取、预测网络以及NMS 组成,在进行特征提取时由于网络没有表明感兴趣的特征信息且没有融合多层特征,因此在特征映射时会忽略一些重要的信息,造成对文本与非文本的误判,使得整个文本检测过程存在耗时、误检等问题。

针对上述问题,本文提出一种以DenseNet[10]网络为基础的文本检测模型。DenseNet 由核心模块dense block 构成,该网络可以提取更深层的文本特征,并减缓了因网络深度造成的梯度消失问题,加强了特征传播和特征重用,同时极大地降低了网络参数数目;同时为了明确感兴趣的特征,在特征提取网络中引入协调注意力(coordinate attention,CA)[11],通过在通道信息中嵌入位置信息来明确感兴趣的特征;为了使网络可以提取内容更丰富的特征,在网络中使用特征融合技术。

1 文本检测算法设计

1.1 注意力模块

注意力机制在计算机视觉领域发挥重要的作用,如:文献[12]通过简单的压缩每一个二维特征图,建立了通道间的相互依赖关系;注意力模型(convolutional block attention module,CBAM)[13]在建立通道依赖关系基础上,通过引入大尺寸卷积核实现空间信息的编码;文献[14]利用非局部机制去获取特征图不同类型的空间信息。但这些注意力模块内部计算量大,将其用于文本检测网络中会消耗大量的计算资源。

CA 降低了对计算资源的消耗,且可以很好的表示感兴趣的特征。该机制的工作流程为:首先通过坐标注意力将通道注意力分解为两个一维的特征编码过程,并分别从两个空间方向去聚集特征;其次从一个空间方向获取长距离的依赖关系,同时在另一空间方向保存准确的位置信息;最后将获得的特征图分别编码成对方向感知和对位置敏感的注意力,将其互补的应用在输入特征图中以增强对感兴趣特征的表示。

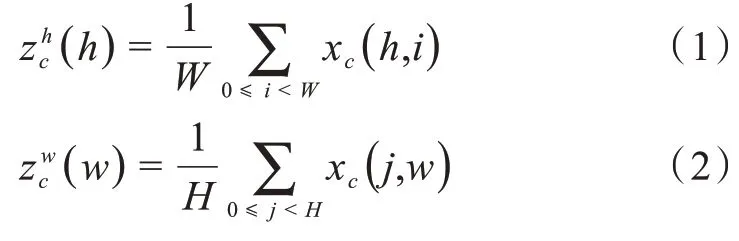

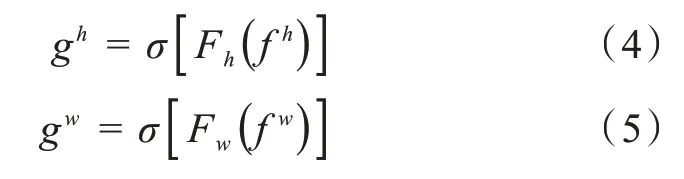

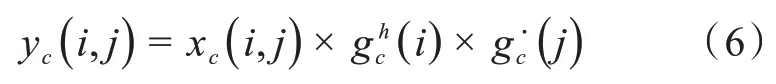

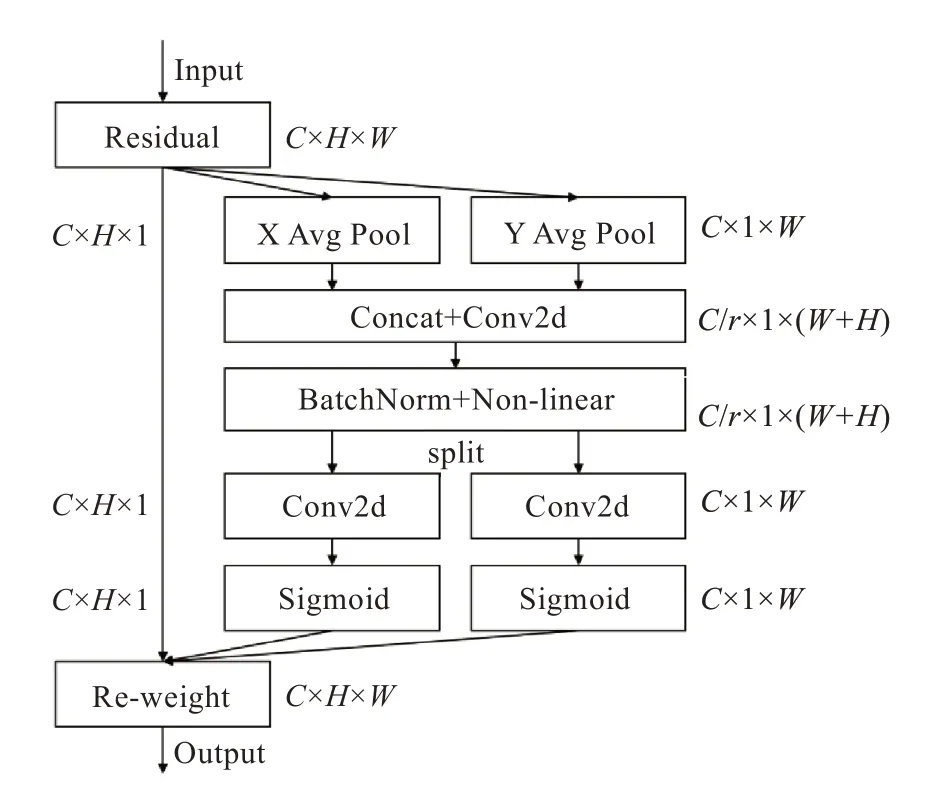

CA 的框架如图1 所示,它可以输入任意的特征向量,并输出一个增强后相同大小的特征向量。其中X Avg Pool 和Y Avg Pool 分别表示一维水平全局池化和一维垂直全局池化。为了使注意力模块利用准确的位置信息获取空间上的远程交互信息,将全局池化分解为两个一维的特征编码操作。具体操作如下:使用空间范围是(H,1 )、( 1,W)的池化内核沿水平与垂直方向对每个通道编码,得到高度h、宽度w处第c信道的输出,如公式(1)、(2)所示:

其中,H、W为特征图的高和宽。将得到的信道输出结果送入共享1× 1 卷积的函数F1中聚合特征,输出结果如公式(3)所示:

其中,[ ·, · ]表示在某一空间维度的串联操作,δ表示非线性激活函数,f∈ℝCr×(H+W)表示在水平与垂直方向编码的中间过程特征图,C为通道数,r表示控制块的缩小比。 然后将f拆分为f h∈ℝC r×H和f w∈ℝC r×W,利用1× 1 的卷积变换Fh和Fw将其变化为通道数相同的张量,得到结果如式(4)~式(5)所示:

其中,σ表示Sigmoid 函数。将输出结果展开并用于注意力权重,得到CA 的输出结果如式(6)所示:

CA 在考虑通道重要性的同时也考虑了对空间信息的编码,得到的两个注意力,图1 中的所有元素都可以反映行与列中是否存在感兴趣的特征,更准确的定位出特征图中感兴趣特征的具体位置,使得网络模型提取特征的性能更好。

图1 协调注意力模块Fig.1 Coordinate attention module

1.2 特征提取网络

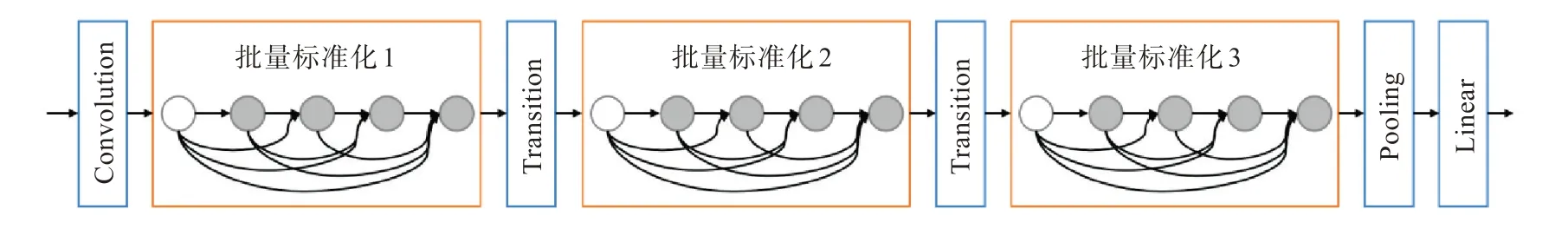

DenseNet 网络使用密集连接的方式将先前层的特征用于后续层的输入,该网络降低了梯度消失的影响,提高特征的传播,实现特征重用,极大地减少模型的参数量,其结构如图2 所示。计算公式如式(7)所示:

图2 DenseNet网络结构Fig.2 Structure of DenseNet network

其中,xl-1表示l- 1 层生成的特征图,[x0,x1,...,xl-1]表示拼接0 至l- 1 层生成的特征图,Hl( · )表示复合函数,包含批量标准化、激活函数(ReLU)以及3× 3 卷积。

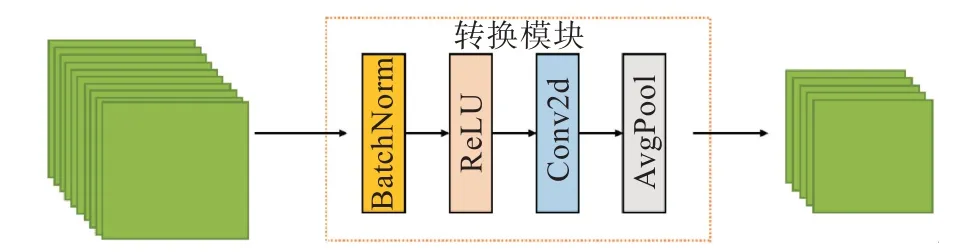

DenseNet 网络使用跳跃拼接保留原本的特征,降低了梯度消失现象的发生,然而由于网络深度不断加深,导致通道数与参数量增多,使得模型很难提取深层次的特征,因此DenseNet 设置了转换模块,其结构如图3 所示。该模块用于Dense Block 之后,主要用来减少通道数。同时为了使通道数更少,在每次Dense Block 拼接前都添加瓶颈结构,使通道数更少。

图3 转换模块Fig.3 Transition block

DenseNet 网络经过批量标准化与转换模块后通道数目减少一半,同时使用下采样减小尺寸大小,从而减少了模型计算量,提升了计算效率。

1.3 融入协调注意力的DenseNet网络

随着卷积网络深度的增加,文本检测任务可以获取更深层次的特征,但是提取特征过程中出现梯度下降或消失现象的概率也变大,为了解决这个问题,本文使用去除全连接层的DenseNet-121网络提取文本特征,该网络有效缓解梯度消失问题,且加强特征传播,提升了特征重用,同时降低了模型参数数目。为了增强对特征图中感兴趣特征的表示,本文在特征提取网络中引入CA,通过将特征的位置信息嵌入通道注意力中,以表示对需要特征的关注。为了使输出特征可以包含丰富的文本信息,使用特征融合技术对批量标准化4 输出的特征进行反卷积,并将该特征与Dense Block 3 输出的特征拼接,最终获得多层文本特征,使得文本检测准确率得到提高。改进后的DenseNet 网络结构如图4 所示。

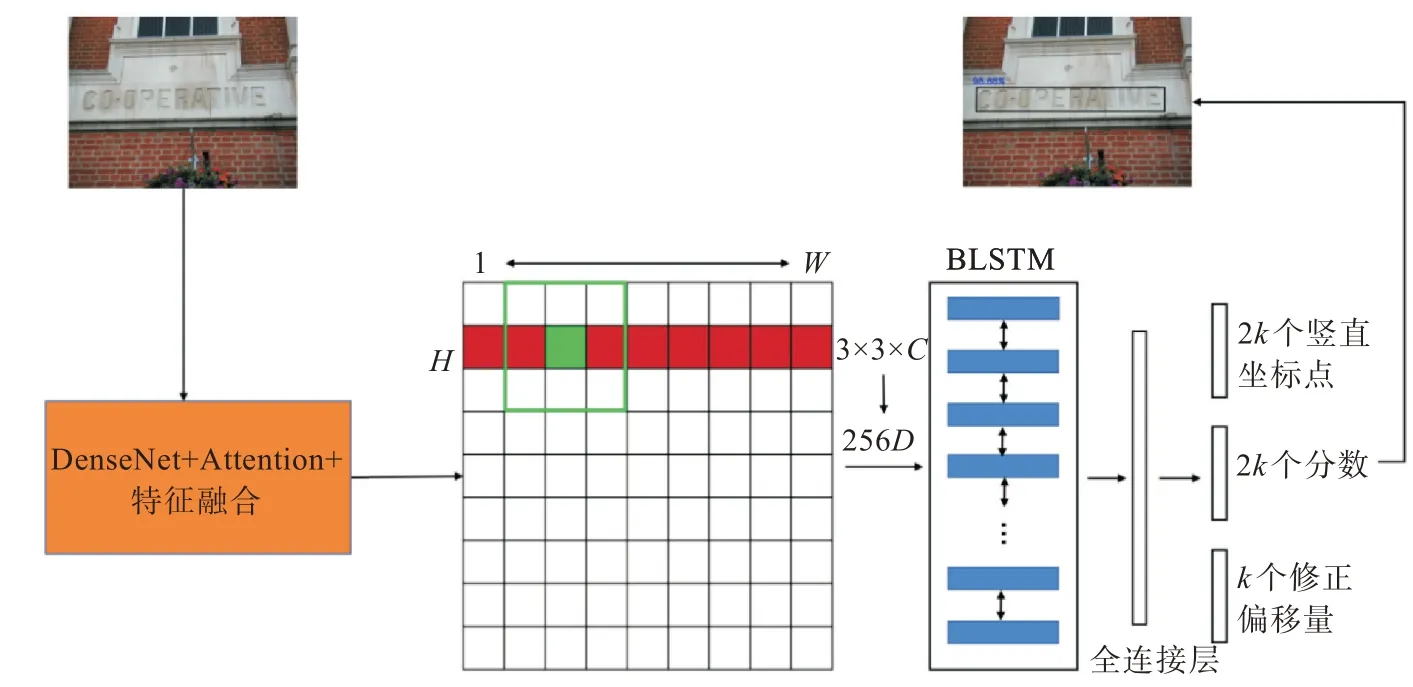

1.4 场景文本检测网络

基于DenseNet 网络设计了自然场景文本检测网络,具体文本检测流程如下:首先利用改进的DenseNet 网络获取输入文本图像的特征图(尺寸为:W×H×C),其中W×H为图像宽高,C为特征图通道数;其次使用3× 3 滑动窗口密集滑动在特征图上,每一个滑动窗口用3× 3×C卷积特征来预测以获得256 维特征向量;然后为了适应不同尺寸的文本框,设计了10 个宽度固定为16 像素,高度由11 至273 像素(每次除0.7)变化的锚框。检测时单独考虑独立文本框有可能会造成对非文本目标的误检,因此为了提升定位精度,将每个文本行转为一系列细粒度文本框,利用双向LSTM对细粒度文本框从两个方向编码;最后将编码得到的结果输入全连接层。改进后的文本检测网络如图5 所示。

图5 文本检测网络Fig.5 Text detection network

2 实验部分

2.1 数据集与评估指标

文本检测实验使用数据集ICDAR2011[15]和ICDAR2013[16]检 测 本 文 方 法 的 有 效 性。ICDAR2011 由229 张训练集与255 张测试集组成,图像中的文本区域均以单词级别来标注。ICDAR2013 由229 张训练集与233 张测试集组成,图像中的文本区域由字符和单词级别来标注。两类数据集均从真实场景获取,且对自然场景中可能受到的遮挡、光照不均、模糊等现象考虑充分。因此这两种数据集满足评价本文方法的条件。

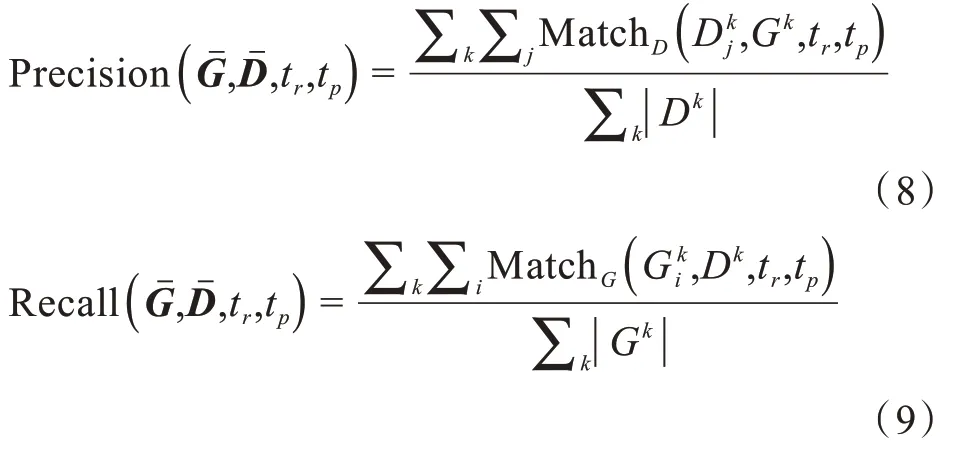

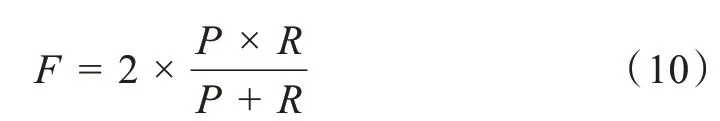

使用DetEval 评价指标来评估两类数据集,该方法通过一对一、一对多以及多对一、3 种方式判断检测框和标记框的匹配程度。最后通过精确度(P)、召回率(R)、F值判断模型有效性。其计算公式如式(8)~式(10)所示:

2.2 对比实验

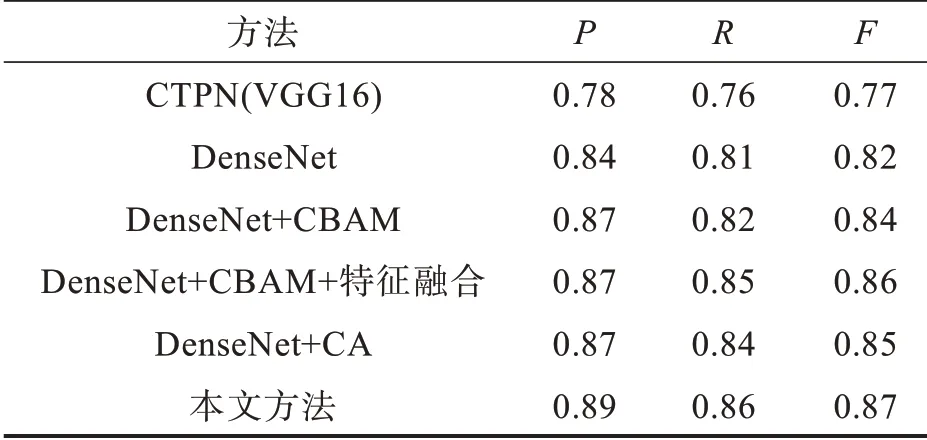

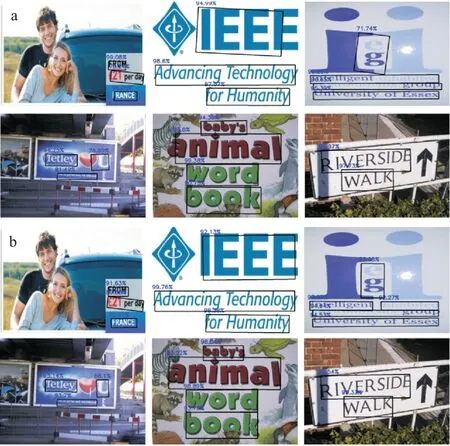

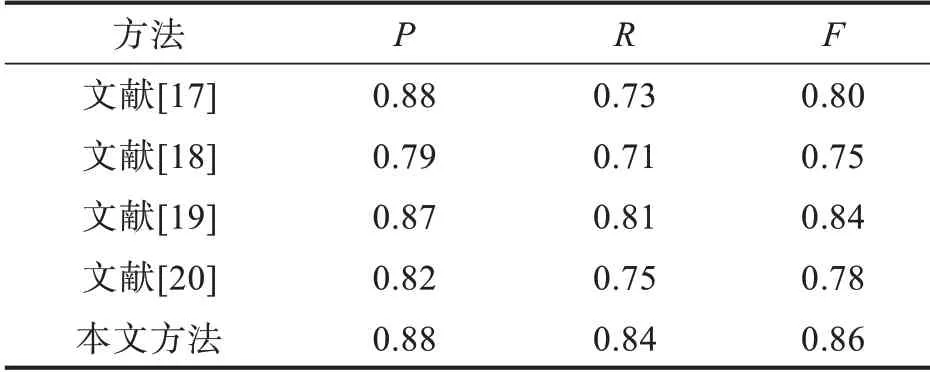

相同环境下,使用数据集ICDAR2011 和ICDAR2013 评估本文不同的改进方法,实验结果如表1、表2 所示。通过表中数据发现,使用本文方法(DenseNet+CA+特征融合)检测文本时,在ICDAR2011 中准确率(P)、召回率(R)、F值分别提高0.12、0.09、0.11,在ICDAR2013 中准确率(P)、召回率(R)、F值分别提高0.11、0.10、0.10。

表2 不同改进方法在ICDAR2013 实验结果Tab.2 Experimental results using different improvement methods in ICDAR2013

对特征提取网络以及注意力进行改进的对比实验如下:

实验一:分别使用VGG16 与DenseNet 网络作为特征提取网络进行文本检测,实验结果如图6 所示。两类网络均存在误检、漏检问题,但是DenseNet 网络对相同图像的检测准确度明显高于VGG16。

图6 不同特征提取网络检测结果:(a)VGG16,(b)DenseNetFig.6 Detection results of feature extraction using different networks:(a)VGG16,(b)DenseNet

实验二:以DenseNet 网络为特征提取网络,为了提取更深层次的网络特征对该网络进行特征融合,为了明确特征提取过程中的感兴趣特征,分别引入CA 与CBAM 注意力进行实验对比,实验结果如图7 所示。通过对相同图像的对比可以发现,CA 的引入降低了文本检测的误检率,提升了文本检测的准确率。

图7 不同注意力方法检测结果:(a)DenseNet+CBAM+特征融合,(b)DenseNet+CA+特征融合Fig.7 Detection results using different attention methods:(a)DenseNet+CBAM+feature fusion,(b)DenseNet+CA+feature fusion

2.3 结果与分析

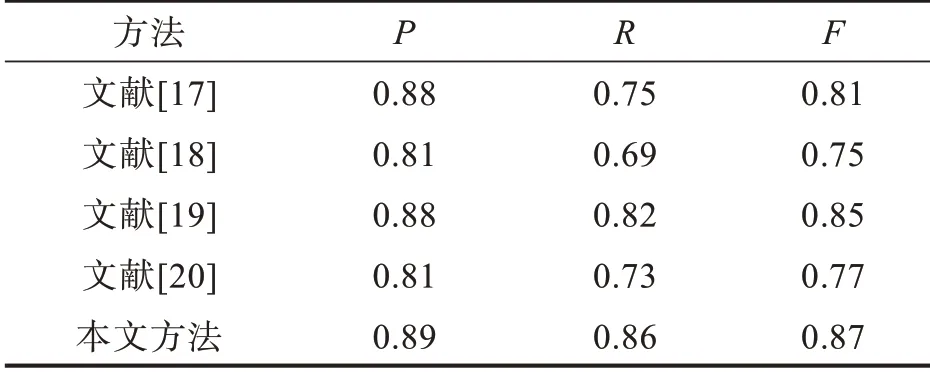

通过实验结果的对比发现,本文改进的自然场景中的文本检测方法有较好的检测结果。为了评估本文方法和其他算法在文本中的检测性能,本次实验选用ICDAR2011 和ICDAR2013 数据集进行实验,实验结果如表3、表4 所示。在ICDAR2011 中本文方法的准确率(P),召回率(R),F值分别为0.88,0.84,0.86;在ICDAR2013 中本文方法的准确率(P)、召回率(R)、F值分别为0.89、0.86、0.87。与其他算法相比本文方法在准确率、召回率、F值上均有提高。

表3 ICDAR2011 评估结果Tab.3 Evaluation results of ICDAR2011

表4 ICDAR2013 评估结果Tab.4 Evaluation results of ICDAR2013

3 结 论

本文提出基于DenseNet 改进的文本检测网络。该网络可以很好地处理自然场景中复杂多样的文本图像。为了获取文本图像的深层特征,使用DenseNet 网络来进行文本特征提取。同时在DenseNet 网络中使用特征融合技术,使改进后的网络可以获得文本内容更丰富的特征。此外,为了使特征提取过程明确感兴趣的特征,引入CA 机制,使得网络在提取特征时能够准确获取需要的特征,减少文本检测过程中的漏检和误检问题。通过使用不同数据集进行实验发现,本文改进后的方法在文本检测任务中有较好的结果。然而本文只针对水平方向文本进行检测,对多方向文本检测效果较差,因此,后期将考虑对多方向文本检测的方法进行探讨。