构建智能化指挥实体 提升基层指挥员训练水平

2022-06-29吴永明杨海波

□吴永明 杨海波 汪 超

随着陆军部队诸兵种合成训练逐步向下延伸,合成营已逐渐成为“军-旅-营”体制下机动作战基本单元,在单人单装训练、连以下分队协同训练的基础上,合成营战术训练是首次实现分队指挥员指挥能力和指挥技能的融合训练。针对目前指挥训练中,存在战术训练组织复杂、训练条件设置单一、训练模拟对手死板、战法固定等不利因素,按照战斗力生成的规律,构设智能化指挥实体,模拟强敌对手和作战环境,实现智能化指挥实体决策智能性、技术方法集成性和平台搭载适应性的目标,提升指挥员训练水平。

一、智能化指挥手段意义

随着信息技术的高速发展,大数据时代已经到来,依托AR技术对大量数据信息的深度分析,有效提升了信息处理的准确性和时效性,实现信息处理全部或部分自动化。智能化指挥手段有效提升了指挥员对现代化战争的把控能力,协助指挥员深度解析战场迷雾,及时准确把握战场态势,为有效预测战局发展提供数据信息参考,形成对敌决策优势。

(一)多维度模拟作战对手。模拟作战对手的关键是模拟其战斗力,智能化指挥实体模拟战斗力要素主要体现在以下五个方面:一是自动、快速、准确获取战场信息、正确理解和研究判断作战态势;二是熟悉武器装备战技术性能、熟练运用武器装备;三是灵活运用战术原则和交战规则;四是统筹把控胜负标准;五是迅速生成有效交战数据,形成一体化的智能指挥决策能力。通过对作战对手各方面的模拟,达到提升指挥员训练水平,提高训练效益的目的。

(二)实现对战场态势的交互与反馈。构建复杂作战模拟系统中的智能化指挥实体,创新性地采用MARL(Multi-Agent Reinforcement learning:MARL)技术,构建算法模型体系,可以让指挥员动态实时地读懂战场态势、精准分析判断对手作战意图、实现智能决策和智能评估,通过实现算法的不断调优,解决复杂条件下战场信息的交互与反馈,使得决策模型逐渐向有利于我方战场局势的方面发展,实现理论与经验的结合,在缩短模型训练进化时间、节约GPU计算资源的条件下,极大地提高指挥员对瞬息万变的战场态势的判断能力。

(三)提升指挥员指挥能力。一方面,智能化指挥实体可在指挥训练模拟中应用,对陆军分队指挥员训练方法、作战方案检验论证提供和开辟新的途径。通过提升作战对手的“高智能”,为指挥员指挥训练提供高水平的“假想敌”,达到不断历练和提升指挥员指挥能力和谋略水平的目的。另一方面,智能化指挥实体可与现有的地面无人化作战平台结合,提升地面无人化作战平台的智能化决策水平,达到“软-硬”兼备的目的;与指挥控制系统一体化链接,自主完成作战任务。

二、智能化指挥实体的战斗力要素

在未来信息化作战中,精确作战、特种作战、一体化联合作战已经成为主要的作战样式。当前,陆军合成营分级分层分要素的战斗力逐步生成,构建智能化指挥实体,对于检验协同训练效果、提升战术训练的真实性、培养指挥手段的可操作性具有关键支持作用。因此,需要从战场态势、规则运用、胜负标准、多智能化指挥实体决策算法四个方面进行构建战斗力要素。

(一)研判战场态势。根据《陆军军事训练大纲》要求,当前陆军合成营主要有7个共同课题,49个使命任务课题。无论共同课题,还是使命任务课题,模拟对抗训练的战场态势具有多源情报深度,多类目标属性,多种陆海空态势。复杂的态势判断往往借助人工智能辅助手段,分析敌情、我情和战场环境,能够结合地形环境特点,对比分析双方武器装备、作战体系,找出敌方态势优劣强弱,为决策行动提供支撑。

(二)熟悉规则运用。在战斗力形成过程中,双方的战斗力均是从单人单装的战斗力逐步合成得来的。为此,智能化指挥实体要实现熟悉规程并熟练运用规则,采用深度学习的方法逐步实现由易到难、由简单到复杂的步骤,将规则区分为不同层次,先简单要素到复杂要素,从基础单元到编队体系。在学会必要的对抗逻辑基础上,逐步迭代升级,机器分类实现和理解,最终实现由弱人工智能向强人工智能转化。

(三)理解对抗胜负标准体系。模拟对抗的胜负标准通常难于判定。每种想定下的对抗,对应不同的作战目标、不同的评判标准,可以说是“一战一标准”。为了让智能化指挥实体读懂标准体系,需要把复杂的作战目标进行分解细化,通过确定目标模型,细化不同作战任务,确定标准的数值指标。

(四)构建多智能化指挥实体决策算法。按照战术训练逐级合成的方式,构建算法模型,实现不同的智能化指挥实体在共同作战区域内情报共享、机动方式选择、对敌打击目标确定、方案评估及优选、对敌毁伤评估、行动方案调整等方面达到最优,最大限度地确保对抗训练取得胜利。

三、智能化指挥实体主要模型构建

(一)战场态势认知模型构建。

1.态势认知。在作战指挥智能决策系统中,态势认知是智能化指挥实体决策的基础。态势认知对象主要包括作战环境、动态的作战实体以及其他影响战局变化的各种因素。

2.态势分析。主要从多源战场数据中提取态势相关技术参数。形成某时节战场环境和作战单元的信息技术参数S,并从S所有技术参数的集合中,提取诸如地理环境特征(高山、密林、乡村、街道等)、对象类型(装甲车、步战车、指挥员等)、对象状态(行军、集结、开战等)一系列态势元素。

3.态势理解。根据信息融合所生成的态势特征向量,并结合相关作战指挥规律,对战场敌我态势进行分析,研判作战对手的主要作战单元部署和作战企图(进攻、防御、撤离等),识别敌方作战意图和作战计划。

4.态势预测。在充分掌握当前态势的基础上,已知t时刻的战场态势S(t),预测T时刻(T>t)时刻的战场态势S(T),即在进行威胁评估的前提下对未来敌方作战单元的状态、可能采取的行动以及导致的结果进行综合预测。对于少量作战单元的状态预测相对简单,而对战场全局态势演变的预测则极其复杂。

(二)作战企图判断模型构建。需要确定影响企图估计的要素以及要素的状态,并按照各要素之间的密切联系建立节点间的有向弧,有向弧表示事件之间的层次关系;然后确定各节点的先验概率或条件概率;最后选择合适的推理算法进行推理。力图获得更深一层次的敌军区域企图判断。简而言之该模块的企图判断需要包括对单智能化指挥实体的原子态势理解以及对于敌军整体的复合态势理解。

(三)构建分层决策模型。决策是行动的先导,对取得战争优势起着决定性的作用。为使智能化指挥实体能够在认知态势、理解规则的基础上,围绕作战目标作出最优决策。

1.基本设想。利用多阶层强化学习手段解决战场对抗问题,其主要作用是将大规模的复杂战场对抗问题在时域空间或频域空间等多维度进行分解和抽象,并采取精准定位策略对各节点问题进行求解。与此同时,相较于传统强化学习解决战场对抗任务时存在的复杂数据问题,分层强化学习手段使用了实现高级博弈任务目标和低级控制之间分离的组网架构,从而达到实现目标是什么和问题怎么办的解决思路。

2.战术决策。上层决策模型,以马尔可夫决策过程为基本理论,建立状态空间、动作空间、激励函数和状态转移函数,通过强化学习训练得出决策模型,同时避免纯强化学习方法计算搜索空间过大的问题。

(1)状态空间。智能化指挥实体所有状态空间维度,主要由其兵种专业、损伤、武器装备、地理位置、地形特点等要素构成。

(2)动作空间。智能化指挥实体的动作空间,是军事实体所能执行的动作的集合。如步战车的动作空间,包括机动、射击、下车、夺控、待机等。根据所代表的作战实体性质不同,各类智能化指挥实体的动作空间不同。由于军事规则的约束,在特定态势下,智能化指挥实体不能执行某些动作,则可执行的动作从而构成有效动作空间。

(3)奖励函数。奖励函数的作用是,定义状态与动作之间的数值关系。奖励值越大,动作越被鼓励;奖励值越小,动作越被抑制。比如敌方被毁伤、敌我兵力比等,都可作为智能当前决策的直接反馈。

奖励函数定义规则包括:当前态势下战场双方兵力比、我方任务完成度、双方所受毁伤等。具体的奖励函数公式设定需要依赖大量的试错与模型训练不断地修正并不断地分析优化塑形。

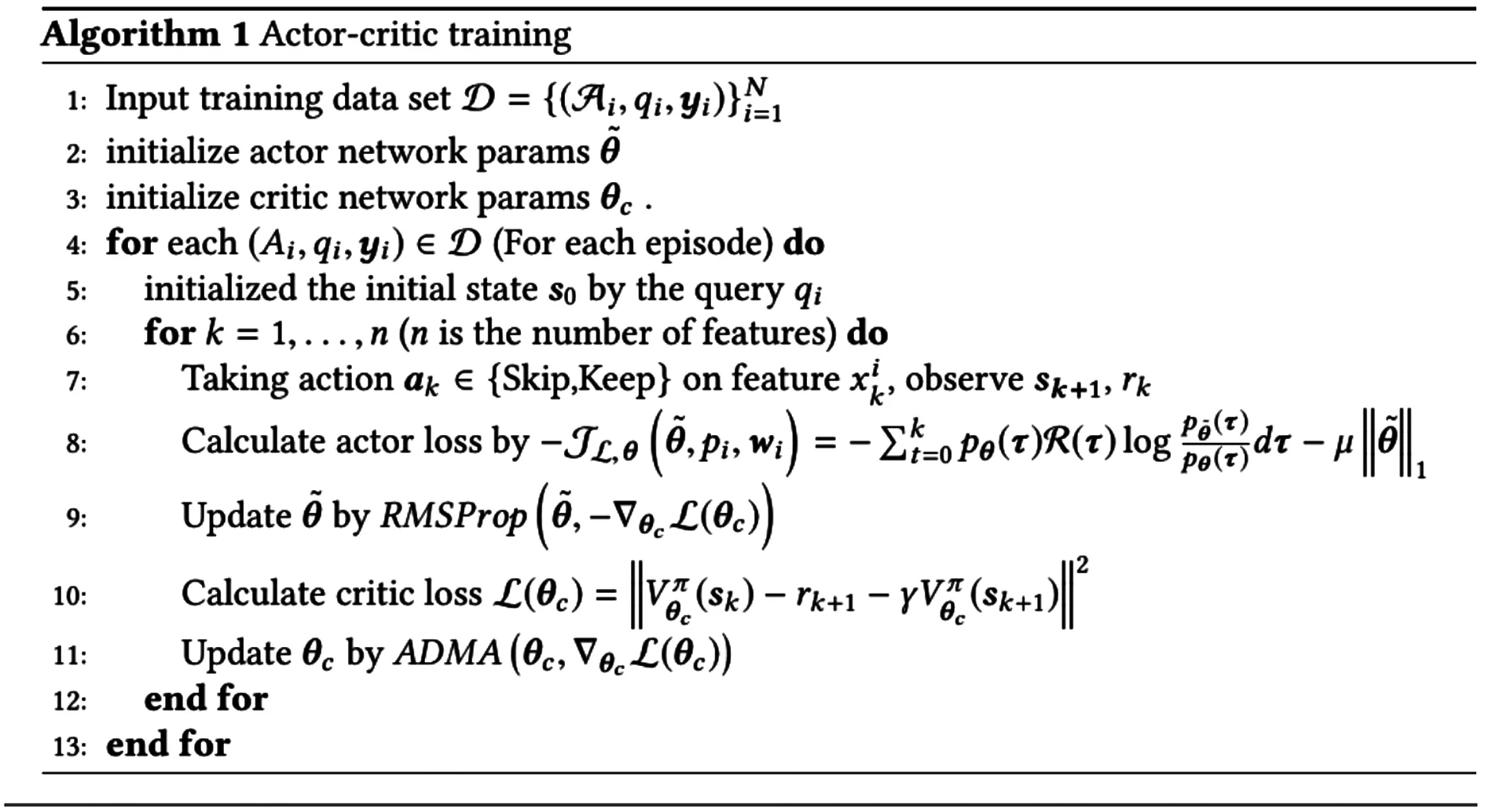

采用Actor-critic来优化loss function,其中actor为策略网络。利用参数化的网络估计每个状态的值函数。算法伪码如图1所示。

图1

3.协作决策。尽管单个智能化指挥实体能根据态势认知自主决策,但智能化指挥实体之间缺少分工协作,导致战术任务重叠;例如,多个智能独立的局部最优决策都是对某一目标射击,但实际综合结果可能是对同一目标进行打击的火力超过需求而造成浪费,未实现全局最优。单智能化指挥实体与多智能化实体由于其所在环境的不同导致学习的任务繁重,面临的挑战更大。

为解决近端策略优化模型(Proximal Policy Optimization,PPO)中智能化指挥实体协作不足的问题,采用MADDPG算法为协助手段,其具有以下三点优势:一是通过深度学习得到的最优解决问题的方案,在应用过程中利用局部信息就能给出最优解决方案;二是无需知道现实环境的动力学模型以及特殊的联络需求;不仅能用于合作环境,也能用于竞争环境。