基于多步态特征融合的情感识别

2022-05-31胡新荣刘军平何儒汉

彭 涛, 唐 经, 何 凯*, 胡新荣, 刘军平*, 何儒汉

(1. 纺织服装智能化湖北省工程研究中心(武汉纺织大学), 湖北武汉 430200;2. 湖北省服装信息化工程技术研究中心(武汉纺织大学), 湖北武汉 430200;3. 武汉纺织大学计算机与人工智能学院, 湖北武汉 430200)

随着计算能力和人机交互技术的不断发展,情感计算逐渐成为情绪研究的新型领域,情绪识别是情感计算中不可或缺的一环。目前可用作识别情绪的特征有很多,主要分为言语特征和非言语特征,例如眼球运动[1]、面部表情、声调、姿势、走路方式[2]等。情感识别中使用任何非言语特征会存在不可靠的特性,被认为是心理学和AI中一个具有挑战性的问题。然而步态作为一种新兴的特征,利用人固有的生理特征和行为特征[3],根据人行走的姿势进行个人情绪识别,具有不易伪装和低分辨率的优势。因此,利用个人步态信息进行情感识别,在情感计算、治疗、康复、机器人、监视和观众理解等方面具有重要意义。

近年来,在计算机视觉领域,基于步态的情感识别研究中,可利用的步态特征分为3种:人体骨骼点的时空位置特征、骨骼点旋转的运动特征、人体步态姿势提取的情绪特征。

基于步态情感识别数据集Emotion-Gait[4]把离散的情感分类为:快乐、悲伤、愤怒、中立等4类。本文将该情感数据集用于所提出的情感识别模型。分析基于步态识别情绪现有的模型方法,目前存在的问题如下: 1)已有的方法仅利用人体骨骼点的时空位置信息和情绪特征结合,以及仅利用骨骼点旋转的运动特征与情绪特征结合,缺少时空位置信息与骨骼点旋转的运动信息结合,无法充分表达步态特征。2)已有特征融合方法都是直接拼接,缺少对融合方法的深入研究。针对以上存在问题,本文提出有效的特征融合方法,将时空位置信息、骨骼点旋转特征协同表达,构建稳健的情绪感知方法,提升情感识别的性能。

1 相关工作

近年来,众多研究情感识别方面的学者逐渐把工作转移到研究步态特征上。心理学实验表明,观察者能够通过观察人手臂摆动、步幅、步长、站立姿势等步态特征来识别其的悲伤、愤怒、快乐和骄傲[5-7]等情绪,这些特征引起了计算机视觉和情感计算领域研究人员对姿态感知情绪的极大兴趣。相关研究将这些情感特征与从循环出现的动作[8]或卷积网络[9]中学习到的特征结合起来,可显著提高分类的准确性。

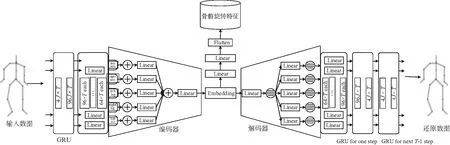

基于步态特征识别情绪的方法主要有3种:1)使用基于LSTM的方法[10],从具有时序信息的步态数据集上提取深度特征,与根据人类步态静态姿势提取的情感特征相结合,进行情绪识别。2)STEP[4]方法生成带标注信息的步态数据,解决数据缺乏的问题。该方法分类部分使用时空图卷积神经网络提取步态数据集时空特征,结合人类步态静态姿势特征进行分类。3)HAP[11]方法利用半监督网络中无监督部分的自编码器,分层注意人体身体的各部分数据。编码器编码和解码的过程能够学习人体各部位(手臂、腿和躯干)的运动特征。对于含有标签的数据,分类器将编码器提取的特征映射到离散情感标签上,从而完成训练过程。

传统GRU、LSTM等模型方法仅仅利用单个时间步长的关节坐标来形成特征向量,并对其进行时间分析,而没有显式地利用关节之间的空间关系。时空图卷积神经网络建立在一系列骨架图之上,网络中每个节点对应人体的一个关节,每个节点有2种类型的边,一种是符合关节自然连通性的空间边,另一种是跨越连续时间步长连接同一关节的时间边,并在此基础上构造多个时空图卷积层,实现信息在时空维度上的集成,之后,用多层时空图卷积(ST-GCN[12])逐步在图上生成更高层次的特征图。时空图卷积模型通过自主学习数据中的时间、空间信息,突破了以往方法的局限性,具有更强的表现力和泛化能力。

深度神经网络在许多计算机视觉领域[13-15]取得了巨大成功,许多注意推理模型[16-17]被用于神经网络识别的工作中,挖掘识别区域,隐式分析高层次特征之间的映射[16-17]关系。传统的注意力机制大多直接利用图片的整体作为注意力机制的输入,虽然这些传统方法产生的注意力可以作为各种任务的先验来使用,但它覆盖对象的区域缺少针对性。Lee等[18]使用深度神经网络生成了情感相关注意力的热点图,但其仅关注图像层面的情感分析,因此无法准确捕捉到有助于提高性能的区域。本文用包含丰富情感特征的步态信息作为基于注意力机制的自适应融合网络的输入,以期提升算法性能。

在情绪识别领域中考虑手势位置等上下文信息能够显著提升情绪识别性能[19],在基于步态识别情绪领域中,融合了人体骨骼时空特征的情绪特征,能对情绪识别的结果有显著提升[4]。HAP[11]网络提取步态信息中骨骼点旋转的信息,识别情绪的精度更为精确,其结果表明,骨骼旋转特征、骨骼时空特征都包含了丰富的情感信息,有助于提高情绪识别的精度。因此,本文提出一种新的模型,利用骨骼旋转信息与具有时空特征的深度信息相结合进行情绪识别,且考虑到直接融合往往无法达到最佳的融合效果,设计一种基于注意力机制的自适应融合网络模块,能自动调整骨骼旋转的运动特征与时空特征的融合权重比例,进一步提升情绪识别的精度。

2 多步态特征融合模型

2.1 整体模型框架

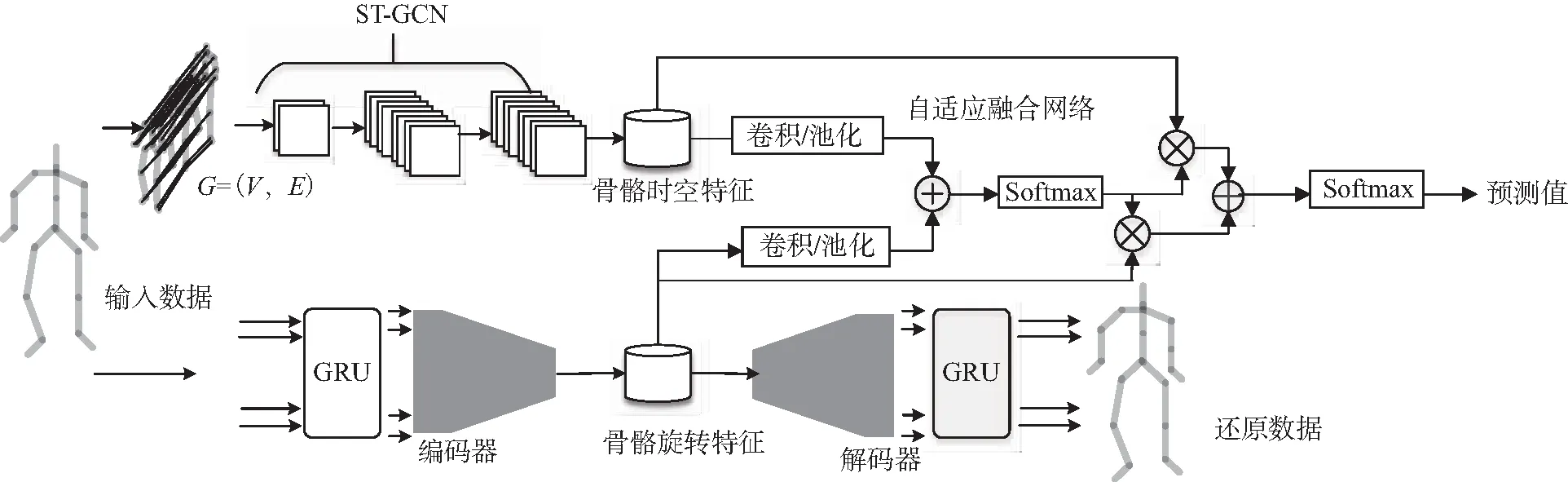

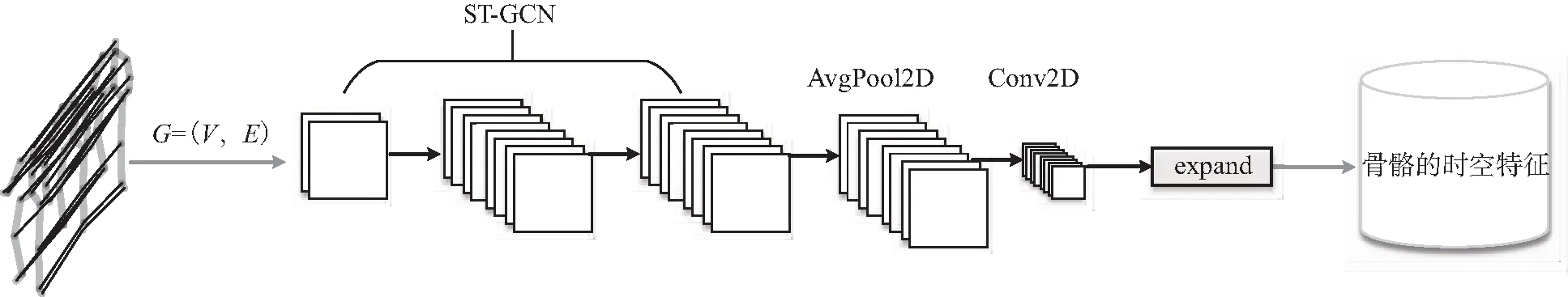

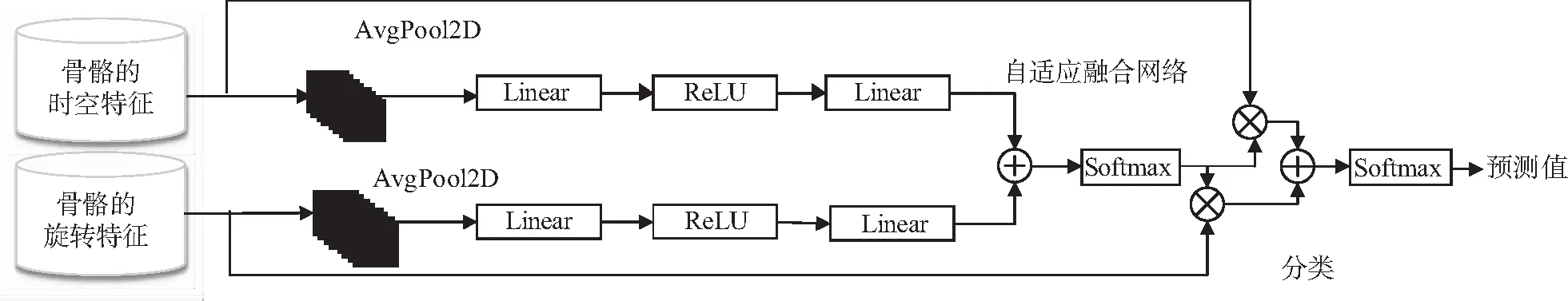

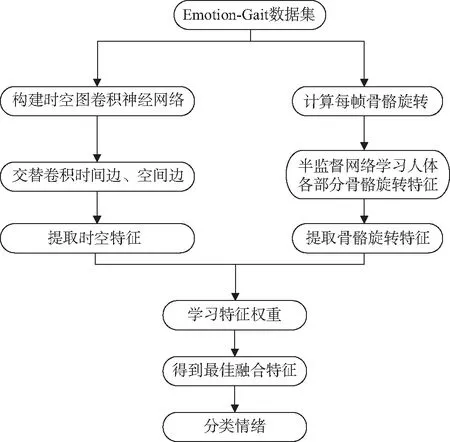

本文提出的网络模型如图1所示,模型由3部分组成:第1部分如图2所示,描述时空特征提取模型(ST-GCN[12])提取时空特征过程;第2部分如图3所示,描述无监督网络提取人体骨骼旋转特征过程;第3部分如图4所示,描述自适应融合网络融合骨骼旋转特征与人体骨骼旋转特征过程。

图1 网络模型Fig. 1 Network model

2.2 模型执行流程

网络模型训练过程包括3个阶段:

第一阶段,如图2所示,为了利用时空图卷积神经网络,需要从步态序列中提取三维的骨架序列。根据步态序列中三维骨骼点坐标信息构建骨架图,如图2中输入数据所示。骨架图表示为G=(V,E),其中V代表骨架图中一系列骨架的点,E代表骨架图的连接边。经过时空图卷积神经网络对骨架图时间和空间上的边交叉进行卷积得到时空特征Fst。

图2 时空特征提取Fig. 2 Spatiotemporal feature extraction

图3 骨骼旋转特征提取Fig. 3 Bone rotation feature extraction

第三阶段,如图4所示,对提取出来的骨骼时空特征、骨骼旋转特征进行融合并对情绪进行分类。在融合之前将提取出来的时空特征进行升维,保证与旋转特征的维度一致。接着对融合的特征进行归一化处理,消除数据量纲的影响。融合时使用基于注意力机制的自适应融合网络,让网络能自动调整骨骼旋转的运动特征与时空特征的融合权重比例。融合过程中骨骼的时空特征权重λst与骨骼的旋转特征权重λra之和为1,二者特征加权求和得到融合特征Fmix,其计算公式如式(1),融合后的特征Fmix进行Softmax层分类得到最后的情绪分类结果。

图4 特征自适应融合Fig. 4 Feature adaptive fusion

Fmix=λra×Fra+λst×Fst。

(1)

2.3 情绪标签设置与分类损失函数

观察者对他人情绪的感知在很大程度上取决于个人所处的社会和受到的文化影响,使情绪感知成为一项固有的主观能力。

此次分类目标是多分类(C>2),且分类的数据集使用的是多标签数据集(使用one-hot编码表示标签),对于此类问题,常使用加权的多类交叉熵损失 (weighted multi-class cross-entropy loss)对模型进行训练。

为了解决正样本数量太少容易引起训练失衡的问题,在训练中为分类器损失设置情绪权重wl=exp(-pl)。加权多类交叉熵损失为

(2)

2.4 模型执行流程图

图5描述了数据集提取特征、数据融合及分类的流程。

图5 模型执行流程Fig. 5 Model execution flow chart

2.5 自适应融合模块

在人类行走时,骨骼旋转特征和骨骼点时空特征在不同情况下表达情绪重要的程度不同。比如当人快乐时,手腕上可能会有些细微的动作,如翻转手腕等,此时时空特征很难捕获骨骼点的局部位移,因此,骨骼旋转特征在进行此种情绪分类时,比骨骼点的时空特征情绪相关性更大。同样,其他情绪分类时,2种特征对情绪分类的影响程度也会不同。因此,本文设计自适应融合模块,让网络能自动调整不同情形下骨骼点旋转特征与骨骼点时空特征融合的权重。

在特征融合之前,需要进行归一化处理,消除数据量纲的影响,将其转化为无量纲的纯数值,使得不同单位或量级的指标能够进行比较和加权。

在归一化特征的基础上,骨骼旋转特征和骨骼点时空特征经过自适应融合网络第一层Softmax层后,骨骼的时空特征和骨骼的旋转特征得到各自的权重比例。在后续的训练中,该部分网络通过学习自动调整特征之间融合时的权重,进而达到最佳融合效果。

2.6 自适应特征权重

采用直接拼接的方法对时空特征与旋转特征进行融合往往无法得到最佳性能。为了使旋转特征和骨骼点时空特征协同表达,本文设计了基于注意力机制的自适应融合网络,自动调整两者特征的融合权重。

获得自适应特征权重如图4所示。标准化后的特征经过平均池化层,压缩数据减少空间信息,以加快计算速度与防止过拟合;然后经过线性层、ReLU层激活函数,使传入下一层的特征具有非线性关系,增加特征的表达能力;最后2种特征张量经过线性层后,拼接输入到Softmax层,输出特征权重λra与λst。在分类部分中,将时空特征与骨骼旋转特征分别加权求和得到最后的特征Fmix,输入到Softmax层进行四分类,得到情感分类的预测值。

3 实验与分析

3.1 数据集和评价标准

本文在最新的基于步态情绪识别数据集Emotion-Gait[4]上进行实验。Emotion-Gait数据集是从BML[22]、Human3.6M[23]、ICT[24]、CMU-Mocap[25]、ELMD等5个数据集中提取3D姿势序列数得到。为了保持不同数据源姿态模型的统一性,将Emotion-Gait中所有的模型转为ELMD中使用的21骨架姿势模型。对每组步态序列使用裁剪或添零补充的方法,保持每组步态数据包含240帧图片。在每组步态序列包含的240帧图片中,每5帧进行下采样,选取1帧作为训练时每个步态数据,组成步态输入序列。Emotion-Gait数据集共有3 924个步态,其中1 835个步态由10位标注者提供注释标签,剩下的2 089个步态没有提供标签。在有标签的数据集中,同一个数据可能被标注多个情绪标签,其中,58%的数据含有快乐标签,32%的数据含有悲伤标签,23%的数据含有愤怒标签,14%的数据含有中立标签。

由于Emotion-Gait数据集分布不均匀,如果使用准确率(ACC)为指标,数据结果难以反映真实情况。比如某类标签数据集在整个数据集中占比较大,将获得较高的准确率。为了避免此情况,本文采用精确度(AP)和平均精确度(MAP)进行衡量。精确度计算公式为

(3)

式中:NTP是正确预测为某类的数量;NFP是误判为某类的数量;精确度ηAP代表模型预测某类情绪时,样本被正确预测的占比,减少了样本不均匀带来的影响。

3.2 对比实验

为了验证骨骼旋转特征与骨骼点时空特征结合的有效性,设计了对比实验一。该实验采用与以往基于步态识别情感相同的特征融合方式,直接融合骨骼旋转特征与骨骼点时空特征,并对使用相同融合方法、不同融合特征得出的情绪分类结果进行对比。

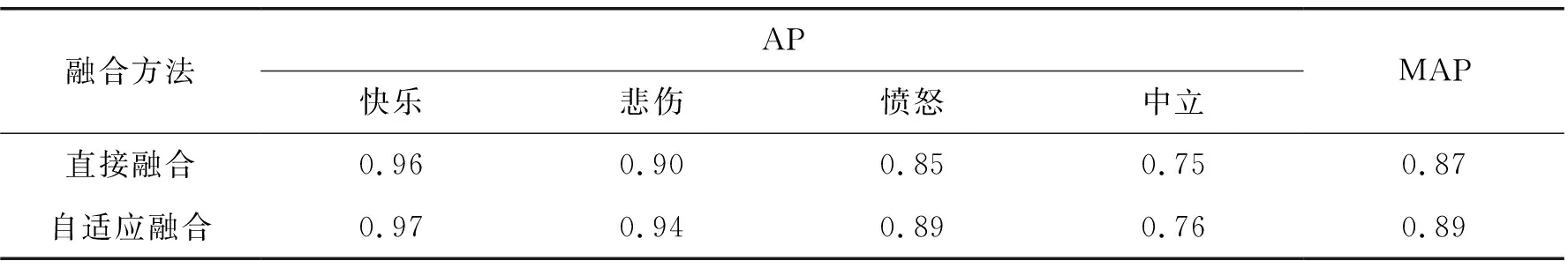

为了验证自适应融合特征方式的效果,设计了对比实验二。该实验使用骨骼旋转特征与时空特征的自适应融合方式与直接拼接的融合方式得出的分类结果进行对比。

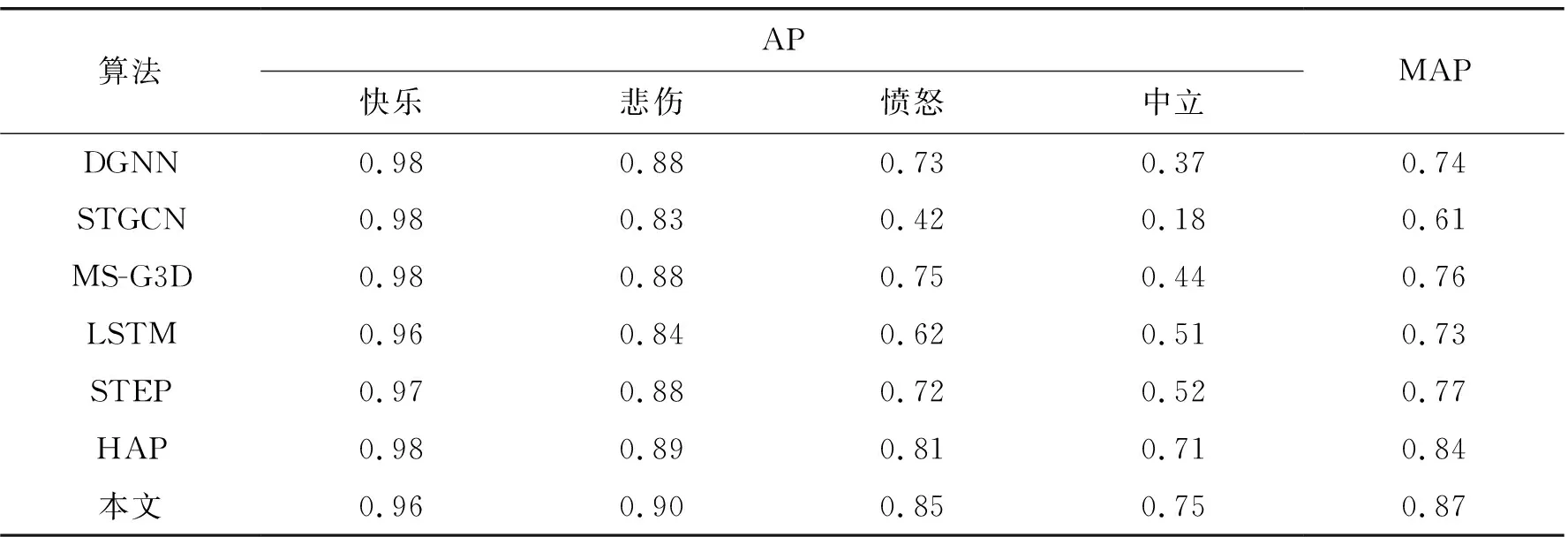

3.2.1 融合特征对比

为了证明方法的有效性,选择可用于步态情绪识别的主流方法参与对比,这些方法包括:1)STGCN[12]、DGNN[26]、MS-G3D[27]等动作识别的方法;2)从基于LSTM的网络提取步态特征,融合姿态情感特征后进行分类的方法;3)基于时空图卷积神经网络的STEP方法;4)使用半监督网络(HAP)的方法。实验结果如表1所示。对于悲伤、愤怒、中立的情绪识别,本文使用骨骼旋转特征和时空特征直接拼接的方法的识别精度比对比算法分别提升了1、4、4个百分点,平均精确度提升了3个百分点。

表1 融合特征对比Tab. 1 Comparison of the fusion features

3.2.2 融合方式对比

为了验证自适应的融合方式能有效提升情绪识别的精确度,本文设置了一组消融实验,即直接融合方式与自适应网络融合方式的对比,结果如表2所示。由表2可知,对于快乐、悲伤、愤怒和中立的识别,自适应网络融合方式的识别精确度比直接融合分别提升了1、4、4、1个百分点,平均精确度提升了2个百分点。

表2 融合方式对比Tab. 2 Comparison of fusion methods

3.3 指标评估与分析

为分析每个分类指标的效果,本文把每类情绪分类结果的AP值进行对比,实验表明,本文方法的平均精确度比HAP方法提升了5个百分点,悲伤、愤怒和中立的精确度分别提升了5、8、5个百分点。HAP方法虽然能利用骨骼间的旋转特征,但是却忽略了人体三维时空信息,本文提取时空信息时采用ST-GCN网络结构,与LSTM等传统网络提取时序特征方法不同的是,ST-GCN在时间维度上提取相邻节点信息对空间临边和时间临边进行训练,所以ST-GCN 能对局部的动作、时空信息进行更好的分析。 利用HAP模型的编码器提取的骨骼旋转信息与ST-GCN提取的时序信息直接拼接,实验结果显示悲伤、愤怒和中立的平均精确度会明显提升(见表1)。

在特征进行融合时,直接拼接往往无法达到最佳融合状态。实验表明,利用自适应网络对特征进行融合,模型识别情绪的精确度能进一步提升(见表2)。其原因是利用自适应融合网络,能对时空特征与骨骼旋转特征自动调节融合权重比例,进而达到最佳融合效果。

4 结语

本文利用骨骼旋转信息与具有时空特征的深度信息自适应融合进行情绪识别,取得了不错的效果,但也有一些局限性。如:本文目前只考虑人的离散情绪,未来可考虑把情绪引入到连续的VAD[28]模型中;本文网络只是基于步态信息感知情绪,未来计划将步态特征与语音、面部表情、文字等多模态信息[29]结合,探索鲁棒性更强、更精确的情绪感知方法;在有遮挡的情况下,数据缺失、模型识别准确度不佳,未来可尝试加入GAN网络对缺失数据进行恢复[30]。