人工智能课程中表现性评价的设计与应用*

2022-05-20詹泽慧姚佳静吴倩意黄秉刚

詹泽慧 姚佳静 吴倩意 黄秉刚

人工智能课程中表现性评价的设计与应用*

詹泽慧1姚佳静2吴倩意1黄秉刚3

(1.华南师范大学,教育信息技术学院,广东广州 510631;2.深圳市盐田区实验学校,广东深圳 518083;3.深圳龙华未来教育研究院,广东深圳 518126)

在国家政策积极鼓励人工智能教育、核心素养导向驱动课堂评价变革的大背景下,如何在人工智能课程中开展表现性评价成为了重要的研究议题。文章首先分析了表现性评价应用于人工智能课程的适切性;随后提出了“教—学—评”一体化的设计理念,构建了“目标—任务—评价”三步走的设计流程,并归纳了五种典型的表现性评价方式;最后,文章以H中学为例在人工智能课程中进行了表现性评价的应用,发现表现性评价可从不同角度进行评判和反馈,但在使用表现性评价量表的过程中也存在内容设计、计分方式、使用方式等方面的问题。在人工智能课程中开展表现性评价,推动以评定教、以评促学,有助于学生高阶能力的形成,是智能化时代创新人才培养的有效途径。

人工智能课程;表现性评价;核心素养;编程作品

一 问题的提出

在人工智能时代,世界各国意识到了掌握先进技术和培养创新人才的重要性,纷纷重视发展人工智能教育。2016年,美国先后发布《为人工智能的未来做好准备》《国家人工智能研发战略规划》,为人工智能的发展制定策略、规划方向。紧追其后,英国发布《人工智能:未来决策制定的机遇与影响》,法国制定《国家人工智能战略》,日本提出《超智能社会5.0战略》,均强调人工智能对未来综合国力的影响,并明确了迎接人工智能时代的积极态度。2017年,我国印发《新一代人工智能发展规划》,号召各类学校逐步新增人工智能课程,建设全国人才梯队,同年发布高中信息技术课程标准,将“人工智能初步”确定为选择性必修课程。2020年,五套《人工智能初步》高中新课标教材陆续出版[1],人工智能教育逐渐在中小学课堂普及。

然而,在人工智能教育实践中,一线教师普遍反映最为棘手的问题是在教学过程中如何实施评价。在新一轮课程改革中,评价方式的改革问题引发了大量讨论:单一关注学生考试成绩的传统评价方法受到诟病,而以学习过程中学生外化表现为度量的表现性评价成为关注的焦点。一方面,表现性评价将学习表现作为评价依据,能比测验考试获得更全面、更客观的评价结果,且更适合用来评价“做”的能力,契合人工智能教育面向高阶能力和综合素养培养的目标。另一方面,表现性评价具有指导性,可融入教学过程作为支架,促进教与学。对教师来说,合理运用表现性评价有助于其判断学生在课程中的学习状态,确定学生是否适合继续学习特定的内容,并据此调整教学目标和进度。而对学生来说,表现性评价提供了明确的表现性任务,学生在完成任务的过程中可以根据每个节点或基本要素的评价标准来了解学习目标、评估自身表现水平,促进自我反思、监控、调节和管理,故有助于学生合理把握学习节奏,促进元认知发展。

在智能时代呼唤创新人才、国家政策积极鼓励人工智能教育、核心素养导向驱动课堂评价体系变革等大背景下,证据导向的人工智能课程表现性评价亟待开展。表现性评价在当前可行而未畅行的原因主要在于:一线教师对人工智能课程中设计和有效实施表现性评价的方法还不甚了解。鉴于此,本研究尝试从适切性、设计方法、应用模式三方面讨论如何将表现性评价应用于人工智能课程,实现教、学、评的一体化,以达到培养学生综合素养和高阶思维的目的。

二 表现性评价应用于人工智能课程的适切性分析

1 表现性评价的发展历程与既定规范

表现性评价是一种以证据为导向、同时兼顾过程与结果、以评促教的评价方式,其基本假设是:任何一种行为和认知表现都可以分解为一系列基本要素,作为表征学业水平的证据;只要对各要素进行合理评价,就可以对总体水平进行准确评定[2]。表现性评价的发展历程可追溯至古代中国和中世纪欧洲,其基本形态曾见于各级各类人才选拔。然而从20世纪起,在第一次工业革命引发的“机械化”浪潮席卷下,标准化纸笔测验成为了风靡全球的主流评价手段。20世纪80年代,人们意识到标准化纸笔测验重识记轻发散、重结果轻过程、仅强调唯一正确答案的做法不利于甄选创新人才,转而开始关注适用于评估问题解决、沟通合作和批判性思维等高阶能力的表现性评价[3]。21世纪以来,各类智能技术赋能于创新人才培养的战略需求,让表现性评价在评估学生高阶能力方面的优势日益凸显,成为人才评价的重要形式。英国是最早将表现性评价作为高校录取依据的国家:在日常教学中由学科教师以中心评审课程作业的形式(如实验报告、实地调查报告、研究论文等)开展,依据全国性大学入学考试机构统一制定的评分标准打分。美国、日本在高利害考试和学习质量监控项目命题中嵌入具有真实情境的表现性评价,也取得了良好效果[4]。我国的表现性评价应用起步较晚,直至本世纪初才逐步见于学科教学[5]。

在表现性评价应用和发展的过程中,已形成了既定的规范。表现性评价的设计,离不开评价目标的确定、表现性任务的设计和评分规则的建构[6]。评价目标直接反映表现性评价的“教育性”,是表现性任务和评分规则的基础。由于表现性评价注重评价内容,而对评价过程没有统一要求,故容易造成其信度低于标准化纸笔测验的情况。为了避免主观性、提升评价结果的参考价值,必须制定清晰的评价标准加以规约。高质量的评价标准需具备以下特征:①内容清晰、表述准确,即使用者能看懂且认同评价标准的相关内容、评价标准的内容避免存在歧义,师生均能根据描述明确与之对应的结果;②便于理解、易于操作,即师生能够快速理解评价标准的正确用法,并在教学过程中快速上手操作。在具体实施过程中,应注意:①落实评分规则的测量功能。指向行为的规则描述应有制约的前提和限定因素,并对行为结果进行量化表达,形成具体可行的评价标准条目,保证信度和个体公平。②发挥评分规则的导向作用。评价标准应始终围绕教学目标展开,可将目标分解为层次化的评价要素,通过学习支架将评价嵌入教学过程中,评分规则可调控教学,并能向学生反馈有意义的信息。

2 表现性评价应用于人工智能课程的适切性

人工智能课程具有区别于其他课程的独特性:在内容上,主要涉及人工智能的发展史、核心算法与编程、系统设计开发、典型应用、伦理道德等;在形式上,项目实践和动手操作是其中必不可少的部分,需配置软硬件设备,而受限于人多、设备少等问题,协作式项目实践是课程的常态[7]。表现性评价在人工智能课程应用的适切性主要体现在四个方面:①评价目标的适切性。人工智能课程面向科技创新人才培养,最终指向学生核心素养,而非仅仅停留在评估知识技能的习得情况,与表现性评价指向高阶能力培养的目标相吻合。②评价形式的适切性。人工智能课程本质上是一种基于真实问题/任务的学习,具有较强的情境依赖性,这与表现性评价通过表现性任务反映行为表现水平在形式上高度一致。③评价载体的适切性。人工智能课程通常涉及学生设计能力和动手操作能力的培养,这些能力可通过作品创作、创意物化的方式得到较好的反映,这也正是应用表现性评价的优势之所在。④多元融合的适切性。人工智能技术在各行业具有广泛的普适性和可嵌入性,人工智能课程也具有多学科融合性,可作为整合性学习的载体,在评价上亦需考虑多个学科的评价目标,这与表现性评价要素多元、层次丰富、操作灵活的特性相匹配。综上所述,表现性评价在人工智能课程中具有较好的适用性和可拓展性。

三 人工智能课程表现性评价的设计方法

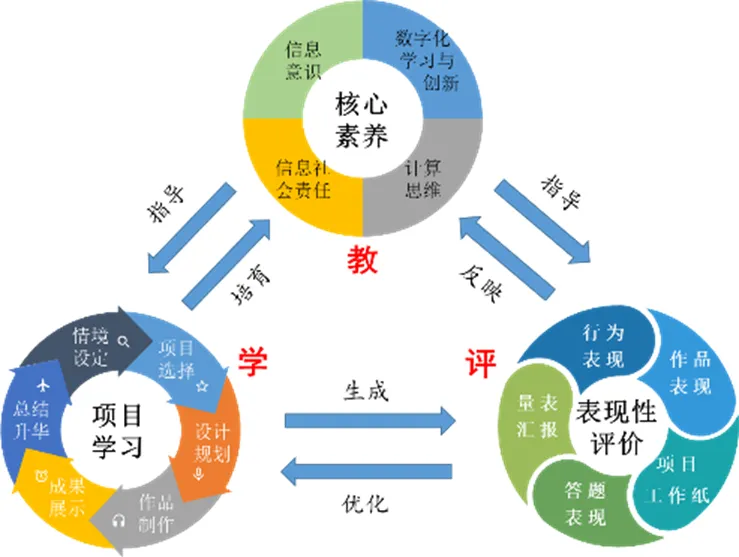

1 设计理念:“教—学—评”一体化

目前,人工智能课程在表现性评价方面尚缺乏经验积累,评什么、怎么评等问题都值得深思。本研究遵循“教—学—评”一体化的设计理念(如图1所示),提出了一套可行的人工智能课程表现性评价方法:将评价与教学活动相融合,学生在评价过程中获得指导,教师可根据评价结果调整教学方案。在“教—学—评”一体化的设计理念中,核心素养、项目学习、表现性评价三者相辅相成、动态呼应:以核心素养为核心的教学目标指导项目学习和表现性评价的进行,而项目学习的过程与产出是表现性评价的对象和载体;表现性评价可基于课堂行为、项目作品(如编程代码、人工智能产品等)、项目工作纸或过程性文档、量表等进行;开展依托表现性评价生成的反思、监控等元认知活动,可以同步优化整个项目学习的效果。

图1 “教—学—评”一体化的设计理念

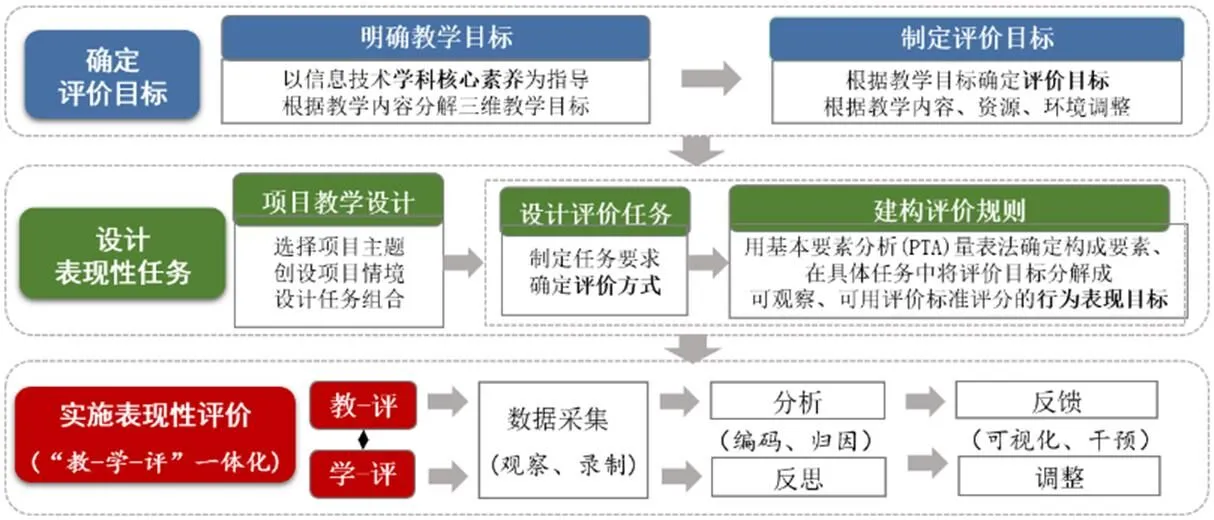

图2 人工智能课程表现性评价的设计流程

2 设计流程:“目标—任务—评价”三步走

人工智能课程表现性评价的设计流程可归纳为三个步骤,如图2所示。

(1)确定评价目标

清晰易懂的评价目标,既是设计表现性任务和落实评分规则的依据与基础,也是整个教学活动的指挥棒。一般来说,确定评价目标的方法有两种[8]:一是“自上而下”基于课程标准或其他顶层设计文件确定评价目标的标准化形式,多用于日常教学;二是“自下而上”基于特定的教学内容确定评价目标的定制化形式,可用于校本特色课程。由于人工智能课程属于信息技术学科,故首先要以信息技术学科核心素养为指引,根据各阶段教学内容制定具体的三维目标(即知识与技能目标、过程与方法目标、情感态度与价值观目标),将抽象的素养标的在知识技能和情感三个维度上进行具体描述;继而要根据三维教学目标确定相应的评价目标(如应该知道的、能够做到的、应该发展的),为后续设计表现性任务、实施表现性评价提供方向性指引。值得一提的是,近期已有国内几份顶层设计文件(如中央电化教育馆组织编制的《中小学人工智能技术与素养框架》、中国教育学会中小学信息技术教育专业委员会组织编制的《中小学人工智能课程开发标准(试行)》等)针对我国的具体国情,对基础教育各学段学生需掌握的学习内容和能力水平进行了界定。在评价目标制定的过程中,应参考顶层设计文件中已有的设计进行细化,根据学科关键能力的阶段水平和课程内容模块对应的能力达成水平确定评价内容和评价维度。

(2)设计表现性任务

表现性任务是指教师根据教学方案设计具体情境下的教学项目及任务。根据表现性评价在使用过程中所受制约程度的不同,可将表现性任务分为受限的任务和发散的任务——受限程度越高,越适合考察概念性的知识;受限程度越低,则越适合观察学生的直接表现和综合能力。在教学活动中,比较常见的表现性任务有纸笔任务、示范展示、实验调查、口头表达与戏剧表演、项目学习。表现性任务的设计可按照以下流程进行:首先,根据教学目标,选择合适的项目主题、创设情境,设计大单元教学中的任务组合[9]。然后,根据具体教学内容和评价目标设计评价任务,包括制定任务要求、编写清晰明确的任务指导语、根据实际情况确定可行的评价方式。最后,构建评价规则,在具体任务中将评价目标分解成可观察、可评分的行为表现目标。由于人工智能课程通常以项目式、协作式的形式进行,所以评分规则需考虑个体评价和集体评价两种类型:个体评价的评分规则指向个体行为表现,既可以针对学生表现的整体情况进行总结性评分,又可以采用分项评分规则对包含若干重要要素的、较为复杂的表现进行量化;而集体评分指向团队/协作小组/班级,通常针对某一集体产出(如小组作品、集体完成的方案文档、组装好的智能套件等)进行评价。借助核对表、表现清单、等级评价量表和基本要素分析量表确定评价构成要素后,需进一步将具体任务中的评价目标分解成可观察、可用评价标准评分的具体表现目标,为评价的实施做好准备。

(3)实施表现性评价

表现性评价的实施需与教学过程/项目实施过程相结合,根据所选的评价方式确定数据采集方式(如录像、问卷、观察记录等)。分析得到评价结果后,教师应及时做归因处理,以合理的方式将评价结果反馈给学生,并适当进行教学干预;学生应在教师的引导下积极反思,调整自己的学习状态和策略。评价的实施应遵循以下两个原则:①全面性。评价标准要覆盖所有学生所能达到的水平,要对不同维度的表现进行差异化描述,并在实施评价时关注和凸显不同维度的差异。②准确性。评价标准对于每个维度及其每个评价指标的描述都要清晰、准确,要能够区分不同程度的行为表现,让评价者能够根据评价标准了解到评什么、如何评。同时,要让学生能够意识到自己现有水平与更高水平之间的差距,以引导其更好地发展。例如,在对学生的编程思路进行评价时,可区分出三个不同的水平:①不能在任务单上写出编程思路;②能在任务单上写出编程思路;③能在任务单上用系统化的方法写出编程思路。这三个水平依次提高,有助于学生认识到自己需要用系统化的方法来思考、理顺编程思路。

3 评价方式:多元化

人工智能课程中的表现性评价可分为行为类、作品类、工作纸类、试题类、量表类等五种类型,这五类表现性评价方式的对比如表1所示。

表1 五类表现性评价方式的对比

(1)基于行为的评价

人工智能教育注重实践,倾向于开展伴随性、过程性的评价,可通过观察和分析外显行为来评估学生的高阶能力[10]。基于行为的评价主要对课堂交互行为、编程任务表现进行采集和编码实现,主要有三种类型:①师生或生生互动分析。例如,顾小清等[11]设计了基于信息技术的互动分析编码系统,形成互动分析编码表,每3秒进行一次行为编码,并通过滞后序列分析形成行为序列;Zhan等[12]设计了智慧教室师生互动编码系统,纳入了言语行为、动作行为、教师驱动、学生主动等维度,可分析“主导—主体”的互动程度。②论坛上的话语分析,如在线讨论的话语分析[13],这种形式主要适用于混合式教学,需有在线平台的支持。③人工智能项目开发过程的行为表现分析。例如,美国加州大学基于Alice平台开发了The Fairy Assessment,其通过让用户在三个不同难度的评价任务中调试和修正程序故障来评测其问题解决能力[14]。

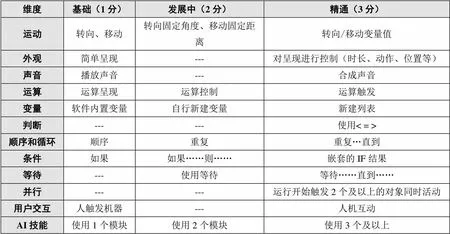

表2 编程作品评分表

(2)基于作品的评价

基于开放性作业来评价学生的综合表现,是作品分析法的一种。Seiter等[15]设计了计算思维理解与评价进阶(Progression of Early Computational Thinking,PECT)模型,用于对小学生的计算思维进行测评:假定小学生能够设计、实施特定任务的程序,将其行为按照“计算思维概念—设计模式变量—证据变量”三个抽象程度依次递减的层次进行分类,将Scratch代码作为具体活动可操作的证据变量进行评分。目前应用最广泛的图形化编程作品评价工具是Dr. Scratch,此工具通过观察编程作品中程序的抽象性、数据表示、空间调控、逻辑性、并行性、触发、同步性七个子维度对计算思维进行评价。但是,本研究使用的平台是科大讯飞的畅言智AI平台,与Dr. Scratch不兼容。考虑到这一问题在其他研究中也可能存在,故本研究借鉴Dr. Scratch的基本评分准则,设计了包含运动、外观、声音等12个维度的编程作品评分表,如表2所示。

(3)基于项目工作纸的评价

项目工作纸即任务单,实际上是一种过程性文档,同时也是表现性评价的重要资源,但目前其重要性尚未得到足够重视。若设计或应用方式不当、项目工作纸完成度低,则会导致数据缺失值过多而难以分析。现有文献对项目工作纸的评价大多以完成度为标准,也有少数将过程文档中的思维导图作为分析对象。例如,根据思维导图规则,从重点突出、发挥联想、构图清晰、个人风格、整体布局五个维度出发,按照发展级、完成级、示范级三个等级进行评分[16]。

(4)基于试题的评价

试题类评价是传统评价常用的手段,主要用于考察概念原理的理解或知识技能的掌握。例如,Witherspoon等[17]针对机器人编程开发了三个系列的知识和概念评估工具,每个系列有17个结构类似的问题,可评估学生对计算原理(如迭代算法、布尔逻辑)的理解;Román-González等[18]开发的计算思维测试(Computational Thinking Test,CTt)将封闭性题目以画布形式呈现,测量思维逻辑和编程技能;Dagiene等[19]开发的百博思测试(Bebras Tasks)面向实际生活问题情境,通过分层任务测量计算思维水平。除了测试成绩,基于试题的表现性评价还考察学生的答题表现,如正确率、作答时间、眼动和脑电状态等。

(5)基于量表的评价

量表类的评价简单、易操作,常被用于评价参与者的情感态度或思维能力[20]。例如,Korkmaz等[21]编制了计算思维量表(Computational Thinking Scales,CTS),含有创造力、算法思维、协作、批判性思维、问题解决等五个维度,在人工智能课程中使用广泛;Kukul等[22]编制了计算思维自我效能感评价量表(Computational Thinking Self -Efficacy Scale,CTSES),用于学习者的自我评估。需注意的是,量表评价级数设计最好控制在五级以内,因为级数过多易加重学生的认知负荷,评价结果的准确率也会受到影响。

四 人工智能课程表现性评价的应用案例

为探索表现性评价应用于人工智能课程的可行性和有效性,本研究依托广州市H中学的人工智能课程开展教学实验。上课地点安排在该校的人工智能教室,教学环境包括1台电视、1个智能音箱、2块电子白板、10台平板电脑、10个小飞机器人、24张可移动学习桌和其他智能设备。其中,小飞机器人可通过语音、屏幕与学生交互,也可通过编程被赋予专属功能。实验对象为该校的24名初中生,实验为期6周、每周2个课时,共12个课时。

1 确定评价目标

本案例采用自上而下的目标设计方法。由于当时义务教育的课程标准尚未发布,故本案例的评价设计主要参考了中华人民共和国教育部制定、人民教育出版社出版的《普通高中信息技术课程标准(2017年版,2020年修订)》,结合课程内容和学情(课程是入门课、学生均是初学者),确定了提升学生人工智能学习兴趣、计算思维、人工智能知识技能三个方面的评价目标。

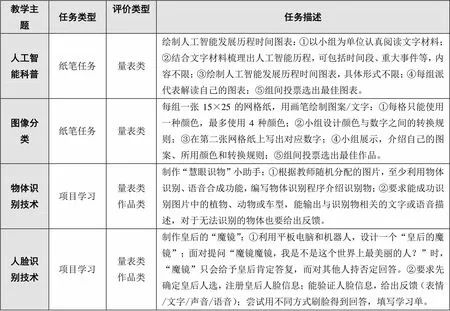

2 设计表现性评价任务

根据人工智能课程的教学内容,综合考虑H中学的教研需求、软硬件设备、课时条件等情况,本案例采用作品类、量表类表现评价方式,设计了4个表现性评价任务,如表3所示。

表3 人工智能课程的表现性评价任务设计

3 实施评价

(1)“教—学—评”一体化过程

第一阶段(即人工智能科普)通过课程讲授、讨论和小组活动,引导学生了解人工智能的定义、特点、应用以及发展历程,并理解为什么“人工智能是打开未来的钥匙”:首先,通过观看“音控机器人”提出问题“什么是人工智能”,引导学生发表看法;再通过“科幻电影中的AI”“实验室中的AI”“家人眼中的AI”三个视频,引出对“人工智能”的科学定义。接着,通过展示无人机的送货过程,请学生思考人工智能需要模拟人类的哪些能力,填写任务单。然后,发放阅读材料,请学生自行绘制人工智能发展历程图;在学生完成表现性任务期间,教师从旁辅助指导,但不妨碍学生的思路和想法,完成任务后请各组代表分享制作思路,解读发展历程图。最后,教师通过抢答的形式回顾全课要点,并在课后发放表现性评价量表让学生自评。

第二阶段(即图像分类)和第三阶段(即物体识别)涉及特征提取、卷积运算等原理知识,兼具理论难度和动手实操性。其中,第二阶段通过绘制有转换规则的图案、使用实验平台体验图像特征提取这两个任务来组织教学;而第三阶段通过课程讲授和操作,引导学生学习物体识别技术。课前,教师将设计好的表现性任务单和表现性评价量表发给学生,鼓励学生事先浏览量表,并告知学生在课内需完成自评和组员互评。课上,教师首先重申量表的使用方法和重要性,并择要讲解评价目标;接着,教师演示使用机器人识别稀有动物,引入学习主题,并指定教室内任一物体,让学生探究物体识别的过程;然后,布置“慧眼识物小助手”任务,让学生通过编程解决实际问题,并在学生自主探究的过程中提供辅助指导,当学生遇到问题时提醒其根据量表和任务单来思考;最后,通过介绍物体识别在生活中的系列应用总结课堂内容。

第四阶段(即人脸识别)介绍人脸识别技术的概念,引导学生思考技术的适用场景(如刷脸支付、进站等)、讨论影响识别率的因素,以理解原理和技术的局限性。课前,教师发放表现性任务单和表现性评价量表。课上,教师通过探究实验让学生体验人脸识别流程;布置“皇后的魔镜”任务让学生配对编程,当学生遇到问题时提醒其根据任务单和量表来思考。在完成“皇后的魔镜”这个任务的过程中,学生会经历“确定皇后(变量)→回顾人脸识别流程(运用已学知识)→验证人脸信息(合作编程)→给出适当反馈”的学习环节。

(2)基于编程作品的评价案例

本研究选取两份较有代表性的编程作品进行打分,以说明编程作品评分表的具体使用方法。图3作品的总分为23分:学生新建一个变量“皇后”,得2分;使用两次简单的文字呈现功能“显示你是最美丽的皇后在屏幕中”和“显示你比我还丑在屏幕中”,得2分;使用三次合成声音,得9分;使用等待功能“等待1秒”,得2分;使用两次运动功能,分别涉及转向固定角度和移动固定距离,得4分;使用条件结构,得2分;使用两个AI技能模块,得2分。图4作品的总分为18分:学生新建一个变量“皇后”,得2分;使用两次简单的文字呈现功能,得2分;使用两次合成声音,得6分;使用条件结构,得2分;设置两个并行程序,得3分;使用五个AI技能模块,得3分。对比这两份编程作品可以发现:图3作品的程序功能简单但丰富,编程量大,加入了创意想法,让整个作品更生动、有趣;而图4作品的程序较多地使用了高级功能,在保证功能实现的基础上又能保持代码简洁明了。这两份都是优秀作品,但图3作品的创造力更强,图4作品的算法思维更佳——这就是表现性评价的意义,可从不同角度进行评判和反馈。

图3 学生编程作品一

图4 学生编程作品二

4 问题反思

本案例采用“量表+作品”的方式在人工智能课程中开展表现性评价,期间发现存在以下问题:①量表的内容问题。在实施评价初期,学生填写表现性评价量表的积极性不高,原因主要在于量表的内容描述过于专业,学生对晦涩难懂的评价指标容易产生抵触情绪;另外,教师没有强调正确填写量表的重要性,故学生并未认识到量表的价值。②量表的计分方式问题。实施评价的前期采取自评方式,但通过访谈发现学生并不认可自评的客观性。因此,第三阶段将评价计分改为“40%师评+30%自评+30%互评”的三方评价方式,这一改变得到了学生的认可;第四阶段则进一步加入了编程作品的评价,与三方评价结果进行加权,使评价结果更加客观,同时也提高了评价的“教育性”。③量表的使用方式问题。在实施评价之初,第一阶段于课后发放量表,引导学生回顾课堂表现、发现不足并有意识地改正。然而,学生难免有惰性,不喜欢占用课后时间,故能够认真反思的学生少之又少。因此,第二阶段于课前发放量表,将表现性评价作为学生课堂表现的自我监控工具和学习支架,引导学生在课堂上参考量表内容调整自身行为。对比两类做法可以发现:课前发放量表并将其作为学习支架融入教学过程取得的效果更好。

五 结语

教学高效,评价先行。立足国家人工智能教育战略,实施表现性评价对于创新人才的高阶能力培养有重要价值。在人工智能课程中实施表现性评价时,教师应尽量使用伴随性评价方式、采用多元计分法,强调并适时引导学生在项目执行过程中利用好表现性评价工具,以更好地发挥表现性评价的教学价值。长此以往,学生的元认知能力将得到发展,以评定教、以评促学的目的也将达成。随着智能化技术的发展,智能化、伴随性的表现性评价有望成为课堂教学的新形态,并实现人工智能技术与人工智能教育的双向赋能。

[1][7]詹泽慧,钟柏昌.高中人工智能教育应该教什么和如何教——基于四本《人工智能初步》教材的内容分析[J].电化教育研究,2020,(6):68-74、82.

[2]Walvoord E, Anderson J. Effective grading: A tool for learning and assessment[J]. Academic Standards, 1998:1-16.

[3]周文叶,陈铭洲.指向核心素养的表现性评价[J].课程·教材·教法,2017,(9):36-43.

[4]Meisels S J, Xue Y, Bickel D P, et al. Parental reactions to authentic performance assessment[J]. Educational Assessment, 2001,(1):61-85.

[5]罗平,李辉.基于思维建模的小学英语多媒体表现性评价的设计和实施[J].教育测量与评价,2017,(10):28-34.

[6]Stiggins R J. NCME instructional module on design and development of performance assessments[J]. Educational Measurement Issues & Practice, 1987,(3):33-42.

[8]崔允漷.课程实施的新取向:基于课程标准的教学[J].教育研究,2009,(1):74-79、110.

[9]詹泽慧.计算机基础课程中的组合式任务驱动教学设计[J].中国教育信息化,2011,(7):63-65.

[10]刘娇,李建生.计算思维的评估方法及应用案例研究[J].现代教育技术,2019,(10):94-99.

[11]顾小清,王炜.支持教师专业发展的课堂分析技术新探索[J].中国电化教育,2004,(7):18-21.

[12]Zhan Z, Wu Q, Lin Z, et al. Smart classroom environments affect teacher-student interaction: Evidence from a behavioural sequence analysis[J]. Australasian Journal of Educational Technology, 2021,(2):96-109.

[13]Zhan Z, Fong P S W, Mei H, et al. Effects of gender grouping on students’ group performance, individual achievements and attitudes in CSCL[J]. Computers in Human Behavior, 2015,(48),587-596.

[14]Werner L, Denner J, Campe S. The fairy performance assessment: Measuring computational thinking in middle school[A]. Proceedings of the 43rd ACM Technical Symposium on Computer Science Education[C]. New York: Association for Computing Machinery, 2012:215-220.

[15]Seiter L, Foreman B. Modeling the learning progressions of computational thinking of primary grade students[A]. Proceedings of 9thAnnual International ACM Conference on International Computing Education Research[C]. New York, USA: ACM, 2013:59-66.

[16](英)托尼·博赞著,李斯译.思维导图——放射性思维[M].北京:世界图书出版公司,2004:24.

[17]Witherspoon E B, Higashi R M, Schunn C D, et al. Developing computational thinking through a virtual robotics programming curriculum[J]. ACM Transactions on Computing Education (TOCE), 2017,(1):1-20.

[18]Román-González M, Pérez-González J C, Jiménez-Fernández C. Which cognitive abilities underlie computational thinking? Criterion validity of the computational thinking test[J]. Computers in Human Behavior, 2016:678-691.

[19]Dagiene V, Futschek G. Bebras international contest on informatics and computer literacy: Criteria for good tasks[A]. International Conference on Informatics in Secondary Schools[C]. Berlin, Heidelberg: Springer, 2008:19-30.

[20]Kong S C, Chiu M M, Lai M. A study of primary school students’ interest, collaboration attitude, and programming empowerment in computational thinking education[J]. Computers & Education, 2018,127:178-189.

[21]Korkmaz Ö, Çakir R, Özden M Y. A validity and reliability study of the computational thinking scales (CTS)[J]. Computers in Human Behavior, 2017,72:558-569.

[22]Kukul V, Karatas S. Computational thinking self-efficacy scale: Development, validity and reliability[J]. Informatics in Education, 2019,(1):151-164.

The Design and Application of Performance Evaluation in Artificial Intelligence Courses

ZHAN Ze-hui1YAO Jia-jing2WU Qian-yi1HUANG Bing-gang3

Under the background that national policies actively encourage artificial intelligence education and core literacy orientation drives the reform of classroom evaluation, how to carry out performance evaluation in artificial intelligence courses has become an important research topic. Firstly, this paper analyzed the suitability of performance evaluation applied in artificial intelligence courses. Then, the integrated design concept of “teaching-learning- evaluation” was put forward, and a three-step design process of “objective-task-implementation” was constructed. Meanwhile, five typical performance evaluation methods were summarized. Finally, this paper took an artificial intelligence course in H Middle School as an example to carry out the application of performance evaluation. It was found that performance evaluation could evaluate and give feedback from different angles, and there were problems in content design, scoring methods, and usage methods during the process of using performance evaluation scales. Carrying out performance evaluation in artificial intelligence courses to promote teaching by evaluation and promote learning by evaluation was conducive to the formation of students’ high-level ability and was an effective way to cultivate innovative talents in the intelligence era.

artificial intelligence course; performance evaluation; core literacy; programming work

G40-057

A

1009—8097(2022)05—0032—10

10.3969/j.issn.1009-8097.2022.05.004

基金项目:本文为广东省教育厅重大基础研究与应用研究项目“基于学科模型的创新能力培养信息化平台设计与应用”(项目编号:#2017WZDXM004)、华南师范大学哲学社会科学重大培育项目“面向创新能力培养的跨学科组合策略与应用效果研究”(项目编号:ZDPY2208)的阶段性研究成果。

詹泽慧,教授,博士,研究方向为STEAM教育、学习分析与智慧教育,邮箱为zhanzehui@m.scnu.edu.cn。

2021年12月31日

编辑:小米