3D视觉表面匹配技术在曲轴毛坯无序抓取中的应用

2022-05-13陆贤辉申红森

陆贤辉 申红森

摘 要:本文主要研究对无序排列曲轴毛坯的自动抓取,通过3D视觉技术实现空间位置搜索,并转换为机器人抓取坐标,在实际运行过程中,为解决3D算法在速度、可靠性、稳定性等方面的不足,视觉识别成功率低,机器人抓取发生碰撞的问题,利用全局模型局部匹配的算法优化基于PPF特征的投票原理,最终实现高效稳定的3D物体匹配识别,并实现了无序排列曲轴毛坯稳定、可靠、快速的抓取,满足了现实生产过程的需求。

关键词:3D视觉 无序抓取 Point Pair Feature (PPF) 投票原理

Abstract:This paper researched the robot loading system for the free-form crankshaft. It was applied with 3D visual camera to search the object in a big steel case, and it would communicate with the robot and sent the coordinate of the specific character in the whole crankshaft. In the practice, the paper propound a new algorithm to improve the Voting Scheme based on PPF and more efficiently matched objects in the point clouds The method was met the production requirement and achieved the stability, reliability and high efficiency in the robot loading system for the free-form crankshaft.

Key words:3D visual camera, free-form, Point Pair Feature (PPF), Voting Scheme

在工厂自动化、智能化的发展进程中,机器视觉技术扮演着一个重要的角色。而一般的2D视觉是可以用来进行工业产品的检测与定位,难以精确呈现待检测和识别的物体的三维信息,视觉工件定位与抓取技术则在工业各领域中的应用越来越广泛,特别是在一些环境恶劣、定位精度要求较高的情况下[1] [2]。在实际生产中,经常出现要求从杂乱无章的物料周转箱或料框中逐一抓取工件的情况,目标工件相互重叠、相互遮掩,对于此类应用,基于2D机器视觉的机械臂抓取技术显然无法有效地完成作业任务,然而,3D机器视觉可以很好地解决此问题[3]。本文以实现了发动机曲轴毛坯从原包装自动上线为对象,采用激光三角3D视觉相机和普通码垛机器人,辅助以自主设计开发的专用夹具,代替之前人工上料工作,取得不错的效果,完善了3D视觉算法在类似曲轴等复杂回转体零件上的应用场景,开发了面向工业应用场景的视觉操作系统,优化了视觉匹配算法模型,形成了适合于曲轴等产品的视觉标定流程。

1 项目目标和技术方案规划

1.1 项目要实现的目标

项目现场为曲轴毛坯人工上料工位,计划实现机器人自动从料框中抓取无序排列的毛坯,人工只需要将料框推到规定的范围内即可,其余动作由机器自动完成。

节拍要求为30秒/件,抓取成功率高于98%。

1.2 无序零件自动抓取动作流程设计

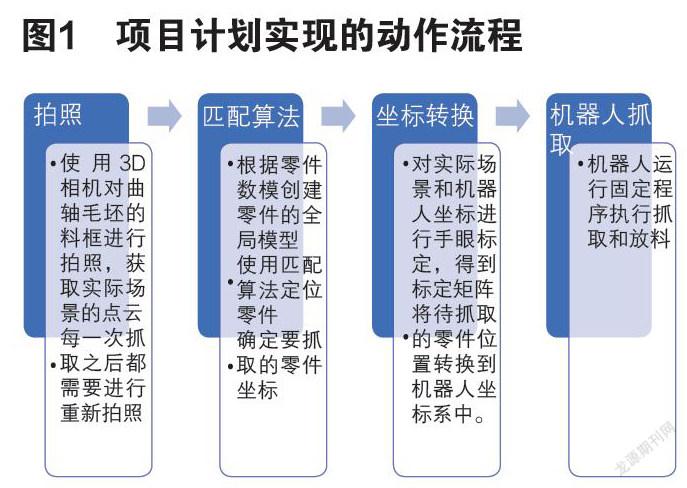

对现场使用场景进行分析,项目计划实现的动作流程如图1所示。

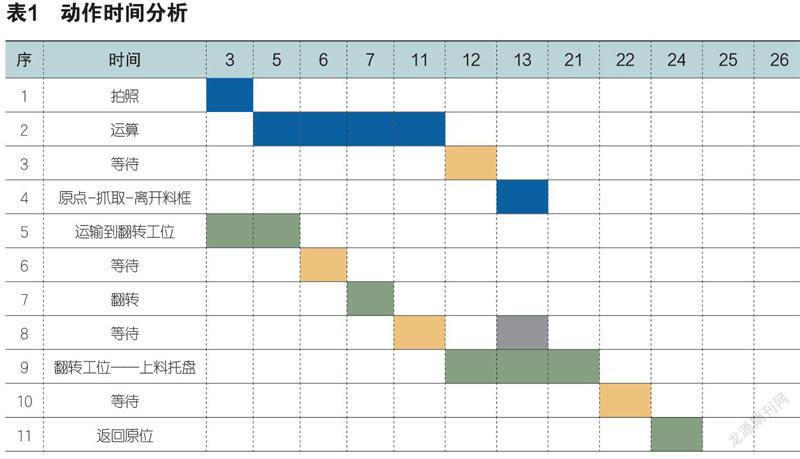

1.3 项目动作时间分析

由表1动作时间分析,可以看出整个循环在30秒也内,可以满足现场需要。

1.4 系统控制框图

项目的主要控制逻辑是机器人到达指定位置后,发信号给工控机,请求坐标信息,工控机收到请求后会调用3D相机进行拍照,并计算出待抓取零件的坐标,通过工业通讯总线反馈给机器人,机器人根据反馈的路径坐标,进行零件抓取动作,动作完成后,再次请求坐标信息。见图2系统控制框图。

1.5 相机的选择

项目测试了两种相机:

线激光扫描相机,SICK Trispector1060,采用激光三角測量法(Laser triangulation),激光光源投射到物体的表面,相机的镜头和激光成一定的角度,生成物体表面的轮廓线,物体在轮廓在激光线处通过,生成多条物体表面的轮廓线,相机将轮廓线组成一副3D的图像,3D图像是基于扫描技术,因此物体与相机必须要发生相对运动。

线激光扫描成像原理如图3所示。

优点,成像稳定,受自然光干扰少,缺点是视野小,需要移动相机扫描成像。

成像效果见图4。

RVBUST RVC-X E20, 3D工业相机采用465 nm蓝色条纹光投影光源和高分辨率传感器,通过单次快照面阵成像,不需要扫描移动机构。

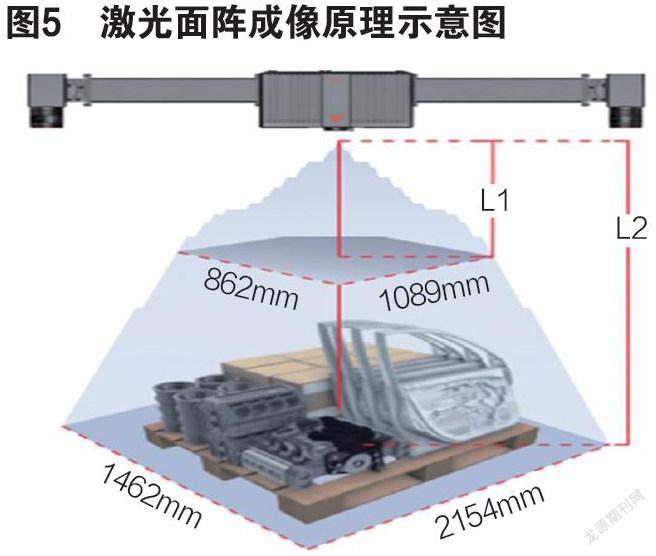

激光面阵成像原理示意见图5。

空间光源成像,无须移动相机,视野大,点云密度低,465nm为可见光源,会受到自然光干扰。

激光面阵成像效果如图6所示。

1.6 项目Demo测试平台

为了验证3D表面匹配理论、算法和机器人手眼标定程序,项目使用Trispector 1060 和UR协作机器人UR5进行测试,通过测试,发现算法的符合度可以达到使用要求。

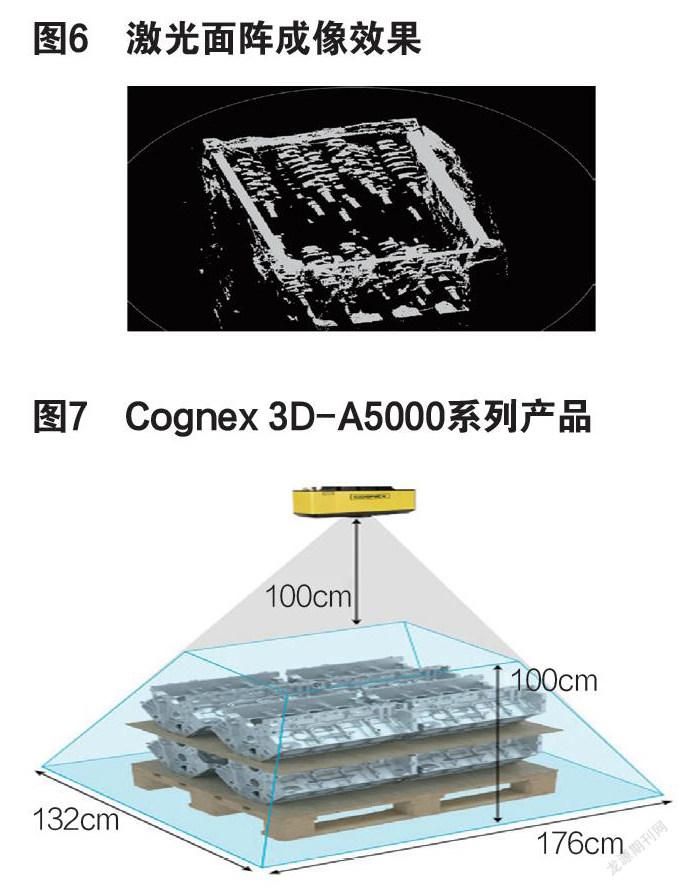

Cognex公司的3D相机3D-A5000,辐以配套软件VisionPro 的3D工具集(包括 PatMax 3D),能够解决3D定位和机器人引导,如图7Cognex 3D-A5000系列产品。

SICK公司的机器人PLB 3D定位系统,通过3D视觉方案实现三维扫描定位,通过导入零件数据模型到配套软件,实现零件的定位匹配,分析工件抓取优先级,引导机器人快速抓取工件,避开上下层工件相互干扰。系统由一台三维相机、一套零件定位软件以及相机的控制系统通信集成工具组成。该相机提供准确可靠的三维图像,受环境光影响小。

当前国内外3D产品层出不穷,而且大部分产品都是软硬件打包在一起,算法和硬件高度集成,利用通用3D相机自主算法实现的案例比较少。而自主算法实现具有更大的操作自由空间,有利于以后的产品升级和应用扩展,因此,作者带领团队通过这个项目,另辟蹊径,研究了3D视觉定位引导机器人技术,为工业领域引用3D视觉技术提供了另一种选择。

2 项目软硬件平台

2.1 项目硬件选择

结合项目节拍时间,工作场地,料框大小等因素,项目最终选定采用RVBUST RVC-X E20 3D工业相机和FANUC-2000iB/165F机器人来完成项目。

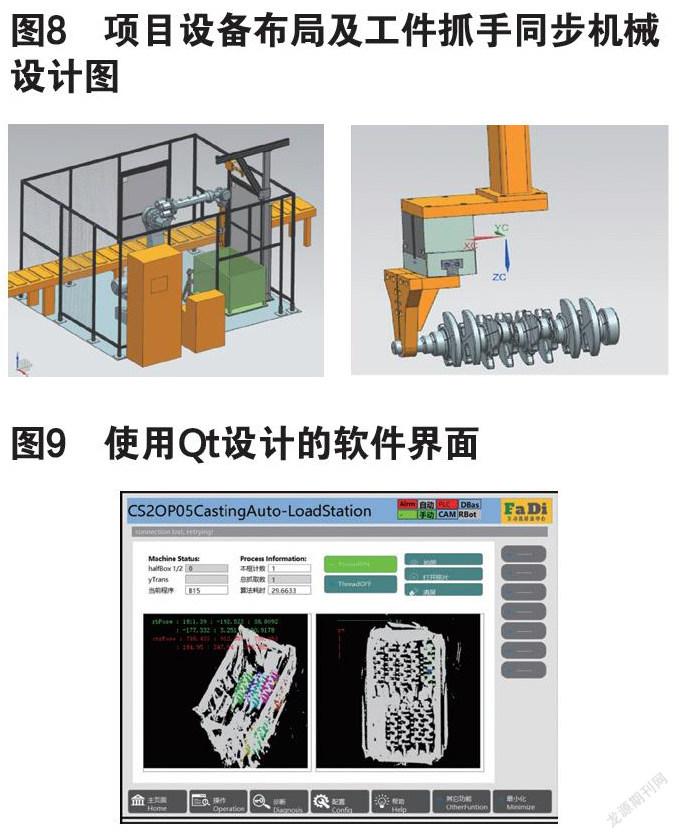

同时,也开始了设备布局及工件抓手同步机械设计,见图8所示。

2.2 项目软件平台

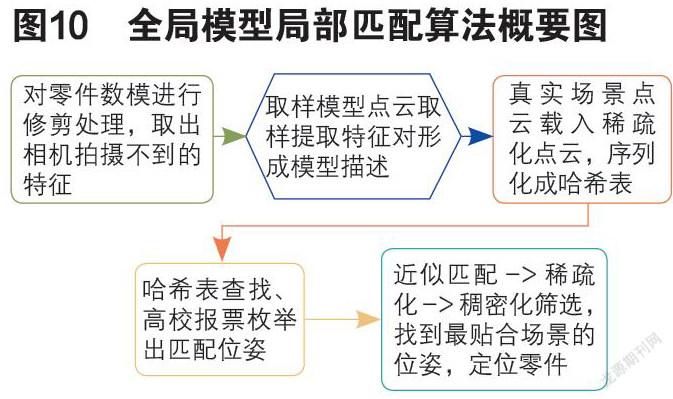

项目软件用Vs2017 community 15.9.31 编译,界面使用Qt 5.12.3 LTS设计。基于qt的软件界面设计如图9所示:

项目用到的视觉算法库有OpenCv4.30和Halcon 18.12。

3 视觉程序设计

3.1 3D表面匹配理论

3D匹配的两个对象之一是3D相机拍照获取真实零件无序堆放的场景(scene),另一个是产品零件的数模(model),这两个对象都要转化成有限的点云集合数据,通过PPF(point pair feature)算法匹配零件的位置。Lowe D G提出的SIFT算法[4]在机器视觉领域得到广泛的应用。梁元月等利用SIFT算法具有尺度不变特性而对移动、旋转、噪音、缩放和遮挡等多种图像变化都有较强的适应能力[5]。

零件的数模处理,根据零件数模,创建点云对特征的模型,通过定义Point Pair Feature(PPF 描述了两个有向点(oriented points)的相对位置和姿态)来构建特征矢量的集合以及每个特征矢量对应的点集对,构建哈希表作为模型的Global Model Description,为以后的匹配算法做准备。

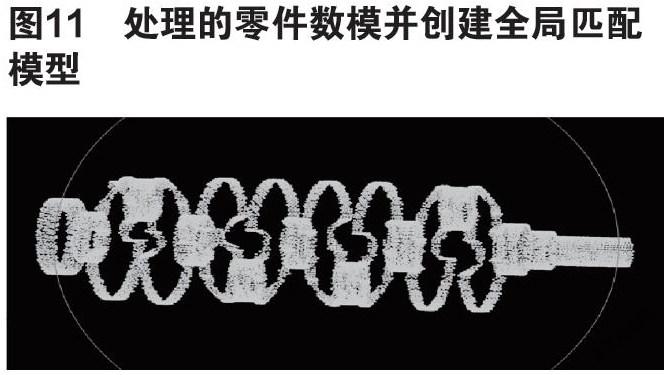

通过3D相机获得到零件(曲轴毛坯)点云(.ply格式文件)。稀疏化模型和场景以提高匹配速度,之后再采用一种高效的投票机制,在二维搜索空间里做局部匹配。这种算法既保证了识别率,也兼顾了匹配速度,算法概要见图10全局模型局部匹配算法概要图。

3.2 模型创建流程

导入零件的3D模型,因为视觉可见的为沿曲轴轴向表面,重直于轴向的表面在匹配中几乎不起作用,我们在模型预处理过程中就删除这些表面,以提高匹配的分值。

用sample_object_model_3d算子对模型进行稀疏化采样处理,以提高匹配速度,采样率越高匹配精度越高,匹配运算耗时也高。

使用surface_normals_object_model_3d 和select_points_object_model_3d算子对模型进行法向筛选,删除对匹配贡献较少的曲面。处理后的模型如图11所示。

使用create_surface_model算子创建全局模型。

3.3 表面匹配

在3D场景找到曲面模型的最佳匹配,匹配到的模型的3D位姿会赋值给Pose,它表示3D模型在坐标系中的位姿。用到的算子如下:

find_surface_model(:: SurfaceModelID,ObjectModel3D, RelSamplingDistance,KeyPointFraction, MinScore,ReturnResultHandle, GenParamName,GenParamValue : Pose, Score, SurfaceMatchingResultID)

该算子实现的过程如下:

第一步:近似匹配,在真实场景中找到模型的大概位姿。为了提高匹配速度,要对真实场景点云進行均匀采样,也要设置关键点比率,从而使对象在遮挡时也能最好使得关键点能够覆盖模型的表面。增加关键点,会使得匹配更加稳定,但是匹配速度会慢。

第二步,优化匹配位姿:这一步是对第一步得到的位姿进行优化,提高位姿的匹配精度。优化位姿的目标是使场景中的采样点到模型中对应点所在的平面的最近距离最小,通过计算场景中模型点的数量与模型总点数之比,获得每个位姿的新的匹配得分,近似认为是场景可见部分的得分,这个得分比近似匹配的分数更加稳定、精确。

第三步:稠密位姿优化:使用和第二步一样的原理,将第二步找到的位姿场景中的所有的点进行重新取样,计算其与模型中对应点的平面距离,因为取点数量比第二步多,获得的匹配位姿精度也得到进一步提高。

3.4 工件高度比较

通过获取匹配的位姿在高度方向的坐标,进行迭代比较,得到位姿最高的零件,算法算述如下:

vector<int>::iterator it;

for (it = iObjIds.begin(); it != iObjIds.end(); it++)

{

GetObjectModel3dParams(hvObjs[it], "center", &hvObjCtr);

if (hvObjTopPs < HTuple(hvObjCtr[2]))

{

// 返回最高点工件序号 : hvObjTopId

hvObjTopPs = ((const HTuple&)hvObjCtr)[2];

hvObjTopId = *it;

}

}

4 机器人与视觉系统坐标标定

4.1 点的坐标变换与刚性物体空间位置变换相关理论

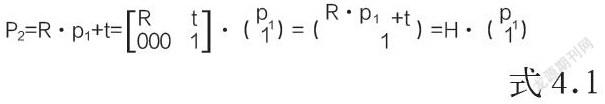

矩阵使用大写字母加粗来表示(例:R),向量使用小写字母加粗表示(例:t)。对于直角坐标系{A},空间任一点p1的位置可以用3x1的列矢量p1来表示。将坐标系{A}进行旋转矩阵R变换和平移矢量t变换后得到点p2,点p2的关系有:

其中,齐次变换矩阵H可用于刚体在空间内的变换,手眼标定的目标就是矩阵H的求取过程,而抓取位置的变换则是使用H的逆阵。

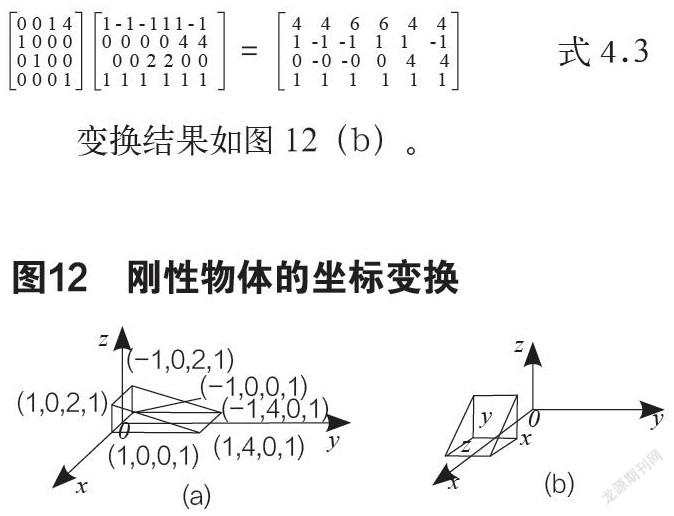

我们可以用描述空间一点的变换方法来描述物体在空间的位置和方向。例如,图4.1(a)所示,物体可由固定该物体的坐标系内的六个点来表示。

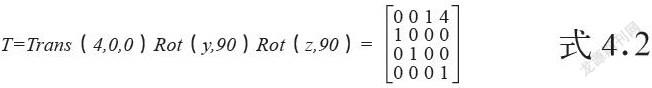

如果首先让物体绕z轴旋转90°,接着绕y轴旋转90°,再沿x轴方向平移4个单位,那么,可用下式描述这一变换:

这个变换矩阵表示对原参考坐标系重合的坐标系进行了旋转和平移操作。

我们可以对上述刚性物体的六个点变换如下:

变换结果如图12(b)。

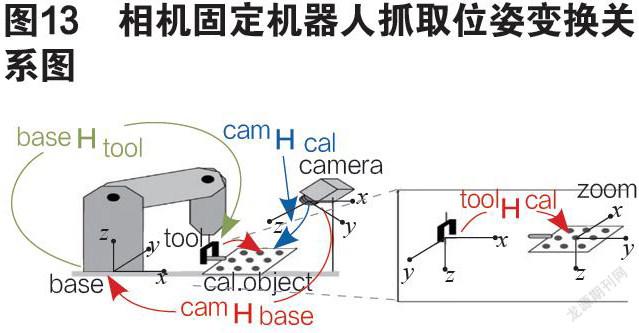

4.2 手眼标定过程中坐标变换关系链

本项目中相机固定位置拍照,机器人移动抓取,如图13所示,抓取位姿的求解变换是先从相机坐标系换算到机器人本体坐标系,再从工具坐标系转换到工件位置。

相機固定机器人抓取位姿变换关系公式描述如下:

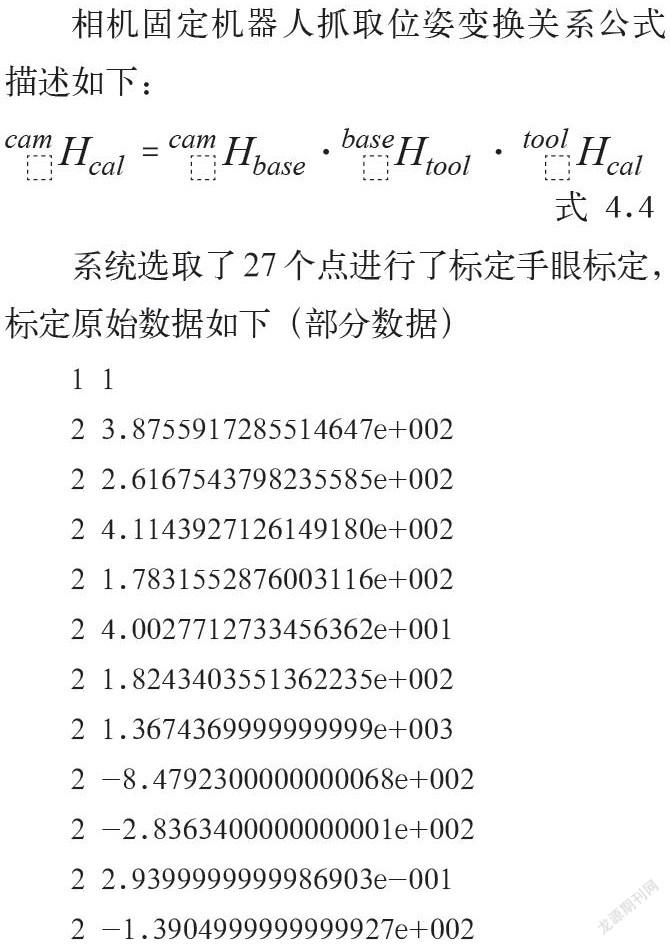

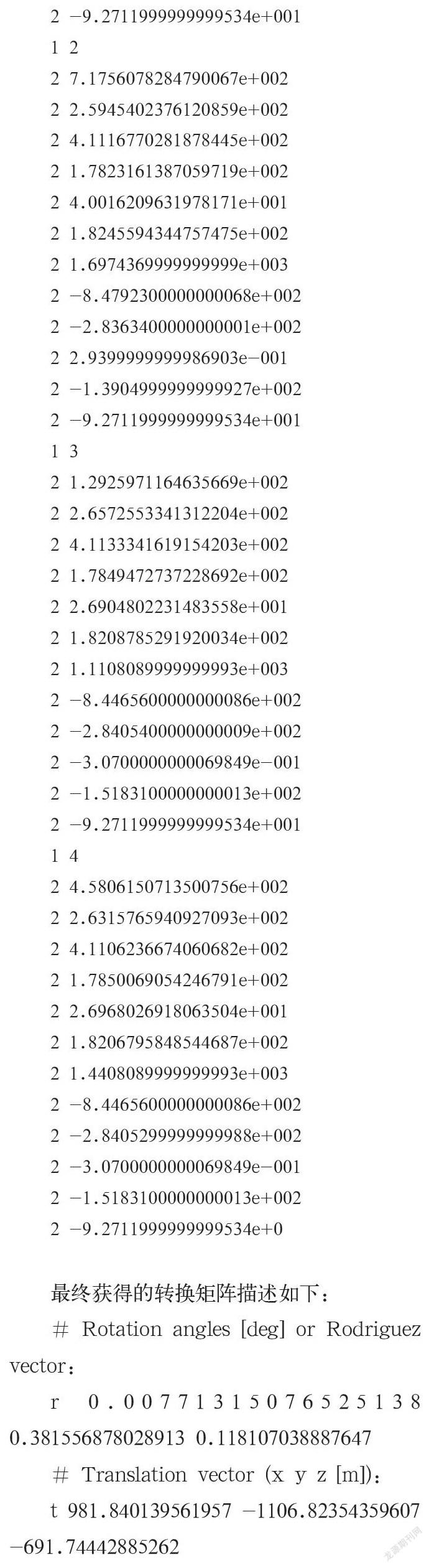

系统选取了27个点进行了标定手眼标定,标定原始数据如下(部分数据)

最终获得的转换矩阵描述如下:

# Rotation angles [deg] or Rodriguez vector:

r 0.00771315076525138 0.381556878028913 0.118107038887647

# Translation vector (x y z [m]):

t 981.840139561957 -1106.82354359607 -691.74442885262

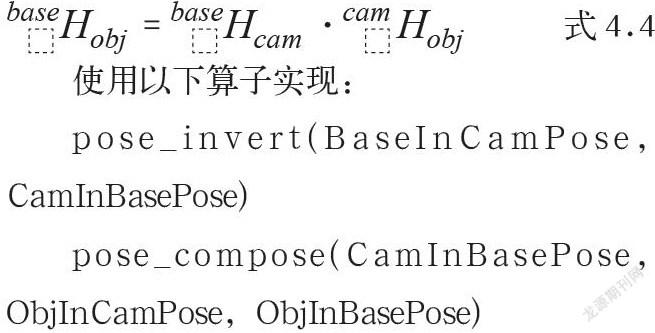

4.3 手眼标定结果使用

对于标定出来的转换矩阵,通过式4.4描述的换算关系实现物料抓取位姿的求取:

使用以下算子实现:

pose_invert(BaseInCamPose, CamInBasePose)

pose_compose(CamInBasePose, ObjInCamPose,ObjInBasePose)

5 问题总结及推广

(1)零件料框包装干扰问题解决。零件运输过程中为了防潮,在外框包了一层塑料薄膜,抓取过程中,塑料薄膜掉落,会挡住相机视线,需要在外框增加卡槽,防止塑料薄膜掉落。(2)机器人手眼标定注意事项。机器人手眼标定过程中,需要视觉系统识别出的位置和机器人的抓取中心,即TCP重合,视觉标定程序设计过程中要确认这一点,否则变换矩阵求取的结果是不准确的。(3)抓取点相邻的零件干涉问题处理。最初设计的抓取点位于曲轴的第三主轴颈位置,该位置接近零件的重心,但也是曲轴相互干涉最多的位置,卡爪没有夹紧空间。经分析后,项目改变抓取点,更改到零件互相接触少的芯轴位置。

通过一系列技术和工程手段,3D算法实现了零件的匹配和定位,再根据手眼标定的结果进行坐标变换,并将抓取坐标发给机器人,机器人执行程序进行抓取和送料操作,项目最终实现了用户的需求。截止笔者收稿,设备已经完成5万根曲轴的抓取,成功率超过98%。

参考文献:

[1]宋丽梅.双目立体机器视觉检测系统及应用[J].西南科技大学学报,2006,21(1),第30~34页.

[2]吴亚鹏.基于双目视觉的运动目标跟踪与兰维测量[D].西北大学硕士论文,2008,第1~2页.

[3]张孙亚.面向分拣系统的机器视觉相关技术研究[D].华南理工大学硕士学位论文,2017,第5~6页.