基于开源数据的情报侦查方法研究

2022-04-29薛亚龙刘梓泞

薛亚龙,刘梓泞

(宁夏警官职业学院,宁夏 银川 750021)

开源数据在提升人们生活质量效能和工作效率的同时,也给数据犯罪情势的生存与发展提供了必要的“土壤”条件。尤其是数据犯罪情势中犯罪手段、犯罪工具、犯罪时空等近年来呈现出跳跃式的发展态势,犯罪目标对象的选择和侵害也越来越虚拟化和动态化,致使犯罪行为由传统的实体犯罪情势向开源数据驱动创新时代的数据犯罪情势所转型。鉴于此,迫切需要引入基于开源数据的情报侦查方法研究范式。这不仅使侦查人员能够对数据犯罪情势的生存与发展态势展开快速高效的算法解析和促进不同开源数据情报源之间的互相融合,而且还能够帮助其提升情报侦查价值需求深挖的协同性和情报侦查决策应用的同配性,全面提高挖掘与分析算法的准确度和精确度,从而实现开源数据情报侦查的应然价值和实然效果。

一、开源数据情报侦查的内涵与属性

目前,越来越多的犯罪行为呈现出虚拟化、智能化、数据化等数据犯罪情势的发展态势,造成传统的情报侦查方法出现力不从心的局面,往往致使案件出现侦查错误或陷入情报侦查僵局。[1]诚然,将开源数据的内涵属性与现代情报侦查工作的特殊价值需求互相融合,不仅是开源数据广泛应用于社会各行业领域的必然趋势,而且还是现代情报侦查工作变革和转型的内在本质需求,更是预防和打击数据犯罪情势生存与发展的实然迫切应对措施。因此,在开源数据驱动创新时代应该赋予开源数据情报侦查新的内涵与属性。

(一)开源数据情报侦查的内涵

在开源数据驱动创新时代,随着开源数据呈现出指数级的迅猛产生和发展,促使其表现出数据含量巨大、价值密度低、类别形态多样以及数据传输速度快等显著特征,[2]给现代情报侦查工作带来了巨大的机遇和挑战。尤其在开源数据的敛散存储、汇集范围、服务对象、分析人员、技术处理过程等方面,给现代情报侦查工作能够创新提供新的途径和方法。[3]显然,依据开源数据的特点和算法价值优势,一方面,有利于情报侦查源搜集从限定数据源向全范围数据延伸和情报侦查途径从封闭性途径向开放性途径拓展;另一方面,还有利于情报侦查人员从固定人员向专业情报侦查人员转变和情报侦查挖掘分析过程从传统实体空间线性模式向开源数据驱动创新时代的循环模式变革,从而全面提高现代情报侦查工作的高效性、客观性、精确性。鉴于此,我们认为,开源数据情报侦查的内涵为:侦查人员以数据犯罪情势中各种海量复杂的开源数据情报源为基础和依据,以案件情报侦查的价值需求感知获取为前提,根据不同开源数据情报源的类别形态和属性结构而采取与其相适应的各种SP-IECLAT 并行关联算法、分簇无线传感数据融合算法、并行聚类CLUBS 算法、引力搜索GSA算法等开源数据挖掘分析算法,从而帮助侦查人员实现预防和打击数据犯罪情势生存与发展变化态势的应然价值和实然效果,属于开源数据驱动创新时代的一种新型数据情报侦查方法。

(二)开源数据情报侦查的属性

1.数据来源的复杂性

开源数据情报侦查的全部过程都离不开对开源数据的挖掘与分析,但是大部分的开源数据都处于敛散化、碎片化、层次化等的记录和存储状态,并且还呈现出索引不规范、格式标准不统一、情报价值不确定等现象。[4]虽然侦查人员对符号型、数值型、文本型、图片型等不同的开源数据能够采取不同的数据算法展开挖掘分析,但是在整个开源数据情报侦查的过程中缺乏全局性的数据情报来源鉴别,并没有对其形成精确性的识别技术方法。所以,数据来源的复杂性是开源数据情报侦查的首要内在属性。基于此,一方面,需要侦查人员对不同来源的开源数据进行快速高效聚类分析,并及时构建和形成开源数据的频繁项目聚类子集;另一方面,需要侦查人员提高对不同开源数据与涉案数据犯罪情势之间关联性挖掘分析的精确度,从而提升开源数据情报侦查的科学性和客观性。

2.数据验证的难度性

由于侦查人员发现和获取开源数据的情报侦查途径有所不同,造成对其来源的有效性和客观性就必然需要进行验证和筛选过滤,以便提高开源数据情报侦查预测和决策的优质性和严谨性。虽然侦查人员采取MapServer 算法、Map 算法等开源数据算法能够使开源数据情报侦查挖掘与分析应用过程实现智能化和联动化,但是开源数据的数据含量巨大、价值密度低、类别形态多样以及数据传输速度快等特征也难以完全避免和消除对其验证的难度性。[5]所以,数据验证的难度性是开源数据情报侦查挖掘与分析应用过程中必然的属性之一。因此,针对开源数据情报侦查的数据验证难度性属性,需要侦查人员增强对开源数据进行验证的收敛速度和数据融合的深度,从而全面提升开源数据情报侦查应用的有效性和精确性。

3.数据情报的融合性

从开源数据情报侦查协作共享和资源开放的角度出发,可以将其数据情报的融合性属性分为两个方面即开源数据的内部融合和非开源数据的外部融合。其中,开源数据的内部融合是开源数据情报侦查中最为重要的一个流程环节,主要目标将侦查人员通过不同情报侦查途径所发现和获取的开源数据进行数据集成和数据聚类,以其聚类初始中心阈值为数据距离构建和形成开源数据的频繁项目聚类子集,从而形成类别形态、格式标准等相同或相似的开源数据仓库集合。而非开源数据的外部融合主要表现为侦查人员将公开获取的开源数据与非公开获取的开源数据进行互相融合,进而有利于实现内部型开源数据与外部型开源数据的互相联动和资源共享。[6]显然,如果公开获取的开源数据和非公开获取的开源数据没有实现数据融合,不但不利于开源数据情报侦查互相协作功能价值的实现,而且还会严重制约和影响开源数据情报侦查应用的高效性和合理性。[7]诚然,开源数据情报侦查的数据情报融合性属性,不仅有利于将内部型和外部型的开源数据进行互相整合和实现数据资源的联动共享,而且还有利于增强其展开情报侦查协作的广度和深度。

二、开源数据情报侦查的平台设计方案提出

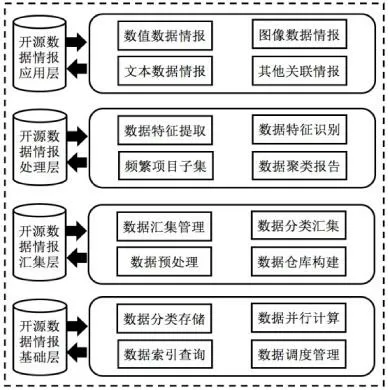

依据开源数据情报侦查的内涵与属性和其流程模型构建原则与内容,提出开源数据情报侦查的平台设计方案,从而增强开源数据情报侦查挖掘与分析的准确性和提升其情报侦查预测与决策的精确性。基于此,可以将开源数据情报侦查的平台自下而上设计为开源数据情报基础层、开源数据情报汇集层、开源数据情报处理层以及开源数据情报应用层等四个功能架构层。(如图1)

图1 开源数据情报侦查的平台设计方案

首先,开源数据情报基础层是整个开源数据情报侦查平台设计的基础和前提,主要包括对涉案不同开源数据情报源的数据分类存储、数据并行计算、数据索引查询以及数据调度管理等基础平台服务,其主要价值在于全面帮助侦查人员提升对各种开源数据情报源进行并行运算的执行率和准确率。然后,开源数据情报汇集层主要根据涉案符号型开源数据、数值型开源数据、文本型开源数据以及图片型开源数据等不同开源数据情报源的类别形态和格式标准,对其采取数据汇集管理、数据分类汇集、数据预处理以及数据仓库构建等技术应用方法,促使涉案数值数据情报、图片数据情报、文本数据情报以及符号数据情报等不同开源数据情报源之间能够自动实现数据集成和数据融合。

其次,开源数据情报处理层主要是依据开源数据情报侦查过程中的不同情报价值需求导向,侦查人员及时对涉案的各种开源数据情报源进行数据特征提取和数据特征识别,而形成频繁项目子集和数据聚类报告等开源数据情报侦查的各种数据加权阈值,从而为挖掘分析其与涉案数据犯罪情势之间各种内在关联数理关系提供不同的开源数据相邻加权系数的支持和保障。

最后,开源数据情报的应用层主要是根据涉案数据犯罪情势的生存与发展态势,帮助侦查人员能够快速高效提供诸如数值数据情报、图像数据情报以及符号数据情报等各种具有情报侦查价值的关联开源数据情报。诚然,在开源数据情报侦查的平台设计方案中,各个功能架构层不仅具有不同的技术应用价值功能和特殊任务,而且其在整个开源数据情报侦查应用过程中能够实现互相衔接和互相联动,促使后续侦查人员对开源数据情报侦查的流程模型构建更加具有科学性和高效性。

三、开源数据情报侦查的流程模型构建

结合开源数据算法的价值优势和情报侦查的价值需求导向,依据开源数据情报侦查的平台设计方案,侦查人员应该根据涉案不同数据犯罪情势的生存与发展态势变化而构建与其相适应的开源数据情报侦查的流程模型,从而有利于实现开源数据情报侦查的应然价值和实然效果。

(一)开源数据情报源的汇集流程模块

从开源数据情报侦查的价值需求导向预设而言,开源数据情报源的汇集流程主要包括三个方面:第一,开源数据情报源的汇集对象。根据涉案数据犯罪情势的生存与发展态势变化趋势,开源数据情报源的汇集对象既包括网络数据库、物联网数据、社交数据等结构化开源数据,又包括搜索引擎数据、类别形态数据、虚拟空间数据等非结构化或半结构化开源数据。[8]显然,侦查人员应该根据侦查情势的发展变化需求而汇集具有针对性、价值性等高质量的各种开源数据情报源。第二,开源数据情报源的汇集方法。根据预设的开源数据情报侦查价值需求导向和其不同的汇集对象,侦查人员可以采取技术驱动数据、对象驱动数据、任务驱动数据等汇集技术方法。例如,面对不同开源数据情报侦查的价值需求导向必须采取有利于侦查情势发展的汇集方法,如侦查人员可以采用定向计量获取、网络关系矩阵、虚拟时空热点等汇集方法;[9]从开源数据的数据路径、数据结构而言,可以采取类别数据仓库构建、检索引擎识别、数据链路预测等可视化的汇集方法;从提高开源数据情报侦查的高效性而言,还可以采取区块链智能合约、关联聚类算法挖掘等汇集方法。[10]第三,开源数据情报源的汇集原则。结合开源数据的阈值加权系数和相似度的相邻系数等特征属性,为了保障开源数据情报源的科学性和客观性,侦查人员在对开源数据情报源进行汇集的过程中应该遵循全面性、客观性、融合性、预测性等重要原则,从而为后续开源数据情报侦查的流程模型构建提供重要的支持和保障。

(二)开源数据情报源的质量评估流程模块

开源数据情报源的质量高低会直接决定开源数据情报侦查应用的应然价值和实际效果,所以侦查人员应当对已汇集的涉案不同开源数据情报源进行检查和验证等质量评估,进而确保开源数据情报侦查流程模型构建的准确性和高效性。从挖掘分析其与涉案数据犯罪情势具有内在关联的数理关系角度出发,侦查人员需要采取对不同结构属性、类别形态的多源数据情报源进行不确定性、数据融合的可行性以及关联聚类性等质量评估,从而帮助其能够快速高效的发现隐藏在开源数据情报源中的冗余数据、重复数据、离群数据等异常数据。[11]同时,侦查人员还可采取不同数据挖掘与分析算法对存储在数据仓库中的各种离散、孤立、片段等的开源数据情报源进行质量检验和评估,进而帮助其全面提升对开源数据情报源进行质量评估的准确性和高效性。诚然,在开源数据情报源的质量评估流程模块中,侦查人员应该根据涉案数据犯罪情势的生存与发展变化趋势采取有利于案件侦查情势发展的不同质量评估技术方法,从而确保开源数据情报侦查流程模型构建的同配属性。

(三)开源数据情报源的聚合流程模块

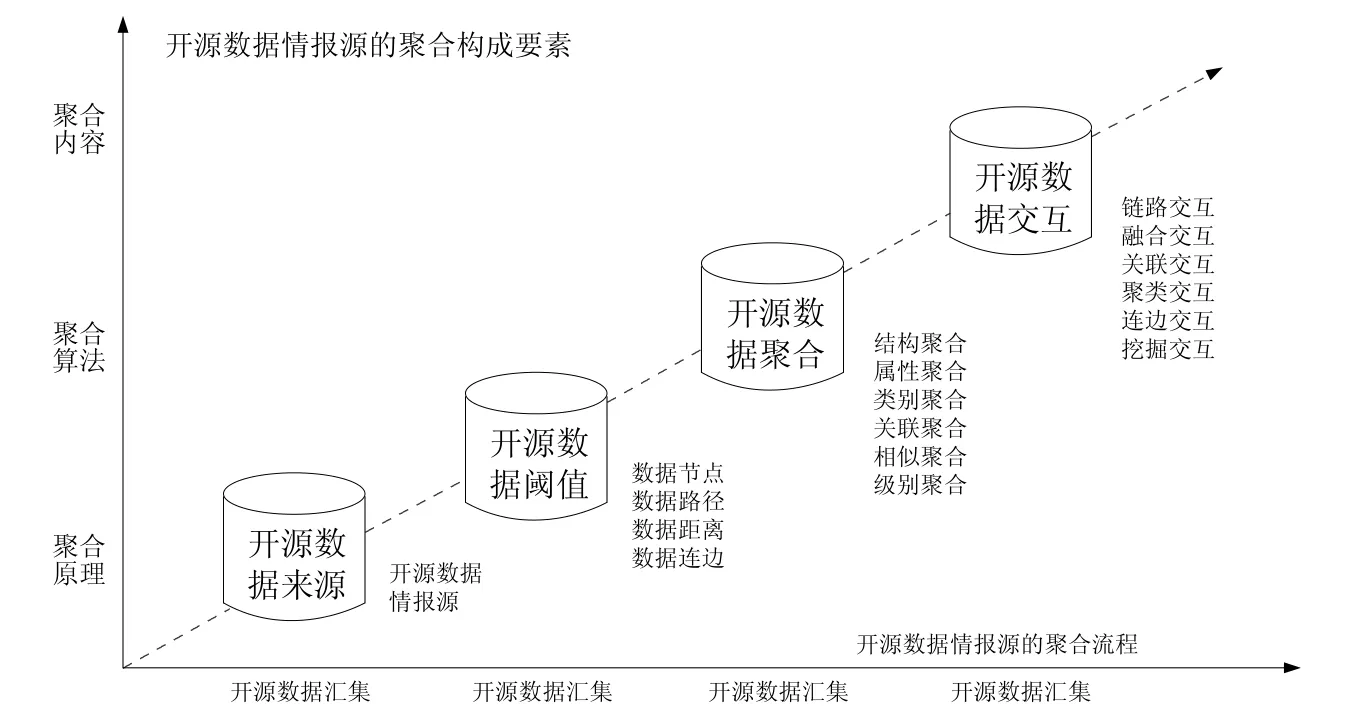

开源数据情报源的聚合流程是整个开源数据情报侦查流程模型构建的核心环节,侦查人员可以依据开源数据的聚合原理和聚合算法,按照不同的情报侦查价值导向需求阈值而对其进行数据聚合。从对开源数据情报源的聚合构成要素出发,可以将其具体分为开源数据汇集、开源数据描述、开源数据聚合、开源数据展示等四个环节。第一,开源数据汇集。该环节主要是对数值型、图片型、文字型、符号型等不同的开源数据情报源进行搜集和数据仓库构建。第二,开源数据描述。该环节任务是对涉案不同开源数据的阈值进行挖掘与分析,主要包括各个开源数据的数据节点、数据路径、数据距离以及数据连边等。第三,开源数据聚合。开源数据聚合是开源数据情报源聚合流程的关键性环节,主要包括对开源数据的结构聚合、属性聚合、类别聚合、关联聚合以及相似聚合、级别聚合等内容。第四,开源数据展示。开源数据展示是侦查人员对开源数据进行挖掘交互的重要环节,主要包括对涉案开源数据的链路交互、融合交互、关联交互、聚类交互以及连边交互和挖掘交互等内容。(如图2)

图2 开源数据情报源的聚合流程

诚然,在开源数据情报源的聚合流程中,侦查人员应该根据涉案不同开源情报源的来源途径、类别形态、属性结构等条件因素,采取与其相适应的聚合原理和聚合算法,避免或降低开源数据情报源数据仓库构建的冗余性和离散性,从而确保开源数据情报源聚合流程模型构建的关联高效性和聚类精确性。

(四)开源数据情报源的挖掘分析流程模块

开源数据情报源挖掘分析流程模块的核心价值在于构建和展示开源数据挖掘与分析的过程和步骤,重点强调的是其所赋予和包含的情报侦查功能与任务。为了实现开源数据情报源挖掘分析流程模型构建的循环反馈和螺旋式精确求精的任务价值,侦查人员应该采取具有循环型的流程模型构建方法,主要包括开源数据搜集、开源数据处理、开源数据分析、开源数据生产等四个部分。

第一,开源数据搜集阶段。该阶段主要对不同的开源数据进行数据清洗、数据存储以及数据仓库构建,进而为对开源数据情报源的挖掘分析奠定数据支持基础。第二,开源数据处理阶段。该阶段的任务是对存储在数据仓库中的各种开源数据进行处理,主要包括数据集成、数据转换以及数据融合等技术处理方法。第三,开源数据分析阶段。该阶段主要目的是对涉案开源数据情报源进行数据验证和数据评估,通过数据聚类等关联算法对其与涉案数据犯罪情势具有潜在关联性的各种数理关系展开分析和研判。第四,开源数据生产阶段。该阶段主要是将对开源数据进行挖掘分析后所形成具有情报侦查价值的数据产品提供给办案的侦查人员,具有指导开源数据情报侦查预测和决策的重要功能价值,从而确保开源数据情报侦查应用质量和效率的优质性、准确性。

(五)开源数据情报源的应用反馈流程模块

开源数据情报源的应用反馈流程核心价值在于强调侦查人员在开源数据情报侦查流程模型构建过程中的反馈率和参与度,并能够依据涉案数据犯罪情势的发展变化趋势而快速高效的对其进行检验和修正。在构建开源数据情报源的应用反馈流程模型过程中,侦查人员不仅需要将开源数据情报侦查的价值导向需求、开源数据的权重加权系数阈值、开源数据的挖掘分析算法等重要构成要素纳入其流程模型构建中,而且还需要考虑开源数据的汇集和数据仓库构建、开源数据不同数据节点的相似度系数、开源数据内在关联数理关系挖掘分析等重要相关要素。同时,侦查人员还应该根据不同的应用反馈检验等评估结果及时对开源数据情报侦查的价值导向需求阈值、平台设计方案以及挖掘分析算法等进行重建或调整。显然,侦查人员在开源数据情报源应用反馈流程中的反馈率和参与度越高,就会越来越使开源数据情报源的应用反馈流程模型朝有利于数据侦查情势的态势发展,从而提高开源数据情报侦查预测和决策的高效性和准确性。

四、开源数据情报侦查的应用方法探讨

在探讨开源数据情报侦查应用方法的过程中,不仅需要考虑开源数据情报侦查的内涵属性、平台设计方案以及流程模型构建等,而且还需要考虑涉案不同开源数据之间的数据节点相似度、数据权重加权系数、数据频繁项目子集等相关要素。因此,在开源数据驱动创新时代应该赋予开源数据情报侦查新的应用方法,一方面,这是实现开源数据情报侦查应然价值的内在本质要求;另一方面,还是预防和打击涉案数据犯罪情势生存与态势发展变化的实然应对选择,从而提高开源数据情报侦查预测和决策的准确性和精确性。

(一)SP-IECLAT 并行关联算法

SP-IECLAT并行关联算法是一种基于Spark运算和构建关联规则模型的数据挖掘分析算法,结合涉案开源数据的数据节点相似度、数据权重加权系数等阈值属性和情报侦查的价值需求导向预设,可将开源数据情报侦查的SP-IECLAT 并行关联算法具体分为以下步骤:

第一步,开源数据的预处理。首先,侦查人员需要从加载数据的HDFS 系统数据仓库中读取和选择情报侦查价值所需的各种开源数据,并将获取的开源数据采取数据融合和构建关联聚类初始中心等进行数据聚合。然后,使用数据集成、数据归约技术处理方法将数据聚合后的开源数据直接转换为具有垂直性的数据仓库。其次,将给定开源数据节点的最小相似度系数与其预设的最小相似度阈值进行分析和比较。若预设开源数据节点相似度的阈值小于给定的最小相似度系数,那么所获得的垂直性数据仓库就属于开源数据的频繁项目集合;反之,则属于开源数据的频繁项目1-集合。

第二步,运算开源数据的频繁项目K-集合。鉴于涉案开源数据情报源的动态性、层次性、复杂性等特点,侦查人员可以采取前缀划分策略的挖掘运算方式。例如,侦查人员可以采用Cluster Manager 的前缀划分策略对开源数据的频繁项目K-集合进行运算,通过触发Dirver Program 的数据节点来制约和影响整个开源数据频繁项目K-集合的控制点,从而起到提高开源数据频繁项目K-集合的运算效率和降低其运算耗时成本等价值作用。[12]

第三步,调入前缀划分策略。依据预设前缀阈值的相同或相似原则,将开源数据频繁项目K-集合划分为FRE-K 个块数。假设S 个不同前缀阈值的频繁项目K-集合表示为FRE -K={fre-k1,fre-k2,…,fre-ks},那么该集合被调入前缀后即可表示为FRE-K={fre-k1-2,fre-k2-2,…,fre-ks-2}。显然,所获取的每个频繁项目K-集合加上其调入前缀就是涉案所有开源数据频繁项目(K+1)-的集合,并且该前缀的频繁项目集合支持度也就是其全部开源数据频繁项目(K+1)-集合的支持度。

第四步,运算开源数据的频繁项目K(K>2)集合。在获取到开源数据的频繁项目K-集合之后,侦查人员首先需要判断该频繁项目K-集合是否为空。如果为空,那么就立刻停止对其的运算;反之,则需要继续对其进行采取前缀划分。然后,侦查人员可以将具有相同或相似前缀的开源数据采取自下而上的数据迭代挖掘算法,促使形成情报侦查价值所需的频繁项目(K+1)集合。其次,侦查人员还需要对所获的频繁项目(K+1)集合再次进行前缀划分,并将通过数据算法挖掘获取的结果存储在犯罪行为与非犯罪行为的关联规则数据库中。最后,当开源数据的频繁项目(K-1)集合被成功前缀划分之后,此时具有前缀划分属性的频繁项目集合即为(K-2)。同时,还需侦查人员将后续剩余的频繁项目集合2-再添加到开源数据的频繁项目K(K>2)集合进行算法挖掘,一直重复添加运算直到没有符合满足的条件即可完成对开源数据频繁项目K(K>2)集合的运算。

(二)分簇无线传感数据融合算法

从EEDFA 算法的价值优势和开源数据情报侦查的价值需求导向预设角度出发,开源数据情报侦查的EEDFA 算法可分为以下步骤:

第一步,开源数据的时间向量降维。涉案不同开源数据情报源Dp 经过控制和汇集之后,需要侦查人员依据时间排序将其统一存储到已构建的数据仓库缓存中,进而形成开源数据的时间向量表示即Vit={d1,d2,d3,...,dp}。其中i 表示开源数据的不同数据节点,t 表示具有时隙特征的数据挖掘周期,而p 则表示开源数据所包含的时隙特征系数阈值。显然,若p 的时隙特征系数阈值越大,那么不同开源数据的数据节点时隙距离就越小,就说明这两个不同开源数据具有关联数理关系的概率就越高;反之,则说明所具有的关联数理关系概率就越低。为了提升开源数据的时间向量降维质量和准确度,侦查人员可以采取APCA 算法中的自适应数据分段相似法。一方面,能够帮助侦查人员按照开源数据的时间向量表示进行自适应的数据挖掘降维处理;另一方面,还可以帮助其全面降低开源数据时间向量降维过程中的误差阈值Terror。

第二步,开源数据节点的可靠性评估。在开源数据情报侦查的EEDFA 算法过程中,侦查人员可能会受到各种来自情报侦查外部环境的干扰而出现制约和影响对数据进行挖掘与分析情况,造成其算法挖掘结果可能存在一定程度的不确定性和不可靠性,所以急需侦查人员对开源数据节点的可靠性展开检验和评估。依据开源数据情报侦查EEDFA 算法的价值优势,侦查人员可以采用数据区间二型模糊系统对开源数据节点的可靠性展开评估。(如图3)

图3 区间二型模糊系统流程模型

第三步,开源数据的关联性挖掘。一方面,当侦查人员完成对开源数据节点的可靠性评估之后,就需要将其发送到EEDFA 算法流程中的数据簇头进行数据融合。由于同一数据簇头内不同开源数据之间的数据节点相似度系数差异性较小,造成部分簇头内存在大量的冗余数据、重复数据、离群数据等异常数据,所以在对开源数据进行数据融合之前需要对其采取去除各种异常数据的数据清洗和数据集成。[13]另一方面,当各种开源数据经过时间向量降维处理之后,必然会造成出现其时间向量长度差异较大的现象,就迫切需要侦查人员对其进行时间向量的延伸和扩展,进而提高对开源数据进行关联挖掘分析的精确度。

诚然,在开源数据情报侦查的EEDFA 算法过程中,不仅能够帮助侦查人员降低或者消除冗余数据、重复数据、离群数据等异常数据的制约和影响,而且还能够帮助其提高对关联数理关系挖掘分析的准确性和客观性。

(三)并行聚类CLUBS 算法

并行聚类CLUBS算法是一种基于快速分层的无参数中心聚类算法,主要融合了数据裂变和数据凝聚两种算法价值优势。[14]结合涉案开源数据的内涵属性和情报侦查的价值需求导向,我们认为,开源数据情报侦查的并行聚类CLUBS 算法具体可分为四个阶段:

第一,开源数据的裂变阶段。并行聚类CLUBS 算法采用自上而下的二叉空间分割技术将开源数据的频繁项目集合分割为系列性的数据簇,根据开源数据挖掘分析的贪婪原则和最小数据簇WCSS 平方和的要求,再采用数据迭代算法对其进行数据融合,促使数据簇内不同开源数据的数据节点相似度系数能够实现互相接近或相同。

第二,开源数据的调整阶段。经过开源数据的裂变阶段之后,其调整阶段的任务主要包括两个方面:一方面,将数据簇中的簇头进行分离。侦查人员先将数据簇按照升维的模式重新进行递增排序,然后依据是否含有噪声块的条件从新获取的升维数据簇中将簇头进行分离;另一方面,构建新的数据椭圆簇。侦查人员可以采取基于数据密度的数据节点相似度检测算法计算不同数据节点到预设椭圆簇中心的数据距离,如果所测数据距离符合的预设距离之内,则属于数据椭圆簇范畴;反之,则重新进行数据调整,直到不符合到预设椭圆簇的中心数据距离为止。

第三,开源数据的凝聚阶段。开源数据凝聚阶段的主要任务是对数据椭圆簇进行合并,进而改进与提升对开源数据挖掘分析的质量和效率。如果数据椭圆簇合并使CH 指标体系数呈增长上升趋势,那么则继续合并且代替原来的两个数据椭圆簇。反之CH 指标系数呈减少下降趋势,则取消合并和结束开源数据的凝聚阶段。

第四,开源数据的挖掘完善阶段。侦查人员对合并后重新获取的数据椭圆簇进行挖掘与分析,从而获取到其与涉案数据犯罪情势具有内在关联性的各种数理关系。同时,为了确保开源数据情报侦查并行聚类CLUBS算法的客观性和准确性,还需要对所获取的各种关联性数理关系进行检验和修正。若符合涉案数据犯罪情势的客观实际且有利于数据侦查情势的态势发展,那么说明其具有客观性和准确性。反之,则需要侦查人员将获取的数据椭圆数据重新进入开源数据的调整阶段进行调整和修正。

诚然,在开源数据情报侦查并行聚类CLUBS 算法的应用过程中,不仅能够帮助侦查人员实现对涉案不同开源数据之间的同步并行运算处理,而且还能够帮助其提高开源数据情报侦查挖掘与分析的高效性和精确性。

(四)引力搜索GSA 算法

引力搜索GSA 算法的主要原理为预设数据的可能解考虑为代理数据集合,代理数据的质量决定代理数据的性能。[15]鉴于不同数据节点之间引力的制约和影响,不同代理数据之间会进行相互融合和归约,促使各种代理数据会朝着具有更大关联数理关系的代理数据进行集成聚类。从实现提升开源数据情报侦查的应然价值和实然效果而言,可以将开源数据情报侦查的引力搜索GSA 算法具体分为以下步骤:

第一步,代理开源数据的初始化。依据已存储在数据仓库中不同开源数据的类别形态和属性结构,侦查人员需要随机选择预设的开源数据进行代理的初始化设置,确定其在不同开源数据维度空间中的具体数据维度位置。第二步,寻找代理开源数据的最优适应度。在挖掘分析各种代理开源数据最优适应度的数据迭代运算过程中,首先侦查人员需要分别选择最优和最差适应度的运算方法,然后运算分别获取代理开源数据的最优适应度阈值和最差适应度阈值。第三步,计算和获取开源数据的引力常量。预设开源数据的时间引力常量为Gc(t),那么其计算公式为其中,G0和a 表示计算开源数据的引力常量,而Tmax则代表对其进行计算的最大数据迭代次数。[16]第四步,计算和获取代理开源数据的引力质量。根据计算和获取代理开源数据引力常量的运算方式,可以将用Massi(T)来表示代理开源数据的引力质量,为了提升计算代理开源数据引力常量的高效性,侦查人员可以采用公式来计算和获取。第五步,计算和获取代理开源数据的引力与加速度。为了提升计算代理开源数据引力与加速度的精确度,侦查人员可以采用基于欧氏距离的数据迭代运算方法,进而获取代理开源数据在欧氏距离[0,1]区间分布的最优适应度引力与加速度。第六步,代理开源数据关联聚类的终止条件。依据开源数据情报侦查中犯罪行为与非犯罪行为的关联构建规则,侦查人员需要通过从第一步到第五步的步骤来挖掘分析其与涉案数据犯罪情势之间存在具有内在关联性的各种数理关系,直到符合预设代理开源数据关联聚类的终止条件为止。

诚然,在开源数据情报侦查的引力搜索GSA算法应用过程中,不仅有利于侦查人员提升获取代理开源数据适应度的效率和降低挖掘分析算法的耗时复杂性,而且还有利于其提高对开源数据进行关联聚类挖掘的精确性和准确性,从而全面提升开源数据情报侦查挖掘分析应用的高效性。

(五)多目标决策时序数据算法

多目标决策时序数据算法是以数据的时间为计算逻辑节点,通过分析该逻辑节点在数据路径、数据距离以及数据连边等中的时间排序和计算不同数据在其中所存在的数据归属度系数阈值,从而挖掘分析出各种时序数据的关联聚类特征、权重加权系数、节点相似度系数等发展态势。[17]结合涉案开源数据的数据熵权时序权重阈值和关联聚类的挖掘分析敏感系数,可以将开源数据情报侦查的多目标决策时序数据算法划分为具体五个步骤:

第一步,构建开源数据的初始矩阵。首先,在涉案开源数据的数据仓库中寻找和选择M 个开源数据的评价指标和N 个开源数据的评价对象。然后,将M 个开源数据的评价指标和N 个开源数据的评价对象重新组合构建开源数据的初始矩阵,并且在该矩阵中包含多目标决策时序数据算法的效用指标系数和效益指标系数两部分。第二步,确定开源数据的AHP 权重指标系数。鉴于确定开源数据AHP 权重指标系数时主观因素所占比重较大的原因,侦查人员可以采取一致性开源数据检测的方法对其进行运算,尽量保障获取开源数据AHP 权重指标系数结果的客观性和全面性。例如,侦查人员可以采取一致性开源数据检测的挖掘公式CR=CI RI,其中CR 表示开源数据的AHP 权重指标系数,RI 表示随机的一致性开源数据检测系数。若CR<0.1,那么表明其通过了一致性开源数据的检测,并具备成为多目标决策时序数据算法的评价矩阵条件。第三步,获取开源数据的加权标准化矩阵。结合开源数据的初始矩阵和开源数据的AHP 权重指标系数,可知开源数据的加权标准化矩阵应该具有正理想属性的同配解为,即可获得开源数据加权标准化矩阵的计算方式为第四步,开源数据的时序处理。在开源数据情报侦查的多目标决策时序数据算法过程中,如果开源数据的数据熵权时序权重阈值越大,那么其与涉案数据犯罪情势之间存在内在关联数理关系的可能性就越小。基于此,侦查人员可以采取线性加权的数据熵权时序运算方法。若通过运算所得开源数据的数据熵权时序权重阈值在[0,1]之间,那么就表示该开源数据与涉案数据犯罪情势之间存在内在关联数理关系的可能性就越大。反之,则表示可能性越小。第五步,开源数据的聚类挖掘。依据第一步所确立的多目标决策时序数据算法的效用指标系数和效益指标系数,侦查人员可对通过第一步到第四步所获取的开源数据进行时序的聚类挖掘分析。例如,侦查人员可以采取基于加速比的开源数据时序聚类挖掘分析算法即其中p 代表开源数据时序聚类挖掘的数量,T1代表对开源数据进行时序聚类挖掘的所需时间,Tp代表对p 个开源数据采取时序算法所消耗的并行执行时间。

显然,在开源数据情报侦查的多目标决策时序数据算法应用过程中,不仅能够帮助侦查人员降低挖掘分析的耗时量和提升关联聚类的加速比,而且还能够帮助其全面提高开源数据情报侦查算法应用的可拓展性和鲁棒性。

(六)轮廓系数K-means 聚类算法

在开源数据情报侦查的轮廓系数K-means 聚类算法中,K 值代表数据仓库中开源数据的聚类簇数量,且K 值阈值的大小会直接影响到对开源数据进行聚类结果的精确性和准确性。从轮廓系数K-means 聚类算法中K 值的选取和情报侦查的价值需求导向预设角度出发,我们认为,可以将其分为六个具体应用步骤:

第一步,初始化开源数据的K 值和平均轮廓系数S。为了全面提升开源数据情报侦查价值需求深挖的协同性和情报侦查决策应用的同配性,侦查人员可以先将轮廓系数K-means 聚类算法的K 值初始化预设为2,以便促使其能够从最小的聚类簇开始运算和挖掘。鉴于平均轮廓系数S 还尚未展开运算,故可将其初始化的值预设为-1。[18]同时,为了提高后续轮廓系数K-means 聚类算法步骤的高效性,还需要侦查人员寻找和选取涉案开源数据的两个数据节点作为其聚类簇初始化的质心节点。第二步,开源数据的数据节点完成聚类任务。首先,利用开源数据的数据节点I 计算其与所属聚类簇之间的质心距离,选择质心距离阈值最小的聚类簇为其所需要的簇;然后,对开源数据的数据节点与其质心之间的平均路径距离进行计算,并将质心距离与最接近其平均距离的数据节点设置为新的开源数据质心;最后,计算和获取开源数据新质心距离与其旧质心距离之间的差异阈值。若所得差异阈值小于轮廓系数K-means 聚类算法中关于聚类条件的最小系数,那么就完成该数据节点的聚类任务。反之,则继续以新质心为重新开始的开源数据聚类任务,直到完成为止。第三步,计算开源数据的数据节点凝聚度。在完成开源数据的数据节点聚类任务后,侦查人员可以利用轮廓系数对开源数据的聚类初始K 值进行运算和挖掘分析,进而获取该数据节点与其聚类簇内其他数据节点之间的平均数据路径距离即数据节点凝聚度。第四步,计算开源数据的数据节点分离度。开源数据的数据节点分离度是指该数据节点Xi与其聚类簇Cm内所有数据节点的平均距离。[19]侦查人员可以利用开源数据的数据节点Xi到某个开源数据聚类簇内所有数据节点的平均数据路径距离作为衡量和测算其到该聚类簇的数据路径距离,而计算和获取的最小平均数据路径距离即为该开源数据的数据节点分离度。第五步,挖掘获取开源数据的平均轮廓系数。在开源数据情报侦查的轮廓系数K-means 聚类算法挖掘与分析过程中,数据节点的凝聚度表示开源数据聚类簇的数据密度程度,而数据节点的分离度则表示其聚类簇内的数据路径距离。显然,在对开源数据进行聚类的过程中,如果数据节点的凝聚度越小,那么其聚类簇的数据路径距离就越远,而对开源数据的聚类效果就越好。鉴于此,侦查人员可以采取开源数据平均轮廓系数的运算公式即,其中Si代表开源数据中数据节点i 的轮廓系数,S 代表开源数据中所有数据节点的平均轮廓系数,且S 的阈值取值范围为[-1,1]。显而易见,开源数据的平均轮廓系数S 的阈值越大,那就表示对其进行聚类效果越好。[20]第六步,开源数据聚类簇数量K 值的调整。侦查人员可以重复第二步到第五步的运算步骤,便可以实现K 值增加的效果。当开源数据被采取轮廓系数K-means 聚类算法进行N 次数据迭代以后,可选取其平均轮廓系数S 最大的阈值作为开源数据聚类簇的K 值,而计算所挖掘到的聚类结果就是最终的运算结果。

诚然,在开源数据情报侦查的轮廓系数K-means 聚类算法过程中,不仅能够帮助侦查人员提高对开源数据关联聚类的准确率和降低其不同类别形态、属性结构的制约与影响,而且还能够帮助其提升开源数据情报侦查价值需求深挖的协同性和情报侦查决策应用的同配性,从而有利于提高开源数据情报侦查挖掘与分析应用的准确度和精确度。

结论

基于开源数据的情报侦查方法是开源数据驱动创新时代的一种新型数据情报侦查方法,主要包括SP-IECLAT 并行关联算法、分簇无线传感数据融合算法、并行聚类CLUBS 算法、引力搜索GSA算法、多目标决策时序数据算法以及轮廓系数K-means 聚类算法等多种开源数据情报侦查方法,且不同的开源数据情报侦查方法都有着不同的应用算法优势。基于此,引入基于开源数据的情报侦查方法研究范式。以开源数据情报侦查的内涵与属性为研究逻辑起点,提出开源数据情报侦查的平台设计方案,构建开源数据情报侦查的流程模型,并对开源数据情报侦查的应用方法展开探讨。这不仅使侦查人员能够对数据犯罪情势的生存与发展态势展开快速高效的算法解析和促进不同开源数据情报源之间的互相融合,而且还能够帮助其提升情报侦查价值需求深挖的协同性和情报侦查决策应用的同配性,全面提高挖掘与分析算法的准确度和精确度,从而实现开源数据情报侦查的应然价值和实然效果。