机器人与机器视觉的垃圾分拣系统设计

2022-04-28梅志敏

梅志敏,陈 艳,胡 杭,张 融

(1.武昌工学院机械工程学院,湖北 武汉 430065;2.武汉轻工大学机械工程学院,湖北 武汉 430023;3.绿色风机制造湖北省协同创新中心,湖北 武汉 430065)

1 引言

近年来,以机器视觉为载体的机器人技术与装备在智能制造行业的应用越来越广,它使工作过程更自动化与智能化,改善了工作环境,也提高了产品精度[1]。同时,垃圾分类是长期困扰人民生活和环境治理的综合议题,亟待通过科学技术手段解决。

绝大部分垃圾为流通商品消耗后造成的,外包装均含由中国编码中心审定发行的条码,通过视觉识别条码获取产品名称,将其与训练集匹配,输出垃圾分类结果,数据传输给机器人执行末端即可实现分拣,对垃圾分类的智能化研究提供了重要的理论和应用基础。

国内外学者开展了一些相关研究。文献[2]设计了基于视觉的建筑垃圾分类和回收的机器人系统,具有高度自动化巡逻、检测和回收等特点;文献[3]设计了基于ROS和计算机视觉的智能垃圾分类系统,通过深度学习训练模型,按颜色、形状、大小进行区分,识别率70%。

文献[4]开展了基于图像视觉的垃圾分类机器人识别控制系统算法设计研究,对瓶罐类垃圾进行分拣机械手臂控制系统设计。对此,本设计以流通商品为研究对象、建立商品条码数据库,将采集到的图像识别后与数据库匹配,结果传输给机器人本体,调用IRB1410的运控程序完成目标物的精确分拣。

2 系统组成与逆运动学方程求解

2.1 系统组成

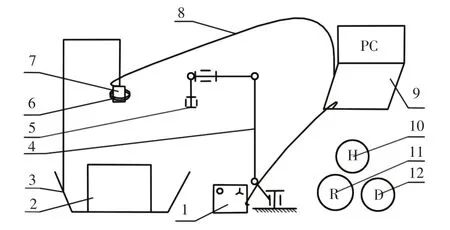

本设计主要由IRB1410 机器人工作站、待分拣垃圾输送装置、视觉采集−识别−通讯平台、MCGS人机界面和三类垃圾收集箱(可回收垃圾、干垃圾和有害垃圾)组成,其中机器人工作站包括本体、控制器和示教器,如图1所示。

图1 系统结构示意图Fig.1 Schematic Diagram of the System Structure

2.2 系统工作原理

当输送装置将待分拣的流通商品垃圾送至视觉检测平台采集区域时,传感器发送采集信号,视觉系统获取外形轮廓图像、条码图像和位置信息,将识别的条码号与流通商品条码数据库和垃圾分类训练集进行匹配[5]。

将位姿(位置和姿态)和分类结果信息传输给机器人控制器,根据逆运动学计算各关节参数,调用PROC 程序抓取待分拣垃圾,放至对应垃圾箱,机器人可设置运行速率适应待分拣垃圾节拍,期间无停顿。系统工作原理图,如图2所示。

图2 系统工作原理图Fig.2 Schematic of the System

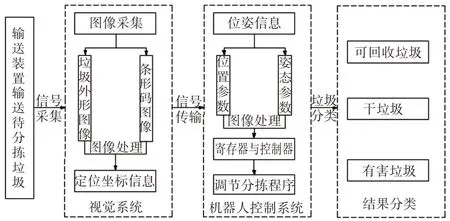

2.3 IRB1410机器人逆运动学求解

本设计是将图像的位姿信息经控制器发送给机器人末端,根据关节变换矩阵求解各关节的位置和姿态,故采用逆运动学法求解,驱动各关节电机[6]。

IRB1410机器人连杆参数,如表1所示。机构运动简图及各关节坐标系,如图3所示。

表1 IRB1410机器人连杆参数Tab.1 IRB1410 Rod Parameters

图3 IRB1410机构运动简图及各关节坐标系Fig.3 IRB1410 Schematic Diagram of Mechanism Motion and Coordinate System of Each Joint

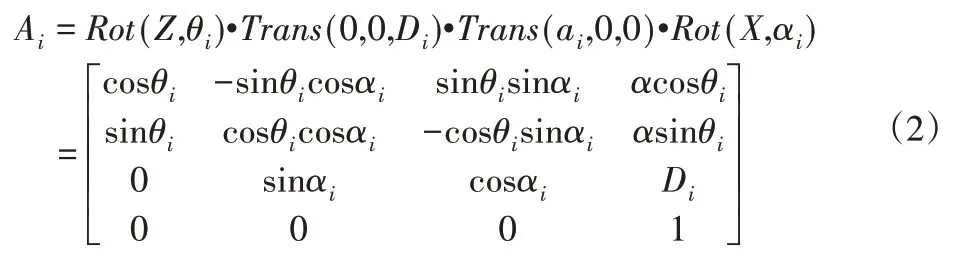

逆运动学方程如下:

已知T6矩阵和各连杆参数,求各关节转角θ1−θ6:

式中:Ai—关节i的位姿变换矩阵;Rot—旋转算子;Trans—平移算子。

由解析法求得各关节角度:

式中:pi—连杆长度在i方向的分量;c—cos;s—sin。

综上,本设计通过视觉定位获取垃圾的位姿后,传输给R6,各关节执行参数实现分拣。

3 视觉系统与图像处理

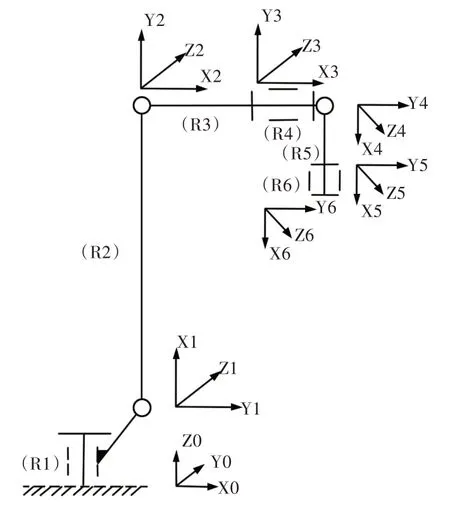

3.1 视觉系统与工作原理

视觉系统由图像采集装置、图像处理系统、机器人分拣工作站和控制通讯传输系统组成。图像采集由光源、镜头和相机组成[7],其中光源采用环形白色光、相机像素1.3万;图像处理系统采用Halcon机器视觉处理平台,将处理结果通过C#混合编程转换至VS2010 的Winform 窗体,经TCP/IP 通信至MCGS 界面中予以显示和统计,如图4所示。

图4 视觉处理流程Fig.4 Visual Processing Flow

工作时,输送带将不同种类的流通商品经过光电传感器时,触发传感器信号输出,相机实时拍照,将图像发至Halcon处理平台,经过RGB灰度转化、HSV转换、阈值分割、连通域闭运算、特征提取、数据库匹配解码、显示等过程,提取包装上外观和条码信息,将求解算法以C#格式输出至VS2010窗体,同步至人机界面上显示类型并计数,机器人完成分拣。

3.2 图像处理

上述环节中,图像采集前需调整好光源和相机目标区域一致,消除因输送带干扰拍照效果,拍照帧数大于输送带运动频率。将采集的RGB图灰度转化成灰度图和HSV图,显化颜色判别和提取特征[8−9]。

特征提取重点是从得到的HSV 图中选取比较明显的灰度图,通过阈值分割和连通域运算后,提取轮廓和条码区域,难点是轮廓的拟合与EAN条码解码,将求取的数值与已知数据库比对,匹配出训练集的最佳值。机理如下:

3.2.1 灰度转化

式中:(fx,y)—待处理的数字图像;

g(x,y)—处理后的数字图像;

T—定义了f的操作。

3.2.2 阈值分割(最大类间方差法)

将灰度值为i∈[0,L−1]的像素定义为ni,则:

各灰度值出现的概率为:

对于pi有:

把图像像素用阈值T分成A和B两类,A由灰度值在[0,T−1]像素中组成,则B在[T,L−1]像素中组成,概率分别为:

用u表示整幅图像平均灰度,所属的区域A、B的平均灰度分别:

区域总方差为:

式中:N—灰度值;

P—概率;

u—平均灰度;

—区域总方差。

让T在(L−1)区间内取值,使最大的T即为最佳区域阈值,图像处理效果最佳。

3.2.3 Canny边缘

Canny边缘检测算子是一种具有较好边缘检测性能的算子,利用高斯函数的一阶微分性质,把边缘检测问题转换为检测函数极大值的问题,能在噪声抑制和边缘检测之间取得较好的折中[8]。

式中:f—图像数据;

H—省略系数的高斯函数;

G—滤波后的平滑图像。

垃圾外包装的条码图像处理过程,如图5所示。可正确读取并显示结果文本。

图5 图像处理流程Fig.5 Image Processing Flow

3.3 MCGS界面设计

为便于结果可视化,将图像分析结果在MCGS人机界面上实时显示[9]。

将Halcon 平台上算法以C#格式导出,同步至VS 2010 的Winform 窗体下,通过TCP/IP 通信协议下载到MCGS 人机界面,实现垃圾种类和数量可视化,如图6所示。

图6 通信调试界面Fig.6 Communication Debugging Interface

4 试验与分析

4.1 试验材料与环境

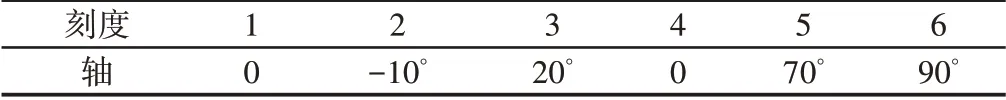

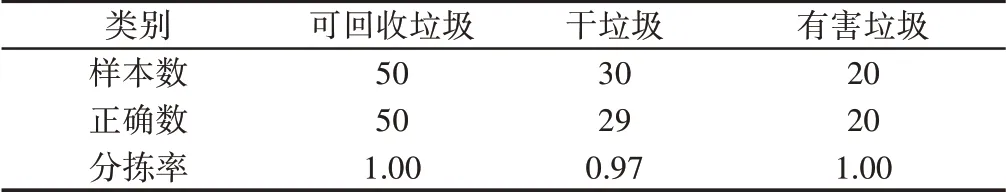

试验样本来自某超市售卖的流通商品,外包装表面均有条形码,根据垃圾分类标准,试验获取流通商品数据库含4765种垃圾信息,因各类垃圾基数相差较大,分别选取可回收垃圾50种、干垃圾30种和有害垃圾20种,长宽高或直径尺寸均小于100mm,随机混装在试验用托盘中,如图7所示。

图7 试验环境Fig.7 Test Environment

4.2 机器人系统初始化

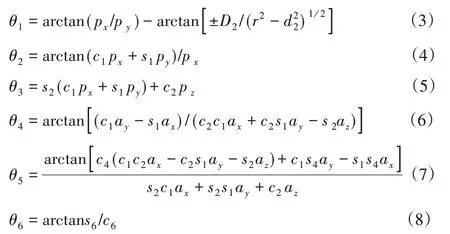

调试前,将机器人初始化[8]。设置机器人校准位置,使霍尔传感器信号为0,其他位置为1,各轴显示刻度,如表2所示。根据右手法则新建工具坐标系Tool 1,使原点位于夹爪中心,Z轴垂直于法兰盘端面。

表2 机器人各轴校准刻度Tab.2 Calibration Scales for Robot Axes

4.3 试验结果

设置输送带在V=100mm/s速度下,对3类共100种垃圾进行随机分拣测试结果,如表3 所示。可知测试中机器人分拣率达97.0%以上。采集条码与数据库匹配平均时间0.002s,表明本设计具有较高的准确性与稳定性。

表3 试验结果Tab.3 Test Results

5 结语

以Halcon机器视觉为载体的ABB机器人运动控制平台,对流通商品外包装垃圾进行实时分拣。

介绍了系统组成与工作原理,求解了IRB1410机器人本体的逆运动学方程,优化了视觉系统图像处理的技术流程,包括图像采集、灰度转化、阈值分割、流通域和匹配解码等,采用Canny算法改善边缘信息处理效果,设计了Winform 窗体和MCGS 界面,通过上位机串口通讯的方式将分析结果输出给机器人,执行末端实现精准分拣。

经试验,本系统分拣率达97.0%以上,表明该系统可达较高的准确度和可行性,在实际工程中具有一定的推广价值。