基于雷视一体机的交通流数据采集系统设计

2022-03-30刘元昊刘杲朋张瀚坤荆林立樊兆董

刘元昊,张 昱,刘杲朋,张瀚坤,荆林立,樊兆董

(1.山东高速建设管理集团有限公司, 济南 250014;

3.山东省路域安全与应急保障 交通运输行业重点实验室,济南 250031)

0 引言

改革开放40多年来,随着我国交通事业的发展,构建快速、高效、绿色、安全的现代高速公路已得到业内专家的广泛认可,也成为我国现阶段交通事业发展的主要任务。综合来看,高速公路面临的交通流量激增、高速交通拥堵、交通事故等突发事件方面的压力,已经成为制约交通发展的重要因素。为此,研究高速公路实时交通流数据采集技术可有效获取动态路网的第一手数据,为道路管理者进行宏观管控、科学规划奠定数据基础;建设交通流数据采集系统是构建智慧交通的关键步骤,也是在未来实现自动驾驶的重要保障。

在交通流数据采集技术方面,国内外学者研发了多种交通流数据采集方法,在实际应用中均存在局限性,如文献[1]使用微波雷达对交通流数据进行采集,此方法有几个显著的不足:其一,雨雪天气会对雷达信号进行干扰,导致所采集数据准确度下降;其二,雷达仅能获取每个被检测目标的质心位置,无法获取其大小和范围,因而导致该方法无法对道路上的车辆与其他物体进行准确区分。为克服雨天对雷达信号的干扰,文献[2]在上海市建立了加入了雷达信号处理算法的雷达采集系统,通过对雨滴反射的雷达信号进行分析,建立当前雨量集群模型,从而有效减轻反射雷达信号中雨杂波的影响。为获取道路车辆车型信息,文献[3]使用摄像机对纽约市交通流数据进行采集,然而在雨天时图像质量严重下降,无法采集有效信息。为克服雨天影响,文献[4]在使用摄像机采集数据的基础上加入了图像处理算法,抵消了部分雨滴影响,提高了图像质量,然而此方法算法复杂度较高,且算法准确度在不同降雨强度下不稳定。文献[5]采用红外摄像机对东京城市道路信息进行采集,此方法虽可通过检测温度较高的车辆轮胎来确定车辆位置信息,但无法有效获取车辆车型信息与非车辆目标信息。文献[6]通过激光雷达与kalman滤波算法,达到了对帕尔马市道路目标精确检测与对其运动信息的精准获取,但是因激光雷达所发红外线波长较短,传播距离受不良天气影响较大,导致该方法在不良天气下准确度较低。文献[7]在长春市建立的数据采集系统使用基于CCD摄像机内部参数标定的方法对车辆进行了调焦,但因实际距离与像素坐标非线性,导致该系统在测量较远距离目标时误差较大。文献[8]使用雷达与摄像机共同采集交通流数据,先使用雷达对路段整体进行扫描,将扫描到目标的区域通过摄像机对其视频图片进行采集与分析。此方法既能获取车辆运动信息,又可对被检测目标的车型进行识别。但因此方法所用摄像机为单目,摄像机本身无法获取车辆距离信息,仅靠雷达采集车辆数据,雨雪天气准确度较低。

在交通流数据采集系统应用方面,国内自主开发的检测装置主要侧重于交通执法,而以增加公路系统运行效率、维护运行安全为目的的系统应用还较少。因此,尽管在道路检测体系方面已经有了一定的投入,但系统尚未完善。如文献[9]在延庆至崇礼高速公路设计的路况感知系统,虽同时使用了雷达与视频对道路信息进行采集,但没有进行数据融合,所采集雷达与视频数据未能进行目标同步,致使单车运行数据的采集种类较少。文献[10]通过激光、毫米波雷达与全景相机建立了一种交通数据采集系统,证实了基于多传感器融合的交通数据采集系统,其目标识别精度高于单一传感器,然而该系统对融合后数据的优化处理步骤较少,其精确度仍有提升空间。

本文通过自主研发的雷视一体机对交通流信息进行采集,既能通过毫米波雷达获取车辆位置、速度等信息,又可利用双目相机特性,以三角测距与帧间测速等方法获取目标车辆运动数据,通过雷视数据的双向最优估计算法进行计算,不仅克服了不良天气下单一雷达测速准确度下降的问题,也增加了单目相机测速的准确率,大幅增加了交通流数据采集的可靠性。

1 系统总体方案

本文设计开发的系统采用端-边-云分级传输的物联网架构,系统架构见图1。在前端,使用雷视一体机对道路车辆的雷达数据与视频数据进行同步采集;在边缘端,首先对雷达与视频信号分别进行数据提取,并对视频中车辆进行CNN车型识别算法,提取目标车辆车型信息。然后对目标车辆的运动数据与位置信息进行基于Kalman滤波器的一维数据最优估计,提高数据精确度。再对依据雷达数据所在的极坐标系与相机数据所在的相机坐标系间的空间关系,以及因二者传感器采样时间不同所导致的采用时间关系,对雷视目标进行匹配验证,从而提高传感器可靠性。最后,以视频图像作为传感器的主体,将雷达发送到云端中的整体图像信息进行视频图像特征层的转化,然后与其他视频图像进行融合之后再发送到云端。

图1 系统整体结构示意图

2 系统硬件设计

2.1 前端设备选型

系统前端主要由雷视一体机组成,布置于被观测路段的主要交通节点处,用于采集道路车辆的雷达、视频数据。

雷视一体机主要包括毫米波雷达与监控相机,毫米波雷达具有较高精度的多维搜索测量功能,可对正常运行中车辆的距离、方位、横/纵向速度与加速度、空间位置等信息进行准确高精度的检测与定位;双目相机主要用于实时记录汽车的流量和行驶情况,并通过视频信号处理软件逐帧地分析视频图片以便于提取出车辆在道路上的行驶轨迹,进而通过推算获得车辆位置、横/纵向速度与加速度等信息。

本交通流数据采集融合系统主要采用BY-VD300型毫米波辐射雷达,与普通大型超声波雷达监测设备相比,本系统在大幅节省设备体积的同时,保证了自身高分辨率,与红外、激光等多种新型光学雷达传感器检测技术设备相比,毫米波遥控雷达在其对雾、烟、灰尘等多方面的抗穿透检测能力更强,并且同时具备了全天候、全时段监测的重要功能。另外,毫米波辐射雷达也具备高抗干扰能力,是因为毫米波在传播时比其他光波衰减更小,在自然光和其他热辐射影响下损耗更低;和其他微波雷达相比,毫米波雷达元器件的体积更小,更易与其他设备进行结合,且信号抗干扰性更强,稳定性更好。

本系统使用的监控相机为SmarterEye S1CG双目相机,利用左相机与右相机对于同一点观察的视差不同,通过三角形测距原理,再结合内部参数,对相机到该点的距离进行计算。与单目相机需要基于巨大的场景样本库对目标物的距离进行估计相比,测距精度会明显提高。

2.2 边缘端设备选型

系统边缘端主要由边缘计算机及配电柜组成,布置于被观测路段道路的中心地带,用于收集前端雷达视频数据,并进行初步数据处理。

边缘计算机型号选用ECX-1400型工控机,因其包含3个SIM插槽、6个3.1USB端口、4个RS-232/422/485串口、32路独立数字输入/输出通道,可适配接口丰富,符合科研需求。

3 系统软件设计

3.1 软件界面设计

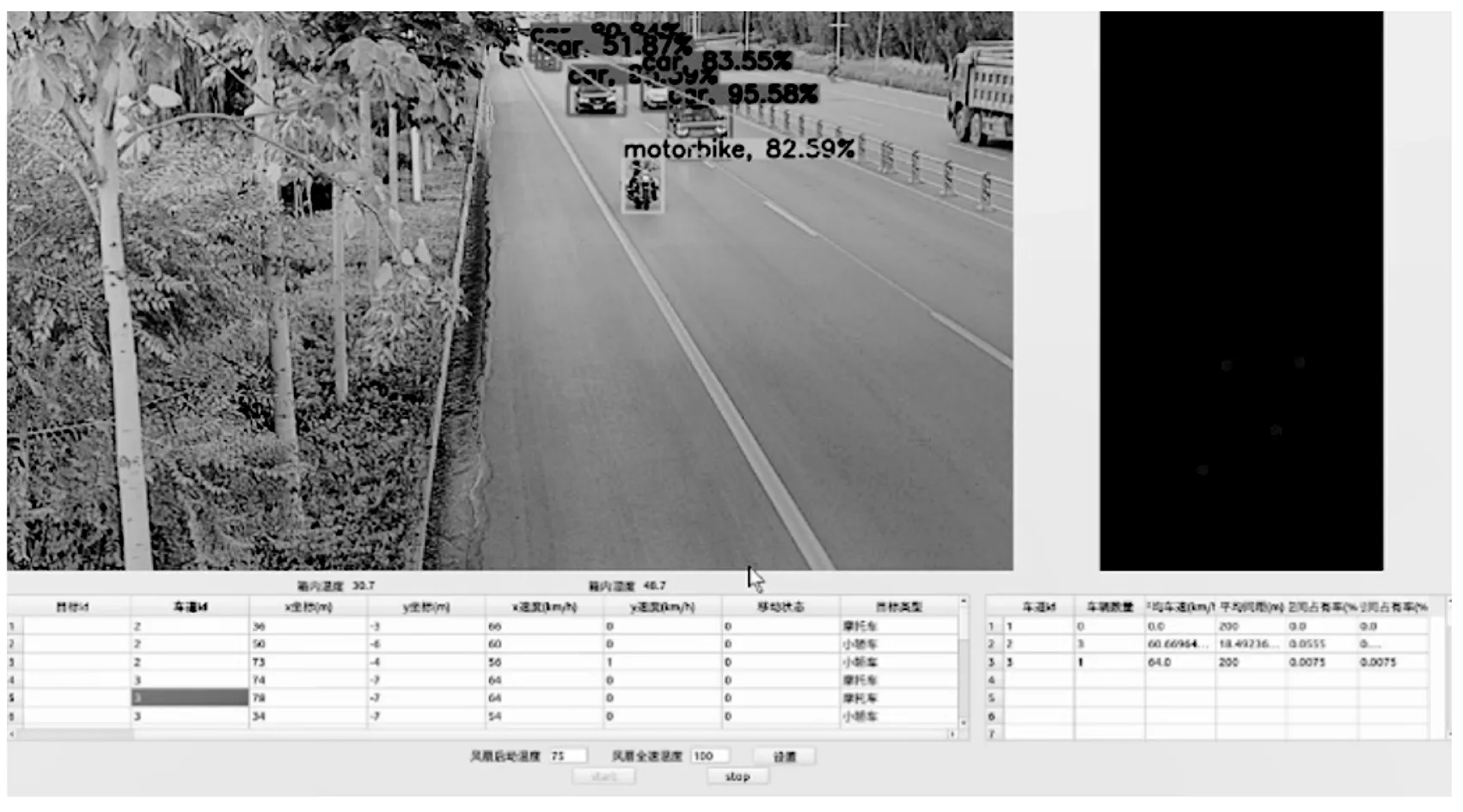

监测软件界面如图2所示,其中‘设置’、‘start’、‘stop’3个按钮分别用于用户对本系统进行初始标定、下达开始运行与停止命令。左上角模块为雷达与视频信息特征级融合后的图像,目标上方文字为目标车型及可信度,右上角模块为车道级精度雷达检测图像,左下角为每个目标的种类及运动信息,右下角模块为每个车道的平均车速、车头车尾间距、时间占有率、空间占有率等数据。

图2 软件界面

3.2 软件功能设计

3.2.1 毫米波雷达数据提取功能

雷达传感器的工作原理是向周围物体发射高频电磁波并接收回波,通过计算电磁波反射的时间即可获取被测目标的距离。当雷达与目标间存在相对运动时,雷达回波将产生多普勒频移效应,故对比电磁波反射前后频移量,即可获取被测目标速度。

本系统所采用毫米波雷达为调频连续式(FMCW),此类雷达通过采集并比较所发射高频连续波与回波间的时差序列,再经过雷达混频器进行计算,即可获取目标位置、速度等信息。

1)目标距离提取:

对FMCW雷达所发射的毫米波电信号进行三角变换,发射信号为接收信号在时域中时移△t后所产生的镜像,滞后时间△t与目标距雷达相对距离R的关系为:

(1)

其中:c为光速,△f(见图4)为混频输出频率差,T为雷达扫描的时间周期,ΔF为信号带宽,由图4对被测目标与毫米波雷达间距R进行计算:

图4 双目相机模型立体视图

(2)

2)目标速度提取:

雷达检测移动目标时将引起多谱勒频移,频移量为fd,发出和回波中的中频频率可分别表示为:

Fb+=△f-fd

(3)

Fb-=△f+fd

(4)

式中,△f代表中频频率;fd表示多谱勒频移,式(3)和式(4)可推导出雷达与目标间相对运动速度,其表达式为:

v=λ(Fb--Fb+)

(5)

3.2.2 双目相机数据提取功能

1)目标距离提取:

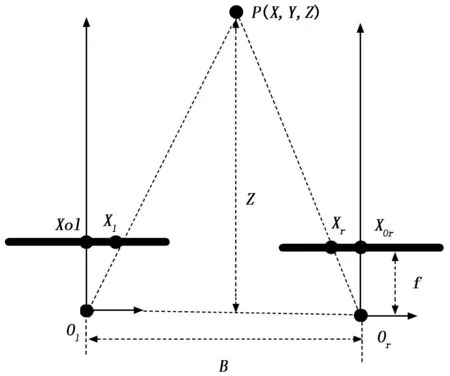

由于本系统使用的前端视频采集设备为双目相机,可对被检测目标进行精准测距。双目测距是利用左相机与右相机对于同一目标点的视差,通过三角形测距原理,对相机到该点的距离进行计算。而传统单目相机需事先采集巨大的场景样本库,才可对目标距离进行对比估算,且测距精度不足。双目测距的原理如图3所示。

图3 双目相机成像模型俯视图

双目相机左右目光心分别为Ol和Or,表示光心间距为B。两光心X轴坐标分别为XOl与XOr。使用前需通过标定确保左右目相机焦距均为f。设P(X,Y,Z)为空间中任一点,其y轴坐标在左右目相机成像平面内相同,其x轴坐标分别为Xl和Xr。由相似三角形原理可知,距离对应关系为:

(6)

对式(6)进行变换后可求得P点Z坐标为:

(7)

(8)

(9)

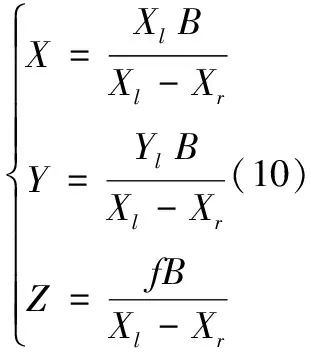

在式(3)与式(4)中代入式(2),即可求得P点X、Y、Z三维坐标:

其中:f为摄像机焦距,Xl-Xr为左右相机视差。

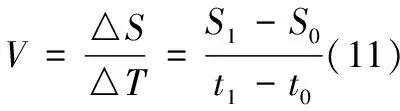

2)目标速度提取:

式中,V为车辆在两帧间隔的速度,△S为车辆在两帧间运动的距离,△T为两帧间隔时间,S1,S0为车辆在对应帧的位置,t1,t0为两帧的采集时间。

根据视觉相机的采集频率等参数,既可获取两帧图像的间隔时间和间隔帧数,计算两帧间隔时间△T后,结合两帧车辆前后位置,即可获取车辆行进距离△S,代入式(11)既可求得车辆速度V。

3.2.3 基于深度卷积神经网络的车型识别功能

考虑到雾端运算特点,本系统所采用车辆类型特征提取算法选用深度卷积神经网络(CNN)技术,以双目相机所采集的原始图像作为输入,通过训练自主学习特征描述,简化特征模型,缩短运算时间,提高系统效率。

鉴于算法应用场景为高速公路,在此场景中车辆外观表现形式复杂,且由于相机实际布设角度与环境光照变化等因素会引起图像中车辆参数的变化,加大识别难度。通过卷积神经网络可对识别并抵消物体移动、缩放等参数变化,能较好克服实际运用中可能出现的各种问题。算法流程图如图5所示。

CNN特征学习模型参考文献[16]基于深度卷积神经网络的车型识别算法,该算法通过五层CNN网络通过图像对目标车辆车型进行识别,见图6,算法输入层为图中第一层I,将灰度图像作为输入。卷积层C1包含Ni个5×5滤波器,偏置为bi。进行卷积运算后,即可得到Ni个特征图像。第三层S2为下采样层,对与目标图像相邻的进行加权运算,权值为Wi+1。然后将运算结果与偏置bi+1的和作为Sigmoid激活函数的输入,即可得到6个21×21大小的特征图,再通过下采样,可获取尺寸为58 ×46的特征图;网络卷积层C3包含与第二层相同的滤波器12个,每个滤波器均可生成一个54×42像素的特征图片,最终通过下采样层S4对所生成图片进行下采样,生成一列由12张27×21特征图片组成的特征向量。

图6 CNN网络构建过程

对该神经网络的训练过程分为正向传播与反向传播,其中正向传播指将训练集直接输入至CNN网络,分析输出;反向传播指筛选分析输出错误的案例,通过反向传播算法逐层传播误差,并更新各层权值。

网络的分类识别功能采用了在图像识别领域稳定性与通用性较强的SVM分类器,以此对本系统算法特征提取有效性进行验证。

3.2.4 基于Kalman滤波器的一维滤波估计

由于设备精度有限,所采集信息将出现一定测量误差,且由于不良天气与设备老化问题,会导致测量数据中出现异常与缺失值。因此,为使传感器所测量的车辆运行数据更加精确,可利用基于Kalman滤波器的最优估计算法,将雷达与视觉相机测量到的车辆横纵向速度、加速度、车头车尾间距等数据进行最优估计,以提高测量精度。算法结构如图7所示(其中蓝色箭头为反馈)。

图7 最优估计算法结构

在初始时刻t0时,输入传感器初始测量值视为初始预测值;将初始预测误差设为习惯值,通过比较测量误差与预测误差可以量化测量值与预测值的可靠程度权重,即为卡尔曼增益K,以此增益对测量值与预测值进行加权,即可获取系统当前时刻最优估计值。

在下一时刻t1时,可通过前一时刻t0输出的最优估计值来生成下一时刻的预测值,并根据t0时预测误差与K来得到当前时刻t1的预测误差,然后用与上一时刻相同的方法生成当前时刻的最优估计值。

算法将随着时间而不断优化,从而在一段适应时间过后稳定输出准确度高的最优估计值。

3.2.5 雷视目标时空匹配

1)空间匹配算法:

空间匹配算法可将毫米波雷达检测到的空间中任一点,准确地投影至照片在相机所采集的图像平面上。该算法首先借助张正友的相机标定方法,结合相机内部和外部的参数值进行畸变矫正,将真实世界坐标系中的点、线、面、体在图片坐标系中进行一一对应,再结合相机外部参数将目标点位在像素坐标系中进行还原。最后通过毫米波雷达和相机安装位置的相对关系计算雷达坐标系与真实世界坐标系之间各点、线、面的转化关系。毫米波雷达、世界与相机坐标系间转换如图8所示。

图8 毫米波雷达、相机和世界坐标系位置关系

图8中,毫米波雷达坐标系为Or-XrYrZr,世界坐标系为Ow-XwYwZw,相机坐标系为Oc-XcYcZc。Z0、Z1为三坐标系的Z坐标,H为三者的Y坐标。其中雷达极坐标系P(R,α)与相机三维坐标系P(Xc,Yc,Zc)转换关系为:

(15)

改写为矩阵形式为:

(16)

P点畸变矫正前的坐标P(x,y)为:

(17)

结合相机内外参数对图片进行去畸变后的图像坐标P(x′,y′)为:

(18)

P点实际像素位置坐标P(u′,v′)为:

(19)

依据张正友标定法,可得到该雷达极坐标下目标在二维图像坐标系下的投影坐标,实现雷达坐标系P(R,α)向像素坐标系P(u′,v′)的转换。

2)时间匹配算法:

在完成雷视信息空间融合后,因各传感器采样时间不同,还需对其进行时间融合,如毫米波雷达采样帧速率为20帧/秒,而视觉相机为25帧/秒。为保证时间同步,故取视觉相机帧率为模板,将视觉相机所采集的每帧图像,与毫米波雷达的缓存数据融合。

3.2.6 雷视数据联合估计

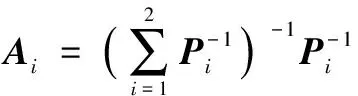

为进一步提高数据采集准确度,本系统采用雷视数据联合估计算法,对不同传感器针对相同目标的测量值进行基于集中式无偏估计的联合估计算法。

设定双目相机与雷达的车辆运动数据测量模型为:

yi(k)=Hix(k)+wi(k),i=1,2

(20)

(21)

其中:Ai为最优加权矩阵,计算方法为:

(22)

其中:Pi为单传感器误差方差阵。双传感器最优融合误差方差阵P0为:

(23)

代入式(21)可得集中式无偏估计结果:

(24)

其中:

(25)

(26)

(27)

4 实验结果与分析

为了验证本系统中的车辆识别算法与数据提取算法,分别在早午两个时段在港西路路侧进行了30分钟的测试,以验证该系统的准确性。测试步骤如下。

1)设备安装:将雷视一体机安装于道路一侧,调整安装角度,连接边缘计算机。

2)设备标定:测量被测路段车道宽度与相对雷达位置后,通过上位机对雷达坐标系中的车道位置进行标定,对双目相机中的车道起止像素进行标定,使系统得以区分不同车道交通流数据。

3)数据采集:在边缘计算机中运行系统,对被测路段交通流数据进行采集,试验视频单独保存,用于后续统计分析和校正。

4)数据分析:在不同车速情况下重复上述步骤,记录并统计实验数据(表1)。

表1 交通流数据采集融合系统路测结果

由上表可知,在不同交通量状态下,本系统均可保证 95% 以上的正确统计率、 97% 以上的测速精度以及90%以上的车型识别准确率。

车辆车型实测数据通过人工计数获得,为了保证计数的正确性和试验的严谨性,本研究制定了统一的车型分类原则,由5名团队成员分别观看试验视频并进行人工车型统计。

为验证本系统车型识别算法的准确度与优越性,引入另外两种基于人工特征提取的图像识别算法对试验数据进行了处理,分别为方向梯度直方图(HOG)与Gabor特征训练的SVM支持向量机,实验结果如表2所示,可以看出,本文所用CNN算法对各车型识别的精确度均远高于传统人工特征提取算法。

表2 车型识别算法测试结果

对本文所用CNN方法的部分错误样本如图9所示,分析后发现问题如下:

图9 错误分类部分样本图片

1) 由于部分电动车设有挡风被,致使算法无法对电瓶车整体进行识别,仅将前轮部分识别为自行车,导致了误判。

2) 由于部分货车体型较大,易被其他车辆遮挡,导致算法未对车辆整体图像进行识别,从而导致误判。

3) 由于训练集中吉普/越野车较少,导致系统对该车型识别精度不高,导致了误判。

5 结束语

本文基于雷视一体机与边缘计算技术,通过雷视数据融合、神经网络车型识别、数据最优估计等算法实现了高速公路交通流数据采集融合系统。本系统主要针对雷达与监控相机的数据采集原理,结合交通工程中对交通流数据的分析需求,提出针对各类数据的采集与最优估计方式。针对车辆速度、位置、加速度等数据,系统先分别利用雷达与双目相机进行采集后,使用Kalman滤波器进行一维最优估计,再对二者估算值进行联合估计以提高数据准确度;针对目标车辆车型数据,系统使用CNN对目标图像进行特征提取后,采用SVM向量机获取目标车型。最后,将各种数据在软件界面中进行集中显示。本文也存在一定局限性,如图像识别算法对被遮挡车辆和各别车型识别的精度不高。计划在未来的研究中,针对目标未被遮挡的部分,采用多尺度特征融合或数据增强算法,通过对遮挡物的种类进行预判断,以训练库中标准车型为基准,重构车辆被遮挡部分,增加被遮挡车辆的识别精度和效率;针对识别精度不高的车型,扩充对应车型训练集,提高CNN目标特征提取准确性,增加系统可靠性。