基于多流网络一致性的视频显著性检测

2022-02-24陈程立诏

宋 佳,陈程立诏

(青岛大学计算机科学技术学院,山东青岛 266071)

0 概述

视频显著性物体检测旨在提取人眼最感兴趣的目标区域,并在动态场景中将其与背景分离[1]。视频显著性物体检测作为计算机视觉的预处理步骤,被广泛应用于视频质量评估[2]、目标跟踪[3]、视频压缩[4]等领域。

目前,图像显著性物体检测研究比较深入,但视频显著性物体检测依然面临巨大挑战,其原因是视频显著性物体检测不仅考虑视频中单帧图像的空间特征,还考虑受时域上运动特征的影响[6]。根据人体视觉系统特点,人眼对正在运动的物体更敏感,因此将己有的视频单帧图像显著性检测方法与视频序列的运动信息相结合能够有效提高显著性检测精确度。随着深度神经网络的发展,许多研究[7-8]已经将卷积神经网络运用到视频显著性检测领域中,而运动信息也作为一个重要因素被考虑在内。研究表明,将运动信息嵌入网络的优势,一方面减少问题域并屏蔽非显著的背景区域,例如当视频场景中的背景复杂且多样时,人们仅依靠颜色信息难以识别显著性物体,但运动信息可以突出显著性物体的位置信息,另一方面提供了空间连贯性的基本提示,即具有相同位移的图像像素属于同一区域的概率较高[7]。

对于运动信息的提取,通过设计有效的网络结构来实现,如单流网络和双流网络[6]。单流网络中运动信息的提取依赖循环卷积[8],循环卷积一般以长短期记忆(convLSTM)[9]模型为代表,通过提取长期时序信息以实现具有强时空一致性的较优检测。然而,convLSTM 模型因过度依赖长期的时序一致性,当连续多帧出现误检时,当前帧的特征无法被相邻帧修复,导致其存在性能瓶颈。由于convLSTM 模型与单流网络都忽略了光流图[10]的空间信息,因此在单流网络的基础上增加运动分支的双流网络能够有效提取光流的空间线索[11]。

虽然双流网络的检测精度较高,但光流对光强度和局部变化敏感,当显著物体发生剧烈或慢速地移动时,导致运动估计准确率低和检测性能下降。针对以上问题,本文提出基于多流网络一致性的视频显著性检测算法(MSNC),在双流网络的基础上增加先验流,从而弥补光流信息的不足,同时通过多流一致性融合(MCP)模型优化多流分支,采用循环训练策略均衡三重网络的权重。

1 相关工作

1.1 传统视频显著性检测算法

传统视频显著性检测算法是以低级线索为主导,采用手工提取特征方式提取运动信息。文献[13]提出一种两级学习策略来提取长期时空线索。文献[14]设计一种简单的方法,即通过对框级物体进行排序和选择来识别显著物体。文献[15]提取空间和时间边缘信息,以增强显著物体定位。传统视频显著性检测算法是最基础的检测算法,其操作简便。由于运动场景的更新、目标尺寸的变化以及拍摄视角的切换,使得该类算法的检测准确率难以达到理想的要求,有待进一步提高和完善。

1.2 基于深度学习的视频显著性检测算法

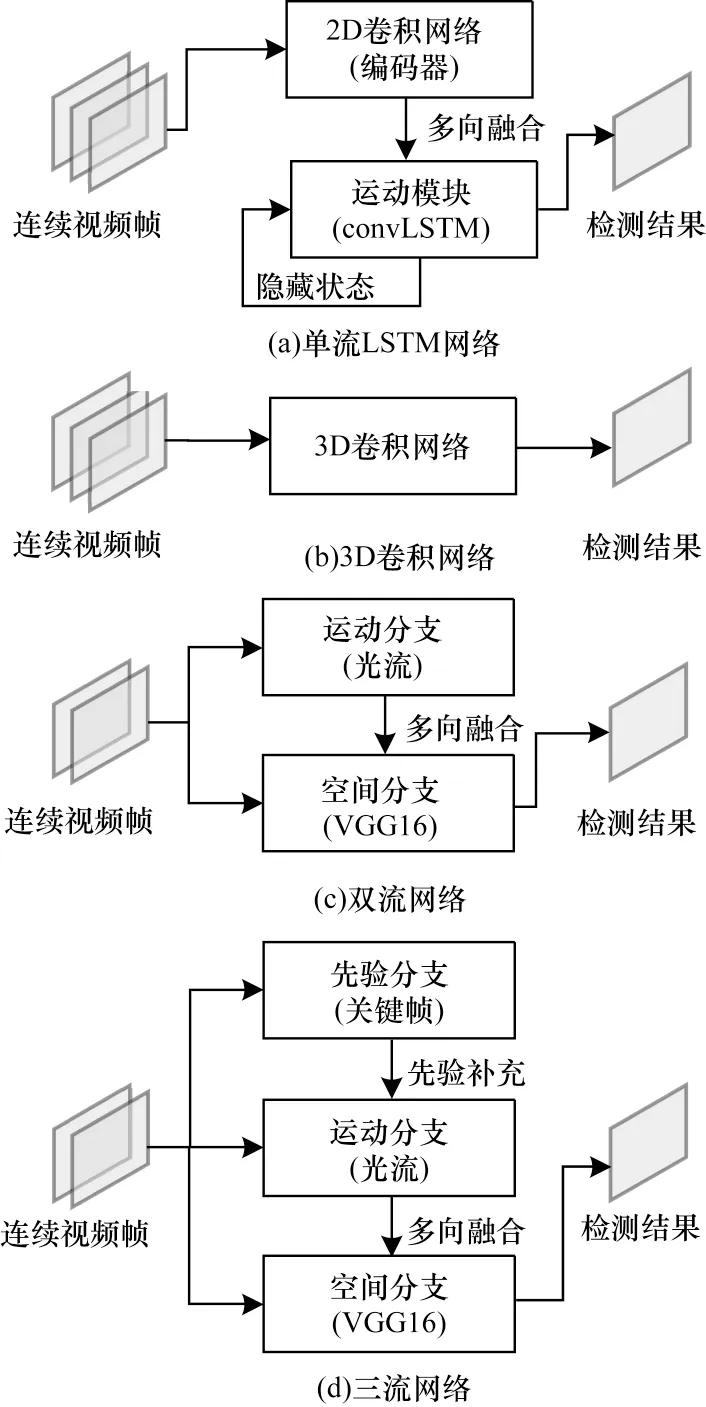

为弥补传统手工提取特征方式的不足,基于深度学习的视频显著性检测算法通过数据驱动自动提取特征,从而实现较高的精确度和较优的鲁棒性。视频显著性检测主流网络结构如图1 所示,按照网络结构不同,分为单流网络、双流网络、3D 卷积网络、三流网络。

图1 视频显著性检测网络结构Fig.1 Structure of video saliency detection network

单流网络以长短期记忆(Long Short Term Memory,LSTM)网络模型为代表,其结构如图1(a)所示。从图1(a)可以看出,连续帧作为输入,首先提取静态特征,然后利用LSTM 融合帧间信息,并间接获取时间序列线索。3D 卷积网络结构如图1(b)所示,其同时提取时空线索,避免出现时空信息分离的情况,减少了时间消耗。文献[16]设计一个端到端的3D 框架以获取时空特征,该框架在编码器和解码器后增加了细化组件,主要原理是提取更深层的语义信息来细化时空显著图。文献[17]提出一种基于全卷积的网络,采用分阶段的方式进行显著性检测。全卷积网络首先预计算空间显著图,然后融合该空间显著图和连续帧以产生最终的时空显著图。为扩大感知范围,文献[18]采用基于光流的映射关系将长期时序信息添加到当前视频帧中。文献[19]提出一种新的方案来感知多尺度时空信息,采用多孔空间金字塔池化[20](Atrous Spatial Pyramid Pooling,ASPP)提取多尺度空间显著性特征,随后将这些特征送入双向convLSTM 网络中,以获取长期和多尺度信息。文献[21]提出一个注意力转移基线,同时开源了针对视频显著性检测问题的大规模注意力转移数据集。

双流网络结构如图1(c)所示,以MGA[7]为代表,光流和静态图分别作为两个分支的输入,之后单个分支对特征信息进行多向融合以得到最终检测结果。其主要原理是利用运动信息定位显著物体,同时提供颜色特征的通道权重。此方法的检测性能虽优于许多单流结构,但其显著结果极易受光流质量影响。若视频中运动模式出现快速运动或静止的情况,光流信息可能会无作用甚至产生负面作用。针对以上问题,本文提出多流网络一致性检测算法(MSNC),如图1(d)所示,利用先验分支弥补低质量的光流分支,将融合后的分支作用于空间分支,以得到最终的显著图。

2 MSNC 算法

2.1 MSNC 算法及网络结构

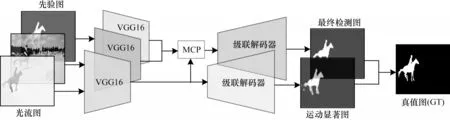

MSNC 算法使用三重网络对提取的信息进行检测,即在双流的基础上增加先验流来弥补运动流的不足,同时实现多流的多向融合互补,采用循环训练策略避免网络产生过拟合现象。MSNC 算法主要分为4 个步骤:1)利用空间子网提取颜色信息;2)利用运动子网提取时序信息;3)利用先验子网提取先验特征;4)利用多流一致性融合模型多流信息,并生成最终的显著图。

MSNC 网络结构如图2 所示。该网络由空间子网、运动子网、先验子网以及MCP 模型组成。三重分支都采用卷积神经网络提取预选目标区域特征,使用VGG16[22]前5 层卷积层作为编码器,其中空间分支和运动分支采用相同的网络结构,均由编码器和级联解码器构成,分别输入静态图片和光流图。相比三重分支和空间分支,先验分支仅包含VGG16[22]基础网络的前5 层结构。此外,经MCP 模型融合后的特征输入到级联解码器中,进而融合多级特征以生成最终的检测图。

图2 MSNC 网络结构Fig.2 Structure of MSNC network

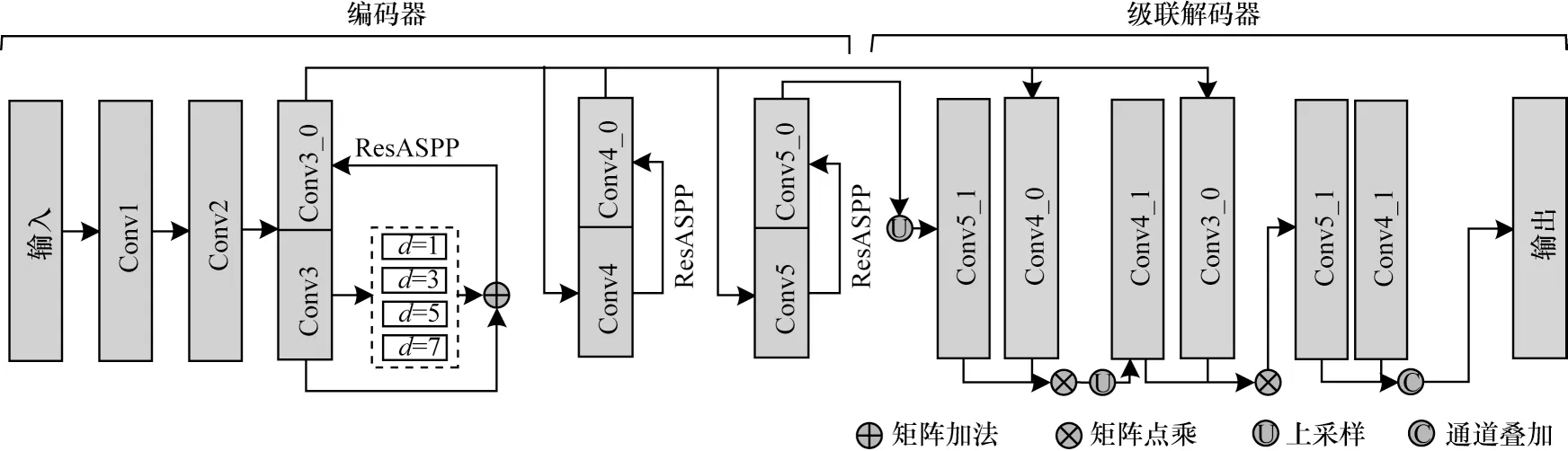

2.2 外观子网

对于卷积神经网络,浅层网络提取边缘和细节信息,其深层网络提取语义和位置信息。本文使用级联网络融合多级特征,使得网络更关注显著物体,通过引入注意力机制来增大位置权重。空间子网的结构如图3 所示。本文采用级联方式融合多层信息,以降低前2 层卷积的利用率来加快运行速度,以VGG16 作为基础网络进行特征提取,该过程分别使用残差空洞卷积池化金字塔(ResASPP)在Conv3、Conv4、Conv5 这3 个卷积层上提取多尺度特征。ResASPP 模型由ASPP[20]和一个残差连 接[23]构 成。ASPP 由4 个平行的分支组成,首先将特征通过1×1卷积降维到通道数C为32,对于每个分支都使用空洞卷积,膨胀率分别是1、3、5、7,然后分别用3×3 卷积统一到相同的通道数并进行叠加操作,最后通过残差连接得到新的特征信息。

图3 空间子网结构Fig.3 Structure of spatial subnet

新生成的多尺度特征以UNet[24]的形式进行融合,融合方式如式(1)~式(3)所示:

其中:Fi表示第i层卷积特 征;Conv(·)为卷积操 作;Cat(·)为特征在 通道维度的叠 加;Up(·)为上采样 操作;×为逐元素相乘。首先将第5 层卷积特征Conv5进行上采样操作,然后与第4 层特征Conv4 相乘得到F1特征,F1继续上采样与第3 层卷积Conv3 相乘得到F2特征,最后将融合后的特征在通道维度上进行叠加,得到融合后特征F3,再经过1×1 卷积降维,获得最终的显著图。

2.3 运动子网

目前,提取运动信息的通用技术主要以光流为代表,利用时域中像素的位移以及相邻帧之间的相关性建立前一帧和当前帧之间的关系。计算光流最先 进的方法包括SPyNet[25]、PWCNet[10],这些光流估计方法在检测精度和速度方面都具有较优的性能。

深度学习需要大量相关数据进行训练,但光流图缺少相应的像素级人工标注,在训练数据较少的条件下难以得到高质量的运动显著图[26]。为此,本文利用颜色真值图作为训练标签对静态图像模型进行微调,能够有效解决在小样本训练过程中的过拟合问题,首先,在光流网络中输入相邻视频帧,经过光流网络PWCNet[10]获得稠密的光流图;其次,对于每个光流数据,使用文献中的编码方式将2 通道的光流数转换为3 通道RGB 图像,之后将生成的3 通道光流图输入到运动子网中,以产生最终的运动显著图。为提高网络的泛化能力,本文在空间子网预训练模型的基础上,利用Davis 数据集2 000 帧来微调该模型,且将学习率设置为10-5,并使用二值交叉熵损失指导训练。

2.4 先验子网

先验网络由VGG16 前5 层网络构成,3 通道先验叠加作为网络输入。先验图的构成相对简单,因此,使用较浅层的网络就可以提取先验特征。在训练过程中,为保持训练数据和测试数据的一致性,输入网络的先验图不能直接用标签替代,而使用腐蚀后的标签。

2.5 多流一致性融合模型

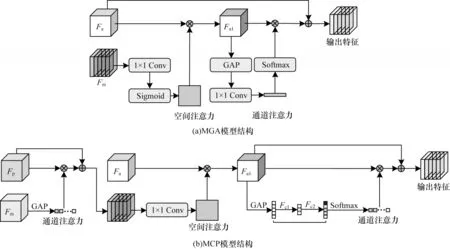

为获取三重网络的最优组合,本文提出MCP 模型,该模型通过融合三分支权重,使得三重网络具有一致性,MGA[7]和MCP 结构如图4 所示。其中:Fa、Fm、Fp分别为空间、运动及先验特征。

图4 MGA 与MCP 模型结构对比Fig.4 Structure comparison of MGA and MCP models

MGA 模型以空间特征Fa和运动特征Fm作为输入,Fm经1×1 卷积和Sigmoid 激活得到空间权重图,之后与Fa相乘得到Fa1。Fa1经过GAP 操作将新的特征降维后使用1×1 卷积及Softmax 函数得到通道权重,此权重作用于Fa1得到融合后的特征。MCP 模型首先对运动特征Fm进行GAP 操作,将其展成一个一维特征,然后经过2 层全连接操作更新通道权重,之后对更新过的权重进行Softmax 操作,使特征权重的值归一化为0~1,生成新的特征向量并作为权重,将其与先验特征相乘,从而保留运动特征与先验特征的一致性,并与原先的先验特征进行残差连接,进而将Fpm作为新的注意力权重与空间特征相融合。该融合过程首先使用1×1 卷积大小将C×W×H的Fpm特征降维到W×H的权重图,并增加Sigmoid 激活操作,并与空间特征Fa相乘产生新的特征Fa1,最终对Fa1进行GAP 操作降维成高维向量g1,经过多层感知机(Multilayer Perceptron,MLP)操作得到更新后的向量g3,MLP 比MGA 中的卷积操作更复杂,使网络更易保留有用信息。g3经Softmax 操作后作为Fa1的通道注意力权重,该权重向量与之前的特征Fa1相乘再加上最初的特征Fa以得到最终的输出特征。MLP操作过程如式(4)所示:

其中:g1为更新前高维向量;g3为更新后高维向量;为第i次全连接操作;σ为Relu 激活函数。

2.6 循环训练策略

三重网络中先验分支的输入作为三通道叠加的先验图,通过传统方法和深度学习算法生成先验图,其中传统方法[27-28]通过RGB 图的颜色对比生成粗略的显著图,深度学习算法是采用当前主流的深度学习检测模型的预测显著图作为先验图。这两种方法都属于外部干预,且得到的先验图受限于模型本身,很难找到先验图存在的共性,并对网络的训练造成干扰。因此,本文使用网络训练过程中生成的上一帧显著图作为当前帧先验图的输入,在训练过程中,将经过腐蚀处理的真值标签作为网络的输入,降低先验图在网络训练过程中的权重。网络的输入以每批大小为一个轮次,每次循环的第一帧使用腐蚀后的真值图,之后每次输入网络的先验图为上一帧所产生的显著图。以上训练策略生成的先验模式多样,可以避免网络出现过拟合现象。在测试过程中,先验分支首次输入高质量关键帧先验图,本文使用颜色显著图和运动显著图的一致性度量来选取关键帧,其中一致性度量使用S-Measure[29]进行计算。通常S-Measure 值越大,说明颜色和运动显著图的一致性越高,其主要原因是低质量运动显著图和颜色显著图完全一致的概率通常较低。因此,按上述方法确定关键帧所对应的颜色显著图(先验图)的质量通常较高。对于非关键帧,本文将上一帧或者下一帧的最终显著图作为当前帧的先验图输入,假设关键帧先验图是第i帧,那么第i帧先验图作为第i+1 帧的先验输入,得到第i+1 的最终显著图,第i+1 帧最终显著图又可以作为第i+2 帧的先验输入,后续依次传递。

3 实验

3.1 评价指标

为准确地评估模型的精度及鲁棒性,本文使用通用评价指标对显著图进行定量评估,包括F值度量(maxF[30])、平均绝对误差、结构度量(SMeasure[29])。

3.1.1F值度量

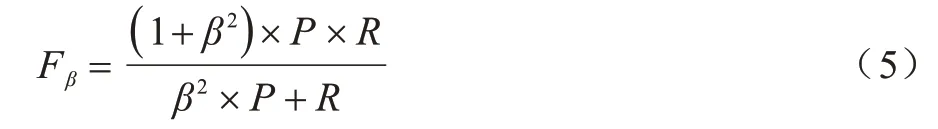

maxF 是准确率(P)和召回率(R)的综合评估,如式(5)所示:

在显著性工作[7]的基础上增加准确率的权重值,本文将β2设置为0.3,并且认为准确率比召回率更重要。

本文在计算准确率和召回率时,输出的显著图首先需要进行二值化,二值化阈值为0~255,大于等于阈值的像素值设为1,小于阈值的像素值设为0。本文将生成的255 张二值显著图与真值图进行比较,计算得到255 个准确率和召回率。准确率越高,说明有较多的显著区域被正确检测,并作为前景区域,召回率越高,说明显著区域覆盖真值图的前景区域越完整。

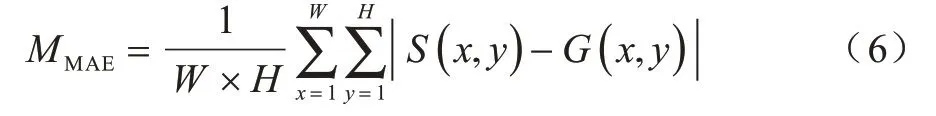

3.1.2 平均绝对误差

平均绝对误差能够直观地计算预测值和真实值之间的误差,如式(6)所示:

其中:W和H分别为图像的宽度和高度;S(x,y)为显著性预测图在像素点处的预测值;G(x,y)为像素点的真实值。

3.1.3 结构度量

结构度量被定义为评估非二进制前景图的结构相似性,用于评估基于区域和基于对象的误差,如式(7)所示:

其中:Sr为区域感知的结构相似性,将显著性图分为许多块,以评估物体部分的结构相似性;So为对象级别的结构相似性,用于评估考虑全局的相似性;×表示像素间的乘法操作;α通常设置为0.5。

3.2 数据集

在深度学习中,视频显著性检测通常需要较多的数据集以验证实验的有效性,研究人员对数据集进行标注,评估显著性算法的性能。目前常用的数据集主要有以下5 类。

Davis 数据集[32]是视频任务中通用的数据集,包含3 455 帧数据,其中训练数据集包含2 076 帧,测试数据集包含1 379 帧,每段视频都能够提供稠密的人工标记的标签。

Segtrack-v2 数据集[33]包含丰富的运动模式,如快速运动、剧烈形变等,其中显著物体偏小,当背景发生轻微运动时,使得检测变得更困难。

Visal 数据集[34]只 有17 段视频(193 帧),每 隔5 帧给出像素级人工标记,运动模式较单一,一般以慢速运动为主。

Davsod 数据集[21]不仅是最新提出的大型视频显著性物体检测数据集,而且是第一个与人眼注意力相关的数据集。根据检测难度不同,该数据集分为简单、正常和困难3 个级别,共有2.4×104的数据,同时提供相关的眼动注视点及实例级标注。

Vos 数据集[35]共有7 464 帧视频数据,包含较多的室内场景,且多数为静止及相机晃动的情况。

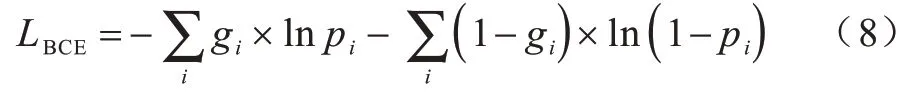

3.3 损失函数

本文所有训练过程的损失函数都使用二值交叉熵损失,其具体实现如式(8)所示:

其中:gi为真值图第i个像素值;pi为预测图第i个像素值;×为逐元素乘法;ln()为对数函数。

3.4 实验环境与参数设置

本文所有实验使用Pytorch 深度学习框架,在RTX2080Ti 工作站上进行训练。此外,为减少时间消耗,网络所有的输入都下采样到352×352,BatchSize 设置为5,参数学习率为10-5,使用Adam[36]优化器,训练迭代次数设置为20。本文采用多阶段训练策略对多流网络中的空间和运动分支进行预先训练,进而再微调多流网络。除使用Duts10000的图片显著性数据集以外,所有的分支和融合模型仅使用Davis 训练集中2×103张图片来进行训练。

4 实验结果分析

4.1 消融分析

4.1.1 多流融合的有效性

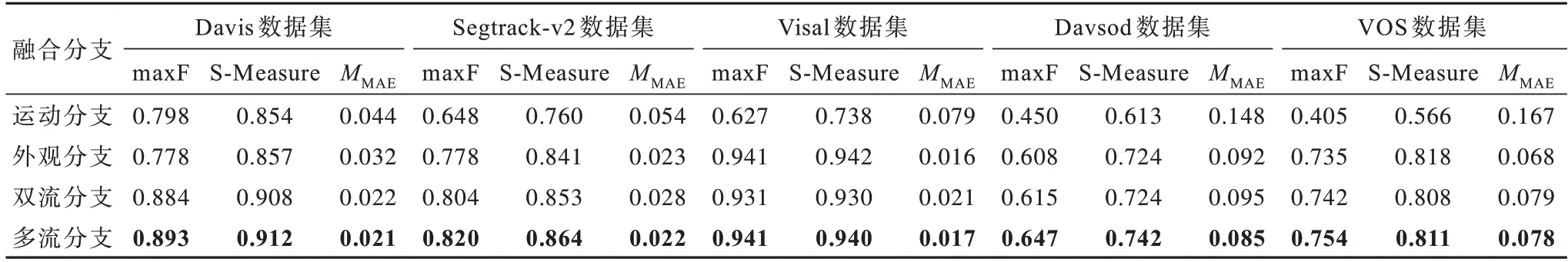

为验证本文算法的有效性,在不同数据集上不同融合分支的评价指标进行对比,如表1 所示,加粗表示最优数据。其中运动分支以光流图作为输入,使用Davis 2000 数据量在空间子网预训练模型上进行微调,外观分支表示外观子网原始结果,双流分支是按照MGA 的融合方式进行复现,多流分支是本文方法(MSNC)。双流分支的评价指标均优于运动分支,其原因是双流分支中的光流图缺少节信息以及存在运动静止的情况。此外,在运动比较复杂的Davsod 和Segtrack-v2 数据集上,多流分支相较于双流分支评价指标较高。

表1 不同融合分支的评价指标对比Table 1 Evaluation indexs comparison among different fusion branches

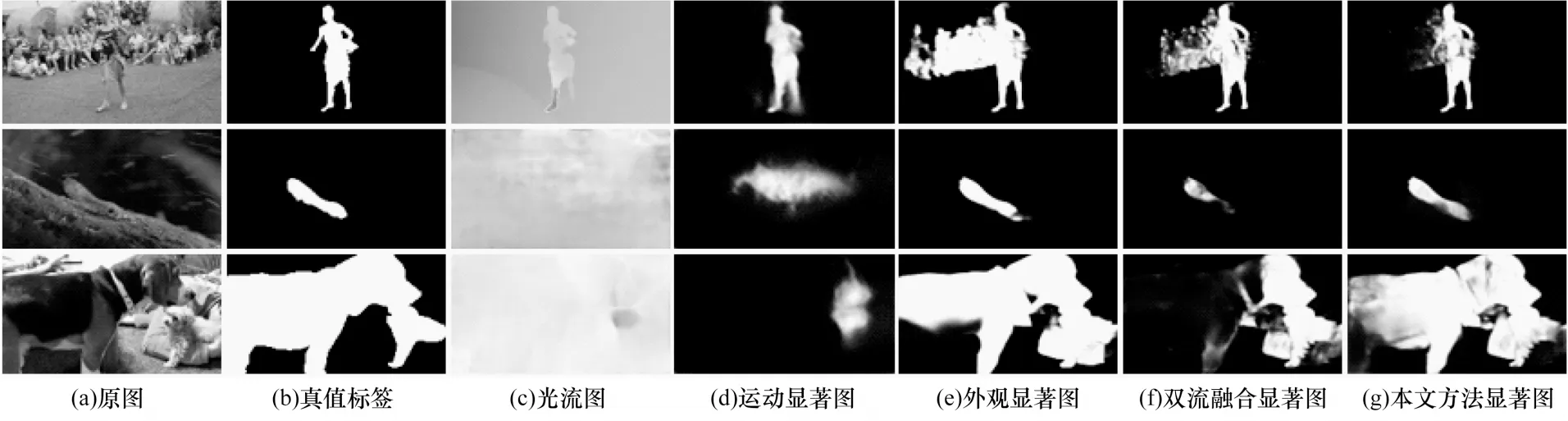

不同的消融分析结果如图5 所示。当视频中运动显著性处于静止时(如第2 行和第3 行),光流图未能表征运动线索,提供了错误的位置信息,从而影响双流网络的最终结果,如图5(f)所示。本文算法通过两流弥补光流的不足,能够有效解决上述问题。

图5 多流融合网络消融结果Fig.5 Ablation results of muti-stream fusion network

4.1.2 多种融合方式对比

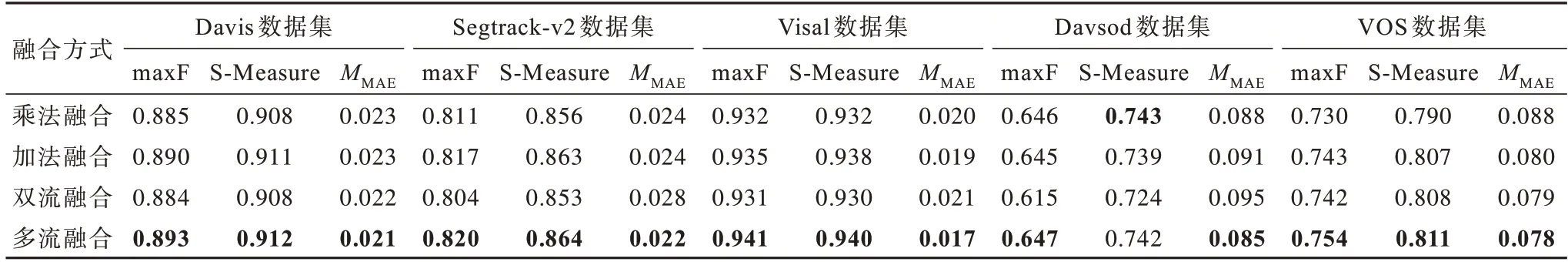

不同融合方式的评价指标对比如表2 所示,加粗表示最优数据。从表2 可以看出,在Davis、Segtrack-v2 和Davsod 数据集上多流融合方式的MMAE相较于乘法融合和加法融合较低。在Visal和VOS 数据集上,多流融合方式的评价指标均较高,能够充分验证多流融合中MCP 融合的有效性。

表2 不同融合方式的评价指标对比Table 2 Evaluation indexs comparison among different fusion methods

4.1.3 训练策略的指标对比

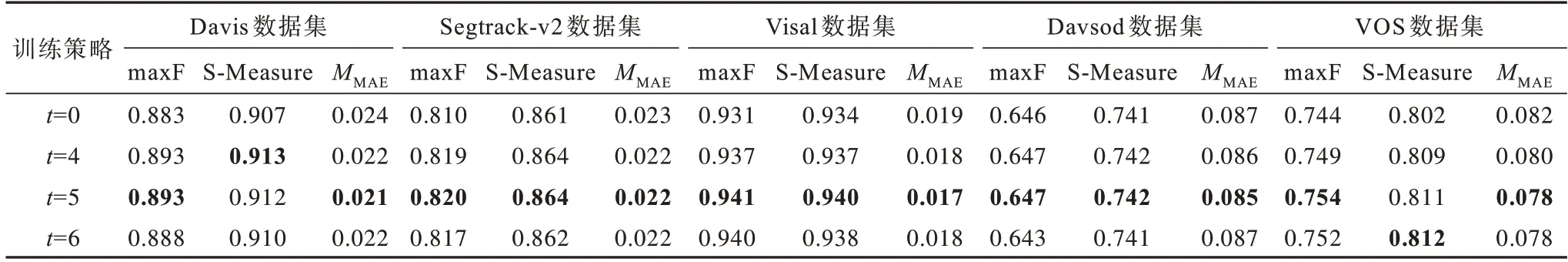

本文以随机训练和循环训练作为自变量进行实验对比。不同训练策略的性能指标对比如表3所示,加粗表示最优数据。t=0 表示不使用循环训练策略,并且先验图全部使用经腐蚀得到的真值标签。t=4 表示BatchSize=4,即4 张先验图为一个循环,每个循环仅使用一个经腐蚀处理过的手工标注,之后依次向下传递。从表3 可以看出,当BatchSize(t)=5 时,MSNC在不同数 据集上的性能指标均较优。

表3 不同训练策略的评价指标对比Table 3 Evaluation indexs comparison among different training strategies

4.2 性能分析

本文主要从指标得分、视觉显著图和运行速度3 个方面对本文算法与其他算法进行了比较。

1)定量分析

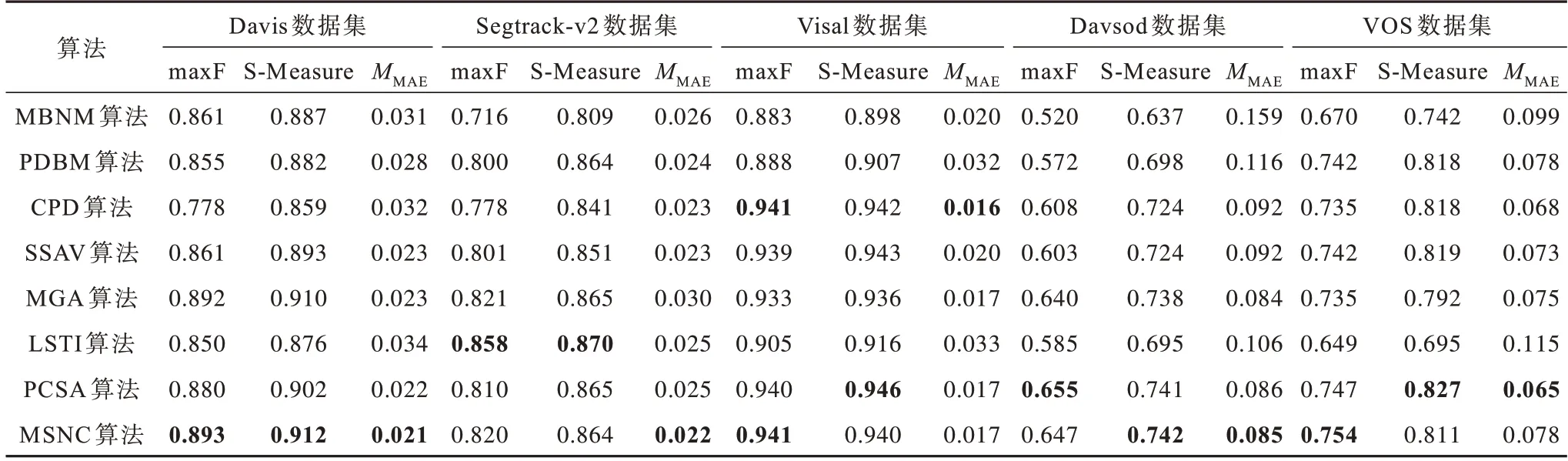

为验证本文算法的有效性,本文以maxF、S-meature和MMAE作为评价指标,与当前主流算法进行比较,包括PCSA[37]、LSTI[38]、MGA、SSAV[21]、CPD[39]、PDBM[19]、MBNM[40]。在不同数据集上不同算法的性能指标对比如表4所示,加粗表示最优数据,本文算法在Davis数据集上的性能指标较优,对比MGA算法,MSNC在VOS数据集上maxF指标上提升了1个百分点,与PCSA[37]相比,MSNC未使用Davis的训练集却得到了较高的检测精度。

表4 不同算法的评价指标对比Table 4 Evaluation indexs comparison among different algorithms

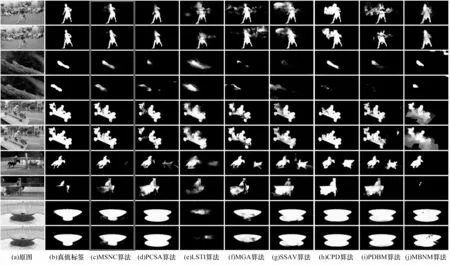

2)结果可视化分析

在不同的视频场景中,不同算法的显著性检测结果对比如图6 所示。本文所提算法在不同运动模式下都能取得较好的检测结果。当物体运动缓慢时,如第3 段视频,MSNC 算法能够得到较完整的显著图,而其他算法在车身位置易发生空洞检测,如第1、2 段视频。与其他算法相比,本文算法提取的显著性图中背景区域包含的噪声较少,显著物体更凸显,表明在背景复杂以及低对比度的场景中三重网络定位更准确。此外,针对遮挡问题(如第4 段视频),MSNC 算法提取的显著性图与真值图具有较高的一致性,并未存在假阳性的问题。

图6 不同算法的显著性检测结果对比Fig.6 Saliency detection results comparison among different algorithms

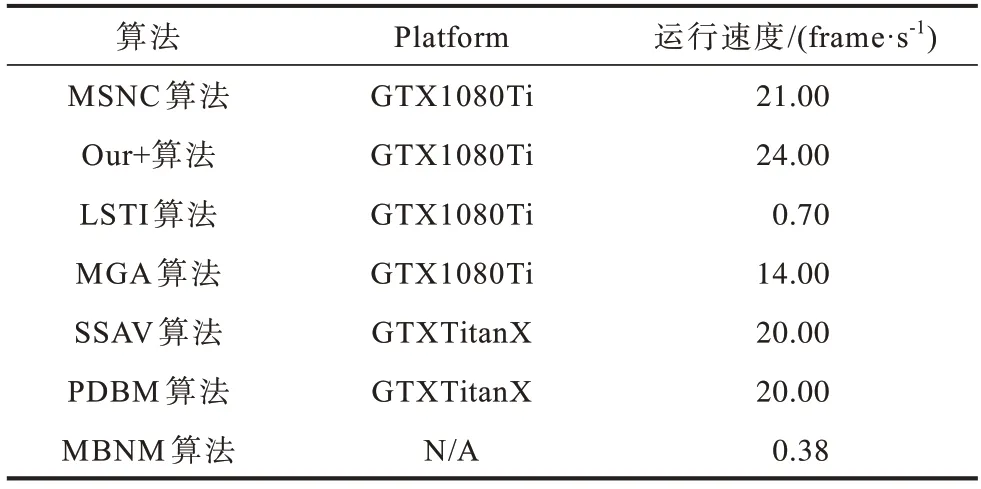

3)效率对比

不同算法的运行速度对比如表5所示。相比当前主流算法,本文算法更高效,其运行速度达到21.00 frame/s。其中,FPS表示模型运行速度,即每秒测试的帧数。MSNC算法运行速度为21.00 frame/s。Ours+表示本文的双流网络,运行速度为24.00 frame/s,因此,先验分支会增加网络的耗时,但仅是每秒3帧的差距。即使先验分支增加了耗时,其运行速度依然比当前主流算法快。从表5可以看出,MSNC算法的运行速度是LSTI算法的30倍。由于LSTI算法使用超像素分割方法,因此增加了总体时间消耗。同时MSNC算法的运行速度也是MGA算法的1.5倍,因为本文的网络结构比MGA 更加简单。

表5 不同算法的运行速度对比Table 5 Comparison of running speed of different algorithms

5 结束语

本文提出基于多流网络一致性的检测算法,设计并使用一种新的三重网络结构来提取预选目标区域的颜色信息、时序信息和先验特征。利用多流一致性融合模型对三流分支进行优化,从而得到最优的视频显著性检测结果。同时使用循环训练策略防止网络产生过拟合,增强网络的泛化能力。实验结果表明,相比PCSA、SSAV、MGA 等算法,MSNC 算法在Davis 数据集上的性能指标较优,具有较高的视频显著性检测精度。后续将对冗余的卷积层进行剪枝,优化网络结构,在不降低精确度的前提下加快检测速度。