结合特征金字塔和区域候选网络的视觉目标跟踪

2022-01-21王敬坤丁德锐王永雄

王敬坤,丁德锐,梁 伟,王永雄

(上海理工大学 光电信息与计算机工程学院,上海 200093)

1 引 言

近十年来,视觉目标跟踪越来越受到人们的关注,在视觉监控[1]、人机交互[2]、增强现实[3]等多个领域都有广泛的应用[4].虽然视觉目标跟踪最近取得了很大的进展,但由于诸如光照变化、尺度变化、遮挡和背景杂波等众多因素的影响,仍然是一项非常具有挑战性的任务.

最近,基于孪生网络的跟踪器因其良好的准确性和速度在学术界中引起了极大的研究关注[5-14].这些孪生跟踪器将视觉目标跟踪问题转化为目标模板特征和搜索区域的特征之间的相似图的互相关联学习问题.例如,CFNet[15]跟踪器和DSiam[16]跟踪器分别通过运行平均模板和快速转换模块更新跟踪模型.SiamRPN[10]跟踪器在孪生网络之后引入区域候选网络,进行联合分类和回归跟踪.DaSiamRPN[11]跟踪器进一步引入干扰感知模块,提高了模型的识别能力.

上述孪生跟踪器已经取得了较好的跟踪性能,特别是在平衡精度和速度方面表现良好,但与先进ECO[17]算法相比,即使是先进的孪生跟踪器(如SiamRPN、DaSiamRPN)在基准数据集(如OTB2015[18])上的准确度仍然有显著的差距.这些跟踪器主要采用了类似于AlexNet[19]的网络架构.对现有的孪生跟踪器进行分析,不难发现其核心原因:1)严格的平移不变性难以保证;2)训练样本分布不均衡;3)低层次空间特征没有充分的利用;4)单阶段的跟踪器使用预定义的锚点框不足以精确定位.

具体地,由于目标可能出现在搜索区域的任何位置,学习到的目标模板的特征表示应该保持空间不变性.进一步从理论上发现,只有AlexNet这样的零填充网络才能满足这种空间不变量限制要求.因此,目前报道的基于复杂ResNet[20]架构的跟踪器的性能并没有得到明显的改善.其次,训练样本分布不均衡,正样本远远小于负样本,而且很多的负样本都是简单样本(非相似非语义背景),这些简单样本在分类器学习鉴别的时候贡献很少有用的信息,从而导致孪生网络训练效率低下.再者,低层次空间特征也没有得到充分的探索.在SiamRPN中,只运用了最后一层的特征来区分目标和背景.然而,跟踪目标很容易受到相似背景的干扰.在这种情况下,高层语义特征在区分背景和目标前景方面的区分度就比较差.最后,SiamRPN采用单阶段回归对预定义的锚点框的目标实施定位,对于与目标有重叠的锚点框,使用非极大值抑制进行筛选.然而,对于无模型的跟踪问题,目标对象的先验信息是未知的,很难估计尺度的变化.因此,在这种单阶段回归中使用预定义锚点框不足以实现精确地定位.

针对平移不变性限制问题,基础的孪生网络跟踪器具有中心偏置,对在中心位置的目标学习的占比更大.因而,本文可以适当的增加中心范围来有效的防止模型崩溃.针对类不平衡问题,两阶段的目标检测器(如Faster R-CNN[21])已经得到初步的解决.在检测器中,第1分类阶段快速过滤掉大部分的背景样本,第2个分类阶段利用抽样式启发方法,以保持前景与背景之间可调节的平衡.有成果表明即使对于极端形状的物体,两阶段回归也能实现精确定位.

综上所述,本文提出了基于特征金字塔(FPN)的级联 RPN网络(简记为CF-RPN)的多阶段的跟踪框架,通过串联一系列的RPN模块来解决类不平衡问题,同时利用多尺度特征来实现鲁棒的视觉跟踪.主要贡献体现在如下4个方面:

1)采用了ResNet架构的孪生网络,通过增加跟踪器的中心范围,有效的防止模型崩溃,保证了平移不变性;

2)采用多级RPN跟踪框架有效的解决了由于正负样本的不平衡导致精度的下降问题.

3)充分利用了目标的高层语义信息以及底层空间信息的多尺度特征信息;

4)级联的RPN可实现锚点框逐级更新,从而细化每一个RPN中目标的位置和形状,提高定位的准确性.

总之,本文提出的CF-RPN视觉跟踪模型在33帧/秒的跟踪效率下,达到了实时的跟踪精度.在5个标准的跟踪数据集上,包括OTB50[22]、OTB100、VOT2016[23]、VOT2018[24]和VOT2019[25],始终获得最佳的跟踪结果.

2 相关工作

由于新的基准数据集的构建和各种改进算法的提出,视觉跟踪在过去十年中得到了快速的发展.基准数据集为不同算法的比较提供了公平的测试平台[18,22].每年举办的跟踪挑战赛不断地刷新着跟踪性能[23-25].特别地,Bolme等人[26]的创新地将卷积定理从信号处理领域引入到视觉跟踪中,将目标模板匹配问题转化为频域的相关运算.通过这种变换,基于相关滤波并辅以合适特征的跟踪器不仅获得了高效的运行速度而且也提高了跟踪精度.随着深度学习模型的广泛运用,基于深度特征表示的相关滤波的跟踪算法在流行的跟踪数据集上的测试以及CVPR挑战赛中都获得了领先的精度[27].本节简要介绍基于孪生网络的跟踪器、特征金字塔及其深层体系结构的最新发展.

2.1 孪生网络

最近基于孪生网络的跟踪器(SiamFC[28])因其在跟踪精度和效率两方面均有良好的表现而受到广泛关注.这些跟踪器将视觉跟踪转换为模板分支和搜索分支的相互关系问题,以便能够更好地利用深度网络的优点实现端到端的学习.具体地,通过一个Y形神经网络的训练,获取两个分支的互相关联的相似图.在实际问题中,这两个分支还可以在跟踪阶段保持固定或在线更新以适应目标的外观变化.在此基础上,融合区域候选网络(RPN)的分类和回归功能,造就了经典的孪生跟踪器(SiamRPN),从而使得跟踪性能得到了较大的提升,产生了一些列非常有前景的结果[8-11,16].值得指出的是,通过数据集OTB的测试,他们的跟踪精度仍然与最先进的深度跟踪器如ECO和MDNet[29]有较大差距.

2.2 特征金字塔

特征金字塔是多尺度目标检测系统中的一个基本组成部分.早期的图像金字塔由于其在计算量和内存上的巨大开销,遭受到了基于深度学习目标检测的抛弃.为了解决多尺度目标检测,在图像金字塔基础上构建的特征金字塔是传统的解决思路,将每一层特征直接输出特征图,这样可以检测大范围尺度的图像.特征金字塔网络(FPN)[30]是根据特征金字塔概念设计的特征提取器,目的是提高精度和速度.它替代了类如Faster R-CNN中的特征提取器,并且生成更高质量的特征图金字塔.

2.3 深层体系结构

得益于2012年深度架构AlexNet的提出,网络架构的研究迅猛发展,许多复杂的深度架构被相继提出,如MobileNet[31],VGGNet[32],GoogleNet[33]和ResNet.这些深层架构不仅提供了对神经网络设计更深入的理解,而且推动了许多计算机视觉任务的前沿技术的发展,如目标检测、图像分割和人体姿态估计等.在深度视觉追踪器中,由于浅层特征对目标物体的精确定位具有显著的支撑作用,当目标场景较为简单时,网络体系架构通常不直接利用来自AlexNet或VGGNet的前几个卷积层的信息.本文考虑复杂场景下的目标跟踪问题,解决尺度变化、背景杂波等带来的挑战.因此亟待尝试采用更深层次的孪生网络模型及其各个卷积层的信息来提升孪生跟踪器的性能.

3 结合特征金字塔的级联区域候选网络(CF-RPN)

本文发现简单地通过直接使用像ResNet50这样的深层网络来训练一个孪生跟踪器并不能获得预期的性能改进,甚至可能不升反降,其潜在的原因是孪生跟踪器的内在限制.如果适当地避免这一限制,采用更深的网络作为基础架构的跟踪算法在性能上应当有显著的提升.基于此,本文提出了一个基于特征金字塔(FPN)的级联 RPN网络(简记为CF-RPN)的多阶段的跟踪框架.该框架的基础网络由一对孪生的FPN构成,且FPN的自顶向下层生成的深高层到浅低层的多尺度特征分别输送到级联的各RPN模块中,如图1所示.在该图中,z为模板帧,x为搜索帧,A1为初始预先设置的锚点框,A2~A4分别为经过各个阶段更新后的锚点框.通过级联的RPN模块,对简单负样本进行筛除,让正负样本比例更加平衡;多尺度特征的处理,使得目标的高层语义信息以及低层时空信息都能够加以利用,有利于定位的准确性.相对于传统RPN网络,级联 RPN网络具有多个锚点框,其锚点受前一级RPN的影响.接下来,让本文给出更为详细的分析与设计.

图1 CF-RPN网络结构Fig.1 Architecture of CF-RPN network

3.1 孪生网络跟踪器的内在限制

基于孪生网络的跟踪算法将视觉跟踪视为模板分支和搜索分支的相互关系问题,以便能够更好地利用深度网络的优点学习跟踪相似度图.模板分支用于学习目标的特征,搜索分支用于搜索区域中的目标.通常在序列的第一帧中给出目标框,可以看作是一个范例z,目的是在语义嵌入空间中从后面的帧x中找到最相似的部分.

f(z,x)=φ(z)*φ(x)+b

(1)

其中,f表示特征图,b表示模型相似度值的偏移量.这个简单的匹配函数导致了孪生跟踪器的两个内在限制:

1)孪生跟踪器采用的搜索部分和特征提取具有严格的平移不变性的内在约束,即:

f(z,x[Δτj])=f(z,x)[Δτj]

(2)

其中[Δτj]为平移子窗口;

2)连接部分对结构对称有内在限制,适用的相似度学习需满足f(z,x′)=f(x′,z).

阻碍孪生跟踪器使用深度网络的核心原因与这两个方面密切相关.具体来说,其一是深度网络中的填充破坏了严格的平移不变性;其二是RPN需要非对称特征来进行分类和回归.

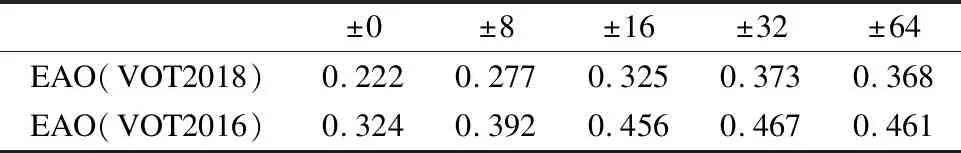

严格的平移不变性只存在于没有填充的网络中,如AlexNet.当现有的网络被ResNet或MobileNet等现代深度网络所取代时,填充不可避免地会使网络变深,从而破坏了严格的平移不变性限制.本文注意到基础的孪生网络跟踪器具有中心偏置,对在中心位置的目标学习的占比更大.为此,本文对采用的ResNet网络适当的增加中心范围.中心范围是数据填充后均匀分布所产生的最大平移范围.本文针对不同中心范围进行了实验,实验结果如表1所示.从该表中不难发现,当适当增加中心范围时,EAO会有明显的提高,但当设置超过±32像素后,反而会有下降的趋势.根据实验结果,本文将中心范围设置为±32像素,使得即使在填充之后位置靠近边界的目标也能够学习,从而有效的防止模型崩溃.

表1 VOT数据集在不同中心范围下的EAO

Table 1 EAO of VOT datasets in different center ranges

±0±8±16±32±64EAO(VOT2018)0.2220.2770.3250.3730.368EAO(VOT2016)0.3240.3920.4560.4670.461

另一方面,单阶段的RPN是利用最后一层特征进行分类和回归的,其中分类分支将每张图像的所有锚点划分为正负样本,回归分支给出最后得分最高的候选框.显而易见,使用单个RPN仅仅只能利用到高层的语义信息,而目标的时空信息没有加以有效的利用,对目标的大尺度变化不能很好的处理,增加了跟踪器的局限性.为此,本文采用多尺度特征的提取,并分别输送到随后的级联的各RPN模块中,使得目标的高层语义信息以及底层空间信息都能得以充分利用.

3.2 特征金字塔驱动的孪生网络

如上所述,只使用诸如AlexNet的浅层网络,各层次不能提供具有较大差异的特征表述.但是考虑到感受野的变化,FPN中不同层次的特征更有意义:底层的特征主要集中在对定位至关重要的颜色、形状等低层次信息,而缺乏语义信息;高层的特征则具有丰富的语义信息,在一些具有挑战性的场景中是有益的,比如运动模糊、巨大变形等场景.显然,使用这些丰富的层次信息能够有助于提升跟踪精度.

FPN主要解决的是物体检测中的多尺度问题.该架构如图2所示:由一个自底向上的线路、一个自顶向下的线路以及横向连接层组成.

图2 FPN网络结构图Fig.2 Architecture of FPN

1)自底向上:自底向上是一个下采样过程,特征图经过卷积层,尺寸逐层减小.对于ResNet而言,本文将每一个阶段的最后一个残差块输出的特征激活输出.记conv2,conv3,conv4和conv5卷积层最后阶段输出的残差块为{C2,C3,C4,C5}.

2)自上而下:自顶向下的过程把更抽象、语义更强的高层特征图进行上采样.

3)横向连接层:该层是将上采样的结果和自底向上生成的相同大小的特征图进行融合.横向连接层连接的两层特征在空间尺寸上相同,这样可以利用低层特征中的时空信息.本文采用1×1的卷积进行连接,来减少特征图数量.

总之,本文借鉴了孪生网络的思想,以FPN作为孪生框架的基础网络,可以得到不同尺度的多层级特征.同时可以得到非对称特征输送给RPN模块,进行下一步的分类和回归.

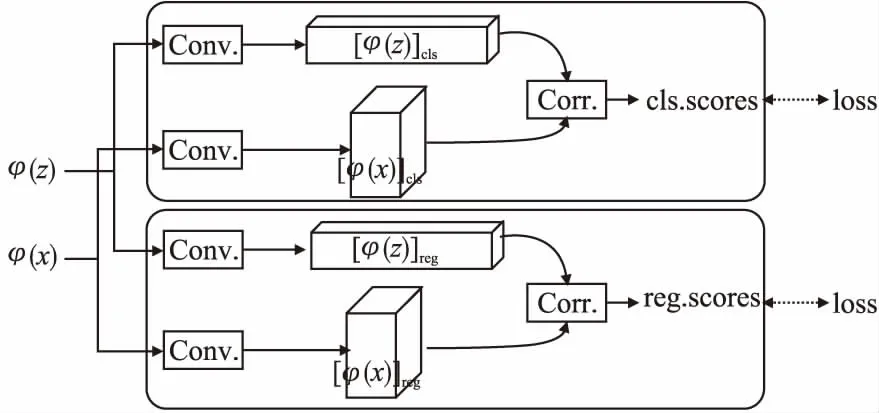

3.3 级联的RPN模块

之前的孪生跟踪器大多忽略了类不平衡的问题,导致在出现类似语义干扰时性能会出现下降的情况.此外,它们只用了来自最后一层的高级语义特征,忽略了多层特征对目标跟踪带来的价值.针对上述不足,在本文采用的网络中,通过提取多分支多尺度特征来协同推断目标位置.具体地,本文从自顶向下结构中提取多层次特征,分别记为φ1,φ2和φ3,分别输送入3个RPN模块.每个RPN模块如图3所示.

图3 RPN网络结构图Fig.3 RPN network

(3)

在训练过程中,每一个RPN的损失函数由分类损失函数和回归损失函数组成:

(4)

(5)

(6)

由于筛除了一些简单的负样本锚点,每个RPN的训练分布逐渐趋于平衡.因此,每个RPN的分类器在区分遭受干扰的样本时具有更强的分辨力.换句话说,多层次特征的利用进一步提高了处理复杂背景的能力.

最后,CF-RPN的总损失函数由所有的RPN的损失函数组成:

(7)

综上,本文制定了一个多阶段目标跟踪框架.对于每个视频帧,在第1帧中预先计算目标模板的多尺度特征.在新的帧中,根据上一帧的结果,利用CF-RPN对该区域进行检测,然后提取感兴趣的区域.在每个阶段,RPN将输出锚点的分类分数和回归偏移量.将分类得分为负的锚点丢弃,剩下的锚点组合成一个新的锚点集输送给下一阶段的RPN.在最后一个阶段L之后,剩余的锚点作为最终目标候选方案,本文运用非极大值抑制(NMS)从中确定最佳的锚点作为跟踪的最终跟踪结果.

4 实验结果

实验细节:CF-RPN是在配置为Intel®Xeon(R)CPU E5-2640 v3 @ 2.60 GHz × 32,Nvidia GTX 2080 8GB RAM的Ubuntu16.04平台上实现的.本文在ILSVRC2015数据集的训练集上训练网络,并学习如何测量一般对象之间的相似性以进行视觉跟踪.在训练时,只需要FPN中自上而下层的多尺度特征,而级联RPN的数量L设置为3.根据经验将学习率以及正负样本的阈值设置为0.95,0.6和0.3.考虑到目标尺度在连续两帧之间的平滑变化,本文对每个锚点使用一个不同比率的比例,设置为[0.33,0.5,1,2,3].CF-RPN采用SGD随机梯度下降法,并进行超过50组序列的端到端训练,学习率在每个序列从到10-6进行几何退火.

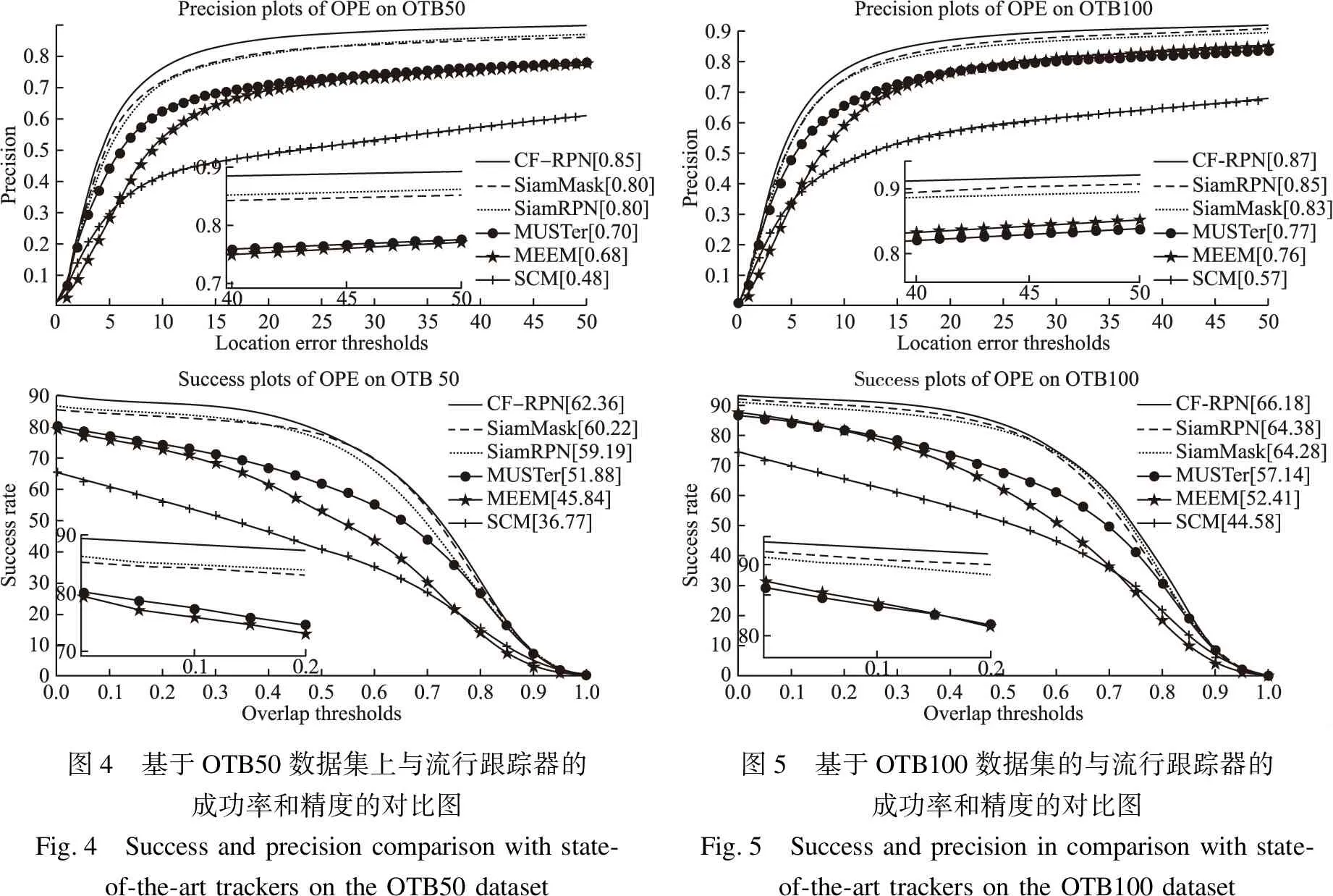

4.1 在数据集OTB50和OTB100上的实验

本文分别在OTB50和OTB100两个数据集上进行实验测试和评估,这两个数据集分别由50个完整标注视频和100个完整标注视频组成.测试可得,本文提出的CF-RPN算法能够达到平均33 fps运行速度.

在跟踪精度、鲁棒性以及EAO等指标方面,本文通过与最近几年流行的跟踪器(如SiamRPN,SiamMask等)进行对比来检验所提CF-RPN算法的有效性,其测试是通过一次成功评估(OPE)实施的,结果如图4、图5所示.具体地,本文提出的CF-RPN方法在OTB50以及OTB100上获得了62.36%和66.18%的准确率.相比准确率分别为59.19%和64.38%的单阶段SiamRPN方法,本文算法的准确率分别提升了3.17%和1.8%.而与准确率分别为60.22%和64.28%的SiamMask方法相比,本文算法的准确率分别提升了2.14%和1.9%.

图4 基于OTB50数据集上与流行跟踪器的成功率和精度的对比图Fig.4 Success and precision comparison with state-of-the-art trackers on the OTB50 dataset图5 基于OTB100数据集的与流行跟踪器的成功率和精度的对比图Fig.5 Success and precision in comparison with state-of-the-art trackers on the OTB100 dataset

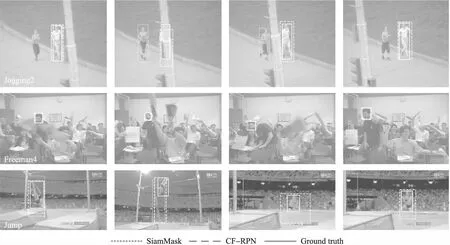

接下来,基于OTB100数据集,本文进一步给出了复杂场景下可视化的目标跟踪结果图,如图6所示.在该图中,实线为目标标签,虚线为SiamMask的跟踪框,双划线为本文提出的CF-RPN算法的跟踪框.在遮挡,相似性干扰,快速移动(第1行,第2行)以及尺度变化(第3行)等挑战下,CF-RPN都能很好的跟踪到目标以及丢失后快速的回归到目标.

图6 OTB100数据集上SiamMask与CF-RPN可视化跟踪效果对比图Fig.6 Comparison of the visual tracking effect of SiamMask and CF-RPN on the OTB100 dataset

4.2 数据集VOT2016、VOT2018及VOT2019上的实验

为了进一步检验算法的有效性,本文进一步在VOT2016、VOT2018及VOT2019数据集上对算法进行了测试.

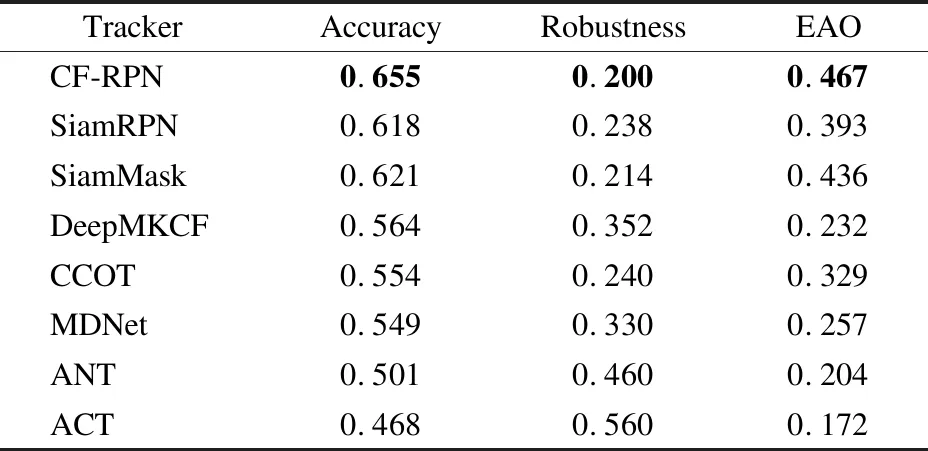

VOT2016包含了60个视频序列,旨在评估跟踪器的短期性能.其运用期望平均重叠率(EAO)来对跟踪算法的整体性能及鲁棒性进行评估.图7显示了不同跟踪器的EAO.由该图不难发现,CF-RPN获得了最好的结果,显著优于基准的SiamRPN和其他方法.进而,表2给出了VOT2016数据集上 不同跟踪器的详细对比数据.如表2所示,CF-RPN的EAO得分为46.7%,明显优于得分为39.3%的SiamRPN算法,性能提升了7.4%;相比于得分为43.6%的SiamMask算法,性能提升了3.1%.此外,本文提出的CF-RPN算法在准确率和鲁棒性上也都领先于其他跟踪器,分别领先排名第二的SiamMask算法1.4%和3.1%.

图7 VOT2016数据集上各算法的EAOFig.7 EAO of various state-of-the-art trackers on the VOT2016 dataset

表2 不同跟踪器在VOT2016中EAO、鲁棒性以及准确率

Table 2 EAO,robustness(failure rate),and accuracy of various state-of-the-art trackers on the VOT2016 dataset

TrackerAccuracyRobustnessEAOCF-RPN0.6550.2000.467SiamRPN0.6180.2380.393SiamMask0.6210.2140.436Deep-MKCF0.5640.3520.232CCOT0.5540.2400.329MDNet0.5490.3300.257ANT0.5010.4600.204ACT0.4680.5600.172

VOT2018 包含了60个序列,这些序列是通过替换VOT2016中至少10个具有挑战性的视频而开发出来的.不同于VOT2016,VOT018引入了一种新的同时考虑跟踪性能和效率的实时实验.根据VOT2018的评估方案,本文采用了期望平均重叠(EAO)、精度(A)以及鲁棒性(R)比较了CF-RPN和SiamRPN以及其他几种排名靠前的算法.如表3所示,CF-RPN的EAO得分为37.3%,仅次于表现最佳的SiamMask算法0.1%,位列第2位;相比于得分为32.7%的SiamRPN算法,性能提升了4.6%.此外,本文提出的CF-RPN算法在准确率和鲁棒性上,皆领先于其他跟踪器,分别领先于排名第二的SiamMask算法2.1%和1%.

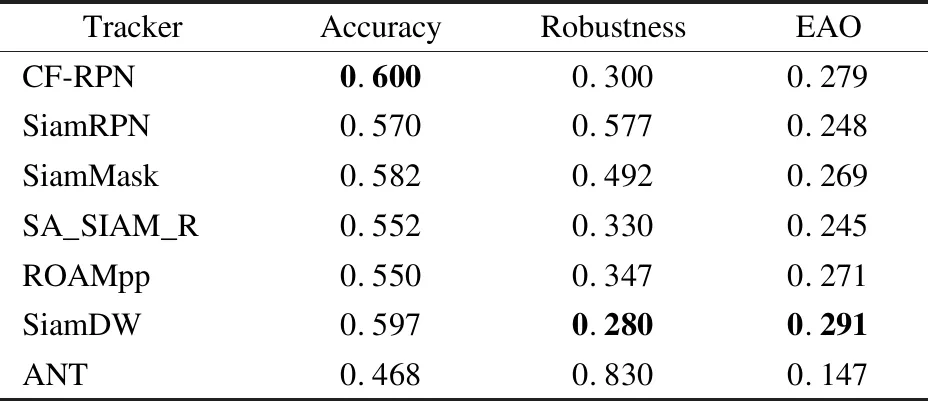

VOT2019同样包含了60个序列,与VOT2018不同的是,VOT2019进行了其中12个序列的更换,增加了挑战的难度,详细对比实验结果如表4所示.具体地,本文提出的CF-RPN算法在准确率方面表现最佳,领先排名第二的SiamDW算法0.3%;其次,EAO得分为27.9%,仅低于得分为29.1%的SiamDW算法1.2%,但相比于得分为26.9%的SiamMask算法,性能提升了1.0%;最后,鲁棒性低于表现最佳的SiamDW算法2.0%,位列于第二,但相比于得分为49.2%的SiamMask算法,性能提升了19.2%.

表3 不同跟踪器在VOT2018中EAO、鲁棒性以及准确率

Table 3 EAO,robustness(failure rate),and accuracy of various state-of-the-art trackers on the VOT2018 dataset

TrackerAccuracyRobustnessEAOCF-RPN0.6130.2600.373SiamRPN0.5740.3100.327SiamMask0.5920.2700.374SA_Siam_R0.5520.2600.330SA_Siam_P0.5100.3600.279ECO0.4840.2700.280SiamFC0.4810.2900.177DCFNet0.4750.5500.185

表4 不同跟踪器在VOT2019中EAO、鲁棒性以及准确率

Table 4 EAO,robustness(failure rate),and accuracy of various state-of-the-art trackers on the VOT2019 dataset

TrackerAccuracyRobustnessEAOCF-RPN0.6000.3000.279SiamRPN0.5700.5770.248SiamMask0.5820.4920.269SA_SIAM_R0.5520.3300.245ROAMpp0.5500.3470.271SiamDW0.5970.2800.291ANT0.4680.8300.147

5 总 结

本文提出了一个多阶段跟踪框架CF-RPN.与以前的算法相比,CF-RPN通过在级联架构中执行难负样本采样,在处理复杂背景(如类似干扰,遮挡,形变,尺度变化)方面表现出了比较强的性能.此外,CF-RPN通过提取多尺度特征,将高层语义信息和低层时空信息都加以利用,通过级联的RPN模块进行更新锚点框,达到提升跟踪效果的目的.在5种流行的数据集OTB50,OTB100,VOT2016,VOT2018,VOT2019上进行的大量实验中,CF-RPN都能获得最好的准确率并实时运行.值得一提的是,由于网络层数较深,计算量较大,以及计算机硬件条件的限制,导致跟踪速度不高.今后将研究如何降低特征提取以及特征处理的计算量,以提高跟踪速度和精度.