基于标签预留Softmax算法的机器视觉检测鉴别语义分割迁移学习技术

2022-01-20刘桂雄黄坚

刘桂雄,黄坚

基于标签预留Softmax算法的机器视觉检测鉴别语义分割迁移学习技术

刘桂雄*,黄坚

(华南理工大学 机械与汽车工程学院,广东 广州 510640)

面向机器视觉检测鉴别的语义分割卷积神经网络(Convolutional Neural Network, CNN)模型能识别、测量被测对象的零部件、尺寸等特征,针对机器视觉检测鉴别增加识别零部件或关键部位的需求,以及进一步迁移学习会损失CNN模型部分权值的问题,提出一种基于标签预留Softmax算法的语义分割迁移学习技术。研究了机器视觉检测鉴别语义分割迁移学习建模方法,分析指出可尝试选定模型所有权值的微调迁移学习,有助于减小模型初始损失;提出了基于标签预留Softmax算法的微调迁移学习方法,可实现检测对象略有不同的模型所有权值微调迁移学习。在自建数据集上的实验表明,标签预留微调迁移学习技术训练模型达到机器视觉检测鉴别要求的时间由42.8 min减少到30.1 min,算法有效、效果明显;应用实验表明,迁移学习技术可实现标准件安装、漏装、误装情况检测与装配质量鉴别的半监督学习,新机箱迁移学习的训练时间不超过20.2 min,检测准确率达到100%,能满足机箱标准件装配质量检测鉴别的需求。

机器视觉;语义分割;迁移学习;卷积神经网络;微调

1 引 言

语义分割机器视觉检测鉴别方法综合采用视觉传感成像技术、卷积神经网络(Convolutional Neural Network, CNN)语义分割算法模型,识别和测量被测对象的形状、尺寸等特征[1-2],按照设计文件和质量标准评价被测对象的优劣[3]。它与计算机视觉数据集的任务有所不同,需迁移学习提高模型准确率[4]。CNN语义分割模型迁移学习把在计算机视觉数据集源任务source上训练的模型,作为在机器视觉检测鉴别的目标任务target上创建模型的起点[5]。研究表明,CNN模型非常适合于迁移学习[6],使用如ImageNet[7]、COCO[8]等大型图像数据集的预训练模型,能很好地迁移到目标任务中,并有利于提高模型性能[9],主要的迁移学习方法有微调、微调-冻结等。微调策略复制源模型上除输出层外模型的结构及参数,向目标模型添加输出层,输出数量为目标数据集中的类别数,并进行输出层参数的随机初始化,在目标数据集上训练目标模型。2019年,浙江大学研究了一种集成迁移学习的轴件表面缺陷检测方法,将源网络权值迁移至CNN模型中,建立轴件表面缺陷检测模型,在轴件生产现场实时检测中具有较高的准确度和鲁棒性,缺陷正确检出率达97%以上[10]。Fang等研发的微型工件表面缺陷检测系统由光纤定位器、远心透镜系统、矩阵立体光、旋转平台与Mask R-CNN模型构成,在生产线上不断连续微调迁移学习[11]。Xi等研究了一种基于Mask R-CNN齿轮点蚀迁移学习方法,在1 500个齿轮点蚀样本下进行微调Mask R-CNN模型,实现多层次点蚀,在不同光照、角度情况下能够准确识别点蚀缺陷[12]。但在识别对象发现变化时(如增加识别零部件或关键部位),微调又需要重新训练输出层。微调-冻结等方法则将微调训练后的模型,作为特征提取器应用到其他场景。王建林等提出了应用YOLOv2模型的多类型合作目标检测方法,采用COCO数据集预训练YOLOv2模型在增强目标图像样本数据集进行微调迁移学习,并作为特征提取器实现了三维精密测量中多类型合作目标的检测[13]。陈筱等提出了改进EfficientNet-B0和EfficientNet-B7模型的迁移学习方法,该方法先对模型进行微调,然后作为特征提取器提取眼底图像实现特征分类,可辅助诊断[14]。通过改进CNN语义分割模型结构,使识别对象发现变化时模型输出层权值也可迁移,不需要随机初始化,有助于缩短训练时间。

本文首先开展机器视觉检测鉴别语义分割迁移学习建模研究,分析迁移不同模型参数构成对损失及准确率的影响,通过机器视觉检测鉴别改进语义分割模型结构,使模型迁移不再需要调整,连同Softmax算法权值均可迁移。

2 机器视觉检测鉴别语义分割迁移学习建模与构成形式

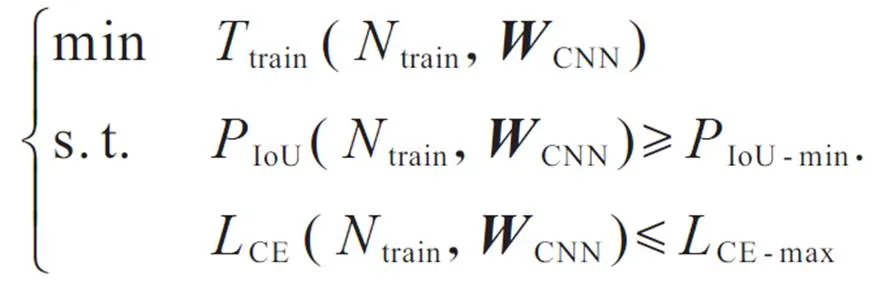

机器视觉检测鉴别语义分割迁移学习目标是在平均精度IoU、模型损失CE满足机器视觉检测鉴别要求的前提下,降低训练时间train。设语义分割网络模型CNN在目标数据集target上进行Fine-tuning迁移学习的模型初始权值CNN,在推荐学习率配置下通过train次迭代后,IoU,CE,train分别表示为IoU(train,CNN),CE(train,CNN),train(train,CNN),有:

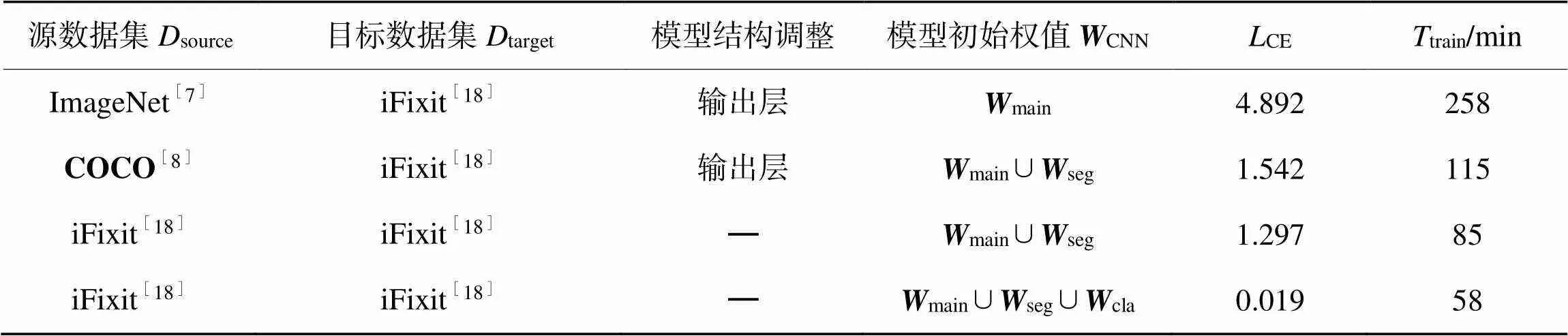

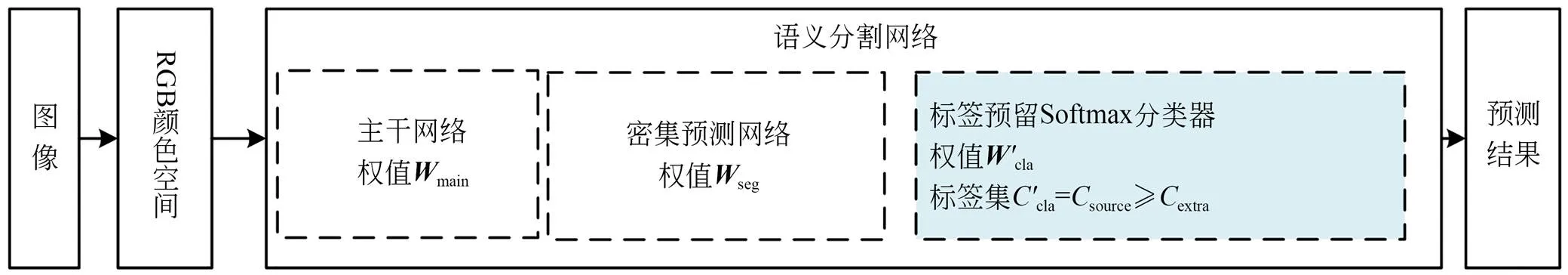

CNN优化是先选定迁移学习的模型初始权值CNN(包括主干网络权值main、密集预测网络权值seg和Softmax层权值cla)构成形式,在目标数据集target下训练网络,比较不同train下的train和CE,选定出CNN的相对较佳值。

表1预训练Mask R-CNN模型Fine-tuning迁移学习初始权值CNN的train和CE

Tab.1 Ttrain and LCE of pre-trained Mask R-CNN model fine-tuning transfer learning initial various weights WCNN

本文在面向语义分割机器视觉检测鉴别中,target与source的分割任务相同,识别对象略有不同(这里学习样本就是识别目标),可尝试选定CNN=main∪seg∪cla权值迁移学习,不是进行分类器Softmax替换,而是进行分类器Softmax改进,使模型在目标任务上的初始损失(train=0时CE)较小,缩短train。

3 基于标签预留Softmax的语义分割迁移学习方法

图1 基于标签预留改进Softmax算法的Fine-tuning迁移学习方法原理

图2 标签预留改进Softmax算法模型

表2标签预留改进Softmax与典型Softmax算法的参数比较

Tab.2Parameter comparison of label-reserved and general Softmax algorithms

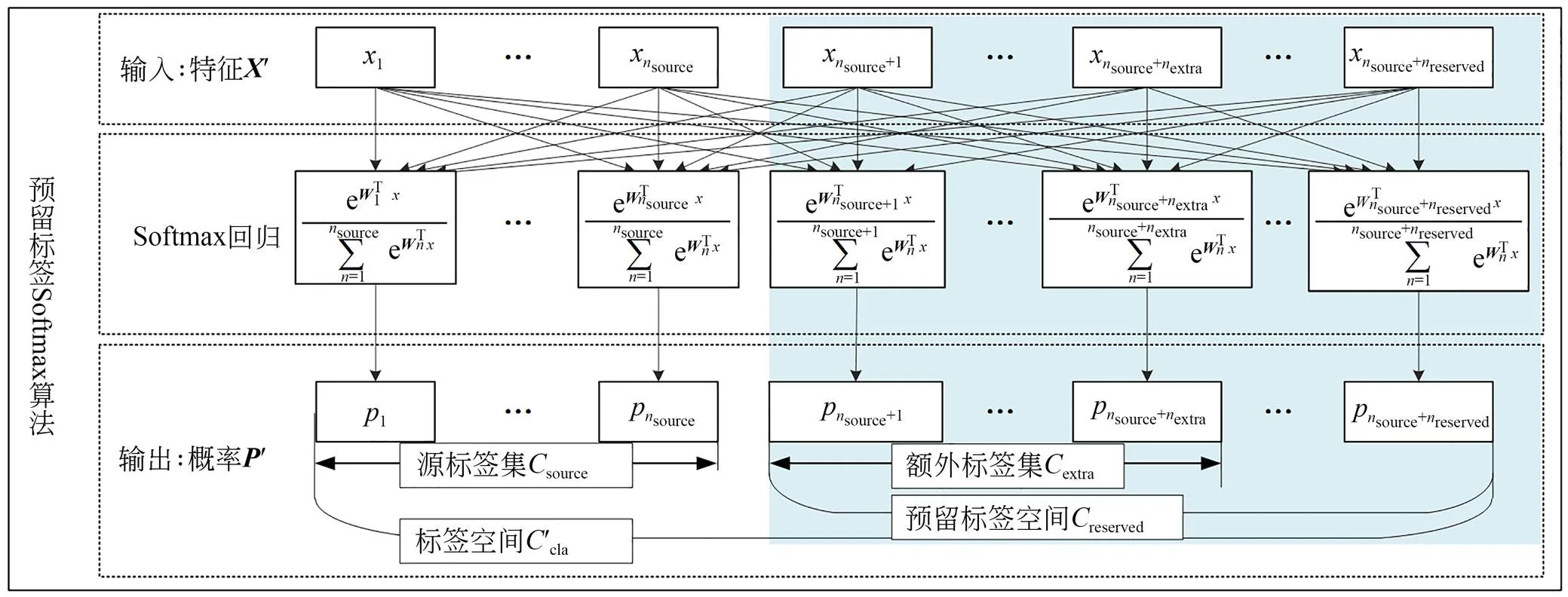

标签预留Softmax算法只需修改语义分割模型的头部网络结构(见图3)。该结构可用于采用ResNet-FPN作为骨干网络的Mask R-CNN模型[17]。图中箭头表示卷积层、反卷积层或全连接层,具体类型可从输入输出特征维度推断(卷积层保留空间维度、反卷积层增加空间维度、全连接层处理一维数组)。标签预留Mask R-CNN模型头部结构改变了输出层卷积层的通道数,其中分类输出通道数为source+reserved+1,边界框回归的输出通道数为(source+reserved)×4;掩膜分割输出特征图尺寸为28×28,通道数为(source+reserved)。

图3 标签预留Mask R-CNN模型的头部结构

Fig.3 Head architecture of label-reserved Mask R-CNN

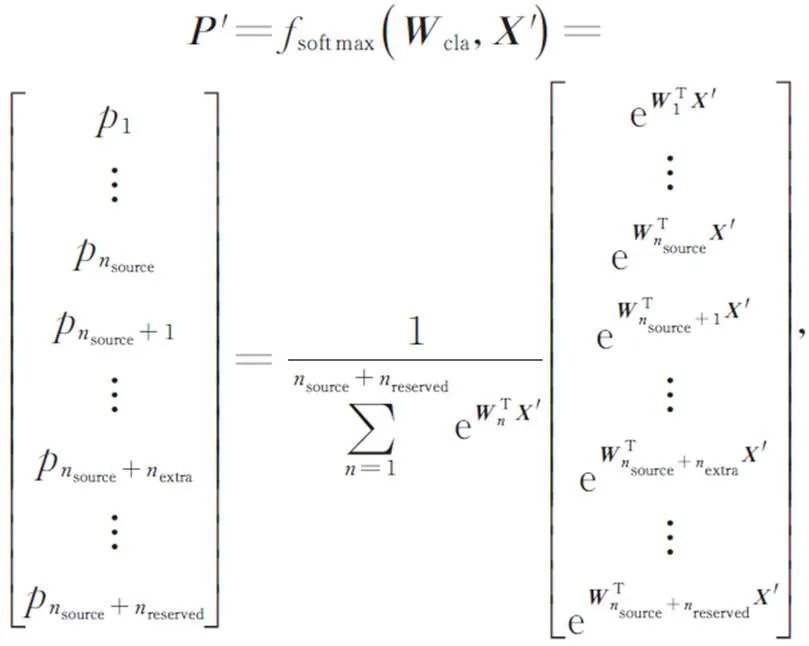

在满足reserved≥extra>0下,基于标签预留Softmax算法的Fine-tuning迁移学习算法为:

式中e2.718 28。

4 实验与结果分析

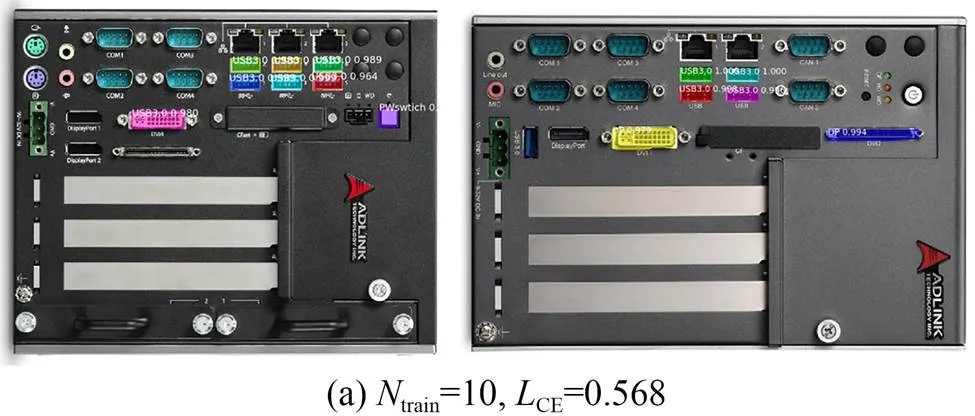

实验上位机的主要硬件为lntel i7-7820X CPU,NVIDIA GeForce GTX 1080Ti GPU,SSD硬盘;软件环境为Ubuntu18.04,Python3.6,Pytorch 1.6与Detectron2 0.4.0。选取机箱装配数据集[19]进行语义分割Fine-tuning迁移学习实验。机箱装配数据集的图像尺寸为910×454~4 046×1 908 pixel,包含不可扩展机箱、可扩展机箱等子集。实验选取不可扩展机箱作为源数据集source,具有多款不可扩展机箱图像200个,标注了USB3.0,RJ45,CFast,DP,HDMI,COM等14种机箱标准件(source=14)。可扩展机箱作为目标数据集target,具有多款可扩展机箱图像200个,标注了19种机箱标准件(target=19),target比source多的标准件主要包括PCI-E挡板、PCI-E板卡、PCI-E固定槽、PCI-E固定螺纹和SATA托盘等5种。

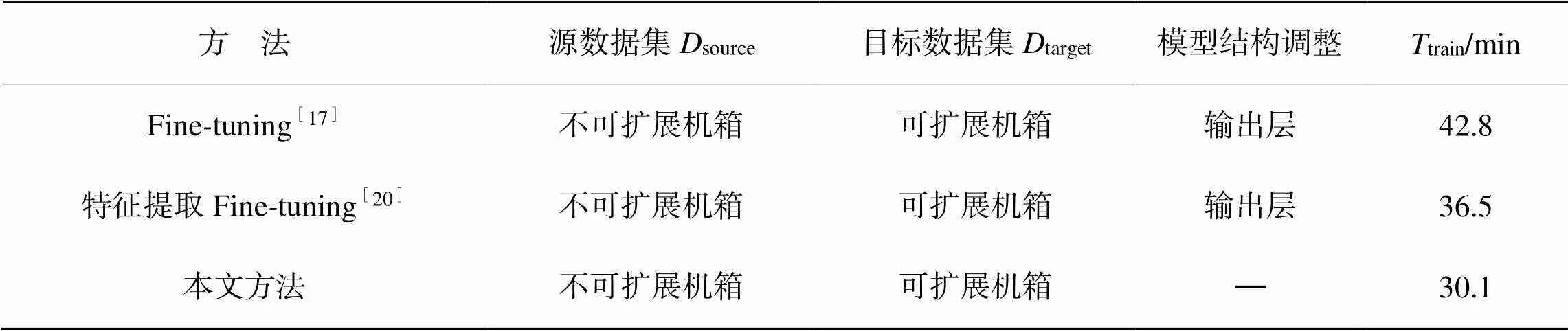

表3不同迁移学习方法的训练时间

Tab.3 Training time ofdifferent transfer learning methods

5 应用验证

将本文方法应用于MVAQ2型制造过程质量视觉检测系统中,实现机箱标准件装配质量检测的无监督自动深度学习,代替原本由领域专家人工才能完成的工作(包括机箱标准件特征提取与模式识别、装配质量检测模板构建等)。研发人员只需要选定标准件图像,系统将自动学习标准件安装、漏装、误装等情况,并推广到标准件装配质量视觉检测鉴别系统中。

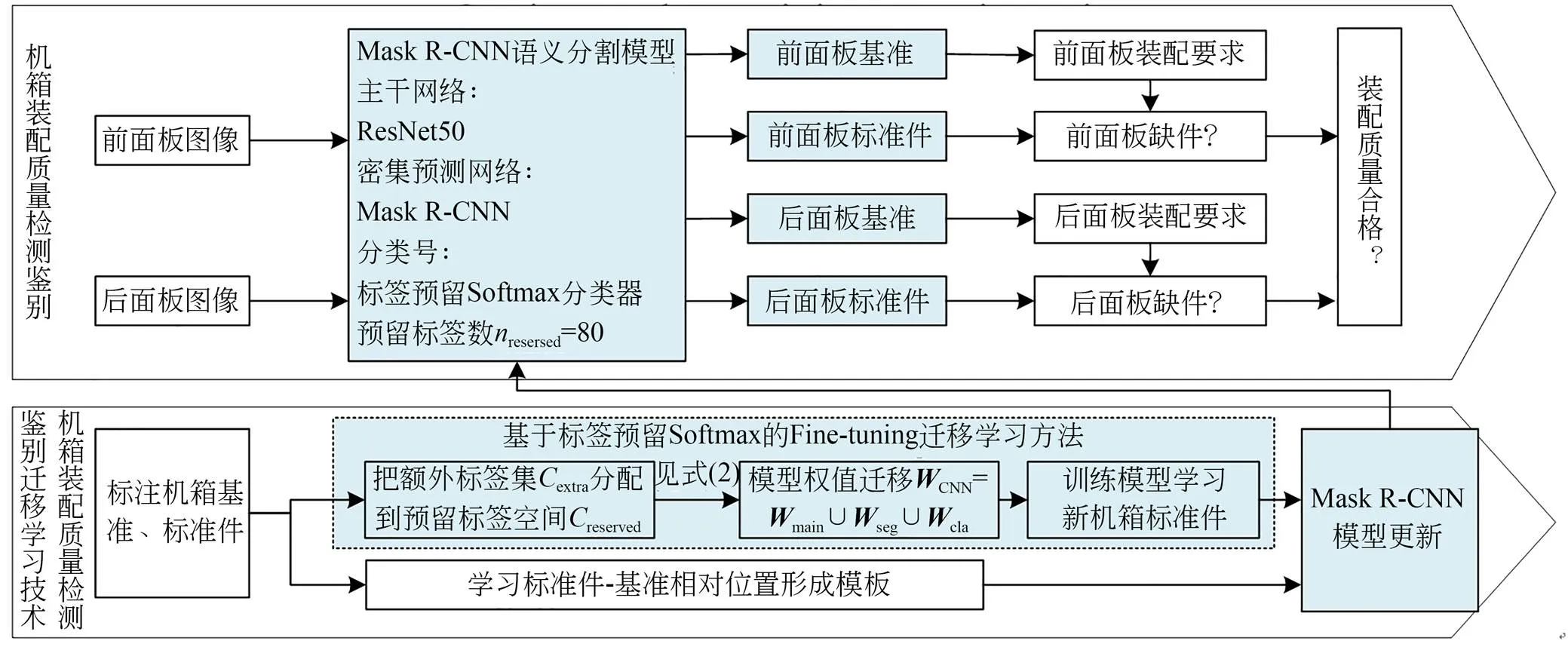

图6 MVAQ2机箱标准件装配质量检测鉴别软件基本功能框图

图6为MVAQ2机箱标准件装配质量检测鉴别软件基本功能,图中深色底色表示装置软件中应用本文迁移学习方法的相关流程及功能。软件应用基于标签预留Softmax算法的Fine-tuning迁移学习方法,具有机箱标准件装配质量检测鉴别学习功能,能训练Mask R-CNN语义分割模型学习机箱基准、标准件,实现机箱各面板的基准、标准件的在线识别与定位,并依据装配技术要求鉴别每个装配位置的工作情况,判断机箱装配质量是否合格。

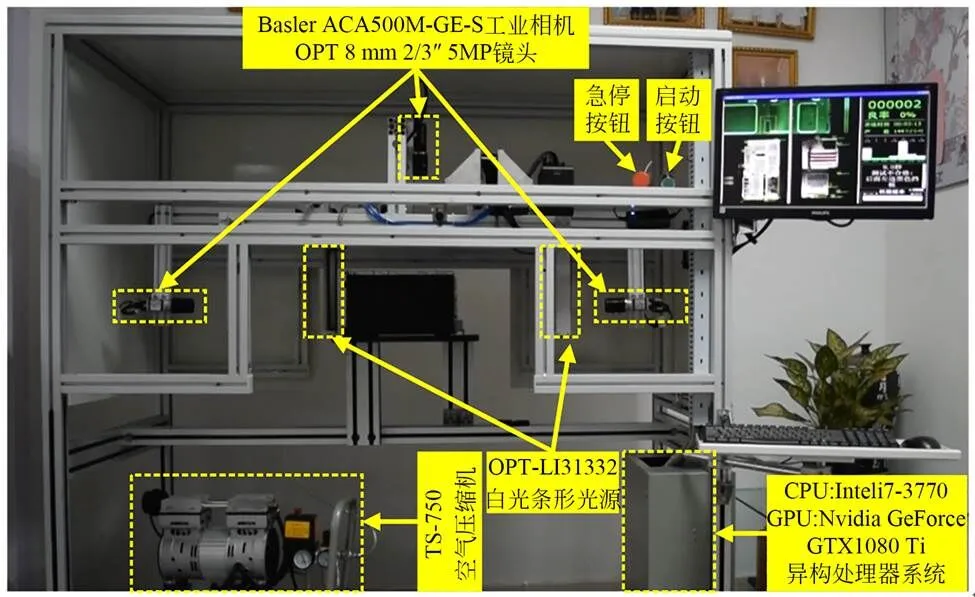

图7为MVAQ2机箱标准件装配质量检测鉴别系统实物图。装置主要由核心计算机、相机、光源、运动控制和用户交互等核心模块构成。其中,光源模块具有白光漫反射照明,相机模块具有机箱三平面移动成像功能,核心计算机上搭载异构多处理器,提供深度学习计算能力。

图7 MVAQ2机箱标准件装配质量检测鉴别装置

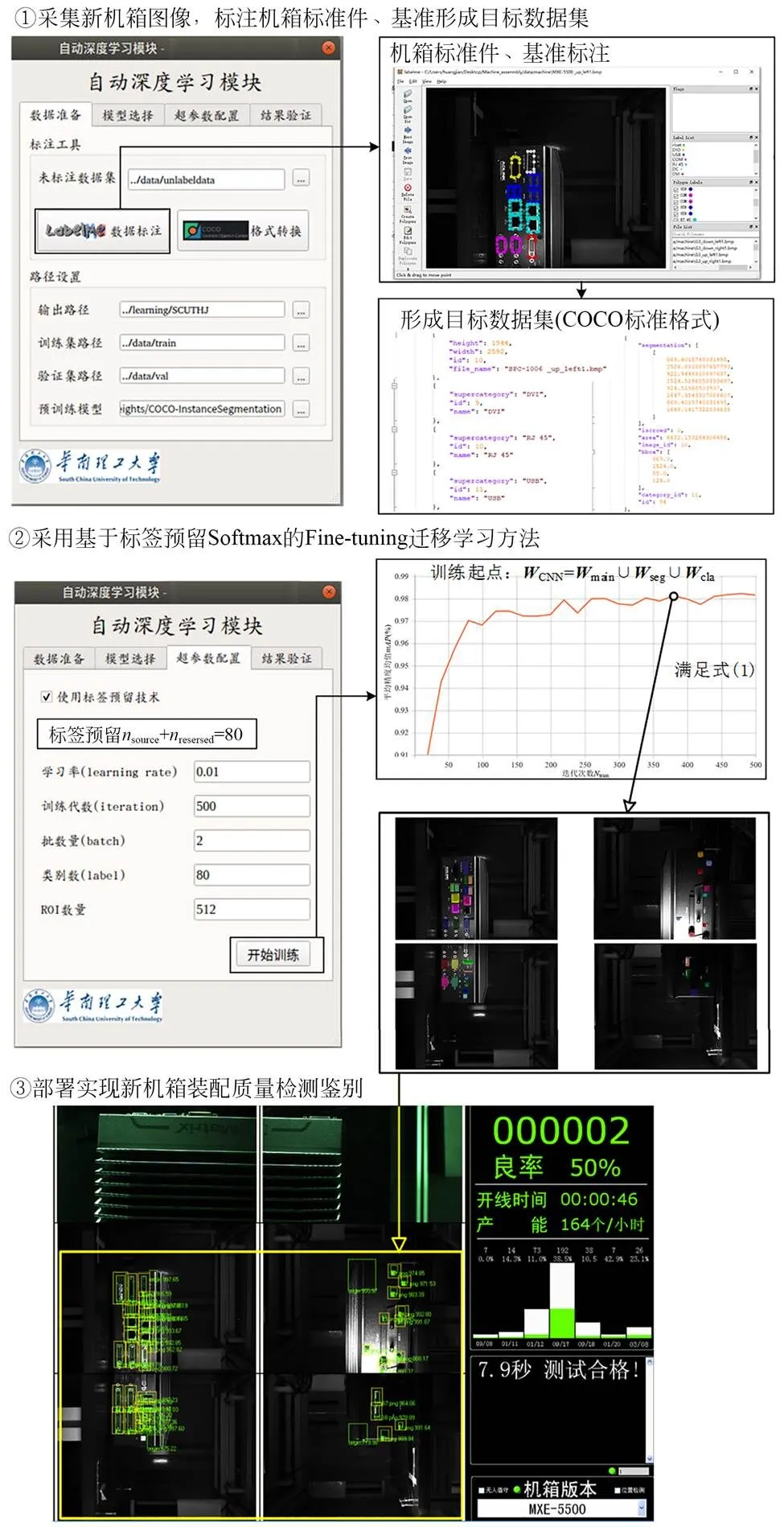

图8 MVAQ2装置新机箱学习流程

按照图8流程,设备开发人员标注标准件(如DVI、RJ45、RS232、DP等)合格情况图像,系统学习单个机箱标准件安装、漏装、误装情况,直到检测准确率达到100%时的人工智能学习时间不超过20.2 min。

6 结 论

[1] 卢荣胜,吴昂,张腾达,等. 自动光学(视觉)检测技术及其在缺陷检测中的应用综述[J]. 光学学报, 2018, 38(8): 23-58.

LU R SH, WU A, ZHANG T D,. Review on automated optical (visual) inspection and its applications in defect detection[J]., 2018, 38(8): 23-58. (in Chinese)

[2] 范丽丽,赵宏伟,赵浩宇,等. 基于深度卷积神经网络的目标检测研究综述[J]. 光学精密工程, 2020, 28(5): 1152-1164.

FAN L L, ZHAO H W, ZHAO H Y,. Survey of target detection based on deep convolutional neural networks[J]., 2020, 28(5): 1152-1164. (in Chinese)

[3] 黄坚,刘桂雄. 面向机器视觉检测的CNN语义分割方法进展[J]. 激光杂志, 2019, 40(5): 10-16.

HUANG J, LIU G X. The development of CNN-based semantic segmentation method for machine vision detection[J]., 2019, 40(5): 10-16. (in Chinese)

[4] SHI Q, ZHANG Y P, LIU X P,. Regularised transfer learning for hyperspectral image classification[J]., 2019, 13(2): 188-193.

[5] 刘桂雄,黄坚,刘思洋,等. 面向语义分割机器视觉的AutoML方法[J]. 激光杂志, 2019,40(6): 1-9.

LIU G X, HUANG J, LIU S Y,. AutoML method for semantic segmentation of machine vision[J]., 2019, 40(6): 1-9. (in Chinese)

[6] YOSINSKI J, CLUNE J, BENGIO Y,. How transferable are features in deep neural networks?[J/OL].,2014,27. https://arxiv.org/abs/1411.1792v1.

[7] RUSSAKOVSKY O, DENG J, SU H,. ImageNet large scale visual recognition challenge[J]., 2015, 115(3): 211-252.

[8] LIN T Y, MAIRE M, BELONGIE S,. Microsoft COCO: common objects in context[C].2014, 2014: 740-755.

[9] 张雪松,庄严,闫飞,等. 基于迁移学习的类别级物体识别与检测研究与进展[J]. 自动化学报, 2019, 45(7): 1224-1243.

ZHANG X S, ZHUANG Y, YAN F,. Status and development of transfer learning based category-level object recognition and detection[J]., 2019, 45(7): 1224-1243. (in Chinese)

[10] 冯毅雄,赵彬,郑浩,等. 集成迁移学习的轴件表面缺陷实时检测[J]. 计算机集成制造系统, 2019, 25(12): 3199-3208.

FENG Y X, ZHAO B, ZHENG H,. Real-time detection of shaft surface defects based on integrated transfer learning[J]., 2019, 25(12): 3199-3208. (in Chinese)

[11] FANG X, JIE W, FENG T. An industrial micro-defect diagnosis system via intelligent segmentation region[J]., 2019, 19(11): 2636.

[12] XI D J, QIN Y, WANG Y Y. Vision measurement of gear pitting under different scenes by deep mask R-CNN[J]., 2020, 20(15): 4298.

[13] 王建林,付雪松,黄展超,等. 改进YOLOv2卷积神经网络的多类型合作目标检测[J]. 光学精密工程, 2020, 28(1): 251-260.

WANG J L, FU X S, HUANG ZH CH,. Multi-type cooperative targets detection using improved YOLOv2 convolutional neural network[J]., 2020, 28(1): 251-260. (in Chinese)

[14] 陈筱,朱向冰,吴昌凡,等. 基于迁移学习与特征融合的眼底图像分类[J]. 光学精密工程, 2021, 29(2): 388-399.

CHEN X, ZHU X B, WU CH F,. Research on fundus image classification based on transfer learning and feature fusion[J]., 2021, 29(2): 388-399. (in Chinese)

[15] HOIEM D, CHODPATHUMWAN Y, DAI Q Y. Diagnosing error in object detectors[C].2012,:, 2012: 340-353.

[16] HE K M, SUN J. Convolutional neural networks at constrained time cost[C]. 2015()712,2015,,,,2015: 5353-5360.

[17] HE K M, GKIOXARI G, DOLLÁR P,. Mask R-CNN[J]., 2020, 42(2): 386-397.

[18] GETTO G, LABRIOLA J T. iFixit myself: user-generated content strategy in 'the free repair guide for everything'[J]., 2016, 59(1): 37-55.

[19] 黄爱民. 面向标准件机箱装配质量图像特征提取与构建方法研究[D].广州:华南理工大学,2017.

HUANG A M.[D]. Guangzhou: South China University of Technology, 2017. (in Chinese)

[20] REBUFFI S A, KOLESNIKOV A, SPERL G,. iCaRL: incremental classifier and representation learning[C]. 2017()2126,2017,,,, 2017: 5533-5542.

Transfer learning techniques for semantic segmentation of machine vision inspection and identification based on label-reserved Softmax algorithms

LIU Guixiong*,HUANG Jian

(,,510640,),:

A convolutional neural network (CNN) model for machine vision inspection and identification can identify and measure the components, size, and other features of an object under test. Herein, a fine-tuning transfer learning technique for semantic segmentation based on a label-reserved softmax algorithm was proposed. First, the transfer learning modeling of semantic segmentation for machine vision inspection and identification was performed. Transferring more CNN model weights would reduce the initial loss of the model. Second, a fine-tuning transfer learning method based on label-reserved softmax algorithms was proposed, which could realize fine-tuning transfer learning with all model weights of slightly different detected objects. Experiments based on custom-developed datasets show that the training time for training models to satisfy the requirements of machine vision inspection and identification is reduced from 42.8 min to 30.1 min. Application experiments show that this transfer learning technique enables semi-supervised learning for the inspection of standard component installation, the inspection of missed and mis-installation cases, and the identification of assembly quality. The training time for the transfer learning of new chassis is less than 20.2 min, and the inspection accuracy reaches 100%. The fine-tuning transfer learning technique is effective and satisfies the requirements of machine vision inspection and identification.

machine vision; semantic segmentation; transfer learning; convolutional neural network(CNN); fine-tuning

TP394.1;TH691.9

A

10.37188/OPE.20223001.0117

1004-924X(2022)01-0117-09

2021-05-16;

2021-07-20.

广东省重点领域研发计划资助项目(No.2019B010154003);广州市产业技术重大攻关计划资助项目(No.201802030006)

刘桂雄(1968),男,广东揭阳人,教授,博士生导师,1995年于重庆大学获得博士学位,主要从事先进传感与仪器的研究。E-mail:megxliu@scut.edu.cn

黄坚(1990),男,广东揭阳人,博士研究生,2009年、2013年于华南理工大学分别获得学士、硕士学位,主要从事制造过程机器视觉检测的研究。E-mail:mehuangjian@mail.scut.edu.cn