基于性诱和深度学习的草地贪夜蛾成虫自动识别计数方法

2021-12-22邱荣洲何玉仙陈韶萍黄美玲池美香翁启勇

邱荣洲, 赵 健, 何玉仙, 陈韶萍, 黄美玲, 池美香, 梁 勇, 翁启勇,*

(1. 福建省农业科学院植物保护研究所, 福建省作物有害生物监测与治理重点实验室, 福州 350013;2. 福建省农业科学院数字农业研究所, 福州 350003; 3. 漳州市长泰区植保站, 福建漳州 363900)

草地贪夜蛾Spodopterafrugiperda属鳞翅目(Lepidoptera)夜蛾科(Noctuidae),是一种原产于美洲热带和亚热带地区的多食性、迁飞性重大农业害虫(Sparks, 1979; Toddel and Pooler, 1980; 郭井菲等, 2018)。2019年草地贪夜蛾已在我国南方的热带、南亚热带地区完成定殖过程(吴孔明, 2020)。对草地贪夜蛾进行种群监测是明确其发生规律并指导防治的重要基础性工作。传统的性信息素诱捕、灯光诱捕、田间调查等人工测报方法,需要由专人定期调查田间的发生为害情况并统计虫口数量,专业性强,劳动强度大,耗时且效率低下。现代信息技术的创新发展为害虫监测预警工作提供了新的方法和强有力的技术支持,基于机器学习的害虫图像识别与计数系统,可以克服传统监测方法存在的短板和不足,实现无人值守的草地贪夜蛾成虫自动识别与精准计数。

近年来,随着图像处理和机器学习等相关技术的快速发展,基于深度学习的图像识别技术在植物病虫害智能识别领域已得到广泛应用。例如,Liu等(2016)应用卷积神经网络(convolutional neural network, CNN)等方法来解决水稻12种害虫种类自动识别的问题,并取得较好的结果。Sladojevic等(2016)提出了一种识别13种病害的深度学习模型,采用人工图像预处理来突出目标区域,从而提高识别率,不足之处是耗时较长。田冉等(2016)利用支持向量机(support vector machine, SVM)对果树害虫图像进行识别分类,获得了88%的识别准确率。周爱明等(2017)利用CaffeNet模型进行蝴蝶科级标本图像识别,获得了95.8%的识别准确率。Lu等(2017)提出了水稻病害识别方法,用深层CNN技术识别10种常见水稻病害,提高了水稻病害识别收敛速度和精度。Leonardo等(2018)提出一种使用深度学习架构进行果蝇识别的方法,并获得了95.68%的准确率。Ferentinos(2018)利用CNN诊断和鉴定植物健康和患病的叶片。Wang等(2019)建立10种害虫识别模型,获得了93.84%分类准确率。Li等(2020)利用改进的GoogLeNet模型实现在自然场景中10种作物害虫的自动分类,并获得98.91%的分类准确率。上述基于深度学习的病虫害自动识别的研究,主要是应用不同的算法和模型解决不同场景下植物病虫害的图像分类和识别的问题,并取得了较好的结果。然而,在田间害虫监测的实际应用场景中,仅对目标害虫进行种类识别,还无法有效解决目标害虫定性与定量自动监测预警的问题。

深度学习目标检测网络可以同时监测目标的类别和位置,快速实现目标物体的数量统计。当前比较有代表性的算法有RCNN(Girshicketal., 2014), Fast RCNN(Renetal., 2017),SSD(Liuetal., 2016)和YOLO(Redmonetal., 2016)等。Ding和Taylor(2016)使用深度学习对田间诱捕器内拍摄的鳞翅目害虫进行计数,仅将深度卷积神经网络作为滑动窗口方法的分类器,导致可检测目标尺寸单一且运算量巨大。Sun等(2018)提出了一种基于优化Fast R-CNN深度学习的检测模型,实现诱捕器内红脂大小蠹的自动计数,并获得0.746的检测精度。Liu和Wang等(2020)进行了SSD, Faster R-CNN和YOLO算法应用在番茄病虫害检测精度和速度的对比实验,YOLO的检测精度与SSD和Faster R-CNN相当,检测时间优于SSD和Faster R-CNN。因此,本研究选择YOLO-V5网络建立草地贪夜蛾深度卷积网络监测模型,并通过图像背景去除、增加对照数据类别等方法,筛选和优化出最优的监测模型,实现对草地贪夜蛾成虫图像的快速、准确的自动识别与计数,为害虫智能化自动监测装备开发提供核心算法支持。

1 材料与方法

1.1 试验数据采集

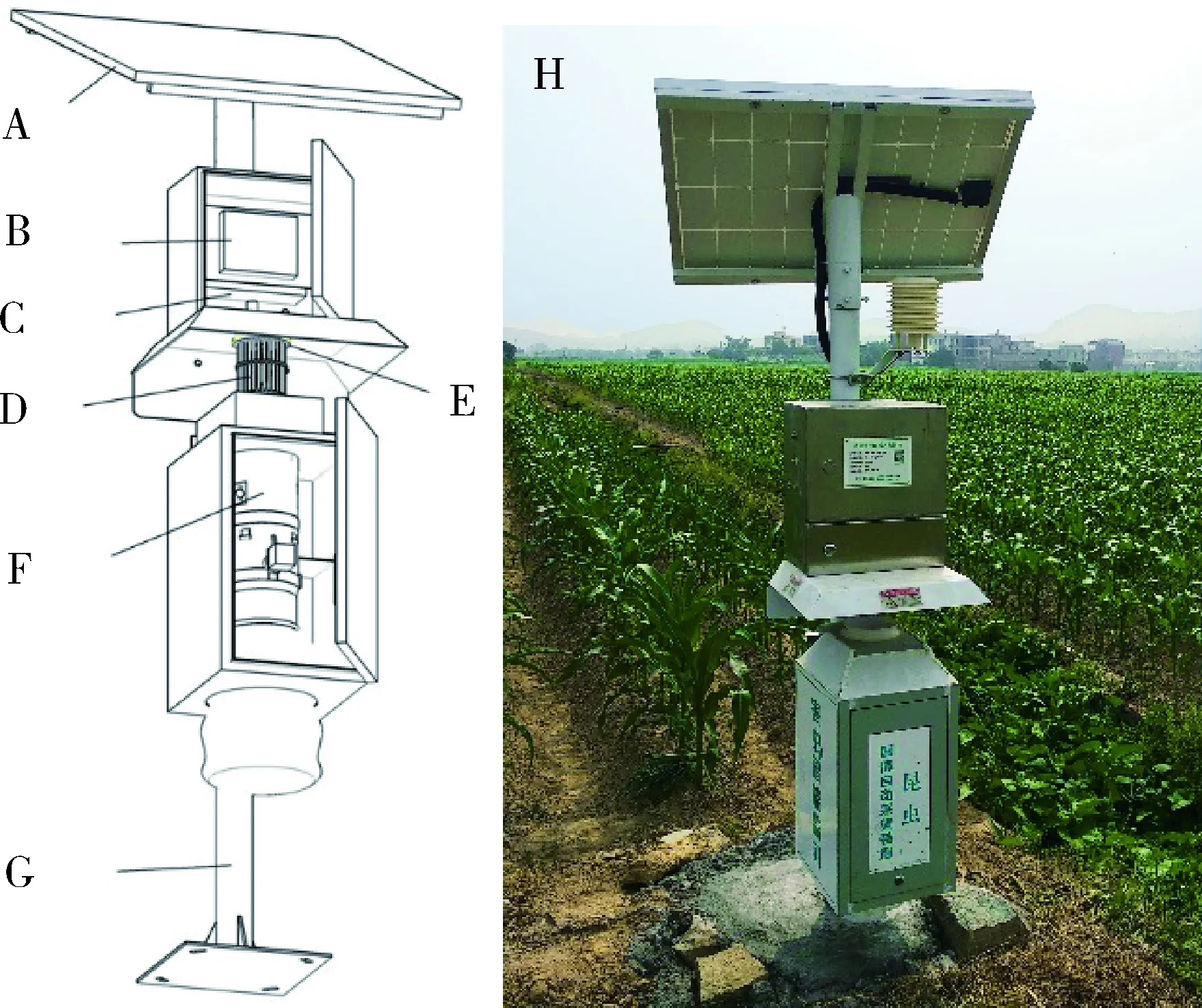

图1 害虫智能监测设备示意图(左)和实物图(右)Fig. 1 Schematic diagram (left) and actual image (right)of pest monitoring equipmentA: 太阳能电池板Solar panels; B: 植保智盒(多功能控制终端)Plant protection box (multi-function control terminal); C: 锂电池Lithium battery; D: 性信息素诱芯Sex pheromone lure; E: 杀虫用高压电网High voltage power grid for killing insects; F: 自动拍摄单元Automatic shooting unit; G: 立杆Upright pole; H: 实物图Physical picture.

本研究使用自动监测设备自动拍摄和常规诱捕器+相机/手机拍摄两种方法采集草地贪夜蛾图像。自动监测设备为课题组自主研制的害虫图像监测设备FAAS-Pest Monitor(授权专利号: ZL201921202577.5),由性诱单元、电击单元、拍摄单元、植保智盒(多功能控制终端)、太阳能供电组件等组成(图1)。设备工作的主要原理是利用性信息素定向诱集目标昆虫,通过高压电网击倒昆虫,虫体掉入拍摄单元的白色背景集虫板,通过植保智盒控制摄像头定时拍摄集虫板上的昆虫图像,并通过4G无线网络上传到云端。监测设备摄像头分辨率为1 800像素×1 350像素,摄像头与底部白色背景集虫板的距离为200 mm,四周设有LED补光灯。每日12∶00时自动采集1次图像,每次图像采集后,设备自动清理虫体,保证每张图片的虫口数为清理前24 h的虫量。试验以性信息素诱捕的草地贪夜蛾雄成虫为检测对象,斜纹夜蛾雄成虫(相似检测目标)为数据扩增样本,通过安装在福建漳州、厦门、莆田、三明等地的设备自动捕获图像2 232张(表1)。

常规诱捕器+相机/手机数据采集方法中采用的诱捕器为漳州英格尔公司生产的船形诱捕器,相机型号为Sony-RX100,手机型号为小米M5。通过相机、手机人工拍摄船型诱捕器的粘虫板上诱捕的草地贪夜蛾照片749张(表1),图像分辨率分别为5 472像素×3 648像素和4 000像素×3 000像素,拍摄距离为150~200 mm。试验数据采集地为福建云霄县东厦镇佳洲岛玉米种植基地。

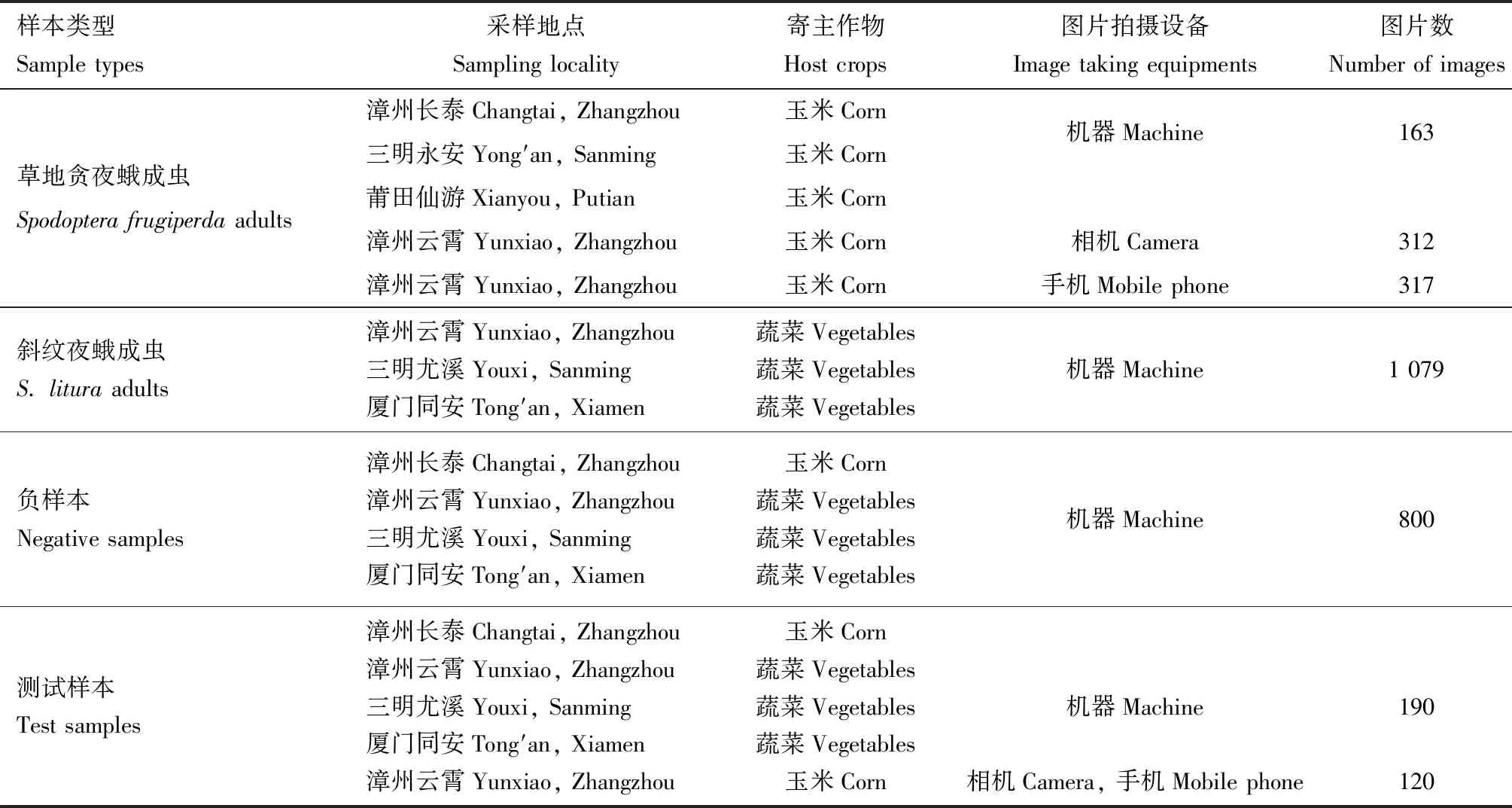

表1 本研究采自福建的样本数据的来源及数量Table 1 The source and amount of sample data taken from Fujian, southern China in this study

1.2 数据集建立

为了探讨不同数据集对模型训练结果的影响,对图像进行了标准化预处理。首先,将采集的2 981张原始大小图片用图像处理软件Photoshop(PS)统一处理成同比例800像素×x像素或x像素×800像素(x<800)的分辨率,再随机挑选2 671张(含10 824头草地贪夜蛾成虫,2 153头斜纹夜蛾成虫)作为训练样本进行边界框标注,剩余的310张作为测试图像。本研究使用自行开发的样本标注软件TFLabelTool,标注草地贪夜蛾、斜纹夜蛾目标边界框。标注时将草地贪夜蛾的最小外接矩形框作为真实框,以减少真实框内的背景像素。标注文件以图片同名的.TXT文本格式进行存储,数据格式与开源LabelTools标注软件生成的标签文件相一致。

根据样本图像标注目标类别,将数据集分为草地贪夜蛾、斜纹夜蛾和负样本3个类型(表2)。数据集A1为自动监测设备诱捕和船形诱捕采集的草地贪夜蛾成虫的原始图像,将训练集A1清除原始训练图像的标注框内的残缺目标(马赛克处理或虚化背景,要求标注框内的草地贪夜蛾是完整的单头虫体,且不含其他草地贪夜蛾的残缺虫体,图2),对处理后的图像进行边界框标注,形成训练集A2;数据集B为自动监测设备诱捕采集的未经边缘残缺目标清除处理的斜纹夜蛾图像;数据集C为机器诱捕和船形诱捕采集的无检测目标的负样本图像,包括空白背景、树叶和其他无关昆虫(除草地贪夜蛾和斜纹夜蛾外的其他昆虫)的背景图像。

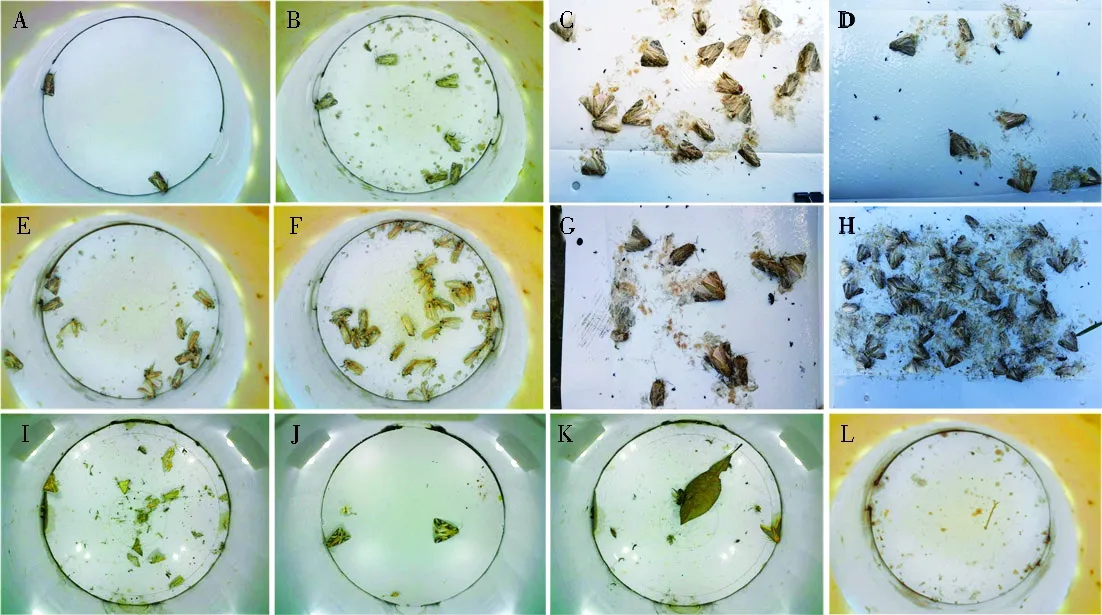

模型训练集和测试集均包含背面朝上、腹面朝上、正面(头部朝上)、侧面朝上、无鳞片虫体、翅展虫体、破损虫体和虫体接触或遮挡等图像样本。根据图像识别的难易程度把测试集分为简单测试集T1(图3: A-D)、困难测试集T2(图3: E-H)和无检测目标测试集T3(图3: I-L)3个梯度,各个测试集的图片数分别为110, 140和60幅(表3)。

表2 训练集样本数据量Table 2 The sample size of training sets

图2 测试集示例图Fig. 2 Typical images of test setsA, C: 原始图像Original images; B, D: 边缘残缺目标清除处理后图像Images with edge incomplete objects removed.

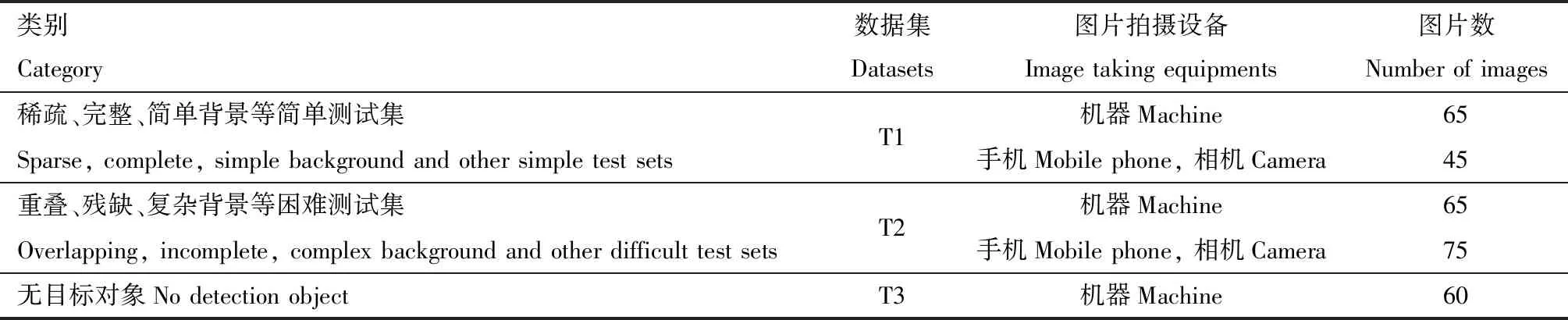

表3 测试集样本数据量Table 3 The sample size of test sets

图3 测试集中的典型图像Fig. 3 Typical images of test setsA: 虫体背面朝上Moths with dorsal side up; B: 虫体侧面朝上Moths with lateral side up; C: 虫体腹面朝上Moths with ventral side up; D: 虫体边缘残缺Moths with incomplete edge of body; E: 虫体腹面朝上、拥挤重叠Moths with ventral side up or/and crowded overlap; F: 虫体鳞片丢失、拥挤重叠Moths with scales lost or overlapping densely; G: 成像模糊、虫体重叠Blurred imaging or moth bodies overlapping; H: 背景复杂、拥挤重叠Complex background or overlapping densely; I: 其他无关昆虫Other unrelated insects; J: 斜纹夜蛾S. litura; K: 树叶和其他无关昆虫Leaves and other unrelated insects; L: 无检测目标Without detection objects; A, B, E, F, I-L: 机器采集的图片Images taken by machine; C, G: 手机拍照的图片Images taken by mobile phone; D, H: 相机拍照图片Images taken by camera.

1.3 实验装置/模型的训练

1.3.1试验平台:为降低部署成本,便于模型后期移植到边缘计算终端实际部署应用,神经网络模型结构采用Yolov5系列中深度最小的Yolov5s网络结构。模型训练采用的操作系统为Ubuntu16.04,训练框架为pytorch,服务器平台配置为:Intel Xeon(R) CPU E3-1245 v3@ 3.40 GHz处理器,32 GB运行内存,8 GB GeForce1080显卡。测试的框架为pytorch,处理器为E5-2620V4@2.10GHz,八核,16 GB RAM,显卡为NvidiaGeForce1050,使用版本号为:CUDA10.0并行计算框架,配合CUDNN7.3版本的深度神经网络API。

1.3.2识别模型的训练:识别模型的训练实验分为2个组。第1组集中在图像背景处理问题上,目标是讨论样本背景对检测精度的影响。该组共使用2个小组图像:a)未修改的草地贪夜蛾图像数据集A1;b)去除边缘残缺目标的草地贪夜蛾图像数据集A2。第2组集中在增加数据类别样本对检测精度的影响,重点分析与草地贪夜蛾具有相似特征的斜纹夜蛾样本对模型的影响。共使用3个小组图像:a)草地贪夜蛾的图像数据集A1;b)在数据集A1基础上增加斜纹夜蛾的图像数据集B,组成数据集A1+B;c)在数据集A1+B的基础上再增加负样本C,组成数据集A1+B+C。在每组案例中,每个模型训练随机抽取80%的样本用于训练,另20%用于验证。使用网络模型YOLOv5s对各组的数据集进行对比训练试验,并在3种不同的测试数据集上验证模型效果。

模型训练参数设置为每批量样本数为28,动量因子为0.937,初始学习率为0.01,训练周期300个。

1.4 评价指标

模型选取准确率(precision, P)、召回率(recall, R)、F1值(F1-measure)、平均准确率(average precision, AP)和计数准确率(counting accuracy, CA)这5个指标作为评价标准,计算公式参考Fawcett(2006)和王志彬等(2014)的方法,如式(1)~(5),表示如下:

(1)

(2)

(3)

(4)

(5)

其中,真阳性(true positive, TP)指被算法检测到为草地贪夜蛾且真实是草地贪夜蛾的样本数量;假阳性(false negative, FP),也就是误检,指被算法检测为草地贪夜蛾但真实不是草地贪夜蛾的样本数量;假阴性(false negative, FN),也就是漏检,指被算法检测为非草地贪夜蛾但真实是草地贪夜蛾的样本数量。F1值是基于准确率和召回率的调和平均值。AP值是根据准确率(P)和召回率(R)绘制的P-R曲线与坐标轴之间的面积。m表示人工计数草地贪夜蛾的样本数量。

2 结果

2.1 清除边缘残缺目标训练样本的对比检测结果

为验证清除边缘残缺目标对检测精度的影响,分别使用训练数据集A1和A2进行对比试验,结果见表4。与未处理的原始图片训练的模型Yolov5s-A1相比,通过数据集A2训练获得的模型Yolov5s-A2对测试集(T1+T2+T3)中草地贪夜蛾识别的准确率(P)提升了5.78%,召回率(R)下降了5.47%,F1值下降了0.02。 其中,简单数据集T1的准确率(P)提升2.61%,召回率(R)下降3.09%, F1值下降0.26; 困难数据集T2的准确率(P)提升4.17%, 召回率(R)下降5.86%,F1值下降1.32。结果表明,清除边缘残缺目标可以提高模型的识别准确率,对困难数据集的检测精度的影响大于简单数据集。从P-R曲线可以看出,模型Yolov5s-A2要优于Yolov5s-A1(图6)。

2.2 增加数据类别(斜纹夜蛾、负样本)样本对结果的影响

分别使用训练数据集A1, A1+B和A1+B+C训练Yolov5s网络模型,得到Yolov5s-A1, Yolov5s-AB和Yolov5s-ABC 3个草地贪夜蛾网络模型。进一步利用测试集T1, T2, T3和T1+T2+T3进行验证。结果表明,模型Yolov5s-AB的F1值、AP值均高于模型Yolov5s-A1;虽然模型Yolov5s-ABC能更好地检测出无目标对象的图像,但是整体F1值、AP值均低于模型Yolov5s-AB(表4)。从P-R曲线可以看出,模型Yolov5s-AB和Yolov5s-ABC优于Yolov5s-A1(图6)。

2.3 不同遮挡重叠程度对比试验

如果诱捕虫量较大,会存在草地贪夜蛾虫体间相互遮挡重叠的问题,这将对检测结果产生较大影响。因此,我们将遮挡程度作为控制变量,分别取测试集T1和T2验证检测结果,见表4和图4(A-L)。其中AP值最高的Yolov5s-AB网络模型,对轻度遮挡简单测试集的识别,模型的准确率(P)为97.42%,召回率(R)为97.92%,F1值为97.67。对遮挡重叠复杂测试集的识别,准确率(P)为96.84%,召回率(R)为90.93%,F1值为93.79。结果表明,在草地贪夜蛾被遮挡以及重叠的情况下,Yolov5s-AB网络模型的识别精度会有所降低,但仍能大部分检测出。

在实际应用中,存在机器定时自动采集的图片中没有草地贪夜蛾或其他昆虫的情况。本研究选择12张斜纹夜蛾的图像、12张空白背景、36张其他昆虫等共60张无检测目标的图像(图4: M-P)来测试检测模型。结果显示,4个检测模型Yolov5s-A1, Yolov5s-A2, Yolov5s-AB和Yolov5s-ABC的误检样本数FP分别为184,101, 15和1头,其中使用Yolov5s-ABC检测网络进行检测,60张图像中只有1张为其他昆虫(1头粘虫)图像误检为草地贪夜蛾。

图4 4个不同网络模型检测结果对比Fig. 4 Comparison of detection results using four different network modelsA-D: 简单测试集T1 Simple test training dataset T1; E-L: 复杂测试集T2 Complicated test training dataset T2; L-M: 无目标测试集T3 No object test training dataset T3; A, E, I, M: Yolov5s-A1; B, F, J, N: Yolov5s-A2; C, G, K, O: Yolov5s-AB; D, H, L, P: Yolov5s-ABC; SF: 草地贪夜蛾成虫Spodoptera frugiperda adults; MS: 斜纹夜蛾成虫S. litura adults.

2.4 不同梯度测试集的计数结果

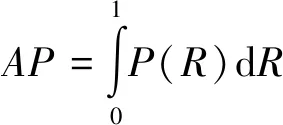

将4个识别模型与人工计数的方法进行比较,应用公式(5)进行计数准确率计算。4个模型中对简单数据集的计数准确率最高的为Yolov5s-AB,最低的为Yolov5s-ABC;对复杂数据集的计数准确率最高的为Yolov5s-AB,最低的为Yolov5s-A1(表5)。各梯度测试集比较结果显示,模型Yolov5s-AB效果最好。以每张测试集图像的人工计算的虫量作为横坐标,对应的模型算法计算的虫量作为纵坐标,绘制散点图,并且画出y=x直线,结合y=x直线和散点的分布对4个模型进行分析。模型Yolov5s-AB的散点分布最靠近人工计数y=x直线,也就是说该模型的优于其他3模型;从每张图片包含的虫量上看,当单张虫量小于40头时,4个模型和人工计数基本符合线性模型,大于40头时,出现个别离群点现象(图5)。

表5 不同网络模型不同梯度测试集的识别计数结果对比Table 5 Comparison of counting results using differentgradient test sets and network models

图5 算法计数与人工计数差异分析Fig. 5 Analysis results of algorithm counting and manual countingA: Yolov5s-A1; B: Yolov5s-A2; C: Yolov5s-AB; D: Yolov5s-ABC. 点号示一张图片。A dot indicates an image.

2.5 几种处理之间的AP值差异比较

通过不同训练集构建了4个识别模型,分别为原始图像集Yolov5s-A1、清除边缘残缺目标图像集Yolov5s-A2、增加斜纹夜蛾样本图像训练的模型Yolov5s-AB和增加无检测对象负样本训练的模型Yolov5s-ABC。4个识别模型对测试集T1+T2+T3检测的P-R曲线如图6所示。 4个模型Yolov5s-A1, Yolov5s-A2, Yolov5s-AB和Yolov5s-ABC的AP值分别为94.01%, 97.00%, 99.09%和98.70%(表4),从高到低排列为:Yolov5s-AB>Yolov5s-ABC>Yolov5s-A2>Yolov5s-A1,其中Yolov5s-AB与Yolov5s-ABC结果相近。

图6 4种不同数据集训练的模型P-R曲线比较Fig. 6 Comparison of P-R curves of the model trained with four different training sets

3 结论与讨论

深度学习正迅速成为图像分类的标准技术。利用深度学习方法进行植物病虫害自动识别面临的主要问题是缺乏能够反映实际病虫害的各种状况和症状特征的图像数据库(Barbedo, 2019)。图像处理等数据扩充技术降低了样本量不足的影响,但这些技术不能再现大多数实际的多样性应用场景。魏靖等(2020)、于业达等(2019)、Chulu等(2019)、Chiwamba等(2019)等基于深度学习技术的草地贪夜蛾图像识别研究,其数据集的图像来源于网上下载、实验室获取、田间拍摄、数据增强等方式,采集数据量小,适用于田间单只草地贪夜蛾成虫的识别,与我国现行的草地贪夜蛾监测的实际应用场景不一致。本研究从田间草地贪夜蛾性诱测报的实际应用出发,除了应用相机、手机等人工采集诱捕器上的图像外,还采用本单位自主研发的自动监测设备来定期采集图像,有效地拓展了实际应用场景下的真实样本数量,通过这两种方法共采集2 981幅原始图像,其中草地贪夜蛾训练样本数量792幅10 824头。

本研究利用深度学习中的Yolov5s网络模型对害虫自动监测设备、相机、手机等多种设备拍摄条件下的草地贪夜蛾图像进行训练,结果表明,获得4个草地贪夜蛾自动识别与计数模型,在3个不同难易梯度的测试集上测试中,模型Yolov5s-AB的检测精度最高,对遮挡和重叠干扰具有更强鲁棒性,准确率和召回率分别达96.84%和90.93%,F1值达93.79,计数准确率CA值达89.01%。研究结果证实了利用深度学习开发草地贪夜蛾识别计数模型是可行的,且能够达到较高的识别准确率。本研究与魏靖等(2020)基于深度学习的草地贪夜蛾图像识别模型研究比较,参加模型训练的草地贪夜蛾训练样本数据量更大,且图像均来源于田间的实际应用场景,研究结果可直接应用于草地贪夜蛾诱捕器粘虫板的识别计数以及自动监测设备。

本研究采用去除边缘残缺目标的方式,实质上是通过减小标注边界框内非目标前景区域特征的干扰,增强了对目标前景区域卷积特征的学习,通过清除背景边界框内被遮挡的残缺草地贪夜蛾及其他干扰物的数据集训练获得的模型Yolov5s-A2,其识别性能优于未处理的原始图片训练的模型Yolov5s-A1,但出现准确率提升而召回率下降的情况,这与Barbedo(2018)报道的结果完全相一致。此外,本研究中模型Yolov5s-A2的准确率提升了5.78%,但召回率却下降了5.47%,与薛月菊等(2018)的报道的准确率和召回率分别提高了1.5%和2.38%相比,存在较大差异。因此可推断,在清除背景中边缘残缺目标的算法中虽然增强了对目标前景区域卷积特征的学习,但弱化了背景与检测目标相关性的特征学习。在实际应用场景中,背景往往与检测目标处于不可分状态,因此,通过去除背景的方法虽然提高了准确率,但是会降低查全率,不适用于草地贪夜蛾的田间图像识别计数。

本研究发现,增加斜纹夜蛾样本图像训练的模型Yolov5s-AB优于单一草地贪夜蛾样本训练的模型Yolov5s-A1,但与增加负样本无检测目标的模型Yolov5s-ABC无明显差异,表明增加相似特征的数据类别对提高图像识别率有着重要作用,而增加负样本对提高图像识别率作用有限。这可能是斜纹夜蛾和草地贪夜蛾同属于夜蛾科昆虫,成虫外型大小、可见特征相似,可以提升相似部分的特征学习分辩效率。这个结果与Tian等(2019)报道的增加数据类别的数量可以提高Yolo模型的检测能力的结果相一致。因此,在样本数据集构建过程中,可以增加检测目标相似特征数据类别的样本数据的采集,可以提升模型的泛化能力(generalization ability)。

本研究首次将YOLO-V5应用于草地贪夜蛾监测的识别计数问题,结果表明将深度学习应用于控制条件下害虫监测设备及诱捕器粘虫板上草地贪夜蛾的识别计数是可行的;增加相似特征数据类别的斜纹夜蛾样本数据对提高草地贪夜蛾图像识别算法的准确率有着重要作用。因此将本研究的优化模型作为草地贪夜蛾种群消长图像监测的核心算法,可为草地贪夜蛾自动化监测设备的精准监测提供核心技术支撑,为广泛开展田间的草地贪夜蛾种群智能化监测预警提供科学依据。